解像度の限界を突破: Byte と中国科学技術大学が大規模なマルチモーダル ドキュメント モデルを明らかに

大規模なマルチモーダル高解像度ドキュメントも登場しました!

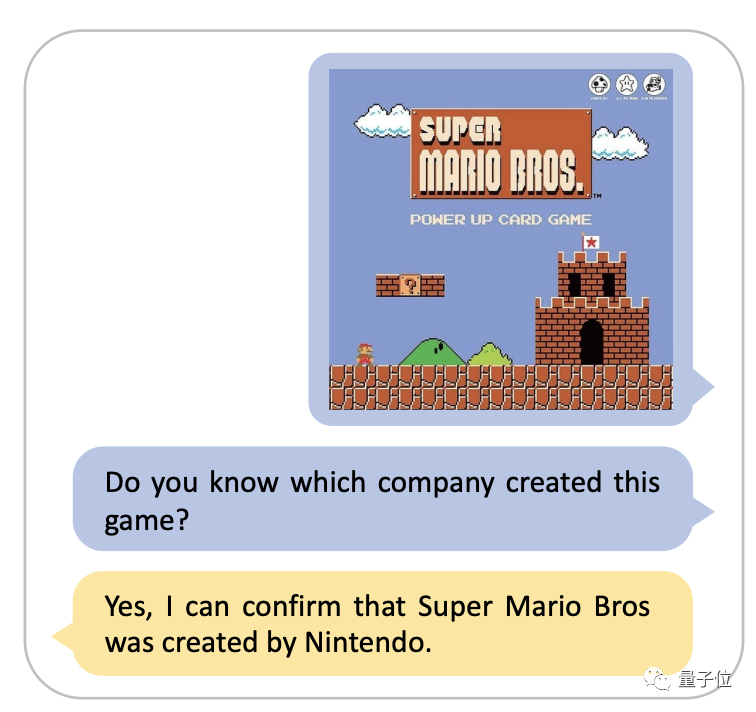

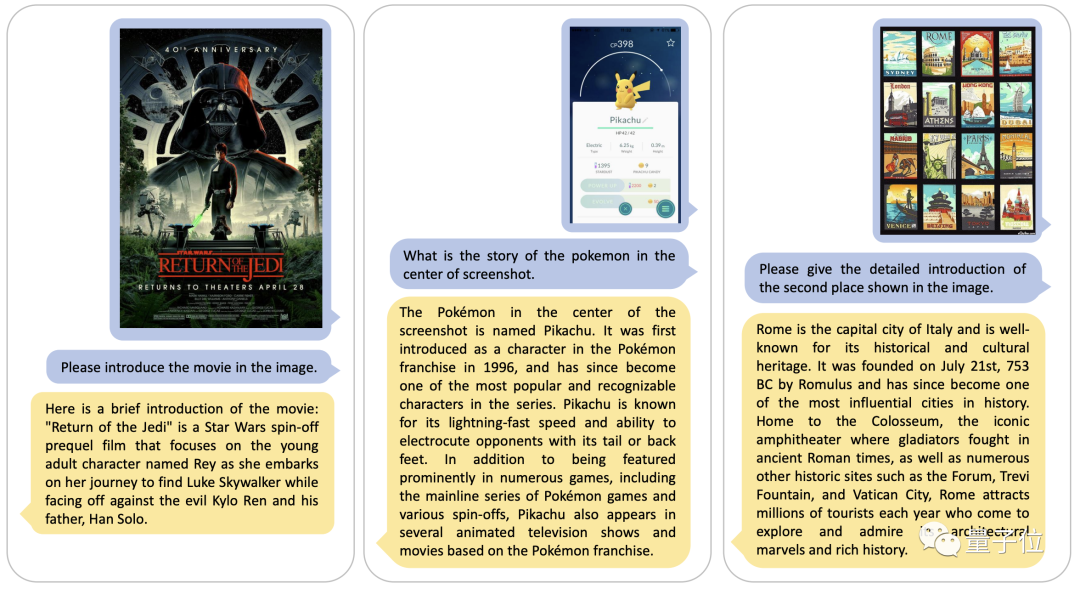

この技術は、画像内の情報を正確に識別するだけでなく、ユーザーのニーズに応じて質問に答えるために独自の知識ベースを呼び出すこともできます

たとえば、写真にマリオのインターフェイスが表示されている場合、直接できます 答えは、これは任天堂の作品であるということです。

このモデルは ByteDance と中国科学技術大学によって共同研究され、2023 年 11 月 24 日に arXiv にアップロードされました

ここで研究してください、著者チームは、統合された 高解像度 マルチモーダル ドキュメント大規模モデル DocPedia である DocPedia を提案しました。

この研究では、著者は高解像度の文書画像を解析できない既存のモデルの欠点を解決する新しい方法を使用しました。

DocPedia の解像度は最大 2560 × 2560 ですが、現在、LLaVA や MiniGPT-4 などの業界の先進的なマルチモーダル大型モデルでは、画像解像度の上限が 336 × 336 であるため、これを使用できません。高解像度のドキュメント画像を解析します。

それでは、このモデルはどのように機能し、どのような最適化手法が使用されているのでしょうか?

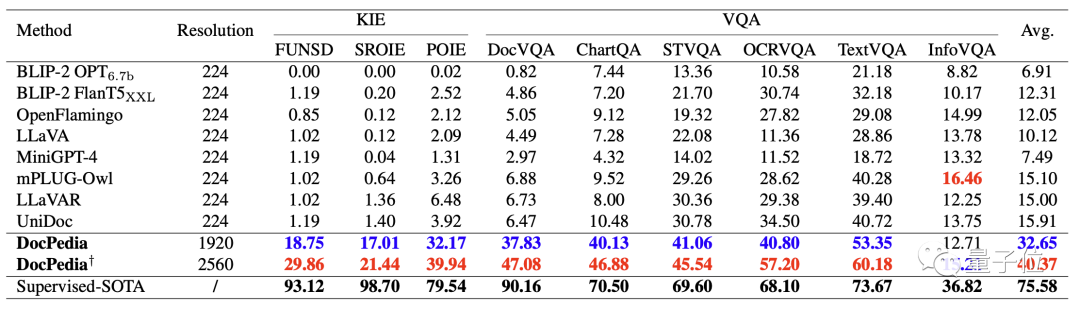

各種評価スコアの大幅な向上

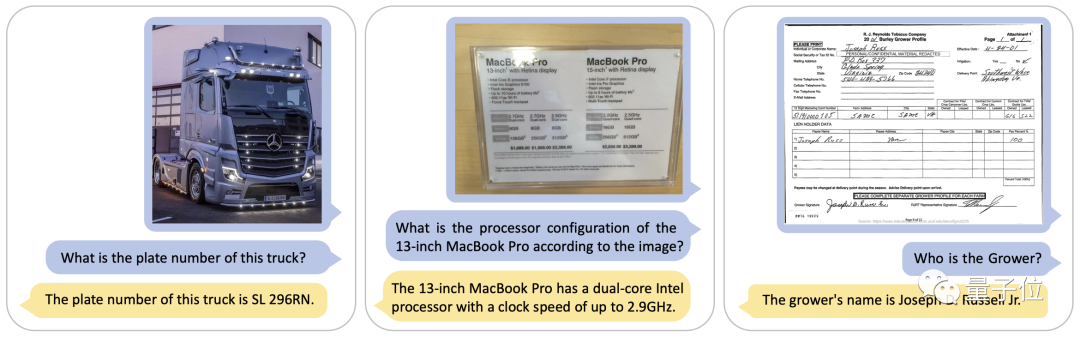

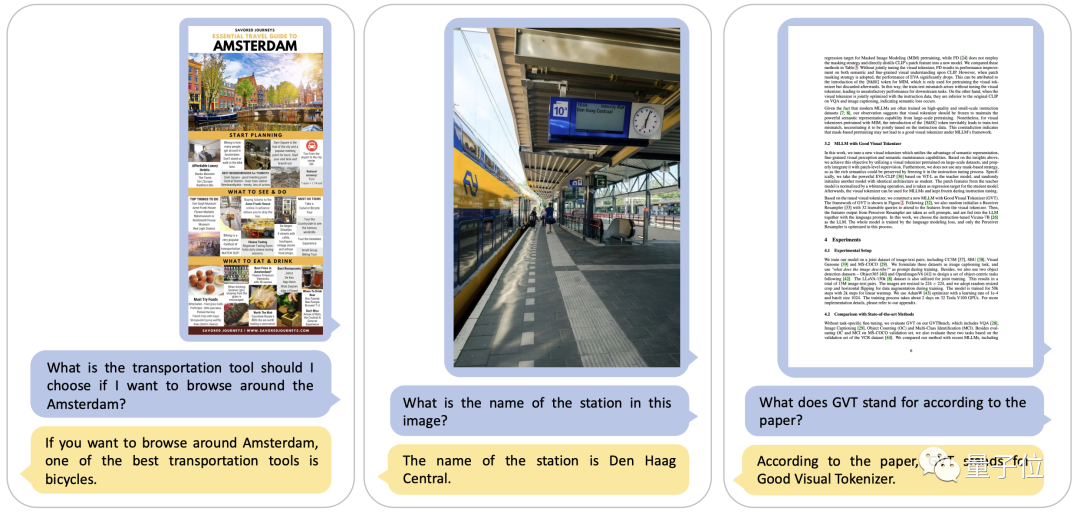

本稿では、DocPedia の高解像度画像とテキスト理解の例を示します。 DocPedia には、指示の内容を理解し、高解像度の文書画像や自然風景の画像から関連するグラフィック情報やテキスト情報を正確に抽出する機能があることがわかります。

たとえば、この一連の写真では、DocPedia が簡単に実行できます。写真から地雷 ナンバープレートの番号やコンピュータの構成などの文字情報により、手書きの文字でも正確に判断できます。

DocPedia は、画像内のテキスト情報と組み合わせて、大規模なモデル推論機能を使用して、コンテキストに基づいて問題を分析することもできます。

#次の表は、いくつかの既存のマルチモーダル大規模モデルと DocPedia の重要情報抽出 (KIE) およびビジュアル質問応答 (VQA) 機能を定量的に比較しています。

#次の表は、いくつかの既存のマルチモーダル大規模モデルと DocPedia の重要情報抽出 (KIE) およびビジュアル質問応答 (VQA) 機能を定量的に比較しています。

解像度を高め、効果的なトレーニング方法を採用することにより、DocPedia がさまざまなテスト ベンチマークで大幅な改善を達成したことがわかります。

それでは、DocPedia はどのようにして成果を上げているのでしょうか。そんな効果?

それでは、DocPedia はどのようにして成果を上げているのでしょうか。そんな効果?

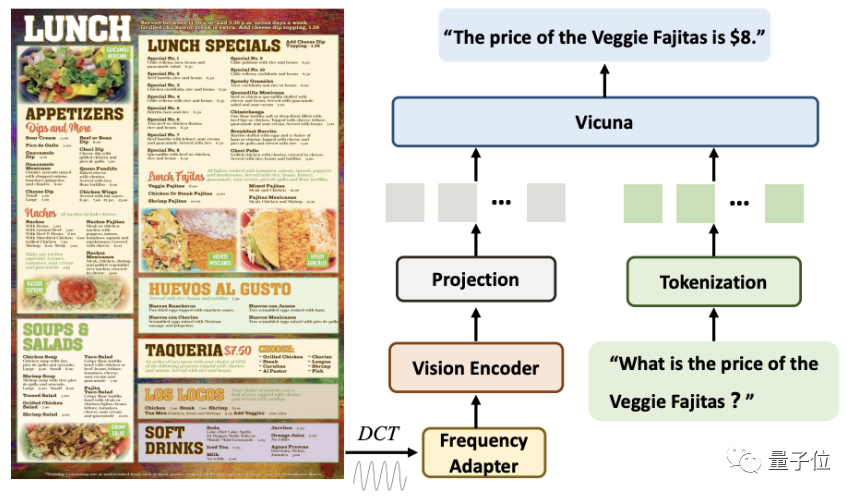

周波数領域からの解像度の問題の解決

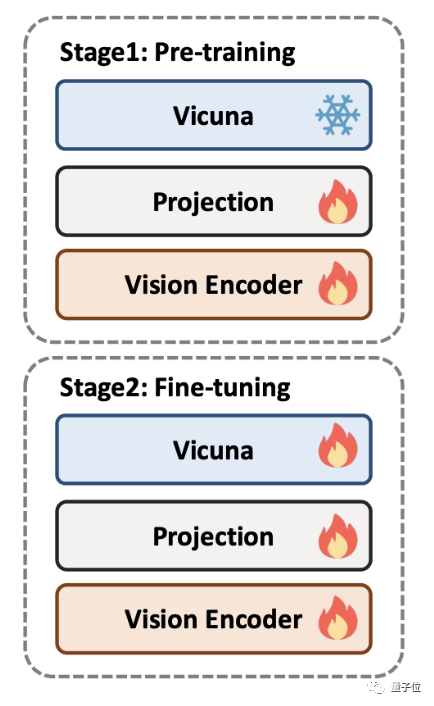

DocPedia のトレーニングは、事前トレーニングと微調整の 2 つの段階に分かれています。 DocPedia をトレーニングするために、作成者チームはさまざまな種類のドキュメントを含む大量のグラフィック データを収集し、命令を微調整するデータ セットを構築しました。

##プレトレーニング段階では、大規模言語モデルはフリーズされ、出力トークン表現空間が大規模言語モデルと一致するようにビジュアル エンコーダーの一部のみが最適化されますこの段階で、著者チームは、テキストや自然のシーンの認識を含む DocPedia の認識機能を主にトレーニングすることを提案しました トレーニング前のタスクには、テキスト検出、テキスト認識、エンドツーエンド OCR、段落が含まれます読み取り、全文読み取り、画像テキストの説明。 微調整フェーズでは、大規模な言語モデルのフリーズが解除され、エンドツーエンドの全体的な最適化が実行されます。著者チームは、知覚理解の共同トレーニング戦略を提案しました。元の低レベルの知覚タスクに、この共同知覚理解トレーニング戦略を追加すると、DocPedia のパフォーマンスがさらに向上します。問題解決の戦略に関しては、既存の方法とは異なり、DocPedia は

周波数領域の観点から問題を解決します。

このステップの後、カスケード周波数ドメイン アダプター (周波数アダプター) を使用します。入力信号をビジョン エンコーダーに渡します。より深い解像度圧縮と特徴抽出のための

この方法では、2560×2560 の画像を 1600 個のトークンで表現できます。

元の画像をビジュアル エンコーダ (Swin Transformer など) に直接入力する場合と比較して、この方法ではトークンの数が 4 倍削減されます。

最後に、これらのトークンは、シーケンス次元の命令から変換されたトークンと結合され、応答用の大規模モデルに入力されます。

アブレーション実験の結果は、解像度の向上と共同認識理解の微調整の実行が、DocPedia のパフォーマンスを向上させる 2 つの重要な要素であることを示しています

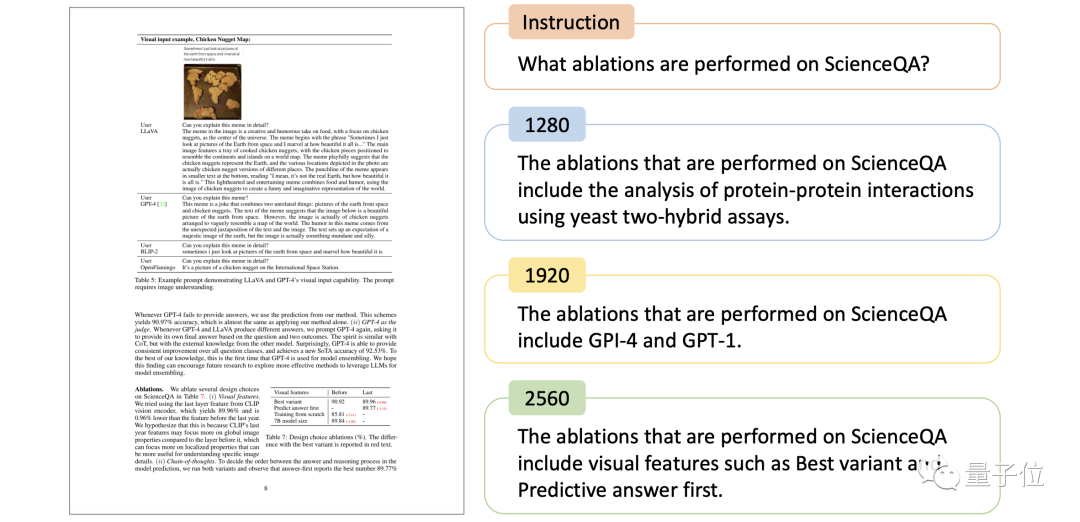

次の図は、DocPedia の回答を紙の画像と、異なる入力スケールでの同じコマンドと比較したものです。解像度が 2560×2560 に増加した場合にのみ、DocPedia が正しく応答することがわかります。

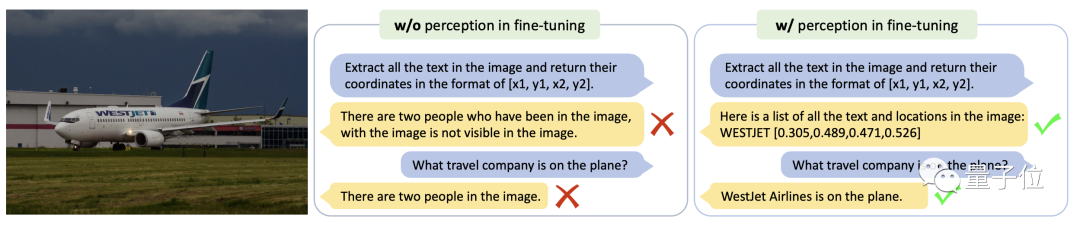

下の図は、異なる微調整戦略の下で、同じシーンのテキスト画像と同じ命令に対する DocPedia のモデル応答を比較しています。

この例から、知覚と理解によって共同で微調整されたモデルは、テキスト認識と意味論的な質問応答を正確に実行できることがわかります

#論文を表示するには、次のリンクをクリックしてください: https://arxiv.org/abs/2311.11810

以上が解像度の限界を突破: Byte と中国科学技術大学が大規模なマルチモーダル ドキュメント モデルを明らかにの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7447

7447

15

15

1374

1374

52

52

76

76

11

11

14

14

6

6

ddrescue を使用して Linux 上のデータを回復する

Mar 20, 2024 pm 01:37 PM

ddrescue を使用して Linux 上のデータを回復する

Mar 20, 2024 pm 01:37 PM

DDREASE は、ハード ドライブ、SSD、RAM ディスク、CD、DVD、USB ストレージ デバイスなどのファイル デバイスまたはブロック デバイスからデータを回復するためのツールです。あるブロック デバイスから別のブロック デバイスにデータをコピーし、破損したデータ ブロックを残して正常なデータ ブロックのみを移動します。 ddreasue は、回復操作中に干渉を必要としないため、完全に自動化された強力な回復ツールです。さらに、ddasue マップ ファイルのおかげでいつでも停止および再開できます。 DDREASE のその他の主要な機能は次のとおりです。 リカバリされたデータは上書きされませんが、反復リカバリの場合にギャップが埋められます。ただし、ツールに明示的に指示されている場合は切り詰めることができます。複数のファイルまたはブロックから単一のファイルにデータを復元します

オープンソース!ゾーイデプスを超えて! DepthFM: 高速かつ正確な単眼深度推定!

Apr 03, 2024 pm 12:04 PM

オープンソース!ゾーイデプスを超えて! DepthFM: 高速かつ正確な単眼深度推定!

Apr 03, 2024 pm 12:04 PM

0.この記事は何をするのですか?私たちは、多用途かつ高速な最先端の生成単眼深度推定モデルである DepthFM を提案します。従来の深度推定タスクに加えて、DepthFM は深度修復などの下流タスクでも最先端の機能を実証します。 DepthFM は効率的で、いくつかの推論ステップ内で深度マップを合成できます。この作品について一緒に読みましょう〜 1. 論文情報タイトル: DepthFM: FastMonocularDepthEstimationwithFlowMatching 著者: MingGui、JohannesS.Fischer、UlrichPrestel、PingchuanMa、Dmytr

こんにちは、電気アトラスです!ボストン・ダイナミクスのロボットが復活、180度の奇妙な動きにマスク氏も恐怖

Apr 18, 2024 pm 07:58 PM

こんにちは、電気アトラスです!ボストン・ダイナミクスのロボットが復活、180度の奇妙な動きにマスク氏も恐怖

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas は正式に電動ロボットの時代に突入します!昨日、油圧式アトラスが歴史の舞台から「涙ながらに」撤退したばかりですが、今日、ボストン・ダイナミクスは電動式アトラスが稼働することを発表しました。ボストン・ダイナミクス社は商用人型ロボットの分野でテスラ社と競争する決意を持っているようだ。新しいビデオが公開されてから、わずか 10 時間ですでに 100 万人以上が視聴しました。古い人が去り、新しい役割が現れるのは歴史的な必然です。今年が人型ロボットの爆発的な年であることは間違いありません。ネットユーザーは「ロボットの進歩により、今年の開会式は人間のように見え、人間よりもはるかに自由度が高い。しかし、これは本当にホラー映画ではないのか?」とコメントした。ビデオの冒頭では、アトラスは仰向けに見えるように地面に静かに横たわっています。次に続くのは驚くべきことです

Google は大喜び: JAX のパフォーマンスが Pytorch や TensorFlow を上回りました! GPU 推論トレーニングの最速の選択肢となる可能性があります

Apr 01, 2024 pm 07:46 PM

Google は大喜び: JAX のパフォーマンスが Pytorch や TensorFlow を上回りました! GPU 推論トレーニングの最速の選択肢となる可能性があります

Apr 01, 2024 pm 07:46 PM

Google が推進する JAX のパフォーマンスは、最近のベンチマーク テストで Pytorch や TensorFlow のパフォーマンスを上回り、7 つの指標で 1 位にランクされました。また、テストは最高の JAX パフォーマンスを備えた TPU では行われませんでした。ただし、開発者の間では、依然として Tensorflow よりも Pytorch の方が人気があります。しかし、将来的には、おそらくより大規模なモデルが JAX プラットフォームに基づいてトレーニングされ、実行されるようになるでしょう。モデル 最近、Keras チームは、ネイティブ PyTorch 実装を使用して 3 つのバックエンド (TensorFlow、JAX、PyTorch) をベンチマークし、TensorFlow を使用して Keras2 をベンチマークしました。まず、主流のセットを選択します

iPhoneのセルラーデータインターネット速度が遅い:修正

May 03, 2024 pm 09:01 PM

iPhoneのセルラーデータインターネット速度が遅い:修正

May 03, 2024 pm 09:01 PM

iPhone のモバイル データ接続に遅延や遅い問題が発生していませんか?通常、携帯電話の携帯インターネットの強度は、地域、携帯ネットワークの種類、ローミングの種類などのいくつかの要因によって異なります。より高速で信頼性の高いセルラー インターネット接続を実現するためにできることがいくつかあります。解決策 1 – iPhone を強制的に再起動する 場合によっては、デバイスを強制的に再起動すると、携帯電話接続を含む多くの機能がリセットされるだけです。ステップ 1 – 音量を上げるキーを 1 回押して放します。次に、音量小キーを押して、もう一度放します。ステップ 2 – プロセスの次の部分は、右側のボタンを押し続けることです。 iPhone の再起動が完了するまで待ちます。セルラーデータを有効にし、ネットワーク速度を確認します。もう一度確認してください 修正 2 – データ モードを変更する 5G はより優れたネットワーク速度を提供しますが、信号が弱い場合はより適切に機能します

超知性の生命力が覚醒する!しかし、自己更新 AI の登場により、母親はデータのボトルネックを心配する必要がなくなりました。

Apr 29, 2024 pm 06:55 PM

超知性の生命力が覚醒する!しかし、自己更新 AI の登場により、母親はデータのボトルネックを心配する必要がなくなりました。

Apr 29, 2024 pm 06:55 PM

世界は狂ったように大きなモデルを構築していますが、インターネット上のデータだけではまったく不十分です。このトレーニング モデルは「ハンガー ゲーム」のようであり、世界中の AI 研究者は、データを貪欲に食べる人たちにどのように餌を与えるかを心配しています。この問題は、マルチモーダル タスクで特に顕著です。何もできなかった当時、中国人民大学学部のスタートアップチームは、独自の新しいモデルを使用して、中国で初めて「モデル生成データフィード自体」を実現しました。さらに、これは理解側と生成側の 2 つの側面からのアプローチであり、両方の側で高品質のマルチモーダルな新しいデータを生成し、モデル自体にデータのフィードバックを提供できます。モデルとは何ですか? Awaker 1.0 は、中関村フォーラムに登場したばかりの大型マルチモーダル モデルです。チームは誰ですか?ソフォンエンジン。人民大学ヒルハウス人工知能大学院の博士課程学生、ガオ・イージャオ氏によって設立されました。

Kuaishou バージョンの Sora「Ke Ling」がテスト用に公開されています。120 秒以上のビデオを生成し、物理学をより深く理解し、複雑な動きを正確にモデル化できます。

Jun 11, 2024 am 09:51 AM

Kuaishou バージョンの Sora「Ke Ling」がテスト用に公開されています。120 秒以上のビデオを生成し、物理学をより深く理解し、複雑な動きを正確にモデル化できます。

Jun 11, 2024 am 09:51 AM

何?ズートピアは国産AIによって実現するのか?ビデオとともに公開されたのは、「Keling」と呼ばれる新しい大規模な国産ビデオ生成モデルです。 Sora も同様の技術的ルートを使用し、自社開発の技術革新を多数組み合わせて、大きく合理的な動きをするだけでなく、物理世界の特性をシミュレートし、強力な概念的結合能力と想像力を備えたビデオを制作します。データによると、Keling は、最大 1080p の解像度で 30fps で最大 2 分の超長時間ビデオの生成をサポートし、複数のアスペクト比をサポートします。もう 1 つの重要な点は、Keling は研究所が公開したデモやビデオ結果のデモンストレーションではなく、ショートビデオ分野のリーダーである Kuaishou が立ち上げた製品レベルのアプリケーションであるということです。さらに、主な焦点は実用的であり、白紙小切手を書かず、リリースされたらすぐにオンラインに移行することです。Ke Ling の大型モデルは Kuaiying でリリースされました。

アメリカ空軍が初のAI戦闘機を公開し注目を集める!大臣はプロセス全体を通じて干渉することなく個人的にテストを実施し、10万行のコードが21回にわたってテストされました。

May 07, 2024 pm 05:00 PM

アメリカ空軍が初のAI戦闘機を公開し注目を集める!大臣はプロセス全体を通じて干渉することなく個人的にテストを実施し、10万行のコードが21回にわたってテストされました。

May 07, 2024 pm 05:00 PM

最近、軍事界は、米軍戦闘機が AI を使用して完全自動空戦を完了できるようになったというニュースに圧倒されました。そう、つい最近、米軍のAI戦闘機が初めて公開され、その謎が明らかになりました。この戦闘機の正式名称は可変安定性飛行シミュレーター試験機(VISTA)で、アメリカ空軍長官が自ら飛行させ、一対一の空戦をシミュレートした。 5 月 2 日、フランク ケンダル米国空軍長官は X-62AVISTA でエドワーズ空軍基地を離陸しました。1 時間の飛行中、すべての飛行動作が AI によって自律的に完了されたことに注目してください。ケンダル氏は「過去数十年にわたり、私たちは自律型空対空戦闘の無限の可能性について考えてきたが、それは常に手の届かないものだと思われてきた」と語った。しかし今では、