テクノロジー周辺機器

テクノロジー周辺機器

AI

AI

Microsoft は、「プロンプト プロジェクト」だけで GPT-4 を医療専門家に変えました。十数種類の高度に微調整されたモデルにより、プロによるテスト精度が初めて 90% を超えました

Microsoft は、「プロンプト プロジェクト」だけで GPT-4 を医療専門家に変えました。十数種類の高度に微調整されたモデルにより、プロによるテスト精度が初めて 90% を超えました

Microsoft は、「プロンプト プロジェクト」だけで GPT-4 を医療専門家に変えました。十数種類の高度に微調整されたモデルにより、プロによるテスト精度が初めて 90% を超えました

Microsoft の最新の研究は、プロンプト プロジェクト -

追加の微調整や専門家による計画を行わなくても、GPT-4 はプロンプトだけで「エキスパート」になることができることを再度証明しています。

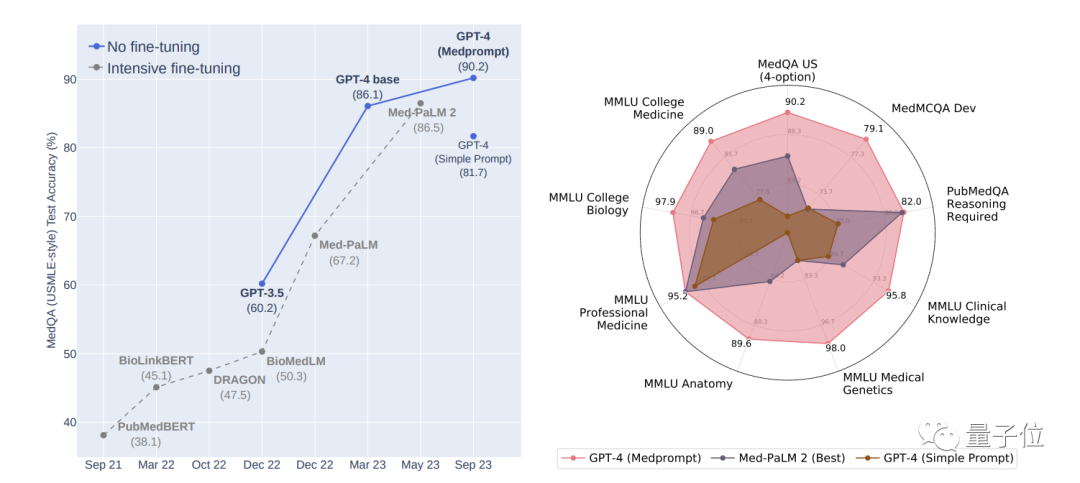

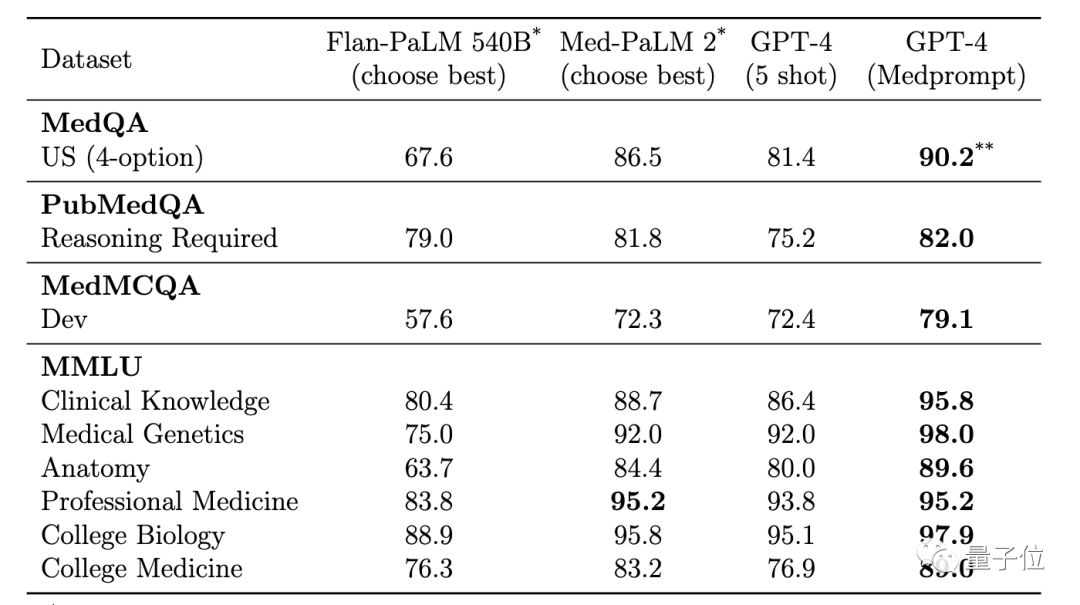

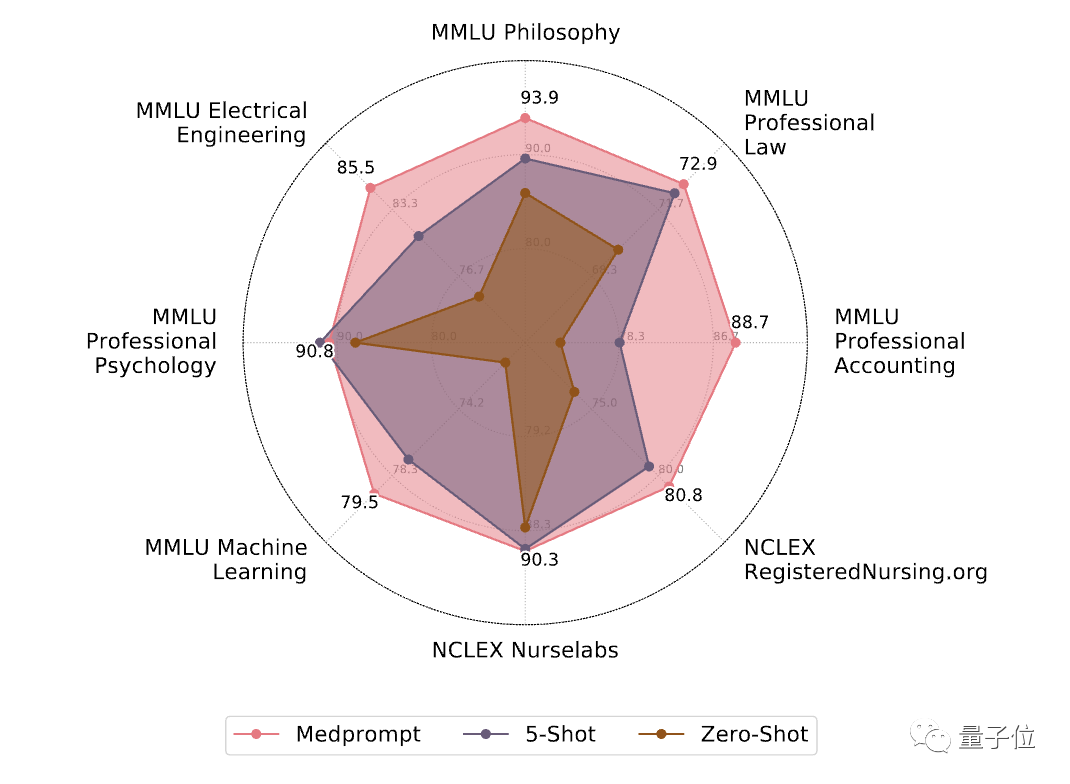

彼らが提案した最新のプロンプト戦略 Medprompt を使用して、医療専門家の分野では、GPT-4 は MultiMed QA の 9 つのテスト セットで最高の結果を達成しました。

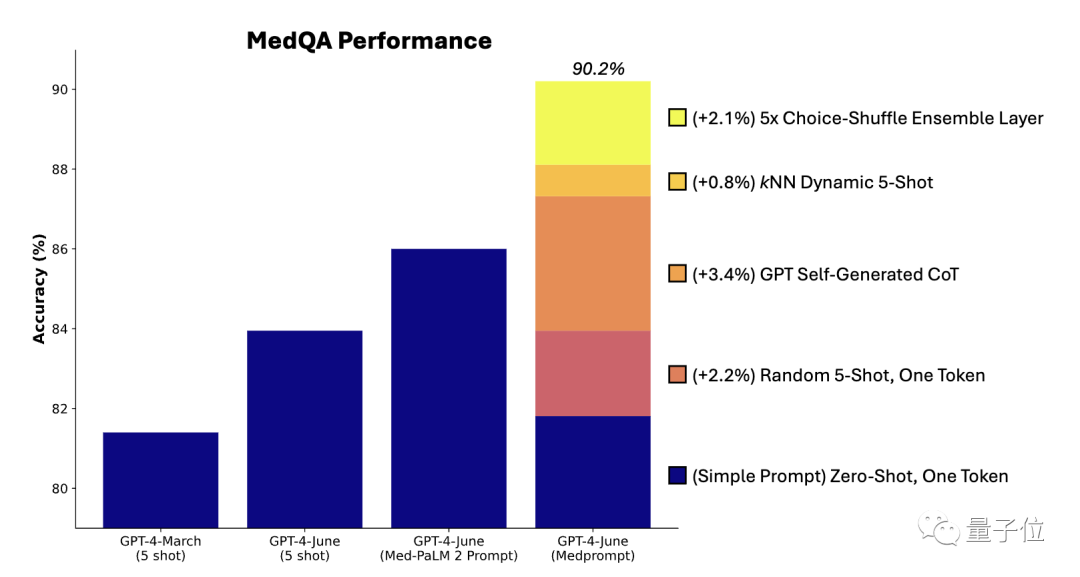

MedQA データセット (米国医師免許試験問題) において、Medprompt は GPT-4 の精度を初めて 90% を超え、 は BioGPT および Med-PaLM# を上回りました。 ## 多数の微調整方法を待っています。

GPT-4 は業界を変えることができるテクノロジーですが、まだ遠いです離れています プロンプトの制限に達しておらず、微調整の制限にも達していません。

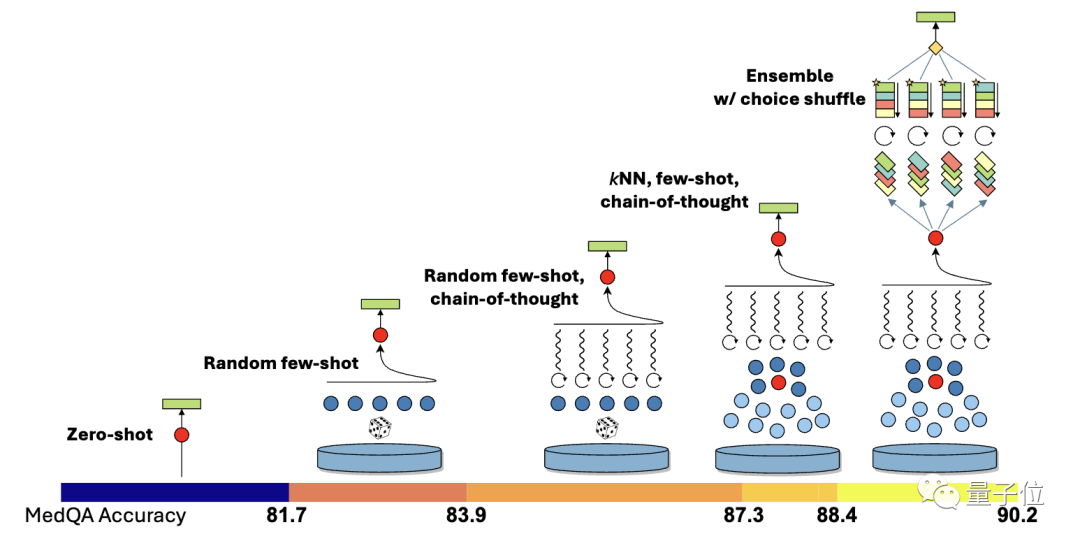

- ダイナミックな数ショット選択

- 自己生成の思考連鎖

- 選択シャッフルアンサンブル)

固定であるため、例の代表性と幅広さについては高い要件が求められます。

以前の方法は、ドメインの専門家が手動でサンプルを作成するというものでしたですが、それでも、専門家が厳選した固定の少数サンプルのサンプルが各タスクを代表するものであるという保証はありません。

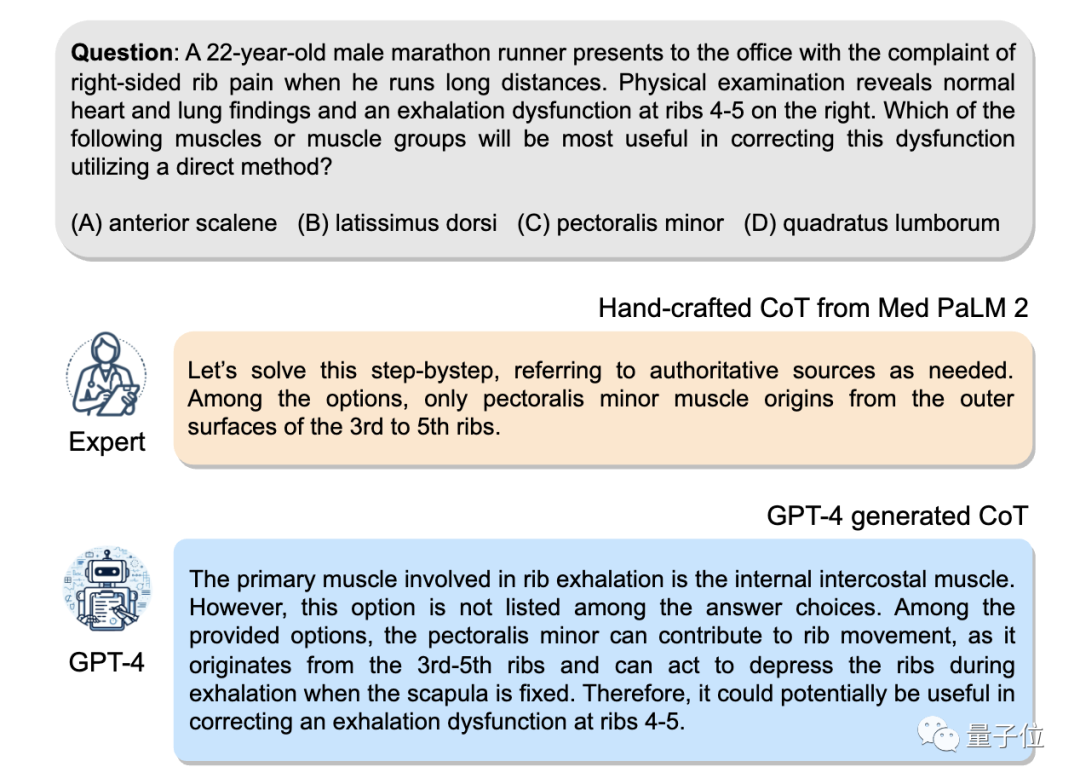

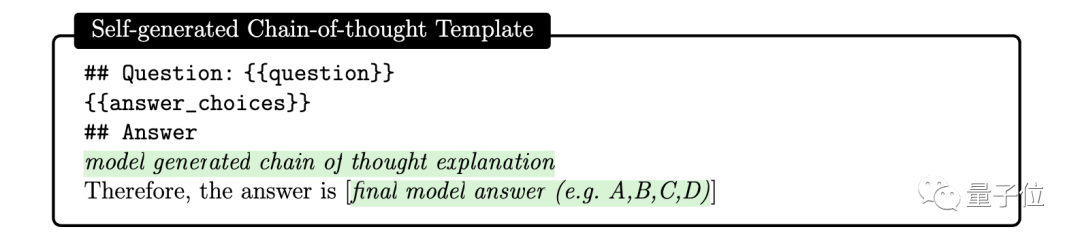

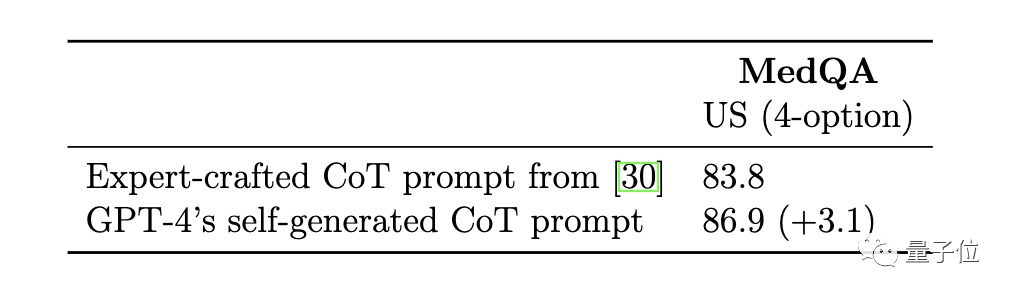

マイクロソフトの研究者は、動的少数ショット例の方法を提案しました。したがって、アイデアは、タスク トレーニング セットを少数ショット例のソースとして使用できるということです。が十分に大きい場合、さまざまなタスク入力に対してさまざまな数ショットの例を選択できます。 具体的な操作に関しては、研究者らはまず text-embedding-ada-002 モデルを使用して、各トレーニング サンプルとテスト サンプルのベクトル表現を生成しました。次に、各テスト サンプルについて、ベクトルの類似性を比較することにより、最も類似した k 個のサンプルがトレーニング サンプルから選択されます。微調整方法と比較して、動的少数ショット選択はトレーニングを利用します。ただし、モデルパラメータの大規模な更新は必要ありません。 自己生成の思考連鎖思考連鎖 (CoT) メソッドは、モデルに段階的に思考させ、一連の中間推論ステップを生成させるメソッドですこれまでの方法は専門家に依存していました 迅速な思考連鎖を備えたいくつかの例を手動で作成しました

ここで、研究者らは、次のプロンプトを使用して、GPT-4 にトレーニング例の思考連鎖を生成するよう簡単に依頼できることを発見しました:

しかし、研究者らは、この自動的に生成された思考チェーンには間違った推論ステップが含まれている可能性があるとも指摘したため、効果的にエラーを減らすことができるフィルターとして検証タグを設定しました。

Med-PaLM 2 モデルの専門家によって手作りされた思考チェーンの例と比較して、GPT-4 によって生成された思考チェーンの基本原理は長く、段階的な推論ロジックは次のとおりです。よりきめ細かい。

オプション シャッフル統合

GPT-4 は、多肢選択問題を扱うときにバイアスがある可能性があります。つまり、質問の内容に関係なく、常に A を選択するか、常に B を選択する傾向があります。オプションは、これは位置の偏差です。

この問題を解決するために、研究者たちは元のオプションの順序を並べ替えて影響を軽減することにしました。たとえば、元のオプションの順序は ABCD ですが、BCDA、CDAB などに変更できます。

次に、各ラウンドで異なるオプションの順序を使用して、GPT-4 に複数のラウンドの予測を実行させます。これにより、GPT-4 はオプションの内容を考慮するように「強制」されます。

最後に、複数ラウンドの予測の結果に投票し、最も一貫性があり正しい選択肢を選択します。

上記のプロンプト戦略を組み合わせたものが Medprompt です。テスト結果を見てみましょう。

最適な複数テスト

このテストでは、研究者は MultiMed QA 評価ベンチマークを使用しました。

Medprompt プロンプト戦略を使用する GPT-4 は、MultiMedQA の 9 つのベンチマーク データ セットすべてで最高スコアを達成し、Flan-PaLM 540B および Med-PaLM 2 よりも優れています。 。

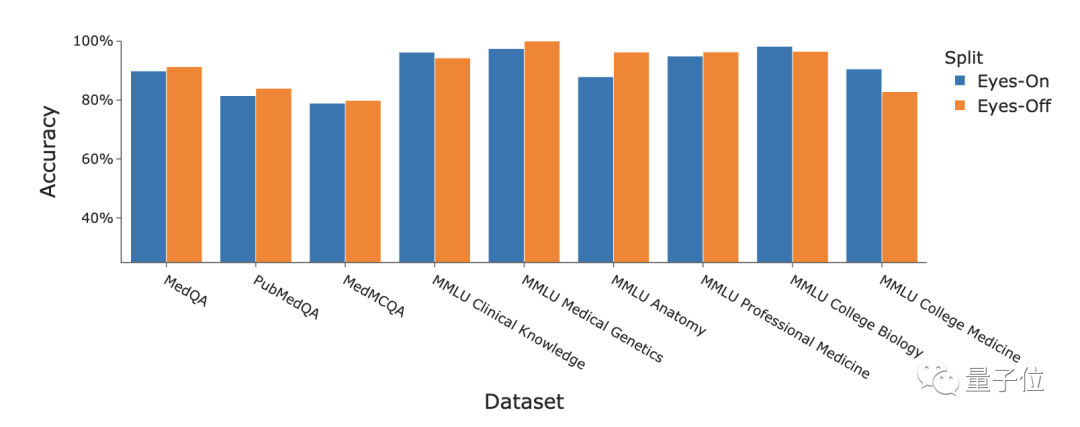

さらに、研究者らは、「アイズオフ」データに対する Medprompt 戦略のパフォーマンスについても議論しました。いわゆる「アイズオフ」データとは、トレーニングまたは最適化プロセス中にモデルが一度も見たことのないデータを指し、モデルがトレーニング データを過学習しているかどうかをテストするために使用されます

論文を表示するには、次のリンクをクリックしてください: https://arxiv.org/pdf/2311.16452.pdf

以上がMicrosoft は、「プロンプト プロジェクト」だけで GPT-4 を医療専門家に変えました。十数種類の高度に微調整されたモデルにより、プロによるテスト精度が初めて 90% を超えましたの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7466

7466

15

15

1376

1376

52

52

77

77

11

11

18

18

19

19

オープンソース!ゾーイデプスを超えて! DepthFM: 高速かつ正確な単眼深度推定!

Apr 03, 2024 pm 12:04 PM

オープンソース!ゾーイデプスを超えて! DepthFM: 高速かつ正確な単眼深度推定!

Apr 03, 2024 pm 12:04 PM

0.この記事は何をするのですか?私たちは、多用途かつ高速な最先端の生成単眼深度推定モデルである DepthFM を提案します。従来の深度推定タスクに加えて、DepthFM は深度修復などの下流タスクでも最先端の機能を実証します。 DepthFM は効率的で、いくつかの推論ステップ内で深度マップを合成できます。この作品について一緒に読みましょう〜 1. 論文情報タイトル: DepthFM: FastMonocularDepthEstimationwithFlowMatching 著者: MingGui、JohannesS.Fischer、UlrichPrestel、PingchuanMa、Dmytr

世界で最も強力なオープンソース MoE モデルが登場。GPT-4 に匹敵する中国語機能を備え、価格は GPT-4-Turbo のわずか 1% 近くです

May 07, 2024 pm 04:13 PM

世界で最も強力なオープンソース MoE モデルが登場。GPT-4 に匹敵する中国語機能を備え、価格は GPT-4-Turbo のわずか 1% 近くです

May 07, 2024 pm 04:13 PM

従来のコンピューティングを超える能力を備えているだけでなく、より低コストでより効率的なパフォーマンスを実現する人工知能モデルを想像してみてください。これは SF ではありません。世界で最も強力なオープンソース MoE モデルである DeepSeek-V2[1] が登場しました。 DeepSeek-V2 は、経済的なトレーニングと効率的な推論の特徴を備えた強力な専門家混合 (MoE) 言語モデルです。これは 236B のパラメータで構成されており、そのうち 21B は各マーカーをアクティブにするために使用されます。 DeepSeek67B と比較して、DeepSeek-V2 はパフォーマンスが優れていると同時に、トレーニング コストを 42.5% 節約し、KV キャッシュを 93.3% 削減し、最大生成スループットを 5.76 倍に高めます。 DeepSeek は一般的な人工知能を研究する会社です

こんにちは、電気アトラスです!ボストン・ダイナミクスのロボットが復活、180度の奇妙な動きにマスク氏も恐怖

Apr 18, 2024 pm 07:58 PM

こんにちは、電気アトラスです!ボストン・ダイナミクスのロボットが復活、180度の奇妙な動きにマスク氏も恐怖

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas は正式に電動ロボットの時代に突入します!昨日、油圧式アトラスが歴史の舞台から「涙ながらに」撤退したばかりですが、今日、ボストン・ダイナミクスは電動式アトラスが稼働することを発表しました。ボストン・ダイナミクス社は商用人型ロボットの分野でテスラ社と競争する決意を持っているようだ。新しいビデオが公開されてから、わずか 10 時間ですでに 100 万人以上が視聴しました。古い人が去り、新しい役割が現れるのは歴史的な必然です。今年が人型ロボットの爆発的な年であることは間違いありません。ネットユーザーは「ロボットの進歩により、今年の開会式は人間のように見え、人間よりもはるかに自由度が高い。しかし、これは本当にホラー映画ではないのか?」とコメントした。ビデオの冒頭では、アトラスは仰向けに見えるように地面に静かに横たわっています。次に続くのは驚くべきことです

MLP に代わる KAN は、オープンソース プロジェクトによって畳み込みまで拡張されました

Jun 01, 2024 pm 10:03 PM

MLP に代わる KAN は、オープンソース プロジェクトによって畳み込みまで拡張されました

Jun 01, 2024 pm 10:03 PM

今月初め、MIT やその他の機関の研究者らは、MLP に代わる非常に有望な代替案である KAN を提案しました。 KAN は、精度と解釈可能性の点で MLP よりも優れています。また、非常に少数のパラメーターを使用して、多数のパラメーターを使用して実行する MLP よりも優れたパフォーマンスを発揮できます。たとえば、著者らは、KAN を使用して、より小規模なネットワークと高度な自動化で DeepMind の結果を再現したと述べています。具体的には、DeepMind の MLP には約 300,000 個のパラメーターがありますが、KAN には約 200 個のパラメーターしかありません。 KAN は、MLP が普遍近似定理に基づいているのに対し、KAN はコルモゴロフ-アーノルド表現定理に基づいているのと同様に、強力な数学的基礎を持っています。以下の図に示すように、KAN は

AI が数学研究を破壊する!フィールズ賞受賞者で中国系アメリカ人の数学者が上位 11 件の論文を主導 | テレンス・タオが「いいね!」しました

Apr 09, 2024 am 11:52 AM

AI が数学研究を破壊する!フィールズ賞受賞者で中国系アメリカ人の数学者が上位 11 件の論文を主導 | テレンス・タオが「いいね!」しました

Apr 09, 2024 am 11:52 AM

AI は確かに数学を変えつつあります。最近、この問題に細心の注意を払っている陶哲軒氏が『米国数学協会会報』(米国数学協会会報)の最新号を送ってくれた。 「機械は数学を変えるのか?」というテーマを中心に、多くの数学者が意見を述べ、そのプロセス全体は火花に満ち、ハードコアで刺激的でした。著者には、フィールズ賞受賞者のアクシャイ・ベンカテシュ氏、中国の数学者鄭楽軍氏、ニューヨーク大学のコンピューター科学者アーネスト・デイビス氏、その他業界で著名な学者を含む強力な顔ぶれが揃っている。 AI の世界は劇的に変化しています。これらの記事の多くは 1 年前に投稿されたものです。

iPhoneのセルラーデータインターネット速度が遅い:修正

May 03, 2024 pm 09:01 PM

iPhoneのセルラーデータインターネット速度が遅い:修正

May 03, 2024 pm 09:01 PM

iPhone のモバイル データ接続に遅延や遅い問題が発生していませんか?通常、携帯電話の携帯インターネットの強度は、地域、携帯ネットワークの種類、ローミングの種類などのいくつかの要因によって異なります。より高速で信頼性の高いセルラー インターネット接続を実現するためにできることがいくつかあります。解決策 1 – iPhone を強制的に再起動する 場合によっては、デバイスを強制的に再起動すると、携帯電話接続を含む多くの機能がリセットされるだけです。ステップ 1 – 音量を上げるキーを 1 回押して放します。次に、音量小キーを押して、もう一度放します。ステップ 2 – プロセスの次の部分は、右側のボタンを押し続けることです。 iPhone の再起動が完了するまで待ちます。セルラーデータを有効にし、ネットワーク速度を確認します。もう一度確認してください 修正 2 – データ モードを変更する 5G はより優れたネットワーク速度を提供しますが、信号が弱い場合はより適切に機能します

超知性の生命力が覚醒する!しかし、自己更新 AI の登場により、母親はデータのボトルネックを心配する必要がなくなりました。

Apr 29, 2024 pm 06:55 PM

超知性の生命力が覚醒する!しかし、自己更新 AI の登場により、母親はデータのボトルネックを心配する必要がなくなりました。

Apr 29, 2024 pm 06:55 PM

世界は狂ったように大きなモデルを構築していますが、インターネット上のデータだけではまったく不十分です。このトレーニング モデルは「ハンガー ゲーム」のようであり、世界中の AI 研究者は、データを貪欲に食べる人たちにどのように餌を与えるかを心配しています。この問題は、マルチモーダル タスクで特に顕著です。何もできなかった当時、中国人民大学学部のスタートアップチームは、独自の新しいモデルを使用して、中国で初めて「モデル生成データフィード自体」を実現しました。さらに、これは理解側と生成側の 2 つの側面からのアプローチであり、両方の側で高品質のマルチモーダルな新しいデータを生成し、モデル自体にデータのフィードバックを提供できます。モデルとは何ですか? Awaker 1.0 は、中関村フォーラムに登場したばかりの大型マルチモーダル モデルです。チームは誰ですか?ソフォンエンジン。人民大学ヒルハウス人工知能大学院の博士課程学生、ガオ・イージャオ氏によって設立されました。

アメリカ空軍が初のAI戦闘機を公開し注目を集める!大臣はプロセス全体を通じて干渉することなく個人的にテストを実施し、10万行のコードが21回にわたってテストされました。

May 07, 2024 pm 05:00 PM

アメリカ空軍が初のAI戦闘機を公開し注目を集める!大臣はプロセス全体を通じて干渉することなく個人的にテストを実施し、10万行のコードが21回にわたってテストされました。

May 07, 2024 pm 05:00 PM

最近、軍事界は、米軍戦闘機が AI を使用して完全自動空戦を完了できるようになったというニュースに圧倒されました。そう、つい最近、米軍のAI戦闘機が初めて公開され、その謎が明らかになりました。この戦闘機の正式名称は可変安定性飛行シミュレーター試験機(VISTA)で、アメリカ空軍長官が自ら飛行させ、一対一の空戦をシミュレートした。 5 月 2 日、フランク ケンダル米国空軍長官は X-62AVISTA でエドワーズ空軍基地を離陸しました。1 時間の飛行中、すべての飛行動作が AI によって自律的に完了されたことに注目してください。ケンダル氏は「過去数十年にわたり、私たちは自律型空対空戦闘の無限の可能性について考えてきたが、それは常に手の届かないものだと思われてきた」と語った。しかし今では、