Visual Transformer の深い理解、Visual Transformer の分析

この記事は自動運転ハート公開アカウントの許可を得て転載しています。転載する場合は出典元にご連絡ください。

前書き&&著者の個人的理解を

現在、Transformer 構造に基づくアルゴリズム モデルは、コンピューター ビジョン (CV) の分野に大きな影響を与えています。これらは、多くの基本的なコンピューター ビジョン タスクにおいて、以前の畳み込みニューラル ネットワーク (CNN) アルゴリズム モデルを上回っています。以下は、私が見つけたさまざまな基本的なコンピューター ビジョン タスクの最新の LeaderBoard ランキングです。LeaderBoard を通じて、さまざまなコンピューター ビジョン タスクにおける Transformer アルゴリズム モデルの優位性がわかります。

- 画像分類タスク

1 つ目は ImageNet の LeaderBoard で、上位 5 つのモデルのうち、各モデルは Transformer 構造を使用しており、CNN 構造は部分的にのみ使用されているか、Transformer と組み合わせられていることがリストからわかります。

画像分類タスクのリーダーボード

- オブジェクト検出タスク

次のステップは COCO テスト開発ですLeaderBoard のリストからわかるように、トップ 5 の半分以上は DETR などのアルゴリズム構造に基づいています。

ターゲット検出タスクのリーダーボード

ターゲット検出タスクのリーダーボード

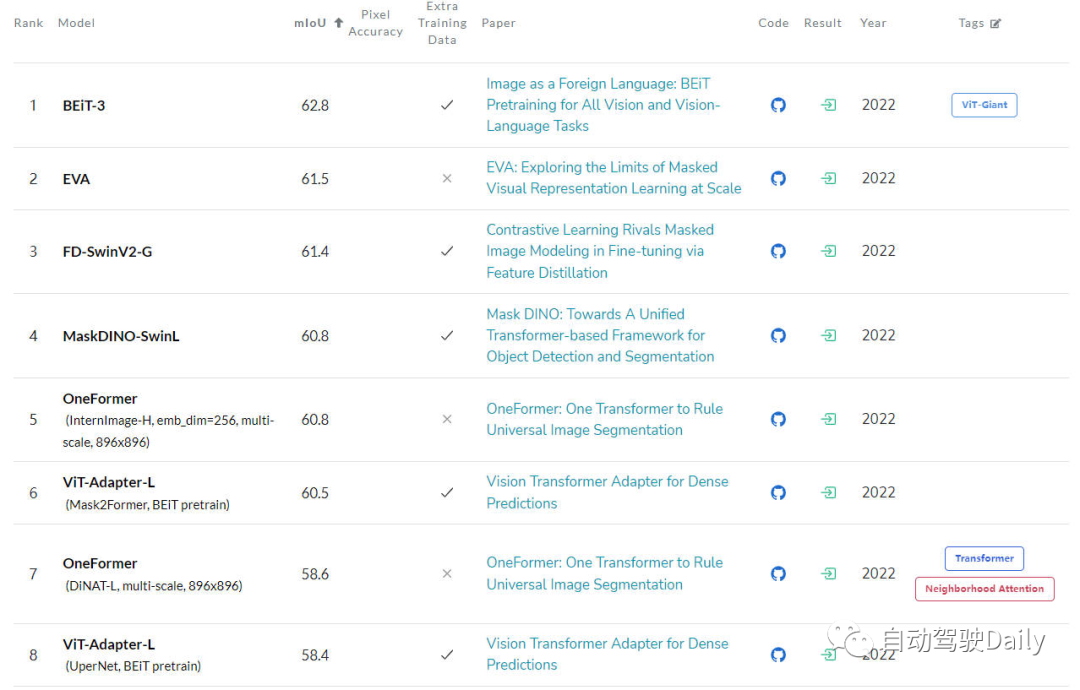

- セマンティック セグメンテーション タスク

最後は、ADE20K val の LeaderBoard です。リストを見てみる リストの上位数件のうち、トランスフォーマー構造が依然として現在の主力を占めていることがわかります。

セマンティック セグメンテーション タスク用のリーダーボード

セマンティック セグメンテーション タスク用のリーダーボード

Transformer は中国で大きな発展の可能性を示していますが、現在のコンピューター ビジョン コミュニティは Vision Transformer の内部動作原理を完全には理解していません。意思決定の根拠(予測結果の出力)が把握できていないため、解釈可能性の必要性が徐々に顕著になってきます。このようなモデルがどのように意思決定を行うかを理解することによってのみ、モデルのパフォーマンスを向上させ、人工知能システムに対する信頼を築くことができます。

この記事の主な目的は、Vision Transformer のさまざまな解釈方法を研究し、さまざまな研究に従ってそれらを比較することです。アルゴリズムの動機、構造タイプ、適用シナリオを分類してレビュー記事を形成します

ビジョン トランスフォーマーの分析

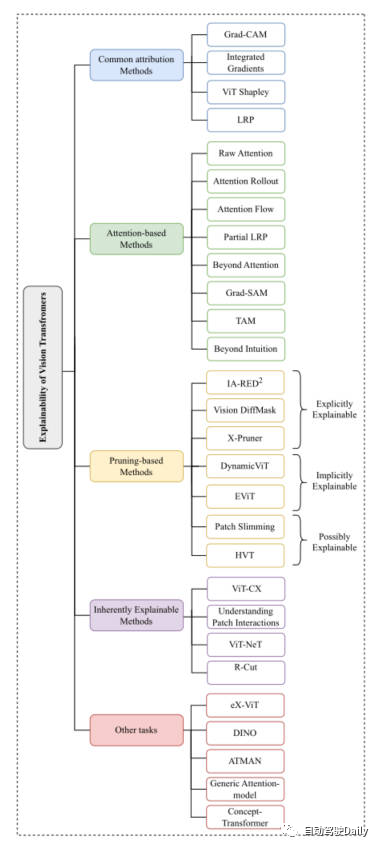

先ほど述べたように、ビジョン トランスフォーマーの構造は次のようになります。さまざまな基本的なコンピュータ ビジョン タスクで非常に良い結果を達成しました。コンピュータ ビジョン コミュニティでは、解釈可能性を高めるために非常に多くの方法が登場しています。この記事では、一般的なアトリビューション手法、アテンションベースの手法、プルーニングベースの手法、本質的に説明可能なものから始まる分類タスクに主に焦点を当てます。メソッド、その他のタスク これら 5 つの側面のうち、最新のタスクと古典的なタスクを選択して紹介します。論文に掲載されているマインド マップは次のとおりです。興味のある内容に基づいてさらに詳しく読むことができます~

この記事のマインド マップ

一般的なアトリビューション メソッド

属性ベースのメソッドの説明は、通常、モデルの入力特徴がどのように最終的な出力結果を徐々に取得するかというプロセスから始まります。このタイプの方法は、主にモデルの予測結果と入力特徴間の相関を測定するために使用されます。

これらの方法の中には、Grad-CAM や Integrated Gradients などがあります。アルゴリズム Visual Transformer に基づくアルゴリズムに直接適用されます。 SHAP や Layer-Wise Relevance Propagation (LRP) などの他の方法も、ViT ベースのアーキテクチャを調査するために使用されています。ただし、SHAP などの手法は計算コストが非常に高いため、最近の ViT Shapely アルゴリズムは、ViT 関連のアプリケーション研究に適応するように設計されました。

アテンションベースのメソッド

Vision Transformer は、アテンション メカニズムを通じて強力な特徴抽出機能を獲得します。注意に基づく解釈可能性手法の中でも、注意の重みの結果を視覚化することは非常に有効な手法です。この記事では、いくつかの視覚化テクニックを紹介します

- 生の注意力 : 名前が示すように、この方法は、ネットワーク モデルの中間層によって得られた注意力の重みマップを視覚化し、モデルの効果を分析することです。

- アテンション ロールアウト: このテクノロジーは、ネットワークのさまざまなレイヤーでアテンションの重みを拡張することにより、入力トークンから中間の埋め込みへの情報の転送を追跡します。

- アテンション フロー: このメソッドは、アテンション グラフをフロー ネットワークとして扱い、最大フロー アルゴリズムを使用して中間埋め込みから入力トークンまでの最大フロー値を計算します。

- partialLRP: この手法は、Vision Transformer のマルチヘッド アテンション メカニズムを視覚化するために提案されており、各アテンション ヘッドの重要性も考慮されています。

- Grad-SAM: この方法は、モデルの予測を説明するために元のアテンション行列のみに依存する制限を軽減するために使用され、研究者に元のアテンションの重みで勾配を使用するよう促します。

- 直感を超えて: この方法は、注意を説明する方法でもあり、注意の知覚と推論フィードバックの 2 段階が含まれます。

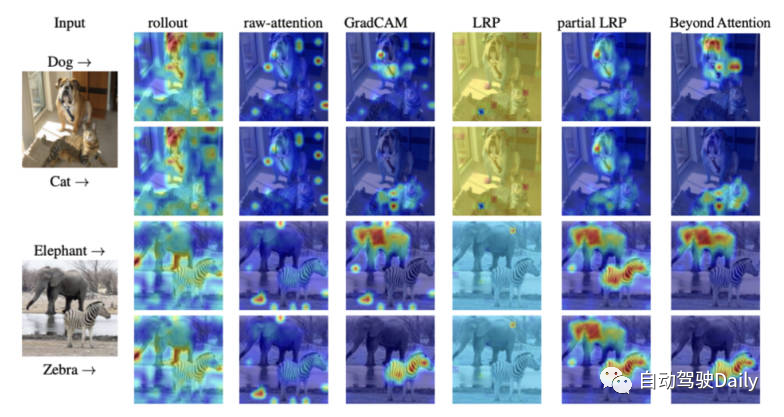

最後に、さまざまな解釈方法のアテンションの視覚化図を示します。さまざまな視覚化方法の違いを自分で感じてください。

さまざまな視覚化手法のアテンション マップの比較

プルーニング ベースの手法

プルーニングは、広く使用されている非常に効果的な手法です。変圧器構造の効率と複雑さを最適化します。枝刈り手法は、冗長な情報や無駄な情報を削除することで、モデルのパラメーターの数と計算の複雑さを軽減します。枝刈りアルゴリズムはモデルの計算効率の向上に重点を置いていますが、このタイプのアルゴリズムでもモデルの解釈可能性を実現できます。

この記事の Vision-Transformer に基づく枝刈り手法は、explicitly Explainable (明示的に説明可能)、implicitly Explainable (暗黙的に説明可能) の 3 つのカテゴリに大別できます。式は説明できる)、おそらく説明可能 (説明可能かもしれない)。

-

明示的に説明可能な

枝刈りベースのメソッドの中には、よりシンプルでより説明可能なモデルを提供できるメソッドがいくつかあります。

- IA-RED^2: この方法の目標は、計算効率とアルゴリズム モデルの解釈可能性の間の最適なバランスを達成することです。このプロセスでは、元の ViT アルゴリズム モデルの柔軟性が維持されます。

- X-Pruner: このメソッドは、特定のクラスでの寄与を予測する解釈可能な知覚マスクを作成することによって、顕著性ユニットを枝刈りするためのメソッドです。

- Vision DiffMask: このプルーニング メソッドには、各 ViT レイヤーにゲート メカニズムを追加することが含まれており、ゲート メカニズムを通じて、入力をシールドしながらモデルの出力を維持できます。さらに、アルゴリズム モデルは残りの画像のサブセットを明確にトリガーできるため、モデルの予測をより深く理解できるようになります。

-

暗黙的に説明可能

枝刈りベースの手法の中には、暗黙的説明可能性モデル カテゴリに分類できる古典的な手法もいくつかあります。 - 動的 ViT: この方法では、軽量の予測モジュールを使用して、現在の特性に基づいて各トークンの重要性を推定します。この軽量モジュールは、階層的な方法で冗長なトークンを取り除くために、ViT のさまざまなレイヤーに追加されます。最も重要なことは、この方法では、分類に最も寄与する重要な画像部分を徐々に特定することにより、解釈可能性が向上します。

- Efficient Vision Transformer (EViT): このメソッドの中心的なアイデアは、トークンを再編成することで EViT を高速化することです。 EViT は、アテンション スコアを計算することで、最も関連性の高いトークンを保持しながら、関連性の低いトークンを追加のトークンに融合します。同時に、EViT の解釈可能性を評価するために、論文の著者は複数の入力画像上でトークン認識プロセスを視覚化しました。

-

おそらく説明可能

このタイプの方法はもともと ViT の説明可能性を向上させることを目的としたものではありませんでしたが、このタイプの方法は、ViT に関するさらなる研究の多くの機会を提供します。モデルの説明可能性、大きな可能性。

- パッチスリム化: トップダウンのアプローチで画像内の冗長なパッチに焦点を当て、ViT を加速します。このアルゴリズムは、重要な視覚的特徴を強調表示するキー パッチの機能を選択的に保持するため、解釈可能性が向上します。

- 階層型ビジュアル トランスフォーマー (HVT): このメソッドは、ViT のスケーラビリティとパフォーマンスを強化するために導入されました。モデルの深さが増加するにつれて、シーケンスの長さは徐々に減少します。さらに、ViT ブロックを複数のステージに分割し、各ステージでプーリング演算を適用することで、計算効率が大幅に向上します。モデルの最も重要なコンポーネントに徐々に集中していることを考えると、解釈可能性と説明可能性の向上に対するその潜在的な影響を調査する機会があります。

本質的に説明可能なメソッド

さまざまな解釈可能なメソッドの中には、主にアルゴリズムを本質的に説明できるモデルを開発するメソッドのクラスがあります。ただし、これらのモデルは通常、ブラック ボックス モデルと同じレベルの精度。したがって、解釈可能性とパフォーマンスの間で慎重なバランスを考慮する必要があります。次に、いくつかの古典的な作品を簡単に紹介します。

- ViT-CX: この方法は、ViT モデル用にカスタマイズされたマスクベースの解釈方法です。このアプローチは、パッチの埋め込みとそれがモデル出力に与える影響に焦点を当てるのではなく、それらに依存しています。この方法は、マスク生成とマスク集約の 2 つの段階で構成されており、それにより、より意味のある顕著性マップが提供されます。

- ViT-NeT: このメソッドは、ツリー構造とプロトタイプを通じて意思決定プロセスを記述する新しいニューラル ツリー デコーダーです。同時に、このアルゴリズムにより、結果を視覚的に解釈することもできます。

- R-Cut: この方法は、関係の重み付けとカットを通じて ViT の解釈可能性を高めます。このメソッドには、Relationship Weighted Out モジュールと Cut モジュールという 2 つのモジュールが含まれています。前者は、中間層から特定のクラスの情報を抽出することに焦点を当て、関連する機能を強調します。後者は、きめの細かい特徴分解を実行します。両方のモジュールを統合することにより、高密度のクラス固有の解釈可能マップを生成できます。

その他のタスク

ViT ベースのアーキテクチャについては、探索における他のコンピュータ ビジョン タスクについても説明する必要があります。特に他のタスクを対象とした解釈可能性手法がいくつか提案されており、関連分野の最新の成果を以下に紹介します。

- eX-ViT: このアルゴリズムは、弱く監視されたセマンティック セグメンテーションに基づく、新しい解釈可能なビジュアル トランスフォーマーです。さらに、解釈可能性を向上させるために、グローバル レベルの属性指向損失、ローカル レベルの属性識別性損失、および属性多様性損失の 3 つの損失を含む属性指向損失モジュールが導入されます。前者はアテンション マップを使用して解釈可能な特徴を作成し、後者の 2 つは属性学習を強化します。

- DINO: このメソッドは、単純な自己教師ありメソッドであり、ラベルのない自己蒸留メソッドです。最終的に学習されたアテンション マップは、画像の意味領域を効果的に保持できるため、解釈可能な目的を達成できます。

- 汎用アテンション モデル: このメソッドは、Transformer アーキテクチャに基づく予測用のアルゴリズム モデルです。この方法は、最も一般的に使用される 3 つのアーキテクチャ、つまり純粋なセルフ アテンション、共同アテンションと組み合わせたセルフ アテンション、およびエンコーダ/デコーダ アテンションに適用されます。モデルの解釈可能性をテストするために、著者らは視覚的な質問応答タスクを使用しましたが、これは物体検出や画像セグメンテーションなどの他の CV タスクにも適用できます。

- ATMAN: これは、アテンション メカニズムを使用して、出力予測に対する入力の相関マップを生成する、モダリティに依存しない摂動手法です。このアプローチは、メモリ効率の高いアテンション操作を通じて変形予測を理解しようとします。

- Concept-Transformer: このアルゴリズムは、ユーザー定義の高レベルの概念の注意スコアを強調表示することによってモデル出力の説明を生成し、信頼性と信頼性を保証します。

将来の見通し

現在、Transformer アーキテクチャに基づくアルゴリズム モデルは、さまざまなコンピューター ビジョン タスクにおいて優れた結果を達成しています。ただし、現在、特に ViT アプリケーションにおいて、解釈可能性手法を使用してモデルのデバッグと改善を促進し、モデルの公平性と信頼性を向上させる方法に関する明確な研究が不足しています。読者がそのようなモデルのアーキテクチャをよりよく理解できるように、Vision Transformer に基づいて解釈可能性アルゴリズム モデルを分類および整理することです。皆様のお役に立てば幸いです。

What need to書き換えられる内容は次のとおりです: 元のリンク: https://mp.weixin.qq.com/s/URkobeRNB8dEYzrECaC7tQ

What need to書き換えられる内容は次のとおりです: 元のリンク: https://mp.weixin.qq.com/s/URkobeRNB8dEYzrECaC7tQ

以上がVisual Transformer の深い理解、Visual Transformer の分析の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7540

7540

15

15

1380

1380

52

52

83

83

11

11

21

21

86

86

世界で最も強力なオープンソース MoE モデルが登場。GPT-4 に匹敵する中国語機能を備え、価格は GPT-4-Turbo のわずか 1% 近くです

May 07, 2024 pm 04:13 PM

世界で最も強力なオープンソース MoE モデルが登場。GPT-4 に匹敵する中国語機能を備え、価格は GPT-4-Turbo のわずか 1% 近くです

May 07, 2024 pm 04:13 PM

従来のコンピューティングを超える能力を備えているだけでなく、より低コストでより効率的なパフォーマンスを実現する人工知能モデルを想像してみてください。これは SF ではありません。世界で最も強力なオープンソース MoE モデルである DeepSeek-V2[1] が登場しました。 DeepSeek-V2 は、経済的なトレーニングと効率的な推論の特徴を備えた強力な専門家混合 (MoE) 言語モデルです。これは 236B のパラメータで構成されており、そのうち 21B は各マーカーをアクティブにするために使用されます。 DeepSeek67B と比較して、DeepSeek-V2 はパフォーマンスが優れていると同時に、トレーニング コストを 42.5% 節約し、KV キャッシュを 93.3% 削減し、最大生成スループットを 5.76 倍に高めます。 DeepSeek は一般的な人工知能を研究する会社です

AI が数学研究を破壊する!フィールズ賞受賞者で中国系アメリカ人の数学者が上位 11 件の論文を主導 | テレンス・タオが「いいね!」しました

Apr 09, 2024 am 11:52 AM

AI が数学研究を破壊する!フィールズ賞受賞者で中国系アメリカ人の数学者が上位 11 件の論文を主導 | テレンス・タオが「いいね!」しました

Apr 09, 2024 am 11:52 AM

AI は確かに数学を変えつつあります。最近、この問題に細心の注意を払っている陶哲軒氏が『米国数学協会会報』(米国数学協会会報)の最新号を送ってくれた。 「機械は数学を変えるのか?」というテーマを中心に、多くの数学者が意見を述べ、そのプロセス全体は火花に満ち、ハードコアで刺激的でした。著者には、フィールズ賞受賞者のアクシャイ・ベンカテシュ氏、中国の数学者鄭楽軍氏、ニューヨーク大学のコンピューター科学者アーネスト・デイビス氏、その他業界で著名な学者を含む強力な顔ぶれが揃っている。 AI の世界は劇的に変化しています。これらの記事の多くは 1 年前に投稿されたものです。

ORB-SLAM3を超えて! SL-SLAM: 低照度、重度のジッター、弱いテクスチャのシーンはすべて処理されます。

May 30, 2024 am 09:35 AM

ORB-SLAM3を超えて! SL-SLAM: 低照度、重度のジッター、弱いテクスチャのシーンはすべて処理されます。

May 30, 2024 am 09:35 AM

以前に書きましたが、今日は、深層学習テクノロジーが複雑な環境におけるビジョンベースの SLAM (同時ローカリゼーションとマッピング) のパフォーマンスをどのように向上させることができるかについて説明します。ここでは、深部特徴抽出と深度マッチング手法を組み合わせることで、低照度条件、動的照明、テクスチャの弱い領域、激しいセックスなどの困難なシナリオでの適応を改善するように設計された多用途のハイブリッド ビジュアル SLAM システムを紹介します。当社のシステムは、拡張単眼、ステレオ、単眼慣性、ステレオ慣性構成を含む複数のモードをサポートしています。さらに、他の研究にインスピレーションを与えるために、ビジュアル SLAM と深層学習手法を組み合わせる方法も分析します。公開データセットと自己サンプリングデータに関する広範な実験を通じて、測位精度と追跡堅牢性の点で SL-SLAM の優位性を実証しました。

Google は大喜び: JAX のパフォーマンスが Pytorch や TensorFlow を上回りました! GPU 推論トレーニングの最速の選択肢となる可能性があります

Apr 01, 2024 pm 07:46 PM

Google は大喜び: JAX のパフォーマンスが Pytorch や TensorFlow を上回りました! GPU 推論トレーニングの最速の選択肢となる可能性があります

Apr 01, 2024 pm 07:46 PM

Google が推進する JAX のパフォーマンスは、最近のベンチマーク テストで Pytorch や TensorFlow のパフォーマンスを上回り、7 つの指標で 1 位にランクされました。また、テストは最高の JAX パフォーマンスを備えた TPU では行われませんでした。ただし、開発者の間では、依然として Tensorflow よりも Pytorch の方が人気があります。しかし、将来的には、おそらくより大規模なモデルが JAX プラットフォームに基づいてトレーニングされ、実行されるようになるでしょう。モデル 最近、Keras チームは、ネイティブ PyTorch 実装を使用して 3 つのバックエンド (TensorFlow、JAX、PyTorch) をベンチマークし、TensorFlow を使用して Keras2 をベンチマークしました。まず、主流のセットを選択します

こんにちは、電気アトラスです!ボストン・ダイナミクスのロボットが復活、180度の奇妙な動きにマスク氏も恐怖

Apr 18, 2024 pm 07:58 PM

こんにちは、電気アトラスです!ボストン・ダイナミクスのロボットが復活、180度の奇妙な動きにマスク氏も恐怖

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas は正式に電動ロボットの時代に突入します!昨日、油圧式アトラスが歴史の舞台から「涙ながらに」撤退したばかりですが、今日、ボストン・ダイナミクスは電動式アトラスが稼働することを発表しました。ボストン・ダイナミクス社は商用人型ロボットの分野でテスラ社と競争する決意を持っているようだ。新しいビデオが公開されてから、わずか 10 時間ですでに 100 万人以上が視聴しました。古い人が去り、新しい役割が現れるのは歴史的な必然です。今年が人型ロボットの爆発的な年であることは間違いありません。ネットユーザーは「ロボットの進歩により、今年の開会式は人間のように見え、人間よりもはるかに自由度が高い。しかし、これは本当にホラー映画ではないのか?」とコメントした。ビデオの冒頭では、アトラスは仰向けに見えるように地面に静かに横たわっています。次に続くのは驚くべきことです

MLP に代わる KAN は、オープンソース プロジェクトによって畳み込みまで拡張されました

Jun 01, 2024 pm 10:03 PM

MLP に代わる KAN は、オープンソース プロジェクトによって畳み込みまで拡張されました

Jun 01, 2024 pm 10:03 PM

今月初め、MIT やその他の機関の研究者らは、MLP に代わる非常に有望な代替案である KAN を提案しました。 KAN は、精度と解釈可能性の点で MLP よりも優れています。また、非常に少数のパラメーターを使用して、多数のパラメーターを使用して実行する MLP よりも優れたパフォーマンスを発揮できます。たとえば、著者らは、KAN を使用して、より小規模なネットワークと高度な自動化で DeepMind の結果を再現したと述べています。具体的には、DeepMind の MLP には約 300,000 個のパラメーターがありますが、KAN には約 200 個のパラメーターしかありません。 KAN は、MLP が普遍近似定理に基づいているのに対し、KAN はコルモゴロフ-アーノルド表現定理に基づいているのと同様に、強力な数学的基礎を持っています。以下の図に示すように、KAN は

テスラのロボットは工場で働く、マスク氏:手の自由度は今年22に達する!

May 06, 2024 pm 04:13 PM

テスラのロボットは工場で働く、マスク氏:手の自由度は今年22に達する!

May 06, 2024 pm 04:13 PM

テスラのロボット「オプティマス」の最新映像が公開され、すでに工場内で稼働可能となっている。通常の速度では、バッテリー(テスラの4680バッテリー)を次のように分類します:公式は、20倍の速度でどのように見えるかも公開しました - 小さな「ワークステーション」上で、ピッキング、ピッキング、ピッキング:今回は、それがリリースされたハイライトの1つビデオの内容は、オプティマスが工場内でこの作業を完全に自律的に行い、プロセス全体を通じて人間の介入なしに完了するというものです。そして、オプティマスの観点から見ると、自動エラー修正に重点を置いて、曲がったバッテリーを拾い上げたり配置したりすることもできます。オプティマスのハンドについては、NVIDIA の科学者ジム ファン氏が高く評価しました。オプティマスのハンドは、世界の 5 本指ロボットの 1 つです。最も器用。その手は触覚だけではありません

FisheyeDetNet: 魚眼カメラに基づいた最初のターゲット検出アルゴリズム

Apr 26, 2024 am 11:37 AM

FisheyeDetNet: 魚眼カメラに基づいた最初のターゲット検出アルゴリズム

Apr 26, 2024 am 11:37 AM

目標検出は自動運転システムにおいて比較的成熟した問題であり、その中でも歩行者検出は最も初期に導入されたアルゴリズムの 1 つです。ほとんどの論文では非常に包括的な研究が行われています。ただし、サラウンドビューに魚眼カメラを使用した距離認識については、あまり研究されていません。放射状の歪みが大きいため、標準のバウンディング ボックス表現を魚眼カメラに実装するのは困難です。上記の説明を軽減するために、拡張バウンディング ボックス、楕円、および一般的な多角形の設計を極/角度表現に探索し、これらの表現を分析するためのインスタンス セグメンテーション mIOU メトリックを定義します。提案された多角形モデルの FisheyeDetNet は、他のモデルよりも優れたパフォーマンスを示し、同時に自動運転用の Valeo 魚眼カメラ データセットで 49.5% の mAP を達成しました。