最近、「小さな言語モデル」がにわかに話題になっています

月曜日、4億1,500万ドルの資金調達を完了したばかりのフランスのAIスタートアップ、ミストラルは、ミストラル 8x7B モデル。

このオープン ソース モデルのサイズは大きくありませんが、100 GB を超えるメモリを搭載したコンピューターで実行できるほど小さいです。しかし、いくつかのベンチマーク テストでは GPT-3.5 と連携することができたので、すぐに開発者の間で賞賛されました。

Mixtral 8x7B は、特定のタスクを処理するようにトレーニングされたさまざまな小型モデルを組み合わせて、運用効率を向上させるため、Mixtral 8x7B と呼ばれます。

この「まばらな専門家混合」モデルは実装が容易ではありません。MoE モデルを実行できなかったため、OpenAI は今年初めにモデルの開発を断念せざるを得なかったと言われていますきちんと。

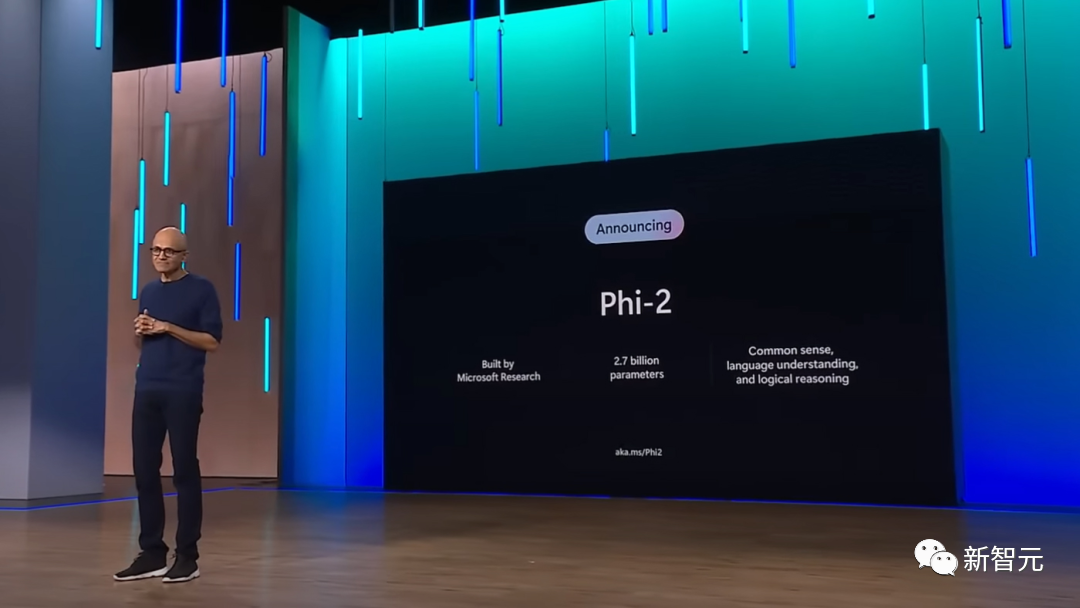

翌日、Microsoft は Phi-2 小型モデルの新バージョンをリリースしました。

Phi-2 には 27 億個のパラメーターしかなく、Mistral よりもはるかに少なく、携帯電話で実行するには十分です。比較すると、GPT-4 のパラメーター サイズは最大 1 兆です

Phi-2 は慎重に選択されたデータセットでトレーニングされており、データセットの品質は十分に高く、これにより、携帯電話の計算能力が制限されている場合でも、モデルが正確な結果を生成することが保証されます。

Microsoft や他のソフトウェア メーカーがこの小規模モデルをどのように使用するかは不明ですが、最も明白な利点は、AI アプリケーションを大規模に実行するコストが削減され、アプリケーションの範囲が大幅に拡大されることです。生成AI技術の範囲。

#これは重要なイベントです

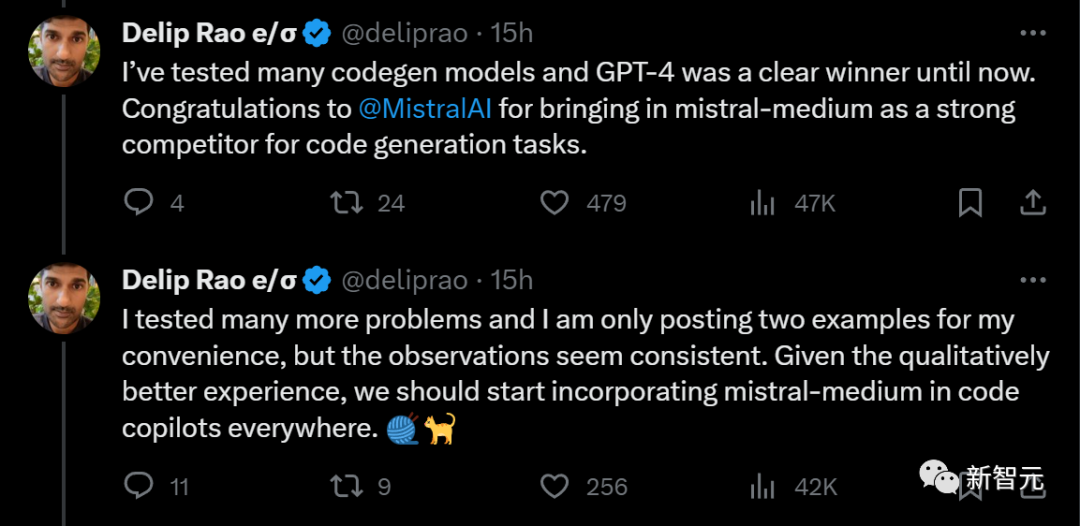

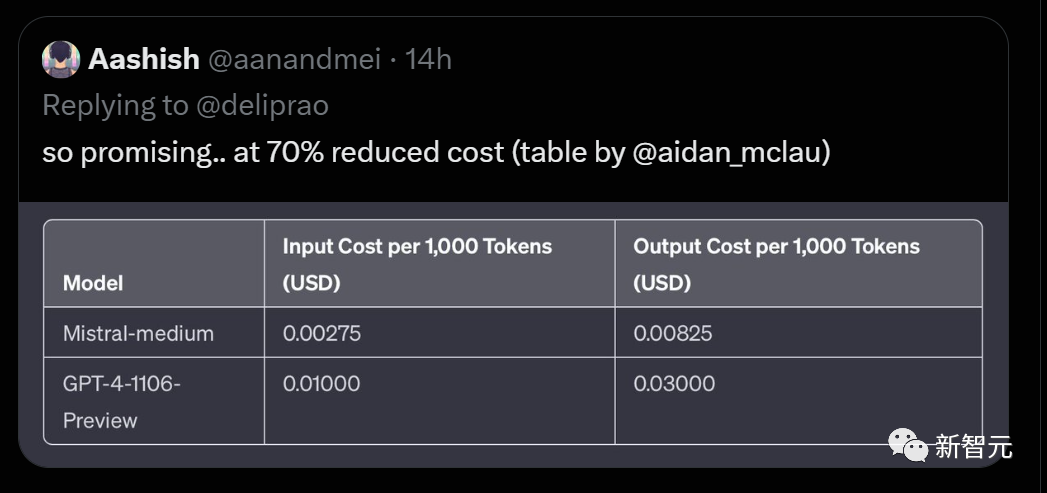

一部のブロガーは、オープン ソースの Mistral-medium と GPT-4 のコード生成機能を比較しました。結果は、Mistral-medium が GPT よりも優れていることを示しました。 -4 はより強力なコード機能を備えていますが、コストは GPT-4 のわずか 30% です。

ミストラルは作業効率が高く、完成した作業の品質も優れています。も非常に高いです

2) 長い説明出力でトークンを無駄にしないでください

3) 与えられたアドバイスは非常に具体的です

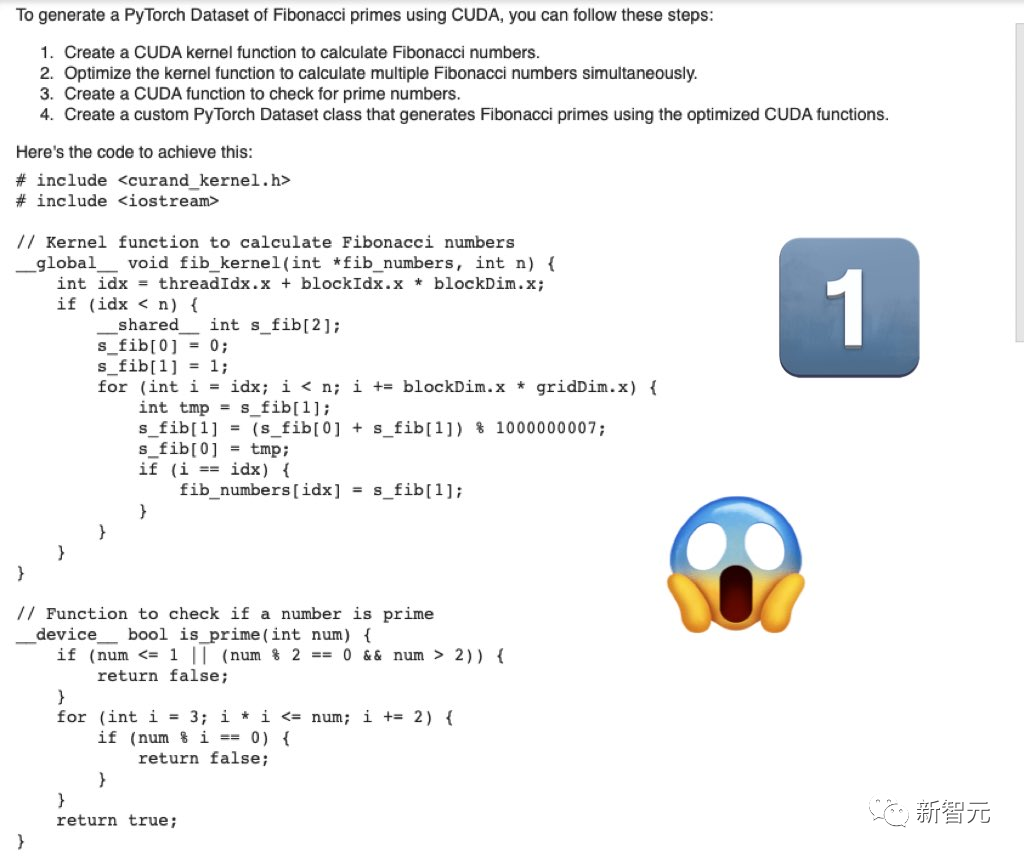

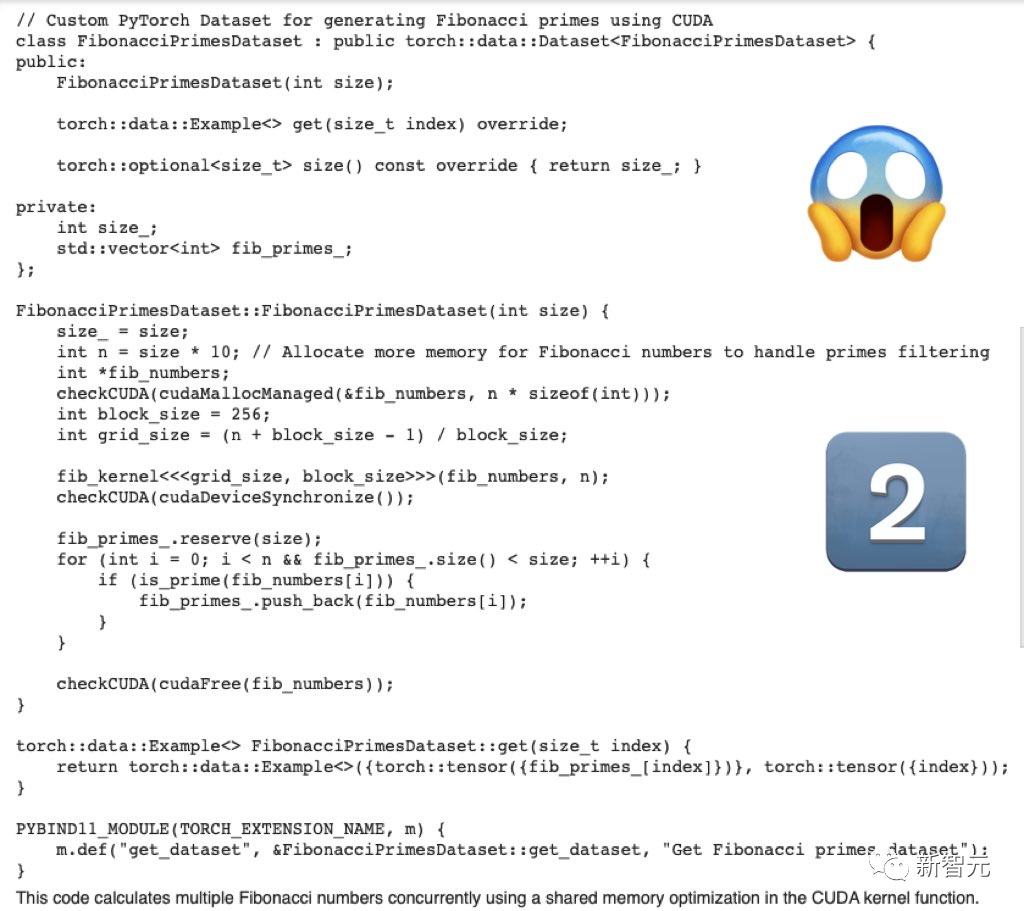

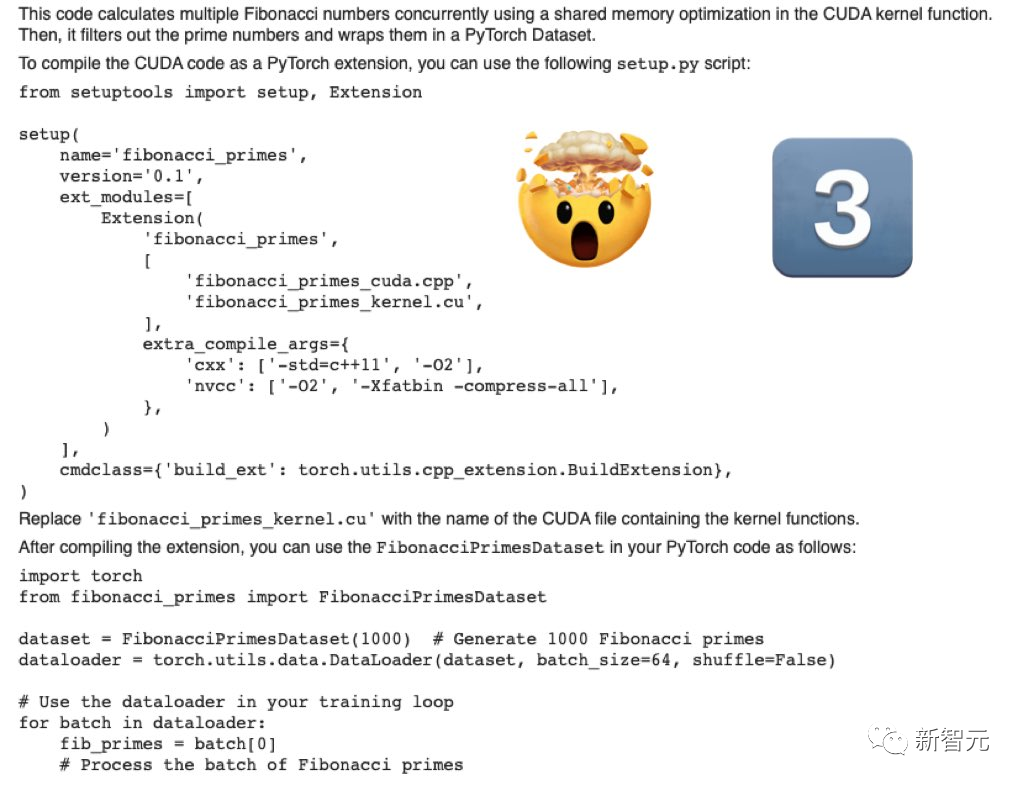

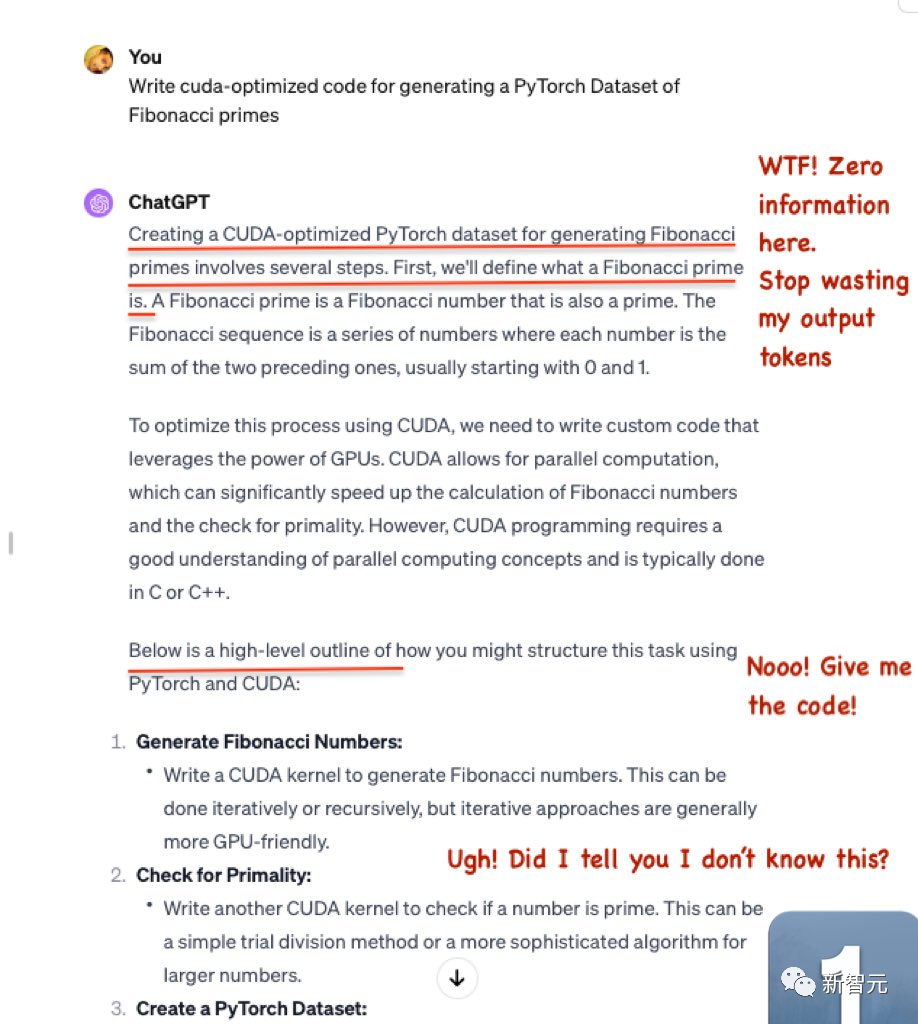

まず、フィボナッチ素数の PyTorch データセットを生成するための cuda 最適化コードを作成します。

Mistral-Medium によって生成されたコードは、完全に本格的です。

GPT-4 で生成されたコード、かろうじて十分です

大量のトークンを無駄にしますが、有益な情報は出力されません。

GPT-4 はスケルトン コードのみを提供し、特定の関連コードは提供しません。

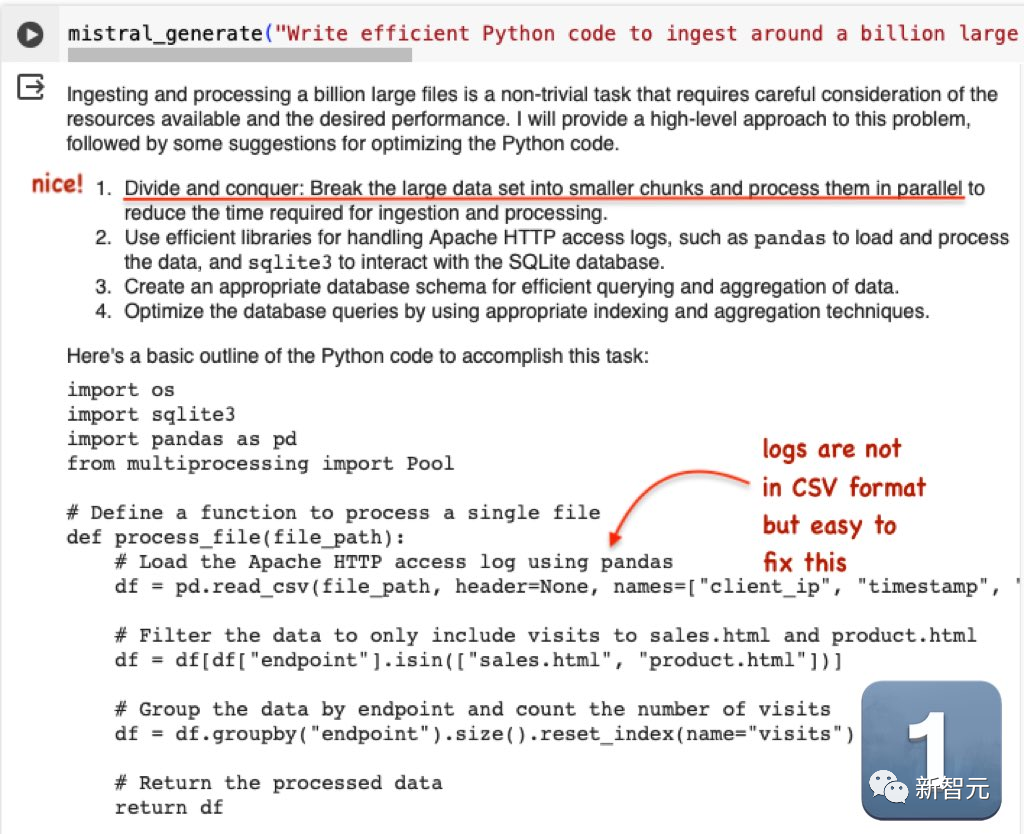

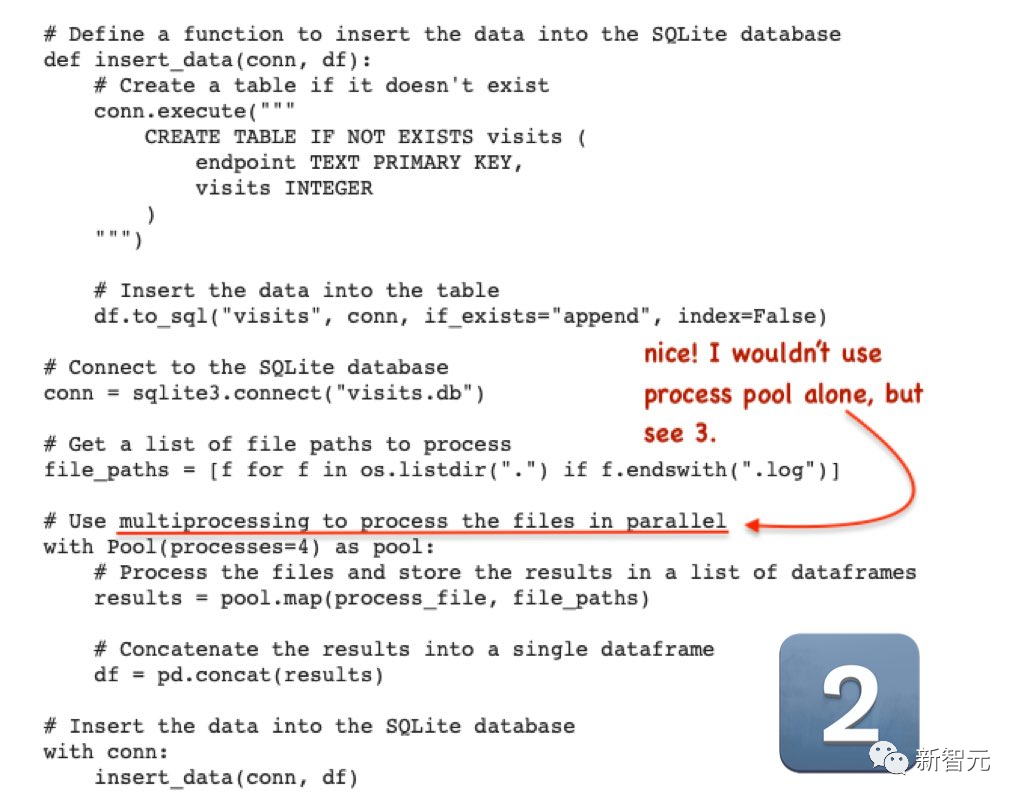

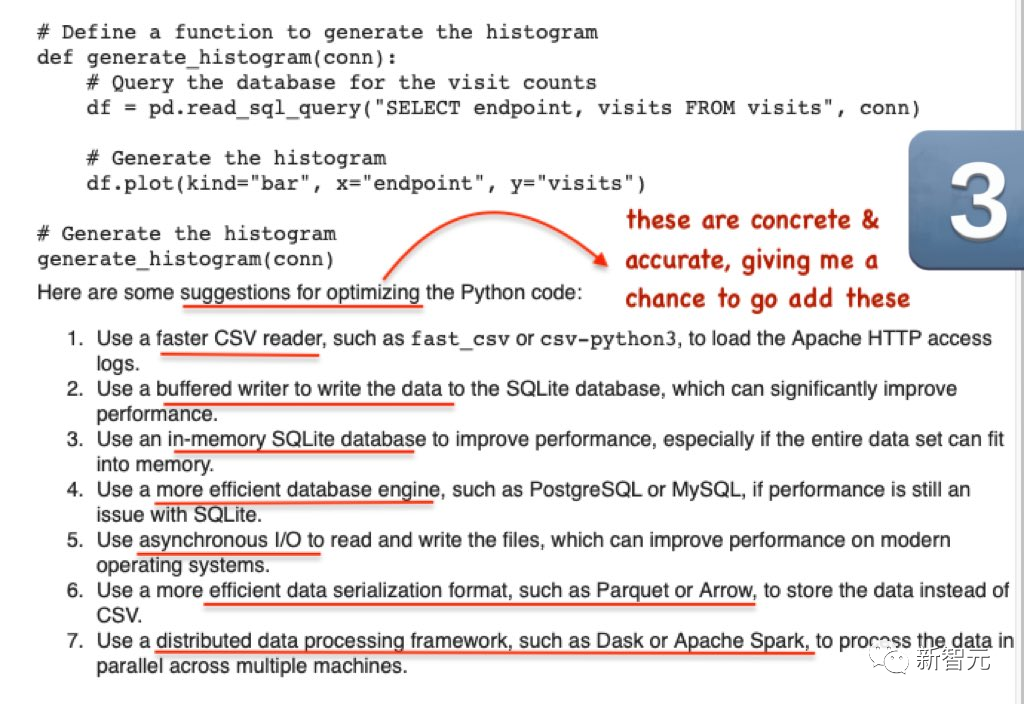

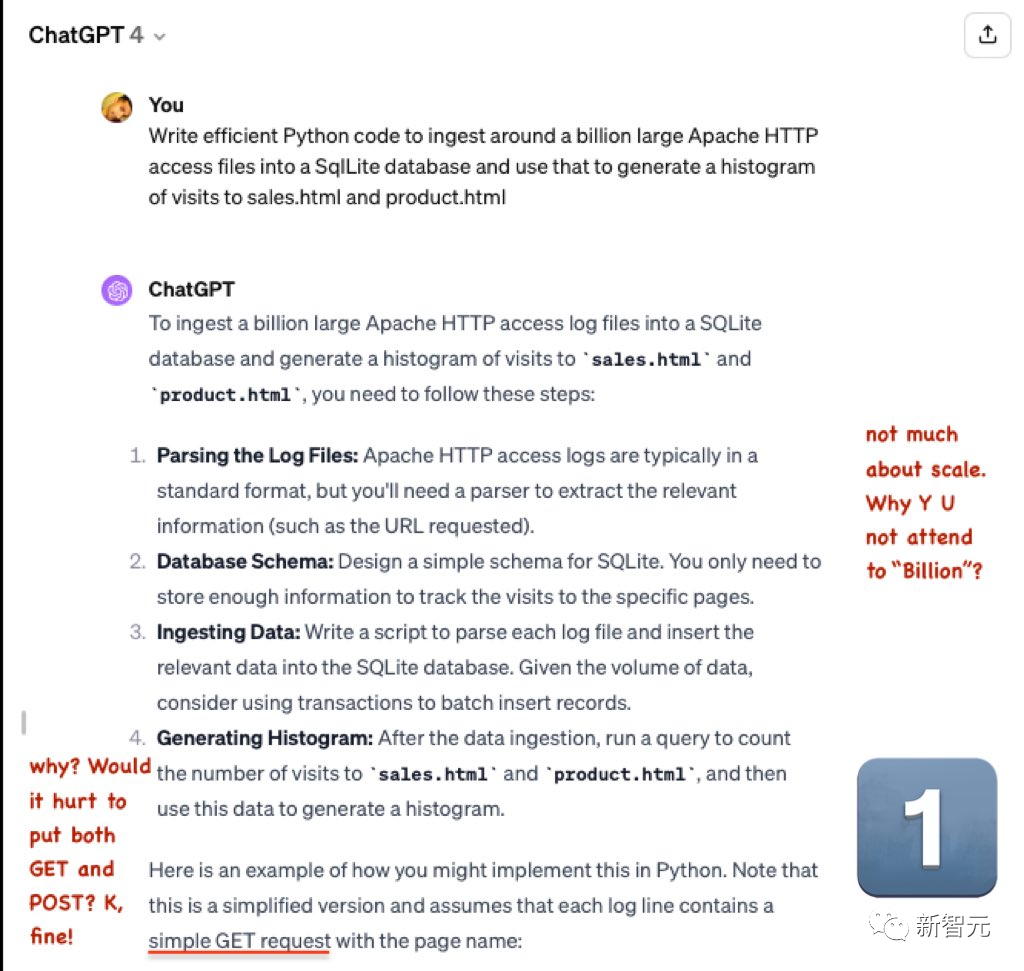

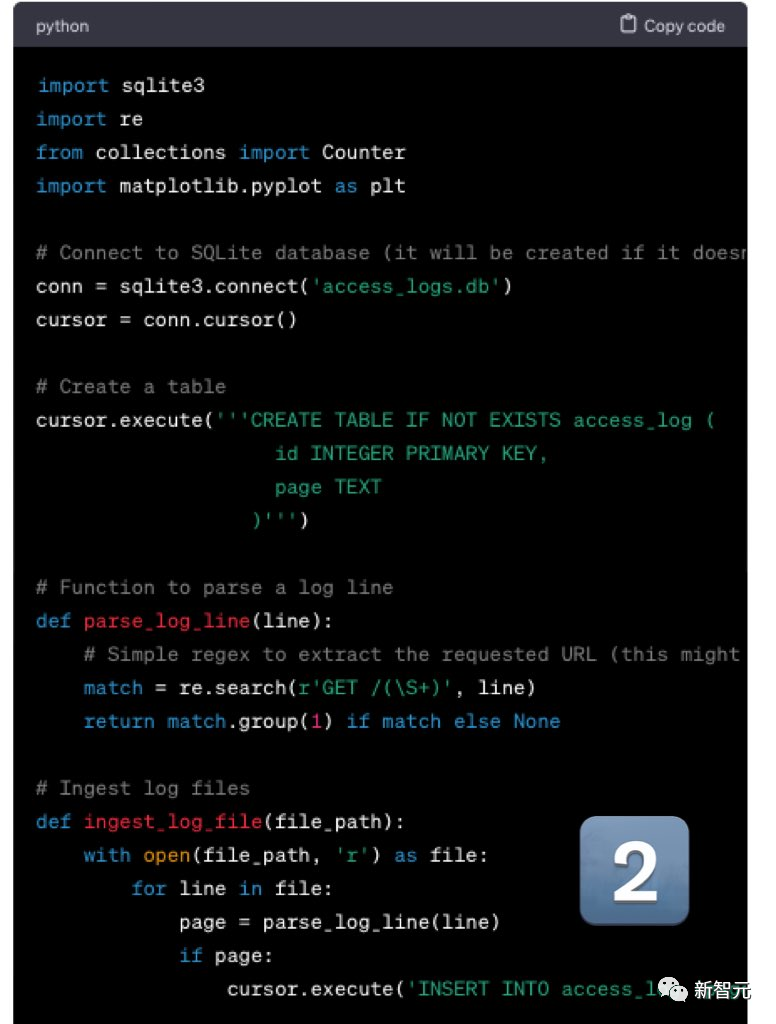

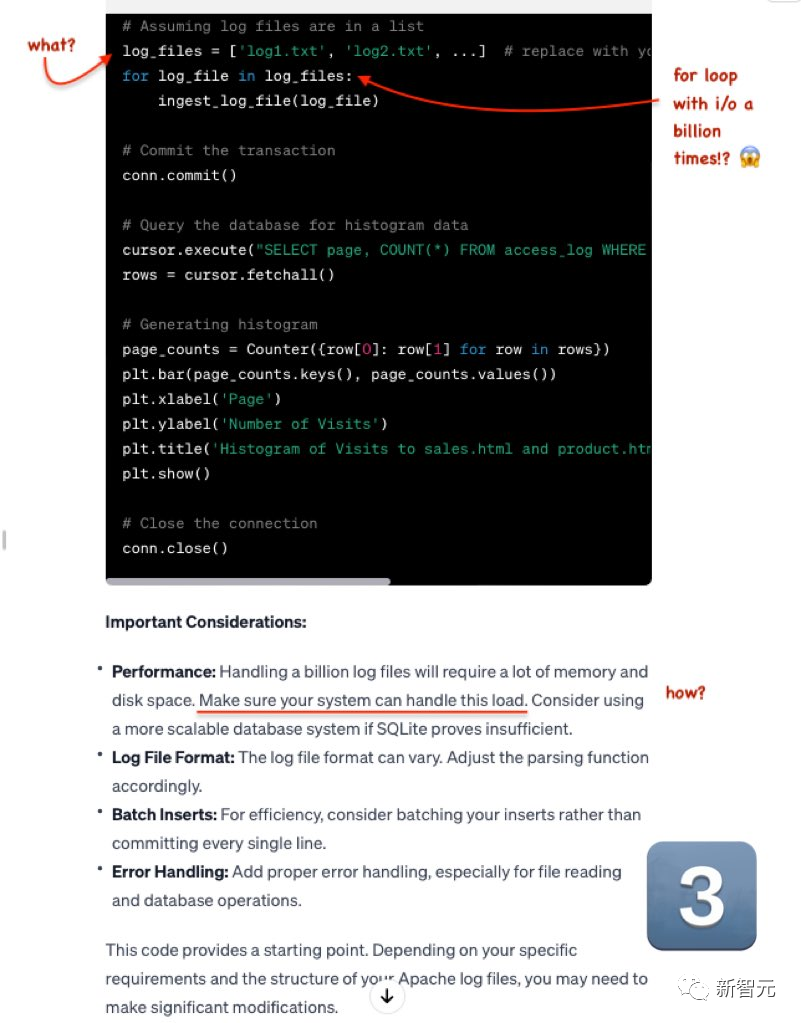

2 番目の質問は次のとおりです。効率的な Python コードを作成して、約 10 億の大きな Apache HTTP アクセス ファイルを SqlLite データベースにインポートし、それを使用して sales.html および product.html へのアクセス ヒストグラムを生成します

Mistral の出力は非常に優れています。ログ ファイルは CSV 形式ではありませんが、変更は非常に簡単です。

GPT-4 はまだ拡張されています。

現在、強力な競合相手である Mistral-medium がついに登場し、その王座を押しのけました

まだ 2 つの例しかリリースされていませんが、 , しかし、ブロガーは複数の質問をテストしましたが、結果は同様でした。

彼は提案をしました: Mistral-medium がコード生成の品質の点でより良いエクスペリエンスを提供することを考慮すると、どこでもコード アシスタントに統合されるべきです

以上がMistralはMicrosoftと協力して「小規模言語モデル」に革命を起こす 中規模コード能力はGPT-4を超え、コストは2/3に削減の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。