OpenAI がセキュリティ チームを強化し、危険な AI に拒否権を与える

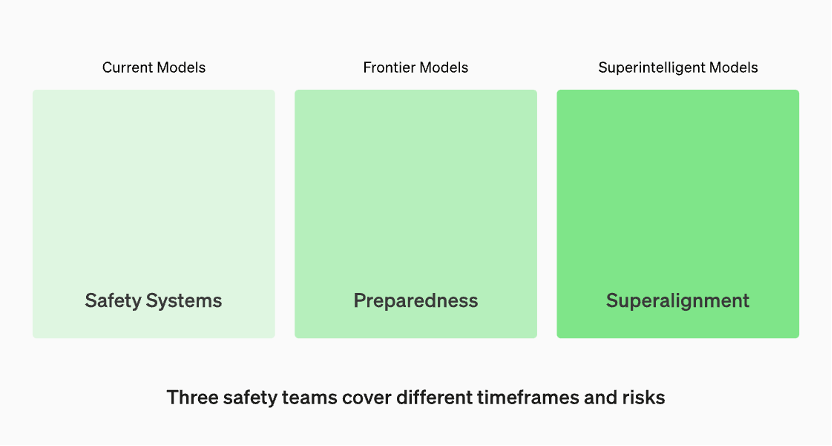

運用中のモデルは、「セキュリティ システム」チームによって管理されます。開発中の最先端モデルには、モデルがリリースされる前にリスクを特定して定量化する「準備」チームがいます。次に、「スーパー アライメント」チームがあり、「スーパー インテリジェンス」モデルの理論的ガイドラインに取り組んでいます。

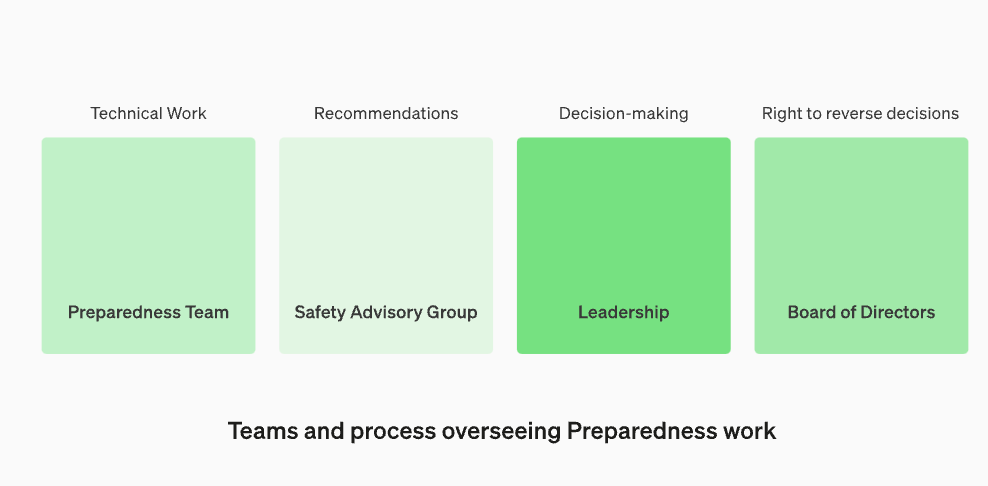

セキュリティ諮問グループを再編成し、技術チームの上に位置し、経営陣に勧告を行い、取締役会に拒否権を与えるOpenAI は、有害な人工知能の脅威から守るために、内部セキュリティ プロセスを強化していると発表しました。彼らは「セキュリティ諮問グループ」と呼ばれる新しい部門を創設し、テクノロジーチームの上に位置し、経営陣にアドバイスを提供し、取締役会の拒否権を与える予定だ。この決定は現地時間 12 月 18 日に発表されました

このアップデートが懸念を引き起こしているのは、OpenAI CEO の Sam Altman が取締役会によって解任されたことが主な理由であり、これは大規模モデルのセキュリティ問題に関連しているようです。 OpenAI取締役会の2人の「失速」メンバー、イリヤ・サツクビ氏とヘレン・トナー氏が、ハイレベルの刷新を受けて取締役の座を失った

この投稿では、OpenAI が、ますます強力になるモデルによってもたらされる壊滅的なリスクを OpenAI がどのように追跡、評価、予測し、防御するのかについて、最新の「準備フレームワーク」について説明します。壊滅的リスクの定義は何ですか? OpenAI は、「私たちが壊滅的リスクと呼んでいるものは、数千億ドルの経済損失をもたらしたり、多くの人に重傷を負わせたり死亡させたりする可能性のあるリスクを指します。これには存続リスクも含まれますが、これに限定されません。」

OpenAI 公式 Web サイトの情報によると、運用中のモデルは「セキュリティ システム」チームによって管理されています。開発段階では、モデルのリリース前にリスクを特定し評価する「準備」と呼ばれるチームが存在します。さらに、「スーパーアライメント」と呼ばれるチームがあり、「超インテリジェント」モデルの理論的ガイドラインに取り組んでいます。

OpenAI チームは、サイバーセキュリティ、説得力 (偽情報など)、モデルの自律性 (自律的に行動する能力)、CBRN (化学的、生物学的、放射性物質、核の脅威など) の 4 つのリスク カテゴリに従って各モデルを評価します。新しい病原体を作り出す能力)

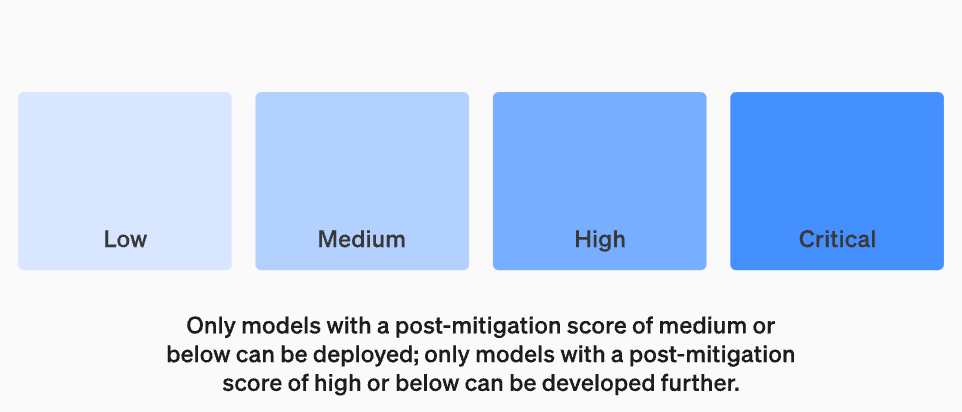

OpenAI は、その仮定においてさまざまな緩和策を考慮しています。たとえば、モデルはナパーム弾やパイプ爆弾の製造プロセスの記述について合理的な留保を維持しています。既知の緩和策を考慮した後でもモデルが「高」リスクがあると評価された場合、そのモデルは導入されません。また、モデルに「重大な」リスクがある場合、それ以上開発されません

モデルを作成する人全員が、モデルを評価して推奨事項を作成するのに最適な人物であるとは限りません。このため、OpenAIは「機能横断型セキュリティ諮問グループ」と呼ばれるチームを設立し、研究者の報告書を技術レベルから検討し、より高い視点からの提言を行い、「未知の部分」の一部を明らかにしたいと考えている。 「 」

このプロセスでは、これらの推奨事項が取締役会と経営陣の両方に送信され、業務を継続するか停止するかを決定する必要がありますが、取締役会にはそれらの決定を取り消す権限があります。これにより、リスクの高い製品やプロセスが取締役会の知らないうちに承認されることを防ぎます

しかし、外部の世界は依然として、専門委員会が勧告を出し、その情報に基づいて CEO が決定を下した場合、OpenAI の取締役会には本当に反論して行動を起こす権利があるのだろうか、と懸念しています。もしそうなら、一般の人々はそれについて聞くでしょうか?現在、独立した第三者監査を求めるという OpenAI の約束を除けば、その透明性の問題は実際には真に対処されていません。

OpenAI の「Readiness Framework」には、次の 5 つの重要な要素が含まれています。

1. 評価と採点私たちはモデルを評価し、「スコアカード」を継続的に更新します。トレーニング中の効率的な計算を 3 倍にするなど、すべての最先端のモデルを評価します。私たちはモデルの限界を押し広げます。これらの調査結果は、最新モデルのリスクを評価し、提案された緩和策の有効性を測定するのに役立ちます。私たちの目標は、エッジ特有の不安を検出してリスクを効果的に軽減することです。モデルの安全性レベルを追跡するために、リスク「スコアカード」と詳細なレポートを作成します

すべての最先端モデルを評価するには、「スコアカード」が必要です

リスクしきい値を設定する目的は、意思決定を行ってリスクを管理する際に明確な境界線を持つことです。リスクしきい値とは、組織または個人が特定の状況下で許容するリスクの最大レベルを指します。リスクのしきい値を設定すると、組織や個人がリスクを軽減または回避するためにいつ行動が必要かを特定できるようになります。リスクしきい値の設定は、リスク評価の結果、関連する規制やポリシー、組織または個人のリスク許容度に基づいて行う必要があります。リスクしきい値を設定するときは、リスク管理手段の有効性と適用性を確保するために、さまざまなリスクの種類の特性と影響を考慮する必要があります。最後に、組織または個人のリスク管理目標との一貫性を保つために、設定されたリスクしきい値を定期的に評価および調整する必要があります。

セキュリティ対策を発動するリスクしきい値を設定します。当社は、サイバーセキュリティ、CBRN (化学、生物学、放射線、核の脅威)、説得、およびモデルの自律性という予備的な追跡カテゴリに基づいて、リスク レベルのしきい値を設定します。 4 つのセキュリティ リスク レベルを指定し、緩和後のスコアが「中」以下のモデルのみをデプロイでき、緩和後のスコアが「高」以下のモデルのみをさらに開発できます。高いリスクまたは重大なリスク (事前緩和) を持つモデルについては、追加のセキュリティ対策も実装します

技術作業と安全に関する意思決定を監督するための運営体制を再設定する

当社は、セキュリティに関する意思決定の技術的な作業と運用構造を監督する専門チームを設立します。準備チームは、最先端モデルの機能の限界を調査し、評価と包括的なレポートを実施するための技術的な作業を推進します。この技術的な作業は、OpenAI セキュリティ モデルの開発と展開の決定にとって重要です。私たちはすべての報告書を検討し、経営陣と取締役会の両方に報告するために、部門横断的なセキュリティ諮問グループを設立しています。意思決定者はリーダーシップですが、取締役会は決定を覆す権限を持っています

セキュリティの強化と対外的な説明責任の強化

私たちは、安全性と外部の説明責任を向上させるためのプロトコルを開発します。当社は定期的にセキュリティ訓練を実施し、当社のビジネスと当社の文化をストレステストします。一部のセキュリティ問題はすぐに発生する可能性があるため、緊急の問題にフラグを立てて迅速に対応することができます。 OpenAI 外部の人々からフィードバックを受け取り、資格のある独立した第三者によるレビューを受けることが有益であると私たちは信じています。今後も他のメンバーにレッド チームを形成してもらい、モデルを評価してもらい、更新情報を外部に共有する予定です

その他の既知および未知のセキュリティ リスクを軽減します:

当社は、その他の既知および未知のセキュリティ リスクの軽減を支援します。私たちは外部関係者と緊密に連携するだけでなく、セキュリティ システムなどの社内チームと緊密に連携して、実際の不正行為を追跡していきます。また、スーパーアライメントと協力して、緊急のミスアライメントのリスクを追跡します。また、スケールの法則で以前に成功したのと同様に、モデルのスケールに応じてリスクがどのように進化するかを測定し、リスクを事前に予測するのに役立つ新しい研究も開拓しています。最後に、私たちは継続的なプロセスに取り組み、新たな「未知の未知の問題」を解決しようとします。

以上がOpenAI がセキュリティ チームを強化し、危険な AI に拒否権を与えるの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7467

7467

15

15

1376

1376

52

52

77

77

11

11

18

18

19

19

データに最適なエンベディング モデルの選択: OpenAI とオープンソースの多言語エンベディングの比較テスト

Feb 26, 2024 pm 06:10 PM

データに最適なエンベディング モデルの選択: OpenAI とオープンソースの多言語エンベディングの比較テスト

Feb 26, 2024 pm 06:10 PM

OpenAI は最近、最新世代の埋め込みモデル embeddingv3 のリリースを発表しました。これは、より高い多言語パフォーマンスを備えた最もパフォーマンスの高い埋め込みモデルであると主張しています。このモデルのバッチは、小さい text-embeddings-3-small と、より強力で大きい text-embeddings-3-large の 2 つのタイプに分類されます。これらのモデルがどのように設計され、トレーニングされるかについてはほとんど情報が開示されておらず、モデルには有料 API を介してのみアクセスできます。オープンソースの組み込みモデルは数多くありますが、これらのオープンソース モデルは OpenAI のクローズド ソース モデルとどう違うのでしょうか?この記事では、これらの新しいモデルのパフォーマンスをオープンソース モデルと実証的に比較します。データを作成する予定です

Spring Boot と OpenAI の出会いによる新しいプログラミング パラダイム

Feb 01, 2024 pm 09:18 PM

Spring Boot と OpenAI の出会いによる新しいプログラミング パラダイム

Feb 01, 2024 pm 09:18 PM

2023年、AI技術が注目を集め、プログラミング分野を中心にさまざまな業界に大きな影響を与えています。 AI テクノロジーの重要性に対する人々の認識はますます高まっており、Spring コミュニティも例外ではありません。 GenAI (汎用人工知能) テクノロジーの継続的な進歩に伴い、AI 機能を備えたアプリケーションの作成を簡素化することが重要かつ緊急になっています。このような背景から、AI 機能アプリケーションの開発プロセスを簡素化し、シンプルかつ直観的にし、不必要な複雑さを回避することを目的とした「SpringAI」が登場しました。 「SpringAI」により、開発者はAI機能を搭載したアプリケーションをより簡単に構築でき、使いやすく、操作しやすくなります。

OpenAI Super Alignment チームの遺作: 2 つの大きなモデルがゲームをプレイし、出力がより理解しやすくなる

Jul 19, 2024 am 01:29 AM

OpenAI Super Alignment チームの遺作: 2 つの大きなモデルがゲームをプレイし、出力がより理解しやすくなる

Jul 19, 2024 am 01:29 AM

AIモデルによって与えられた答えがまったく理解できない場合、あなたはそれをあえて使用しますか?機械学習システムがより重要な分野で使用されるにつれて、なぜその出力を信頼できるのか、またどのような場合に信頼してはいけないのかを実証することがますます重要になっています。複雑なシステムの出力に対する信頼を得る方法の 1 つは、人間または他の信頼できるシステムが読み取れる、つまり、考えられるエラーが発生する可能性がある点まで完全に理解できる、その出力の解釈を生成することをシステムに要求することです。見つかった。たとえば、司法制度に対する信頼を築くために、裁判所に対し、決定を説明し裏付ける明確で読みやすい書面による意見を提供することを求めています。大規模な言語モデルの場合も、同様のアプローチを採用できます。ただし、このアプローチを採用する場合は、言語モデルが

Rust ベースの Zed エディターはオープンソース化されており、OpenAI と GitHub Copilot のサポートが組み込まれています

Feb 01, 2024 pm 02:51 PM

Rust ベースの Zed エディターはオープンソース化されており、OpenAI と GitHub Copilot のサポートが組み込まれています

Feb 01, 2024 pm 02:51 PM

著者丨コンパイル: TimAnderson丨プロデュース: Noah|51CTO Technology Stack (WeChat ID: blog51cto) Zed エディター プロジェクトはまだプレリリース段階にあり、AGPL、GPL、および Apache ライセンスの下でオープンソース化されています。このエディターは高性能と複数の AI 支援オプションを備えていますが、現在は Mac プラットフォームでのみ利用可能です。 Nathan Sobo 氏は投稿の中で、GitHub 上の Zed プロジェクトのコード ベースでは、エディター部分は GPL に基づいてライセンスされ、サーバー側コンポーネントは AGPL に基づいてライセンスされ、GPUI (GPU Accelerated User) インターフェイス部分はApache2.0ライセンス。 GPUI は Zed チームによって開発された製品です

OpenAI を待つのではなく、Open-Sora が完全にオープンソースになるのを待ちましょう

Mar 18, 2024 pm 08:40 PM

OpenAI を待つのではなく、Open-Sora が完全にオープンソースになるのを待ちましょう

Mar 18, 2024 pm 08:40 PM

少し前まで、OpenAISora はその驚くべきビデオ生成効果で急速に人気を博し、数ある文学ビデオ モデルの中でも際立って世界的な注目を集めるようになりました。 2 週間前にコストを 46% 削減した Sora トレーニング推論再現プロセスの開始に続き、Colossal-AI チームは世界初の Sora のようなアーキテクチャのビデオ生成モデル「Open-Sora1.0」を完全にオープンソース化し、全体をカバーしました。データ処理、すべてのトレーニングの詳細、モデルの重みを含むトレーニング プロセスを管理し、世界中の AI 愛好家と協力してビデオ作成の新時代を推進します。ちょっと覗いてみましょう。Colossal-AI チームがリリースした「Open-Sora1.0」モデルによって生成された賑やかな街のビデオを見てみましょう。オープンソラ1.0

Embedding サービスのローカル実行パフォーマンスは OpenAI Text-Embedding-Ada-002 を上回っており、とても便利です。

Apr 15, 2024 am 09:01 AM

Embedding サービスのローカル実行パフォーマンスは OpenAI Text-Embedding-Ada-002 を上回っており、とても便利です。

Apr 15, 2024 am 09:01 AM

Ollama は、Llama2、Mistral、Gemma などのオープンソース モデルをローカルで簡単に実行できるようにする非常に実用的なツールです。この記事では、Ollamaを使ってテキストをベクトル化する方法を紹介します。 Ollama をローカルにインストールしていない場合は、この記事を読んでください。この記事では、nomic-embed-text[2] モデルを使用します。これは、短いコンテキストおよび長いコンテキストのタスクにおいて OpenAI text-embedding-ada-002 および text-embedding-3-small よりも優れたパフォーマンスを発揮するテキスト エンコーダーです。 o が正常にインストールされたら、nomic-embed-text サービスを開始します。

マイクロソフトとOpenAIは人型ロボットに1億ドル投資する計画!ネチズンはマスク氏に電話をかけている

Feb 01, 2024 am 11:18 AM

マイクロソフトとOpenAIは人型ロボットに1億ドル投資する計画!ネチズンはマスク氏に電話をかけている

Feb 01, 2024 am 11:18 AM

MicrosoftとOpenAIが人型ロボットのスタートアップに巨額の資金を投資していることが年初に明らかになった。このうちマイクロソフトは9500万ドル、OpenAIは500万ドルを投資する予定だ。ブルームバーグによると、同社は今回のラウンドで総額5億米ドルを調達する予定で、資金調達前の評価額は19億米ドルに達する可能性がある。何が彼らを惹きつけるのでしょうか?まずはこの会社のロボット分野の実績を見てみましょう。このロボットはすべて銀と黒で、その外観はハリウッドの SF 大作映画に登場するロボットのイメージに似ています。今、彼はコーヒー カプセルをコーヒー マシンに入れています。正しく置かれていない場合でも、何もせずに自動的に調整されます。人間リモコン: ただし、しばらくすると、コーヒーを持ち帰って楽しむことができます: 家族にそれを認識した人はいますか? はい、このロボットは少し前に作成されました。

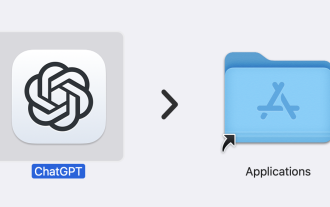

専用アプリのリリースにより、ChatGPT が macOS で利用可能になりました

Jun 27, 2024 am 10:05 AM

専用アプリのリリースにより、ChatGPT が macOS で利用可能になりました

Jun 27, 2024 am 10:05 AM

Open AI の ChatGPT Mac アプリケーションは、ここ数か月間 ChatGPT Plus サブスクリプションを持つユーザーのみに限定されていましたが、現在は誰でも利用できるようになりました。最新の Apple S を持っている限り、アプリは他のネイティブ Mac アプリと同じようにインストールされます。