効率的なデータ クローリング テクノロジーをマスターする: 強力な Java クローラーを構築する

強力な Java クローラーの構築: これらのテクノロジーを習得して効率的なデータ クローリングを実現するには、特定のコード例が必要です

1. はじめに

インターネットの急速な発展に伴い、データ リソースが豊富にあるため、Web ページからデータをクロールする必要があるアプリケーション シナリオがますます増えています。 Java は強力なプログラミング言語として、独自の Web クローラー開発フレームワークと豊富なサードパーティ ライブラリを備えているため、理想的な選択肢となっています。この記事では、Java を使用して強力な Web クローラーを構築する方法を説明し、具体的なコード例を示します。

2. Web クローラーの基礎知識

- Web クローラーとは何ですか?

Web クローラーは、インターネット上で Web ページを閲覧する人間の動作をシミュレートし、Web ページから必要なデータを取得する自動プログラムです。クローラーは、特定のルールに従って Web ページからデータを抽出し、ローカルに保存するか、さらに処理します。 - クローラーの動作原理

クローラーの動作原理は、次のステップに大別できます。 - HTTP リクエストを送信して Web ページのコンテンツを取得します。

- ページを解析し、必要なデータを抽出します。

- 保管またはその他のさらなる処理用。

3. Java クローラー開発フレームワーク

Java には、Web クローラーの開発に使用できる開発フレームワークが多数ありますが、よく使用される 2 つのフレームワークを以下に紹介します。

- Jsoup

Jsoup は、HTML を解析、走査、操作するための Java ライブラリです。これは、HTML からのデータ抽出を非常に簡単にする柔軟な API と便利なセレクターを提供します。以下は、データ抽出に Jsoup を使用するサンプル コードです:

// 导入Jsoup库

import org.jsoup.Jsoup;

import org.jsoup.nodes.Document;

import org.jsoup.nodes.Element;

import org.jsoup.select.Elements;

public class JsoupExample {

public static void main(String[] args) throws Exception {

// 发送HTTP请求获取网页内容

Document doc = Jsoup.connect("http://example.com").get();

// 解析页面,提取需要的数据

Elements elements = doc.select("h1"); // 使用选择器选择需要的元素

for (Element element : elements) {

System.out.println(element.text());

}

}

}- HttpClient

HttpClient は、HTTP リクエストを送信するブラウザを簡単にシミュレートできる Java HTTP リクエスト ライブラリです。サーバーからの応答。以下は、HttpClient を使用して HTTP リクエストを送信するサンプル コードです:

// 导入HttpClient库

import org.apache.http.HttpEntity;

import org.apache.http.HttpResponse;

import org.apache.http.client.HttpClient;

import org.apache.http.client.methods.HttpGet;

import org.apache.http.impl.client.DefaultHttpClient;

import org.apache.http.util.EntityUtils;

public class HttpClientExample {

public static void main(String[] args) throws Exception {

// 创建HttpClient实例

HttpClient httpClient = new DefaultHttpClient();

// 创建HttpGet请求

HttpGet httpGet = new HttpGet("http://example.com");

// 发送HTTP请求并获取服务器的响应

HttpResponse response = httpClient.execute(httpGet);

// 解析响应,提取需要的数据

HttpEntity entity = response.getEntity();

String content = EntityUtils.toString(entity);

System.out.println(content);

}

}4. 高度なテクノロジー

- マルチスレッド

クローラーでは、マルチスレッドを使用して複数の Web ページを同時にクロールできます。以下は、Java マルチスレッドを使用して実装されたクローラのサンプル コードです。

import org.jsoup.Jsoup;

import org.jsoup.nodes.Document;

import org.jsoup.nodes.Element;

import org.jsoup.select.Elements;

import java.util.concurrent.ExecutorService;

import java.util.concurrent.Executors;

public class MultiThreadSpider {

private static final int THREAD_POOL_SIZE = 10;

public static void main(String[] args) throws Exception {

ExecutorService executorService = Executors.newFixedThreadPool(THREAD_POOL_SIZE);

for (int i = 1; i <= 10; i++) {

final int page = i;

executorService.execute(() -> {

try {

// 发送HTTP请求获取网页内容

Document doc = Jsoup.connect("http://example.com/page=" + page).get();

// 解析页面,提取需要的数据

Elements elements = doc.select("h1"); // 使用选择器选择需要的元素

for (Element element : elements) {

System.out.println(element.text());

}

} catch (Exception e) {

e.printStackTrace();

}

});

}

executorService.shutdown();

}

}- エージェント IP

IP がサーバーによって禁止されている問題を解決するために、クロール頻度に応じて、プロキシ IP を使用して実際の IP アドレスを隠すことができます。プロキシ IP を使用するクローラのサンプル コードは次のとおりです:

import org.jsoup.Jsoup;

import org.jsoup.nodes.Document;

import org.jsoup.nodes.Element;

import org.jsoup.select.Elements;

import java.net.InetSocketAddress;

import java.net.Proxy;

public class ProxyIPSpider {

public static void main(String[] args) throws Exception {

// 创建代理IP

Proxy proxy = new Proxy(Proxy.Type.HTTP, new InetSocketAddress("127.0.0.1", 8080));

// 发送HTTP请求并使用代理IP

Document doc = Jsoup.connect("http://example.com").proxy(proxy).get();

// 解析页面,提取需要的数据

Elements elements = doc.select("h1"); // 使用选择器选择需要的元素

for (Element element : elements) {

System.out.println(element.text());

}

}

}5. 概要

この記事では、Java を使用して強力な Web クローラを構築する方法を紹介し、具体的なコード例を示しました。 . .これらのテクニックを学ぶことで、Web ページから必要なデータをより効率的にクロールできるようになります。もちろん、Web クローラーの使用には、関連する法律と倫理の遵守、クローラー ツールの合理的な使用、プライバシーと他者の権利の保護も必要です。この記事が Java クローラーの学習と使用に役立つことを願っています。

以上が効率的なデータ クローリング テクノロジーをマスターする: 強力な Java クローラーを構築するの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7493

7493

15

15

1377

1377

52

52

77

77

11

11

19

19

41

41

Stable Diffusion 3 の論文がついに公開され、アーキテクチャの詳細が明らかになりましたが、Sora の再現に役立つでしょうか?

Mar 06, 2024 pm 05:34 PM

Stable Diffusion 3 の論文がついに公開され、アーキテクチャの詳細が明らかになりましたが、Sora の再現に役立つでしょうか?

Mar 06, 2024 pm 05:34 PM

StableDiffusion3 の論文がついに登場しました!このモデルは2週間前にリリースされ、Soraと同じDiT(DiffusionTransformer)アーキテクチャを採用しており、リリースされると大きな話題を呼びました。前バージョンと比較して、StableDiffusion3で生成される画像の品質が大幅に向上し、マルチテーマプロンプトに対応したほか、テキスト書き込み効果も向上し、文字化けが発生しなくなりました。 StabilityAI は、StableDiffusion3 はパラメータ サイズが 800M から 8B までの一連のモデルであると指摘しました。このパラメーター範囲は、モデルを多くのポータブル デバイス上で直接実行できることを意味し、AI の使用を大幅に削減します。

自動運転と軌道予測についてはこの記事を読めば十分です!

Feb 28, 2024 pm 07:20 PM

自動運転と軌道予測についてはこの記事を読めば十分です!

Feb 28, 2024 pm 07:20 PM

自動運転では軌道予測が重要な役割を果たしており、自動運転軌道予測とは、車両の走行過程におけるさまざまなデータを分析し、将来の車両の走行軌跡を予測することを指します。自動運転のコアモジュールとして、軌道予測の品質は下流の計画制御にとって非常に重要です。軌道予測タスクには豊富な技術スタックがあり、自動運転の動的/静的知覚、高精度地図、車線境界線、ニューラル ネットワーク アーキテクチャ (CNN&GNN&Transformer) スキルなどに精通している必要があります。始めるのは非常に困難です。多くのファンは、できるだけ早く軌道予測を始めて、落とし穴を避けたいと考えています。今日は、軌道予測に関するよくある問題と入門的な学習方法を取り上げます。関連知識の紹介 1. プレビュー用紙は整っていますか? A: まずアンケートを見てください。

DualBEV: BEVFormer および BEVDet4D を大幅に上回る、本を開いてください!

Mar 21, 2024 pm 05:21 PM

DualBEV: BEVFormer および BEVDet4D を大幅に上回る、本を開いてください!

Mar 21, 2024 pm 05:21 PM

この論文では、自動運転においてさまざまな視野角 (遠近法や鳥瞰図など) から物体を正確に検出するという問題、特に、特徴を遠近法 (PV) 空間から鳥瞰図 (BEV) 空間に効果的に変換する方法について検討します。 Visual Transformation (VT) モジュールを介して実装されます。既存の手法は、2D から 3D への変換と 3D から 2D への変換という 2 つの戦略に大別されます。 2D から 3D への手法は、深さの確率を予測することで高密度の 2D フィーチャを改善しますが、特に遠方の領域では、深さ予測に固有の不確実性により不正確さが生じる可能性があります。 3D から 2D への方法では通常、3D クエリを使用して 2D フィーチャをサンプリングし、Transformer を通じて 3D と 2D フィーチャ間の対応のアテンション ウェイトを学習します。これにより、計算時間と展開時間が増加します。

「Minecraft」が AI の街に変わり、NPC の住人が本物の人間のようにロールプレイ

Jan 02, 2024 pm 06:25 PM

「Minecraft」が AI の街に変わり、NPC の住人が本物の人間のようにロールプレイ

Jan 02, 2024 pm 06:25 PM

この四角い男性は、目の前にいる「招かれざる客」の正体について考えながら眉をひそめていることに注意してください。彼女が危険な状況にあることが判明し、これに気づくと、彼女は問題を解決するための戦略を見つけるためにすぐに頭の中で探索を始めました。最終的に、彼女は現場から逃走し、できるだけ早く助けを求め、直ちに行動を起こすことにしました。同時に、反対側の人も彼女と同じことを考えていた……『マインクラフト』では、登場人物全員が人工知能によって制御されている、そんなシーンがありました。それぞれに個性的な設定があり、例えば先ほどの女の子は17歳ながら賢くて勇敢な配達員です。彼らは記憶力と思考力を持ち、Minecraft の舞台となるこの小さな町で人間と同じように暮らしています。彼らを動かすのはまったく新しいものであり、

Java クローラーの入門: その基本概念と応用方法を理解する

Jan 10, 2024 pm 07:42 PM

Java クローラーの入門: その基本概念と応用方法を理解する

Jan 10, 2024 pm 07:42 PM

Java クローラーに関する予備調査: その基本的な概念と使用法を理解するには、具体的なコード例が必要です インターネットの急速な発展に伴い、企業や個人にとって大量のデータの取得と処理は不可欠なタスクとなっています。クローラー(WebScraping)は自動データ取得手段として、インターネット上のデータを迅速に収集できるだけでなく、大量のデータを分析・処理することができます。クローラーは、多くのデータ マイニングおよび情報検索プロジェクトにおいて非常に重要なツールとなっています。この記事では、Java クローラーの基本的な概要を紹介します。

レビュー!深いモデルの融合 (LLM/基本モデル/フェデレーテッド ラーニング/ファインチューニングなど)

Apr 18, 2024 pm 09:43 PM

レビュー!深いモデルの融合 (LLM/基本モデル/フェデレーテッド ラーニング/ファインチューニングなど)

Apr 18, 2024 pm 09:43 PM

9 月 23 日、論文「DeepModelFusion:ASurvey」が国立国防技術大学、JD.com、北京理工大学によって発表されました。ディープ モデルの融合/マージは、複数のディープ ラーニング モデルのパラメーターまたは予測を 1 つのモデルに結合する新しいテクノロジーです。さまざまなモデルの機能を組み合わせて、個々のモデルのバイアスとエラーを補償し、パフォーマンスを向上させます。大規模な深層学習モデル (LLM や基本モデルなど) での深層モデルの融合は、高い計算コスト、高次元のパラメーター空間、異なる異種モデル間の干渉など、いくつかの課題に直面しています。この記事では、既存のディープ モデル フュージョン手法を 4 つのカテゴリに分類します。 (1) 「パターン接続」。損失低減パスを介して重み空間内の解を接続し、より適切な初期モデル フュージョンを取得します。

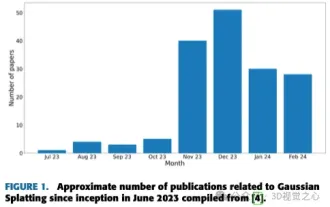

単なる 3D ガウス以上のもの!最先端の 3D 再構成技術の最新概要

Jun 02, 2024 pm 06:57 PM

単なる 3D ガウス以上のもの!最先端の 3D 再構成技術の最新概要

Jun 02, 2024 pm 06:57 PM

上記と著者の個人的な理解は、画像ベースの 3D 再構成は、一連の入力画像からオブジェクトまたはシーンの 3D 形状を推測することを含む困難なタスクであるということです。学習ベースの手法は、3D形状を直接推定できることから注目を集めています。このレビュー ペーパーは、これまでにない新しいビューの生成など、最先端の 3D 再構成技術に焦点を当てています。入力タイプ、モデル構造、出力表現、トレーニング戦略など、ガウス スプラッシュ メソッドの最近の開発の概要が提供されます。未解決の課題と今後の方向性についても議論します。この分野の急速な進歩と 3D 再構成手法を強化する数多くの機会を考慮すると、アルゴリズムを徹底的に調査することが重要であると思われます。したがって、この研究は、ガウス散乱の最近の進歩の包括的な概要を提供します。 (親指を上にスワイプしてください

スムーズなビルド: Maven イメージ アドレスを正しく構成する方法

Feb 20, 2024 pm 08:48 PM

スムーズなビルド: Maven イメージ アドレスを正しく構成する方法

Feb 20, 2024 pm 08:48 PM

スムーズなビルド: Maven イメージ アドレスを正しく構成する方法 Maven を使用してプロジェクトをビルドする場合、正しいイメージ アドレスを構成することが非常に重要です。ミラー アドレスを適切に構成すると、プロジェクトの構築を迅速化し、ネットワークの遅延などの問題を回避できます。この記事では、Maven ミラー アドレスを正しく構成する方法と、具体的なコード例を紹介します。 Maven イメージ アドレスを構成する必要があるのはなぜですか? Maven は、プロジェクトの自動構築、依存関係の管理、レポートの生成などを行うことができるプロジェクト管理ツールです。 Maven でプロジェクトをビルドする場合、通常は