テクノロジー周辺機器

テクノロジー周辺機器

AI

AI

Transformer ランクを下げると、特定のレイヤー内の 90% 以上のコンポーネントの削除を減らすことなく、LLM を維持しながらパフォーマンスが向上します。

Transformer ランクを下げると、特定のレイヤー内の 90% 以上のコンポーネントの削除を減らすことなく、LLM を維持しながらパフォーマンスが向上します。

Transformer ランクを下げると、特定のレイヤー内の 90% 以上のコンポーネントの削除を減らすことなく、LLM を維持しながらパフォーマンスが向上します。

MIT とマイクロソフトは共同研究を実施し、追加のトレーニングなしで大規模な言語モデルのタスクのパフォーマンスを向上させ、そのサイズを縮小できることがわかりました。

大規模モデルの時代、Transformer は独自の機能で科学研究分野全体をサポートします。 Transformer ベースの言語モデル (LLM) は、その導入以来、さまざまなタスクで優れたパフォーマンスを実証してきました。 Transformer の基礎となるアーキテクチャは、自然言語モデリングと推論のための最先端のテクノロジとなり、コンピュータ ビジョンや強化学習などの分野で大きな可能性を示しています

しかし、現在の Transformer アーキテクチャは非常に大きく、通常はトレーニングと推論に多くのコンピューティング リソースを必要とします。

次のように書き換えます: より多くのパラメーターまたはデータでトレーニングされた Transformer は他のモデルよりも明らかに能力が高いため、これを行うのは理にかなっています。ただし、Transformer ベースのモデルとニューラル ネットワークでは、学習した仮説を維持するためにすべての適応パラメーターを保持する必要はないことが、ますます多くの研究で示されています。

一般に、モデルをトレーニングする場合、過剰なパラメーター化は非常に問題があるようです。便利ですが、これらのモデルは推論前に大幅に枝刈りされる可能性があります。研究によると、ニューラル ネットワークでは、パフォーマンスを大幅に低下させることなく、重みの 90% 以上を削除できることがわかっています。この現象は、モデル推論を支援する枝刈り戦略に対する研究者の関心を引き起こしました。

MIT と Microsoft の研究者は、論文「真実はそこにあります: 層選択的ランク削減による言語モデルの推論の改善により、驚くべき結果が得られました」と書いています。 Transformer モデルの特定のレイヤーを慎重にプルーニングすると、特定のタスクにおけるモデルのパフォーマンスが大幅に向上することがわかりました。

論文を表示するには、次のリンクをクリックしてください: https://arxiv.org/pdf/2312.13558.pdf

-

論文のホームページ: https://pratyushasharma.github.io/laser/

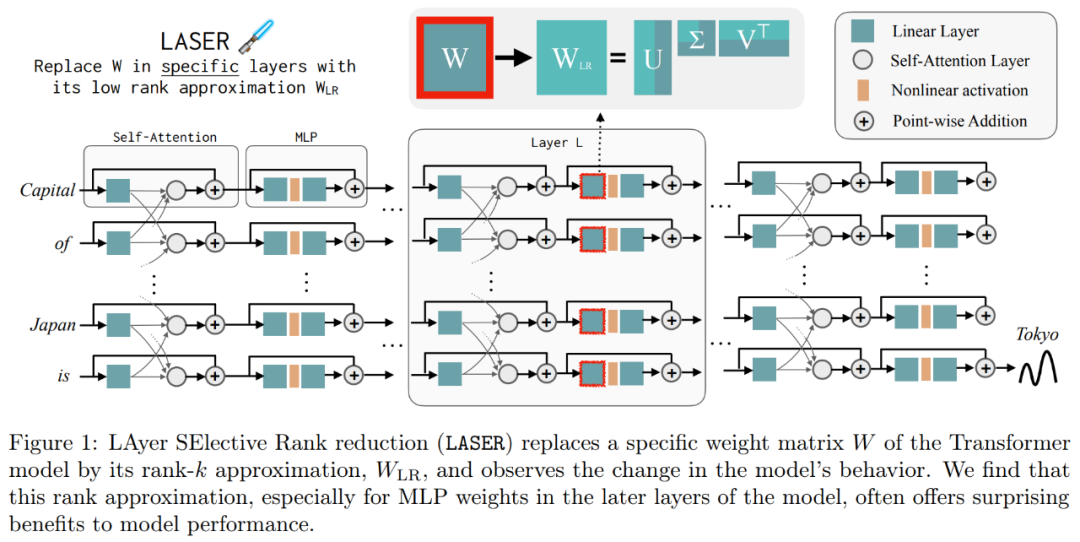

研究では、この単純な介入を LASER (Layer Selective Rank Reduction) と呼んでいます。 LLM の特性は、特異値分解を通じて Transformer モデルの特定の層の学習重み行列の高次成分を選択的に削減することで大幅に改善されます。この操作は、追加のパラメーターやデータなしでモデルのトレーニングが完了した後に実行できます。

操作中に、モデル固有の重み行列とレイヤーで重みの削減が実行されます。この研究では、多くの同様のマトリックスの重量を大幅に削減できることも判明しており、通常、コンポーネントの 90% 以上が除去されるまでパフォーマンスの低下は観察されません。また、これらの削減によって精度が大幅に向上する可能性があることも判明しました。この発見は次のように考えられます。自然言語に限定されず、強化学習でもパフォーマンスの向上が見られます。

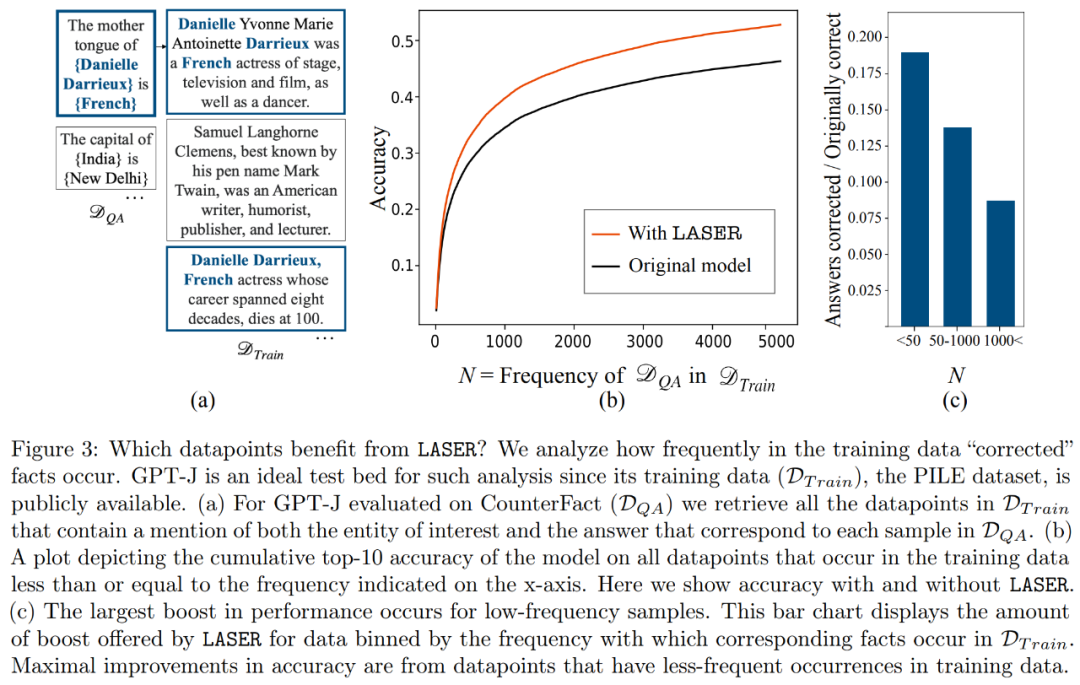

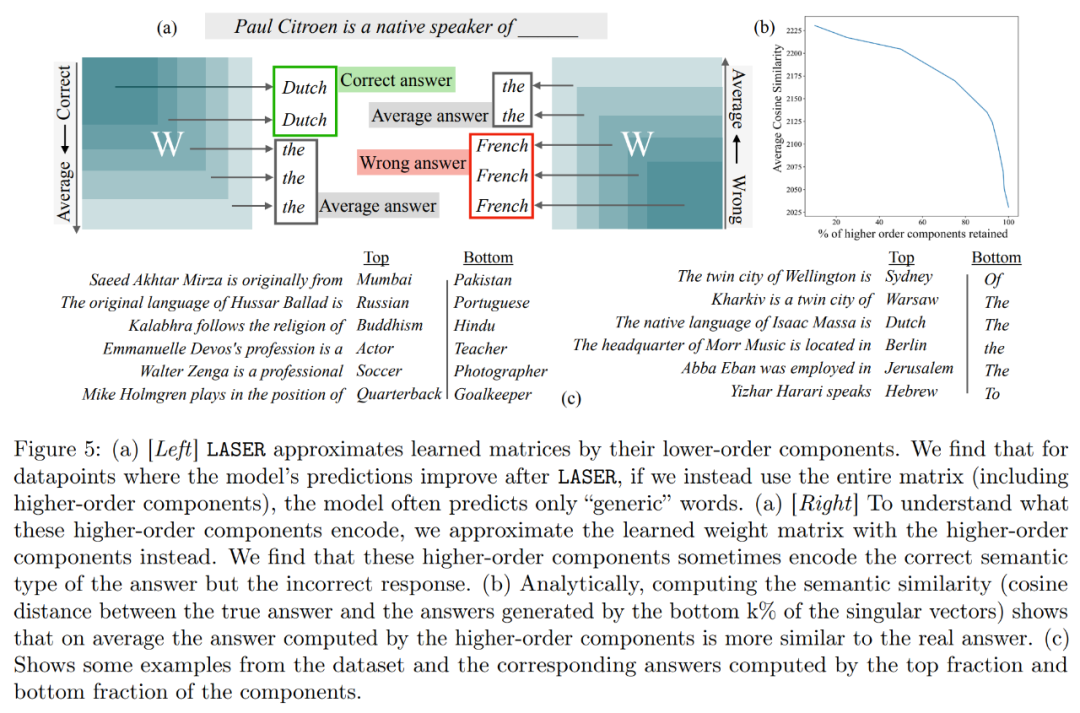

さらに、この研究では、上位コンポーネントに何が格納されているかを推測し、パフォーマンスを向上させるために削除できるようにすることを試みています。この研究では、LASER は正しい質問に答えましたが、介入前は、元のモデルは主に高頻度の単語 (「the」、「of」など) で応答しており、それらの単語は意味論的なタイプが質問と同じではなかったことがわかりました。つまり、これらのコンポーネントにより、モデルは介入なしで無関係な高頻度単語を生成します。

ただし、ある程度のランク削減を行うことで、モデルの答えを正解に変えることができます。

これを理解するために、この研究では、残りのコンポーネントが個別にエンコードするものについても調査し、高次の特異ベクトルのみを使用して重み行列を近似します。これらのコンポーネントは、正解と同じ意味カテゴリ内の異なる応答または共通の高頻度単語を記述していることが判明しました。

これらの結果は、ノイズの多い高次成分が低次成分と組み合わされると、それらの矛盾する応答により、不正確である可能性がある平均的な答えが生成されることを示唆しています。図 1 は、Transformer のアーキテクチャと LASER の手順を視覚的に表したものです。ここでは、多層パーセプトロン (MLP) の特定の層の重み行列が、その低ランク近似によって置き換えられます。

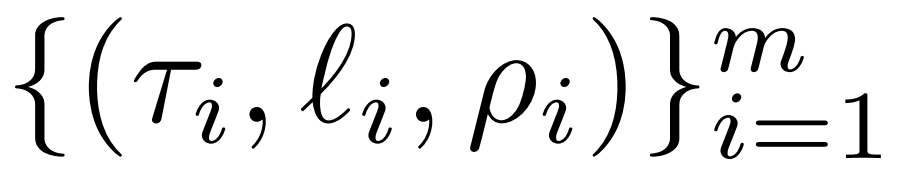

レーザーの概要レーザー介入について詳しく説明します。シングルステップの LASER 介入は、パラメータ τ、層の数 ℓ、および削減ランク ρ を含むトリプレット (τ、ℓ、ρ) によって定義されます。これらの値は合わせて、低ランク近似によって置き換えられる行列と近似の程度を記述します。研究者は、パラメータのタイプに基づいて介入する行列のタイプを分類します。

研究者は、MLP と次から構成されるアテンション層で構成される W = {W_q, W_k, W_v, W_o, U_in, U_out} の行列に焦点を当てます。の行列。階層の数は、研究者の介入の階層を表します (最初の階層には 0 から始まるインデックスが付けられます)。たとえば、Llama-2 には 32 層あるため、ℓ ∈ {0, 1, 2,・・・31} となります。

最終的に、ρ ∈ [0, 1) は、低ランクの近似を行うときに最大ランクのどの部分を保存する必要があるかを示します。たとえば、

と仮定すると、行列の最大ランクは d です。研究者らはこれを ⌊ρ・d⌋- 近似に置き換えました。 下の図 1 は LASER の例であり、この図では、τ = U_in および ℓ = L は、L^ 番目の層の Transformer ブロック内の MLP の最初の層の重み行列の更新を表します。別のパラメーターは、ランク k 近似の k を制御します。

下の図 1 は LASER の例であり、この図では、τ = U_in および ℓ = L は、L^ 番目の層の Transformer ブロック内の MLP の最初の層の重み行列の更新を表します。別のパラメーターは、ランク k 近似の k を制御します。

LASER は、ネットワーク内の特定の情報の流れを制限し、予期せぬパフォーマンス上の大幅な利点をもたらす可能性があります。これらの介入は簡単に組み合わせることができるため、一連の介入を任意の順序で適用できます。

元の意味を変更しないようにするには、内容を中国語に書き直す必要があります。元の文を表示する必要はありません

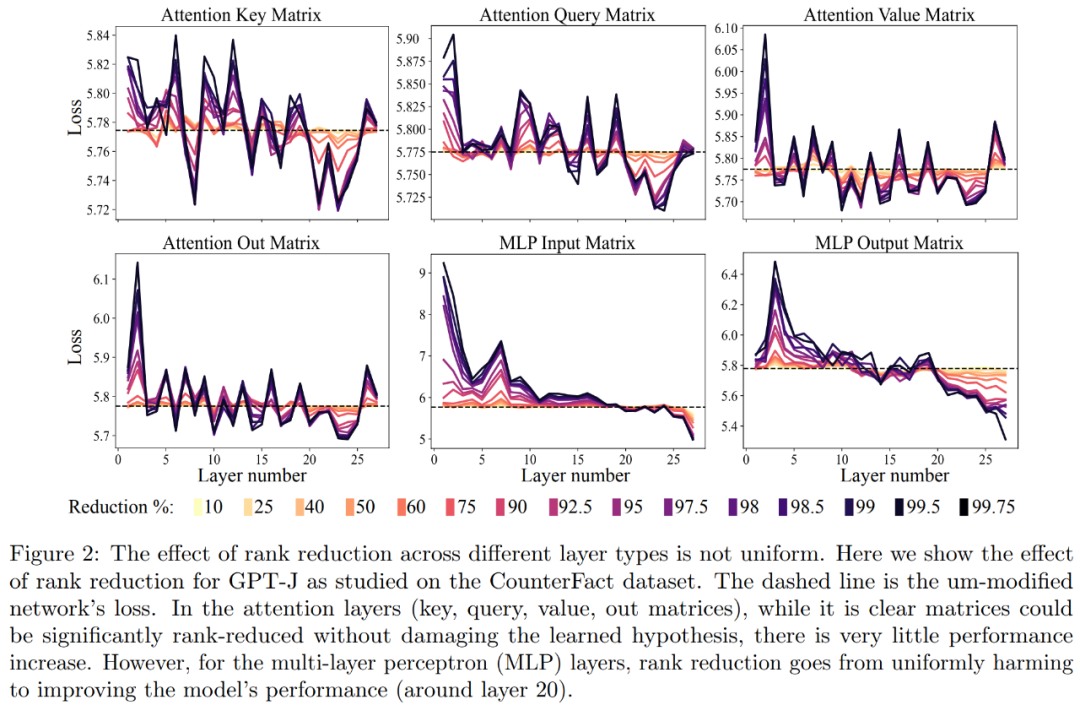

実験部分では、研究者は PILE データセットで事前トレーニングされた GPT-J モデルを使用しました。モデルの層数は 27 で、パラメータは 60 億です。次に、モデルの動作が CounterFact データセットで評価されます。このデータセットには、(トピック、関係、回答) トリプルのサンプルが含まれており、質問ごとに 3 つの言い換えプロンプトが提供されます。 1 つ目は、CounterFact データセット上の GPT-J モデルの分析です。以下の図 2 は、Transformer アーキテクチャの各行列に異なる量のランク削減を適用した結果、データセットの分類損失に与える影響を示しています。 Transformer の各層は 2 層の小さな MLP で構成されており、入力行列と出力行列が個別に示されています。色が異なると、除去されたコンポーネントの割合が異なります。

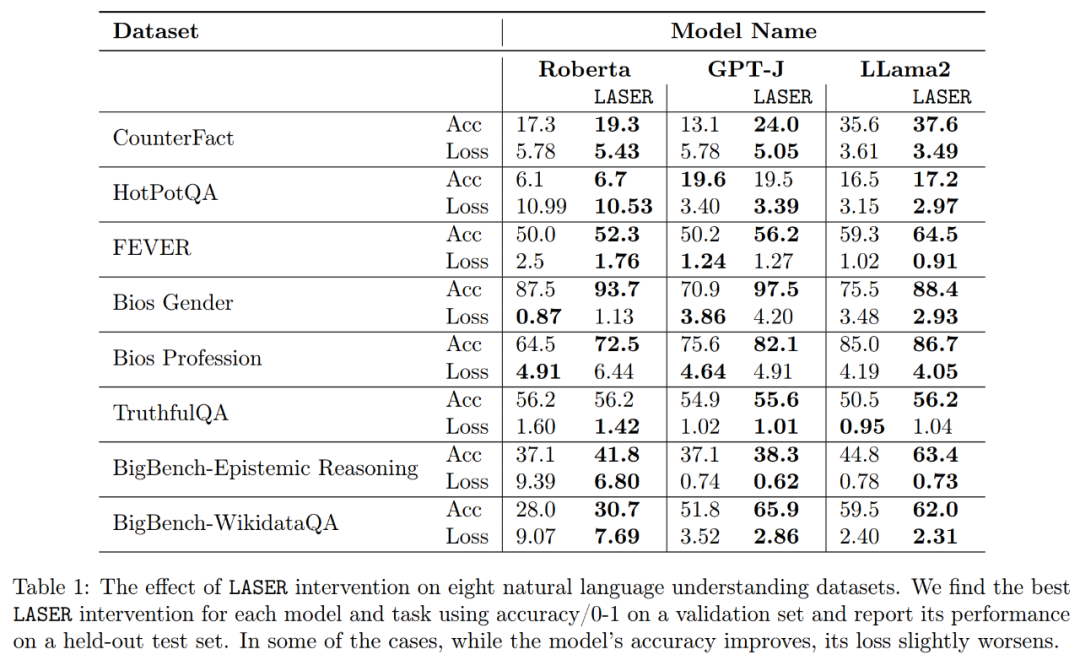

##最後に、研究者らは、複数の言語理解タスクに関する 3 つの異なる LLM に対する発見の一般化可能性を評価しました。タスクごとに、精度、分類精度、損失という 3 つの指標を生成してモデルのパフォーマンスを評価しました。上記の表 1 に示すように、ランクの低下が大きくても、モデルの精度は低下しませんが、モデルのパフォーマンスは向上します。

##最後に、研究者らは、複数の言語理解タスクに関する 3 つの異なる LLM に対する発見の一般化可能性を評価しました。タスクごとに、精度、分類精度、損失という 3 つの指標を生成してモデルのパフォーマンスを評価しました。上記の表 1 に示すように、ランクの低下が大きくても、モデルの精度は低下しませんが、モデルのパフォーマンスは向上します。

以上がTransformer ランクを下げると、特定のレイヤー内の 90% 以上のコンポーネントの削除を減らすことなく、LLM を維持しながらパフォーマンスが向上します。の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7530

7530

15

15

1378

1378

52

52

82

82

11

11

21

21

76

76

ControlNet の作者がまたヒット作を出しました!写真から絵画を生成し、2 日間で 1.4,000 個のスターを獲得する全プロセス

Jul 17, 2024 am 01:56 AM

ControlNet の作者がまたヒット作を出しました!写真から絵画を生成し、2 日間で 1.4,000 個のスターを獲得する全プロセス

Jul 17, 2024 am 01:56 AM

これも Tusheng のビデオですが、PaintsUndo は別の道を歩んでいます。 ControlNet 作者 LvminZhang が再び生き始めました!今回は絵画の分野を目指します。新しいプロジェクト PaintsUndo は、開始されて間もなく 1.4kstar を獲得しました (まだ異常なほど上昇しています)。プロジェクトアドレス: https://github.com/lllyasviel/Paints-UNDO このプロジェクトを通じて、ユーザーが静止画像を入力すると、PaintsUndo が線画から完成品までのペイントプロセス全体のビデオを自動的に生成するのに役立ちます。 。描画プロセス中の線の変化は驚くべきもので、最終的なビデオ結果は元の画像と非常によく似ています。完成した描画を見てみましょう。

オープンソース AI ソフトウェア エンジニアのリストのトップに立つ UIUC のエージェントレス ソリューションは、SWE ベンチの実際のプログラミングの問題を簡単に解決します

Jul 17, 2024 pm 10:02 PM

オープンソース AI ソフトウェア エンジニアのリストのトップに立つ UIUC のエージェントレス ソリューションは、SWE ベンチの実際のプログラミングの問題を簡単に解決します

Jul 17, 2024 pm 10:02 PM

AIxivコラムは、当サイトが学術的・技術的な内容を掲載するコラムです。過去数年間で、このサイトの AIxiv コラムには 2,000 件を超えるレポートが寄せられ、世界中の主要な大学や企業のトップ研究室がカバーされ、学術交流と普及を効果的に促進しています。共有したい優れた作品がある場合は、お気軽に寄稿するか、報告のために当社までご連絡ください。提出電子メール: liyazhou@jiqizhixin.com; zhaoyunfeng@jiqizhixin.com この論文の著者は全員、イリノイ大学アーバナ シャンペーン校 (UIUC) の Zhang Lingming 教師のチームのメンバーです。博士課程4年、研究者

RLHF から DPO、TDPO に至るまで、大規模なモデル アライメント アルゴリズムはすでに「トークンレベル」になっています

Jun 24, 2024 pm 03:04 PM

RLHF から DPO、TDPO に至るまで、大規模なモデル アライメント アルゴリズムはすでに「トークンレベル」になっています

Jun 24, 2024 pm 03:04 PM

AIxivコラムは、当サイトが学術的・技術的な内容を掲載するコラムです。過去数年間で、このサイトの AIxiv コラムには 2,000 件を超えるレポートが寄せられ、世界中の主要な大学や企業のトップ研究室がカバーされ、学術交流と普及を効果的に促進しています。共有したい優れた作品がある場合は、お気軽に寄稿するか、報告のために当社までご連絡ください。提出メール: liyazhou@jiqizhixin.com; zhaoyunfeng@jiqizhixin.com 人工知能の開発プロセスにおいて、大規模言語モデル (LLM) の制御とガイダンスは常に中心的な課題の 1 つであり、これらのモデルが両方とも確実に機能することを目指しています。強力かつ安全に人類社会に貢献します。初期の取り組みは人間のフィードバックによる強化学習手法に焦点を当てていました (RL

OpenAI Super Alignment チームの遺作: 2 つの大きなモデルがゲームをプレイし、出力がより理解しやすくなる

Jul 19, 2024 am 01:29 AM

OpenAI Super Alignment チームの遺作: 2 つの大きなモデルがゲームをプレイし、出力がより理解しやすくなる

Jul 19, 2024 am 01:29 AM

AIモデルによって与えられた答えがまったく理解できない場合、あなたはそれをあえて使用しますか?機械学習システムがより重要な分野で使用されるにつれて、なぜその出力を信頼できるのか、またどのような場合に信頼してはいけないのかを実証することがますます重要になっています。複雑なシステムの出力に対する信頼を得る方法の 1 つは、人間または他の信頼できるシステムが読み取れる、つまり、考えられるエラーが発生する可能性がある点まで完全に理解できる、その出力の解釈を生成することをシステムに要求することです。見つかった。たとえば、司法制度に対する信頼を築くために、裁判所に対し、決定を説明し裏付ける明確で読みやすい書面による意見を提供することを求めています。大規模な言語モデルの場合も、同様のアプローチを採用できます。ただし、このアプローチを採用する場合は、言語モデルが

arXiv 論文は「弾幕」として投稿可能、スタンフォード alphaXiv ディスカッション プラットフォームはオンライン、LeCun は気に入っています

Aug 01, 2024 pm 05:18 PM

arXiv 論文は「弾幕」として投稿可能、スタンフォード alphaXiv ディスカッション プラットフォームはオンライン、LeCun は気に入っています

Aug 01, 2024 pm 05:18 PM

乾杯!紙面でのディスカッションが言葉だけになると、どんな感じになるでしょうか?最近、スタンフォード大学の学生が、arXiv 論文のオープン ディスカッション フォーラムである alphaXiv を作成しました。このフォーラムでは、arXiv 論文に直接質問やコメントを投稿できます。 Web サイトのリンク: https://alphaxiv.org/ 実際、URL の arXiv を alphaXiv に変更するだけで、alphaXiv フォーラムの対応する論文を直接開くことができます。この Web サイトにアクセスする必要はありません。その中の段落を正確に見つけることができます。論文、文: 右側のディスカッション エリアでは、ユーザーは論文のアイデアや詳細について著者に尋ねる質問を投稿できます。たとえば、次のような論文の内容についてコメントすることもできます。

公理的トレーニングにより、LLM は因果推論を学習できます。6,700 万個のパラメータ モデルは、1 兆個のパラメータ レベル GPT-4 に匹敵します。

Jul 17, 2024 am 10:14 AM

公理的トレーニングにより、LLM は因果推論を学習できます。6,700 万個のパラメータ モデルは、1 兆個のパラメータ レベル GPT-4 に匹敵します。

Jul 17, 2024 am 10:14 AM

LLM に因果連鎖を示すと、LLM は公理を学習します。 AI はすでに数学者や科学者の研究を支援しています。たとえば、有名な数学者のテレンス タオは、GPT などの AI ツールを活用した研究や探索の経験を繰り返し共有しています。 AI がこれらの分野で競争するには、強力で信頼性の高い因果推論能力が不可欠です。この記事で紹介する研究では、小さなグラフでの因果的推移性公理の実証でトレーニングされた Transformer モデルが、大きなグラフでの推移性公理に一般化できることがわかりました。言い換えれば、Transformer が単純な因果推論の実行を学習すると、より複雑な因果推論に使用できる可能性があります。チームが提案した公理的トレーニング フレームワークは、デモンストレーションのみで受動的データに基づいて因果推論を学習するための新しいパラダイムです。

リーマン予想の大きな進歩!陶哲軒氏はMITとオックスフォードの新しい論文を強く推薦し、37歳のフィールズ賞受賞者も参加した

Aug 05, 2024 pm 03:32 PM

リーマン予想の大きな進歩!陶哲軒氏はMITとオックスフォードの新しい論文を強く推薦し、37歳のフィールズ賞受賞者も参加した

Aug 05, 2024 pm 03:32 PM

最近、2000年代の7大問題の一つとして知られるリーマン予想が新たなブレークスルーを達成した。リーマン予想は、数学における非常に重要な未解決の問題であり、素数の分布の正確な性質に関連しています (素数とは、1 とそれ自身でのみ割り切れる数であり、整数論において基本的な役割を果たします)。今日の数学文献には、リーマン予想 (またはその一般化された形式) の確立に基づいた 1,000 を超える数学的命題があります。言い換えれば、リーマン予想とその一般化された形式が証明されれば、これらの 1,000 を超える命題が定理として確立され、数学の分野に重大な影響を与えることになります。これらの命題の一部も有効性を失います。 MIT数学教授ラリー・ガスとオックスフォード大学から新たな進歩がもたらされる

最初の Mamba ベースの MLLM が登場しました!モデルの重み、トレーニング コードなどはすべてオープンソースです

Jul 17, 2024 am 02:46 AM

最初の Mamba ベースの MLLM が登場しました!モデルの重み、トレーニング コードなどはすべてオープンソースです

Jul 17, 2024 am 02:46 AM

AIxivコラムは、当サイトが学術的・技術的な内容を掲載するコラムです。過去数年間で、このサイトの AIxiv コラムには 2,000 件を超えるレポートが寄せられ、世界中の主要な大学や企業のトップ研究室がカバーされ、学術交流と普及を効果的に促進しています。共有したい優れた作品がある場合は、お気軽に寄稿するか、報告のために当社までご連絡ください。提出電子メール: liyazhou@jiqizhixin.com; zhaoyunfeng@jiqizhixin.com。はじめに 近年、さまざまな分野でマルチモーダル大規模言語モデル (MLLM) の適用が目覚ましい成功を収めています。ただし、多くの下流タスクの基本モデルとして、現在の MLLM はよく知られた Transformer ネットワークで構成されています。