国内の大規模オープンソースMoEモデルを導入、Llama 2-7Bと同等の性能を持ちながら計算量を60%削減

オープンソースの MoE モデルに、ついに初の国内プレーヤーが登場しました!

性能はdense Llama 2-7Bモデルに劣りませんが、計算量は40%しかありません。

このモデルは、特に数学とコーディング能力の点で、ラマを圧倒する 19 面の戦士と呼ぶことができます。

これは、Deep Search チームの最新のオープンソース 160 億パラメータ エキスパート モデル DeepSeek MoE です。

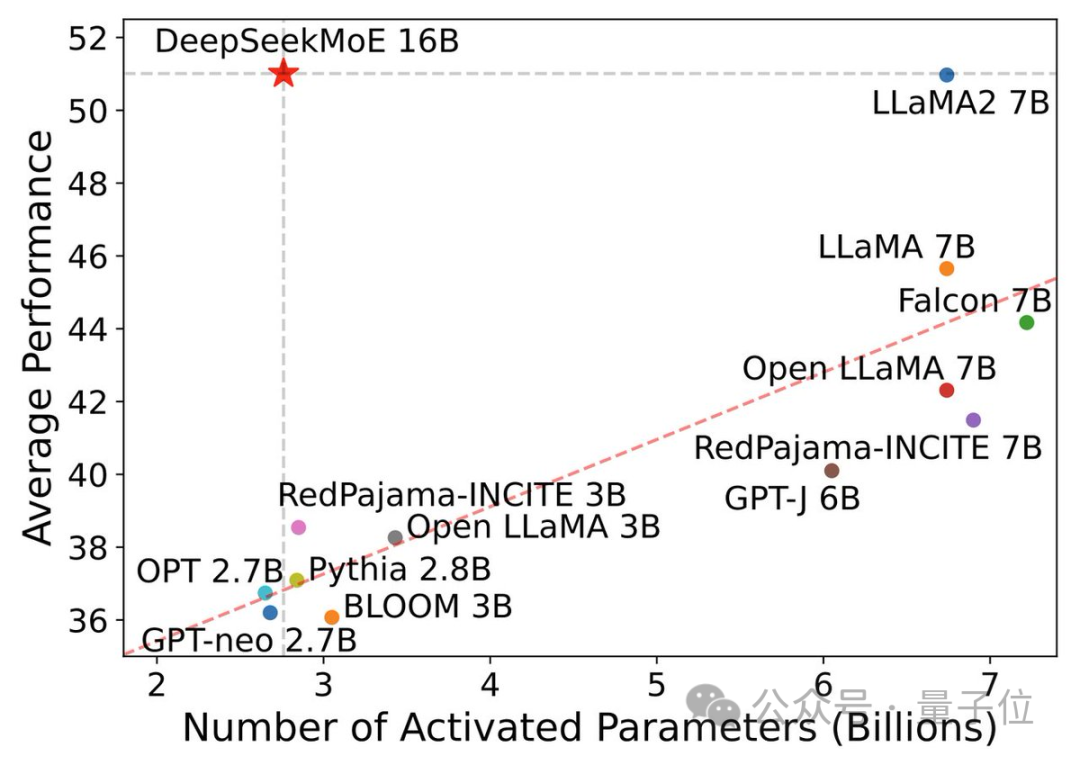

DeepSeek MoE は、優れたパフォーマンスに加えて、コンピューティング能力を節約することを主な焦点としています。

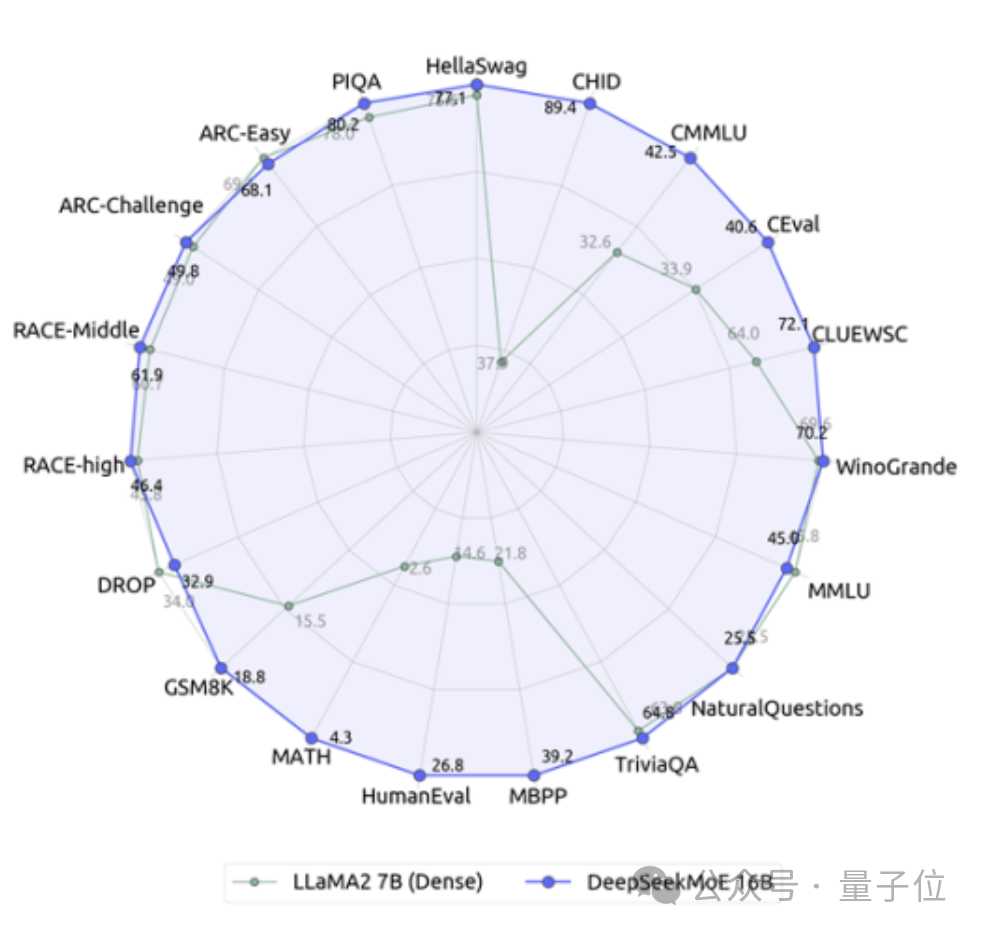

このパフォーマンス アクティベーション パラメータ図では、これが「選択」され、左上隅の大きな空白領域を占めています。

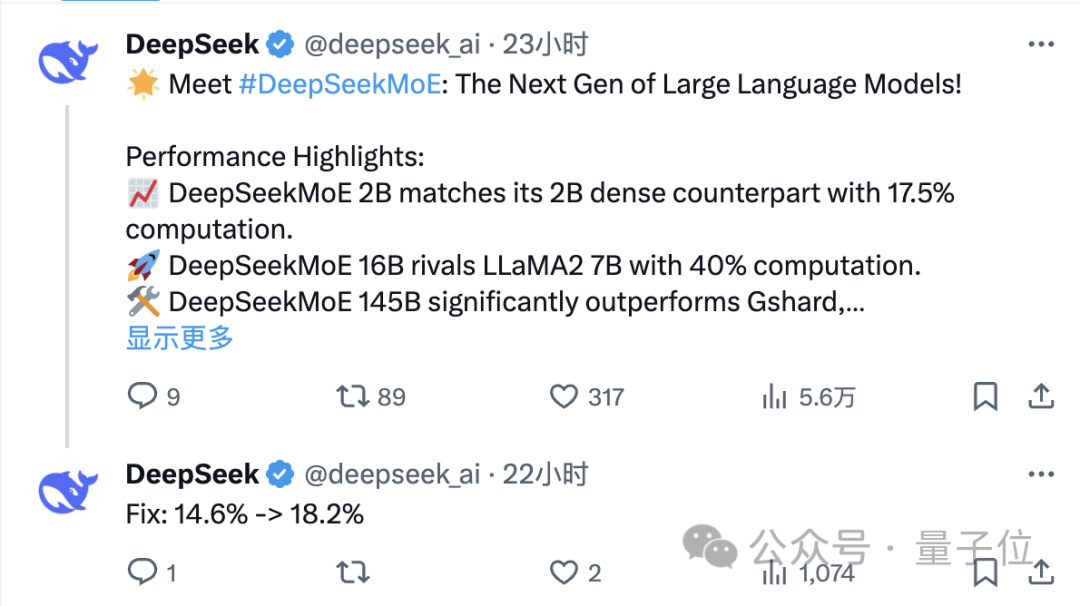

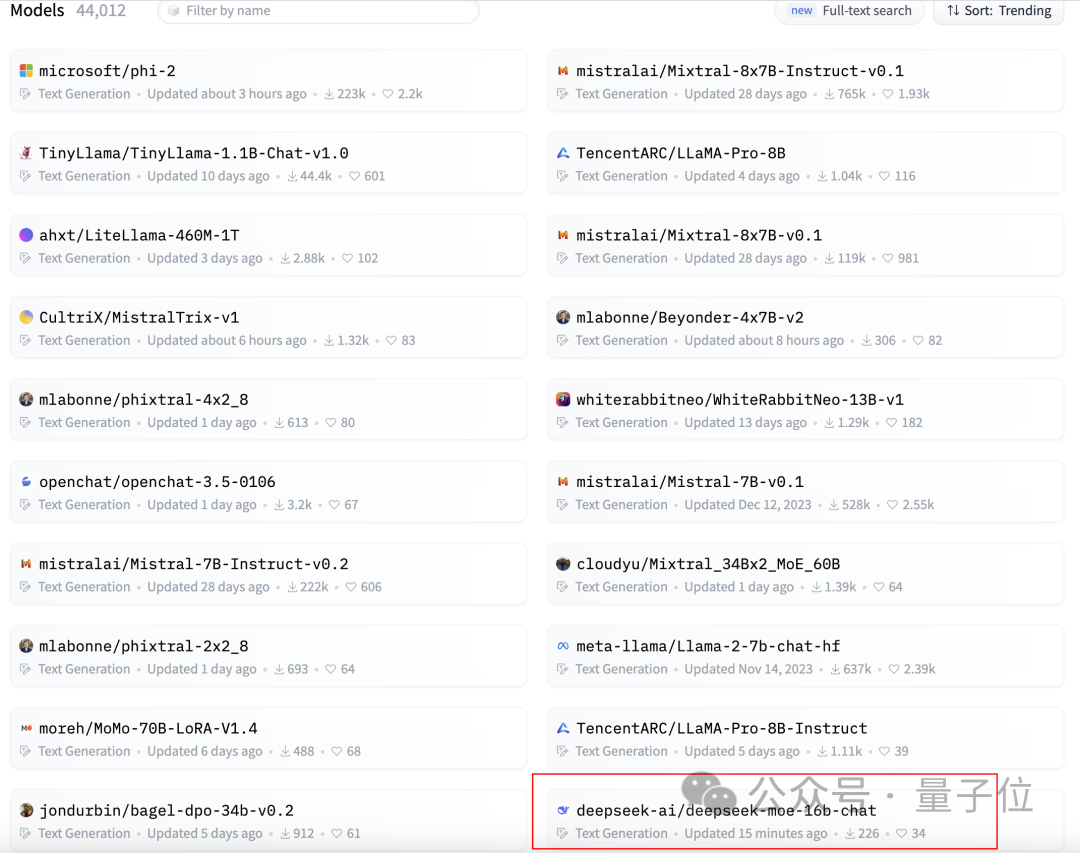

リリースからわずか 1 日後、X に関する DeepSeek チームのツイートは大量のリツイートと注目を集めました。

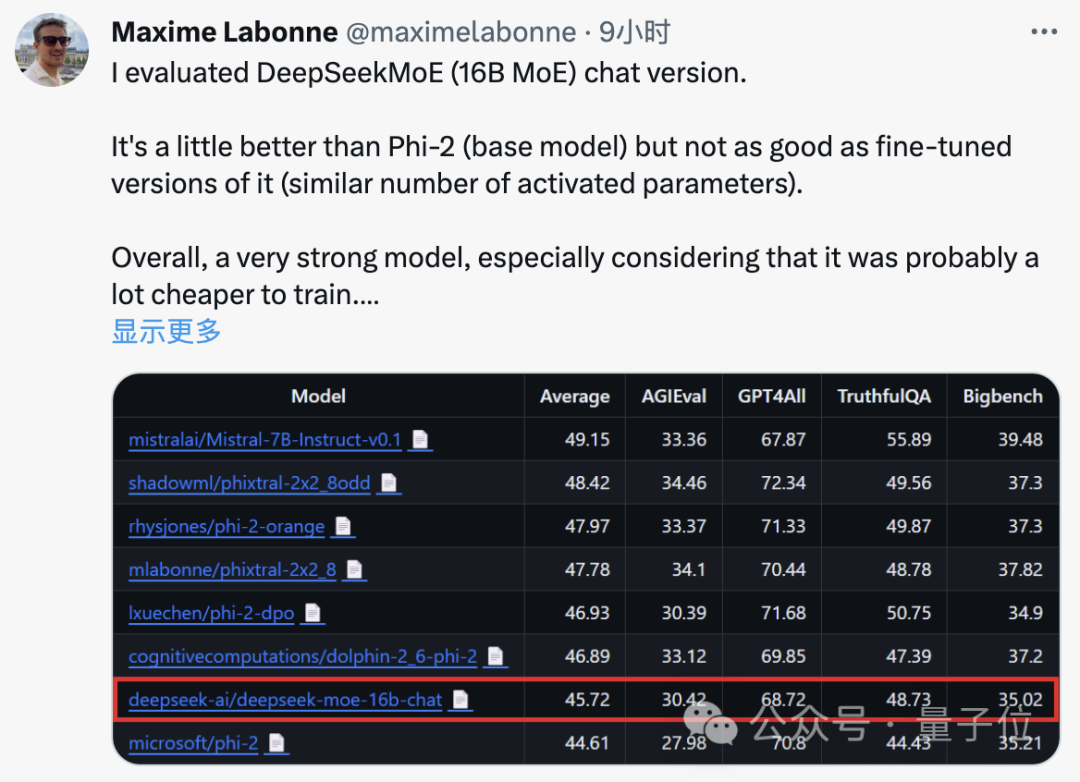

JP モルガンの機械学習エンジニア、マキシム・ラボンヌ氏もテスト後に、DeepSeek MoE のチャット版は Microsoft の「小規模モデル」Phi-2 よりも若干パフォーマンスが優れていると述べました。

同時に、DeepSeek MoE も GitHub で 300 個のスターを獲得し、Hugging Face テキスト生成モデル ランキングのホームページに掲載されました。

それでは、DeepSeek MoE の具体的なパフォーマンスはどのようなものでしょうか?

計算量が 60% 削減

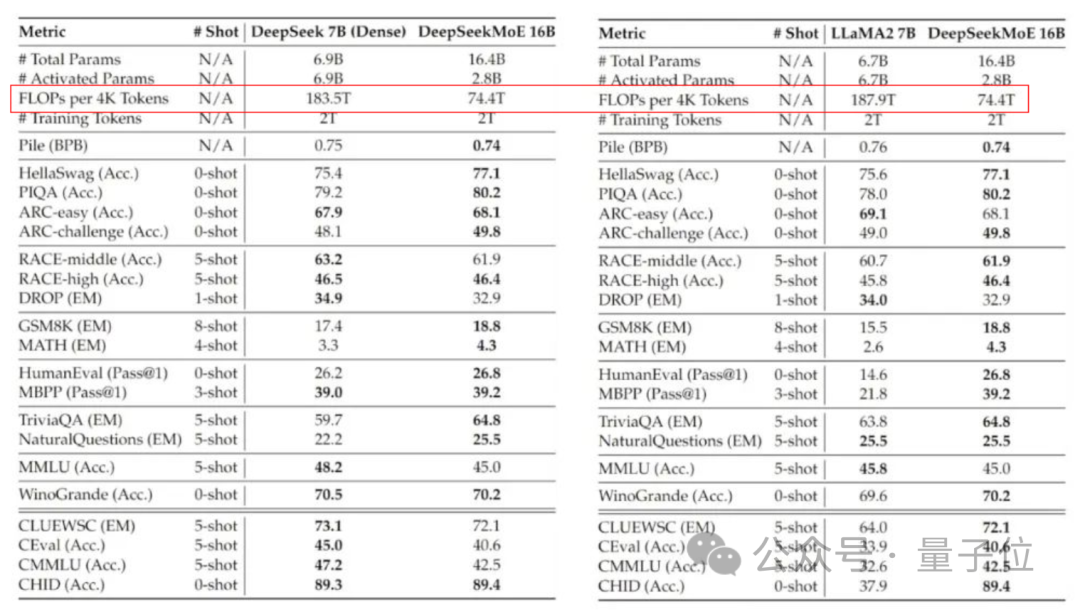

現在のバージョンの DeepSeek MoE には 160 億個のパラメータがあり、実際に有効化されるパラメータの数は約 28 億個です。

独自の 7B 高密度モデルと比較すると、19 データセットにおける 2 つのパフォーマンスには異なる長所と短所がありますが、全体的なパフォーマンスは比較的近いです。

同じく高密度モデルである Llama 2-7B と比較すると、DeepSeek MoE は数学やコードなどにおいて明らかな利点を示しています。

しかし、両方の高密度モデルの計算量は 4k トークンあたり 180TFLOP を超えますが、DeepSeek MoE の計算量は 74.4TFLOP のみで、この 2 つのモデルの 40% にすぎません。

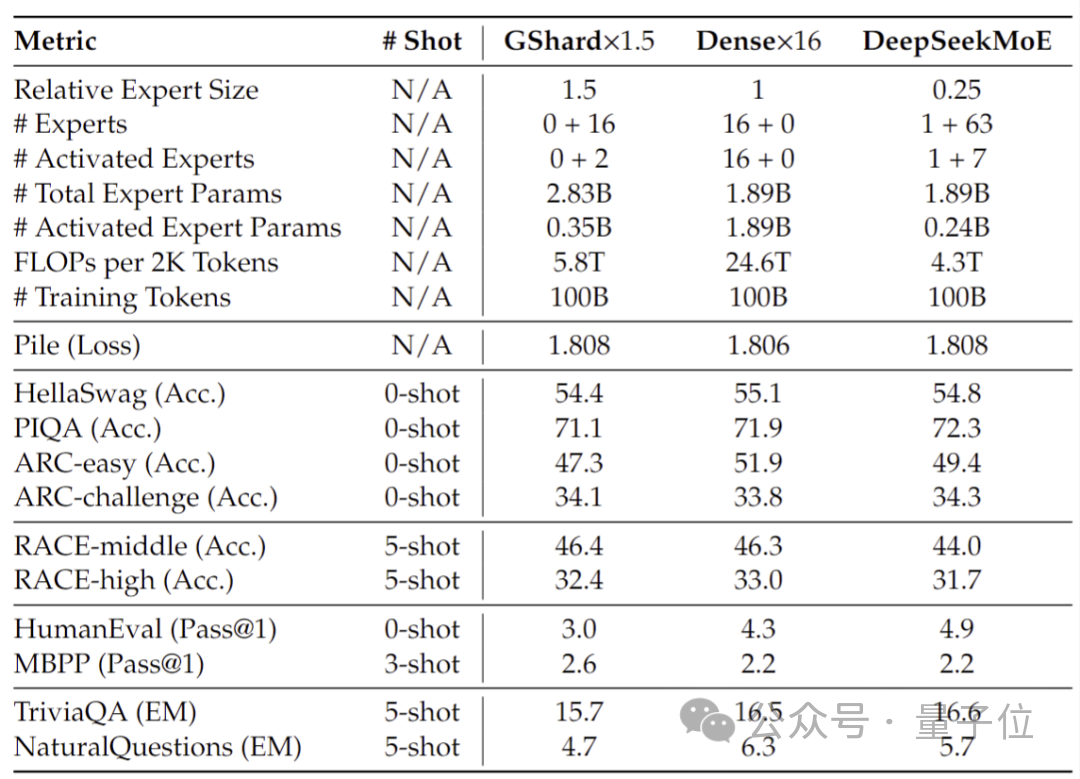

20 億のパラメーターで実施されたパフォーマンス テストでは、DeepSeek MoE が、より少ない計算で 1.5 倍のパラメーターを使用しても同じ MoE モデルのパフォーマンスを達成できることが示されています。 B は同等かそれ以上の結果を示しています。

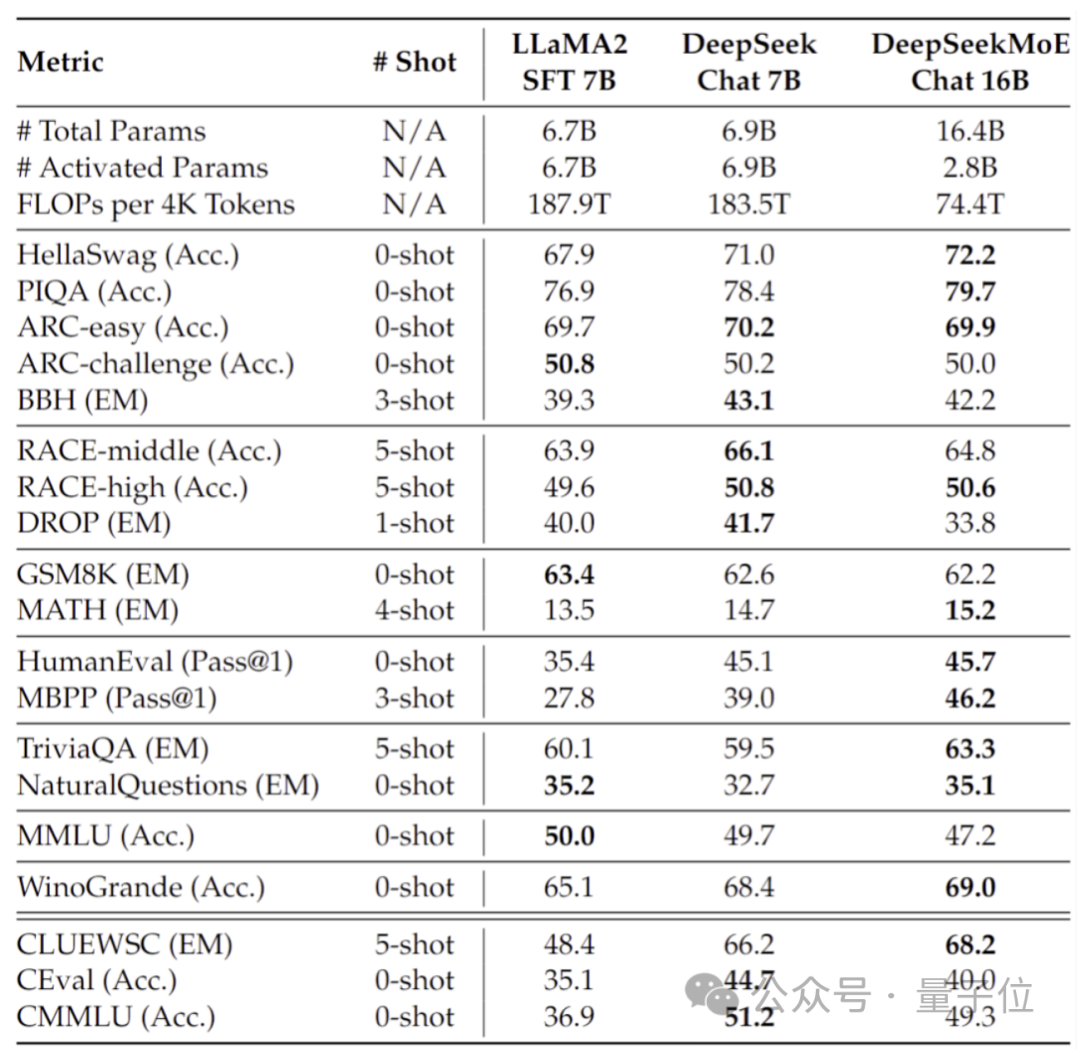

さらに、Deep Seek チームは SFT に基づいて DeepSeek MoE のチャット バージョンも微調整し、そのパフォーマンスも独自の高密度バージョンや Llama 2 に近づきました。 -7B。

さらに、DeepSeek チームは、DeepSeek MoE モデルの 145B バージョンが開発中であることも明らかにしました。

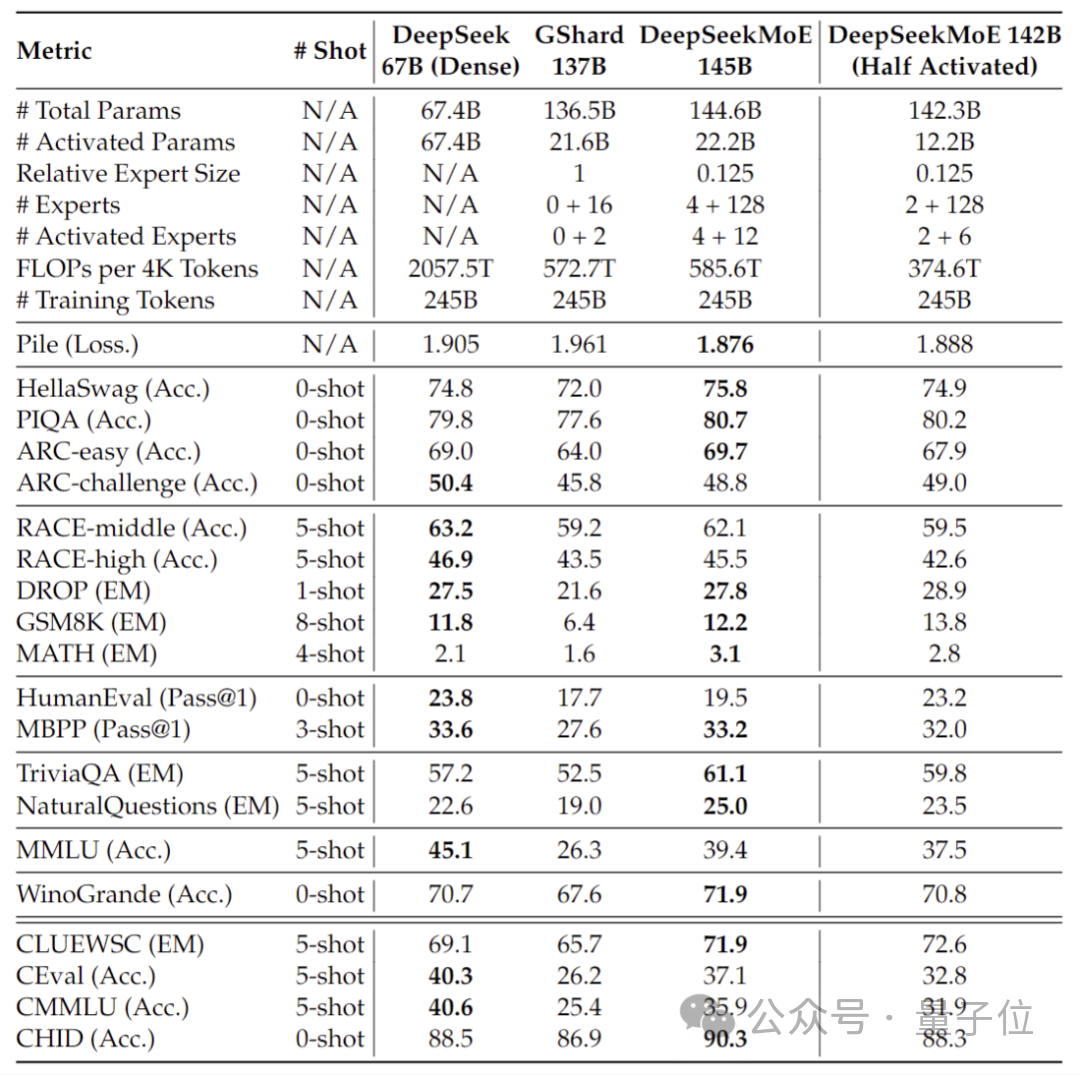

段階的な予備テストでは、145B DeepSeek MoE が GShard 137B に大きくリードしており、28.5% の計算量で DeepSeek 67B モデルの高密度バージョンと同等のパフォーマンスを達成できることが示されています。

研究開発が完了したら、チームは 145B バージョンもオープンソース化する予定です。

これらのモデルのパフォーマンスの背後には、DeepSeek が独自に開発した新しい MoE アーキテクチャがあります。

自社開発の MoE の新しいアーキテクチャ

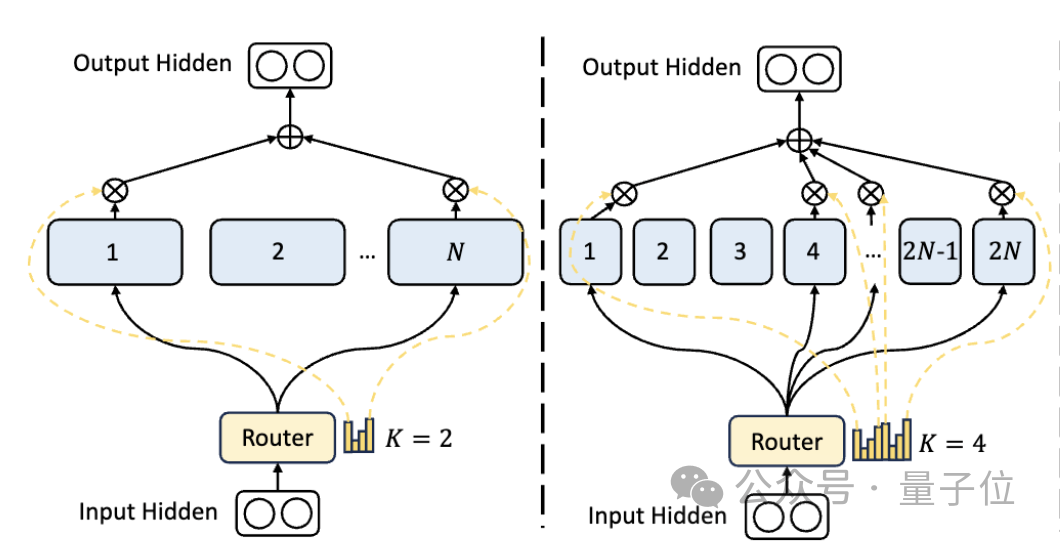

まず、従来の MoE アーキテクチャと比較して、DeepSeek にはよりきめ細かい専門部門があります。

パラメータの総数が固定されている場合、従来のモデルは N 人の専門家を分類できますが、DeepSeek は 2N 人の専門家を分類できます。

同時に、タスクを実行するたびに選択される専門家の数が従来のモデルの 2 倍になるため、使用されるパラメータの総数は変わりませんが、選択の自由度が高まります。

このセグメンテーション戦略により、アクティベーション専門家のより柔軟かつ適応的な組み合わせが可能になり、それによってさまざまなタスクにおけるモデルの精度と知識獲得の適切性が向上します。

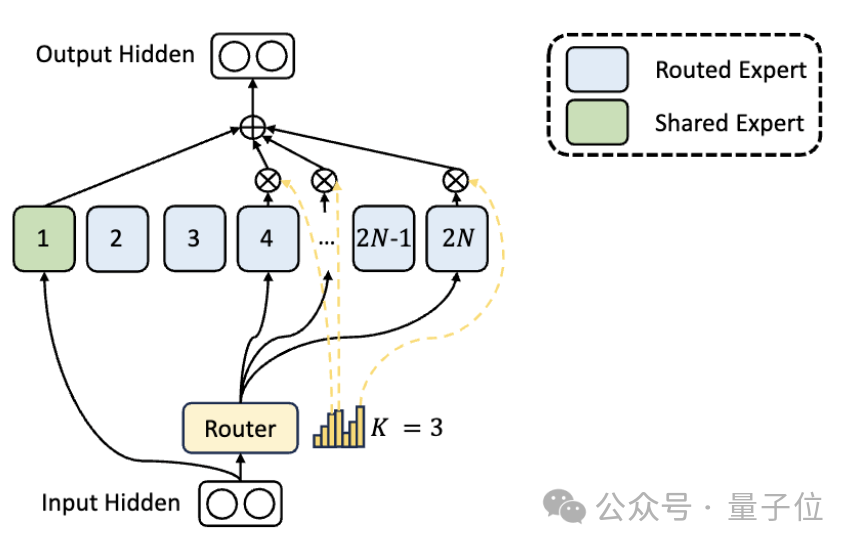

エキスパート部門の違いに加えて、DeepSeek では「共有エキスパート」設定も革新的に導入されています。

これらの共有エキスパートは、すべての入力のトークンをアクティブ化し、ルーティング モジュールの影響を受けません。目的は、さまざまなコンテキストで必要な共通の知識を取得して統合することです。

これらの共有知識を共有エキスパートに圧縮することで、他のエキスパート間のパラメーターの重複を減らすことができ、それによってモデルのパラメーター効率が向上します。

共有エキスパートを設定すると、他のエキスパートが独自の知識領域にさらに集中できるようになり、専門家の専門性の全体的なレベルが向上します。

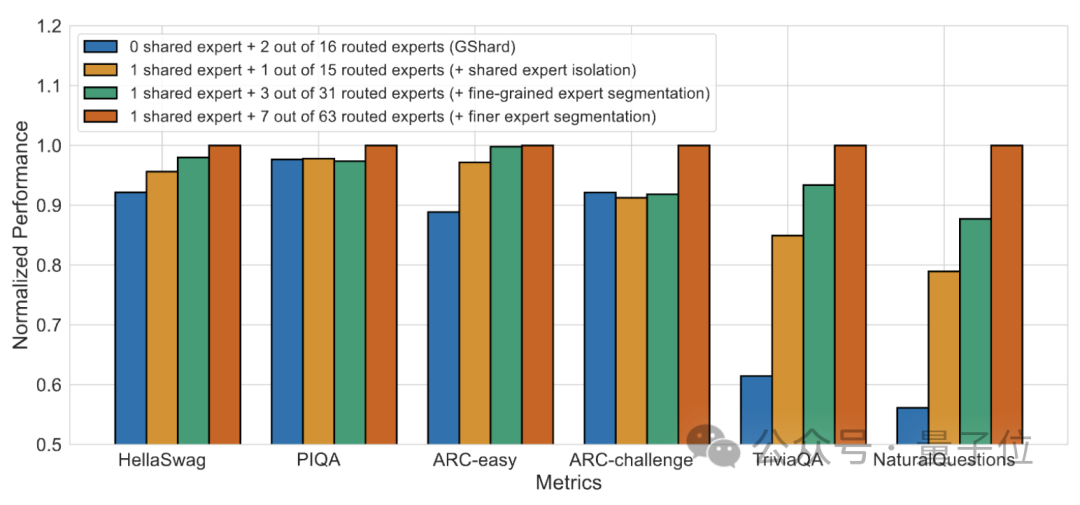

#アブレーション実験の結果は、両方のソリューションが DeepSeek MoE の「コスト削減と効率向上」において重要な役割を果たすことを示しています。

論文アドレス: https://arxiv.org/abs/2401.06066。

参考リンク: https://mp.weixin.qq.com/s/T9-EGxYuHcGQgXArLXGbgg。

以上が国内の大規模オープンソースMoEモデルを導入、Llama 2-7Bと同等の性能を持ちながら計算量を60%削減の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7563

7563

15

15

1385

1385

52

52

84

84

11

11

28

28

99

99

Bytedance Cutting が SVIP スーパー メンバーシップを開始: 継続的な年間サブスクリプションは 499 元で、さまざまな AI 機能を提供

Jun 28, 2024 am 03:51 AM

Bytedance Cutting が SVIP スーパー メンバーシップを開始: 継続的な年間サブスクリプションは 499 元で、さまざまな AI 機能を提供

Jun 28, 2024 am 03:51 AM

このサイトは6月27日、JianyingはByteDanceの子会社であるFaceMeng Technologyによって開発されたビデオ編集ソフトウェアであり、Douyinプラットフォームに依存しており、基本的にプラットフォームのユーザー向けに短いビデオコンテンツを作成すると報告しました。 Windows、MacOS、その他のオペレーティング システム。 Jianyingは会員システムのアップグレードを正式に発表し、インテリジェント翻訳、インテリジェントハイライト、インテリジェントパッケージング、デジタルヒューマン合成などのさまざまなAIブラックテクノロジーを含む新しいSVIPを開始しました。価格的には、クリッピングSVIPの月額料金は79元、年会費は599元(当サイト注:月額49.9元に相当)、継続月額サブスクリプションは月額59元、継続年間サブスクリプションは、年間499元(月額41.6元に相当)です。さらに、カット担当者は、ユーザーエクスペリエンスを向上させるために、オリジナルのVIPに登録している人は、

Rag と Sem-Rag を使用したコンテキスト拡張 AI コーディング アシスタント

Jun 10, 2024 am 11:08 AM

Rag と Sem-Rag を使用したコンテキスト拡張 AI コーディング アシスタント

Jun 10, 2024 am 11:08 AM

検索強化生成およびセマンティック メモリを AI コーディング アシスタントに組み込むことで、開発者の生産性、効率、精度を向上させます。 JanakiramMSV 著者の EnhancingAICodingAssistantswithContextUsingRAGandSEM-RAG から翻訳。基本的な AI プログラミング アシスタントは当然役に立ちますが、ソフトウェア言語とソフトウェア作成の最も一般的なパターンに関する一般的な理解に依存しているため、最も適切で正しいコードの提案を提供できないことがよくあります。これらのコーディング アシスタントによって生成されたコードは、彼らが解決する責任を負っている問題の解決には適していますが、多くの場合、個々のチームのコーディング標準、規約、スタイルには準拠していません。これにより、コードがアプリケーションに受け入れられるように修正または調整する必要がある提案が得られることがよくあります。

微調整によって本当に LLM が新しいことを学習できるようになるのでしょうか: 新しい知識を導入すると、モデルがより多くの幻覚を生成する可能性があります

Jun 11, 2024 pm 03:57 PM

微調整によって本当に LLM が新しいことを学習できるようになるのでしょうか: 新しい知識を導入すると、モデルがより多くの幻覚を生成する可能性があります

Jun 11, 2024 pm 03:57 PM

大規模言語モデル (LLM) は巨大なテキスト データベースでトレーニングされ、そこで大量の現実世界の知識を取得します。この知識はパラメータに組み込まれており、必要なときに使用できます。これらのモデルの知識は、トレーニングの終了時に「具体化」されます。事前トレーニングの終了時に、モデルは実際に学習を停止します。モデルを調整または微調整して、この知識を活用し、ユーザーの質問により自然に応答する方法を学びます。ただし、モデルの知識だけでは不十分な場合があり、モデルは RAG を通じて外部コンテンツにアクセスできますが、微調整を通じてモデルを新しいドメインに適応させることが有益であると考えられます。この微調整は、ヒューマン アノテーターまたは他の LLM 作成物からの入力を使用して実行され、モデルは追加の実世界の知識に遭遇し、それを統合します。

GenAI および LLM の技術面接に関する 7 つのクールな質問

Jun 07, 2024 am 10:06 AM

GenAI および LLM の技術面接に関する 7 つのクールな質問

Jun 07, 2024 am 10:06 AM

AIGC について詳しくは、51CTOAI.x コミュニティ https://www.51cto.com/aigc/Translator|Jingyan Reviewer|Chonglou を参照してください。これらの質問は、インターネット上のどこでも見られる従来の質問バンクとは異なります。既成概念にとらわれずに考える必要があります。大規模言語モデル (LLM) は、データ サイエンス、生成人工知能 (GenAI)、および人工知能の分野でますます重要になっています。これらの複雑なアルゴリズムは人間のスキルを向上させ、多くの業界で効率とイノベーションを推進し、企業が競争力を維持するための鍵となります。 LLM は、自然言語処理、テキスト生成、音声認識、推奨システムなどの分野で幅広い用途に使用できます。 LLM は大量のデータから学習することでテキストを生成できます。

あなたが知らない機械学習の 5 つの流派

Jun 05, 2024 pm 08:51 PM

あなたが知らない機械学習の 5 つの流派

Jun 05, 2024 pm 08:51 PM

機械学習は人工知能の重要な分野であり、明示的にプログラムしなくてもコンピューターにデータから学習して能力を向上させる機能を提供します。機械学習は、画像認識や自然言語処理から、レコメンデーションシステムや不正行為検出に至るまで、さまざまな分野で幅広く応用されており、私たちの生活様式を変えつつあります。機械学習の分野にはさまざまな手法や理論があり、その中で最も影響力のある 5 つの手法は「機械学習の 5 つの流派」と呼ばれています。 5 つの主要な学派は、象徴学派、コネクショニスト学派、進化学派、ベイジアン学派、およびアナロジー学派です。 1. 象徴主義は、象徴主義とも呼ばれ、論理的推論と知識の表現のためのシンボルの使用を強調します。この学派は、学習は既存の既存の要素を介した逆演繹のプロセスであると信じています。

新しい科学的で複雑な質問応答ベンチマークと大規模モデルの評価システムを提供するために、UNSW、アルゴンヌ、シカゴ大学、およびその他の機関が共同で SciQAG フレームワークを立ち上げました。

Jul 25, 2024 am 06:42 AM

新しい科学的で複雑な質問応答ベンチマークと大規模モデルの評価システムを提供するために、UNSW、アルゴンヌ、シカゴ大学、およびその他の機関が共同で SciQAG フレームワークを立ち上げました。

Jul 25, 2024 am 06:42 AM

編集者 |ScienceAI 質問応答 (QA) データセットは、自然言語処理 (NLP) 研究を促進する上で重要な役割を果たします。高品質の QA データ セットは、モデルの微調整に使用できるだけでなく、大規模言語モデル (LLM) の機能、特に科学的知識を理解し推論する能力を効果的に評価することもできます。現在、医学、化学、生物学、その他の分野をカバーする多くの科学 QA データ セットがありますが、これらのデータ セットにはまだいくつかの欠点があります。まず、データ形式は比較的単純で、そのほとんどが多肢選択式の質問であり、評価は簡単ですが、モデルの回答選択範囲が制限され、科学的な質問に回答するモデルの能力を完全にテストすることはできません。対照的に、自由回答型の Q&A

SOTA パフォーマンス、厦門マルチモーダルタンパク質-リガンド親和性予測 AI 手法、初めて分子表面情報を結合

Jul 17, 2024 pm 06:37 PM

SOTA パフォーマンス、厦門マルチモーダルタンパク質-リガンド親和性予測 AI 手法、初めて分子表面情報を結合

Jul 17, 2024 pm 06:37 PM

編集者 | KX 医薬品の研究開発の分野では、タンパク質とリガンドの結合親和性を正確かつ効果的に予測することが、医薬品のスクリーニングと最適化にとって重要です。しかし、現在の研究では、タンパク質とリガンドの相互作用における分子表面情報の重要な役割が考慮されていません。これに基づいて、アモイ大学の研究者らは、初めてタンパク質の表面、3D 構造、配列に関する情報を組み合わせ、クロスアテンション メカニズムを使用して異なるモダリティの特徴を比較する、新しいマルチモーダル特徴抽出 (MFE) フレームワークを提案しました。アライメント。実験結果は、この方法がタンパク質-リガンド結合親和性の予測において最先端の性能を達成することを実証しています。さらに、アブレーション研究は、この枠組み内でのタンパク質表面情報と多峰性特徴の位置合わせの有効性と必要性を実証しています。 「S」で始まる関連研究

SKハイニックスは8月6日に12層HBM3E、321層NANDなどのAI関連新製品を展示する。

Aug 01, 2024 pm 09:40 PM

SKハイニックスは8月6日に12層HBM3E、321層NANDなどのAI関連新製品を展示する。

Aug 01, 2024 pm 09:40 PM

8月1日の本サイトのニュースによると、SKハイニックスは本日(8月1日)ブログ投稿を発表し、8月6日から8日まで米国カリフォルニア州サンタクララで開催されるグローバル半導体メモリサミットFMS2024に参加すると発表し、多くの新世代の製品。フューチャー メモリおよびストレージ サミット (FutureMemoryandStorage) の紹介。以前は主に NAND サプライヤー向けのフラッシュ メモリ サミット (FlashMemorySummit) でしたが、人工知能技術への注目の高まりを背景に、今年はフューチャー メモリおよびストレージ サミット (FutureMemoryandStorage) に名前が変更されました。 DRAM およびストレージ ベンダー、さらに多くのプレーヤーを招待します。昨年発売された新製品SKハイニックス