更新された Point Transformer: より効率的、高速、そして強力になりました。

原題: Point Transformer V3: Simpler, Faster, Stronger

論文リンク: https://arxiv.org/pdf/2312.10035.pdf

コードリンク: https:// github.com/Pointcept/PointTransformerV3

著者の所属: HKU SH AI Lab MPI PKU MIT

論文のアイデア:

この記事は、注意メカニズムに焦点を当て、内部の革新を追求します。代わりに、スケールの力を活用して、点群処理のコンテキストにおける精度と効率の間の既存のトレードオフを克服することに焦点を当てています。この論文は、3D 大規模表現学習における最近の進歩からインスピレーションを得て、モデルのパフォーマンスが設計の複雑さよりもスケールによって影響を受けることを認識しています。したがって、この論文では、特定のパターンで編成された点群など、スケーリング後の全体的なパフォーマンスへの影響が少ない特定のメカニズムの精度よりも単純さと効率を優先する Point Transformer V3 (PTv3) を提案します。正確な近隣検索。この原理により、大幅なスケーリングが可能になり、効率を維持しながら受容野を 16 ポイントから 1024 ポイントに拡張できます (以前の PTv2 と比較して 3 倍高速な処理と 10 倍のメモリ効率)。 PTv3 は、屋内および屋外のシナリオをカバーする 20 以上の下流タスクで最先端の結果を達成します。 PTv3 は、これらの結果を次のレベルに引き上げ、マルチデータセットの共同トレーニングによるさらなる機能強化を実現します。

ネットワーク設計:

3D 表現学習における最近の進歩 [85] は、複数の 3D データセットにわたる協調的なトレーニング方法を導入することにより、点群処理の限界を克服しています。データサイズの制限に基づいて作成されています。この戦略と組み合わせると、効率的な畳み込みバックボーン [12] が、点群変換器 [38、84] に通常伴う精度のギャップを効果的に埋めることができます。ただし、点群変換器自体は、スパース畳み込みと比較した点群変換器の効率ギャップのため、このスケールの利点をまだ十分に享受できていません。この発見は、スケーリング原理の観点から点変圧器の設計選択を再検討するという、この研究の最初の動機を形成しました。この論文では、モデルのパフォーマンスは、複雑な設計よりも規模によって大きく影響されると考えています。

したがって、この記事では、スケーラビリティを実現するために、特定のメカニズムの精度よりもシンプルさと効率を優先する Point Transformer V3 (PTv3) を紹介します。このような調整は、スケーリング後の全体的なパフォーマンスにほとんど影響しません。具体的には、PTv3 は、優れた効率とスケーラビリティを実現するために次の調整を行います。

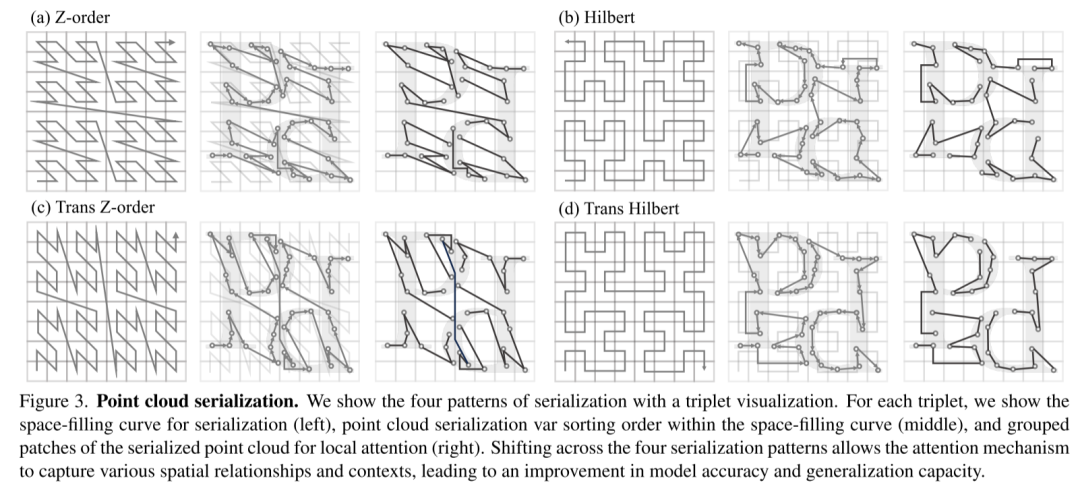

- 最近の 2 つの進歩 [48、77] に触発され、構造化された非構造化点群の利点を認識し、スケーラビリティの利点を考慮して、PTv3 は従来の空間空間を変更します。 K-Nearest Neighbors (KNN) クエリによって定義される近接性。転送時間の 28% を占めます。代わりに、特定のパターンに従って編成された点群内の直列化された近傍の可能性を探ります。

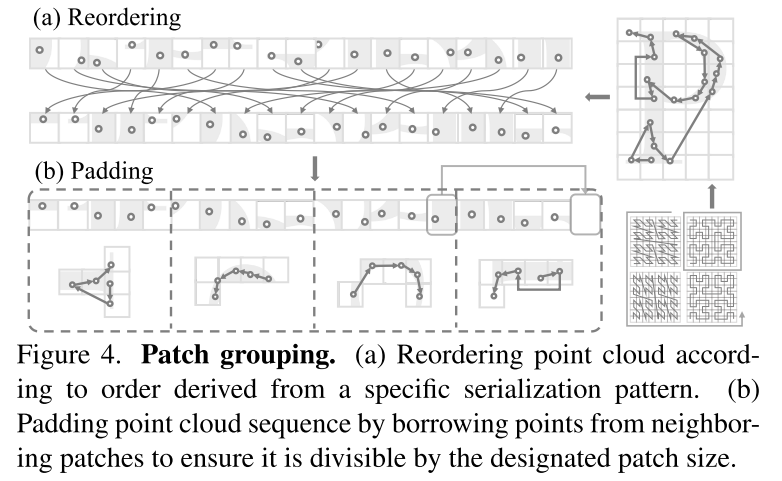

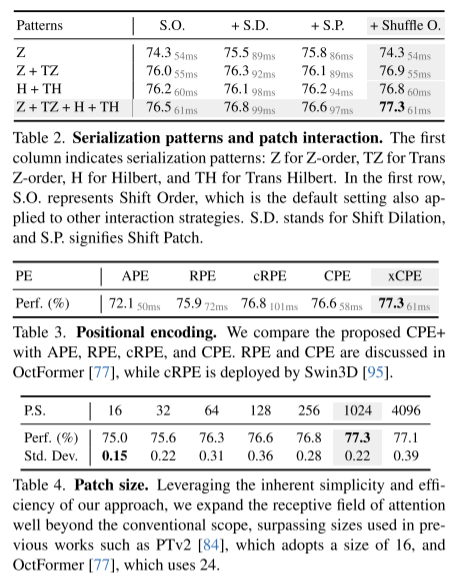

- PTv3 は、シリアル化された点群に合わせた簡素化されたアプローチを採用し、シフト ウィンドウ (アテンション オペレーターの融合を妨げる) や近隣メカニズム (大量のメモリ消費を引き起こす) などのより複雑なアテンション パッチ相互作用メカニズムを置き換えます。

- PTv3 は、転送時間の 26% を占める相対位置エンコーディングへの依存を排除し、よりシンプルなフロントエンドのスパース畳み込み層を採用します。

この記事では、これらの設計は、スケーリング原理と既存の点群変換器の進歩によって推進される直感的な選択であると考えています。重要なことに、この記事では、詳細なモジュール設計ではなく、スケーラビリティがバックボーン設計にどのような影響を与えるかを理解することが非常に重要であることを強調しています。

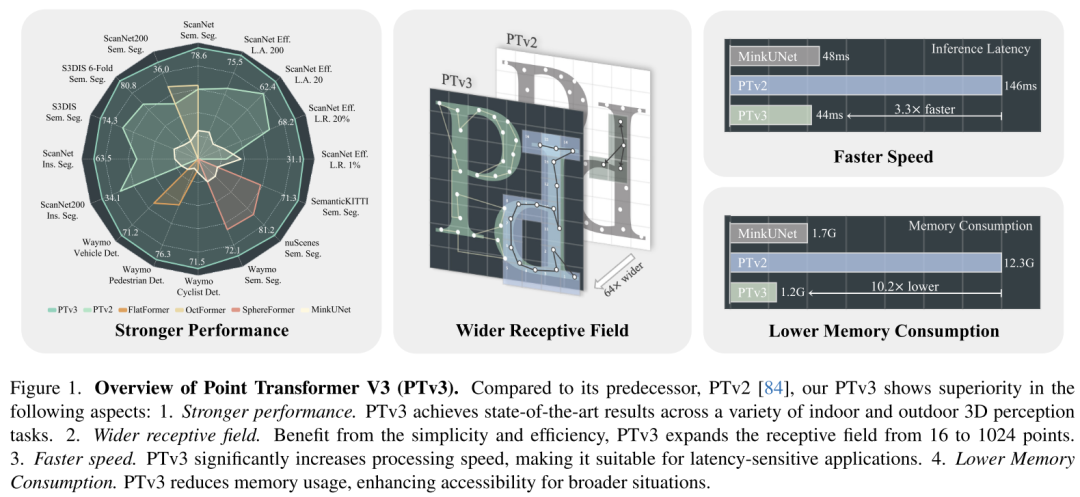

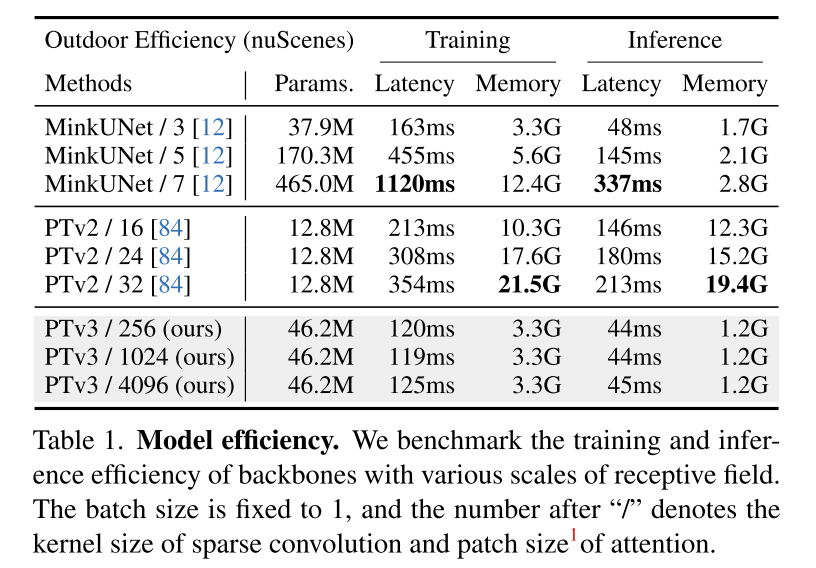

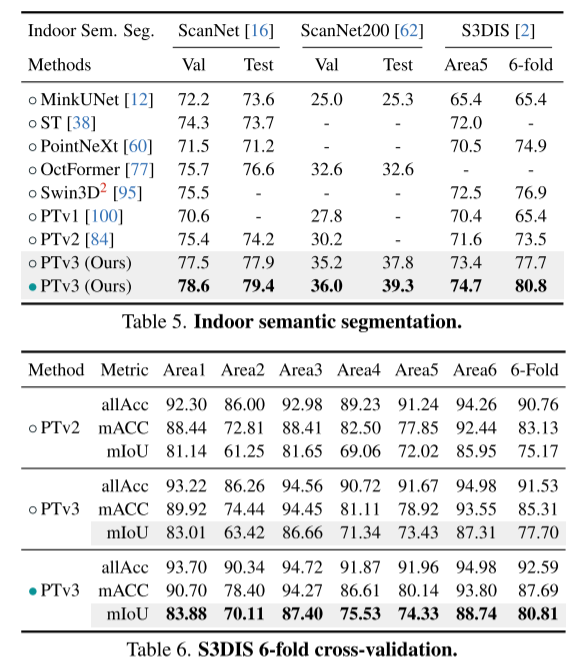

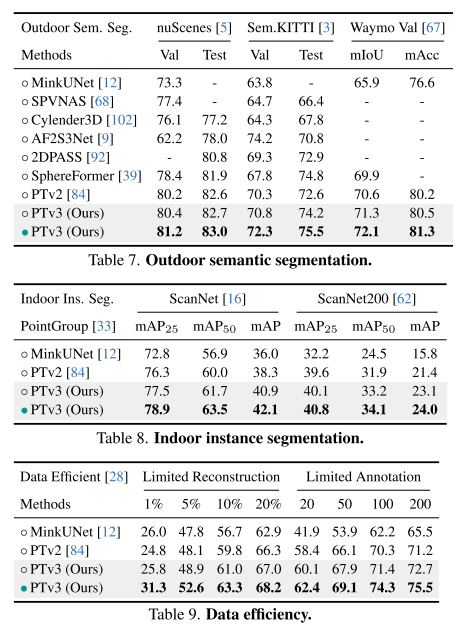

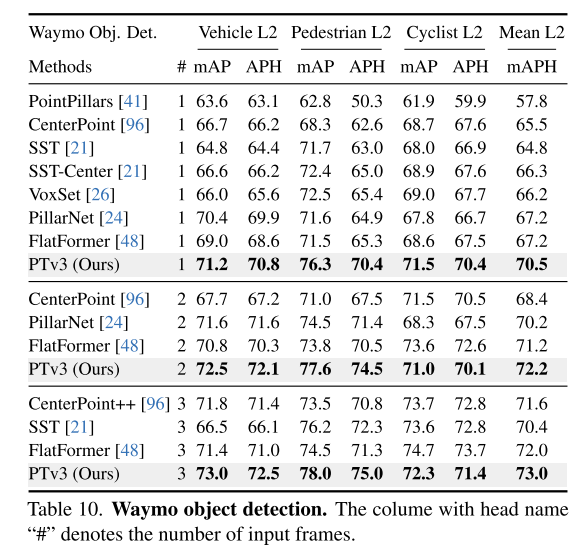

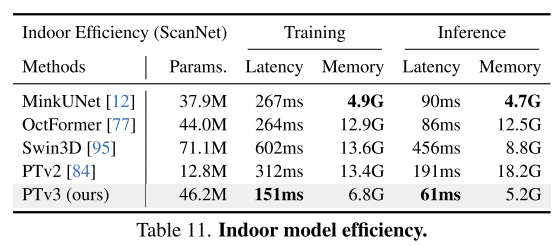

この原理により、スケーラビリティが大幅に向上し、精度と効率の間の従来のトレードオフが克服されます (図 1 を参照)。 PTv3 は、以前のバージョンと比べて 3.3 倍高速な推論と 10.2 倍のメモリ使用量を実現します。さらに重要なことは、PTv3 はその固有の感知範囲を拡張する能力を活用し、効率を維持しながら受容野を 16 点から 1024 点に拡張します。この拡張性は現実世界の認識タスクにおける優れたパフォーマンスを支えており、PTv3 は屋内および屋外のシナリオで 20 以上の下流タスクで最先端の結果を達成しています。 PTv3 は、マルチデータセットトレーニングを通じてデータサイズをさらに増やすことで、これらの結果をさらに改善します [85]。この記事の洞察が、この方向での将来の研究に刺激を与えることが期待されます。

図 1. Point Transformer V3 (PTv3) の概要。前任者の PTv2 [84] と比較して、この論文の PTv3 は次の点で優れていることを示しています。 1. より強力なパフォーマンス。 PTv3 は、屋内および屋外のさまざまな 3D 認識タスクで最先端の結果を達成します。 2. より広い受容野。シンプルさと効率の恩恵を受けて、PTv3 は受容野を 16 ポイントから 1024 ポイントに拡張します。 3. より速く。 PTv3 は処理速度を大幅に向上させ、遅延に敏感なアプリケーションに適しています。 4. メモリ消費量を削減します。 PTv3 はメモリ使用量を削減し、幅広い状況でのアクセシビリティを強化します。

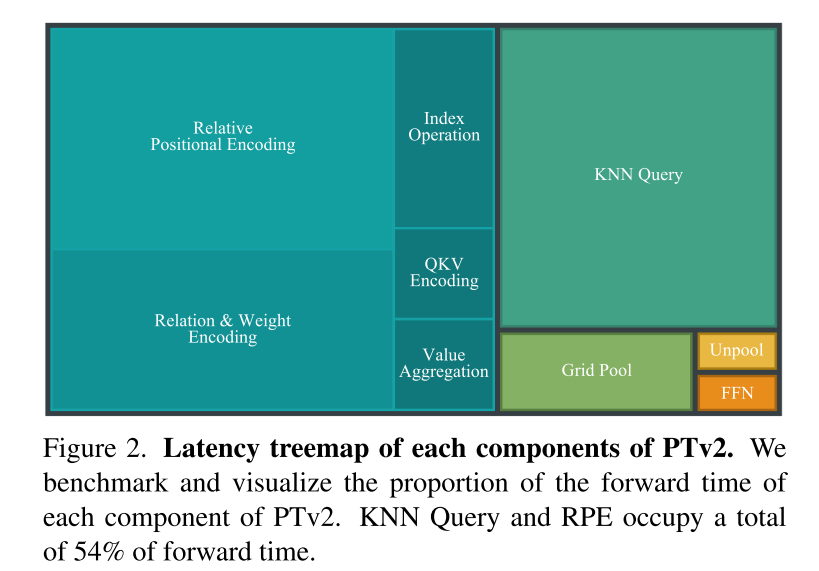

図 2. PTv2 の各コンポーネントの遅延ツリー図。この記事では、PTv2 の各コンポーネントの転送時間比率をベンチマークし、視覚化します。 KNN クエリと RPE は合計転送時間の 54% を占めます。

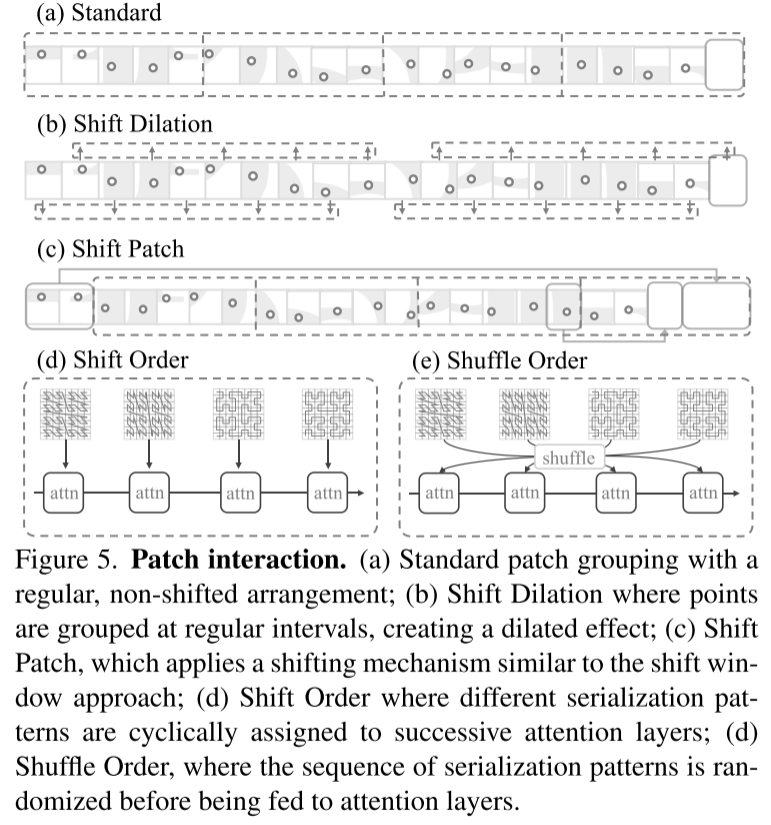

#図 5. パッチの相互作用。 (a) 規則的でシフトのない配置による標準パッチ グループ化、(b) 拡張効果を生み出すためにポイントが一定の間隔で集約される並進拡張、(c) シフト パッチと同様のシフト メカニズムを使用するシフトウィンドウ法、(d) 異なるシリアル化パターンが連続する注目層に周期的に割り当てられるシフト順序、(d) シリアル化パターンのシーケンスが注目層に入力される前にランダム化されるシャッフル順序。

#図 5. パッチの相互作用。 (a) 規則的でシフトのない配置による標準パッチ グループ化、(b) 拡張効果を生み出すためにポイントが一定の間隔で集約される並進拡張、(c) シフト パッチと同様のシフト メカニズムを使用するシフトウィンドウ法、(d) 異なるシリアル化パターンが連続する注目層に周期的に割り当てられるシフト順序、(d) シリアル化パターンのシーケンスが注目層に入力される前にランダム化されるシャッフル順序。

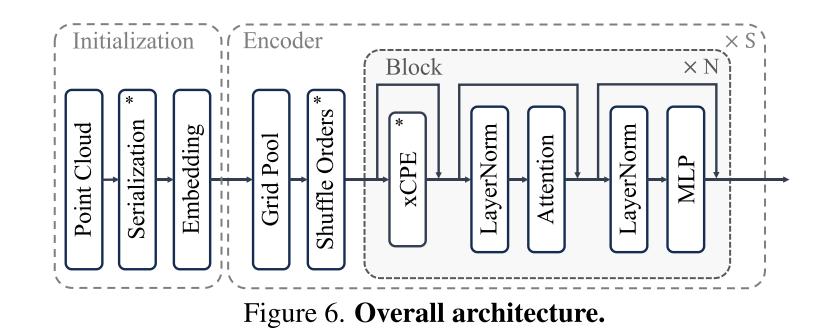

図 6. 全体的なアーキテクチャ。 #########実験結果: ##################################### #

図 6. 全体的なアーキテクチャ。 #########実験結果: ##################################### #

概要:

概要:

この記事では、問題の克服に向けて機能する Point Transformer V3 を紹介します。点群処理における精度と効率の間の従来のトレードオフは、大きく前進します。この論文は、バックボーン設計におけるスケーリング原理の新しい解釈に基づいて、モデルのパフォーマンスが設計の複雑さよりもスケールによって大きく影響を受けると主張しています。この論文では、小型の衝撃メカニズムの精度よりも効率を優先することで、スケールの力を活用し、パフォーマンスを向上させています。つまり、この記事では、モデルをよりシンプルかつ高速にすることで、モデルをより強力にすることができます。

この記事では、問題の克服に向けて機能する Point Transformer V3 を紹介します。点群処理における精度と効率の間の従来のトレードオフは、大きく前進します。この論文は、バックボーン設計におけるスケーリング原理の新しい解釈に基づいて、モデルのパフォーマンスが設計の複雑さよりもスケールによって大きく影響を受けると主張しています。この論文では、小型の衝撃メカニズムの精度よりも効率を優先することで、スケールの力を活用し、パフォーマンスを向上させています。つまり、この記事では、モデルをよりシンプルかつ高速にすることで、モデルをより強力にすることができます。

引用:

引用:

Wu, X.、Jiang, L.、Wang, P.、Liu, Z.、Liu, X.、Qiao, Y.、 Ouyang, W.、He, T.、& Zhao, H. (2023).Point Transformer V3: Simpler, Faster, Stronger.

Wu, X.、Jiang, L.、Wang, P.、Liu, Z.、Liu, X.、Qiao, Y.、 Ouyang, W.、He, T.、& Zhao, H. (2023).Point Transformer V3: Simpler, Faster, Stronger.

ArXiv. /abs/2312.10035

以上が更新された Point Transformer: より効率的、高速、そして強力になりました。の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7503

7503

15

15

1377

1377

52

52

78

78

11

11

19

19

54

54

オープンソース!ゾーイデプスを超えて! DepthFM: 高速かつ正確な単眼深度推定!

Apr 03, 2024 pm 12:04 PM

オープンソース!ゾーイデプスを超えて! DepthFM: 高速かつ正確な単眼深度推定!

Apr 03, 2024 pm 12:04 PM

0.この記事は何をするのですか?私たちは、多用途かつ高速な最先端の生成単眼深度推定モデルである DepthFM を提案します。従来の深度推定タスクに加えて、DepthFM は深度修復などの下流タスクでも最先端の機能を実証します。 DepthFM は効率的で、いくつかの推論ステップ内で深度マップを合成できます。この作品について一緒に読みましょう〜 1. 論文情報タイトル: DepthFM: FastMonocularDepthEstimationwithFlowMatching 著者: MingGui、JohannesS.Fischer、UlrichPrestel、PingchuanMa、Dmytr

エンコーダ/デコーダ アーキテクチャを放棄し、より効果的なエッジ検出に拡散モデルを使用する 国立防衛工科大学は DiffusionEdge を提案しました

Feb 07, 2024 pm 10:12 PM

エンコーダ/デコーダ アーキテクチャを放棄し、より効果的なエッジ検出に拡散モデルを使用する 国立防衛工科大学は DiffusionEdge を提案しました

Feb 07, 2024 pm 10:12 PM

現在のディープ エッジ検出ネットワークは通常、エンコーダ/デコーダ アーキテクチャを採用しています。このアーキテクチャには、マルチレベルの特徴をより適切に抽出するためのアップ サンプリング モジュールとダウン サンプリング モジュールが含まれています。ただし、この構造では、ネットワークが正確かつ詳細なエッジ検出結果を出力することが制限されます。この問題に対して、AAAI2024 に関する論文は新しい解決策を提供しています。論文のタイトル: DiffusionEdge:DiffusionProbabilisticModelforCrispEdgeDetection 著者: Ye Yunfan (国立国防技術大学)、Xu Kai (国立国防技術大学)、Huang Yuxing (国立国防技術大学)、Yi Renjiao (国立国防技術大学)、Cai Zhiping (防衛工科大学) 論文リンク:https://ar

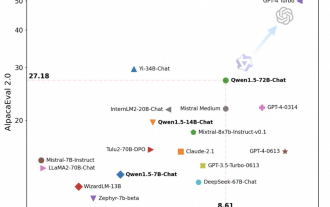

Tongyi Qianwen が再びオープンソースになり、Qwen1.5 では 6 つのボリューム モデルが提供され、そのパフォーマンスは GPT3.5 を超えます

Feb 07, 2024 pm 10:15 PM

Tongyi Qianwen が再びオープンソースになり、Qwen1.5 では 6 つのボリューム モデルが提供され、そのパフォーマンスは GPT3.5 を超えます

Feb 07, 2024 pm 10:15 PM

春節に合わせて、Tongyi Qianwen Model (Qwen) のバージョン 1.5 がオンラインになりました。今朝、新しいバージョンのニュースが AI コミュニティの注目を集めました。大型モデルの新バージョンには、0.5B、1.8B、4B、7B、14B、72Bの6つのモデルサイズが含まれています。その中でも最強バージョンの性能はGPT3.5やMistral-Mediumを上回ります。このバージョンには Base モデルと Chat モデルが含まれており、多言語サポートを提供します。アリババの同義前文チームは、関連技術が同義前文公式ウェブサイトと同義前文アプリでもリリースされたと述べた。さらに、本日の Qwen 1.5 リリースには、32K のコンテキスト長のサポート、Base+Chat モデルのチェックポイントのオープン、および 32K のコンテキスト長のサポートなどのハイライトもあります。

大規模なモデルもスライスでき、Microsoft SliceGPT により LLAMA-2 の計算効率が大幅に向上します。

Jan 31, 2024 am 11:39 AM

大規模なモデルもスライスでき、Microsoft SliceGPT により LLAMA-2 の計算効率が大幅に向上します。

Jan 31, 2024 am 11:39 AM

大規模言語モデル (LLM) には通常、数十億のパラメーターがあり、数兆のトークンでトレーニングされます。ただし、このようなモデルのトレーニングとデプロイには非常にコストがかかります。計算要件を軽減するために、さまざまなモデル圧縮技術がよく使用されます。これらのモデル圧縮技術は一般に、蒸留、テンソル分解 (低ランク因数分解を含む)、枝刈り、および量子化の 4 つのカテゴリに分類できます。プルーニング手法は以前から存在していましたが、多くはパフォーマンスを維持するためにプルーニング後にリカバリ微調整 (RFT) を必要とするため、プロセス全体のコストが高くつき、拡張が困難になります。チューリッヒ工科大学とマイクロソフトの研究者は、この問題に対する SliceGPT と呼ばれる解決策を提案しました。この方法の中心となるアイデアは、重み行列の行と列を削除することでネットワークの埋め込みを減らすことです。

こんにちは、電気アトラスです!ボストン・ダイナミクスのロボットが復活、180度の奇妙な動きにマスク氏も恐怖

Apr 18, 2024 pm 07:58 PM

こんにちは、電気アトラスです!ボストン・ダイナミクスのロボットが復活、180度の奇妙な動きにマスク氏も恐怖

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas は正式に電動ロボットの時代に突入します!昨日、油圧式アトラスが歴史の舞台から「涙ながらに」撤退したばかりですが、今日、ボストン・ダイナミクスは電動式アトラスが稼働することを発表しました。ボストン・ダイナミクス社は商用人型ロボットの分野でテスラ社と競争する決意を持っているようだ。新しいビデオが公開されてから、わずか 10 時間ですでに 100 万人以上が視聴しました。古い人が去り、新しい役割が現れるのは歴史的な必然です。今年が人型ロボットの爆発的な年であることは間違いありません。ネットユーザーは「ロボットの進歩により、今年の開会式は人間のように見え、人間よりもはるかに自由度が高い。しかし、これは本当にホラー映画ではないのか?」とコメントした。ビデオの冒頭では、アトラスは仰向けに見えるように地面に静かに横たわっています。次に続くのは驚くべきことです

更新された Point Transformer: より効率的、高速、そして強力になりました。

Jan 17, 2024 am 08:27 AM

更新された Point Transformer: より効率的、高速、そして強力になりました。

Jan 17, 2024 am 08:27 AM

原題: PointTransformerV3: Simpler, Faster, Stronger 論文リンク: https://arxiv.org/pdf/2312.10035.pdf コードリンク: https://github.com/Pointcept/PointTransformerV3 著者単位: HKUSHAILabMPIPKUMIT 論文アイデア: この記事は「注目メカニズム内のイノベーションを求めて」で公開することを目的としたものではありません。代わりに、スケールの力を活用して、点群処理のコンテキストにおける精度と効率の間の既存のトレードオフを克服することに焦点を当てています。 3D 大規模表現学習の最近の進歩からインスピレーションを得て、

Kuaishou バージョンの Sora「Ke Ling」がテスト用に公開されています。120 秒以上のビデオを生成し、物理学をより深く理解し、複雑な動きを正確にモデル化できます。

Jun 11, 2024 am 09:51 AM

Kuaishou バージョンの Sora「Ke Ling」がテスト用に公開されています。120 秒以上のビデオを生成し、物理学をより深く理解し、複雑な動きを正確にモデル化できます。

Jun 11, 2024 am 09:51 AM

何?ズートピアは国産AIによって実現するのか?ビデオとともに公開されたのは、「Keling」と呼ばれる新しい大規模な国産ビデオ生成モデルです。 Sora も同様の技術的ルートを使用し、自社開発の技術革新を多数組み合わせて、大きく合理的な動きをするだけでなく、物理世界の特性をシミュレートし、強力な概念的結合能力と想像力を備えたビデオを制作します。データによると、Keling は、最大 1080p の解像度で 30fps で最大 2 分の超長時間ビデオの生成をサポートし、複数のアスペクト比をサポートします。もう 1 つの重要な点は、Keling は研究所が公開したデモやビデオ結果のデモンストレーションではなく、ショートビデオ分野のリーダーである Kuaishou が立ち上げた製品レベルのアプリケーションであるということです。さらに、主な焦点は実用的であり、白紙小切手を書かず、リリースされたらすぐにオンラインに移行することです。Ke Ling の大型モデルは Kuaiying でリリースされました。

Gemini Pro に追いつき、推論機能と OCR 機能を向上させた LLaVA-1.6 は強力すぎます

Feb 01, 2024 pm 04:51 PM

Gemini Pro に追いつき、推論機能と OCR 機能を向上させた LLaVA-1.6 は強力すぎます

Feb 01, 2024 pm 04:51 PM

昨年 4 月、ウィスコンシン大学マディソン校、マイクロソフト リサーチ、コロンビア大学の研究者が共同で LLaVA (Large Language and Vision Assistant) をリリースしました。 LLaVA は小規模なマルチモーダル命令データセットでのみトレーニングされていますが、一部のサンプルでは GPT-4 と非常によく似た推論結果を示します。その後 10 月に、オリジナルの LLaVA に簡単な変更を加えて 11 のベンチマークの SOTA を更新した LLaVA-1.5 をリリースしました。このアップグレードの結果は非常に刺激的で、マルチモーダル AI アシスタントの分野に新たなブレークスルーをもたらします。研究チームは、推論、OCR、および