知識の圧縮: モデルの蒸留とモデルの枝刈り

モデルの蒸留と枝刈りは、パラメーターと計算の複雑さを効果的に軽減し、操作効率とパフォーマンスを向上させるニューラル ネットワーク モデル圧縮テクノロジーです。モデルの蒸留では、より大きなモデルでより小さなモデルをトレーニングし、知識を伝達することでパフォーマンスを向上させます。プルーニングは、冗長な接続とパラメーターを削除することでモデルのサイズを削減します。これら 2 つの手法は、モデルの圧縮と最適化に非常に役立ちます。

モデルの蒸留

モデルの蒸留は、より小さなモデルをトレーニングすることによって、大規模なモデルの予測能力を再現する手法です。大きいモデルを「教師モデル」、小さいモデルを「生徒モデル」と呼びます。通常、教師モデルにはより多くのパラメータと複雑性があるため、トレーニング データとテスト データによりよく適合できます。モデルの蒸留では、教師モデルの予測動作を模倣するように生徒モデルがトレーニングされ、より小さなモデル ボリュームで同様のパフォーマンスを達成します。このように、モデルの蒸留により、モデルの予測能力を維持しながらモデルのボリュームを削減できます。

具体的には、モデルの蒸留は次の手順で行われます。

教師モデルをトレーニングするときは、通常、バックプロパゲーションや逆伝播などの従来の方法を使用します。確率的勾配降下法を使用して、大規模なディープ ニューラル ネットワーク モデルをトレーニングし、トレーニング データで適切に実行されることを確認します。

2. ソフト ラベルの生成: 教師モデルを使用してトレーニング データを予測し、その出力をソフト ラベルとして使用します。ソフト ラベルの概念は、従来のハード ラベル (ワンホット エンコーディング) に基づいて開発されており、より継続的な情報を提供し、異なるカテゴリ間の関係をより適切に説明できます。

3. スチューデント モデルをトレーニングする: ソフト ラベルを目的関数として使用して、小さなディープ ニューラル ネットワーク モデルをトレーニングし、トレーニング データで適切に実行できるようにします。現時点では、学生モデルの入力と出力は教師モデルと同じですが、モデルのパラメータと構造はより単純化され、合理化されています。

モデル蒸留の利点は、パフォーマンスを維持しながら、小規模なモデルの計算の複雑さとストレージの要件を軽減できることです。さらに、ソフトラベルを使用すると、より継続的な情報が提供されるため、学生モデルはさまざまなカテゴリ間の関係をよりよく学習できるようになります。モデル蒸留は、自然言語処理、コンピューター ビジョン、音声認識などのさまざまな応用分野で広く使用されています。

モデル プルーニング

モデル プルーニングは、不要なニューロンと接続を削除することによってニューラル ネットワーク モデルを圧縮する手法です。ニューラル ネットワーク モデルには通常、多数のパラメーターと冗長な接続があります。これらのパラメーターと接続はモデルのパフォーマンスに大きな影響を与えないかもしれませんが、モデルの計算の複雑さとストレージ スペースの要件が大幅に増加します。モデルの枝刈りでは、モデルのパフォーマンスを維持しながら、これらの無駄なパラメーターと接続を削除することで、モデルのサイズと計算の複雑さを軽減できます。

モデル枝刈りの具体的な手順は次のとおりです:

1. 元のモデルをトレーニングします: バックプロパゲーションやバックプロパゲーションなどの従来のトレーニング方法を使用します。ランダム化 勾配降下法は、大規模なディープ ニューラル ネットワーク モデルをトレーニングし、トレーニング データで適切なパフォーマンスを発揮します。

2. ニューロンの重要性を評価する: いくつかの方法 (L1 正則化、ヘシアン行列、テイラー展開など) を使用して、各ニューロンの重要性、つまり最終的なニューロンの重要性を評価します。出力 結果への貢献度。重要度の低いニューロンは、役に立たないニューロンとみなすことができます。

3. 不要なニューロンと接続を削除する: ニューロンの重要性に基づいて、不要なニューロンと接続を削除します。これは、重みを 0 に設定するか、対応するニューロンと接続を削除することで実現できます。

モデル プルーニングの利点は、モデルのサイズと計算の複雑さを効果的に削減できることにより、モデルのパフォーマンスが向上することです。さらに、モデルの枝刈りは、過剰適合を軽減し、モデルの汎化能力を向上させるのに役立ちます。モデル枝刈りは、自然言語処理、コンピューター ビジョン、音声認識などのさまざまな応用分野でも広く使用されています。

最後に、モデル蒸留とモデル枝刈りはどちらもニューラル ネットワーク モデル圧縮手法ですが、実装方法と目的は若干異なります。モデルの蒸留では、教師モデルの予測された動作を使用して生徒モデルをトレーニングすることに重点が置かれますが、モデルの枝刈りでは、モデルを圧縮するために不要なパラメーターと接続を削除することに重点が置かれます。

以上が知識の圧縮: モデルの蒸留とモデルの枝刈りの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7563

7563

15

15

1385

1385

52

52

84

84

11

11

28

28

99

99

RNN、LSTM、GRU の概念、違い、長所と短所を調べる

Jan 22, 2024 pm 07:51 PM

RNN、LSTM、GRU の概念、違い、長所と短所を調べる

Jan 22, 2024 pm 07:51 PM

時系列データでは、観測間に依存関係があるため、相互に独立していません。ただし、従来のニューラル ネットワークは各観測値を独立したものとして扱うため、時系列データをモデル化するモデルの能力が制限されます。この問題を解決するために、リカレント ニューラル ネットワーク (RNN) が導入されました。これは、ネットワーク内のデータ ポイント間の依存関係を確立することにより、時系列データの動的特性をキャプチャするためのメモリの概念を導入しました。反復接続を通じて、RNN は以前の情報を現在の観測値に渡して、将来の値をより適切に予測できます。このため、RNN は時系列データを含むタスクにとって強力なツールになります。しかし、RNN はどのようにしてこの種の記憶を実現するのでしょうか? RNN は、ニューラル ネットワーク内のフィードバック ループを通じて記憶を実現します。これが RNN と従来のニューラル ネットワークの違いです。

ニューラル ネットワークの浮動小数点オペランド (FLOPS) の計算

Jan 22, 2024 pm 07:21 PM

ニューラル ネットワークの浮動小数点オペランド (FLOPS) の計算

Jan 22, 2024 pm 07:21 PM

FLOPS はコンピュータの性能評価の規格の 1 つで、1 秒あたりの浮動小数点演算の回数を測定するために使用されます。ニューラル ネットワークでは、モデルの計算の複雑さとコンピューティング リソースの使用率を評価するために FLOPS がよく使用されます。これは、コンピューターの計算能力と効率を測定するために使用される重要な指標です。ニューラル ネットワークは、データ分類、回帰、クラスタリングなどのタスクを実行するために使用される、複数のニューロン層で構成される複雑なモデルです。ニューラル ネットワークのトレーニングと推論には、多数の行列の乗算、畳み込み、その他の計算操作が必要となるため、計算の複雑さは非常に高くなります。 FLOPS (FloatingPointOperationsperSecond) を使用すると、ニューラル ネットワークの計算の複雑さを測定し、モデルの計算リソースの使用効率を評価できます。フロップ

テキスト分類に双方向 LSTM モデルを使用するケーススタディ

Jan 24, 2024 am 10:36 AM

テキスト分類に双方向 LSTM モデルを使用するケーススタディ

Jan 24, 2024 am 10:36 AM

双方向 LSTM モデルは、テキスト分類に使用されるニューラル ネットワークです。以下は、テキスト分類タスクに双方向 LSTM を使用する方法を示す簡単な例です。まず、必要なライブラリとモジュールをインポートする必要があります: importosimportnumpyasnpfromkeras.preprocessing.textimportTokenizerfromkeras.preprocessing.sequenceimportpad_sequencesfromkeras.modelsimportSequentialfromkeras.layersimportDense,Em

ファジーニューラルネットワークの定義と構造解析

Jan 22, 2024 pm 09:09 PM

ファジーニューラルネットワークの定義と構造解析

Jan 22, 2024 pm 09:09 PM

ファジー ニューラル ネットワークは、ファジー ロジックとニューラル ネットワークを組み合わせたハイブリッド モデルで、従来のニューラル ネットワークでは処理が困難なファジーまたは不確実な問題を解決します。その設計は人間の認知における曖昧さと不確実性にインスピレーションを得ているため、制御システム、パターン認識、データマイニングなどの分野で広く使用されています。ファジー ニューラル ネットワークの基本アーキテクチャは、ファジー サブシステムとニューラル サブシステムで構成されます。ファジー サブシステムは、ファジー ロジックを使用して入力データを処理し、それをファジー セットに変換して、入力データの曖昧さと不確実性を表現します。ニューラル サブシステムは、ニューラル ネットワークを使用して、分類、回帰、クラスタリングなどのタスクのファジー セットを処理します。ファジー サブシステムとニューラル サブシステム間の相互作用により、ファジー ニューラル ネットワークはより強力な処理能力を持ち、

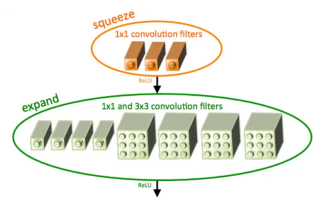

SqueezeNet の概要とその特徴

Jan 22, 2024 pm 07:15 PM

SqueezeNet の概要とその特徴

Jan 22, 2024 pm 07:15 PM

SqueezeNet は、高精度と低複雑性のバランスが取れた小型で正確なアルゴリズムであり、リソースが限られているモバイル システムや組み込みシステムに最適です。 2016 年、DeepScale、カリフォルニア大学バークレー校、スタンフォード大学の研究者は、コンパクトで効率的な畳み込みニューラル ネットワーク (CNN) である SqueezeNet を提案しました。近年、研究者は SqueezeNetv1.1 や SqueezeNetv2.0 など、SqueezeNet にいくつかの改良を加えました。両方のバージョンの改良により、精度が向上するだけでなく、計算コストも削減されます。 ImageNet データセット上の SqueezeNetv1.1 の精度

畳み込みニューラル ネットワークを使用した画像のノイズ除去

Jan 23, 2024 pm 11:48 PM

畳み込みニューラル ネットワークを使用した画像のノイズ除去

Jan 23, 2024 pm 11:48 PM

畳み込みニューラル ネットワークは、画像のノイズ除去タスクで優れたパフォーマンスを発揮します。学習したフィルターを利用してノイズを除去し、元の画像を復元します。この記事では、畳み込みニューラル ネットワークに基づく画像ノイズ除去方法を詳しく紹介します。 1. 畳み込みニューラル ネットワークの概要 畳み込みニューラル ネットワークは、複数の畳み込み層、プーリング層、全結合層の組み合わせを使用して画像の特徴を学習および分類する深層学習アルゴリズムです。畳み込み層では、畳み込み演算を通じて画像の局所的な特徴が抽出され、それによって画像内の空間相関が捕捉されます。プーリング層は、特徴の次元を削減することで計算量を削減し、主要な特徴を保持します。完全に接続された層は、学習した特徴とラベルをマッピングして画像分類やその他のタスクを実装する役割を果たします。このネットワーク構造の設計により、畳み込みニューラル ネットワークは画像処理と認識に役立ちます。

Rust を使用して単純なニューラル ネットワークを作成する手順

Jan 23, 2024 am 10:45 AM

Rust を使用して単純なニューラル ネットワークを作成する手順

Jan 23, 2024 am 10:45 AM

Rust は、安全性、パフォーマンス、同時実行性に重点を置いたシステムレベルのプログラミング言語です。オペレーティング システム、ネットワーク アプリケーション、組み込みシステムなどのシナリオに適した安全で信頼性の高いプログラミング言語を提供することを目的としています。 Rust のセキュリティは主に、所有権システムと借用チェッカーという 2 つの側面から実現されます。所有権システムにより、コンパイラはコンパイル時にコードのメモリ エラーをチェックできるため、一般的なメモリの安全性の問題が回避されます。 Rust は、コンパイル時に変数の所有権の転送のチェックを強制することで、メモリ リソースが適切に管理および解放されることを保証します。ボロー チェッカーは、変数のライフ サイクルを分析して、同じ変数が複数のスレッドによって同時にアクセスされないようにすることで、一般的な同時実行セキュリティの問題を回避します。これら 2 つのメカニズムを組み合わせることで、Rust は以下を提供できます。

因果畳み込みニューラル ネットワーク

Jan 24, 2024 pm 12:42 PM

因果畳み込みニューラル ネットワーク

Jan 24, 2024 pm 12:42 PM

因果畳み込みニューラル ネットワークは、時系列データの因果関係の問題のために設計された特別な畳み込みニューラル ネットワークです。従来の畳み込みニューラル ネットワークと比較して、因果畳み込みニューラル ネットワークは、時系列の因果関係を保持するという独特の利点があり、時系列データの予測と分析に広く使用されています。因果畳み込みニューラル ネットワークの中心的なアイデアは、畳み込み演算に因果関係を導入することです。従来の畳み込みニューラルネットワークは、現時点の前後のデータを同時に認識できますが、時系列予測では情報漏洩の問題が発生する可能性があります。現時点での予測結果は、将来の時点のデータに影響を受けるからです。この問題を解決するのが因果畳み込みニューラル ネットワークであり、現時点と過去のデータのみを認識することができ、将来のデータを認識することはできません。