人工ニューラルネットワークにおけるシグモイド関数の応用

人工ニューラル ネットワークでは、非線形特性を導入するためのニューロンの活性化関数としてシグモイド関数がよく使用されます。これにより、ニューラル ネットワークはより複雑な決定境界を学習し、画像認識、自然言語処理、音声認識などのさまざまなアプリケーションで重要な役割を果たすことができます。

シグモイド関数は、任意の入力値を 0 から 1 までの値にマッピングできる一般的に使用される数学関数であるため、二値分類やロジスティック回帰問題で広く使用されています。この関数は、最初はゆっくりと増加し、その後急速に 1 に近づき、最終的には横ばいになる「S」字型を特徴としています。

シグモイド関数について理解する

シグモイド関数は、入力値を 0 から 1 までの範囲にマッピングするために使用される一般的に使用される数学関数です。その数学的定義は 1/(1 e^(-x)) です。ここで、x は入力値、e は定数 2.718 です。この関数は、二項分類およびロジスティック回帰問題で非常に役立ちます。その値の範囲は (0,1) で、そのドメインは (-infinity, infinity) です。 S 字関数の特徴は、実際の入力を確率値に変換できるため、機械学習や統計におけるモデルの出力層でよく使用されます。

シグモイド関数の重要な特性の 1 つは、入力値が増加するにつれて出力値が「S」字型の曲線を示すことです。入力値が増加すると出力値も徐々に増加し、最終的には 1 に近づきます。この機能は、二項分類問題における決定境界をモデル化するための重要な機能を提供します。

シグモイド関数のもう 1 つの重要なプロパティはその導関数であり、ニューラル ネットワークのトレーニングで重要な役割を果たします。シグモイド関数の導関数は f(x)(1-f(x)) として定義されます。ここで、f(x) は関数の出力を表します。導関数の存在により、ニューラル ネットワークはニューロンの重みとバイアスをより効果的に調整できるようになり、ネットワークのパフォーマンスが向上します。導関数を計算することにより、ネットワークは損失関数の勾配に基づいてパラメーターを更新できるため、ネットワークは段階的に最適化して精度を向上させることができます。導関数を使用してネットワークをトレーニングするこの方法は、ディープ ラーニングの分野で広く使用されており、ニューラル ネットワークが学習してさまざまな複雑なタスクに適応できるようになります。

シグモイド関数に加えて、ReLU や Tanh など、シグモイド関数の制限を補うことができる他の活性化関数があります。シグモイド関数の出力は常に 0 ~ 1 の間であるため、ネットワークの出力が 1 より大きいか 0 より小さい必要がある場合に問題が発生する可能性があります。 ReLU 関数は、正の数を変更せずに負の数を 0 にマッピングすることで、この問題を解決できます。また、tanh 関数も一般的に使用される活性化関数であり、その出力範囲は -1 ~ 1 であり、シグモイド関数よりも柔軟です。したがって、ニューラル ネットワークを設計する場合、より良い結果を達成するために、特定のニーズに応じてさまざまな活性化関数を選択できます。

グラフを使用してシグモイド関数を視覚化すると、そのプロパティをより深く理解するのに役立ちます。グラフは、関数によってとられる「S」字形と、入力値の変化に応じて出力値がどのように変化するかを示します。

人工ニューラル ネットワークにおけるシグモイド関数

シグモイド関数は、通常、人工ニューラル ネットワークの活性化関数として使用されます。フィードフォワード ニューラル ネットワークでは、各ニューロンの出力がシグモイド関数によって処理され、モデルに非線形特性が導入されます。非線形特性の導入は、ニューラル ネットワークがより複雑な決定境界を学習できるようになり、それによって特定のタスクでのパフォーマンスが向上するため、重要です。

利点:

- 0 から 1 までの出力値を生成します。これは、二値分類やロジスティック回帰の問題に役立ちます。

- 微分可能とは、微分が計算できることを意味し、ニューロンの重みとバイアスを調整することでネットワークを最適化することが簡単です。

欠点:

- 0 または 1 に近い出力値が生成される可能性があり、最適化アルゴリズムで問題が発生する可能性があります。

- シグモイド関数の勾配は、出力値 0 または 1 付近で非常に小さくなり、最適化アルゴリズムがニューロンの重みとバイアスを調整することが困難になります。

以上が人工ニューラルネットワークにおけるシグモイド関数の応用の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7455

7455

15

15

1375

1375

52

52

77

77

11

11

14

14

9

9

RNN、LSTM、GRU の概念、違い、長所と短所を調べる

Jan 22, 2024 pm 07:51 PM

RNN、LSTM、GRU の概念、違い、長所と短所を調べる

Jan 22, 2024 pm 07:51 PM

時系列データでは、観測間に依存関係があるため、相互に独立していません。ただし、従来のニューラル ネットワークは各観測値を独立したものとして扱うため、時系列データをモデル化するモデルの能力が制限されます。この問題を解決するために、リカレント ニューラル ネットワーク (RNN) が導入されました。これは、ネットワーク内のデータ ポイント間の依存関係を確立することにより、時系列データの動的特性をキャプチャするためのメモリの概念を導入しました。反復接続を通じて、RNN は以前の情報を現在の観測値に渡して、将来の値をより適切に予測できます。このため、RNN は時系列データを含むタスクにとって強力なツールになります。しかし、RNN はどのようにしてこの種の記憶を実現するのでしょうか? RNN は、ニューラル ネットワーク内のフィードバック ループを通じて記憶を実現します。これが RNN と従来のニューラル ネットワークの違いです。

ニューラル ネットワークの浮動小数点オペランド (FLOPS) の計算

Jan 22, 2024 pm 07:21 PM

ニューラル ネットワークの浮動小数点オペランド (FLOPS) の計算

Jan 22, 2024 pm 07:21 PM

FLOPS はコンピュータの性能評価の規格の 1 つで、1 秒あたりの浮動小数点演算の回数を測定するために使用されます。ニューラル ネットワークでは、モデルの計算の複雑さとコンピューティング リソースの使用率を評価するために FLOPS がよく使用されます。これは、コンピューターの計算能力と効率を測定するために使用される重要な指標です。ニューラル ネットワークは、データ分類、回帰、クラスタリングなどのタスクを実行するために使用される、複数のニューロン層で構成される複雑なモデルです。ニューラル ネットワークのトレーニングと推論には、多数の行列の乗算、畳み込み、その他の計算操作が必要となるため、計算の複雑さは非常に高くなります。 FLOPS (FloatingPointOperationsperSecond) を使用すると、ニューラル ネットワークの計算の複雑さを測定し、モデルの計算リソースの使用効率を評価できます。フロップ

ファジーニューラルネットワークの定義と構造解析

Jan 22, 2024 pm 09:09 PM

ファジーニューラルネットワークの定義と構造解析

Jan 22, 2024 pm 09:09 PM

ファジー ニューラル ネットワークは、ファジー ロジックとニューラル ネットワークを組み合わせたハイブリッド モデルで、従来のニューラル ネットワークでは処理が困難なファジーまたは不確実な問題を解決します。その設計は人間の認知における曖昧さと不確実性にインスピレーションを得ているため、制御システム、パターン認識、データマイニングなどの分野で広く使用されています。ファジー ニューラル ネットワークの基本アーキテクチャは、ファジー サブシステムとニューラル サブシステムで構成されます。ファジー サブシステムは、ファジー ロジックを使用して入力データを処理し、それをファジー セットに変換して、入力データの曖昧さと不確実性を表現します。ニューラル サブシステムは、ニューラル ネットワークを使用して、分類、回帰、クラスタリングなどのタスクのファジー セットを処理します。ファジー サブシステムとニューラル サブシステム間の相互作用により、ファジー ニューラル ネットワークはより強力な処理能力を持ち、

テキスト分類に双方向 LSTM モデルを使用するケーススタディ

Jan 24, 2024 am 10:36 AM

テキスト分類に双方向 LSTM モデルを使用するケーススタディ

Jan 24, 2024 am 10:36 AM

双方向 LSTM モデルは、テキスト分類に使用されるニューラル ネットワークです。以下は、テキスト分類タスクに双方向 LSTM を使用する方法を示す簡単な例です。まず、必要なライブラリとモジュールをインポートする必要があります: importosimportnumpyasnpfromkeras.preprocessing.textimportTokenizerfromkeras.preprocessing.sequenceimportpad_sequencesfromkeras.modelsimportSequentialfromkeras.layersimportDense,Em

畳み込みニューラル ネットワークを使用した画像のノイズ除去

Jan 23, 2024 pm 11:48 PM

畳み込みニューラル ネットワークを使用した画像のノイズ除去

Jan 23, 2024 pm 11:48 PM

畳み込みニューラル ネットワークは、画像のノイズ除去タスクで優れたパフォーマンスを発揮します。学習したフィルターを利用してノイズを除去し、元の画像を復元します。この記事では、畳み込みニューラル ネットワークに基づく画像ノイズ除去方法を詳しく紹介します。 1. 畳み込みニューラル ネットワークの概要 畳み込みニューラル ネットワークは、複数の畳み込み層、プーリング層、全結合層の組み合わせを使用して画像の特徴を学習および分類する深層学習アルゴリズムです。畳み込み層では、畳み込み演算を通じて画像の局所的な特徴が抽出され、それによって画像内の空間相関が捕捉されます。プーリング層は、特徴の次元を削減することで計算量を削減し、主要な特徴を保持します。完全に接続された層は、学習した特徴とラベルをマッピングして画像分類やその他のタスクを実装する役割を果たします。このネットワーク構造の設計により、畳み込みニューラル ネットワークは画像処理と認識に役立ちます。

ツイン ニューラル ネットワーク: 原理と応用分析

Jan 24, 2024 pm 04:18 PM

ツイン ニューラル ネットワーク: 原理と応用分析

Jan 24, 2024 pm 04:18 PM

シャム ニューラル ネットワークは、ユニークな人工ニューラル ネットワーク構造です。これは、同じパラメーターと重みを共有する 2 つの同一のニューラル ネットワークで構成されます。同時に、2 つのネットワークは同じ入力データも共有します。 2 つのニューラル ネットワークは構造的に同一であるため、このデザインは双子からインスピレーションを得ています。シャム ニューラル ネットワークの原理は、2 つの入力データ間の類似性や距離を比較することによって、画像マッチング、テキスト マッチング、顔認識などの特定のタスクを完了することです。トレーニング中、ネットワークは、類似したデータを隣接する領域にマッピングし、異なるデータを離れた領域にマッピングしようとします。このようにして、ネットワークはさまざまなデータを分類または照合する方法を学習して、対応するデータを実現できます。

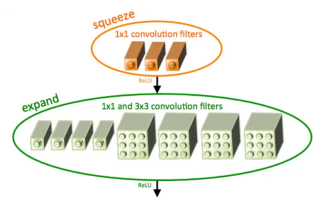

SqueezeNet の概要とその特徴

Jan 22, 2024 pm 07:15 PM

SqueezeNet の概要とその特徴

Jan 22, 2024 pm 07:15 PM

SqueezeNet は、高精度と低複雑性のバランスが取れた小型で正確なアルゴリズムであり、リソースが限られているモバイル システムや組み込みシステムに最適です。 2016 年、DeepScale、カリフォルニア大学バークレー校、スタンフォード大学の研究者は、コンパクトで効率的な畳み込みニューラル ネットワーク (CNN) である SqueezeNet を提案しました。近年、研究者は SqueezeNetv1.1 や SqueezeNetv2.0 など、SqueezeNet にいくつかの改良を加えました。両方のバージョンの改良により、精度が向上するだけでなく、計算コストも削減されます。 ImageNet データセット上の SqueezeNetv1.1 の精度

因果畳み込みニューラル ネットワーク

Jan 24, 2024 pm 12:42 PM

因果畳み込みニューラル ネットワーク

Jan 24, 2024 pm 12:42 PM

因果畳み込みニューラル ネットワークは、時系列データの因果関係の問題のために設計された特別な畳み込みニューラル ネットワークです。従来の畳み込みニューラル ネットワークと比較して、因果畳み込みニューラル ネットワークは、時系列の因果関係を保持するという独特の利点があり、時系列データの予測と分析に広く使用されています。因果畳み込みニューラル ネットワークの中心的なアイデアは、畳み込み演算に因果関係を導入することです。従来の畳み込みニューラルネットワークは、現時点の前後のデータを同時に認識できますが、時系列予測では情報漏洩の問題が発生する可能性があります。現時点での予測結果は、将来の時点のデータに影響を受けるからです。この問題を解決するのが因果畳み込みニューラル ネットワークであり、現時点と過去のデータのみを認識することができ、将来のデータを認識することはできません。