より有用なモデルには、「段階的に考える」だけでは不十分ではなく、より深い「段階的に考える」ことが必要です。

最近、大規模言語モデル (LLM) とその高度なヒンティング戦略の出現により、言語モデルの研究、特に古典的な自然言語処理 (NLP) タスクにおいて大きな進歩が見られました。重要なイノベーションの 1 つは、思考連鎖 (CoT) プロンプト テクノロジであり、複数のステップからなる問題解決能力が高く評価されています。 CoT テクノロジーは人間の逐次推論に従い、クロスドメイン、長期一般化、およびクロス言語タスクなどのさまざまな課題で優れたパフォーマンスを示します。 CoT は、論理的で段階的な推論アプローチにより、複雑な問題解決シナリオにおいて重要な解釈可能性を提供します。

CoT は大きな進歩を遂げましたが、研究コミュニティはその具体的なメカニズムとそれが機能する理由についてまだ合意に達していません。この知識のギャップは、CoT パフォーマンスの向上がまだ未知の領域であることを意味します。現在、研究者には体系的な方法論が欠如しており、推測と実験に頼ることしかできないため、CoT の改善を探る主な方法は試行錯誤です。しかし、これは同時に、この分野に重要な研究の機会が存在すること、つまりCoTの内部動作について深く構造化された理解を発展させることを意味します。この目標を達成できれば、現在の CoT プロセスがわかりやすくなるだけでなく、さまざまな複雑な NLP タスクでこの手法をより信頼性が高く効率的に適用する道も開かれるでしょう。

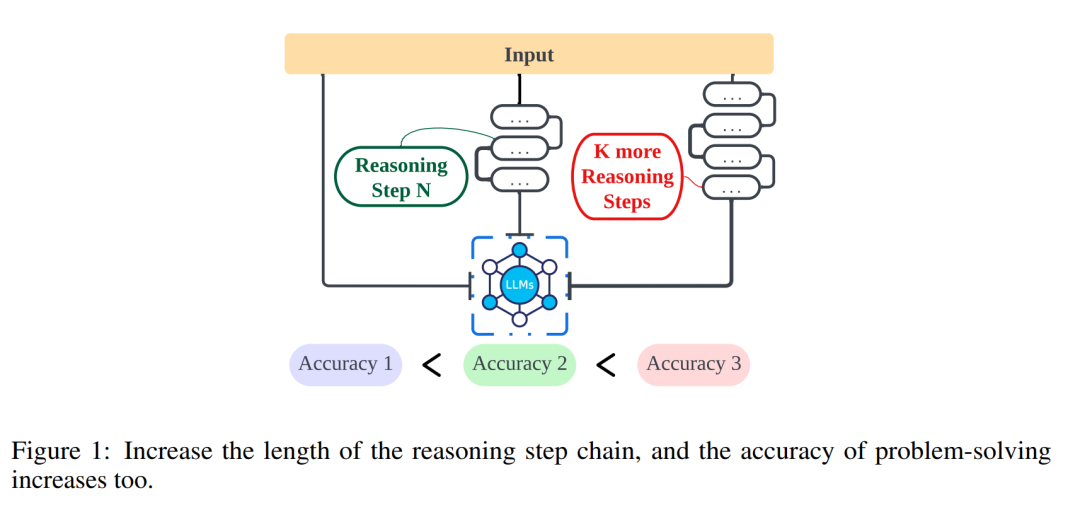

ノースウェスタン大学、リバプール大学、ニュージャージー工科大学の研究者らによる研究では、推論ステップの長さと結論の正確さとの関係をさらに調査し、人々のより良い支援に貢献しています。自然言語処理 (NLP) の問題を効果的に解決する方法を理解します。この調査では、推論ステップが、連続オープン テキスト (CoT) の機能を可能にするプロンプトの最も重要な部分であるかどうかを調査します。 実験では、特に新しい推論ステップを導入する場合、追加の知識が導入されないように研究者らは変数を厳密に制御しました。ゼロサンプル実験では、研究者らは最初のプロンプトを「段階的に考えてください」から「段階的に考えて、できるだけ多くの段階を考えてみてください」に調整した。サンプル数が少ない問題について、研究者らは、他のすべての要素を一定に保ちながら、基本的な推論ステップを拡張する実験を設計しました。 これらの実験を通じて、研究者らは推論ステップの長さと結論の正確さとの間に相関関係があることを発見した。より具体的には、参加者は、より多くのステップを検討するように求められた場合、より正確な結論を提供する傾向がありました。これは、NLP 問題を解く際に、推論ステップを拡張することで問題解決の精度を向上できることを示しています。 この研究は、NLP 問題がどのように解決されるかを深く理解する上で非常に重要であり、NLP テクノロジーをさらに最適化および改善するための有用な指針を提供します。

- 論文のタイトル: 大規模言語モデルに対する推論ステップの長さの影響

- #論文リンク: https://arxiv.org/pdf/2401.04925.pdf

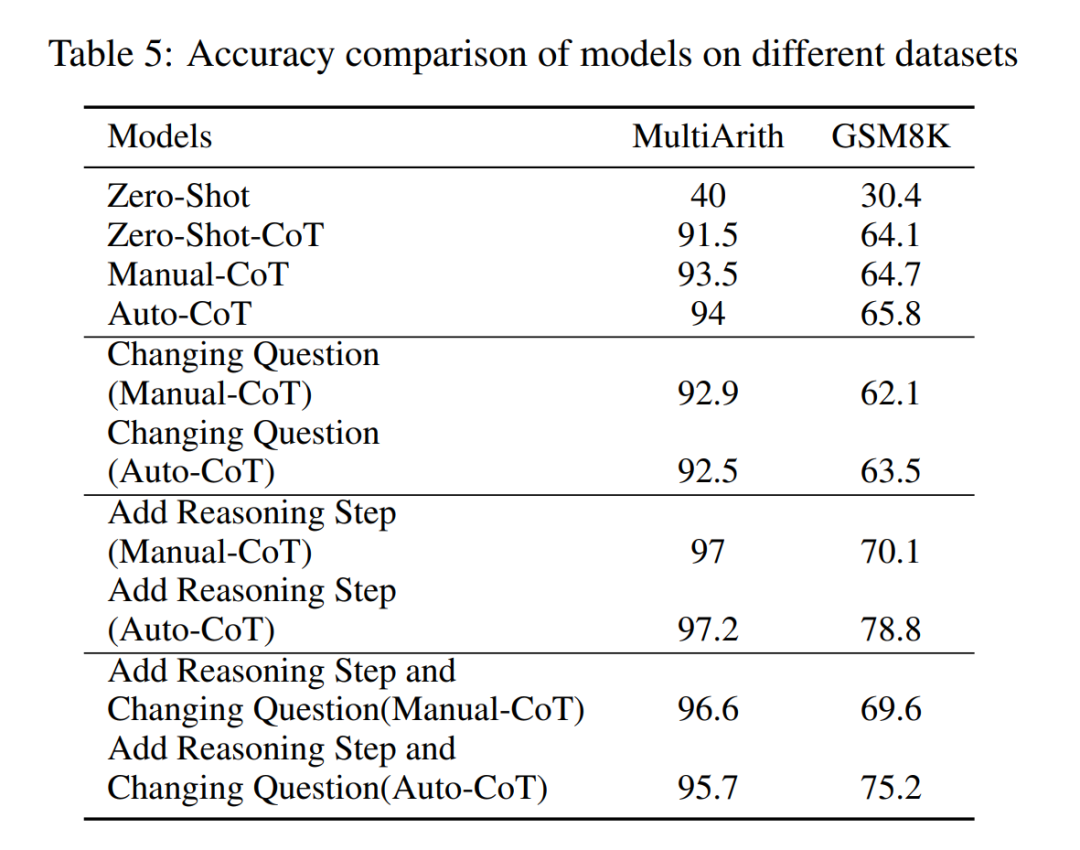

# #この記事の最初の実験セットは、上記の戦略に基づいて Auto-CoT テクノロジを使用して、ゼロサンプルおよび小さなサンプルのタスクに対する推論パフォーマンスの向上を評価することを目的としています。次に、さまざまな推論ステップ数でのさまざまな方法の精度が評価されました。その後、研究者らは研究対象を拡大し、この記事で提案した戦略の有効性をさまざまな LLM (GPT-3.5 や GPT-4 など) で比較しました。研究結果は、一定の範囲内で、推論連鎖の長さとLLMの能力の間に明確な相関関係があることを示しています。研究者が誤解を招く情報を推論チェーンに導入しても、パフォーマンスが向上することを考慮する価値があります。このことから、重要な結論が得られます。パフォーマンスに影響を与える主な要因は、思考チェーンの精度ではなく、思考チェーンの長さであるようです。

# #この記事の最初の実験セットは、上記の戦略に基づいて Auto-CoT テクノロジを使用して、ゼロサンプルおよび小さなサンプルのタスクに対する推論パフォーマンスの向上を評価することを目的としています。次に、さまざまな推論ステップ数でのさまざまな方法の精度が評価されました。その後、研究者らは研究対象を拡大し、この記事で提案した戦略の有効性をさまざまな LLM (GPT-3.5 や GPT-4 など) で比較しました。研究結果は、一定の範囲内で、推論連鎖の長さとLLMの能力の間に明確な相関関係があることを示しています。研究者が誤解を招く情報を推論チェーンに導入しても、パフォーマンスが向上することを考慮する価値があります。このことから、重要な結論が得られます。パフォーマンスに影響を与える主な要因は、思考チェーンの精度ではなく、思考チェーンの長さであるようです。

この記事の主な調査結果は次のとおりです:

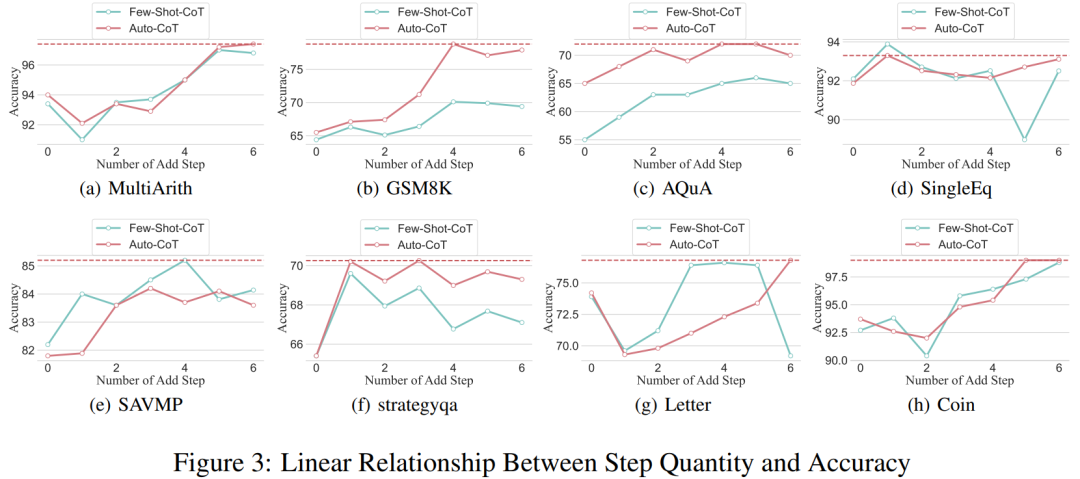

- サンプル CoT が小さい場合、推論ステップ数と精度の間には直接的な線形関係があります。これにより、複雑な推論における CoT ヒントを最適化する定量化可能な方法が提供されます。具体的には、プロンプトに推論ステップを追加すると、複数のデータセットに対する LLM の推論機能が大幅に向上します。さらに、推論ステップを短縮すると、重要な情報が保持されている場合でも、モデルの推論機能が大幅に弱まる可能性があります。

- 間違った推論であっても、必要な長さの推論が維持されていれば、有利な結果が得られる可能性があります。たとえば、数学の問題などのタスクでは、プロセス中に生成される中間数値のエラーが最終結果に影響を与える可能性は低くなります。

- 推論ステップの増加によるメリットの大きさは、タスク自体によって制限されます。単純なタスクでは必要なステップが少なくなりますが、複雑なタスクでは推論シーケンスが長くなり、大幅なメリットが得られます。

- ゼロショット CoT の推論ステップを増やすと、LLM の精度も大幅に向上します。

研究方法

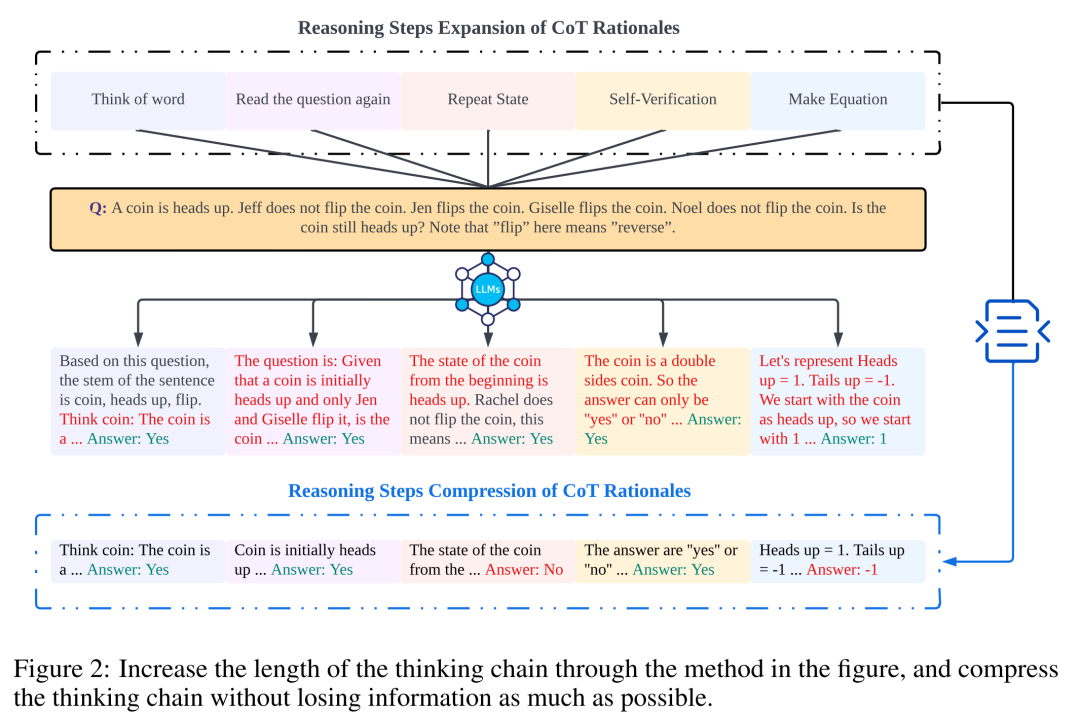

研究者らは、推論ステップと CoT プロンプトのパフォーマンスとの関係を調べるために分析を実施しました。彼らのアプローチの中心的な前提は、シリアル化ステップが推論中の CoT キューの最も重要なコンポーネントであるということです。これらの手順により、言語モデルは、返信コンテンツを生成するときに、推論のためにより多くのロジックを適用できるようになります。このアイデアをテストするために、研究者らは、基本的な推論ステップを連続的に拡張および圧縮することによって CoT の推論プロセスを変更する実験を設計しました。同時に、他のすべての要素を一定に保ちました。具体的には、研究者らは、新しい推論コンテンツを導入したり、既存の推論コンテンツを削除したりすることなく、推論ステップ数を体系的に変更しただけでした。以下では、ゼロショットおよび数ショットの CoT キューを評価します。実験プロセス全体を図 2 に示します。この制御変数分析アプローチを通じて、研究者らは、論理的に健全な応答を生成する LLM の能力に CoT がどのように影響するかを解明しました。

##ゼロサンプル CoT 分析

ゼロサンプル シナリオでは、研究 著者は、最初のプロンプトを「段階的に考えてください」から「段階的に考えて、できるだけ多くの段階を考えてください」に変更しました。この変更は、数ショット CoT 環境とは異なり、ユーザーが使用中に追加の推論ステップを導入できないために行われました。研究者らは、最初のプロンプトを変更することで、LLM がより幅広く考えるように導きました。このアプローチの重要性は、数ショットのシナリオで一般的な増分トレーニングや追加のサンプル駆動型の最適化手法を必要とせずに、モデルの精度を向上できることにあります。この改良戦略により、より包括的かつ詳細な推論プロセスが保証され、ゼロサンプル条件下でのモデルのパフォーマンスが大幅に向上します。

小規模サンプル CoT 分析

このセクションでは、推論ステップを追加または圧縮することによって、CoT の推論チェーンを変更します。目的は、推論構造の変化が LLM の決定にどのような影響を与えるかを研究することです。推論ステップの拡張中、研究者はタスクに関連する新しい情報を導入することを避ける必要があります。このようにして、推論ステップが唯一の研究変数になりました。

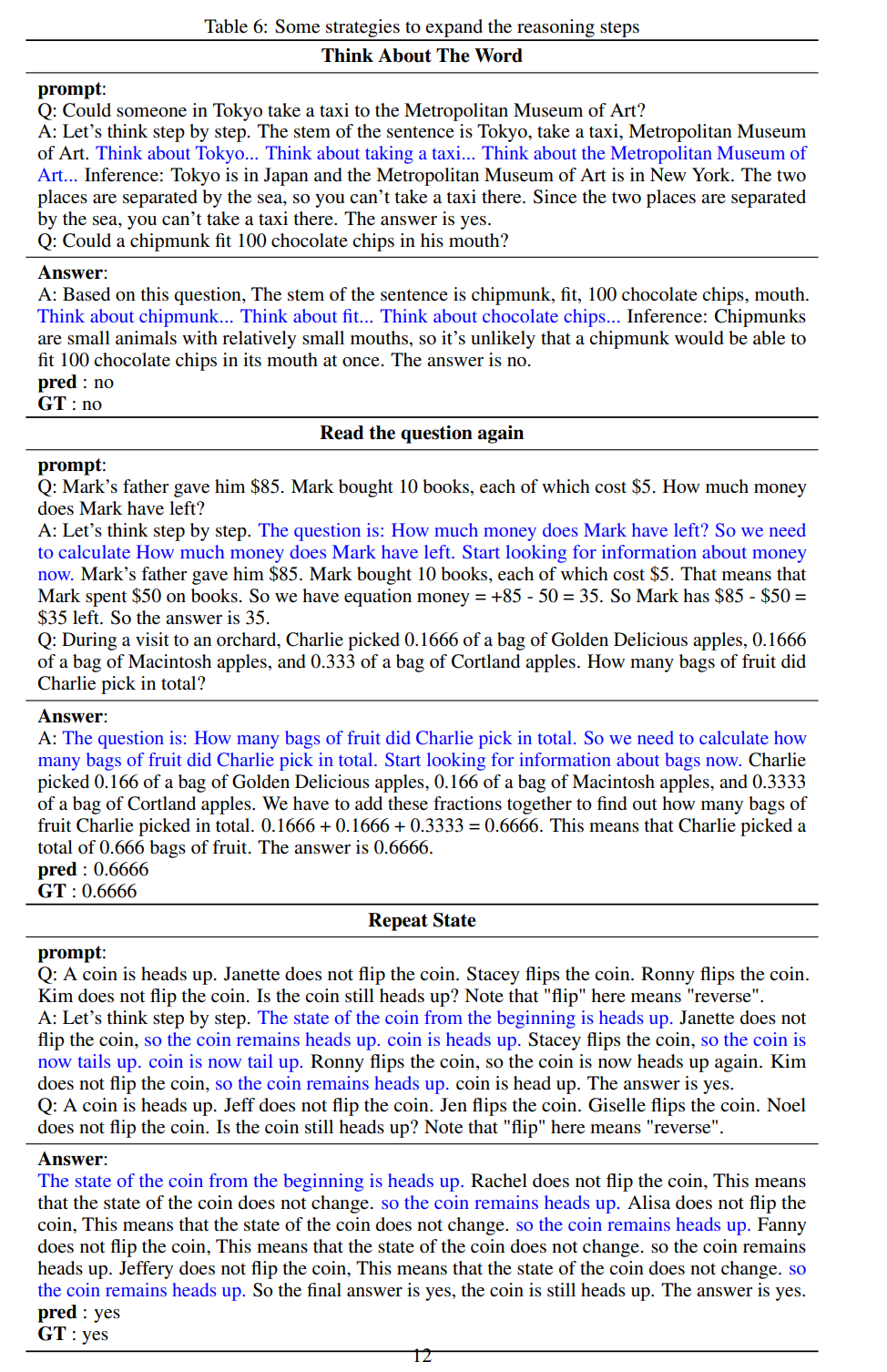

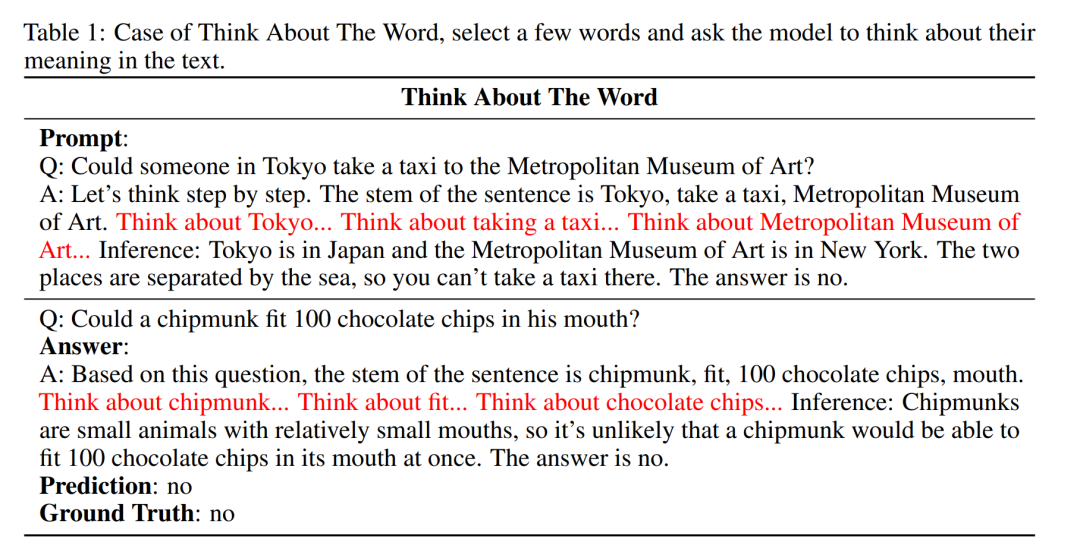

この目的を達成するために、研究者らは、さまざまな LLM アプリケーションの推論ステップを拡張する次の研究戦略を設計しました。人は問題についての考え方に決まったパターンを持っていることがよくあります。たとえば、より深く理解するために問題を何度も繰り返す、記憶負荷を軽減するために数式を作成する、トピックの理解を助けるために問題内の単語の意味を分析する、要約するなどです。現在の状態を簡略化する トピックの説明。研究者らは、ゼロサンプル CoT と Auto-CoT のインスピレーションに基づいて、CoT プロセスが標準化されたモデルとなり、プロンプト部分で CoT の思考の方向を制限することで正しい結果が得られることを期待しています。この手法の核心は、人間の思考プロセスをシミュレートし、思考の連鎖を再構築することです。 5 つの一般的なプロンプト戦略を表 6 に示します。

- 単語思考: この戦略では、モデルが単語を解釈し、知識ベースを再構築する必要があります。多くの場合、単語には複数の異なる意味があり、これにより、モデルが既成概念にとらわれずに考え、生成された説明に基づいて質問内の単語を再解釈できるようになります。このプロセスでは新しい情報は導入されません。プロンプトでは、研究者はモデルが考えている単語の例を示し、モデルはこのプロセスを実行するための新しい質問に基づいて自動的に単語を選択します。

- 質問のリロード: 思考の連鎖における他のテキストの干渉を減らすために、質問を繰り返し読んでください。つまり、モデルに問題を覚えさせます。

- 繰り返し状態: 繰り返し読み取りと同様に、現在の状態の概要が長い一連の推論の後に追加されます。目的は、モデルの記憶を簡素化し、他のモデルの干渉を軽減することです。 CoTに関するテキスト。

- 自己検証: 人間は質問に答えるときに、自分の答えが正しいかどうかを確認します。そこで研究者らは、モデルが答えを得る前に、いくつかの基本情報に基づいて答えが合理的かどうかを判断する自己検証プロセスを追加した。

- 方程式の準備: 数学的な問題の場合、方程式を作成すると、人間が記憶を要約して単純化するのに役立ちます。未知の量 x の仮定を必要とする一部の問題では、方程式を確立することが不可欠なプロセスです。研究者らはこのプロセスをシミュレートし、モデルに数学の問題で方程式を確立しようとさせました。

全体として、この記事のリアルタイム戦略はモデルに反映されています。表 1 に示されているのは一例であり、他の 4 つの戦略の例は元の論文で参照できます。

#実験と結果

##推論ステップと精度の関係

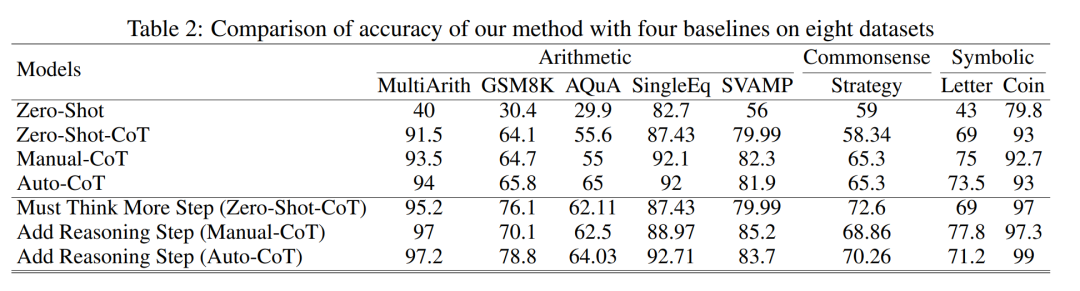

表 2 は、3 クラス推論タスクの 8 つのデータセットで GPT-3.5-turbo-1106 を使用した精度を比較しています。

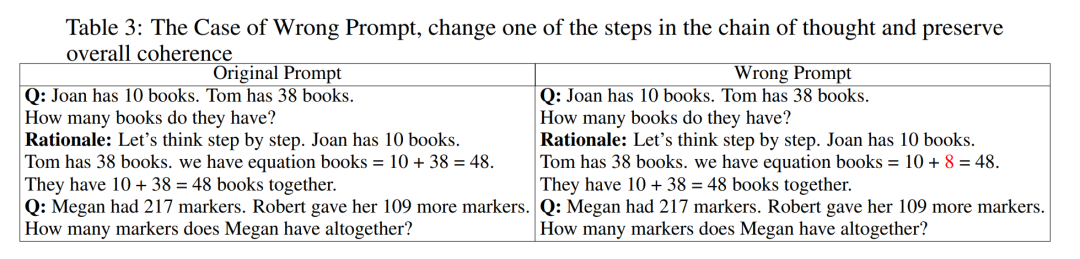

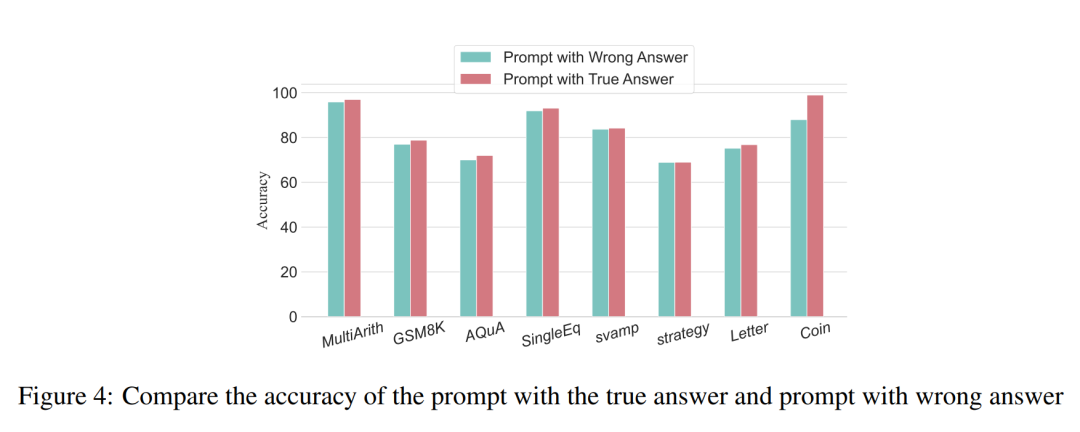

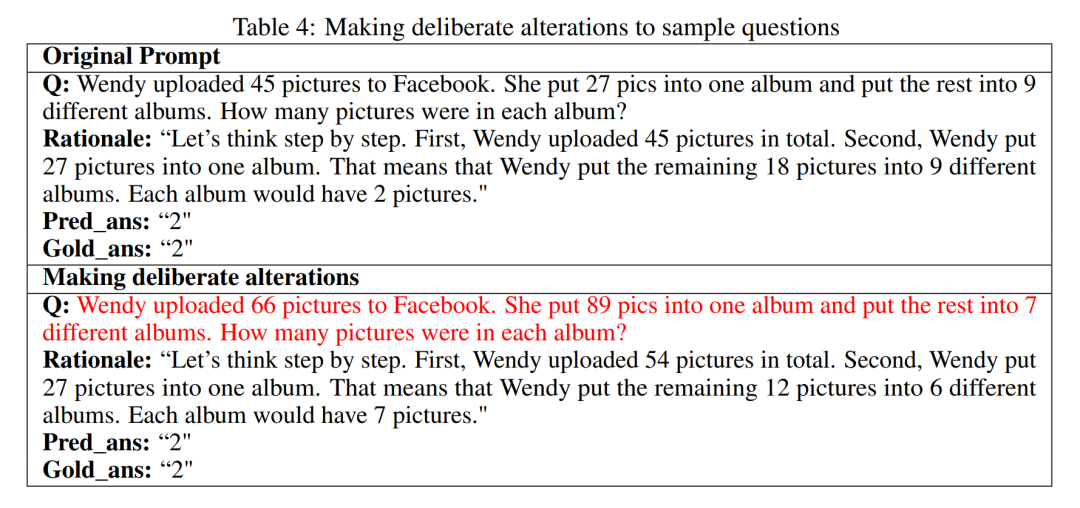

推論ステップは LLM のパフォーマンスに影響します唯一の要因は?研究者らは次のような試みを行った。プロンプトの 1 つのステップを誤った説明に変更し、それが思考の連鎖に影響を与えるかどうかを確認します。この実験では、すべてのプロンプトにエラーを追加しました。具体的な例については、表 3 を参照してください。

算術型の問題では、解答の結果がどれか一つでも外れても、推論過程における思考連鎖への影響は最小限です。 、それで研究者は、算術タイプの問題を解決するとき、大規模な言語モデルは単一の計算よりもプロンプト内の思考パターンの連鎖についてより多くを学習すると主張されています。コインデータのような論理的な問題の場合、プロンプト結果の逸脱により、思考の連鎖全体が断片化することがよくあります。研究者らはまた、GPT-3.5-turbo-1106 を使用してこの実験を完了し、以前の実験から得られた各データセットの最適なステップ数に基づいてパフォーマンスを保証しました。結果を図 4 に示します。

算術型の問題では、解答の結果がどれか一つでも外れても、推論過程における思考連鎖への影響は最小限です。 、それで研究者は、算術タイプの問題を解決するとき、大規模な言語モデルは単一の計算よりもプロンプト内の思考パターンの連鎖についてより多くを学習すると主張されています。コインデータのような論理的な問題の場合、プロンプト結果の逸脱により、思考の連鎖全体が断片化することがよくあります。研究者らはまた、GPT-3.5-turbo-1106 を使用してこの実験を完了し、以前の実験から得られた各データセットの最適なステップ数に基づいてパフォーマンスを保証しました。結果を図 4 に示します。

#圧縮推論の手順

#圧縮推論の手順

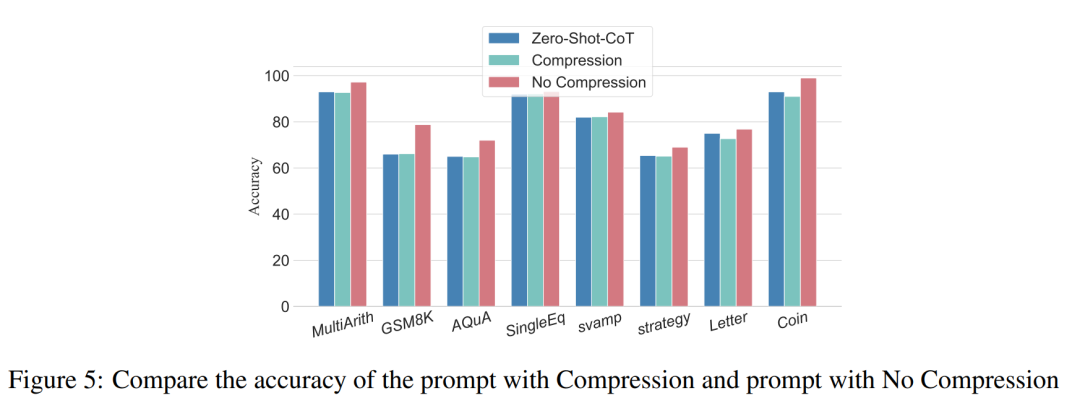

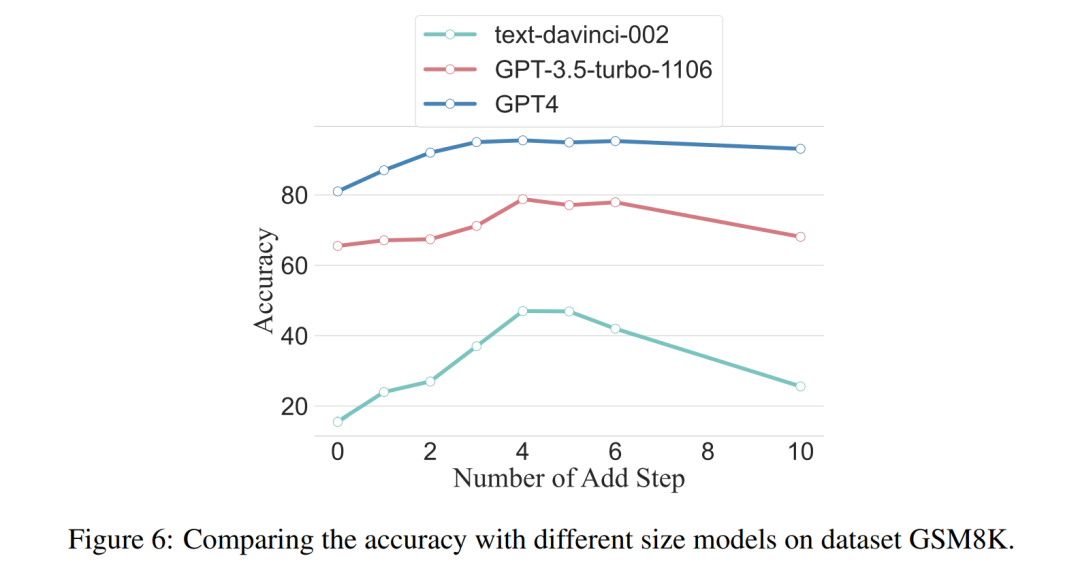

これまでの実験では、推論ステップを追加すると LLM 推論の精度が向上することが実証されました。それでは、小さなサンプル問題で基礎となる推論ステップを圧縮すると、LLM のパフォーマンスに悪影響が及ぶのでしょうか?この目的を達成するために、研究者らは推論ステップ圧縮実験を実施し、実験設定で概説した手法を使用して推論プロセスを Auto CoT と Few-Shot-CoT に凝縮して推論ステップの数を削減しました。結果を図 5 に示します。 #結果は、モデルのパフォーマンスが大幅に低下し、基本的にゼロと同等のレベルに戻っていることを示しています。 -サンプルメソッド。この結果はさらに、CoT 推論ステップを増やすと CoT パフォーマンスが向上し、その逆も同様であることを示しています。 仕様の異なるモデルの性能比較 研究者らはまた、スケーリング現象が観察できるかどうかも尋ねました。必要な推論ステップは LLM のサイズに関連していますか?研究者らは、text-davinci-002、GPT-3.5-turbo-1106、GPT-4 などのさまざまなモデルで使用される推論ステップの平均数を調査しました。各モデルが最高のパフォーマンスに達するために必要な平均推論ステップは、GSM8K での実験を通じて計算されました。 8 つのデータセットの中で、このデータセットは text-davinci-002、GPT-3.5-turbo-1106、GPT-4 とのパフォーマンスの差が最も大きくなります。初期パフォーマンスが最も悪かった text-davinci-002 モデルでは、この記事で提案した戦略が最も高い改善効果を示していることがわかります。結果を図 6 に示します。 #共同作業の例における問題の影響

詳細については、原論文をお読みください。

以上がより有用なモデルには、「段階的に考える」だけでは不十分ではなく、より深い「段階的に考える」ことが必要です。の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7467

7467

15

15

1376

1376

52

52

77

77

11

11

18

18

19

19

Laravelの地理空間:インタラクティブマップと大量のデータの最適化

Apr 08, 2025 pm 12:24 PM

Laravelの地理空間:インタラクティブマップと大量のデータの最適化

Apr 08, 2025 pm 12:24 PM

700万のレコードを効率的に処理し、地理空間技術を使用したインタラクティブマップを作成します。この記事では、LaravelとMySQLを使用して700万を超えるレコードを効率的に処理し、それらをインタラクティブなマップの視覚化に変換する方法について説明します。最初の課題プロジェクトの要件:MySQLデータベースに700万のレコードを使用して貴重な洞察を抽出します。多くの人は最初に言語をプログラミングすることを検討しますが、データベース自体を無視します。ニーズを満たすことができますか?データ移行または構造調整は必要ですか? MySQLはこのような大きなデータ負荷に耐えることができますか?予備分析:キーフィルターとプロパティを特定する必要があります。分析後、ソリューションに関連している属性はわずかであることがわかりました。フィルターの実現可能性を確認し、検索を最適化するためにいくつかの制限を設定しました。都市に基づくマップ検索

Vue Axiosのタイムアウトを設定する方法

Apr 07, 2025 pm 10:03 PM

Vue Axiosのタイムアウトを設定する方法

Apr 07, 2025 pm 10:03 PM

Vue axiosのタイムアウトを設定するために、Axiosインスタンスを作成してタイムアウトオプションを指定できます。グローバル設定:Vue.Prototype。$ axios = axios.create({Timeout:5000});単一のリクエストで:this。$ axios.get( '/api/users'、{timeout:10000})。

MySQLを解決する方法は開始できません

Apr 08, 2025 pm 02:21 PM

MySQLを解決する方法は開始できません

Apr 08, 2025 pm 02:21 PM

MySQLの起動が失敗する理由はたくさんあり、エラーログをチェックすることで診断できます。一般的な原因には、ポートの競合(ポート占有率をチェックして構成の変更)、許可の問題(ユーザー許可を実行するサービスを確認)、構成ファイルエラー(パラメーター設定のチェック)、データディレクトリの破損(テーブルスペースの復元)、INNODBテーブルスペースの問題(IBDATA1ファイルのチェック)、プラグインロード障害(エラーログのチェック)が含まれます。問題を解決するときは、エラーログに基づいてそれらを分析し、問題の根本原因を見つけ、問題を防ぐために定期的にデータをバックアップする習慣を開発する必要があります。

インストール後にMySQLの使用方法

Apr 08, 2025 am 11:48 AM

インストール後にMySQLの使用方法

Apr 08, 2025 am 11:48 AM

この記事では、MySQLデータベースの操作を紹介します。まず、MySQLWorkBenchやコマンドラインクライアントなど、MySQLクライアントをインストールする必要があります。 1. mysql-uroot-pコマンドを使用してサーバーに接続し、ルートアカウントパスワードでログインします。 2。CreatedAtaBaseを使用してデータベースを作成し、データベースを選択します。 3. createTableを使用してテーブルを作成し、フィールドとデータ型を定義します。 4. INSERTINTOを使用してデータを挿入し、データをクエリし、更新することでデータを更新し、削除してデータを削除します。これらの手順を習得することによってのみ、一般的な問題に対処することを学び、データベースのパフォーマンスを最適化することでMySQLを効率的に使用できます。

リモートシニアバックエンジニア(プラットフォーム)がサークルが必要です

Apr 08, 2025 pm 12:27 PM

リモートシニアバックエンジニア(プラットフォーム)がサークルが必要です

Apr 08, 2025 pm 12:27 PM

リモートシニアバックエンジニアの求人事業者:サークル場所:リモートオフィスジョブタイプ:フルタイム給与:$ 130,000- $ 140,000職務記述書サークルモバイルアプリケーションとパブリックAPI関連機能の研究開発に参加します。ソフトウェア開発ライフサイクル全体をカバーします。主な責任は、RubyonRailsに基づいて独立して開発作業を完了し、React/Redux/Relay Front-Endチームと協力しています。 Webアプリケーションのコア機能と改善を構築し、機能設計プロセス全体でデザイナーとリーダーシップと緊密に連携します。肯定的な開発プロセスを促進し、反復速度を優先します。 6年以上の複雑なWebアプリケーションバックエンドが必要です

mysqlはjsonを返すことができますか

Apr 08, 2025 pm 03:09 PM

mysqlはjsonを返すことができますか

Apr 08, 2025 pm 03:09 PM

MySQLはJSONデータを返すことができます。 json_extract関数はフィールド値を抽出します。複雑なクエリについては、Where句を使用してJSONデータをフィルタリングすることを検討できますが、そのパフォーマンスへの影響に注意してください。 JSONに対するMySQLのサポートは絶えず増加しており、最新バージョンと機能に注意を払うことをお勧めします。

MySQLインストール後にデータベースのパフォーマンスを最適化する方法

Apr 08, 2025 am 11:36 AM

MySQLインストール後にデータベースのパフォーマンスを最適化する方法

Apr 08, 2025 am 11:36 AM

MySQLパフォーマンスの最適化は、インストール構成、インデックス作成、クエリの最適化、監視、チューニングの3つの側面から開始する必要があります。 1。インストール後、INNODB_BUFFER_POOL_SIZEパラメーターやclose query_cache_sizeなど、サーバーの構成に従ってmy.cnfファイルを調整する必要があります。 2。過度のインデックスを回避するための適切なインデックスを作成し、説明コマンドを使用して実行計画を分析するなど、クエリステートメントを最適化します。 3. MySQL独自の監視ツール(ShowProcessList、ShowStatus)を使用して、データベースの健康を監視し、定期的にデータベースをバックアップして整理します。これらの手順を継続的に最適化することによってのみ、MySQLデータベースのパフォーマンスを改善できます。

MySQLの主な鍵はヌルにすることができます

Apr 08, 2025 pm 03:03 PM

MySQLの主な鍵はヌルにすることができます

Apr 08, 2025 pm 03:03 PM

MySQLプライマリキーは、データベース内の各行を一意に識別するキー属性であるため、空にすることはできません。主キーが空になる可能性がある場合、レコードを一意に識別することはできません。これにより、データの混乱が発生します。一次キーとして自己挿入整数列またはUUIDを使用する場合、効率やスペース占有などの要因を考慮し、適切なソリューションを選択する必要があります。