カメラかライダーを選択しますか?堅牢な 3D オブジェクト検出の実現に関する最近のレビュー

0. 前面に書かれ&&個人的な理解

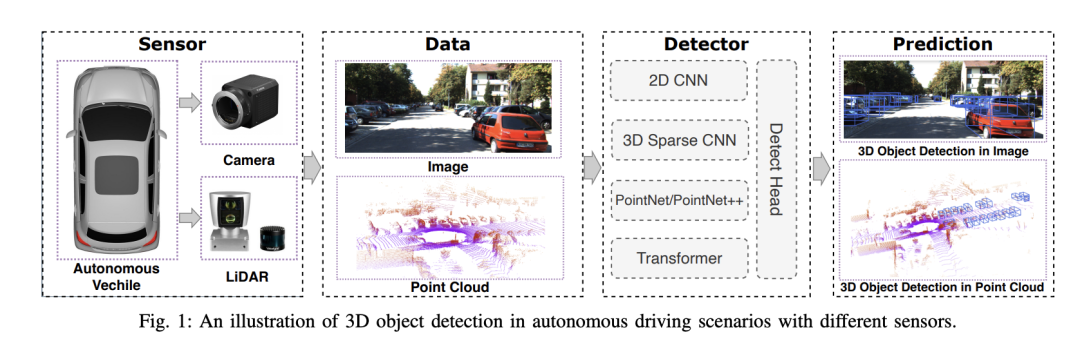

自動運転システムは、さまざまなセンサー (カメラ、ライダー、レーダーなど)は、周囲の環境を感知し、アルゴリズムとモデルを使用してリアルタイムの分析と意思決定を行うために使用されます。これにより、車両は道路標識の認識、他車両の検知・追跡、歩行者の行動予測などを行うことで、複雑な交通環境に適応しながら安全に走行することが可能となり、現在広く注目を集めており、将来の交通における重要な開発分野と考えられています。 。 1つ。しかし、自動運転を難しくしているのは、周囲で何が起こっているかを車に理解させる方法を見つけることです。そのためには、周囲環境にある物体 (位置、形状、サイズ、カテゴリなど) を正確に認識して記述することができる、自動運転システムにおける 3D 物体検出アルゴリズムが必要です。この包括的な環境認識により、自動運転システムは運転環境をより深く理解し、より正確な意思決定を行うことができます。

私たちは、主にロバスト性を考慮して、自動運転における 3D 物体検出アルゴリズムの包括的な評価を実施しました。評価では、環境変動、センサーノイズ、位置ずれという 3 つの重要な要素が特定されました。これらの要素は、現実世界の変化する条件下での検出アルゴリズムのパフォーマンスにとって重要です。

- 環境の変動性: この記事では、検出アルゴリズムが照明、天候、季節の変化などのさまざまな環境条件に適応する必要があることを強調しています。

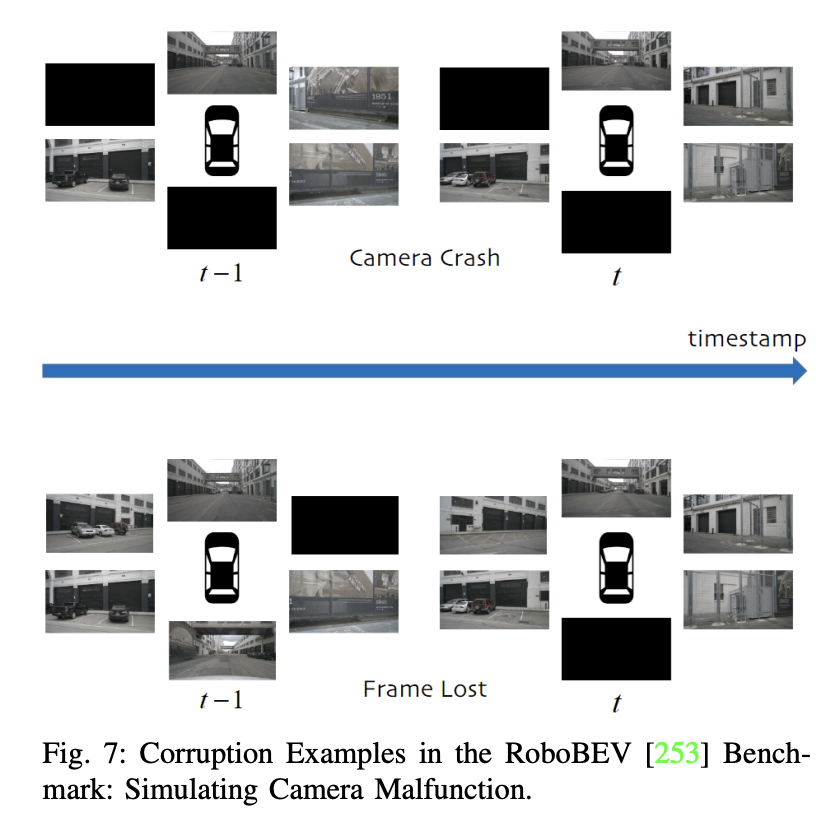

- センサー ノイズ: アルゴリズムは、カメラ モーション ブラーやその他の問題を含むセンサー ノイズに効果的に対処する必要があります。

- ミスアライメント: キャリブレーションエラーまたはその他の要因によって引き起こされるミスアライメントの場合、アルゴリズムは、外部要因 (凹凸のある路面など) または内部要因 (システムなど) にかかわらず、これらの要因を考慮する必要があります。時計のズレ)。

では、精度、遅延、堅牢性というパフォーマンス評価の 3 つの主要領域についても詳しく説明します。

- 精度: 研究では重要なパフォーマンス指標として精度に焦点を当てることがよくありますが、複雑で極端な条件下でのパフォーマンスについては、現実のセックスの信頼性を確保するためにより深い理解が必要です。

- 遅延: 自動運転におけるリアルタイム機能は非常に重要です。検出方法の遅延は、特に緊急事態において、タイムリーな意思決定を行うシステムの能力に影響を与えます。

- 堅牢性: 現在の評価の多くは現実世界のシナリオの多様性を完全には考慮していない可能性があるため、さまざまな条件下でのシステムの安定性をより包括的に評価する必要があります。

この論文は、安全認識におけるマルチモーダル 3D 検出手法の大きな利点を指摘しており、さまざまなセンサーからのデータを融合することで、より豊かで多様な認識能力を提供し、それによって自動運転システムを改善します。 。

1. データセット

上記では、自動運転システムで使用される 3D 物体検出データセットを、主に Evaluate に焦点を当てて簡単に紹介します。さまざまなセンサーモダリティの利点と限界、および公開データセットの特性。

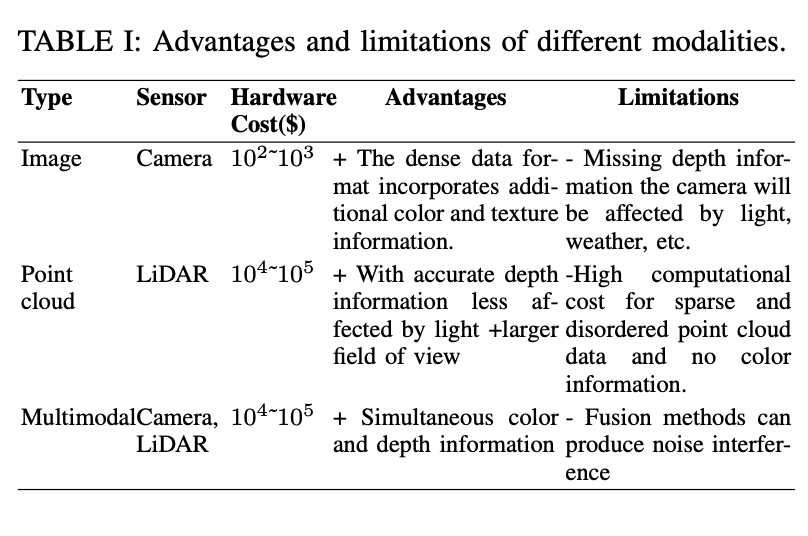

まず、表には、カメラ、点群、マルチモーダル (カメラと LIDAR) の 3 種類のセンサーが示されています。タイプごとに、ハードウェアのコスト、利点、および制限がリストされます。カメラ データの利点は、豊富な色とテクスチャ情報を提供できることですが、深度情報が欠如していることと、光や天候の影響を受けやすいことが限界です。 LiDAR は正確な深度情報を提供できますが、高価で色情報がありません。

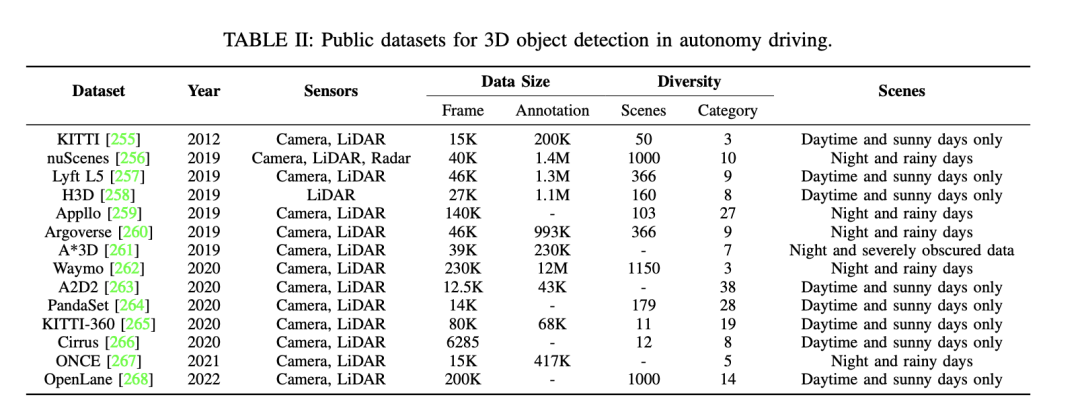

次に、自動運転における 3D 物体検出に利用できる公開データセットが他にもいくつかあります。これらのデータセットには、KITTI、nuScenes、Waymo などが含まれます。これらのデータセットの詳細は次のとおりです。 - KITTI データセットには、さまざまな種類のセンサーを使用して複数年にリリースされたデータが含まれています。多数のフレームと注釈のほか、シーン番号とカテゴリ、日中、晴れ、夜、雨などのさまざまなシーン タイプを含むさまざまなシーンが提供されます。 - nuScenes データセットも重要なデータセットであり、複数年にリリースされたデータも含まれています。このデータセットはさまざまなセンサーを使用し、多数のフレームとアノテーションを提供します。さまざまなシーン番号やカテゴリ、さまざまなシーン タイプなど、さまざまなシナリオをカバーしています。 - Waymo データセットも自動運転用のデータセットで、これにも複数年のデータが含まれています。このデータセットはさまざまなタイプのセンサーを使用し、豊富な数のフレームと注釈を提供します。さまざまなシナリオをカバーします

さらに、「クリーンな」自動運転データセットに関する研究についても触れられ、ノイズの多いシナリオ下でのモデルの堅牢性を評価することの重要性が強調されています。過酷な条件下でのカメラの単一モダリティ手法に焦点を当てた研究もあれば、ノイズの問題に焦点を当てたマルチモーダル データセットもあります。たとえば、GROUNDED データセットは、さまざまな気象条件下での地中レーダー測位に焦点を当てているのに対し、ApolloScape オープン データセットには、さまざまな気象条件や照明条件をカバーする LIDAR、カメラ、GPS データが含まれています。

現実世界で大規模なノイズを含むデータを収集するには法外なコストがかかるため、多くの研究では合成データセットの使用が検討されています。たとえば、ImageNet-C は、画像分類モデルにおける一般的な摂動に対処するためのベンチマーク研究です。この研究の方向性はその後、自動運転における 3D 物体検出用に調整された堅牢なデータセットに拡張されました。

#2. 視覚ベースの 3D オブジェクト検出

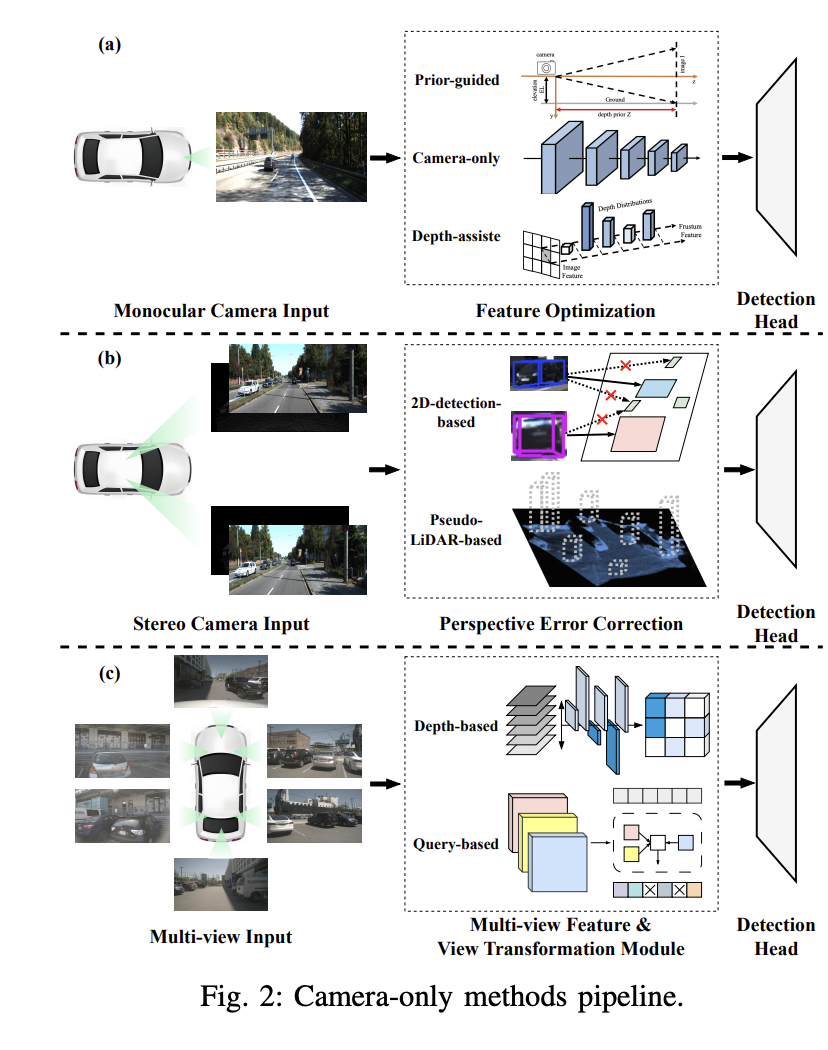

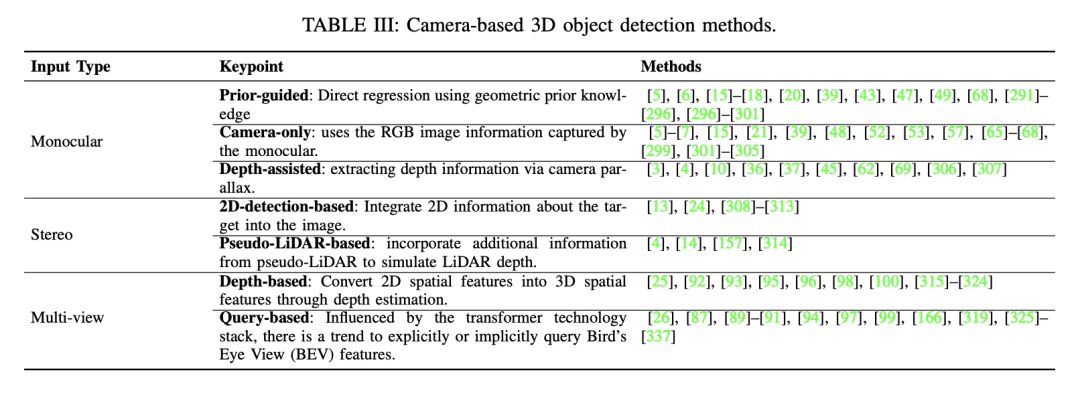

#このパートでは、単眼 3D オブジェクト検出の概念と、事前ベースの単眼 3D オブジェクト検出、カメラのみの単眼 3D オブジェクト検出、および深度支援による単眼 3D オブジェクト検出の 3 つの主な方法について説明します。

事前ガイド付き単眼 3D オブジェクト検出

この方法では、画像に隠されたオブジェクトの形状とシーンのジオメトリに関する事前知識を利用して、単眼 3D オブジェクト検出の課題を解決します。事前トレーニングされたサブネットワークまたは補助タスクを導入することにより、事前の知識により追加の情報または制約が提供され、3D オブジェクトの正確な位置を特定し、検出の精度と堅牢性を向上させることができます。共通の事前知識には、オブジェクトの形状、幾何学的一貫性、時間的制約、およびセグメンテーション情報が含まれます。たとえば、Mono3D アルゴリズムは、まず 3D オブジェクトが固定地平面上にあると仮定し、次にオブジェクトの以前の 3D 形状を使用して 3D 空間内にバウンディング ボックスを再構築します。

#カメラのみの単眼 3D オブジェクト検出

この方法では、単一のカメラでキャプチャされた画像のみを使用して 3D オブジェクトの検出と位置特定を行います。 。畳み込みニューラル ネットワーク (CNN) を使用して画像から 3D バウンディング ボックス パラメーターを直接回帰し、3 次元空間内のオブジェクトのサイズと姿勢を推定します。この直接回帰手法はエンドツーエンドの方法でトレーニングでき、3D オブジェクトの全体的な学習と推論を促進します。たとえば、Smoke アルゴリズムは 2D 境界ボックスの回帰を放棄し、個々のキーポイントの推定と 3D 変数の回帰を組み合わせることによって、検出された各オブジェクトの 3D ボックスを予測します。

奥行き支援による単眼 3D オブジェクト検出奥行き推定は、奥行き支援による単眼 3D オブジェクト検出において重要な役割を果たします。より正確な単眼検出結果を達成するために、多くの研究では、事前にトレーニングされた補助的な深さ推定ネットワークが利用されています。このプロセスは、MonoDepth などの事前トレーニングされた深度推定器を使用して、単眼画像を深度画像に変換することから始まります。次に、深度画像と単眼画像を処理するために 2 つの主な方法が採用されます。たとえば、Pseudo-LiDAR 検出器は、事前トレーニングされた深度推定ネットワークを使用して Pseudo-LiDAR 表現を生成しますが、画像から LiDAR への生成のエラーにより、Pseudo-LiDAR と LiDAR ベースの検出器の間には大きなパフォーマンスのギャップが存在します。

これらの方法の探索と応用を通じて、単眼 3D オブジェクト検出はコンピュータ ビジョンとインテリジェント システムの分野で大きな進歩を遂げ、これらの分野にブレークスルーとチャンスをもたらしました。

このパートでは、ステレオ ビジョンに基づく 3D オブジェクト検出テクノロジについて説明します。ステレオ ビジョン 3D オブジェクト検出では、一対の立体画像を利用して 3D オブジェクトを識別し、位置を特定します。これらの方法は、ステレオ カメラでキャプチャされたデュアル ビューを利用することにより、ステレオ マッチングとキャリブレーションを通じて高精度の深度情報を取得することに優れており、これが単眼カメラのセットアップと異なる特徴です。これらの利点にもかかわらず、ステレオ ビジョン手法には、LIDAR ベースの手法と比較して依然としてパフォーマンスに大きなギャップがあります。さらに、ステレオ画像からの 3D オブジェクト検出の領域は比較的ほとんど研究されておらず、この領域に特化した研究努力は限られています。

- 2D 検出ベースの方法: 従来の 2D オブジェクト検出フレームワークを変更して、ステレオ検出の問題を解決できます。たとえば、ステレオ R-CNN は、画像ベースの 2D 検出器を使用して 2D プロポーザルを予測し、対応する左右の画像の左右の関心領域 (RoI) を生成します。続いて、第 2 段階では、以前に生成された RoI に基づいて 3D オブジェクトのパラメータを直接推定します。このパラダイムはその後の研究で広く採用されました。

- 擬似LiDARベースの方法: ステレオ画像から予測された視差マップは深度マップに変換でき、さらに擬似LiDARポイントに変換できます。したがって、単眼検出方法と同様に、擬似ライダー表現はステレオビジョンベースの 3D オブジェクト検出方法でも使用できます。これらの方法は、ステレオ マッチングにおける視差推定を強化して、より正確な奥行き予測を実現することを目的としています。たとえば、Wang らは、擬似ライダー表現の導入における先駆者でした。この表現は深度マップを含む画像から生成され、検出を支援するためにモデルが深度推定タスクを実行する必要があります。その後の研究はこのパラダイムに従い、追加の色情報を導入して疑似点群、補助タスク (インスタンスのセグメンテーション、前景と背景のセグメンテーション、ドメイン適応など)、および座標変換スキームを強化することによって改良されました。 Ma et al.によって提案されたPatchNetは、単眼3D物体検出に擬似ライダー表現を使用するという従来の概念に挑戦していることは注目に値します。各ピクセルの 3D 座標をエンコードすることにより、PatchNet は擬似 LIDAR 表現を使用せずに同等の単眼検出結果を達成できます。この観察は、擬似 LIDAR 表現の力が点群表現そのものではなく、座標変換から得られることを示唆しています。

2.3 マルチビュー 3D オブジェクト検出

最近、マルチビュー 3D オブジェクト検出は次の点で改善されました。精度と堅牢性が高く、前述の単眼視や立体視による3D物体検出方式と比較して優れています。 LiDAR ベースの 3D 物体検出とは異なり、最新のパノラマ鳥瞰図 (BEV) 手法により、高精度マップの必要性がなくなり、検出が 2D から 3D に向上します。この進歩は、マルチビュー 3D オブジェクト検出の重要な発展につながりました。マルチカメラ 3D 物体検出における主な課題は、異なる画像内の同じ物体を識別し、複数の視点入力から身体の特徴を集約することです。現在の方法では、複数のビューを鳥瞰図 (BEV) 空間に均一にマッピングすることが一般的です。

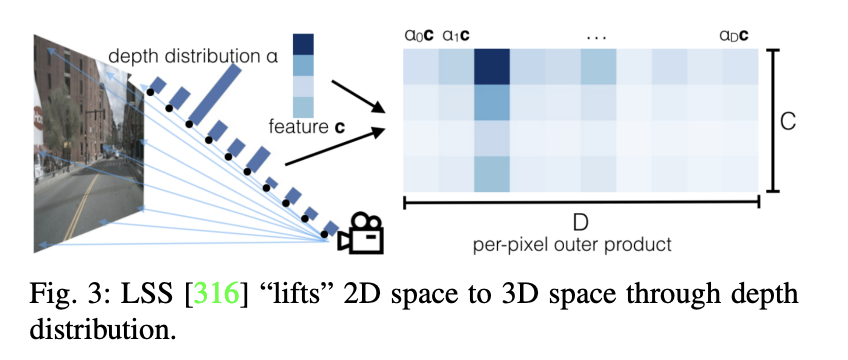

深度ベースのマルチビュー手法:

2D 空間から BEV 空間への直接変換は、重大な課題を引き起こします。 LSS は、3D 空間を仲介物として利用する深度ベースの方法を初めて提案しました。この方法では、まず 2D フィーチャのグリッド深度分布を予測し、次にこれらのフィーチャをボクセル空間に持ち上げます。このアプローチにより、2D 空間から BEV 空間へのより効率的な変換が期待できます。 LSS に続いて、CaDDN も同様の深い表現方法を採用しています。ボクセル空間の特徴を BEV 空間に圧縮することで、最終的な 3D 検出を実行します。 CaDDN はマルチビュー 3D オブジェクト検出の一部ではなく、シングルビュー 3D オブジェクト検出であり、その後の詳細な研究に影響を与えたことは注目に値します。 LSS と CaDDN の主な違いは、CaDDN は実際のグラウンドトゥルース深度値を使用して分類深度分布の予測を監視するため、2D 空間から 3D 情報をより正確に抽出できる優れた深層ネットワークを作成できることです。

クエリベースのマルチビュー メソッド

Transformer テクノロジの影響により、クエリベースのマルチビュー メソッドは 3D 空間から 2D 空間のフィーチャを取得します。 DETR3D は、マルチビュー フィーチャの集約問題を解決するために 3D オブジェクト クエリを導入しました。さまざまな視点から画像特徴を切り出し、学習した 3D 基準点を使用して 2D 空間に投影することで、Bird's Eye View (BEV) 空間の画像特徴を取得します。深さベースのマルチビュー方法とは異なり、クエリベースのマルチビュー方法は、逆クエリ技術を使用してまばらなBEV特徴を取得し、これはその後のクエリベースの開発に根本的に影響を与えます。ただし、明示的な 3D 基準点に関連する潜在的な不正確さのため、PETR は BEV 空間を構築するために暗黙的な位置エンコーディング手法を採用し、その後の作業に影響を与えました。

2.4 分析: 精度、遅延、堅牢性

現在、鳥瞰図 (BEV) 認識に基づく 3D 物体検出ソリューションが急速に開発されています。多くのレビュー記事が存在するにもかかわらず、この分野の包括的なレビューはまだ不十分です。 Shanghai AI Lab と SenseTime Research Institute は、BEV ソリューションの技術ロードマップの詳細なレビューを提供します。ただし、既存のレビューとは異なり、自動運転の安全認識などの重要な側面を考慮しています。カメラベースのソリューションの技術ロードマップと現在の開発状況を分析した後、「精度、遅延、堅牢性」の基本原則に基づいて議論する予定です。安全意識の視点を統合し、自動運転における安全意識の実践を導きます。

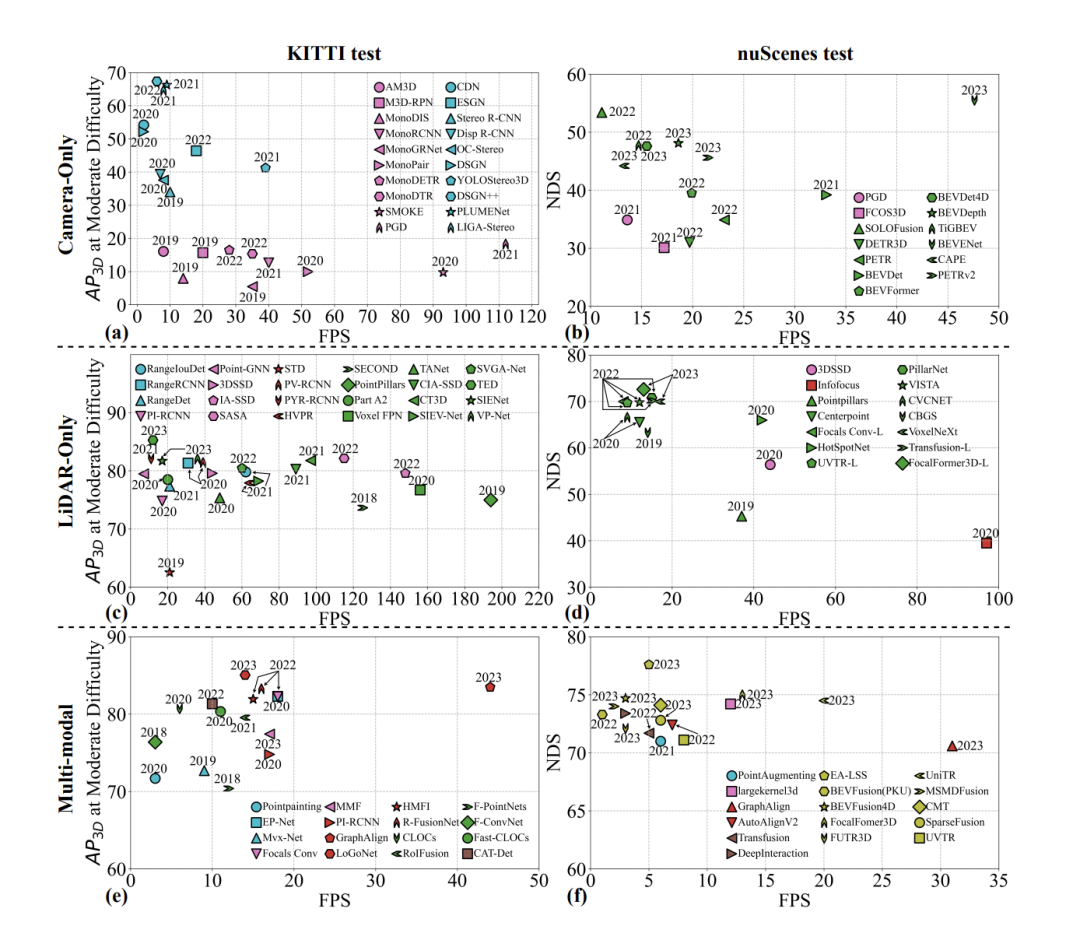

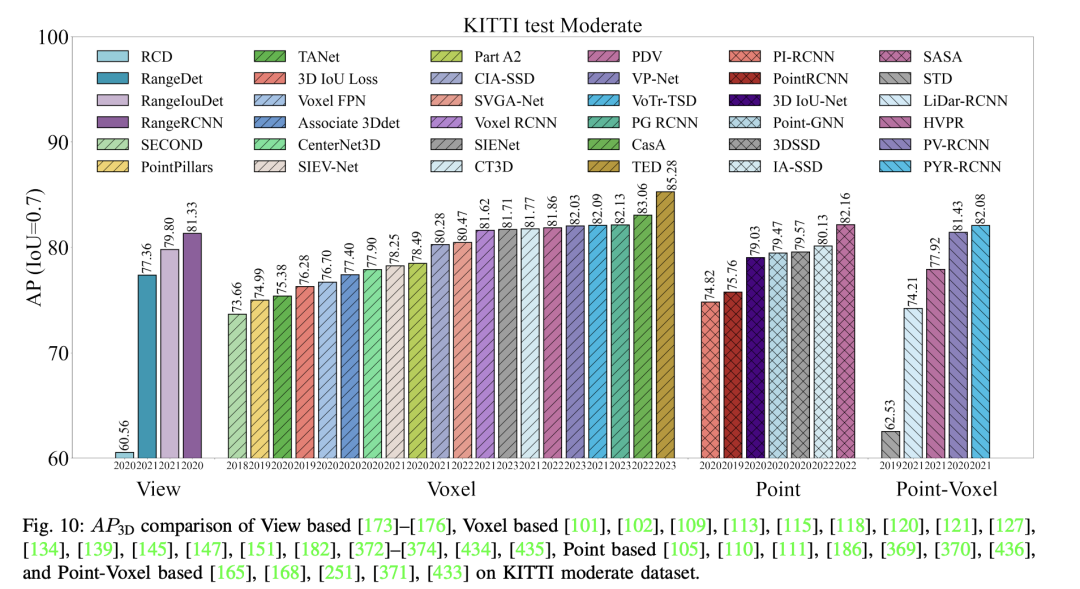

- 精度: ほとんどの研究論文やレビューでは精度が重視されており、これは非常に重要です。精度は AP (平均精度) に反映されますが、手法が異なればパラダイムの違いにより大きな違いが現れる可能性があるため、AP だけを考慮しても包括的な見通しが得られない可能性があります。図に示すように、代表的な 10 の方法を比較のために選択しました。その結果は、単眼式 3D オブジェクト検出と立体視 3D オブジェクト検出の間に大きなメトリックの違いがあることを示しています。現状では、単眼立体物検出の精度は立体立体物検出の精度に比べてかなり低いことがわかります。ステレオ ビジョン 3D オブジェクト検出では、同じシーンの 2 つの異なる視点からキャプチャされた画像を利用して、奥行き情報を取得します。カメラ間のベースラインが大きいほど、取得される深度情報の範囲が広くなります。時間の経過とともに、マルチビュー (鳥瞰図認識) 3D オブジェクト検出が徐々に単眼方式に取って代わり、mAP が大幅に向上しました。センサーの数の増加は、mAP に大きな影響を与えます。

- 遅延: 自動運転の分野では、遅延は非常に重要です。これは、システムが入力信号に反応するまでにかかる時間を指します。これには、センサー データの収集からシステムの意思決定、アクションの実行までのプロセス全体が含まれます。自動運転では、いかなる形式の遅延も重大な結果につながる可能性があるため、遅延の要件は非常に厳格です。自動運転における遅延の重要性は、リアルタイム応答性、安全性、ユーザー エクスペリエンス、双方向性、緊急対応などの側面に反映されています。 3D オブジェクト検出の分野では、遅延 (1 秒あたりのフレーム数、FPS) と精度がアルゴリズムのパフォーマンスを評価するための重要な指標です。図に示すように、単眼視および立体視による 3D オブジェクト検出のグラフは、KITTI データセットの同じ難易度における平均精度 (AP) と FPS の関係を示しています。自動運転を実装するには、3D 物体検出アルゴリズムは遅延と精度のバランスを取る必要があります。単眼検出は高速ですが、精度に欠けます。逆に、ステレオおよびマルチビュー方式は正確ですが、時間がかかります。今後の研究では、高い精度を維持するだけでなく、自動運転におけるリアルタイム応答性と安全性という 2 つの要件を満たすために、FPS の向上と遅延の短縮にもさらに注意を払う必要があります。

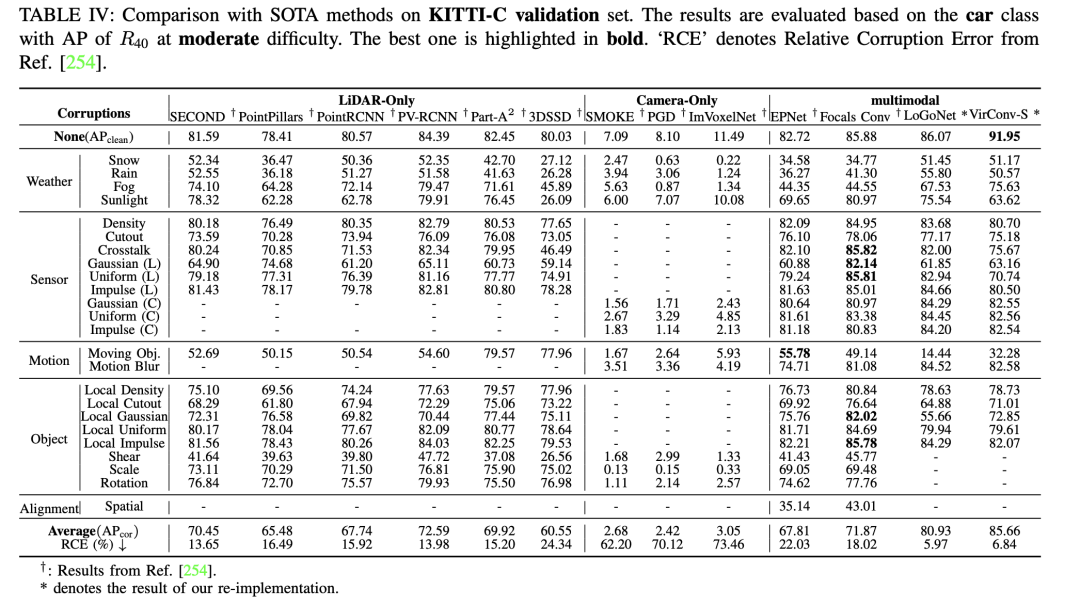

- 堅牢性: 堅牢性は自動運転の安全性に関する認識における重要な要素であり、これまで包括的なレビューでは見落とされてきた重要なトピックを表しています。この側面は、KITTI、nuScenes、Waymo などの、現在の適切に設計されたクリーンなデータセットやベンチマークでは対処されていないことがよくあります。現在、RoboBEV や Robo3D などの研究成果には、センサー損失やその他の要因など、3D オブジェクト検出における堅牢性の考慮事項が組み込まれています。彼らは、堅牢性を評価するために 3D オブジェクト検出に関連するデータセットに摂動を導入することを含む方法論を採用しています。これには、気象条件の変化、センサーの故障、動作の外乱、オブジェクト関連の摂動など、さまざまな種類のノイズの導入が含まれており、さまざまなノイズ源がモデルに及ぼすさまざまな影響を明らかにすることを目的としています。通常、堅牢性を研究するほとんどの論文は、クリーンなデータセット (KITTI、nuScenes、Waymo など) の検証セットにノイズを導入することによって評価されます。さらに、カメラのみの 3D オブジェクト検出方法の例として KITTI-C と nuScenes-C を強調する参考文献の調査結果を強調します。この表は、カメラのみのアプローチが LIDAR のみおよびマルチモデル融合アプローチよりも全体的に堅牢でないことを示す全体的な比較を示しています。さまざまな種類のノイズの影響を非常に受けやすくなります。 KITTI-C では、SMOKE、PGD、および ImVoxelNet の 3 つの代表的な作品は、一貫して全体的なパフォーマンスが低く、ノイズに対する堅牢性が低下しています。 nuScenes-C では、DETR3D や BEVFormer などの注目すべき手法が FCOS3D や PGD と比較して優れた堅牢性を示しており、センサーの数が増えるにつれて全体的な堅牢性が向上することがわかります。要約すると、将来のカメラのみのアプローチでは、コスト要因と精度指標 (mAP、NDS など) だけでなく、安全認識と堅牢性に関連する要因も考慮する必要があります。私たちの分析は、将来の自動運転システムの安全性について貴重な洞察を提供することを目的としています。

3. Lidar ベースの 3D オブジェクト検出

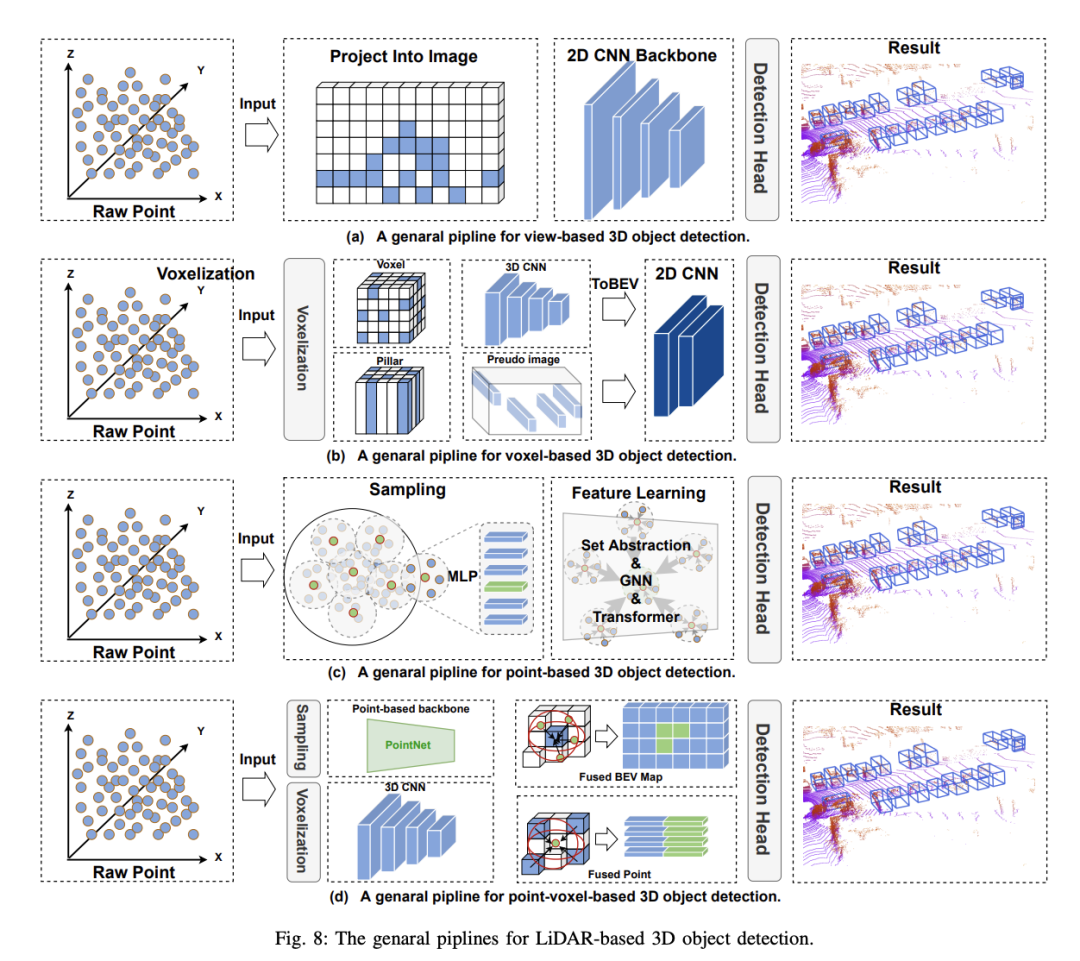

ボクセルベースの 3D オブジェクト検出方法は、スパースを組み合わせることを提案します。点群はセグメント化されて通常のボクセルに割り当てられ、その結果、高密度のデータ表現が得られます。このプロセスはボクセル化と呼ばれます。ビューベースの方法と比較して、ボクセルベースの方法は空間畳み込みを使用して 3D 空間情報を効果的に認識し、自動運転における安全認識に不可欠なより高い検出精度を実現します。ただし、これらの方法には依然として次の課題があります:

- 高い計算複雑さ: カメラベースの方法と比較して、ボクセルベースの方法は、3D 空間を表すために膨大な数のボクセルが使用されるため、大量のメモリとコンピューティング リソースを必要とします。

- 空間情報の損失: ボクセルの離散化特性により、ボクセル化プロセス中に詳細や形状情報が失われたりぼやけたりする可能性があります。同時に、ボクセルの解像度が限られているため、正確に検出するのが難しい小さな物体。

- スケールと密度の不一致: ボクセルベースの手法では、通常、異なるスケールと密度のボクセル グリッドでの検出が必要ですが、異なるシーンでのターゲットのスケールと密度の変化が大きいため、さまざまな目標に合わせて適切なスケールと密度を選択することが課題になります。

これらの課題を克服するには、データ表現の制限を解決し、ネットワーク機能の機能とターゲット位置の精度を向上させ、複雑なシーンに対するアルゴリズムの理解を強化する必要があります。最適化戦略はさまざまですが、通常はデータ表現とモデル構造の両方を最適化することを目的としています。

3.1 ボクセルベースの 3D オブジェクト検出

PC のディープラーニングの隆盛により、ポイントベースの 3D オブジェクト検出はそのフレームワークの多くを継承し、Detect 3D を提案します。前処理を行わずに元のポイントからオブジェクトを直接抽出します。ボクセルベースの方法と比較して、元の点群は元の情報を最大限に保持するため、きめ細かい特徴の取得に有益であり、結果として高精度が得られます。同時に、PointNet に関する一連の作業により、ポイントベースのメソッドの強力な基盤が自然に提供されます。ポイントベースの 3D オブジェクト検出器には、点群サンプリングと特徴学習という 2 つの基本コンポーネントがあります。現時点では、ポイントベースの手法のパフォーマンスは、コンテキスト ポイントの数と特徴学習で採用されるコンテキスト半径という 2 つの要素によって依然として影響を受けます。 。例: コンテキスト ポイントの数を増やすと、より詳細な 3D 情報を取得できますが、モデルの推論時間が大幅に増加します。同様に、コンテキストの半径を小さくすると、同じ効果が得られる可能性があります。したがって、これら 2 つの要素に適切な値を選択することで、モデルが精度と速度のバランスを達成できるようになります。さらに、点群内の各点を計算する必要があるため、点群のサンプリング プロセスが点ベースの方法のリアルタイム操作を制限する主な要因になります。具体的には、上記の問題を解決するために、ほとんどの既存の方法は、ポイントベースの 3D オブジェクト検出器の 2 つの基本コンポーネントを中心に最適化されています: 1) ポイント サンプリング 2) 特徴学習

3.2 ポイントベースの 3D オブジェクト検出

ポイントベースの 3D オブジェクト検出方法は、多くの深層学習フレームワークを継承しており、前処理は実行せずに、元の点群から直接 3D オブジェクトを検出することを提案しています。ボクセルベースの手法と比較して、元の点群は元の情報を最大限に保持するため、きめの細かい特徴を取得することができ、高い精度が得られます。同時に、PointNet の一連の作業は、ポイントベースのメソッドの強力な基盤を提供します。ただし、これまでのところ、ポイントベースの手法のパフォーマンスは、依然として 2 つの要素、つまり特徴学習で使用されるコンテキスト ポイントの数とコンテキスト半径の影響を受けます。たとえば、コンテキスト ポイントの数を増やすと、より詳細な 3D 情報を取得できますが、モデルの推論時間は大幅に増加します。同様に、コンテキスト半径を小さくすると、同じ効果が得られます。したがって、これら 2 つの要素に適切な値を選択することで、モデルの精度と速度のバランスを実現できます。さらに、点群サンプリング プロセスは、点群内の各点に対して計算を実行する必要があるため、ポイントベースの方法のリアルタイム操作を制限する主な要因です。これらの問題を解決するために、既存の方法は主に、ポイントベースの 3D オブジェクト検出器の 2 つの基本コンポーネント、1) 点群サンプリング、2) 特徴学習を中心に最適化しています。

最遠点サンプリング (FPS) は PointNet から派生したもので、ポイントベースの手法で広く使用されている点群サンプリング手法です。その目標は、元の点群から代表的な点のセットを選択して、それらの間の距離を最大化し、点群全体の空間分布を最適にカバーすることです。 PointRCNN は、PointNet をバックボーン ネットワークとして使用する、ポイントベースの手法の中で画期的な 2 段階の検出器です。最初の段階では、点群からボトムアップ方式で 3D 提案を生成します。第 2 段階では、意味論的な特徴と局所的な空間特徴を組み合わせることによって提案が洗練されます。ただし、既存の FPS ベースの手法には依然としていくつかの問題があります: 1) 検出に関係のないポイントもサンプリング プロセスに関与し、追加の計算負荷が生じます; 2) ポイントがオブジェクトのさまざまな部分に不均一に分布し、その結果、サンプリング戦略が最適ではなくなります。これらの問題に対処するために、その後の作業では FPS のような設計パラダイムを採用し、セグメンテーション、ランダム サンプリング、特徴空間サンプリング、ボクセル ベースのサンプリング、レイ グループ ベースのサンプリングに基づいた背景ポイント フィルタリングなどの改善が行われました。

ポイントベースの 3D オブジェクト検出方法の特徴学習段階は、まばらな点群データから識別可能な特徴表現を抽出することを目的としています。特徴学習段階で使用されるニューラル ネットワークは、次の特性を持つ必要があります: 1) 不変性、点群バックボーン ネットワークは入力点群の次数に影響されない必要があります; 2) ローカル認識機能があり、ローカル エリアを感知してモデル化できます。 、ローカル特徴を抽出する、3)コンテキスト情報を統合し、グローバルおよびローカルコンテキスト情報から特徴を抽出する機能。上記の特性に基づいて、生の点群を処理するために多数の検出器が設計されています。ほとんどのメソッドは、使用されるコア オペレーターに従って次のように分類できます: 1) PointNet ベースのメソッド、2) グラフ ニューラル ネットワーク ベースのメソッド、3) Transformer ベースのメソッド。

PointNet ベースのメソッド

PointNet ベースのメソッドは、主にセットの抽象化に依存して、元の点をダウンサンプリングし、ローカル情報を集約し、元の対称性の不変性を維持しながらコンテキスト情報を統合します。ポイントの。 Point-RCNN は、ポイントベースの手法の中で初の 2 段階の作業であり、優れたパフォーマンスを実現しますが、依然として計算コストが高いという問題に直面しています。その後の研究では、検出プロセスに追加のセマンティック セグメンテーション タスクを導入して、検出にほとんど寄与しない背景ポイントを除外することで、この問題を解決しました。

グラフ ニューラル ネットワークに基づくメソッド

グラフ ニューラル ネットワーク (GNN) には、適応構造、動的近傍、ローカルおよびグローバルのコンテキスト関係を構築する機能、および定期的なサンプリングの堅牢性。 Point-GNN は、自動登録メカニズム、マージ、スコアリング操作を通じてオブジェクトのカテゴリと形状を予測する単一ステージのグラフ ニューラル ネットワークを設計する先駆的な研究であり、3D オブジェクト検出の新しい方法としてグラフ ニューラル ネットワークの使用を実証しています。潜在的。

Transformer ベースの手法

近年、Transformer (Transformer) は点群解析で研究されており、多くのタスクで良好なパフォーマンスを発揮しています。たとえば、Pointformer は 3D 点群を処理するローカルおよびグローバル アテンション モジュールを導入し、ローカル Transformer モジュールはローカル領域内の点間の相互作用をモデル化するために使用され、グローバル Transformer はシーンレベルのコンテキスト認識表現を学習することを目的としています。グループフリーは、点群内のすべての点を直接利用して、各オブジェクト候補の特徴を計算します。各点の寄与は、自動的に学習されたアテンション モジュールによって決定されます。これらの方法は、非構造化および順序付けされていない生の点群の処理における Transformer ベースの方法の可能性を示しています。

3.3 点ボクセル ベースの 3D オブジェクト検出

点群ベースの 3D オブジェクト検出方法は、高解像度を提供し、元のデータの空間構造を保持しますが、面スパースなデータを扱う場合、計算が非常に複雑になり非効率になります。対照的に、ボクセルベースの方法は、構造化されたデータ表現を提供し、計算効率を向上させ、従来の畳み込みニューラル ネットワーク テクノロジーの適用を容易にします。ただし、離散化プロセスにより、微細な空間的詳細が失われることがよくあります。これらの問題を解決するために、ポイントボクセル (PV) ベースの方法が開発されました。ポイントボクセル手法は、ポイントベース手法のきめ細かい情報取得機能とボクセルベース手法の計算効率を活用することを目的としています。これらの方法を統合することにより、ポイントボクセルベースの方法は点群データをより詳細に処理し、全体的な構造と微細幾何学的詳細をキャプチャできます。自動運転システムの意思決定の精度は高精度の検出結果に依存するため、これは自動運転における安全認識にとって非常に重要です。

ポイントボクセル法の主な目標は、ポイントツーボクセルまたはボクセルツーポイント変換を通じて、ボクセルとポイント間のフィーチャの相互作用を実現することです。多くの研究が、バックボーン ネットワークでポイントとボクセルの特徴融合を利用するというアイデアを検討してきました。これらの方法は、1) 初期融合、2) 後期融合の 2 つのカテゴリに分類できます。

a) 初期融合: いくつかの方法では、ボクセルとポイントの特徴を融合するための新しい畳み込み演算子の使用が検討されており、PVCNN はこの方向での最初の研究となる可能性があります。このアプローチでは、ボクセルベースのブランチはまずポイントを低解像度のボクセル グリッドに変換し、畳み込みを通じて隣接するボクセルの特徴を集約します。次に、デボクセル化と呼ばれるプロセスを通じて、ボクセル レベルの特徴がポイント レベルの特徴に変換され、ポイントベースの分岐によって取得された特徴と融合されます。ポイントベースの分岐では、個々のポイントごとに特徴が抽出されます。近隣情報を集約しないため、この方法は高速に実行できます。その後、SPVCNN は PVCNN に基づいて物体検出の分野に拡張されました。補助タスクやマルチスケール特徴の融合など、さまざまな観点から改善を試みる方法もあります。

b) 融合後: この一連の方法では、主に 2 段階の検出フレームワークが使用されます。まず、ボクセルベースのアプローチを使用して、予備的なオブジェクトの提案が生成されます。次に、ポイントレベルの特徴を使用して、検出フレームを正確に分割します。 Shi et al. によって提案された PV-RCNN は、ポイントボクセルベースの方法におけるマイルストーンです。これは、第 1 段階の検出器として SECOND を使用し、キーポイント特徴を融合するための RoI グリッド プーリングを備えた第 2 段階の改良段階を提案しています。その後の研究は主に上記のパラダイムに従い、第 2 段階の検出の進歩に焦点を当てます。注目すべき開発には、アテンション メカニズム、スケールを意識したプーリング、ポイント密度を意識したリファインメント モジュールなどがあります。

ポイント ボクセル ベースの方法は、ボクセル ベースの方法の計算効率と、ポイント ベースの方法に基づいて詳細な情報をキャプチャする機能の両方を備えています。ただし、ポイント対ボクセルまたはボクセル対ポイントの関係を構築したり、ボクセルとポイントの特徴を融合すると、追加の計算オーバーヘッドが発生します。したがって、ポイントボクセルベースの方法は、ボクセルベースの方法と比較してより優れた検出精度を達成できますが、推論時間は増加します。

#4. マルチモーダル 3D オブジェクト検出

##4.1 投影ベースの 3D オブジェクト検出

投影ベースの 3D オブジェクト検出方法では、特徴融合段階で投影行列を使用して、点群と画像の特徴を統合します。ここで重要なのは、データ拡張などの融合段階の他の投影プロセスではなく、特徴融合中の投影に焦点を当てることです。融合段階で使用されるさまざまな種類の投影に応じて、投影ベースの 3D オブジェクト検出方法はさらに次のカテゴリに分類できます。

点投影に基づく 3D オブジェクト検出

: このタイプの方法は、画像の特徴を元の点群に投影することにより、元の点群データの表現能力を高めます。これらの方法の最初のステップは、キャリブレーション マトリックスを使用して、LIDAR ポイントと画像ピクセル間の強い相関関係を確立することです。次に、データを追加することで点群の特徴が強化されます。この機能強化には 2 つの形式があります。1 つはセグメンテーション スコアを結合することによるもの (PointPainting など)、もう 1 つは関連するピクセルからの CNN 特徴を使用するもの (MVP など)。 PointPainting はセグメンテーション スコアを追加することで LIDAR ポイントを強化しますが、画像内の色とテクスチャの詳細を効果的にキャプチャするには限界があります。これらの問題を解決するために、FusionPainting などのより洗練された方法が開発されました。- 特徴投影に基づく 3D オブジェクト検出: 点投影に基づく方法とは異なり、このタイプの方法は、点群特徴抽出段階で点群特徴と画像特徴を融合することに主に焦点を当てています。このプロセスでは、キャリブレーション マトリックスを適用してボクセルの 3D 座標系を画像のピクセル座標系に変換することにより、点群と画像モダリティが効果的に融合されます。たとえば、ContFuse は、連続畳み込みを通じてマルチスケール畳み込み特徴マップを融合します。

- 自動投影に基づく 3D オブジェクト検出: 多くの研究では直接投影によるフュージョンが実行されていますが、投影誤差の問題は解決されていません。一部の作品 (AutoAlignV2 など) は、オフセットや近傍投影などを学習することでこれらのエラーを軽減します。たとえば、HMFI、GraphAlign、および GraphAlign は、画像投影およびローカル グラフ モデリング用の投影キャリブレーション マトリックスの事前知識を利用します。

- 意思決定投影ベースの 3D オブジェクト検出: このタイプの方法では、投影行列を使用して、関心領域 (RoI) または特定の結果内のフィーチャを位置合わせします。たとえば、Graph-RCNN はグラフ ノードをカメラ画像内の位置に投影し、双一次補間を通じてカメラ画像内のそのピクセルの特徴ベクトルを収集します。 F-PointNet は、2D 画像検出を通じてオブジェクトのカテゴリと位置を決定し、3D 空間の校正されたセンサー パラメーターと変換行列を通じて、対応する 3D 空間の点群を取得します。

- これらの方法は、投影テクノロジーを使用してマルチモーダル 3D オブジェクト検出における特徴融合を実現する方法を示していますが、異なるモダリティ間の相互作用と精度の処理には依然として一定の制限があります。

#非投影ベースの 3D物体検出 この検出方法は、特徴の位置合わせに依存せずに融合を実現し、その結果、堅牢な特徴表現が得られます。これらは、多くの場合、カメラ機能のセマンティック密度を低下させ、Focals Conv や PointPainting などの技術の有効性に影響を与える、カメラから LIDAR への投影の制限を回避します。非投影法では通常、クロスアテンション メカニズムを採用するか、統一空間を構築して、直接特徴投影に固有の位置ずれの問題を解決します。これらの方法は主に、(1) クエリ学習ベースの方法と (2) 統合特徴ベースの方法の 2 つのカテゴリに分類されます。クエリ学習ベースの方法では、融合プロセス中の位置合わせの必要性が完全に回避されます。対照的に、統一特徴ベースの方法は、統一特徴空間を構築しますが、投影を完全に回避するわけではなく、通常は単一のモダリティ コンテキストで発生します。たとえば、BEVFusion はカメラから BEV への投影に LSS を利用します。このプロセスは融合前に発生し、フィーチャの位置がずれているシナリオでかなりの堅牢性を示します。

- クエリ学習に基づく 3 次元オブジェクト検出: Transfusion、DeepFusion、DeepInteraction、autoalign、CAT-Det、MixedFusion などのクエリ学習に基づく 3 次元オブジェクト検出手法.、 の機能融合プロセス投影要件を回避します。代わりに、クロスアテンション メカニズムを通じて特徴融合を実行する前に、特徴の位置合わせを実現します。通常、点群フィーチャはクエリとして使用され、画像フィーチャはキーと値として使用され、グローバル フィーチャ クエリを通じて堅牢性の高いマルチモーダルフィーチャが取得されます。さらに、DeepInteraction ではマルチモーダル インタラクションが導入されており、点群と画像フィーチャがさまざまなクエリとして使用され、さらなるフィーチャ インタラクションが実現されます。画像特徴の包括的な統合により、点群特徴のみをクエリとして使用する場合と比較して、より堅牢なマルチモーダル特徴の取得が可能になります。一般に、クエリ学習に基づく 3 次元物体検出方法では、Transformer ベースの構造を使用して特徴クエリを実行し、特徴の位置合わせを実現します。最終的に、マルチモーダル機能は CenterPoint などの LIDAR ベースのプロセスに統合されました。

- 統一特徴に基づく三次元物体検出: EA-BEV、BEVFusion、cai2023bevfusion4d、FocalFormer3D、FUTR3D、UniTR、Uni3Dなどの統一特徴に基づく三次元物体検出手法、virconv、MSMDFusion、sfd、cmt、UVTR、sparsefusion などは通常、特徴融合前の投影を通じて異種モダリティの融合前統合を実現します。 BEV fusion シリーズでは、深度推定に LSS が使用され、正面図の特徴が BEV 特徴に変換され、BEV 画像と BEV 点群特徴が融合されます。一方、CMT と UniTR は、点群と画像のトークン化に Transformer を使用し、Transformer エンコーディングを通じて暗黙的な統一空間を構築します。 CMT は位置エンコード プロセスで投影を使用しますが、特徴学習レベルでの投影関係への依存を完全に回避します。 FocalFormer3D、FUTR3D、および UVTR は、Transformer のクエリを使用して DETR3D と同様のソリューションを実装し、クエリを通じて統合されたスパース BEV 特徴空間を構築することで、直接投影によって引き起こされる不安定性を軽減します。

VirConv、MSMDFusion、SFD は擬似点群を通じて統一空間を構築し、特徴学習の前に投影が行われます。直接投影によってもたらされる問題は、その後の特徴学習によって解決されます。要約すると、統合されたフィーチャベースの 3D オブジェクト検出方法は、現在、非常に正確で堅牢なソリューションを表しています。これらには射影行列が含まれていますが、この射影はマルチモーダル フュージョン間では発生しないため、非射影 3D オブジェクト検出方法とみなされます。自動投影 3D オブジェクト検出方法とは異なり、投影誤差の問題を直接解決するわけではありませんが、統一空間を構築し、マルチモーダル 3D オブジェクト検出の複数の次元を考慮して、非常に堅牢なマルチモーダル特徴を取得することを選択します。

5. 結論

3D オブジェクト検出は、自動運転の知覚において重要な役割を果たします。近年、この分野は急速に発展し、数多くの研究論文が発表されています。センサーによって生成される多様なデータ形式に基づいて、これらの方法は主に、画像ベース、点群ベース、およびマルチモーダルの 3 つのタイプに分類されます。これらの方法の主な評価指標は、高精度と低遅延です。多くのレビューがこれらのアプローチを要約し、主に「高精度と低遅延」の中核原則に焦点を当て、技術的な軌跡を説明しています。

しかし、自動運転技術がブレークスルーから実用化に移行する過程において、既存のレビューは安全認識を中心的な焦点として捉えておらず、安全認識に関連する現在の技術的道筋をカバーできていません。たとえば、最近のマルチモーダル融合手法は実験段階で堅牢性についてテストされることがよくありますが、この側面は現在のレビューでは十分に考慮されていません。

したがって、重要な側面として「精度、遅延、堅牢性」に焦点を当てて、3D オブジェクト検出アルゴリズムを再検討してください。私たちは、安全認識の観点からの再分類に特に重点を置いて、以前のレビューを再分類します。この研究が、高精度の限界を探るだけでなく、3D 物体検出に関する将来の研究に新たな洞察を提供することが期待されています。

以上がカメラかライダーを選択しますか?堅牢な 3D オブジェクト検出の実現に関する最近のレビューの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7456

7456

15

15

1375

1375

52

52

77

77

11

11

14

14

9

9

なぜ自動運転ではガウス スプラッティングが非常に人気があるのに、NeRF は放棄され始めているのでしょうか?

Jan 17, 2024 pm 02:57 PM

なぜ自動運転ではガウス スプラッティングが非常に人気があるのに、NeRF は放棄され始めているのでしょうか?

Jan 17, 2024 pm 02:57 PM

上記と著者の個人的な理解 3 次元ガウシアンプラッティング (3DGS) は、近年、明示的な放射線フィールドとコンピューター グラフィックスの分野で出現した革新的なテクノロジーです。この革新的な方法は、数百万の 3D ガウスを使用することを特徴とし、主に暗黙的な座標ベースのモデルを使用して空間座標をピクセル値にマッピングする神経放射線場 (NeRF) 方法とは大きく異なります。明示的なシーン表現と微分可能なレンダリング アルゴリズムにより、3DGS はリアルタイム レンダリング機能を保証するだけでなく、前例のないレベルの制御とシーン編集も導入します。これにより、3DGS は、次世代の 3D 再構築と表現にとって大きな変革をもたらす可能性のあるものとして位置付けられます。この目的を達成するために、私たちは 3DGS 分野における最新の開発と懸念について初めて体系的な概要を提供します。

自動運転シナリオにおけるロングテール問題を解決するにはどうすればよいでしょうか?

Jun 02, 2024 pm 02:44 PM

自動運転シナリオにおけるロングテール問題を解決するにはどうすればよいでしょうか?

Jun 02, 2024 pm 02:44 PM

昨日の面接で、ロングテール関連の質問をしたかと聞かれたので、簡単にまとめてみようと思いました。自動運転のロングテール問題とは、自動運転車におけるエッジケース、つまり発生確率が低い考えられるシナリオを指します。認識されているロングテール問題は、現在、単一車両のインテリジェント自動運転車の運用設計領域を制限している主な理由の 1 つです。自動運転の基礎となるアーキテクチャとほとんどの技術的問題は解決されており、残りの 5% のロングテール問題が徐々に自動運転の開発を制限する鍵となってきています。これらの問題には、さまざまな断片的なシナリオ、極端な状況、予測不可能な人間の行動が含まれます。自動運転におけるエッジ シナリオの「ロング テール」とは、自動運転車 (AV) におけるエッジ ケースを指します。エッジ ケースは、発生確率が低い可能性のあるシナリオです。これらの珍しい出来事

カメラかライダーを選択しますか?堅牢な 3D オブジェクト検出の実現に関する最近のレビュー

Jan 26, 2024 am 11:18 AM

カメラかライダーを選択しますか?堅牢な 3D オブジェクト検出の実現に関する最近のレビュー

Jan 26, 2024 am 11:18 AM

0.前面に書かれています&& 自動運転システムは、さまざまなセンサー (カメラ、ライダー、レーダーなど) を使用して周囲の環境を認識し、アルゴリズムとモデルを使用することにより、高度な知覚、意思決定、および制御テクノロジーに依存しているという個人的な理解リアルタイムの分析と意思決定に。これにより、車両は道路標識の認識、他の車両の検出と追跡、歩行者の行動の予測などを行うことで、安全な運行と複雑な交通環境への適応が可能となり、現在広く注目を集めており、将来の交通分野における重要な開発分野と考えられています。 。 1つ。しかし、自動運転を難しくしているのは、周囲で何が起こっているかを車に理解させる方法を見つけることです。これには、自動運転システムの 3 次元物体検出アルゴリズムが、周囲環境にある物体 (位置を含む) を正確に認識し、記述することができる必要があります。

CLIP-BEVFormer: BEVFormer 構造を明示的に監視して、ロングテール検出パフォーマンスを向上させます。

Mar 26, 2024 pm 12:41 PM

CLIP-BEVFormer: BEVFormer 構造を明示的に監視して、ロングテール検出パフォーマンスを向上させます。

Mar 26, 2024 pm 12:41 PM

上記および筆者の個人的な理解: 現在、自動運転システム全体において、認識モジュールが重要な役割を果たしている。道路を走行する自動運転車は、認識モジュールを通じてのみ正確な認識結果を得ることができる。下流の規制および制御モジュール自動運転システムでは、タイムリーかつ正確な判断と行動決定が行われます。現在、自動運転機能を備えた自動車には通常、サラウンドビューカメラセンサー、ライダーセンサー、ミリ波レーダーセンサーなどのさまざまなデータ情報センサーが搭載されており、さまざまなモダリティで情報を収集して正確な認識タスクを実現しています。純粋な視覚に基づく BEV 認識アルゴリズムは、ハードウェア コストが低く導入が容易であるため、業界で好まれており、その出力結果はさまざまな下流タスクに簡単に適用できます。

自動運転と軌道予測についてはこの記事を読めば十分です!

Feb 28, 2024 pm 07:20 PM

自動運転と軌道予測についてはこの記事を読めば十分です!

Feb 28, 2024 pm 07:20 PM

自動運転では軌道予測が重要な役割を果たしており、自動運転軌道予測とは、車両の走行過程におけるさまざまなデータを分析し、将来の車両の走行軌跡を予測することを指します。自動運転のコアモジュールとして、軌道予測の品質は下流の計画制御にとって非常に重要です。軌道予測タスクには豊富な技術スタックがあり、自動運転の動的/静的知覚、高精度地図、車線境界線、ニューラル ネットワーク アーキテクチャ (CNN&GNN&Transformer) スキルなどに精通している必要があります。始めるのは非常に困難です。多くのファンは、できるだけ早く軌道予測を始めて、落とし穴を避けたいと考えています。今日は、軌道予測に関するよくある問題と入門的な学習方法を取り上げます。関連知識の紹介 1. プレビュー用紙は整っていますか? A: まずアンケートを見てください。

SIMPL: 自動運転向けのシンプルで効率的なマルチエージェント動作予測ベンチマーク

Feb 20, 2024 am 11:48 AM

SIMPL: 自動運転向けのシンプルで効率的なマルチエージェント動作予測ベンチマーク

Feb 20, 2024 am 11:48 AM

原題: SIMPL: ASimpleandEfficientMulti-agentMotionPredictionBaselineforAutonomousDriving 論文リンク: https://arxiv.org/pdf/2402.02519.pdf コードリンク: https://github.com/HKUST-Aerial-Robotics/SIMPL 著者単位: 香港科学大学DJI 論文のアイデア: この論文は、自動運転車向けのシンプルで効率的な動作予測ベースライン (SIMPL) を提案しています。従来のエージェントセントとの比較

nuScenes の最新 SOTA | SparseAD: スパース クエリは効率的なエンドツーエンドの自動運転に役立ちます。

Apr 17, 2024 pm 06:22 PM

nuScenes の最新 SOTA | SparseAD: スパース クエリは効率的なエンドツーエンドの自動運転に役立ちます。

Apr 17, 2024 pm 06:22 PM

先頭と開始点に書かれている エンドツーエンドのパラダイムでは、統一されたフレームワークを使用して自動運転システムのマルチタスクを実現します。このパラダイムの単純さと明確さにも関わらず、サブタスクにおけるエンドツーエンドの自動運転手法のパフォーマンスは、依然としてシングルタスク手法に比べてはるかに遅れています。同時に、以前のエンドツーエンド手法で広く使用されていた高密度鳥瞰図 (BEV) 機能により、より多くのモダリティやタスクに拡張することが困難になります。ここでは、スパース検索中心のエンドツーエンド自動運転パラダイム (SparseAD) が提案されています。このパラダイムでは、スパース検索は、高密度の BEV 表現を使用せずに、空間、時間、タスクを含む運転シナリオ全体を完全に表します。具体的には、統合されたスパース アーキテクチャが、検出、追跡、オンライン マッピングなどのタスク認識のために設計されています。さらに、重い

エンドツーエンドおよび次世代の自動運転システムと、エンドツーエンドの自動運転に関する誤解について話しましょう。

Apr 15, 2024 pm 04:13 PM

エンドツーエンドおよび次世代の自動運転システムと、エンドツーエンドの自動運転に関する誤解について話しましょう。

Apr 15, 2024 pm 04:13 PM

この 1 か月間、いくつかのよく知られた理由により、私は業界のさまざまな教師やクラスメートと非常に集中的な交流をしてきました。この交換で避けられない話題は当然、エンドツーエンドと人気の Tesla FSDV12 です。この機会に、現時点での私の考えや意見を整理し、皆様のご参考とご議論に役立てたいと思います。エンドツーエンドの自動運転システムをどのように定義するか、またエンドツーエンドで解決することが期待される問題は何でしょうか?最も伝統的な定義によれば、エンドツーエンド システムとは、センサーから生の情報を入力し、関心のある変数をタスクに直接出力するシステムを指します。たとえば、画像認識では、従来の特徴抽出 + 分類子方式と比較して、CNN はエンドツーエンドと言えます。自動運転タスクでは、各種センサー(カメラ/LiDAR)からのデータを入力