なぜ ICLR はマンバの論文を受け入れなかったのでしょうか? AIコミュニティが大きな議論を巻き起こした

2023 年、AI 大型モデルの分野で有力なプレーヤーである Transformer の地位が挑戦され始めます。 「Mamba」と呼ばれる新しいアーキテクチャが登場しました。これは、言語モデリングの点で Transformer に匹敵し、さらにはそれを超える可能性がある選択的状態空間モデルです。同時に、Mamba はコンテキストの長さが増加するにつれて線形スケーリングを実現できるため、100 万ワード長のシーケンスを処理でき、実際のデータを処理する際の推論スループットが 5 倍向上します。この画期的な性能向上は目を引くものであり、AI分野の発展に新たな可能性をもたらします。

リリースから 1 か月以上経ち、Mamba は徐々にその影響力を発揮し始め、MoE-Mamba、Vision Mamba、VMamba、U-Mamba、MambaByte などの多くのプロジェクトを生み出しました。 . . Mamba は、Transformer の欠点を継続的に克服する大きな可能性を示しています。これらの開発は、Mamba の継続的な開発と進歩を示しており、人工知能の分野に新たな可能性をもたらしています。

しかし、この新進気鋭の「スター」は、2024 年の ICLR 会議で挫折に遭遇しました。最新の公開結果によると、マンバの論文はまだ保留中であるが、決定待ちの欄にその名前が表示されるだけで、延期されたのか却下されたのかは判断できない。

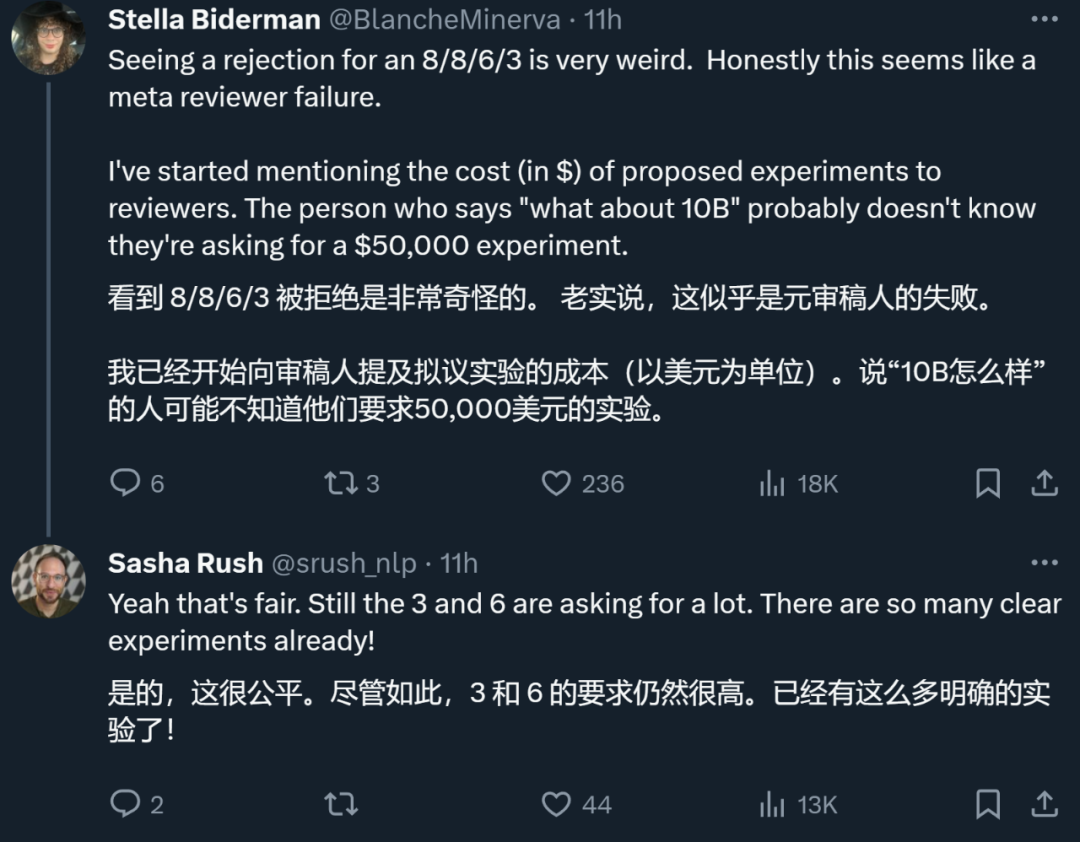

全体的に、Mamba は 4 人のレビュアーからそれぞれ 8/8/6/3 の評価を受けました。これほどの評価を受けたにもかかわらず拒否されるのは本当に不可解だという人もいた。

その理由を理解するには、低いスコアを付けた査読者のコメントを確認する必要があります。

論文レビュー ページ: https://openreview.net/forum?id=AL1fq05o7H

なぜ「十分ではない」のか?

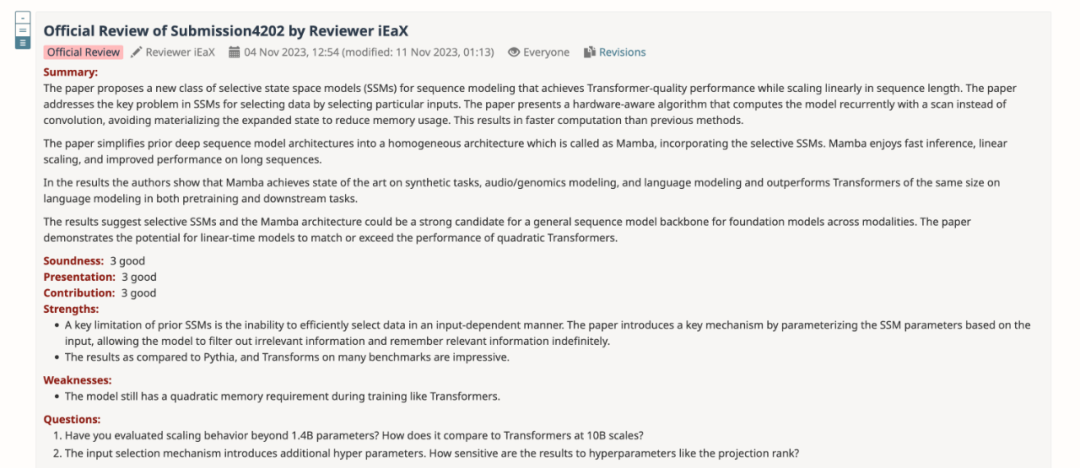

レビューのフィードバックで、「3: 拒否、十分ではない」というスコアを付けたレビューアーは、Mamba に関するいくつかの意見を説明しました:

モデル設計についての考え:

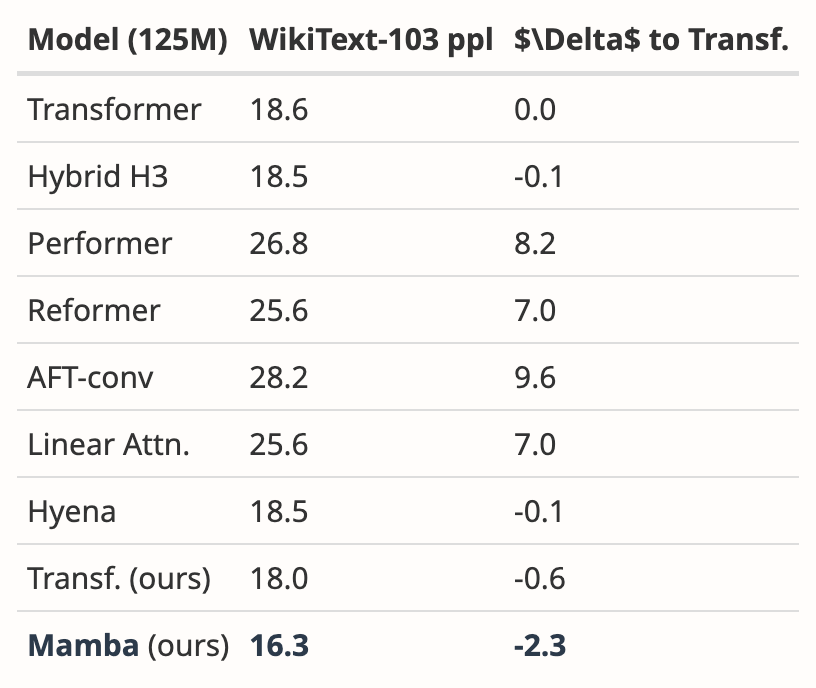

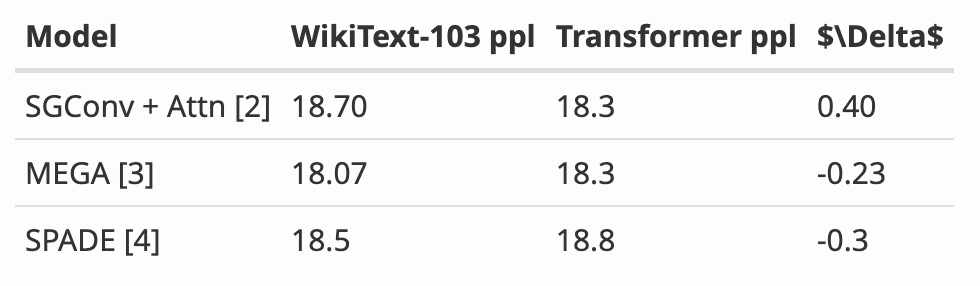

- Mamba の動機は、注意ベースのモデルの効率を向上させながら、再帰的モデルの欠点に対処することです。この方向に沿った多くの研究があります: S4-diagonal [1]、SGConv [2]、MEGA [3]、SPADE [4]、および多くの効率的な Transformer モデル (例: [5])。これらすべてのモデルはほぼ線形の複雑さを達成しており、著者はモデルのパフォーマンスと効率の点で Mamba をこれらの作品と比較する必要があります。モデルのパフォーマンスに関しては、いくつかの簡単な実験 (Wikitext-103 の言語モデリングなど) で十分です。

- アテンションベースの Transformer モデルの多くは長さの汎化能力を示します。つまり、モデルは短いシーケンス長でトレーニングし、より長いシーケンス長でテストできます。例としては、相対位置エンコーディング (T5) や Alibi [6] などがあります。 SSM は一般に連続的であるため、Mamba にはこの長さの汎化能力があるのでしょうか?

実験に関する考察:

- 著者は、より強力なベースラインと比較する必要があります。著者らは、モデル アーキテクチャの動機として H3 が使用されたと述べていますが、実験では H3 と比較しませんでした。 [7] の表 4 によると、Pile データセットでは、H3 の ppl はそれぞれ 8.8 (1.25 M)、7.1 (3.55 M)、および 6.0 (1.3B) であり、Mamba よりも大幅に優れています。著者らはH3との比較を示す必要がある。

- 事前トレーニング済みモデルについては、著者はゼロサンプル推論の結果のみを示しています。この設定はかなり制限されており、結果は Mamba の有効性を十分に裏付けていません。著者らには、入力シーケンスが自然に非常に長い (たとえば、arXiv データセットの平均シーケンス長が 8k を超える) 文書の要約など、長いシーケンスを使った実験をさらに行うことをお勧めします。

- 著者は、主な貢献の 1 つは長いシーケンスのモデリングであると主張しています。著者らは、基本的に長い配列を理解するための標準ベンチマークである LRA (Long Range Arena) 上のより多くのベースラインと比較する必要があります。

- #メモリ ベンチマークがありません。セクション 4.5 は「速度とメモリのベンチマーク」というタイトルですが、速度の比較のみが示されています。さらに、作成者は、図 8 の左側で、モデル層、モデル サイズ、畳み込みの詳細など、より詳細な設定を提供する必要があります。著者らは、シーケンス長が非常に長い場合 (図 8 左)、FlashAttention が最も遅くなる理由について、何らかの直観を提供できますか?

さらに、別のレビュー担当者も Mamba の欠点を指摘しました。モデルには、Transformers と同様に、トレーニング中に依然として二次メモリが必要です。

著者: 改訂しました、レビューしてください

すべての査読者の意見を要約した後、著者チームも論文の内容を改訂および改善し、新しい実験結果と追加を追加しました。分析:

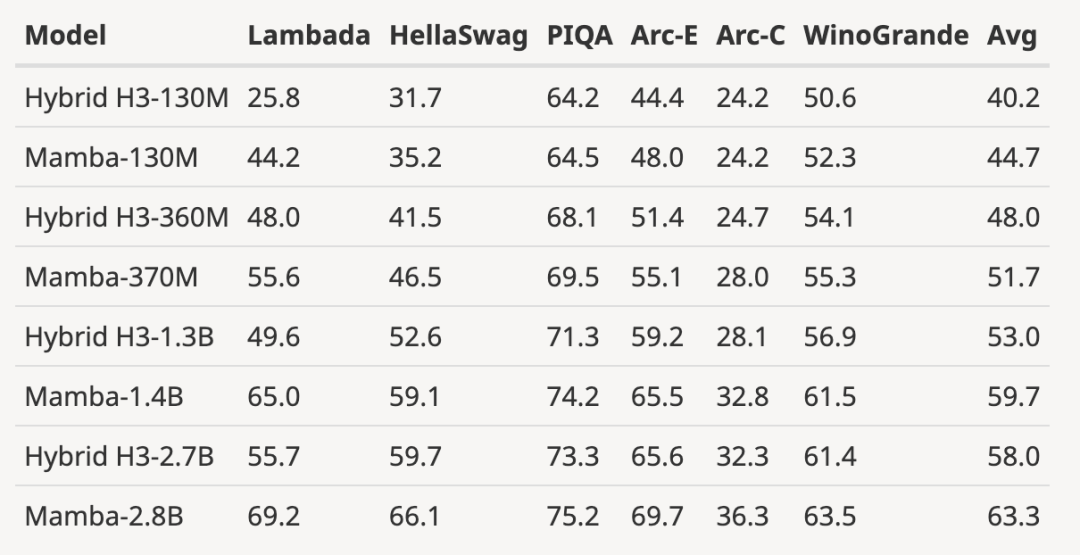

- H3 モデルの評価結果を追加

著者はサイズを 125M-2.7 Pretrained にダウンロードしましたB パラメータを使用して H3 モデルを作成し、一連の評価を実行しました。 Mamba はすべての言語評価において大幅に優れており、これらの H3 モデルは二次注意を使用したハイブリッド モデルであるのに対し、線形時間 Mamba 層のみを使用した著者の純粋なモデルはすべての指標において大幅に優れていることに注目する価値があります。

事前学習済み H3 モデルとの評価比較は次のとおりです:

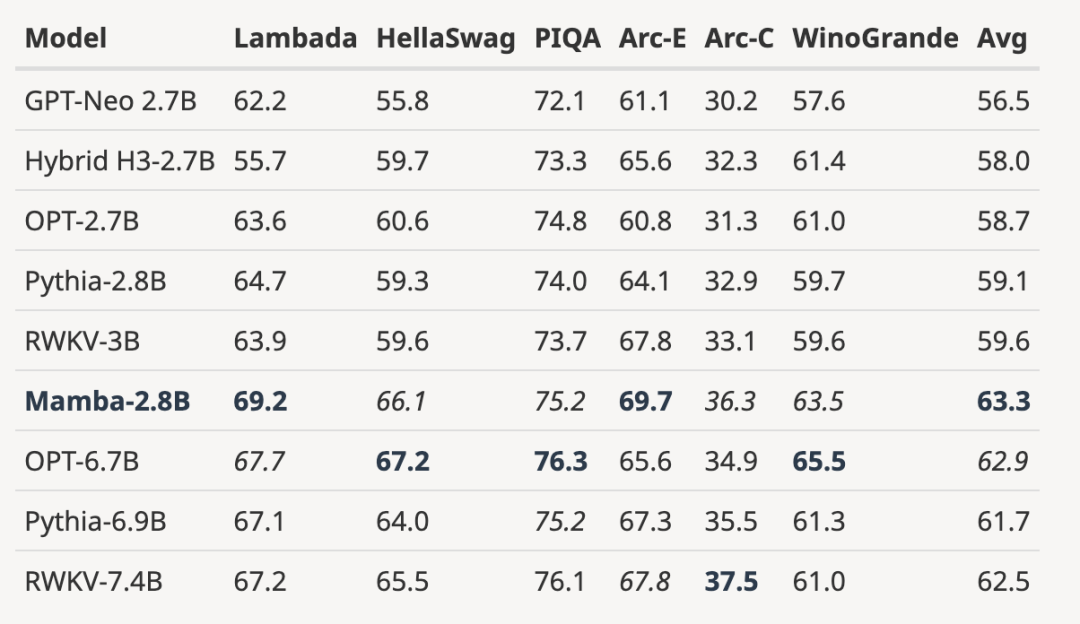

- ##完全にトレーニングされたモデルをより大きなモデル サイズに拡張します

下の図に示すように、同じ数値に基づいてトレーニングされた 3B オープンソースを使用します。トークン数(300B) モデルと比較して、すべての評価結果において Mamba が優れています。これは 7B スケール モデルにも匹敵します。Mamba (2.8B) を OPT、Pythia、および RWKV (7B) と比較すると、Mamba がすべてのベンチマーク スコアで最高の平均スコアと最高/2 位を達成しています。

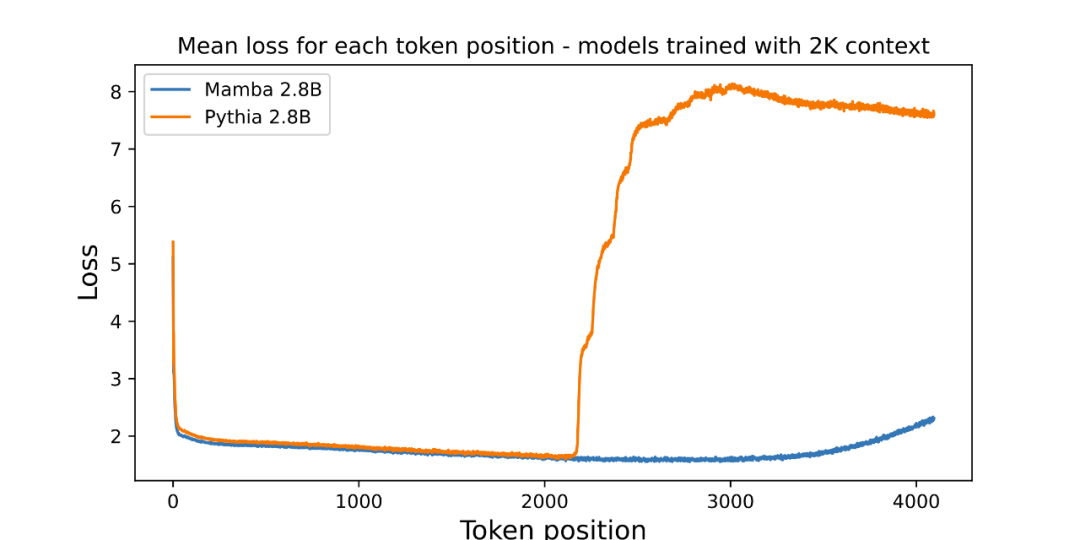

- #トレーニング長を超える長さの外挿結果を示します

- #著者は、事前トレーニングされた 3B パラメーター言語モデルの長さの外挿を評価するための画像を添付しました:

画像位置ごとの平均損失 (対数の可読性) が にプロットされています。最初のトークンにはコンテキストがないため、混乱度は高くなりますが、Mamba とベースライン Transformer (Pythia) の両方の混乱度は、コンテキストの長さ (2048) でトレーニングする前に増加します。興味深いことに、Mamba の可解決性は、トレーニング コンテキストを超えて、最大約 3000 の長さまで大幅に向上します。

画像位置ごとの平均損失 (対数の可読性) が にプロットされています。最初のトークンにはコンテキストがないため、混乱度は高くなりますが、Mamba とベースライン Transformer (Pythia) の両方の混乱度は、コンテキストの長さ (2048) でトレーニングする前に増加します。興味深いことに、Mamba の可解決性は、トレーニング コンテキストを超えて、最大約 3000 の長さまで大幅に向上します。

著者は、長さの外挿がこの記事のモデルの直接的な動機ではなく、追加の機能として扱っていることを強調しています。

ここでのベースライン モデル (Pythia) は長さの外挿を念頭に置いてトレーニングされていないため、より一般的な他の Transformer バリアント (T5 や Alibi 相対位置エンコーディングなど) が存在する可能性があります。相対位置エンコーディングを使用して Pile でトレーニングされたオープン ソース 3B モデルが見つからないため、この比較はできません。

- Mamba は、Pythia と同様、トレーニング時に長さの外挿を考慮しないため、比較できません。 Transformer には、長さ一般化アイソメトリックの能力を向上させるための多くのテクニック (さまざまな位置埋め込みなど) があるのと同じように、将来の研究では、同様の機能のための SSM 固有のテクニックを導き出すことが興味深いかもしれません。

- WikiText-103 から新しい結果を追加

- 著者は複数の論文の結果を分析しました。 Mamba が WikiText-103 上で、他の 20 以上の最先端の二次二次シーケンス モデルよりも大幅に優れたパフォーマンスを発揮することを示しています。

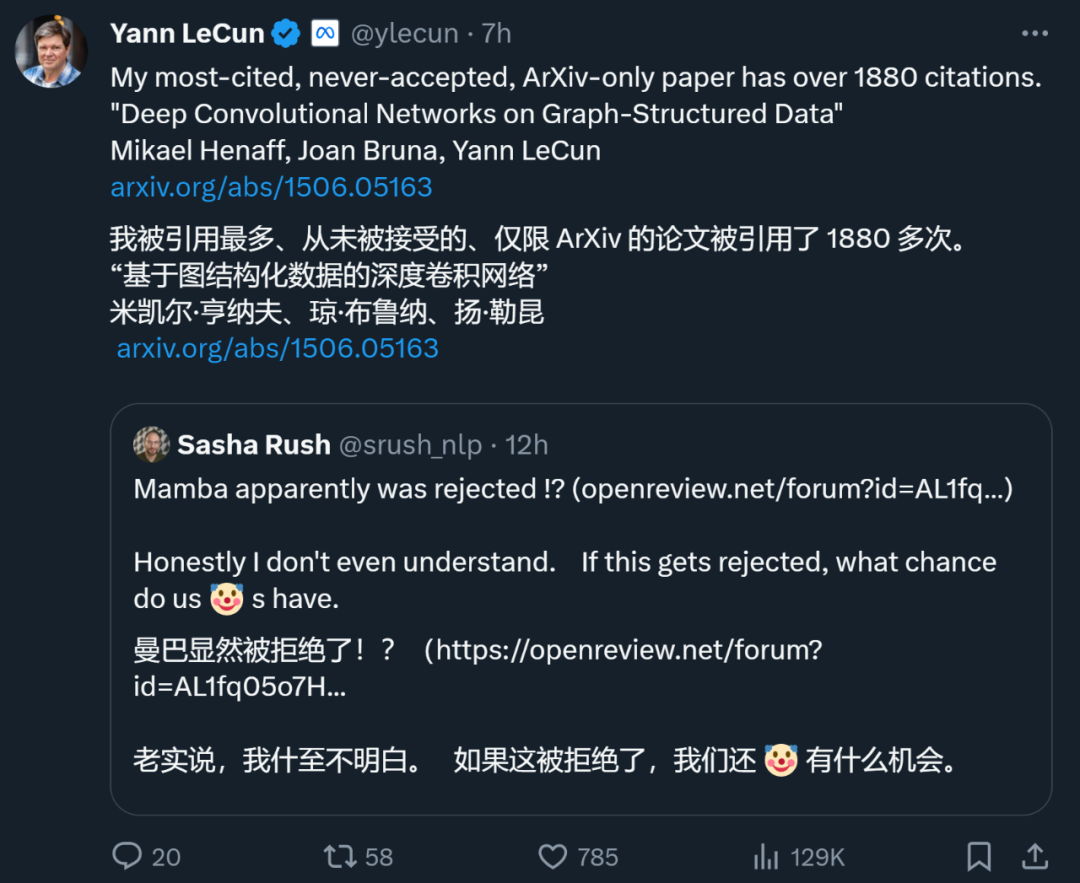

トップカンファレンスで拒否された論文

主要な AI トップカンファレンスでは、「投稿数の爆発的増加」が頭の痛い問題であるため、査読者のエネルギーは必然的に限られます。間違い。これにより、YOLO、transformer XL、Dropout、サポート ベクター マシン (SVM)、知識蒸留、SIFT、Google 検索エンジンの Web ページ ランキング アルゴリズム PageRank など、歴史上の多くの有名な論文が拒否されることになりました (「有名な YOLO と PageRank」を参照)影響力のある研究が最高の CS 会議によって拒否されました。」)

ディープラーニングの三大巨頭の一人であるヤン・ルカン氏ですら、断られることの多い大手製紙メーカーでもあります。たった今、同氏は、1887回引用されている論文「グラフ構造データに関する深層畳み込みネットワーク」もトップカンファレンスで拒否されたとツイートした。

ICML 2022 の期間中、彼は「3 つの論文を投稿し、3 つが拒否された」ことさえありました。

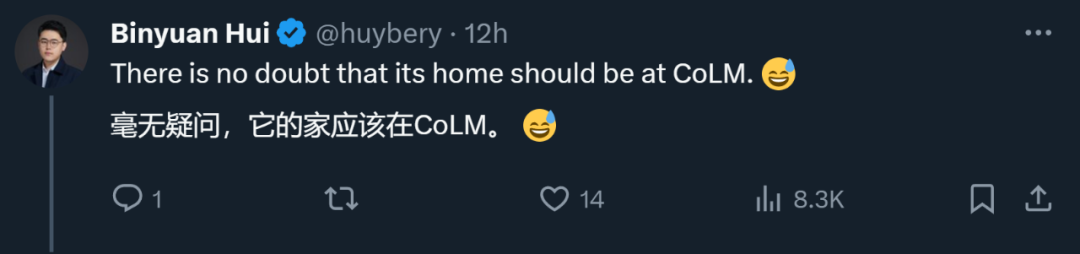

したがって、論文がトップカンファレンスで拒否されたからといって、その論文に価値がないというわけではありません。上記で拒否された論文の中には、他の学会への移籍を選択した論文も多く、最終的には採択されました。そのため、ネチズンはマンバに対し、陳丹祁などの若い学者が設立したCOLMに切り替えるよう提案した。 COLM は言語モデリング研究に特化した学術会場であり、言語モデル テクノロジの開発の理解、改善、コメントに重点を置いており、Mamba のような論文にはより良い選択となる可能性があります。

しかし、Mamba が最終的に ICLR に受け入れられるかどうかに関係なく、Mamba は影響力のある作品となり、コミュニティに突破口を見せることができました。のトランスフォーマー シャックルは、従来のトランスフォーマー モデルを超えた探求に新たな活力を注入しました。

以上がなぜ ICLR はマンバの論文を受け入れなかったのでしょうか? AIコミュニティが大きな議論を巻き起こしたの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

Video Face Swap

完全無料の AI 顔交換ツールを使用して、あらゆるビデオの顔を簡単に交換できます。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7744

7744

15

15

1643

1643

14

14

1397

1397

52

52

1291

1291

25

25

1234

1234

29

29

WorldCoin(WLD)価格予測2025-2031:WLDは2031年までに4ドルに達しますか?

Apr 21, 2025 pm 02:42 PM

WorldCoin(WLD)価格予測2025-2031:WLDは2031年までに4ドルに達しますか?

Apr 21, 2025 pm 02:42 PM

WorldCoin(WLD)は、独自の生体認証とプライバシー保護メカニズムを備えた暗号通貨市場で際立っており、多くの投資家の注目を集めています。 WLDは、特にOpenai人工知能技術と組み合わせて、革新的なテクノロジーを備えたAltcoinsの間で驚くほど演奏しています。しかし、デジタル資産は今後数年間でどのように振る舞いますか? WLDの将来の価格を一緒に予測しましょう。 2025年のWLD価格予測は、2025年にWLDで大幅に増加すると予想されています。市場分析は、平均WLD価格が1.31ドルに達する可能性があり、最大1.36ドルであることを示しています。ただし、クマ市場では、価格は約0.55ドルに低下する可能性があります。この成長の期待は、主にWorldCoin2によるものです。

クロスチェーントランザクションとはどういう意味ですか?クロスチェーントランザクションとは何ですか?

Apr 21, 2025 pm 11:39 PM

クロスチェーントランザクションとはどういう意味ですか?クロスチェーントランザクションとは何ですか?

Apr 21, 2025 pm 11:39 PM

クロスチェーントランザクションをサポートする交換:1。Binance、2。Uniswap、3。Sushiswap、4。CurveFinance、5。Thorchain、6。1inchExchange、7。DLNTrade、これらのプラットフォームはさまざまな技術を通じてマルチチェーン資産トランザクションをサポートします。

なぜ仮想通貨価格の上昇または下落があるのですか?なぜ仮想通貨価格の上昇または下落があるのですか?

Apr 21, 2025 am 08:57 AM

なぜ仮想通貨価格の上昇または下落があるのですか?なぜ仮想通貨価格の上昇または下落があるのですか?

Apr 21, 2025 am 08:57 AM

仮想通貨価格の上昇の要因には、次のものが含まれます。1。市場需要の増加、2。供給の減少、3。刺激された肯定的なニュース、4。楽観的な市場感情、5。マクロ経済環境。衰退要因は次のとおりです。1。市場需要の減少、2。供給の増加、3。ネガティブニュースのストライキ、4。悲観的市場感情、5。マクロ経済環境。

ハイブリッドブロックチェーン取引プラットフォームとは何ですか?

Apr 21, 2025 pm 11:36 PM

ハイブリッドブロックチェーン取引プラットフォームとは何ですか?

Apr 21, 2025 pm 11:36 PM

暗号通貨交換を選択するための提案:1。流動性の要件については、優先度は、その順序の深さと強力なボラティリティ抵抗のため、Binance、gate.ioまたはokxです。 2。コンプライアンスとセキュリティ、Coinbase、Kraken、Geminiには厳格な規制の承認があります。 3.革新的な機能、Kucoinのソフトステーキング、Bybitのデリバティブデザインは、上級ユーザーに適しています。

カーネルエアドロップ報酬を獲得する方法バイナンスフルプロセス戦略

Apr 21, 2025 pm 01:03 PM

カーネルエアドロップ報酬を獲得する方法バイナンスフルプロセス戦略

Apr 21, 2025 pm 01:03 PM

暗号通貨の賑やかな世界では、新しい機会が常に現れます。現在、Kerneldao(Kernel)Airdropアクティビティは多くの注目を集め、多くの投資家の注目を集めています。それで、このプロジェクトの起源は何ですか? BNBホルダーはそれからどのような利点を得ることができますか?心配しないでください、以下はあなたのためにそれを一つ一つ明らかにします。

Aavenomicsは、Aaveプロトコルトークンを変更し、Tokenの買戻しを導入するための推奨事項です。

Apr 21, 2025 pm 06:24 PM

Aavenomicsは、Aaveプロトコルトークンを変更し、Tokenの買戻しを導入するための推奨事項です。

Apr 21, 2025 pm 06:24 PM

Aavenomicsは、Aaveプロトコルトークンを変更し、Aavedaoの定足数を実装したToken Reposを導入する提案です。 Aave Project Chain(ACI)の創設者であるMarc Zellerは、これをXで発表し、契約の新しい時代をマークしていることに注目しました。 Aave Chain Initiative(ACI)の創設者であるMarc Zellerは、Aavenomicsの提案にAave Protocolトークンの変更とトークンリポジトリの導入が含まれていると発表しました。 Zellerによると、これは契約の新しい時代を告げています。 Aavedaoのメンバーは、水曜日の週に100でした。

ビットコイン完成品構造の分析チャートは何ですか?描く方法は?

Apr 21, 2025 pm 07:42 PM

ビットコイン完成品構造の分析チャートは何ですか?描く方法は?

Apr 21, 2025 pm 07:42 PM

ビットコイン構造分析チャートを描画する手順には、次のものが含まれます。1。図面の目的と視聴者を決定します。2。適切なツールを選択します。3。フレームワークを設計し、コアコンポーネントを入力します。4。既存のテンプレートを参照してください。完全な手順チャートが正確で理解しやすいことを確認してください。

通貨サークル市場に関するリアルタイムデータの上位10の無料プラットフォーム推奨事項がリリースされます

Apr 22, 2025 am 08:12 AM

通貨サークル市場に関するリアルタイムデータの上位10の無料プラットフォーム推奨事項がリリースされます

Apr 22, 2025 am 08:12 AM

初心者に適した暗号通貨データプラットフォームには、Coinmarketcapと非小さいトランペットが含まれます。 1。CoinMarketCapは、初心者と基本的な分析のニーズに合わせて、グローバルなリアルタイム価格、市場価値、取引量のランキングを提供します。 2。小さい引用は、中国のユーザーが低リスクの潜在的なプロジェクトをすばやくスクリーニングするのに適した中国フレンドリーなインターフェイスを提供します。