Flume と Kafka: データ フローの処理にはどちらのツールが適していますか?

Flume と Kafka: データ ストリーム処理にはどちらのツールが適していますか?

概要

Flume と Kafka はどちらも、大量のリアルタイム データを収集、集約、送信するための人気のあるデータ ストリーム処理ツールです。どちらも高スループット、低遅延、信頼性という特徴がありますが、機能、アーキテクチャ、および適用可能なシナリオにいくつかの違いがあります。

Flume

Flume は、分散型で信頼性が高く可用性の高いデータ収集、集約、送信システムです。さまざまなソースからデータを収集し、HDFS、HBase、またはその他のストレージ システムに保存できます。 。 Flume は、以下を含む複数のコンポーネントで構成されます。

- エージェント: Flume エージェントは、データ ソースからデータを収集する役割を果たします。

- チャネル: Flume チャネルは、データの保存とバッファリングを担当します。

- シンク: Flume シンクは、ストレージ システムへのデータの書き込みを担当します。

Flume の利点は次のとおりです:

- 使いやすさ: Flume はユーザーフレンドリーなインターフェイスとシンプルな構成を備えているため、インストールとインストールが簡単です。使用。

- 高スループット: Flume は大量のデータを処理できるため、ビッグ データ処理シナリオに適しています。

- 信頼性: Flume には、データが失われないことを保証する信頼性の高いデータ送信メカニズムがあります。

Flume の欠点は次のとおりです:

- 低レイテンシ: Flume はレイテンシが高く、リアルタイムの処理が必要なシナリオには適していません。データ。

- スケーラビリティ: Flume のスケーラビリティは限られており、大量のデータの処理が必要なシナリオには適していません。

Kafka

Kafka は、大量のリアルタイム データを保存および処理できる、スケーラブルでフォールトトレラントな分散型メッセージング システムです。 Kafka は、次のような複数のコンポーネントで構成されます。

- ブローカー: Kafka ブローカーは、データの保存と管理を担当します。

- トピック: Kafka トピックは論理データ パーティションであり、複数のパーティションを含めることができます。

- パーティション: Kafka パーティションは、一定量のデータを保存できる物理データ ストレージ ユニットです。

- コンシューマ: Kafka コンシューマは、Kafka トピックからのデータを消費する責任があります。

Kafka の利点は次のとおりです:

- 高スループット: Kafka は大量のデータを処理できるため、ビッグ データ処理シナリオに適しています。

- 低遅延: Kafka は低遅延であるため、リアルタイムのデータ処理が必要なシナリオに適しています。

- スケーラビリティ: Kafka は優れたスケーラビリティを備えているため、より多くのデータを処理するために簡単に拡張できます。

Kafka の欠点は次のとおりです:

- 複雑さ: Kafka の構成と管理は比較的複雑であり、一定の技術的経験が必要です。

- 信頼性: Kafka のデータ ストレージ メカニズムは信頼性が低く、データが失われる可能性があります。

適用可能なシナリオ

Flume と Kafka はどちらもビッグ データ処理シナリオに適していますが、適用可能な具体的なシナリオには違いがあります。

Flume は次のシナリオに適しています:

- さまざまなソースからデータを収集および集約する必要がある。

- データを HDFS、HBase、またはその他のストレージ システムに保存する必要があります。

- 単純なデータの処理と変換が必要です。

Kafka は次のシナリオに適しています:

- 大量のリアルタイム データを処理する必要がある。

- データの複雑な処理と分析が必要です。

- データは分散ファイル システムに保存する必要があります。

コード例

Flume

# 创建一个Flume代理 agent1.sources = r1 agent1.sinks = hdfs agent1.channels = c1 # 配置数据源 r1.type = exec r1.command = tail -F /var/log/messages # 配置数据通道 c1.type = memory c1.capacity = 1000 c1.transactionCapacity = 100 # 配置数据汇 hdfs.type = hdfs hdfs.hdfsUrl = hdfs://localhost:9000 hdfs.fileName = /flume/logs hdfs.rollInterval = 3600 hdfs.rollSize = 10485760

Kafka

# 创建一个Kafka主题 kafka-topics --create --topic my-topic --partitions 3 --replication-factor 2 # 启动一个Kafka代理 kafka-server-start config/server.properties # 启动一个Kafka生产者 kafka-console-producer --topic my-topic # 启动一个Kafka消费者 kafka-console-consumer --topic my-topic --from-beginning

結論

Flume と Kafka はどちらも人気のあるデータ ストリーム処理ツールです機能、アーキテクチャ、適用可能なシナリオが異なります。選択するときは、特定のニーズを評価する必要があります。

以上がFlume と Kafka: データ フローの処理にはどちらのツールが適していますか?の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7554

7554

15

15

1382

1382

52

52

83

83

11

11

24

24

96

96

PHP と Kafka を使用してリアルタイム株価分析を実装する方法

Jun 28, 2023 am 10:04 AM

PHP と Kafka を使用してリアルタイム株価分析を実装する方法

Jun 28, 2023 am 10:04 AM

インターネットとテクノロジーの発展に伴い、デジタル投資への関心が高まっています。多くの投資家は、より高い投資収益率を得ることを期待して、投資戦略を模索し、研究し続けています。株式取引では、リアルタイムの株式分析が意思決定に非常に重要であり、Kafka のリアルタイム メッセージ キューと PHP テクノロジの使用は効率的かつ実用的な手段です。 1. Kafka の概要 Kafka は、LinkedIn によって開発された高スループットの分散型パブリッシュおよびサブスクライブ メッセージング システムです。 Kafka の主な機能は次のとおりです。

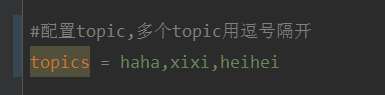

springboot+kafka で @KafkaListener を使用して複数のトピックを動的に指定する方法

May 20, 2023 pm 08:58 PM

springboot+kafka で @KafkaListener を使用して複数のトピックを動的に指定する方法

May 20, 2023 pm 08:58 PM

このプロジェクトは springboot+kafak 統合プロジェクトであるため、springboot で kafak 消費アノテーション @KafkaListener を使用していることを説明し、まず application.properties でカンマで区切られた複数のトピックを設定します。方法: Spring の SpEl 式を使用してトピックを次のように構成します: @KafkaListener(topics="#{’${topics}’.split(’,’)}") プログラムを実行します。コンソールの印刷効果は次のとおりです。

React と Apache Kafka を使用してリアルタイム データ処理アプリケーションを構築する方法

Sep 27, 2023 pm 02:25 PM

React と Apache Kafka を使用してリアルタイム データ処理アプリケーションを構築する方法

Sep 27, 2023 pm 02:25 PM

React と Apache Kafka を使用してリアルタイム データ処理アプリケーションを構築する方法 はじめに: ビッグ データとリアルタイム データ処理の台頭により、リアルタイム データ処理アプリケーションの構築が多くの開発者の追求となっています。人気のあるフロントエンド フレームワークである React と、高性能分散メッセージング システムである Apache Kafka を組み合わせることで、リアルタイム データ処理アプリケーションを構築できます。この記事では、React と Apache Kafka を使用してリアルタイム データ処理アプリケーションを構築する方法を紹介します。

Kafkaを探索するための可視化ツール5選

Feb 01, 2024 am 08:03 AM

Kafkaを探索するための可視化ツール5選

Feb 01, 2024 am 08:03 AM

Kafka 視覚化ツールの 5 つのオプション ApacheKafka は、大量のリアルタイム データを処理できる分散ストリーム処理プラットフォームです。これは、リアルタイム データ パイプライン、メッセージ キュー、イベント駆動型アプリケーションの構築に広く使用されています。 Kafka の視覚化ツールは、ユーザーが Kafka クラスターを監視および管理し、Kafka データ フローをより深く理解するのに役立ちます。以下は、5 つの人気のある Kafka 視覚化ツールの紹介です。 ConfluentControlCenterConfluent

Kafka 視覚化ツールの比較分析: 最適なツールを選択するには?

Jan 05, 2024 pm 12:15 PM

Kafka 視覚化ツールの比較分析: 最適なツールを選択するには?

Jan 05, 2024 pm 12:15 PM

適切な Kafka 視覚化ツールを選択するにはどうすればよいですか? 5 つのツールの比較分析 はじめに: Kafka は、ビッグ データの分野で広く使用されている、高性能、高スループットの分散メッセージ キュー システムです。 Kafka の人気に伴い、Kafka クラスターを簡単に監視および管理するためのビジュアル ツールを必要とする企業や開発者が増えています。この記事では、読者がニーズに合ったツールを選択できるように、一般的に使用される 5 つの Kafka 視覚化ツールを紹介し、その特徴と機能を比較します。 1.カフカマネージャー

複数のkafkaを構成するspringbootプロジェクトのサンプルコード

May 14, 2023 pm 12:28 PM

複数のkafkaを構成するspringbootプロジェクトのサンプルコード

May 14, 2023 pm 12:28 PM

1.spring-kafkaorg.springframework.kafkaspring-kafka1.3.5.RELEASE2. 設定ファイル関連情報 kafka.bootstrap-servers=localhost:9092kafka.consumer.group.id=20230321#同時に消費できるスレッドの数 (通常は一貫しています)パーティションの数で) kafka.consumer.concurrency=10kafka.consumer.enable.auto.commit=falsekafka.boo

go-zero と Kafka+Avro の実践: 高性能対話型データ処理システムの構築

Jun 23, 2023 am 09:04 AM

go-zero と Kafka+Avro の実践: 高性能対話型データ処理システムの構築

Jun 23, 2023 am 09:04 AM

近年、ビッグ データと活発なオープン ソース コミュニティの台頭により、ますます多くの企業が増大するデータ ニーズを満たすために高性能の対話型データ処理システムを探し始めています。このテクノロジー アップグレードの波の中で、go-zero と Kafka+Avro はますます多くの企業に注目され、採用されています。 go-zero は、Golang 言語をベースに開発されたマイクロサービス フレームワークで、高いパフォーマンス、使いやすさ、拡張の容易さ、メンテナンスの容易さという特徴を備えており、企業が効率的なマイクロサービス アプリケーション システムを迅速に構築できるように設計されています。その急速な成長

Rocky Linux に Apache Kafka をインストールするにはどうすればよいですか?

Mar 01, 2024 pm 10:37 PM

Rocky Linux に Apache Kafka をインストールするにはどうすればよいですか?

Mar 01, 2024 pm 10:37 PM

RockyLinux に ApacheKafka をインストールするには、次の手順に従います。 システムの更新: まず、RockyLinux システムが最新であることを確認し、次のコマンドを実行してシステム パッケージを更新します: sudoyumupdate Java のインストール: ApacheKafka は Java に依存しているため、最初に JavaDevelopmentKit (JDK) をインストールします)。 OpenJDK は、次のコマンドを使用してインストールできます。 sudoyuminstalljava-1.8.0-openjdk-devel ダウンロードして解凍します。 ApacheKafka 公式 Web サイト () にアクセスして、最新のバイナリ パッケージをダウンロードします。安定したバージョンを選択してください