ゼロから始める: Kafka 統合環境を迅速に構築するための Springboot ガイド

Springboot Integrated Kafka の概要

Apache Kafka は、非常に高いスループットでデータを生成、消費、保存できる分散ストリーミング サービスです。これは、ログ集約、メトリック収集、監視、トランザクション データ パイプラインなどのさまざまなアプリケーションを構築するために広く使用されています。

Springboot は、Spring アプリケーション開発を簡素化するためのフレームワークです。これは、Kafka を Spring アプリケーションに簡単に統合するための、すぐに使用できる自動配線と規約を提供します。

Kafka が Springboot を統合するために必要な環境を構築する

1. Apache Kafka をインストールする

- Apache Kafka ディストリビューションをダウンロードします。

- ディストリビューションを解凍し、Kafka サービスを開始します。

- Kafka サービス ログをチェックして、正常に実行されていることを確認します。

2. Springboot のインストール

- Springboot ディストリビューションをダウンロードします。

- ディストリビューションを抽出し、システムのパスに追加します。

- Springboot アプリケーションを作成します。

コード例

1. Springboot アプリケーションの作成

public class SpringbootKafkaApplication {

public static void main(String[] args) {

SpringApplication.run(SpringbootKafkaApplication.class, args);

}

}2. Kafka 依存関係の追加

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-kafka</artifactId>

</dependency>3. Kafka プロデューサーの構成

@Bean

public ProducerFactory<String, String> senderFactory() {

Map<String, Object> config = new LinkedHashMap<>();

config.put(ProducerConfig.BOOTSTRAP_ certification_URL_setConfig, "kafka://127.0.0.1:9092");

config.put(ProducerConfig.KEY_SERIALIZER_setClass_Config, StringDeserializer.class);

config.put(ProducerConfig.KEY_SERIALIZER_setClass_Config, StringDeserializer.class);

return new SimpleKafkaProducerFactory<>(config);

}4. Kafka コンシューマーの構成

@Bean

public ConcurrentKafkaListenerContainerFactory<String, String> kafkaListenerContainerFactory() {

ConcurrentKafkaListenerContainerFactory<String, String> factory = new ConcurrentKafkaListenerContainerFactory<>();

factory.setBrokerAddresses("127.0.0.1:9092");

factory.setKeyDeserializer(new StringDeserializer());

factory.setKeyDeserializer(new StringDeserializer());

return factory;

}5. Kafka プロデューサー サービスの作成

@Service

public class ProducerService {

@Autowired

private KafkaTemplate<String, String> kafkaTemplate;

public void sendMessage(String message) {

kafkaTemplate.send("test-kafka", message);

}

}6. Kafka コンシューマー サービスの作成

@Service

public class ReceiverService {

@KafkaListener(topics = "test-kafka", id = "kafka-consumer-1")

public void receiveMessage(String message) {

System.out.println("Message received: " + message);

}

}Test

- Kafka サービスを開始します。

- Springboot アプリケーションを開始します。

- ProducerService を使用してメッセージを送信します。

- Kafka サービス ログをチェックして、情報が正しく受信されていることを確認します。

- Springboot アプリケーション ログをチェックして、情報が正しく消費されていることを確認します。

概要

この記事では、Springboot を使用して Kafka を Spring アプリケーションに統合する方法を説明します。まずKafkaとSpringbootの概要を説明し、KafkaがSpringbootを統合するために必要な環境の構築方法について説明しました。次に、Springboot を使用して Kafka 情報を生成および消費する方法を示す、詳細な Springboot アプリケーションの例を示します。

以上がゼロから始める: Kafka 統合環境を迅速に構築するための Springboot ガイドの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7478

7478

15

15

1377

1377

52

52

77

77

11

11

19

19

33

33

springboot+kafka で @KafkaListener を使用して複数のトピックを動的に指定する方法

May 20, 2023 pm 08:58 PM

springboot+kafka で @KafkaListener を使用して複数のトピックを動的に指定する方法

May 20, 2023 pm 08:58 PM

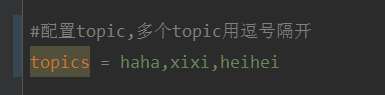

このプロジェクトは springboot+kafak 統合プロジェクトであるため、springboot で kafak 消費アノテーション @KafkaListener を使用していることを説明し、まず application.properties でカンマで区切られた複数のトピックを設定します。方法: Spring の SpEl 式を使用してトピックを次のように構成します: @KafkaListener(topics="#{’${topics}’.split(’,’)}") プログラムを実行します。コンソールの印刷効果は次のとおりです。

PHP と Kafka を使用してリアルタイム株価分析を実装する方法

Jun 28, 2023 am 10:04 AM

PHP と Kafka を使用してリアルタイム株価分析を実装する方法

Jun 28, 2023 am 10:04 AM

インターネットとテクノロジーの発展に伴い、デジタル投資への関心が高まっています。多くの投資家は、より高い投資収益率を得ることを期待して、投資戦略を模索し、研究し続けています。株式取引では、リアルタイムの株式分析が意思決定に非常に重要であり、Kafka のリアルタイム メッセージ キューと PHP テクノロジの使用は効率的かつ実用的な手段です。 1. Kafka の概要 Kafka は、LinkedIn によって開発された高スループットの分散型パブリッシュおよびサブスクライブ メッセージング システムです。 Kafka の主な機能は次のとおりです。

SpringBoot が Kafka 構成ツール クラスを統合する方法

May 12, 2023 pm 09:58 PM

SpringBoot が Kafka 構成ツール クラスを統合する方法

May 12, 2023 pm 09:58 PM

spring-kafka は Java バージョンの kafkaclient と spring の統合に基づいています. 操作を容易にするためにさまざまなメソッドをカプセル化する KafkaTemplate を提供します. Apache の kafka-client をカプセル化しており、組織に依存するクライアントをインポートする必要はありません.springframework.kafkaspring-kafkaYML 設定.kafka:#bootstrap-servers:server1:9092,server2:9093#kafka 開発アドレス,#プロデューサー設定プロデューサー:#Kafka によって提供されるシリアル化および逆シリアル化クラス キー

Kafkaを探索するための可視化ツール5選

Feb 01, 2024 am 08:03 AM

Kafkaを探索するための可視化ツール5選

Feb 01, 2024 am 08:03 AM

Kafka 視覚化ツールの 5 つのオプション ApacheKafka は、大量のリアルタイム データを処理できる分散ストリーム処理プラットフォームです。これは、リアルタイム データ パイプライン、メッセージ キュー、イベント駆動型アプリケーションの構築に広く使用されています。 Kafka の視覚化ツールは、ユーザーが Kafka クラスターを監視および管理し、Kafka データ フローをより深く理解するのに役立ちます。以下は、5 つの人気のある Kafka 視覚化ツールの紹介です。 ConfluentControlCenterConfluent

React と Apache Kafka を使用してリアルタイム データ処理アプリケーションを構築する方法

Sep 27, 2023 pm 02:25 PM

React と Apache Kafka を使用してリアルタイム データ処理アプリケーションを構築する方法

Sep 27, 2023 pm 02:25 PM

React と Apache Kafka を使用してリアルタイム データ処理アプリケーションを構築する方法 はじめに: ビッグ データとリアルタイム データ処理の台頭により、リアルタイム データ処理アプリケーションの構築が多くの開発者の追求となっています。人気のあるフロントエンド フレームワークである React と、高性能分散メッセージング システムである Apache Kafka を組み合わせることで、リアルタイム データ処理アプリケーションを構築できます。この記事では、React と Apache Kafka を使用してリアルタイム データ処理アプリケーションを構築する方法を紹介します。

Kafka 視覚化ツールの比較分析: 最適なツールを選択するには?

Jan 05, 2024 pm 12:15 PM

Kafka 視覚化ツールの比較分析: 最適なツールを選択するには?

Jan 05, 2024 pm 12:15 PM

適切な Kafka 視覚化ツールを選択するにはどうすればよいですか? 5 つのツールの比較分析 はじめに: Kafka は、ビッグ データの分野で広く使用されている、高性能、高スループットの分散メッセージ キュー システムです。 Kafka の人気に伴い、Kafka クラスターを簡単に監視および管理するためのビジュアル ツールを必要とする企業や開発者が増えています。この記事では、読者がニーズに合ったツールを選択できるように、一般的に使用される 5 つの Kafka 視覚化ツールを紹介し、その特徴と機能を比較します。 1.カフカマネージャー

複数のkafkaを構成するspringbootプロジェクトのサンプルコード

May 14, 2023 pm 12:28 PM

複数のkafkaを構成するspringbootプロジェクトのサンプルコード

May 14, 2023 pm 12:28 PM

1.spring-kafkaorg.springframework.kafkaspring-kafka1.3.5.RELEASE2. 設定ファイル関連情報 kafka.bootstrap-servers=localhost:9092kafka.consumer.group.id=20230321#同時に消費できるスレッドの数 (通常は一貫しています)パーティションの数で) kafka.consumer.concurrency=10kafka.consumer.enable.auto.commit=falsekafka.boo

Rocky Linux に Apache Kafka をインストールするにはどうすればよいですか?

Mar 01, 2024 pm 10:37 PM

Rocky Linux に Apache Kafka をインストールするにはどうすればよいですか?

Mar 01, 2024 pm 10:37 PM

RockyLinux に ApacheKafka をインストールするには、次の手順に従います。 システムの更新: まず、RockyLinux システムが最新であることを確認し、次のコマンドを実行してシステム パッケージを更新します: sudoyumupdate Java のインストール: ApacheKafka は Java に依存しているため、最初に JavaDevelopmentKit (JDK) をインストールします)。 OpenJDK は、次のコマンドを使用してインストールできます。 sudoyuminstalljava-1.8.0-openjdk-devel ダウンロードして解凍します。 ApacheKafka 公式 Web サイト () にアクセスして、最新のバイナリ パッケージをダウンロードします。安定したバージョンを選択してください