2 月 8 日のニュース: Microsoft の台頭と比較すると、Apple の AI 分野での配置はかなり控えめに見えますが、これは Apple が世界のトップに立っているという意味ではありません。その分野での実績はありません。 Apple は最近、自然言語命令に基づいて画像を編集できる「MGIE」と呼ばれる新しいオープンソース人工知能モデルをリリースしました。

出典: VentureBeat Midjourney との共同制作

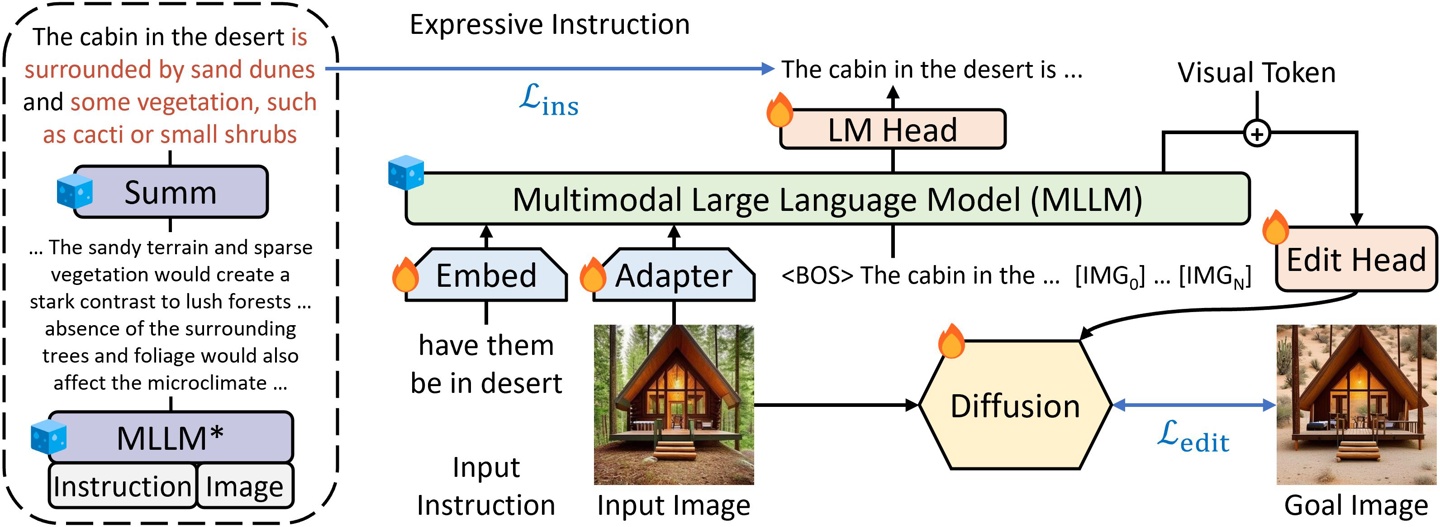

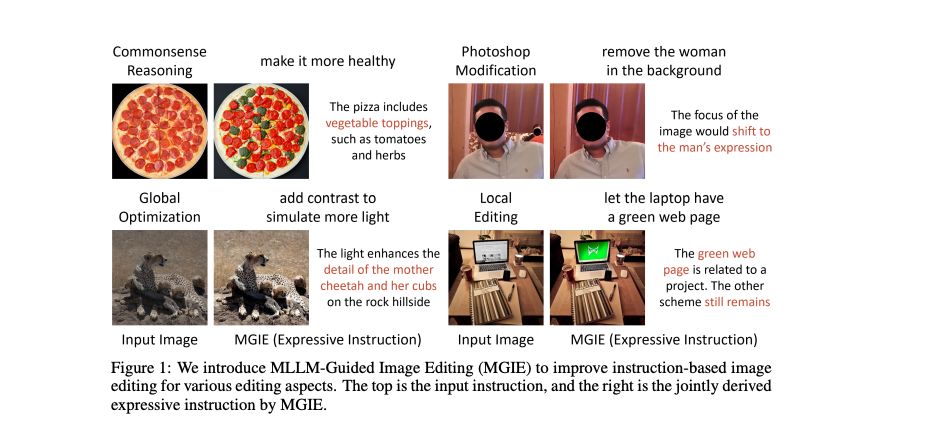

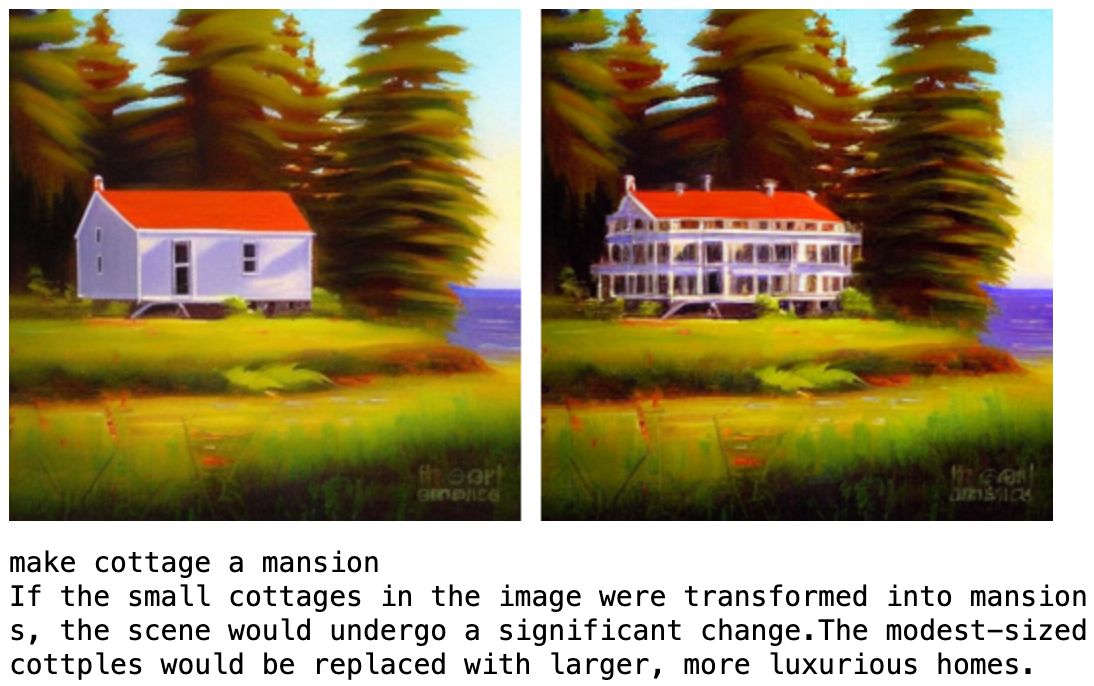

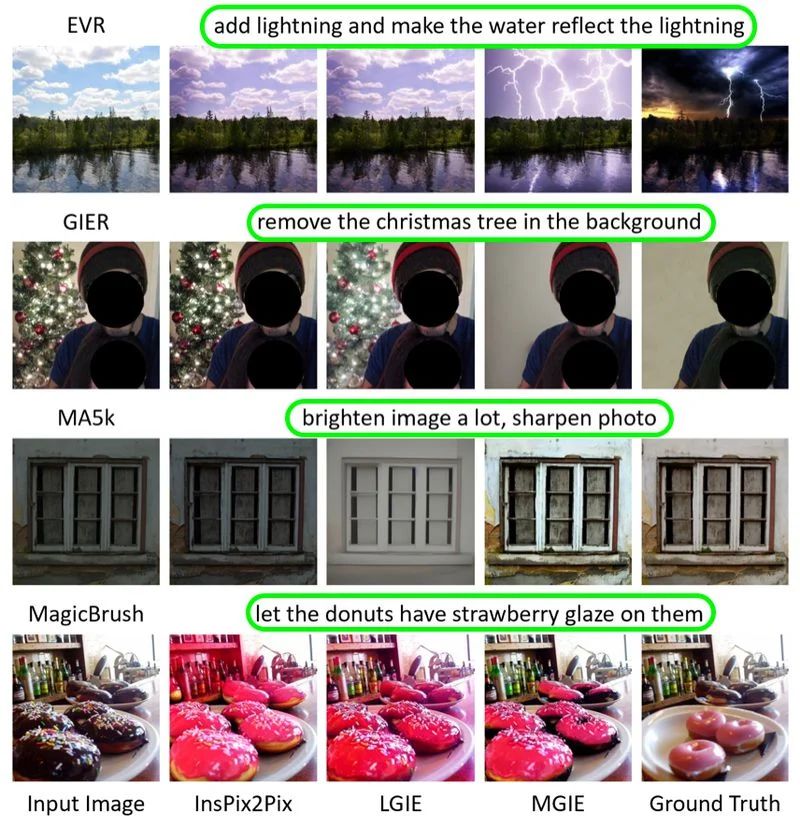

MGIE (MLLM ガイド付き画像編集) はマルチモーダル エクスプロイトですLarge Language Model (MLLM) は、ユーザーの指示を解釈し、ピクセルレベルの操作を実行するテクノロジーです。ユーザーの自然言語コマンドを理解し、Photoshop のような変更、グローバルな写真の最適化、ローカル編集を実行できます。 MGIE を使用すると、複雑な画像処理ソフトウェアに詳しくなくても、写真に対してさまざまな編集を簡単に実行できます。このテクノロジーは、画像編集プロセスを簡素化すると同時に、より直感的で効率的な編集方法を提供します。

Apple は、カリフォルニア大学サンタバーバラ校の研究者と共同で、2024 年の学習表現国際会議 (ICLR) で MGIE に関連する研究結果を発表しました。 ICLR は、人工知能研究の分野で最も重要な会議の 1 つです。

MGIE を紹介する前に、このサイトでは MLLM (Multimodal Language Learning Model) について簡単に紹介します。 MLLM は、テキストと画像を同時に処理できるという点でユニークな強力な人工知能モデルであり、それによって命令ベースの画像編集機能が強化されます。 MLLM は、クロスモーダルな理解と視覚的知覚応答の生成において優れた機能を示していますが、画像編集タスクではまだ広く使用されていません。

MGIE は、2 つの方法で MLLM を画像編集プロセスに統合します。まず、MLLM を活用して、ユーザー入力から正確で表現力豊かな指示を導き出します。これらの手順は簡潔かつ明確であり、編集プロセスに明確なガイダンスを提供します。

たとえば、「空を青くする 」と入力すると、MGIE は「空の領域の彩度を 20% 増やす 」というコマンドを生成できます。

第 2 に、MLLM を使用して視覚的な想像力、つまり目的の編集を表現できる可能性を生成します。この表現は編集の本質を捉えており、ピクセルレベルの操作をガイドするために使用できます。 MGIE は、命令導出、視覚的想像力、および画像編集モジュールを共同で最適化する、新しいエンドツーエンドのトレーニング スキームを採用しています。

#MGIE は、単純な色の調整から複雑なオブジェクトの操作まで、さまざまな編集状況に対応できます。モデルは、ユーザーの好みに基づいてグローバルおよびローカル編集を実行することもできます。 MGIE の機能には次のようなものがあります。

MGIE は GitHub 上のオープン ソース プロジェクトです。ユーザーは ここ をクリックしてコード、データ、事前トレーニングされたモデルを見つけることができます。このプロジェクトでは、MGIE を使用してさまざまな編集タスクを完了する方法を示すデモ ノートブックも提供します。

以上がApple、一文で写真を洗練できる新しいAIモデルMGIEを披露の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。