ハードウェアチュートリアル

ハードウェアチュートリアル

ハードウェアニュース

ハードウェアニュース

NVIDIA が RTX HDR 機能を開始: サポートされていないゲームは AI フィルターを使用して HDR の豪華な視覚効果を実現します

NVIDIA が RTX HDR 機能を開始: サポートされていないゲームは AI フィルターを使用して HDR の豪華な視覚効果を実現します

NVIDIA が RTX HDR 機能を開始: サポートされていないゲームは AI フィルターを使用して HDR の豪華な視覚効果を実現します

このサイトからのニュース 2 月 23 日、NVIDIA は昨夜、NVIDIA アプリケーションを更新してリリースしました。これにより、プレーヤーに新しい統合 GPU コントロール センターが提供され、プレーヤーは、フローティング ウィンドウによって提供される強力な記録ツールを通じて素晴らしい瞬間をキャプチャできるようになります。ゲーム。

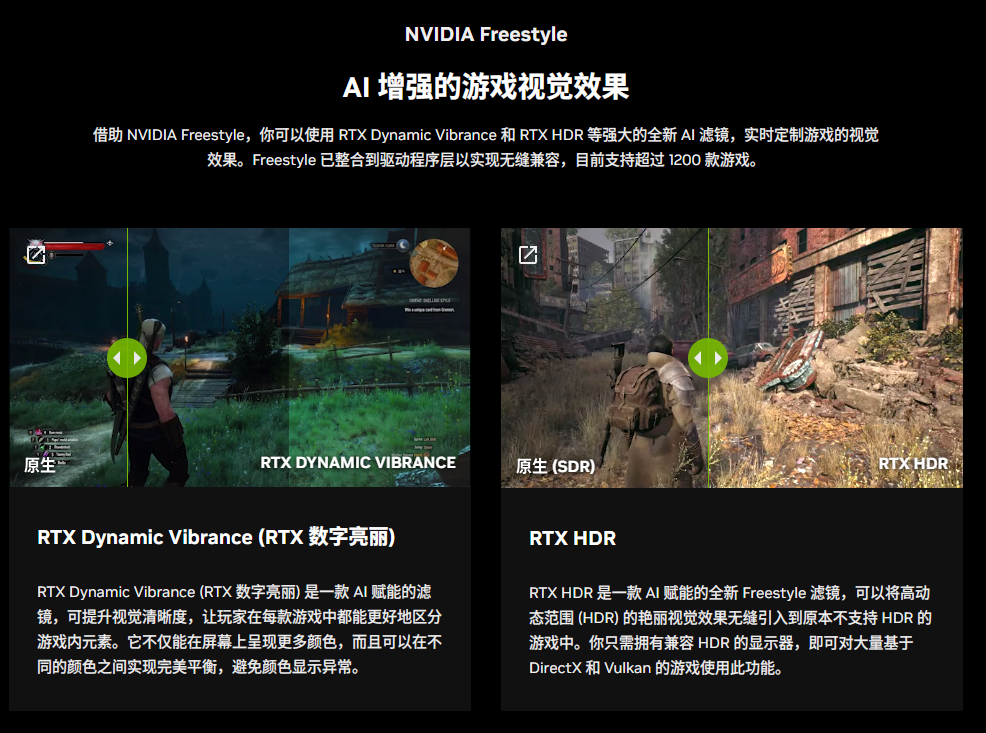

今回のアップデートでは、NVIDIA は RTX HDR 機能も導入しました。公式の紹介文は次のとおりこのサイトに添付されています:

RTX HDRこの新しい AI を活用したフリースタイル フィルターは、本来 HDR をサポートしていないゲームに、ハイ ダイナミック レンジ (HDR) のゴージャスな視覚効果をシームレスに導入できます。この機能をさまざまな DirectX および Vulkan ベースのゲームで使用するには、HDR 互換モニターが必要です。

RTX HDR 機能を有効にすると、HDR をサポートしていない場合でも、プレーヤーは HDR モードでゲームを実行できます。

Nvidia によると、GeForce グラフィックス カードで実行される最も人気のある 50 のゲームのうち、ハイ ダイナミック レンジ (HDR) をネイティブにサポートしているのは 10 のみです。

新しい RTX HDR 機能は、DirectX 9、DirectX 11、DirectX 12、Vulkan API に基づいた無数の SDR ゲームに HDR サポートを提供し、SDR コンテンツを即座に HDR に変換できます。

要件

RTX HDR のシステム要件には、Windows 11 オペレーティング システム (バージョン 22621 以降)、PC に接続された HDR 対応モニター、GeForce RTX 2000 シリーズ以降のバージョンのグラフィックス カード、およびドライバーのバージョン 551.52 以降。

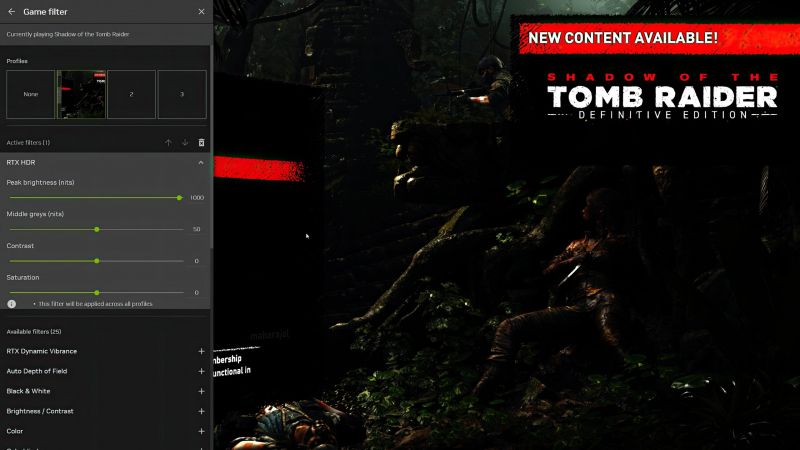

RTX HDR を使用する前に、ゲーム内の HDR 設定 (存在する場合) を無効にする必要があります。また、Windows 11 では Windows AutoHDR 機能を無効にする必要があります。RTX HDR が適切に動作するには、ゲームを全画面モードで起動する必要があります。

NVIDIA は、RTX HDR を使用する前に、Dynamic Super Resolution (DSR/DLDSR)、NVIDIA Image Scaling (NIS)、および Fast Sync を無効にする必要があることにも注意しています。すべての RTX HDR 設定は NVIDIA オーバーレイで構成されます。

RTX HDR 設定を以下に示します:

以上がNVIDIA が RTX HDR 機能を開始: サポートされていないゲームは AI フィルターを使用して HDR の豪華な視覚効果を実現しますの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7480

7480

15

15

1377

1377

52

52

77

77

11

11

19

19

33

33

スーパーピープル ゲームのダウンロードとインストール方法の紹介

Mar 30, 2024 pm 04:01 PM

スーパーピープル ゲームのダウンロードとインストール方法の紹介

Mar 30, 2024 pm 04:01 PM

superpeople ゲームは、steam クライアントを通じてダウンロードできます。このゲームのサイズは約 28G です。ダウンロードとインストールには通常 1 時間半かかります。ここでは、具体的なダウンロードとインストールのチュートリアルを紹介します。グローバルクローズドテストへの新しい申請方法 1) Steamストア(Steamクライアントダウンロード)で「SUPERPEOPLE」を検索 2) 「SUPERPEOPLE」ストアページ下部にある「SUPERPEOPLEクローズドテストへのアクセスをリクエスト」をクリック 3) request accessボタン、Steamライブラリで「SUPERPEOPLECBT」ゲームが確認できます 4)「SUPERPEOPLECBT」内のインストールボタンをクリックしてダウンロード

ASUS、Intelの第13/14世代プロセッサーでのゲームの安定性を向上させるBIOSアップデートをリリース

Apr 20, 2024 pm 05:01 PM

ASUS、Intelの第13/14世代プロセッサーでのゲームの安定性を向上させるBIOSアップデートをリリース

Apr 20, 2024 pm 05:01 PM

4月20日の当サイトのニュースによると、ASUSは最近、Intelの第13/14世代プロセッサでゲームを実行する際のクラッシュなどの不安定性を改善するBIOSアップデートをリリースしたとのこと。同サイトは以前、バンダイナムコの格闘ゲーム「鉄拳8」のPCデモ版を実行すると、コンピュータに十分なメモリとビデオメモリがある場合でもシステムがクラッシュし、メモリ不足を示すエラーメッセージが表示されるなどの問題がプレイヤーから報告されたと報告していた。同様のクラッシュの問題は、「バトルフィールド 2042」、「レムナント 2」、「フォートナイト」、「ロード オブ ザ フォールン」、「ホグワーツ レガシー」、「ザ ファイナル」などの多くのゲームでも発生しています。 RADは今年2月に長い記事を公開し、ゲームクラッシュの問題はBIOS設定、高いクロック周波数、Intelプロセッサの高い消費電力の組み合わせであると説明した。

NVIDIA 対話モデル ChatQA はバージョン 2.0 に進化し、コンテキストの長さは 128K と記載されています

Jul 26, 2024 am 08:40 AM

NVIDIA 対話モデル ChatQA はバージョン 2.0 に進化し、コンテキストの長さは 128K と記載されています

Jul 26, 2024 am 08:40 AM

オープンな LLM コミュニティは百花繚乱の時代です Llama-3-70B-Instruct、QWen2-72B-Instruct、Nemotron-4-340B-Instruct、Mixtral-8x22BInstruct-v0.1 などがご覧いただけます。優秀なパフォーマーモデル。しかし、GPT-4-Turboに代表される独自の大型モデルと比較すると、オープンモデルには依然として多くの分野で大きなギャップがあります。一般的なモデルに加えて、プログラミングと数学用の DeepSeek-Coder-V2 や視覚言語タスク用の InternVL など、主要な領域に特化したいくつかのオープン モデルが開発されています。

「AI Factory」はソフトウェア スタック全体の再構築を促進し、NVIDIA はユーザーが展開できる Llama3 NIM コンテナを提供します

Jun 08, 2024 pm 07:25 PM

「AI Factory」はソフトウェア スタック全体の再構築を促進し、NVIDIA はユーザーが展開できる Llama3 NIM コンテナを提供します

Jun 08, 2024 pm 07:25 PM

6月2日の当サイトのニュースによると、現在開催中のHuang Renxun 2024 Taipei Computexの基調講演で、Huang Renxun氏は、生成人工知能がソフトウェアスタック全体の再構築を促進すると紹介し、NIM(Nvidia Inference Microservices)のクラウドネイティブマイクロサービスをデモしました。 。 Nvidia は、「AI ファクトリー」が新たな産業革命を引き起こすと信じています。Microsoft が開拓したソフトウェア業界を例に挙げると、Huang Renxun 氏は、生成人工知能がそのフルスタックの再構築を促進すると信じています。あらゆる規模の企業による AI サービスの導入を促進するために、NVIDIA は今年 3 月に NIM (Nvidia Inference Microservices) クラウドネイティブ マイクロサービスを開始しました。 NIM+ は、市場投入までの時間を短縮するために最適化されたクラウドネイティブのマイクロサービスのスイートです

PS5 Proへの道筋をつける『No Man's Sky』アップデートコードがゲーム機の開発コード名「Trinity」と画質設定ファイルに「驚いた」

Jul 22, 2024 pm 01:10 PM

PS5 Proへの道筋をつける『No Man's Sky』アップデートコードがゲーム機の開発コード名「Trinity」と画質設定ファイルに「驚いた」

Jul 22, 2024 pm 01:10 PM

7月22日の当サイトのニュースによると、海外メディアtwistedvoxelは、『No Man's Sky』の最新「World Part 1」アップデートコード内に噂のPS5開発コードネーム「Trinity」と関連画質設定ファイルを発見し、ソニーがPS5Proモデルが最近発売されました。 「No Man's Sky」は最近のアップデートでゲームのグラフィックス性能を強化しましたが、多くのプレイヤーは、これがHelloGamesが事前に新しいモデルへの道を切り開いているのではないかとまだ信じています。最新のグラフィックスプリセットによると、PS5 Proのゲームの動的解像度は異なります。スケーリングは 0.6 から 0.8 に増加しました。これは、ゲームの平均解像度が高く、一部のグラフィックの詳細が「高」レベルから「超」レベルにアップグレードされていることを意味します。

TrendForce: Nvidia の Blackwell プラットフォーム製品により、TSMC の CoWoS 生産能力は今年 150% 増加します

Apr 17, 2024 pm 08:00 PM

TrendForce: Nvidia の Blackwell プラットフォーム製品により、TSMC の CoWoS 生産能力は今年 150% 増加します

Apr 17, 2024 pm 08:00 PM

4月17日の当サイトのニュースによると、TrendForceは最近、Nvidiaの新しいBlackwellプラットフォーム製品に対する需要は強気で、2024年にはTSMCのCoWoSパッケージング総生産能力が150%以上増加すると予想されるレポートを発表した。 NVIDIA Blackwell の新しいプラットフォーム製品には、B シリーズ GPU と、NVIDIA 独自の GraceArm CPU を統合する GB200 アクセラレータ カードが含まれます。 TrendForce は、サプライチェーンが現在 GB200 について非常に楽観的であることを確認しており、2025 年の出荷台数は 100 万台を超え、Nvidia のハイエンド GPU の 40 ~ 50% を占めると予想されています。 Nvidiaは今年下半期にGB200やB100などの製品を提供する予定だが、上流のウェーハパッケージングではさらに複雑な製品を採用する必要がある。

300元を費やして組み立てたコンピューターは、地元の大型モデルで正常に動作しました

Apr 12, 2024 am 08:07 AM

300元を費やして組み立てたコンピューターは、地元の大型モデルで正常に動作しました

Apr 12, 2024 am 08:07 AM

2023 年が AI 元年とみなされるなら、2024 年は大規模な AI モデルの普及にとって重要な年になる可能性があります。過去 1 年間で、多数の大規模な AI モデルと多数の AI アプリケーションが登場し、Meta や Google などのメーカーも、「AI 人工知能」と同様の独自のオンライン/ローカル大規模モデルを一般に公開し始めています。 「それは手の届かないところにある。」という概念が突然人々に浮かびました。現在、人々は生活の中で人工知能に触れる機会が増えており、注意深く見てみると、アクセスできるさまざまな AI アプリケーションのほぼすべてが「クラウド」上に展開されていることがわかります。大きなモデルをローカルで実行できるデバイスを構築したい場合、ハードウェアは 5,000 元以上の新品の AIPC になります。

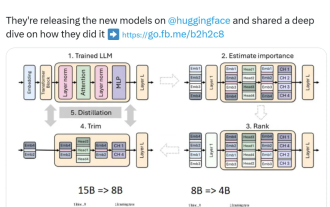

Nvidia はプルーニングと蒸留を試しています。Llama 3.1 8B のパラメータを半分にして、同じサイズでより良いパフォーマンスを実現しています。

Aug 16, 2024 pm 04:42 PM

Nvidia はプルーニングと蒸留を試しています。Llama 3.1 8B のパラメータを半分にして、同じサイズでより良いパフォーマンスを実現しています。

Aug 16, 2024 pm 04:42 PM

小型モデルの台頭。先月、Meta は Llama3.1 シリーズのモデルをリリースしました。これには、Meta のこれまでで最大のモデルである 405B モデルと、それぞれ 700 億と 80 億のパラメータを持つ 2 つの小型モデルが含まれています。 Llama3.1 は、オープンソースの新時代の到来を告げるものと考えられています。ただし、新世代モデルはパフォーマンスが強力ですが、導入時には依然として大量のコンピューティング リソースが必要です。したがって、多くの言語タスクで十分なパフォーマンスを発揮し、導入コストも非常に安価な小規模言語モデル (SLM) を開発するという別の傾向が業界に現れています。最近、NVIDIA の研究では、構造化された重み枝刈りと知識の蒸留を組み合わせることで、最初は大きなモデルから徐々に小さな言語モデルを取得できることが示されました。チューリング賞受賞、メタチーフA