Meitu AI部分再描画技術公開!好きなように変更してください!美しい絵を部分的に描き直せばやりたい放題

最近、突然の拡大効果で話題を呼んだ「AI拡張」機能は、オートフィルのおもしろくて面白い結果が度々話題となり、ネット上でブームを巻き起こしています。ユーザーも積極的にこの機能を試し、その180度の大きな変化にも人々を驚かせ、話題の人気は高まり続けました。

これは、笑いと熱意を呼び起こすと同時に、AI が現実世界の問題を解決し、ユーザー エクスペリエンスを向上させるのに本当に役立つかどうかに人々が常に注目していることを意味します。 AIGC テクノロジーの急速な発展に伴い、AI 適用シナリオの実装が加速しており、新たな生産性革命が到来することを示しています。

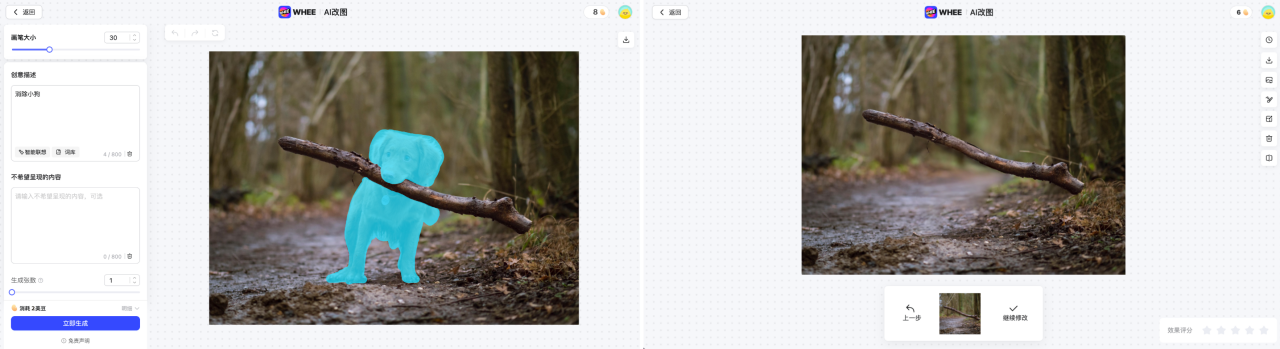

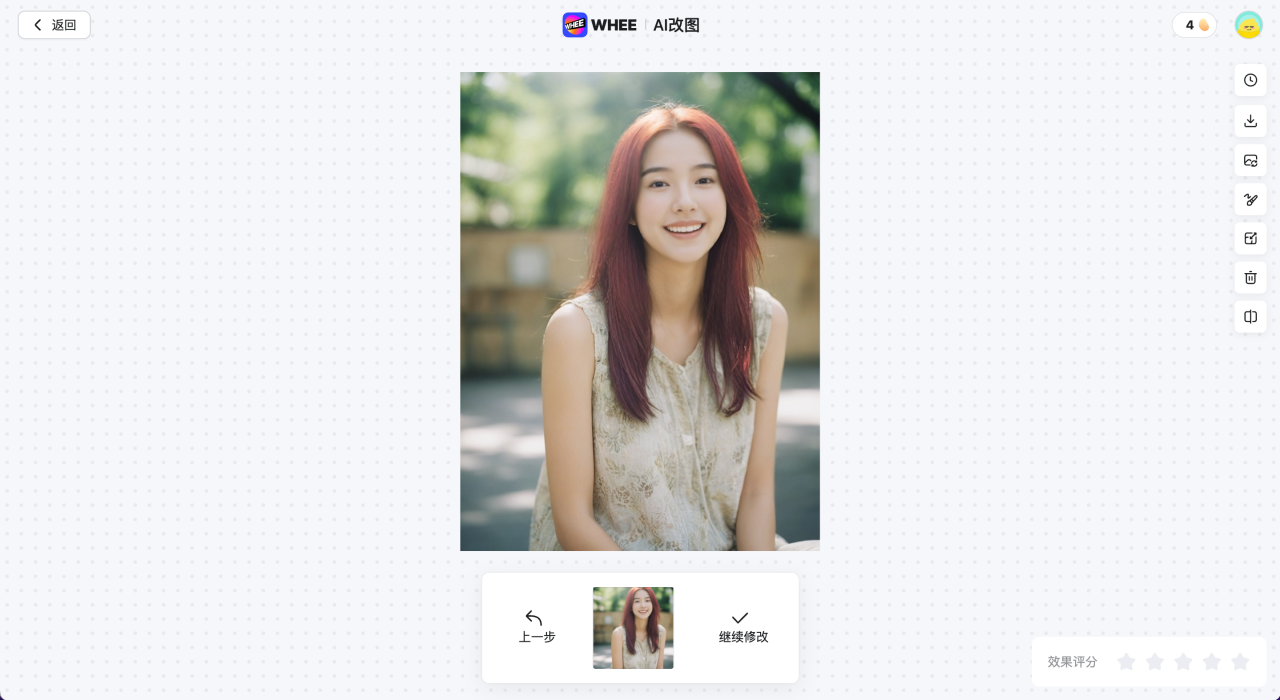

最近、Meitu の WHEE などの製品は、AI 画像拡大機能と AI 画像修正機能を開始し、簡単なプロンプト入力で、ユーザーは画像を修正したり、画面要素を削除したり、画面を自由に拡大したりすることができます。素晴らしいエフェクトにより、ツールを使用する敷居が大幅に下がり、ユーザーに効率的で高品質な画像作成体験をもたらします。

MiracleVision (Qixiang Intelligence) が結果を排除します

MiracleVision (Qixiang Intelligence) が結果を置き換えます効果 前

MiracleVision (Qixiang Intelligence) 置換効果

MiracleVision (Qixiang Intelligence) AI 画像変更効果

強力なモデル機能により、思いどおりに画像を編集できます

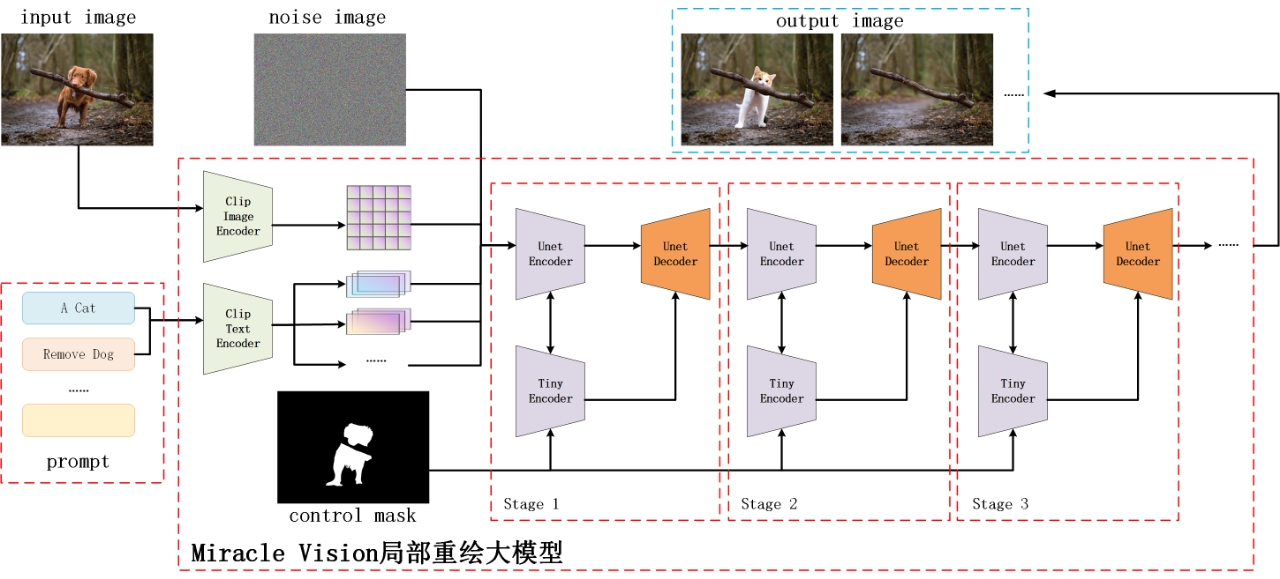

Meitu AI 部分再描画モデルは、拡散モデル (Diffision Model) テクノロジーに基づいて完全なインペイント & アウトペイント モデル フレームワークを構築し、内部領域を再描画しますターゲットの削除や外部領域の拡張などのタスクは 1 つのソリューションに統合され、いくつかの特定の効果の問題に対して特別な最適化設計が行われます。

MiracleVision モデルは、Vincentian グラフ モデルです。最初の畳み込み層を変換し、unet 全体を微調整することで修復タスクに適応させることができますが、これには、unet の元の重みを変更する必要があります。トレーニング データの量が不十分な場合、モデルのパフォーマンスの低下につながります。

したがって、MiracleVision の既存の生成機能を最大限に活用するために、チームは部分再描画モデルで MiracleVision の unet モデルを直接微調整するのではなく、controlnet を使用してマスクの入力ブランチを追加します。制御されている。

同時に、トレーニング コストを節約し、推論を高速化するために、圧縮されたコントロールネット モジュールをトレーニングに使用して、計算量を可能な限り削減します。トレーニング プロセス中に、unet モデルのパラメーターが固定され、controlnet モジュールのみが更新され、最終的にはモデル全体が修復できるようになります。

Meitu AI はモデル アーキテクチャ図を部分的に再描画します

アウトペイント タスクはクロップ タスクの逆の操作です。トリミング タスクは、元の画像を画像の境界に沿ってトリミングし、必要な部分のみを保持し、画像コンテンツの減算操作を行うことです。一方、外側のタスクは、モデルの生成機能を使用して、画像の境界に沿って外側に拡張することです。何もないところから作成する 元々存在しないコンテンツを抽出することは、画像コンテンツの追加操作です。

本質的に、アウトペイント タスクは、マスク領域がイメージの周縁に配置されることを除いて、特別なインペイント タスクとみなすこともできます。

さまざまなトレーニング戦略により、オブジェクトの生成と削除を自由に制御します

一般的な拡散モデルは、修復タスクを実行するときに、削除するよりも置き換えることに優れています。特定のターゲットを削除する必要がある場合、モデルは、特にマスクが存在しない場合、マスク領域に元から存在しないいくつかの新しい前景ターゲットを簡単に描画できます。エリア この現象は、これらのターゲットがプロンプトに表示されない場合でも、エリアが比較的大きい場合に特に顕著です。その理由は主に次の 3 つの側面です:

1. トレーニング セットのプロンプトは通常、画像にあるもののみを説明し、画像にないものは説明しないため、トレーニングされたモデルはベースにすることができます。 on プロンプトにターゲットを生成するように指示するのは簡単ですが、ターゲットの生成を停止するのは困難です。分類子なしのガイダンス戦略を使用しても、不要なオブジェクトを否定的な単語に追加することでこのターゲットの生成を抑制できますが、考えられるすべてのターゲットを否定的な単語に書き込むことは不可能であるため、モデルは依然としていくつかの予期しないターゲットを生成する傾向があります。 ;

2. 訓練データの分布から、大規模な画像訓練セット内のほとんどの画像は前景と背景で構成されているため、純粋な背景画像が占める割合は比較的小さく、これは拡散がモデルはトレーニング中に潜在的なルールを学習しました。つまり、画像内にターゲットの前景が存在する可能性が高く (プロンプトで言及されていない場合でも)、これによりモデルは修復タスクを実行するときに、出力画像がトレーニング中の分布に近づくように、マスク領域に何かが生成される可能性が高くなります。

3. 塗りつぶされるマスク領域の形状には、特定の意味情報も含まれる場合があります。たとえば、他のガイダンスがなければ、モデルはマスク領域に新しい猫を猫の形で塗りつぶす傾向が強くなり、除去タスクが失敗します。

MiracleVision でターゲット生成とターゲット除去の両方を実行できるようにするために、チームはマルチタスク トレーニング戦略を採用しました:

1. トレーニング段階では、マスク領域がターゲットに該当するとき、純粋な背景領域が少ない場合は、特定のプロンプト キーワードをトリガー ガイド ワードとして追加し、モデルの推論段階で、このキーワードを前方ガイド ワードとしてプロンプト埋め込みに追加して、モデルがより多くの背景領域を生成するように促します。

2. 純粋な背景画像がトレーニング セット全体で占める割合は比較的小さいため、トレーニングへの寄与を高めるために、各トレーニング バッチで、一定の割合の背景画像が手動でサンプリングされ、背景画像に追加されます。トレーニングにより、背景画像の割合が全体的に安定したままになります。

3. マスク形状に対するモデルのセマンティック依存性を減らすために、トレーニング段階で異なる形状のさまざまなマスクがランダムに生成され、マスク形状の多様性が高まります。

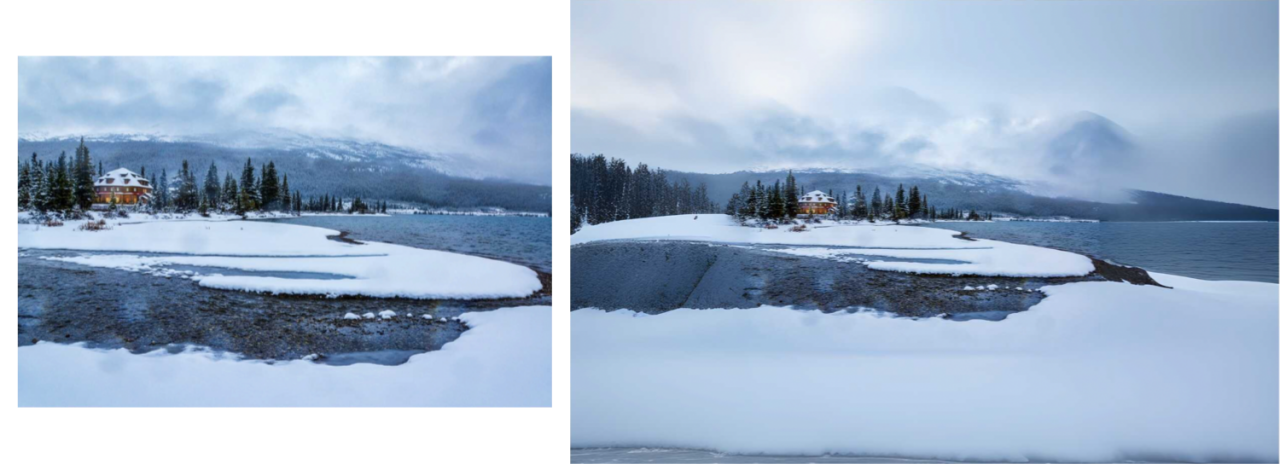

高精度テクスチャ生成、より自然な融合

トレーニング セット内の高精細テクスチャ データは、トレーニング データ全体のほんの一部にすぎないため、インペイント タスクを実行する場合、通常、非常に豊かなテクスチャを含む結果は生成されません。その結果、元のテクスチャが豊かなシーンに不自然な融合や境界感が生じます。

この問題を解決するために、チームは独自に開発したテクスチャ詳細モデルをガイド モデルとして使用し、MiracleVision による生成品質の向上とオーバーフィッティングの抑制を支援し、生成された領域が生成された領域の間に収まるようにしました。元の画像の領域と他の領域をより適切に組み合わせることができます。

元の画像 vs テクスチャ詳細を追加していない画像 vsMiracleVision 拡大画像効果

#より速く、より良い効果、より効率的なインタラクション!

拡散モデル ソリューションでは、通常、推論中に複数ステップの逆拡散プロセスが必要となり、その結果、単一画像の処理に時間がかかりすぎます。生成品質を維持しながらユーザー エクスペリエンスを最適化するために、Meitu Imaging Research Institute (MT Lab) チームは AI 部分再描画テクノロジーの特別なチューニング ソリューションを作成し、最終的にパフォーマンスと効果の最適なバランスを実現しました。

まず、MiracleVision の前処理、後処理および推論プロセスにおける多数の行列計算が、可能な限り並列コンピューティングのために GPU に移植されるため、効果的に計算が高速化され、計算量が削減されます。 CPUの負荷。同時に、画像を組み立てるプロセス中に、可能な限りレイヤーを融合し、FlashAttendant を使用してビデオ メモリの使用量を削減し、推論パフォーマンスを向上させ、さまざまな NVIDIA グラフィックスの GPU コンピューティング パワーの使用を最大化するためにカーネル実装を調整します。カード。

さらに、MiracleVision は、独自に開発したモデル パラメーター定量化手法を利用して、明らかな精度の損失なしに 8 ビットに量子化されます。 GPU グラフィックス カードによって 8 ビット量子化のサポートが異なるため、混合精度戦略を革新的に採用して、さまざまなサーバー リソース環境下で最適な演算子を適応的に選択し、全体的な高速化の最適なソリューションを実現します。

ユーザー入力画像の解像度が高い場合、サーバー リソースと時間コストの制限により、元の解像度で直接推論を実行することは困難です。この点に関して、チームはまず画像の解像度を適切なサイズに圧縮し、次に MiracleVision に基づいて推論を実行し、次に超解像度アルゴリズムを使用して画像を元の解像度に復元し、次に元の画像との画像融合を実行しました。これにより、鮮明な画像が生成され、推論プロセス中のメモリ使用量と実行時間が節約されます。

Meitu は Samsung と緊密に協力し、AI を使用した新しいモバイル画像編集エクスペリエンスを作成します

サムスン電子は1月25日、中国でGalaxy S24シリーズの新製品発表会を開催した。 MeituはSamsungとの協力を深め、Samsungの新型Galaxy S24シリーズの携帯電話アルバム向けに新たなAI画像編集エクスペリエンスを構築するとともに、Meitu画像研究所(MT Lab)が独自に開発したジェネレーティブ編集機能「AI画像拡張機能」と「AI画像修正機能」を提供します。モバイル画像の編集と作成のための新しいスペースを開くために正式にリリースされました。

AI画像編集機能により、編集したい画像を長押しするだけで、画像の移動や削除、サイズ変更などが簡単に行えます。さらに、写真の水平線が垂直でない場合、AI画像拡大機能は、ユーザーが角度を調整した後、写真の欠落領域をインテリジェントに補い、写真の構図を修正します。

MiracleVision がもたらす AI 機能に基づいて、Meitu はユーザーが携帯電話でプロレベルの編集効果を簡単に達成し、よりパーソナライズされた写真作品を作成できるよう支援するだけでなく、AI 全体の推進と強化も継続していきます。携帯電話業界における画像処理能力。

Meitu Imaging Research Institute (MT Lab) の強力な技術力を利用して、MiracleVision は半年以内にバージョン 4.0 までバージョンアップされました。今後も Meitu は、電子商取引、広告、ゲーム、その他の業界におけるユーザー エクスペリエンスの向上に努め、さまざまなシナリオの実務者がワークフローの効率を向上できるよう支援していきます。

以上がMeitu AI部分再描画技術公開!好きなように変更してください!美しい絵を部分的に描き直せばやりたい放題の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7450

7450

15

15

1374

1374

52

52

77

77

11

11

14

14

7

7

DeepMind ロボットが卓球をすると、フォアハンドとバックハンドが空中に滑り出し、人間の初心者を完全に打ち負かしました

Aug 09, 2024 pm 04:01 PM

DeepMind ロボットが卓球をすると、フォアハンドとバックハンドが空中に滑り出し、人間の初心者を完全に打ち負かしました

Aug 09, 2024 pm 04:01 PM

でももしかしたら公園の老人には勝てないかもしれない?パリオリンピックの真っ最中で、卓球が注目を集めています。同時に、ロボットは卓球のプレーにも新たな進歩をもたらしました。先ほど、DeepMind は、卓球競技において人間のアマチュア選手のレベルに到達できる初の学習ロボット エージェントを提案しました。論文のアドレス: https://arxiv.org/pdf/2408.03906 DeepMind ロボットは卓球でどれくらい優れていますか?おそらく人間のアマチュアプレーヤーと同等です: フォアハンドとバックハンドの両方: 相手はさまざまなプレースタイルを使用しますが、ロボットもそれに耐えることができます: さまざまなスピンでサーブを受ける: ただし、ゲームの激しさはそれほど激しくないようです公園の老人。ロボット、卓球用

初のメカニカルクロー!元羅宝は2024年の世界ロボット会議に登場し、家庭に入ることができる初のチェスロボットを発表した

Aug 21, 2024 pm 07:33 PM

初のメカニカルクロー!元羅宝は2024年の世界ロボット会議に登場し、家庭に入ることができる初のチェスロボットを発表した

Aug 21, 2024 pm 07:33 PM

8月21日、2024年世界ロボット会議が北京で盛大に開催された。 SenseTimeのホームロボットブランド「Yuanluobot SenseRobot」は、全製品ファミリーを発表し、最近、世界初の家庭用チェスロボットとなるYuanluobot AIチェスプレイロボット - Chess Professional Edition(以下、「Yuanluobot SenseRobot」という)をリリースした。家。 Yuanluobo の 3 番目のチェス対局ロボット製品である新しい Guxiang ロボットは、AI およびエンジニアリング機械において多くの特別な技術アップグレードと革新を経て、初めて 3 次元のチェスの駒を拾う機能を実現しました。家庭用ロボットの機械的な爪を通して、チェスの対局、全員でのチェスの対局、記譜のレビューなどの人間と機械の機能を実行します。

クロードも怠け者になってしまった!ネチズン: 自分に休日を与える方法を学びましょう

Sep 02, 2024 pm 01:56 PM

クロードも怠け者になってしまった!ネチズン: 自分に休日を与える方法を学びましょう

Sep 02, 2024 pm 01:56 PM

もうすぐ学校が始まり、新学期を迎える生徒だけでなく、大型AIモデルも気を付けなければなりません。少し前、レディットはクロードが怠け者になったと不満を漏らすネチズンでいっぱいだった。 「レベルが大幅に低下し、頻繁に停止し、出力も非常に短くなりました。リリースの最初の週は、4 ページの文書全体を一度に翻訳できましたが、今では 0.5 ページの出力さえできません」 !」 https://www.reddit.com/r/ClaudeAI/comments/1by8rw8/something_just_feels_wrong_with_claude_in_the/ というタイトルの投稿で、「クロードには完全に失望しました」という内容でいっぱいだった。

世界ロボット会議で「未来の高齢者介護の希望」を担う家庭用ロボットを囲みました

Aug 22, 2024 pm 10:35 PM

世界ロボット会議で「未来の高齢者介護の希望」を担う家庭用ロボットを囲みました

Aug 22, 2024 pm 10:35 PM

北京で開催中の世界ロボット会議では、人型ロボットの展示が絶対的な注目となっているスターダストインテリジェントのブースでは、AIロボットアシスタントS1がダルシマー、武道、書道の3大パフォーマンスを披露した。文武両道を備えた 1 つの展示エリアには、多くの専門的な聴衆とメディアが集まりました。弾性ストリングのエレガントな演奏により、S1 は、スピード、強さ、正確さを備えた繊細な操作と絶対的なコントロールを発揮します。 CCTVニュースは、「書道」の背後にある模倣学習とインテリジェント制御に関する特別レポートを実施し、同社の創設者ライ・ジエ氏は、滑らかな動きの背後にあるハードウェア側が最高の力制御と最も人間らしい身体指標(速度、負荷)を追求していると説明した。など)、AI側では人の実際の動きのデータが収集され、強い状況に遭遇したときにロボットがより強くなり、急速に進化することを学習することができます。そしてアジャイル

Li Feifei 氏のチームは、ロボットに空間知能を与え、GPT-4o を統合する ReKep を提案しました

Sep 03, 2024 pm 05:18 PM

Li Feifei 氏のチームは、ロボットに空間知能を与え、GPT-4o を統合する ReKep を提案しました

Sep 03, 2024 pm 05:18 PM

ビジョンとロボット学習の緊密な統合。最近話題の1X人型ロボットNEOと合わせて、2つのロボットハンドがスムーズに連携して服をたたむ、お茶を入れる、靴を詰めるといった動作をしていると、いよいよロボットの時代が到来するのではないかと感じられるかもしれません。実際、これらの滑らかな動きは、高度なロボット技術 + 精緻なフレーム設計 + マルチモーダル大型モデルの成果です。有用なロボットは多くの場合、環境との複雑かつ絶妙な相互作用を必要とし、環境は空間領域および時間領域の制約として表現できることがわかっています。たとえば、ロボットにお茶を注いでもらいたい場合、ロボットはまずティーポットのハンドルを掴んで、お茶をこぼさないように垂直に保ち、次にポットの口がカップの口と揃うまでスムーズに動かす必要があります。 、そしてティーポットを一定の角度に傾けます。これ

ACL 2024 賞の発表: HuaTech による Oracle 解読に関する最優秀論文の 1 つ、GloVe Time Test Award

Aug 15, 2024 pm 04:37 PM

ACL 2024 賞の発表: HuaTech による Oracle 解読に関する最優秀論文の 1 つ、GloVe Time Test Award

Aug 15, 2024 pm 04:37 PM

貢献者はこの ACL カンファレンスから多くのことを学びました。 6日間のACL2024がタイのバンコクで開催されています。 ACL は、計算言語学と自然言語処理の分野におけるトップの国際会議で、国際計算言語学協会が主催し、毎年開催されます。 ACL は NLP 分野における学術的影響力において常に第一位にランクされており、CCF-A 推奨会議でもあります。今年の ACL カンファレンスは 62 回目であり、NLP 分野における 400 以上の最先端の作品が寄せられました。昨日の午後、カンファレンスは最優秀論文およびその他の賞を発表しました。今回の優秀論文賞は7件(未発表2件)、最優秀テーマ論文賞1件、優秀論文賞35件です。このカンファレンスでは、3 つの Resource Paper Award (ResourceAward) と Social Impact Award (

宏蒙スマートトラベルS9とフルシナリオ新製品発売カンファレンス、多数の大ヒット新製品が一緒にリリースされました

Aug 08, 2024 am 07:02 AM

宏蒙スマートトラベルS9とフルシナリオ新製品発売カンファレンス、多数の大ヒット新製品が一緒にリリースされました

Aug 08, 2024 am 07:02 AM

今日の午後、Hongmeng Zhixingは新しいブランドと新車を正式に歓迎しました。 8月6日、ファーウェイはHongmeng Smart Xingxing S9およびファーウェイのフルシナリオ新製品発表カンファレンスを開催し、パノラマスマートフラッグシップセダンXiangjie S9、新しいM7ProおよびHuawei novaFlip、MatePad Pro 12.2インチ、新しいMatePad Air、Huawei Bisheng Withを発表しました。レーザー プリンタ X1 シリーズ、FreeBuds6i、WATCHFIT3、スマート スクリーン S5Pro など、スマート トラベル、スマート オフィスからスマート ウェアに至るまで、多くの新しいオールシナリオ スマート製品を開発し、ファーウェイは消費者にスマートな体験を提供するフル シナリオのスマート エコシステムを構築し続けています。すべてのインターネット。宏孟志興氏:スマートカー業界のアップグレードを促進するための徹底的な権限付与 ファーウェイは中国の自動車業界パートナーと提携して、

AI の使用 | Microsoft CEO のクレイジーなアムウェイ AI ゲームは私を何千回も苦しめた

Aug 14, 2024 am 12:00 AM

AI の使用 | Microsoft CEO のクレイジーなアムウェイ AI ゲームは私を何千回も苦しめた

Aug 14, 2024 am 12:00 AM

Machine Power Report 編集者: Yang Wen 大型モデルや AIGC に代表される人工知能の波は、私たちの生活や働き方を静かに変えていますが、ほとんどの人はまだその使い方を知りません。そこで、直感的で興味深く簡潔な人工知能のユースケースを通じてAIの活用方法を詳しく紹介し、皆様の思考を刺激するコラム「AI in Use」を立ち上げました。また、読者が革新的な実践的な使用例を提出することも歓迎します。なんと、AIは本当に天才になってしまったのです。最近、AIが生成した写真の真贋を見分けるのが難しいと話題になっています。 (詳しくはこちら:AI活用中 | 3ステップでAI美女になり、1秒でAIに元に戻される) インターネット上で人気のAI Google ladyのほかにも、さまざまなFLUXジェネレーターが登場しています。ソーシャルプラットフォーム上に出現した