Intel オープンソース NPU アクセラレーション ライブラリ、Core Ultra プロセッサ AI PC は軽量の大規模言語モデルを実行可能

3 月 4 日のニュースでは、Intel が最近 GitHub で NPU アクセラレーション ライブラリをリリースしたことを示しました。この動きにより、Core Ultra プロセッサを搭載した AI PC は、TinyLlama や Gemma-2b などの軽量で大規模なアプリケーションをよりスムーズに実行できるようになります。言語モデル。

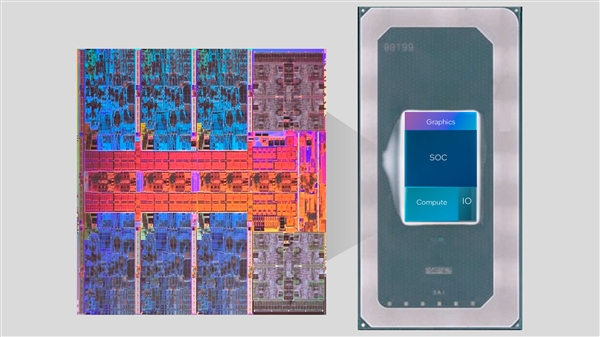

Core Ultra シリーズには初めて NPU AI エンジンが統合されており、このエンジンはいくつかの軽量 AI 推論タスクを処理し、CPU および GPU と連携してさまざまなニーズに対応できます。 . AI アプリケーションの要件。

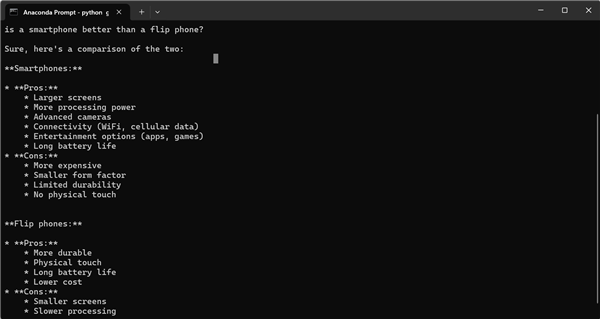

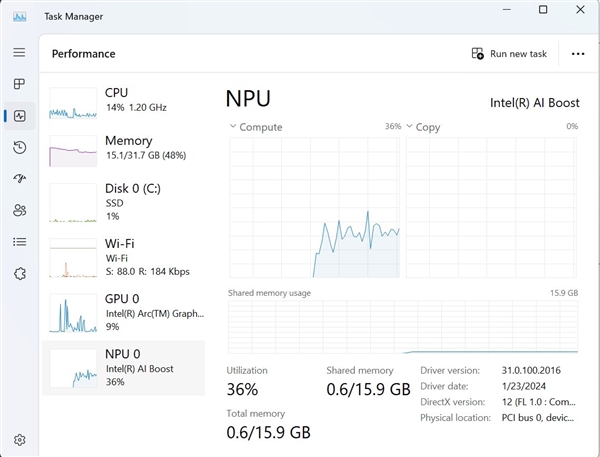

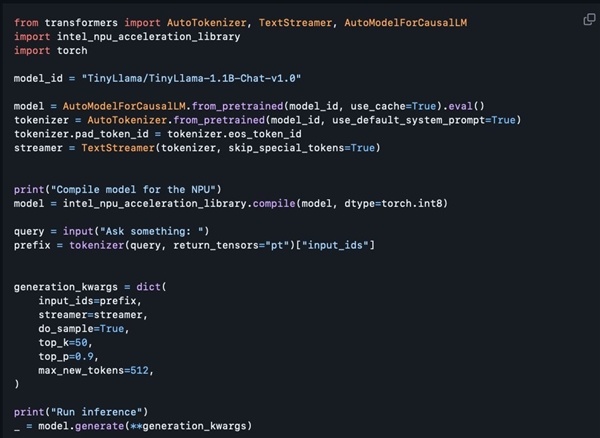

今回リリースされた NPU アクセラレーション ライブラリは主に開発者向けに用意されていることがわかりますが、一定のプログラミング経験のあるユーザーでも利用できます。も試してみてください。 Intel のソフトウェア アーキテクトである Tony Mongkolsmai 氏は、11 億パラメータの TinyLlama 大型モデルに基づく AI チャットボットを MSI Monarch 14 AI Evo ラップトップで実行する方法をデモンストレーションしました。この AI チャットボットは簡単な会話を行うことができます。同時に、Windows タスク マネージャーには、NPU への有効な呼び出しも表示されます。

ただし、現在のオープンソース NPU アクセラレーション ライブラリには、8 ビット量子化と FP16 精度をサポートしていますが、4 ビット量子化はまだサポートされていないため、機能的にまだいくつかの欠点があります。 NPU/GPU ハイブリッド コンピューティングなどの高度な機能と同様に、関連する技術ドキュメントはまだ提供されていません。しかし、インテルは将来的に機能を段階的に拡張することを約束しており、これにより既存の機能が2倍になることが見込まれており、AI開発者にとってより利便性と可能性がもたらされることは間違いありません。

以上がIntel オープンソース NPU アクセラレーション ライブラリ、Core Ultra プロセッサ AI PC は軽量の大規模言語モデルを実行可能の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

Video Face Swap

完全無料の AI 顔交換ツールを使用して、あらゆるビデオの顔を簡単に交換できます。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7821

7821

15

15

1647

1647

14

14

1402

1402

52

52

1300

1300

25

25

1238

1238

29

29

リークにより、Intel Arrow Lake-U、-H、-HX、-S の主要な仕様が明らかに

Jun 15, 2024 pm 09:49 PM

リークにより、Intel Arrow Lake-U、-H、-HX、-S の主要な仕様が明らかに

Jun 15, 2024 pm 09:49 PM

IntelArrowLake は、LunarLake と同じプロセッサ アーキテクチャに基づいていると予想されており、つまり、Intel の新しい Lion Cove パフォーマンス コアが経済的な Skymont 効率コアと組み合わされることになります。

インテルTXTとは何ですか?

Jun 11, 2023 pm 06:57 PM

インテルTXTとは何ですか?

Jun 11, 2023 pm 06:57 PM

IntelTXT は、Intel が開発したハードウェア支援セキュリティ テクノロジであり、CPU と BIOS の間に保護されたスペースを確立することで、起動中のサーバーの整合性とセキュリティを確保できます。 TXT の正式名は TrustedExecutionTechnology、つまり Trusted Execution Technology です。簡単に言うと、TXT は、サーバーの起動時に悪意のあるプログラムや不正なソフトウェアによってサーバーが変更されていないことを保証するハードウェア レベルの保護を提供するセキュリティ テクノロジです。これです

LG、LG Gram 16 Pro を刷新した最薄かつ最軽量の Intel Lunar Lake ノートパソコンを発表

Sep 10, 2024 am 06:44 AM

LG、LG Gram 16 Pro を刷新した最薄かつ最軽量の Intel Lunar Lake ノートパソコンを発表

Sep 10, 2024 am 06:44 AM

LGはすでにIntel Meteor Lakeプロセッサを搭載したGram 16 Proを提供している(Amazonで現在1,699.99ドル)。しかし、同社はIntelのMeteor LakeアーキテクチャをLunar Lakeに切り替えることを決定しており、Intelは先週ベルリンで開催されたIFA 2024でそれを披露した。 Th

Beelink EQi12 は EQ12 よりも強力なミニ PC として発売

Aug 21, 2024 pm 08:37 PM

Beelink EQi12 は EQ12 よりも強力なミニ PC として発売

Aug 21, 2024 pm 08:37 PM

Beelink は、新しいミニ PC EQi12 を発売しました。これは、同ブランドが昨年発表した、Intel N100 に付属していた EQ12 のアップグレード バージョンです。新しいコンピューターには、ハイエンドチップの 1 つである Intel Core i7 12650H までを搭載できます

Intel オープンソース NPU アクセラレーション ライブラリ、Core Ultra プロセッサ AI PC は軽量の大規模言語モデルを実行可能

Mar 05, 2024 am 11:13 AM

Intel オープンソース NPU アクセラレーション ライブラリ、Core Ultra プロセッサ AI PC は軽量の大規模言語モデルを実行可能

Mar 05, 2024 am 11:13 AM

3 月 4 日のニュースによると、Intel は最近、GitHub で NPU アクセラレーション ライブラリをリリースしました。これにより、Core Ultra プロセッサを搭載した AIPC が TinyLlama や Gemma-2b などの軽量の大規模言語モデルをよりスムーズに実行できるようになります。 Core Ultra シリーズには NPUAI エンジンが初めて統合されており、このエンジンはいくつかの軽量 AI 推論タスクを処理し、CPU および GPU と連携してさまざまな AI アプリケーションの要件を満たすことができます。今回公開されたNPUアクセラレーションライブラリは主に開発者向けに用意されているが、一定のプログラミング経験のあるユーザーも利用してみることができることが分かる。インテル ソフトウェア アーキテクトの Tony Mongkolsmai が、次の方法をデモンストレーションします。

Yoga Slim 7i Aura Edition: Lenovo が新しい軽量 Intel Lunar Lake ラップトップのリリースで Samsung を下回る

Sep 11, 2024 am 06:41 AM

Yoga Slim 7i Aura Edition: Lenovo が新しい軽量 Intel Lunar Lake ラップトップのリリースで Samsung を下回る

Sep 11, 2024 am 06:41 AM

Lenovo は、Intel Lunar Lake ベースのラップトップを最初に発表してから 1 週間も経たないうちに、Yoga Slim 7i Aura Edition をリリースしました。同社はベルリンで開催された IFA 2024 中にラップトップに関する多くの詳細を明らかにしましたが、

Arc Battlemage: Intel の次世代ゲーム グラフィックス カードに 3 つの GPU が搭載されることを示唆するリーク

Jul 02, 2024 am 09:44 AM

Arc Battlemage: Intel の次世代ゲーム グラフィックス カードに 3 つの GPU が搭載されることを示唆するリーク

Jul 02, 2024 am 09:44 AM

Intel の次世代 GPU アーキテクチャは、Intel Lunar Lake の一部として 9 月に発売される予定です。 Meteor Lake の Arc Alchemist iGPU と同様に、iGPU には最大 8 個の Xe コアが搭載されていますが、新しいアーキテクチャでは 50% 高いパフォーマンスが達成されると予想されています。

九州風神、Ice Storm一体型水冷ラジエーターを発売

Feb 28, 2024 pm 05:10 PM

九州風神、Ice Storm一体型水冷ラジエーターを発売

Feb 28, 2024 pm 05:10 PM

DeepCool は PC 冷却ソリューションの大手メーカーであり、同社の Ice Storm オールインワン水冷ラジエーターの最新製品ラインは、高性能 PC ハードウェアとゲーム体験を強化するように設計されています。このシリーズの製品には、カスタマイズ可能な 2.8 インチ LCD ディスプレイが装備されており、ユーザーに新しい美しさ、カスタマイズ、冷却効率の体験をもたらします。優れた 2.8 インチ LCD ディスプレイで創造性を解き放ちます。Ice Storm オールインワン水冷ラジエーターのハイライトは、印象的な 2.8 インチ TFTIPS 大画面です。ユーザーは、このディスプレイを使用してコンテンツをパーソナライズできます。 1,670万色のトゥルーカラーLCDは640x480の高解像度で優れた画質性能を実現し、コールドヘッドにはジャイロセンサーが内蔵されており、画面の設置方向を自動認識します。第 5 世代ポンプ技術 Ice Storm One