大型モデルを90%「スリム化」!清華大学とハルビン工業大学は、容量の 83% を維持しながら 1 ビット量子化という極端な圧縮ソリューションを提案しました。

大規模モデルに対する

定量化、プルーニング、その他の 圧縮操作は、展開の最も一般的な部分です。

しかし、この limit はどれくらいの大きさなのでしょうか?

清華大学とハルビン工業大学による共同研究では、

90% という答えが得られました。

彼らは、大規模モデルの 1 ビット極限圧縮フレームワーク OneBit を提案しました。これにより、大規模モデルの 90% を超える重み圧縮が初めて達成され、ほとんどの (83 %) 機能。

遊びとは「欲しくて欲しがる」ことだと言えます~

見てみましょう。

大規模モデルの 1 ビット量子化方法はこちらです

枝刈りや量子化から知識の蒸留や低ランクの重み分解に至るまで、大規模モデルはすでにほとんどコストを削減することなく重みの 4 分の 1 を圧縮できます。損失。

重み量子化は通常、大規模なモデルのパラメータを低ビット幅表現に変換します。これは、完全にトレーニングされたモデルを変換する (PTQ) か、トレーニング中に量子化ステップを導入する (QAT) ことによって実現できます。このアプローチは、モデルの計算要件とストレージ要件を軽減するのに役立ち、それによってモデルの効率とパフォーマンスが向上します。重みを量子化することで、モデルのサイズを大幅に削減でき、リソースに制約のある環境での展開により適したものになります。また、

ただし、既存の量子化方法は 3 ビット未満で重大なパフォーマンスの低下に直面します。これは主に次のような理由によるものです。 to:

- 既存のパラメータの低ビット幅表現方法では、1 ビットで重大な精度が低下します。 Round-To-Nearest 法に基づくパラメータを 1 ビットで表現すると、変換後のスケーリング係数 s とゼロ点 z は実質的な意味を失います。

- 既存の 1 ビット モデル構造では、浮動小数点精度の重要性が十分に考慮されていません。浮動小数点パラメータの欠如はモデル計算プロセスの安定性に影響を与え、モデル自身の学習能力を大幅に低下させる可能性があります。

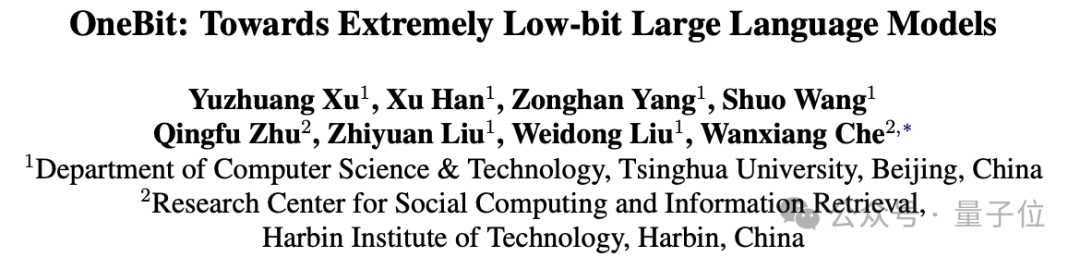

1 ビットの超低ビット幅量子化の障害を克服するために、著者は新しい 1 ビット モデル フレームワーク、つまり新しい 1 ビット線形層構造を含む OneBit を提案します。 SVID ベースのパラメータ初期化方法と量子化ベースの認識 知識蒸留のための深層転移学習。

この新しい 1 ビット モデルの量子化方法は、元のモデルの機能のほとんどを保持し、広大な圧縮範囲、超低スペース占有、限られたコンピューティング コストを実現します。これは、大型モデルを PC やスマートフォンに展開する場合に非常に重要です。

全体的なフレームワーク

OneBit フレームワークには通常、新しく設計された 1 ビット モデル構造、元のモデルに基づいて定量化されたモデル パラメーターを初期化する方法、知識の蒸留に基づいた詳細な機能の移行が含まれます。 。

この新しく設計された 1 ビット モデル構造は、以前の量子化作業における 1 ビット量子化における深刻な精度損失の問題を効果的に克服でき、トレーニングおよび移行中に優れた安定性を示します。

定量的モデルの初期化方法は、知識の抽出のためのより良い開始点を設定し、収束を加速し、より優れた能力移転効果を達成することができます。

1. 1 ビット モデルの構造

1 ビットでは、各重み値が 1 ビットでのみ表現できる必要があるため、可能な状態は最大 2 つだけです。

著者は、これら 2 つの状態として ±1 を選択しました。利点は、デジタル システム内の 2 つのシンボルを表し、より完全な機能を備えていることです。同時に、Sign(・) を通じて簡単に取得できることです。関数。

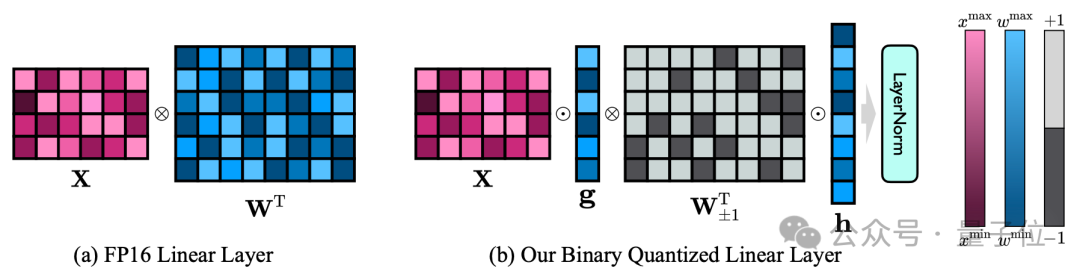

著者の 1 ビット モデル構造は、FP16 モデルのすべての線形層 (埋め込み層と lm_head を除く) を 1 ビット線形層に置き換えることによって実現されます。

Sign(・) 関数によって取得される 1 ビットの重みに加えて、ここの 1 ビット線形層には、他の 2 つの重要なコンポーネント (FP16 精度の値ベクトル) も含まれています。

△FP16 線形層と OneBit 線形層の比較

この設計は、元の重み行列の高いランクを維持するだけでなく、必要な浮動小数点の精度は、安定した高品質の学習プロセスを保証するために重要です。

上図からわかるように、値ベクトル g と h のみが FP16 形式を維持しており、重み行列は全体が ±1 で構成されています。

著者は、例を通じて OneBit の圧縮機能を確認できます。

40964096 FP16 線形層が圧縮されていると仮定すると、OneBit には 40964096 1 ビット行列と 2 つの 4096*1 FP16 値ベクトルが必要です。

ビットの総数は 16,908,288、パラメータの総数は 16,785,408 です。平均すると、各パラメータは約 1.0073 ビットしか占有しません。

この種の圧縮範囲は前例がなく、真の 1bit LLM と言えます。

2. パラメーターの初期化と転移学習

完全にトレーニングされた元のモデルを使用して量子化モデルをより適切に初期化するために、著者は新しいパラメーター行列の分解を提案します。この方法は「値符号独立行列因数分解 (SVID)」と呼ばれます。

この行列分解方法は、シンボルと絶対値を分離し、絶対値に対してランク 1 近似を実行します。元の行列パラメータを近似する方法は、次のように表すことができます。

ランク 1 近似は、特異値分解 (SVD) や非負行列因数分解 (NMF) などの一般的な行列因数分解手法によって実現できます。

著者は、この SVID メソッドが演算の順序を交換することで 1 ビット モデルのフレームワークに適合し、それによってパラメーターの初期化が実現できることを数学的に示しています。

さらに、分解プロセス中に元の行列を近似するためのシンボリック行列の貢献も証明されています。詳細については、論文を参照してください。

著者は、大規模モデルの超低ビット幅量子化を解決する効果的な方法は、量子化を意識したトレーニング QAT である可能性があると考えています。

したがって、SVID が定量モデルのパラメーター開始点を与えた後、著者は元のモデルを教師モデルとして使用し、知識の蒸留を通じてそこから学習します。

具体的には、学生モデルは主に教師モデルのロジットと隠れた状態から指導を受けます。

トレーニング中に、値ベクトルとパラメーター行列の値が更新され、デプロイメント中に、量子化された 1 ビットのパラメーター行列を計算に直接使用できます。

モデルが大きいほど効果は高くなります

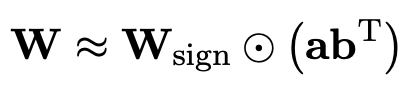

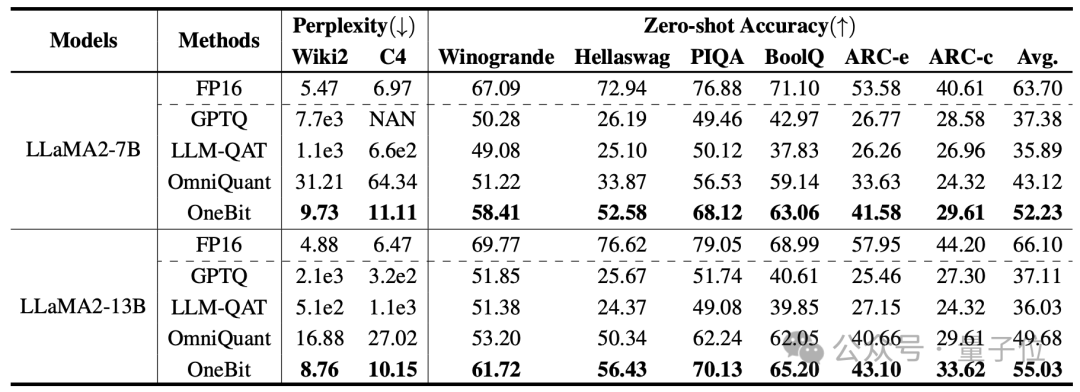

著者が選択したベースラインは、FP16 Transformer、GPTQ、LLM-QAT、および OmniQuant です。

最後の 3 つはすべて、定量化の分野における古典的な強力なベースラインであり、特に OmniQuant は、著者以前の最強の 2 ビット量子化手法です。

現時点では 1 ビットの重み量子化に関する研究がないため、著者は OneBit フレームワークに対してのみ 1 ビットの重み量子化を使用し、他の方式には 2 ビットの量子化設定を採用します。

蒸留データの場合、著者は LLM-QAT に従い、教師モデルのセルフサンプリングを使用してデータを生成しました。

著者は、1.3B から 13B までのさまざまなサイズのモデル、OPT および LLaMA-1/2 をさまざまなシリーズで使用して、OneBit の有効性を証明しています。評価指標としては、検証セットの複雑さと常識推論のゼロショット精度が用いられます。詳細については論文を参照してください。

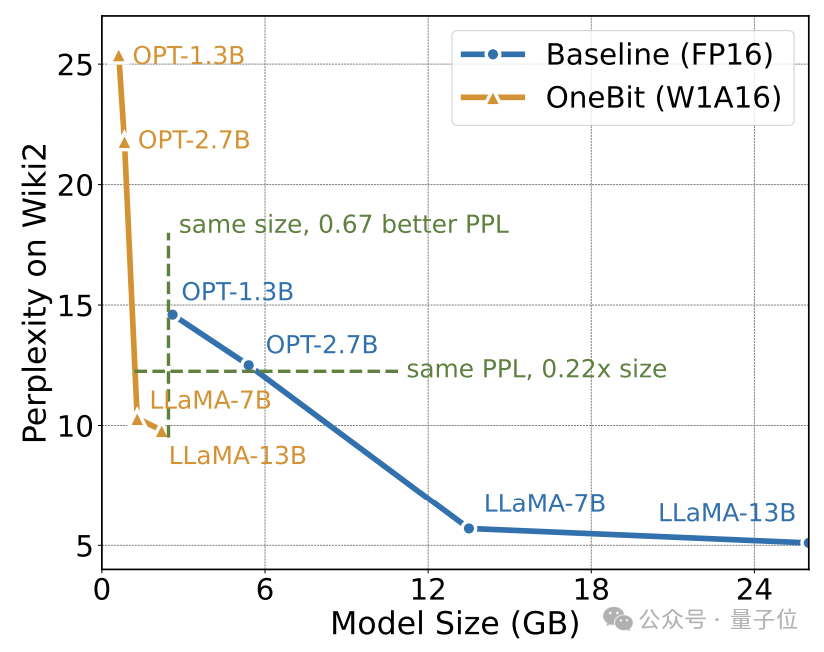

上の表は、1 ビット量子化における他の方法と比較した OneBit の利点を示しています。 モデルが大きいほど、OneBit の効果が高まることは注目に値します。

モデル サイズが大きくなるにつれて、OneBit 定量的モデルは FP16 モデルよりも混乱を軽減します。

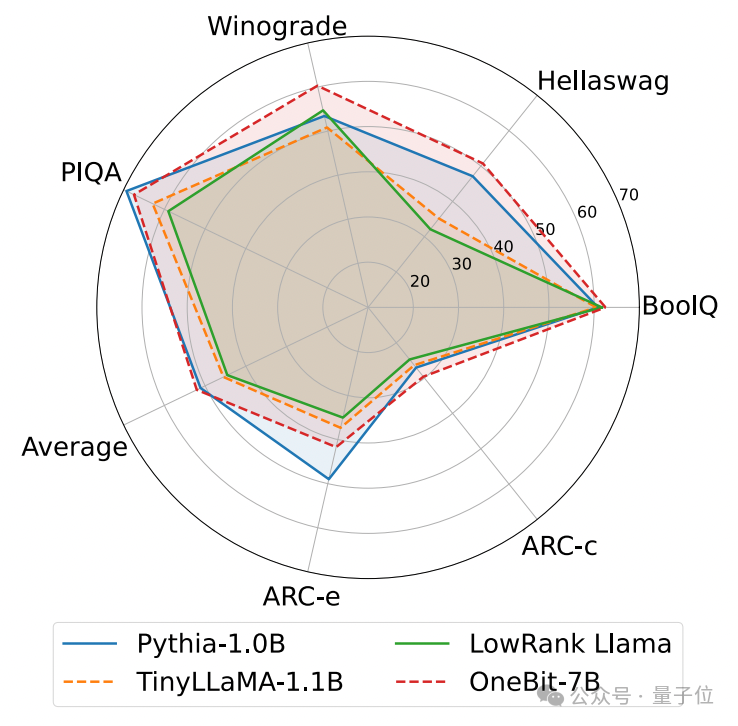

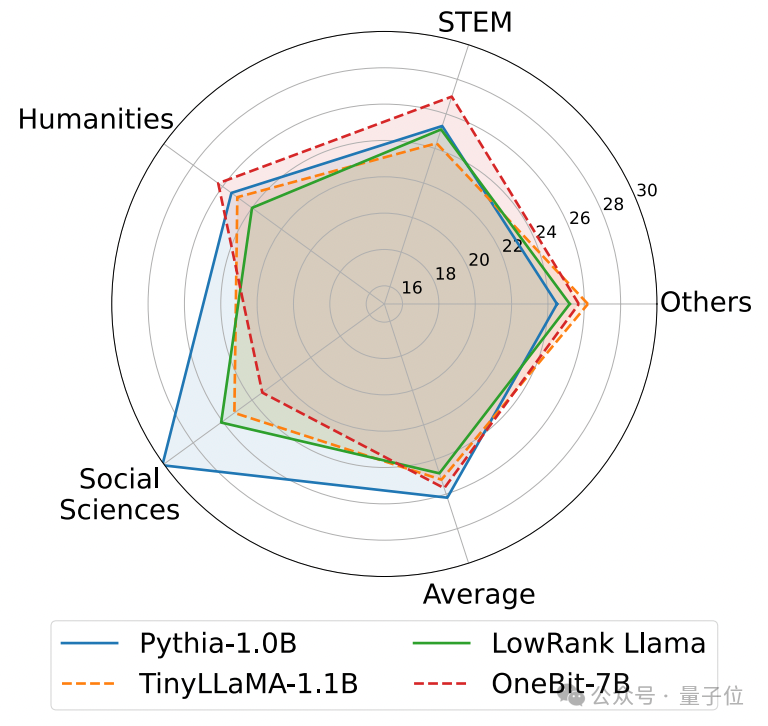

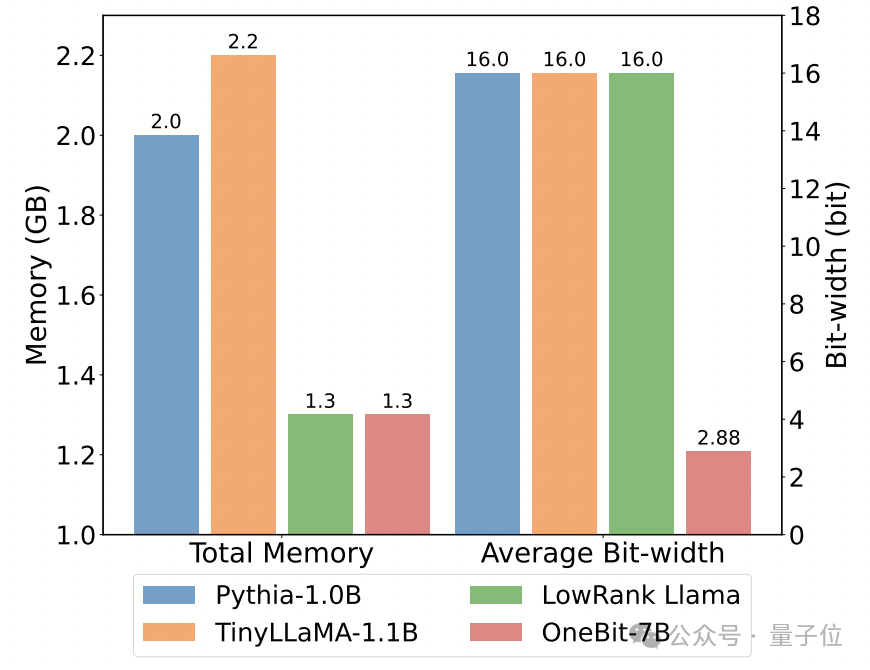

以下は、いくつかの異なる小型モデルの常識的な推論、世界の知識、および空間占有です:

著者は、いくつかの異なるタイプの小型モデルのサイズと実際の機能も比較しました。

著者は、OneBit-7B が平均ビット幅が最も小さく、占有スペースが最も小さく、必要なトレーニング ステップが比較的少ないにもかかわらず、常識的推論能力の点で他のモデルに劣らないことを発見しました。

同時に、著者は、OneBit-7B モデルには社会科学の分野で深刻な知識の忘却があることも発見しました。

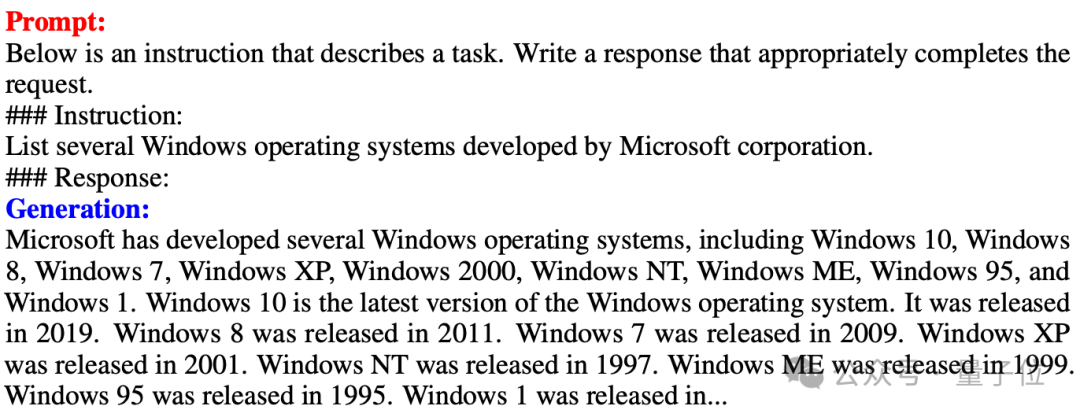

△FP16 リニア レイヤーと OneBit リニア レイヤーの比較 OneBit-7B 命令の微調整後のテキスト生成の例

上の図にも示されていますOneBit- 7B 命令を微調整した後の Text 生成例。 OneBit-7B は SFT ステージの能力を効果的に獲得しており、パラメータの合計がわずか 1.3GB (FP16 の 0.6B モデルに相当) であるにもかかわらず、比較的スムーズにテキストを生成できることがわかります。全体として、OneBit-7B は実用的な応用価値を示しています。

分析と考察

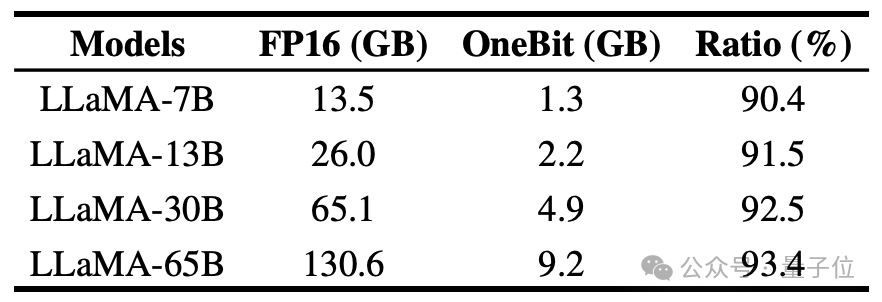

著者は、さまざまなサイズの LLaMA モデルに対する OneBit の圧縮率を示しており、モデルに対する OneBit の圧縮率が驚くべき 90% を超えていることがわかります。

#特に、OneBit はモデルが増えるにつれて圧縮率が高くなります。

これは、より大きなモデルにおける著者の方法の利点を示しています。つまり、より高い圧縮率でより大きな限界ゲイン (複雑さ) が得られます。さらに、著者のアプローチは、サイズとパフォーマンスの間で適切なトレードオフを実現します。

1 ビット定量モデルには計算上の利点があり、非常に重要です。パラメーターの純粋なバイナリ表現は、スペースを大幅に節約できるだけでなく、行列乗算のハードウェア要件も軽減します。

高精度モデルにおける行列乗算の要素乗算を効率的なビット演算に変えることができ、ビットの割り当てと加算のみで行列積が完成するため、応用の可能性が非常に高いです。

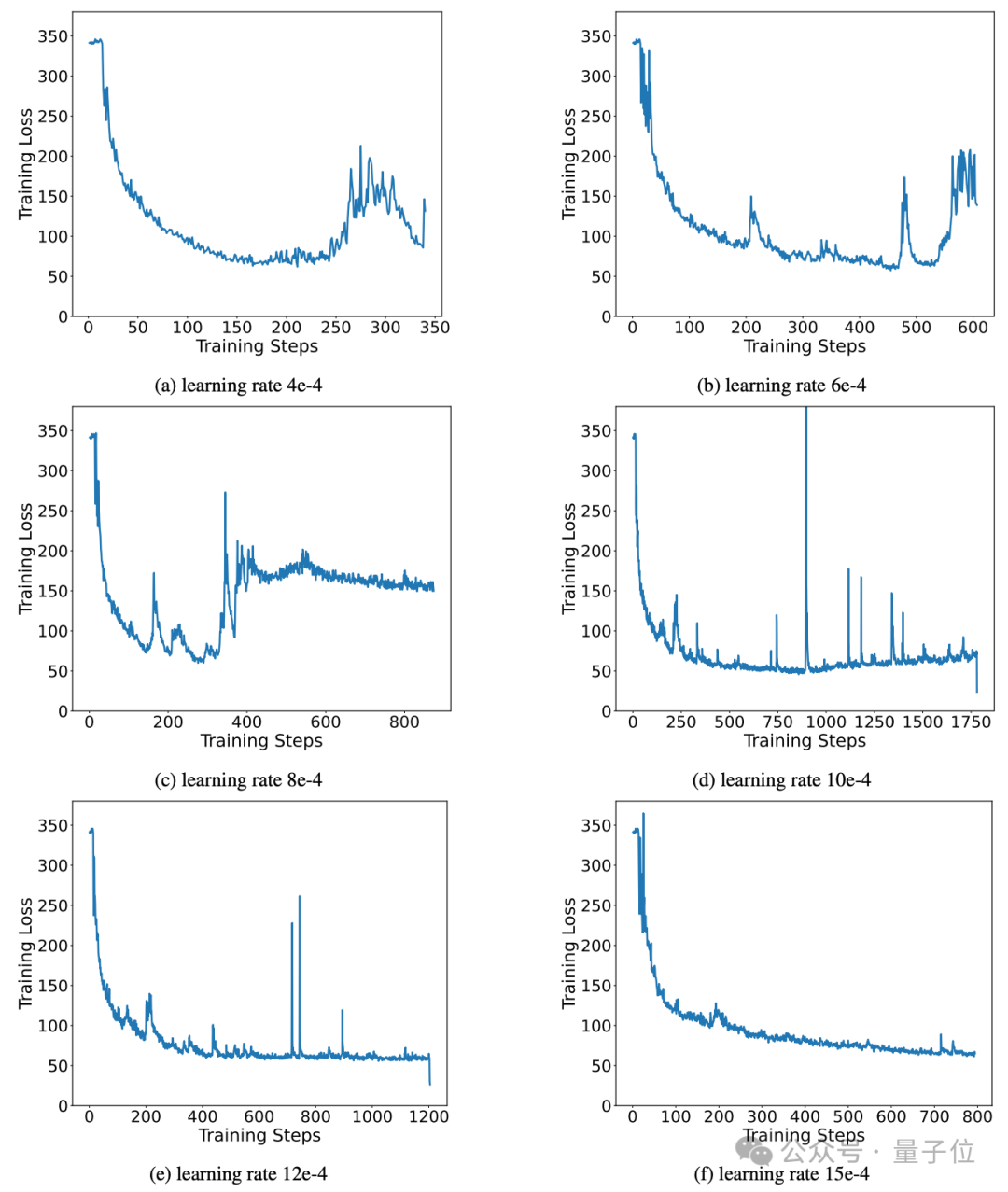

さらに、著者の方法は、トレーニング プロセス中に優れた安定した学習能力を維持します。

実際、バイナリ ネットワーク トレーニングの不安定性の問題、ハイパーパラメータに対する感度、および収束の難しさは、研究者によって常に懸念されてきました。

著者は、モデルの安定した収束を促進する上での高精度の値ベクトルの重要性を分析しています。

これまでの研究では 1 ビット モデル アーキテクチャが提案され、それを使用してモデルを最初からトレーニングしていました (BitNet [1] など)。しかし、ハイパーパラメータの影響を受けやすく、完全にトレーニングされた高レベルのモデルから学習を転送するのは困難でした。精密モデル。著者はまた、知識蒸留における BitNet のパフォーマンスを試しましたが、そのトレーニングが十分に安定していないことがわかりました。

要約

著者は、1ビット重み量子化のためのモデル構造とそれに対応するパラメータ初期化方法を提案しました。

さまざまなサイズとシリーズのモデルでの広範な実験により、OneBit には代表的な強力なベースラインで明らかな利点があり、モデルのサイズとパフォーマンスの間で適切なトレードオフが達成されることが示されています。

さらに、著者はこの極低ビット量子化モデルの機能と展望をさらに分析し、将来の研究への指針を提供します。

論文アドレス: https://arxiv.org/pdf/2402.11295.pdf

以上が大型モデルを90%「スリム化」!清華大学とハルビン工業大学は、容量の 83% を維持しながら 1 ビット量子化という極端な圧縮ソリューションを提案しました。の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

Video Face Swap

完全無料の AI 顔交換ツールを使用して、あらゆるビデオの顔を簡単に交換できます。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

1663

1663

14

14

1419

1419

52

52

1313

1313

25

25

1264

1264

29

29

1237

1237

24

24

2025年のトップ10の通貨取引プラットフォームのどれがトップ10の通貨取引プラットフォームの1つです

Apr 28, 2025 pm 08:12 PM

2025年のトップ10の通貨取引プラットフォームのどれがトップ10の通貨取引プラットフォームの1つです

Apr 28, 2025 pm 08:12 PM

2025年の世界の上位10の暗号通貨取引所には、Binance、Okx、Gate.io、Coinbase、Kraken、Huobi、Bitfinex、Kucoin、Bittrex、Poloniexが含まれます。これらはすべて、高い取引量とセキュリティで知られています。

ビットコインの価値はいくらですか

Apr 28, 2025 pm 07:42 PM

ビットコインの価値はいくらですか

Apr 28, 2025 pm 07:42 PM

ビットコインの価格は20,000ドルから30,000ドルの範囲です。 1。ビットコインの価格は2009年以来劇的に変動し、2017年には20,000ドル近くに達し、2021年にはほぼ60,000ドルに達しました。2。価格は、市場需要、供給、マクロ経済環境などの要因の影響を受けます。 3.取引所、モバイルアプリ、ウェブサイトを通じてリアルタイム価格を取得します。 4。ビットコインの価格は非常に不安定であり、市場の感情と外部要因によって駆動されます。 5.従来の金融市場と特定の関係を持ち、世界の株式市場、米ドルの強さなどの影響を受けています。6。長期的な傾向は強気ですが、リスクを慎重に評価する必要があります。

世界のトップ10の通貨取引プラットフォームのどれがトップ10の通貨取引プラットフォームの最新バージョンです

Apr 28, 2025 pm 08:09 PM

世界のトップ10の通貨取引プラットフォームのどれがトップ10の通貨取引プラットフォームの最新バージョンです

Apr 28, 2025 pm 08:09 PM

世界の上位10の暗号通貨取引プラットフォームには、Binance、Okx、Gate.io、Coinbase、Kraken、Huobi Global、Bitfinex、Bittrex、Kucoin、Poloniexが含まれます。これらはすべて、さまざまな取引方法と強力なセキュリティ対策を提供します。

復号化GATE.IO戦略のアップグレード:Memebox 2.0でCrypto Asset Managementを再定義する方法は?

Apr 28, 2025 pm 03:33 PM

復号化GATE.IO戦略のアップグレード:Memebox 2.0でCrypto Asset Managementを再定義する方法は?

Apr 28, 2025 pm 03:33 PM

Memebox 2.0は、革新的なアーキテクチャとパフォーマンスのブレークスルーを通じて、暗号資産管理を再定義します。 1)3つの主要な問題点を解決します。資産サイロ、収入の減少、セキュリティと利便性のパラドックスです。 2)インテリジェントアセットハブ、動的リスク管理およびリターンエンハンスメントエンジン、クロスチェーン移動速度、平均降伏率、およびセキュリティインシデント応答速度が向上します。 3)ユーザーに、ユーザー価値の再構築を実現し、資産の視覚化、ポリシーの自動化、ガバナンス統合を提供します。 4)生態学的なコラボレーションとコンプライアンスの革新により、プラットフォームの全体的な有効性が向上しました。 5)将来的には、スマート契約保険プール、予測市場統合、AI主導の資産配分が開始され、引き続き業界の発展をリードします。

トップ通貨取引プラットフォームは何ですか?トップ10の最新の仮想通貨交換

Apr 28, 2025 pm 08:06 PM

トップ通貨取引プラットフォームは何ですか?トップ10の最新の仮想通貨交換

Apr 28, 2025 pm 08:06 PM

現在、上位10の仮想通貨交換にランクされています。1。Binance、2。Okx、3。Gate.io、4。CoinLibrary、5。Siren、6。HuobiGlobal Station、7。Bybit、8。Kucoin、9。Bitcoin、10。BitStamp。

トップ10の仮想通貨取引アプリは何ですか?最新のデジタル通貨交換ランキング

Apr 28, 2025 pm 08:03 PM

トップ10の仮想通貨取引アプリは何ですか?最新のデジタル通貨交換ランキング

Apr 28, 2025 pm 08:03 PM

Binance、OKX、Gate.ioなどの上位10のデジタル通貨交換は、システムを改善し、効率的な多様化したトランザクション、厳格なセキュリティ対策を改善しました。

CでChronoライブラリを使用する方法は?

Apr 28, 2025 pm 10:18 PM

CでChronoライブラリを使用する方法は?

Apr 28, 2025 pm 10:18 PM

CでChronoライブラリを使用すると、時間と時間の間隔をより正確に制御できます。このライブラリの魅力を探りましょう。 CのChronoライブラリは、時間と時間の間隔に対処するための最新の方法を提供する標準ライブラリの一部です。 Time.HとCtimeに苦しんでいるプログラマーにとって、Chronoは間違いなく恩恵です。コードの読みやすさと保守性を向上させるだけでなく、より高い精度と柔軟性も提供します。基本から始めましょう。 Chronoライブラリには、主に次の重要なコンポーネントが含まれています。STD:: Chrono :: System_Clock:現在の時間を取得するために使用されるシステムクロックを表します。 STD :: Chron

CでハイDPIディスプレイを処理する方法は?

Apr 28, 2025 pm 09:57 PM

CでハイDPIディスプレイを処理する方法は?

Apr 28, 2025 pm 09:57 PM

CでのハイDPIディスプレイの取り扱いは、次の手順で達成できます。1)DPIを理解してスケーリングし、オペレーティングシステムAPIを使用してDPI情報を取得し、グラフィックスの出力を調整します。 2)クロスプラットフォームの互換性を処理し、SDLやQTなどのクロスプラットフォームグラフィックライブラリを使用します。 3)パフォーマンスの最適化を実行し、キャッシュ、ハードウェアアクセラレーション、および詳細レベルの動的調整によりパフォーマンスを改善します。 4)ぼやけたテキストやインターフェイス要素などの一般的な問題を解決し、DPIスケーリングを正しく適用することで解決します。