誤解されている「中国版Sora」の背後にあるバイトダンスにはどのような技術があるのでしょうか?

2024 年の初めに、OpenAI は生成 AI の分野で大ヒット作「Sora」をリリースしました。

近年、ビデオ生成分野における技術の進歩は加速し続けており、多くのテクノロジー企業も関連する技術の進歩と導入結果を発表しています。これに先立って、Pika と Runway も同様の製品を発売していましたが、Sora がリリースしたデモは明らかに単独でビデオ生成分野の基準を引き上げました。

今後の競争において、どの企業がSoraを超える製品を最初に生み出すかはまだ未知数です。

国内では、多くの大手テクノロジー企業に注目が集まっています。

以前、Bytedance が Sora のリリース前に Boximator と呼ばれるビデオ生成モデルを開発していたと報告されました。

Boximator は、ビデオ内のオブジェクトの生成を正確に制御する方法を提供します。ユーザーは複雑なテキスト命令を記述する必要はなく、図に示すように、参照イメージ内にボックスを描画してターゲットを選択し、追加のボックスと線を追加してターゲットの終了位置またはクロスフレーム モーション パス全体を定義するだけです。次の図:

ByteDance はこれに対して控えめな態度を維持しており、関係者は Boximator が技術的手法を研究するための彼らのプロジェクトであるとメディアに答えたビデオ生成の分野でオブジェクトの動きを制御するために使用されます。まだ完全には完成しておらず、画質、忠実度、ビデオ再生時間の点で、主要な海外ビデオ生成モデルとの間には依然として大きなギャップがあります。

関連する技術文書 (https://arxiv.org/abs/2402.01566) には、Boximator がプラグインとして実行され、既存のビデオ生成と簡単に統合できることが記載されています。モデルを統合します。モーション コントロール機能を追加することで、ビデオ品質を維持するだけでなく、柔軟性と使いやすさも向上します。

ビデオ生成には複数の細分化されたテクノロジが含まれており、画像/ビデオの理解、画像生成、超解像度などのテクノロジと密接に関連しています。詳細な調査の結果、ByteDance が複数の部門でいくつかの研究結果を公表していることが判明しました。

この記事では、ByteDance のインテリジェント創造チームによる 9 件の研究を紹介します。これには、Wensheng Picture、Wensheng Video、Tusheng Video、Video Understanding などの多くの最新成果が含まれています。これらの研究から視覚生成モデルを探索する技術の進歩を追跡することもできます。

ビデオ生成に関して、Byte にはどのような実績がありますか?

今年 1 月初旬、ByteDance はビデオ生成モデル MagicVideo-V2 をリリースし、かつてコミュニティで激しい議論を巻き起こしました。

- #論文タイトル: MagicVideo-V2: マルチステージの高美性ビデオ世代

- 論文リンク: https://arxiv.org/abs/2401.04468

- #プロジェクトアドレス: https://magicvideov2.github.io/

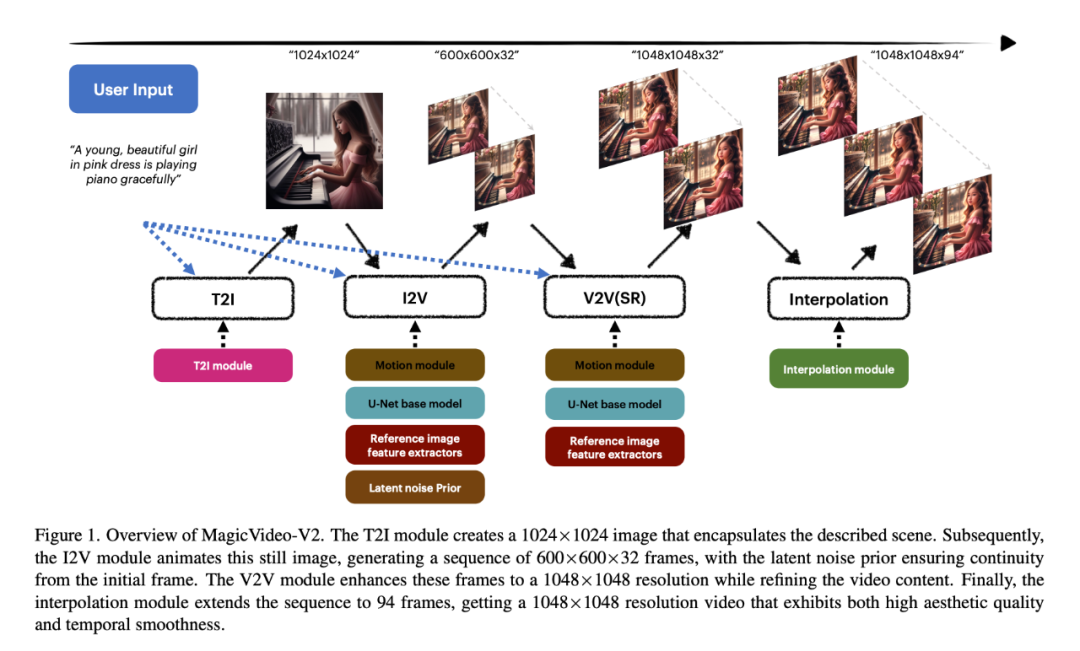

MagicVideo-V2 のイノベーションは、テキストから画像へのモデル、ビデオ モーション ジェネレーターです。 、参考画像埋め込みモジュールとフレーム補間モジュールは、エンドツーエンドのビデオ生成パイプラインに統合されています。このアーキテクチャ設計のおかげで、MagicVideo-V2 は、美しい高解像度のビデオを生成するだけでなく、忠実度や滑らかさも比較的良好で、「美観」の面で安定した高レベルのパフォーマンスを維持することができます。

具体的には、研究者らはまず T2I モジュールを使用して、説明されたシーンをカプセル化する 1024 x 1024 の画像を作成しました。次に、I2V モジュールはこの静止画像をアニメーション化して 600×600×32 の一連のフレームを生成します。このとき、基礎となるノイズによって初期フレームからの連続性が保証されます。 V2V モジュールは、ビデオ コンテンツを調整しながら、これらのフレームを 1048 × 1048 の解像度に拡張します。最後に、補間モジュールはシーケンスを 94 フレームに拡張し、解像度 1048 x 1048 のビデオを生成します。生成されたビデオは、高い美的品質と時間的な滑らかさを備えています。

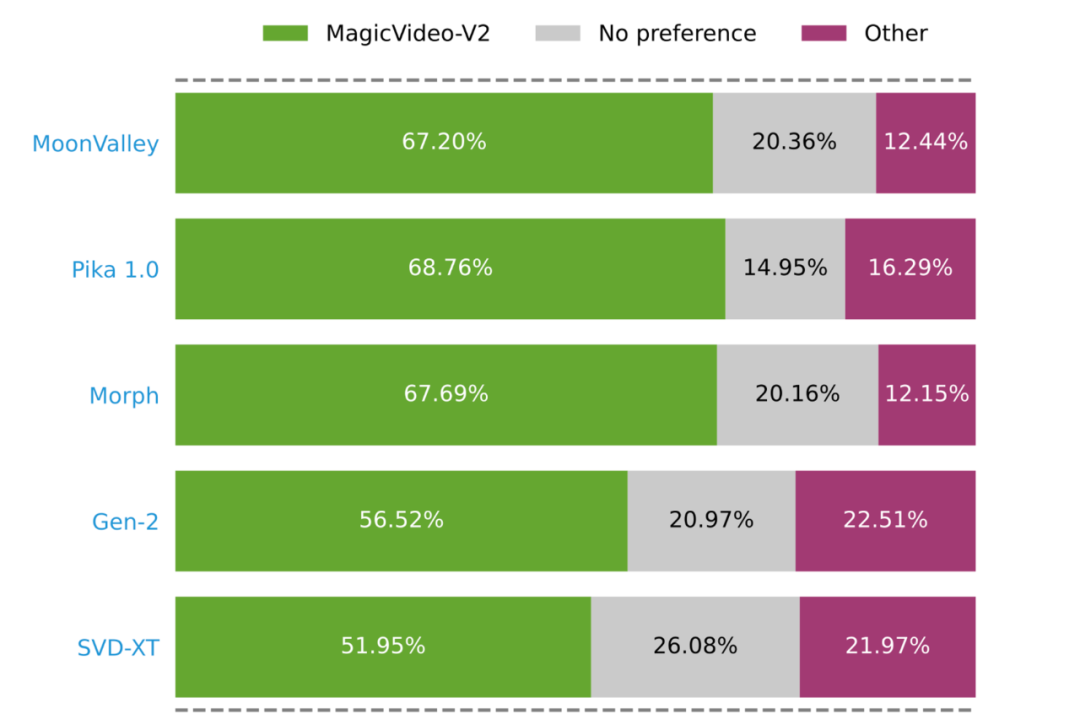

研究者が実施した大規模なユーザー評価により、MagicVideo-V2 がいくつかのよく知られた T2V 方式 (グリーン、グレー、ピンク) よりも好まれることが証明されました。バーは、MagicVideo-V2 がそれぞれ良い、普通、または悪いと評価されていることを表します)。

高品質ビデオ生成の裏側

視覚学習と言語学習を統合する研究パラダイム

MagicVideo-V2 の論文から、ビデオ生成テクノロジーの進歩は、Vincent Picture や Picture Video などの AIGC テクノロジーの道を切り開くことと切り離せないことがわかります。審美性の高いコンテンツを生成するための基礎は、理解、特に視覚と言語のモダリティを学習および統合するモデルの能力の向上にあります。

近年、大規模な言語モデルの拡張性と一般的な機能により、視覚と言語学習を統合する研究パラダイムが生まれています。 「視覚」と「言語」という 2 つのモダリティ間の自然なギャップを埋めるために、研究者は、事前にトレーニングされた大規模な言語モデルと視覚モデルの表現を接続し、クロスモーダル特徴を抽出し、視覚的な質問応答などのタスクを完了します。画像のキャプション、視覚的な知識の推論、対話などのタスク。

これらの方向で、ByteDance も関連する調査を行っています。

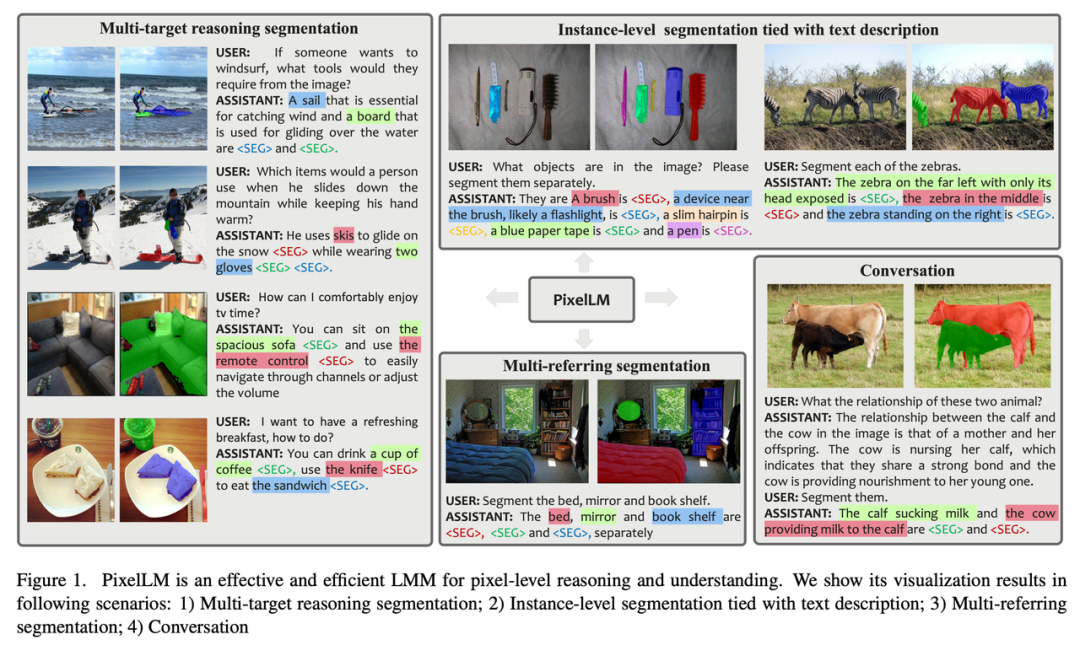

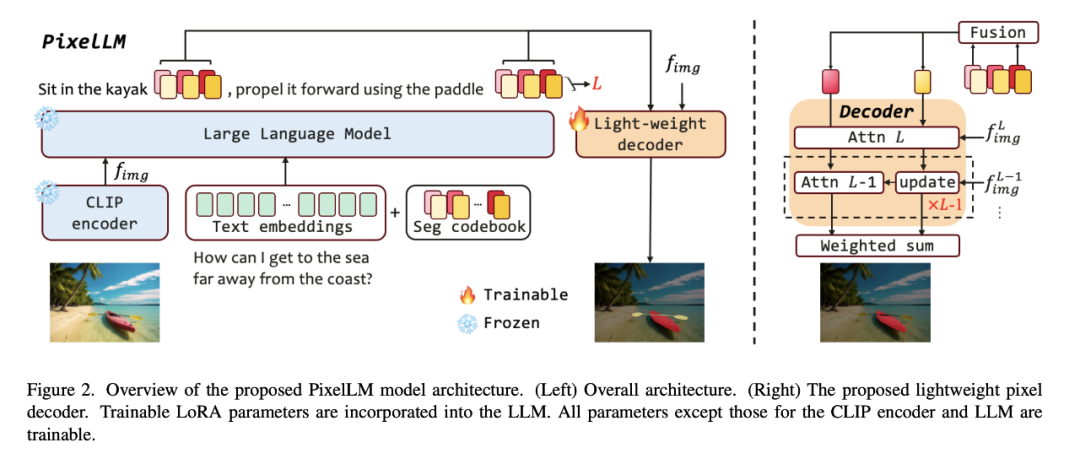

たとえば、オープンワールド ビジョン タスクにおける多目的推論とセグメンテーションの課題に対処するために、ByteDance は北京交通大学および北京科学技術大学の研究者と協力して、 PixelLM. と呼ばれる効率的な大規模ピクセルレベルの推論モデルを提案し、それをオープンソースにします。

- 論文タイトル: PixelLM: 大規模マルチモーダル モデルを使用したピクセル推論

- #論文リンク: https://arxiv.org/pdf/2312.02228.pdf

- プロジェクト アドレス: https://pixellm.github.io/

画像と比較して、ビデオ コンテンツが関係する場合、モデルが直面する課題は大幅に増加します。なぜなら、映像には豊富で多様な視覚情報が含まれているだけでなく、時系列のダイナミックな変化も含まれているからです。

既存の大規模なマルチモーダル モデルがビデオ コンテンツを処理する場合、通常、ビデオ フレームを一連のビジュアル トークンに変換し、それらを言語トークンと組み合わせてテキストを生成します。しかし、生成されるテキストの長さが長くなると、ビデオコンテンツの影響が徐々に弱まり、生成されるテキストが元のビデオコンテンツからどんどん乖離し、いわゆる「錯覚」が生じます。

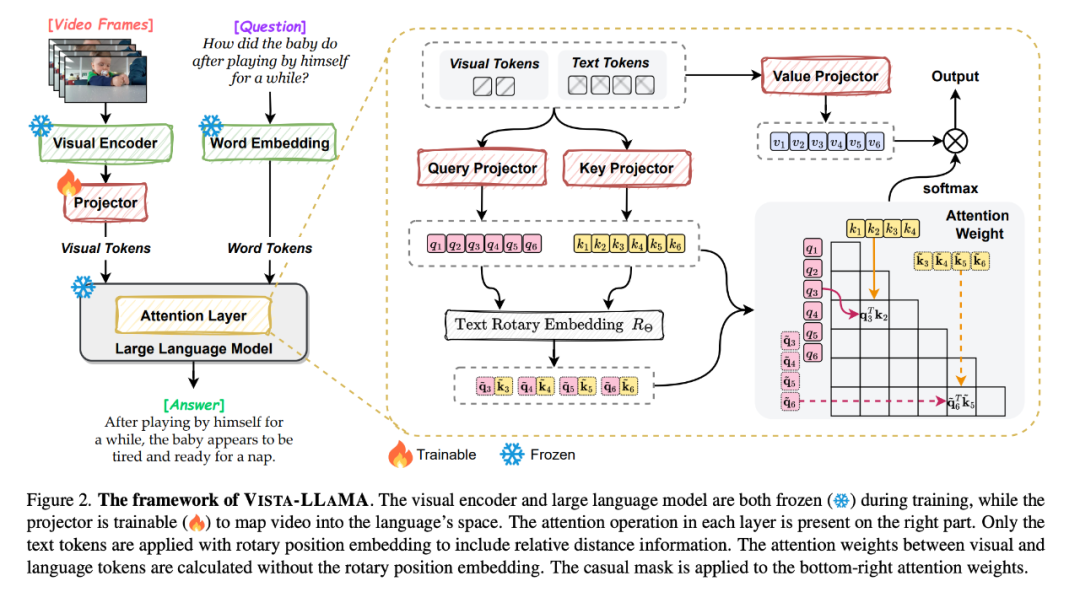

この問題に直面して、バイトダンスと浙江大学は、ビデオ コンテンツの複雑さに特化して設計されたマルチモーダル大規模モデルである Vista-LLaMA を提案しました。

- 論文タイトル: Vista-LLaMA: ビジュアル トークンまでの等距離による信頼性の高いビデオ ナレーター

- 論文リンク: https ://arxiv.org/pdf/2312.08870.pdf

- プロジェクトアドレス: https://jinxxian.github.io/Vista-LLaMA/

Vista-LLaMA は、ビジュアル等距離トークン アテンション (EDVT) という改良されたアテンション メカニズムを採用し、ビジュアル トークンやテキスト トークンを処理する際に従来のアテンション メカニズムを削除します。テキスト間の相対位置エンコーディングを保持します。この方法により、言語モデルによるビデオ コンテンツの理解の深さと正確さが大幅に向上します。

特に、Vista-LLaMA によって導入されたシリアル化ビジュアル プロジェクターは、ビデオの時系列分析問題に新しい視点を提供します。これは、線形投影レイヤーを通じてビジュアル トークンの時間的コンテキストをエンコードします。これにより、ビデオ内の動的な変化を理解するモデルの能力が強化されます。

ICLR 2024 に最近承認された研究では、ByteDance の研究者は、ビデオ コンテンツ学習能力の事前トレーニング方法の強化モデルも調査しました。

ビデオテキストトレーニングコーパスの規模と品質が限られているため、ほとんどの視覚言語基本モデルは事前トレーニングに画像テキストデータセットを採用し、主に視覚的意味表現モデリングに焦点を当てています。時間的な意味表現と相関は無視されます。

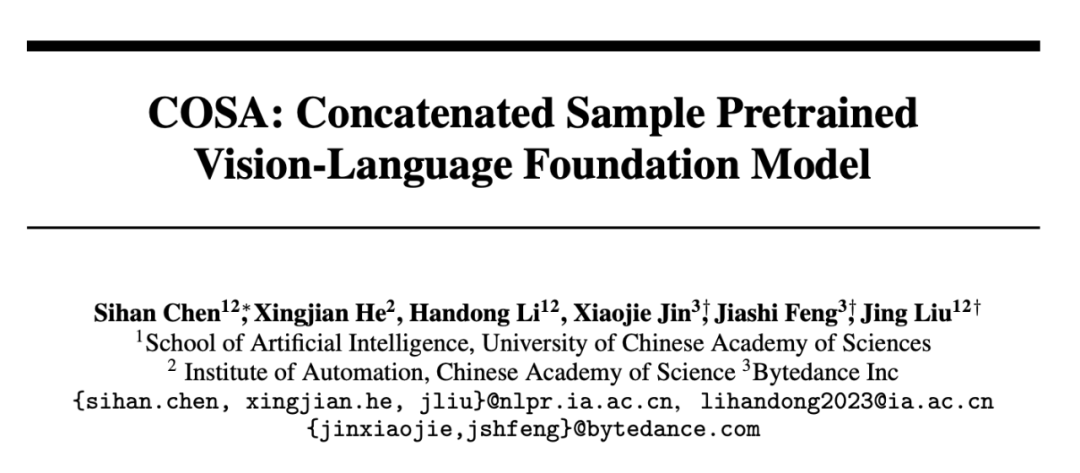

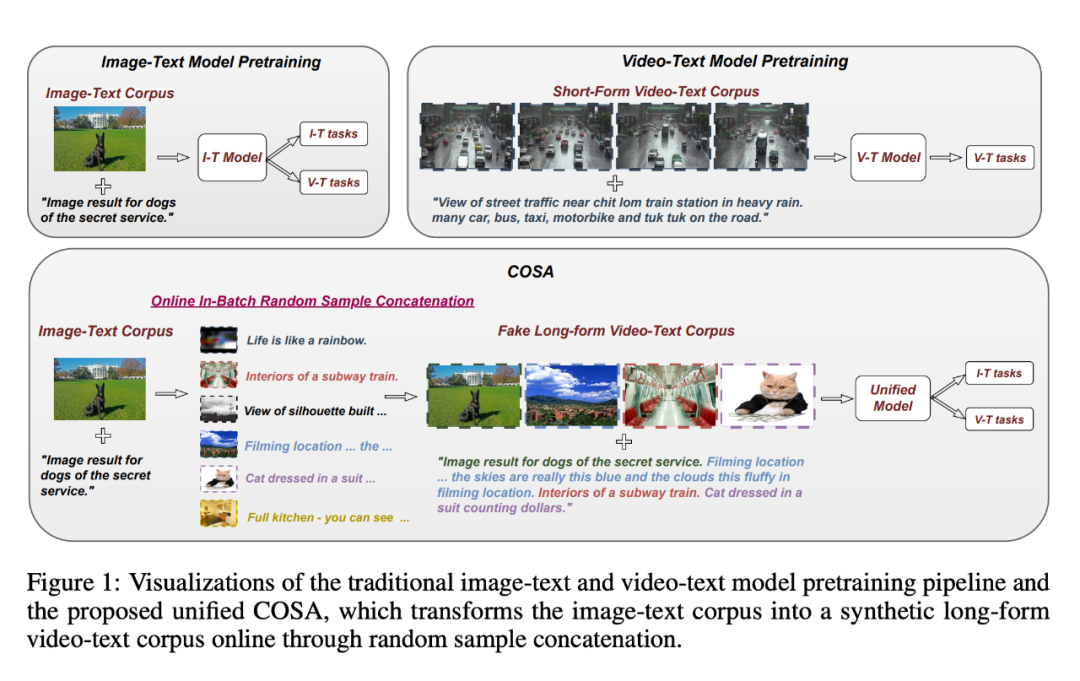

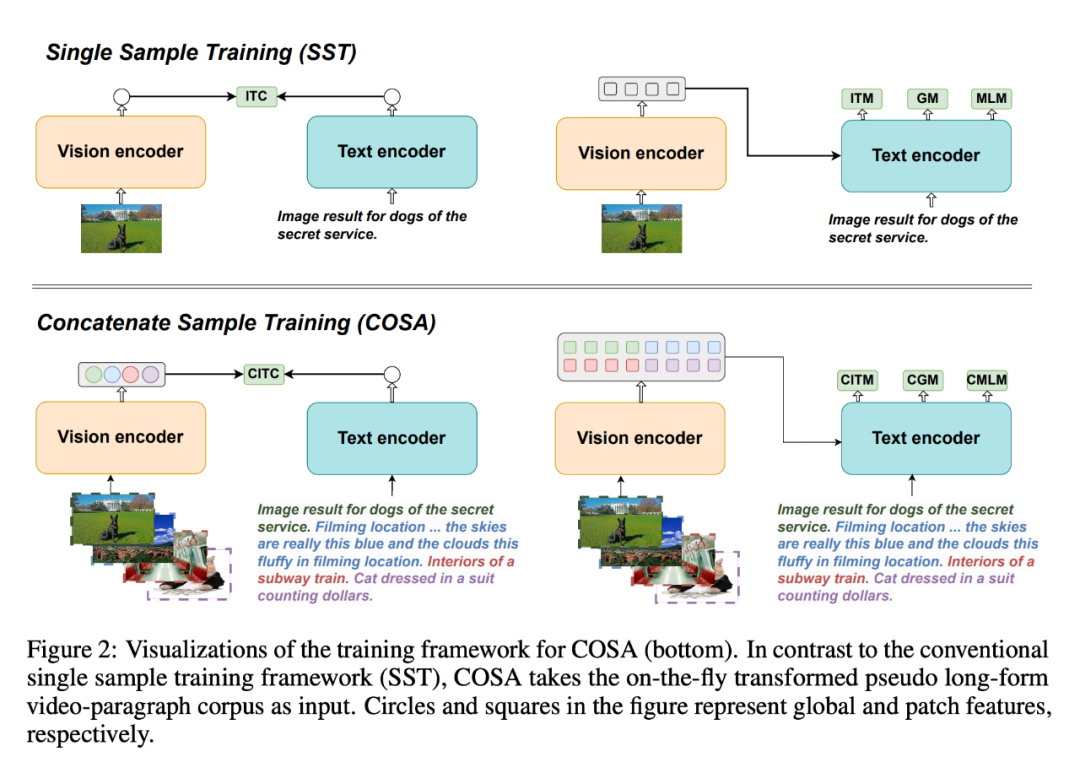

この問題を解決するために、彼らは、事前トレーニングされた視覚言語ベースモデルを連結したサンプルである COSA を提案しました。

- 論文タイトル: COSA: 連結サンプルの事前トレーニング済み視覚言語基盤モデル

- #論文リンク: https://arxiv.org/pdf/2306.09085.pdf # #プロジェクトのホームページ: https://github.com/TXH-mercury/COSA

- ##COSA は、視覚的なコンテンツとイベント レベルの一時的な手がかりに画像テキスト コーパスのみを使用します。関節モデリング。研究者らは、事前トレーニングのための入力として、複数の画像とテキストのペアを順番に連結しました。この変換により、既存の画像テキスト コーパスが擬似長編ビデオ段落コーパスに効果的に変換され、より豊かなシーン遷移とイベント説明の明示的な対応が可能になります。実験では、COSA が、長い/短いビデオ テキスト タスクや、検索、字幕、質問応答などの画像テキスト タスクを含む、さまざまな下流タスクのパフォーマンスを一貫して向上させることができることを示しています。

画像から動画へ

再認識される"拡散モデル"

視覚言語モデルに加えて、拡散モデルもほとんどのビデオ生成モデルで使用されるテクノロジです。

画像とテキストのペアの大規模なデータセットに対する厳密なトレーニングを通じて、拡散モデルは完全にテキスト情報に基づいて詳細な画像を生成できます。画像生成に加えて、拡散モデルは音声生成、時系列生成、3D 点群生成などにも使用できます。

たとえば、一部の短いビデオ アプリケーションでは、ユーザーは写真を提供するだけで偽のアクション ビデオを生成できます。

何百年もの間、神秘的な微笑みを保ち続けるモナリザは、すぐに走ることができます:

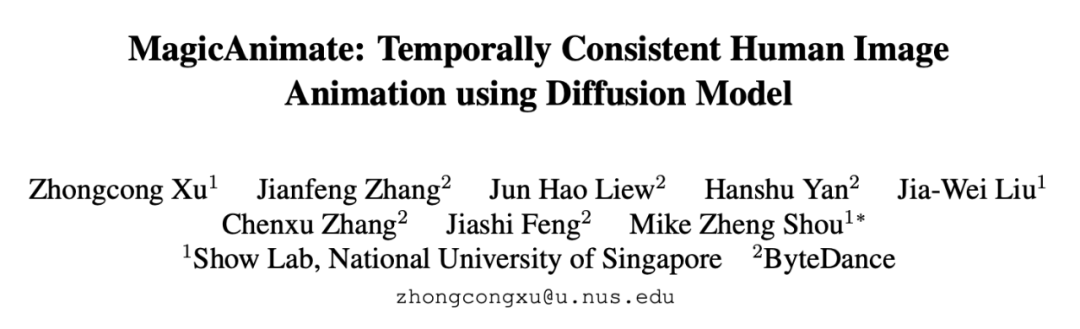

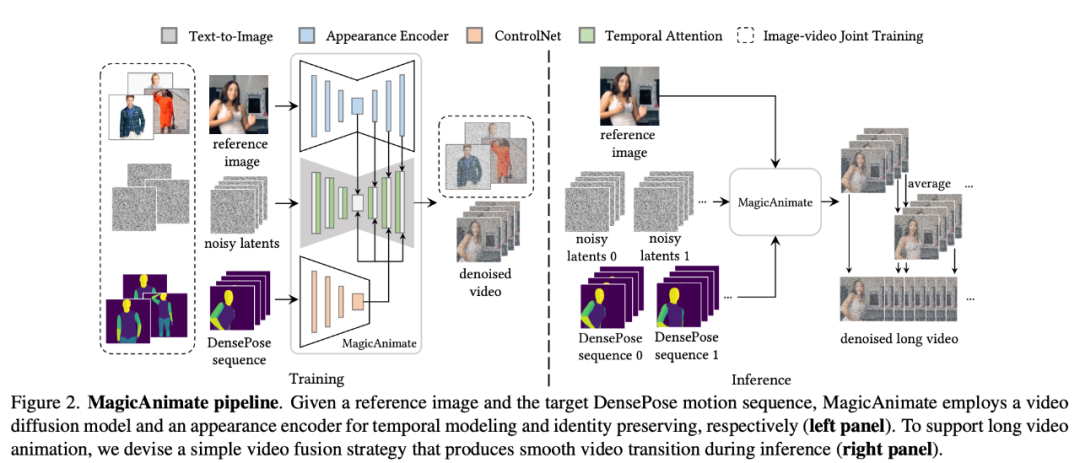

この興味深いアプリケーションの背後にあるテクノロジーは、シンガポール国立大学とバイトダンスの研究者が共同で立ち上げた「MagicAnimate」です。

MagicAnimate は、拡散ベースの人体イメージ アニメーション フレームワークで、アニメーション全体の時間的一貫性を確実に確保し、特定のモーション シーケンスに基づいてビデオを生成するタスクにおけるアニメーションの忠実度を向上させることができます。さらに、MagicAnimate プロジェクトはオープンソースです。

- 論文タイトル: MagicAnimate: 拡散モデルを使用した時間的に一貫した人間のイメージ アニメーション

- ##論文リンク: https://arxiv.org/pdf/2311.16498.pdf

- プロジェクト アドレス: https://showlab 。 github.io/magicanimate/

MagicAnimate はビデオ全体を重複するセグメントに分割し、重複するフレームの予測を単純に平均します。最後に、研究者らは、参照画像の保持能力と単一フレームの忠実性をさらに強化するために、画像とビデオの共同トレーニング戦略も導入しました。 MagicAnimate は実際の人間のデータのみでトレーニングされていますが、目に見えないドメイン データのアニメーション、テキストと画像の拡散モデルとの統合、複数人のアニメーションなど、さまざまなアプリケーション シナリオに一般化できる能力を実証しています。

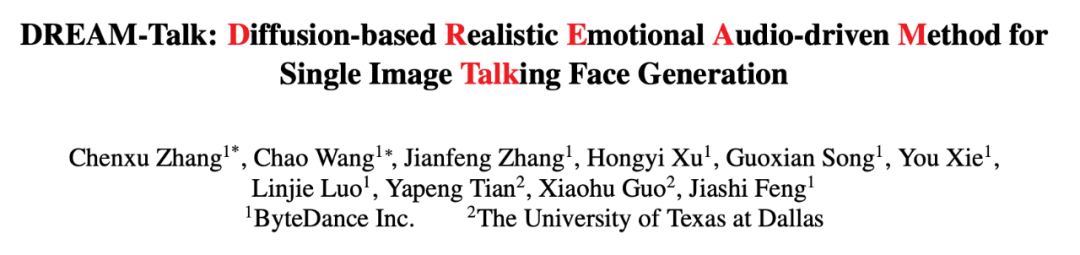

- 論文タイトル: DREAM-Talk: 拡散ベースのリアルで感情的な音声主導型単一画像の話す顔の生成方法

- #論文リンク: https://arxiv.org/pdf/2312.13578.pdf

- プロジェクトアドレス: https://dreamtalkemo.github.io/

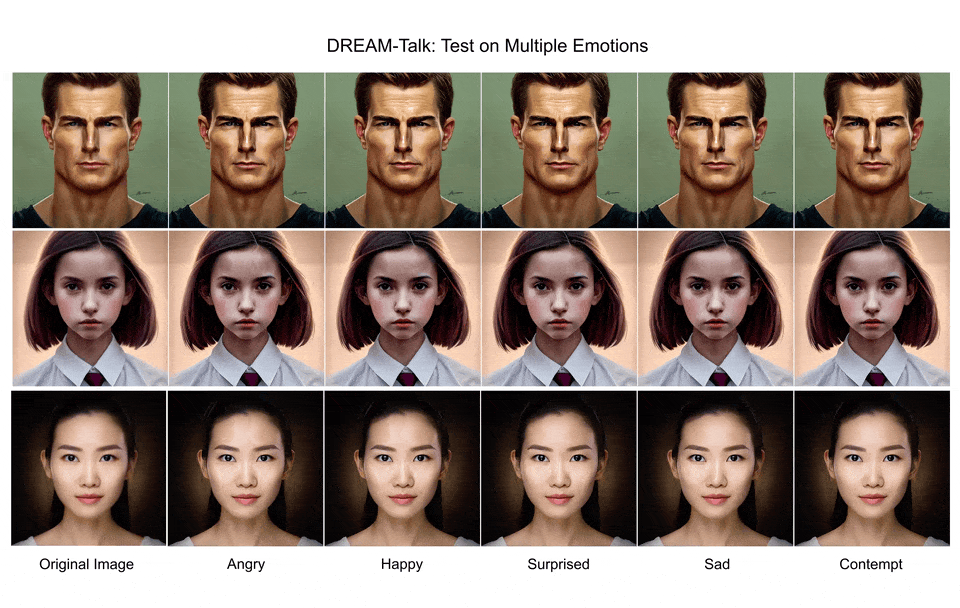

- このタスクが難しいことはわかっています。感情豊かな対話と正確なリップシンクを同時に実現するために、通常、リップシンクの精度を確保するために、表現力が大幅に犠牲になることがよくあります。

「DREAM-Talk」は、拡散ベースのオーディオ ドライバー フレームワークで、2 つの段階に分かれています。まず、研究者らは、オーディオと音声に基づいて使用できる新しい拡散モジュール EmoDiff を提案しました。参照 感情スタイルは、さまざまな非常にダイナミックな感情表現と頭のポーズを生成します。唇の動きと音声の間には強い相関関係があることを考慮して、研究者らは音声機能と感情的なスタイルを使用してダイナミクスを改善し、唇の同期精度を向上させました。また、ビデオ間レンダリング モジュールを導入して、あらゆるポートレートに表情と唇の動きを転送することを実現しました。

エフェクトの観点から見ると、DREAM-Talk は表現力、リップシンクの精度、知覚品質の点で確かに優れています:

しかし、画像生成であろうとビデオ生成であろうと、普及モデルルートに基づく現在の研究には、解決する必要のある基本的な課題がまだいくつかあります。

たとえば、多くの人が生成されたコンテンツ (SAG、DREAM-Talk に相当) の品質を懸念していますが、これは拡散モデルの生成プロセスのいくつかのステップに関連している可能性があります。 、ガイド付きサンプリングなど。

拡散モデルにおけるガイド付きサンプリングは、トレーニングを必要とするものとトレーニングを必要としないものの 2 つのカテゴリに大別できます。トレーニング不要のガイド付きサンプリングでは、既製の事前トレーニング済みネットワーク (美的評価モデルなど) を利用して生成プロセスをガイドし、より少ないステップでより高い精度で事前トレーニング済みモデルから知識を取得することを目指しています。現在のトレーニングなしのガイドなしサンプリング アルゴリズムは、クリーンな画像の 1 ステップ推定に基づいて、ガイド エネルギー関数を取得します。ただし、事前トレーニングされたネットワークはクリーンな画像でトレーニングされているため、クリーンな画像の 1 ステップ推定プロセスは不正確になる可能性があり、特に拡散モデルの初期段階では、初期のタイム ステップで不正確なガイダンスが発生する可能性があります。

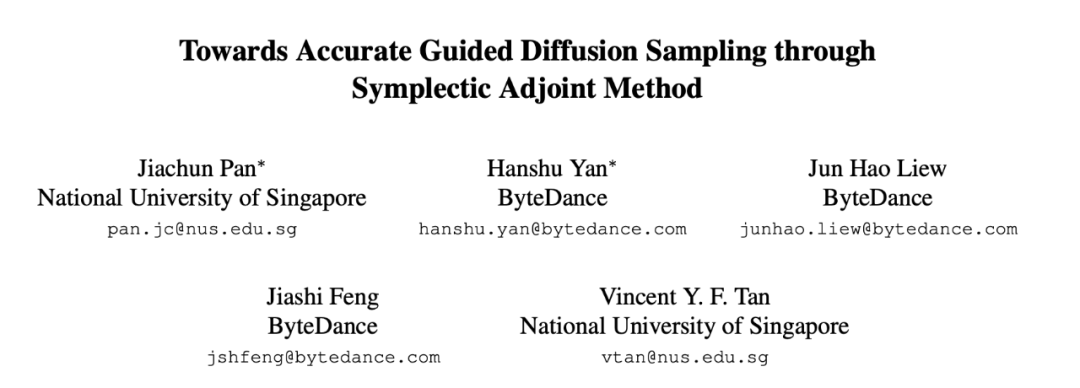

この問題に対応して、ByteDance とシンガポール国立大学の研究者は共同で Symplectic Adjoint Guide (SAG) を提案しました。

- 論文タイトル: シンプレクティック随伴法による正確なガイド付き拡散サンプリングに向けて

- 論文リンク: https://arxiv.org/pdf/2312.12030.pdf

ICLR 2024 に最近選ばれた論文は、「拡散確率モデルの勾配逆伝播の臨界感度法」に焦点を当てています。

- 論文タイトル: 拡散確率モデルの勾配逆伝播のための随伴感度法

- 論文リンク: https://arxiv.org/pdf/2307.10711.pdf

- # #拡散確率モデルのサンプリング プロセスにはノイズ除去 U-Net への再帰呼び出しが含まれるため、単純勾配バックプロパゲーションではすべての反復の中間状態を保存する必要があり、その結果、メモリ消費量が非常に多くなります。

この論文では、研究者によって提案された AdjointDPM は、まず、対応する確率フロー ODE を解くことによって拡散モデルから新しいサンプルを生成します。次に、別の拡張 ODE を解くことにより、隣接感度法を使用してモデル パラメーター (調整信号、ネットワークの重み、初期ノイズを含む) の損失の勾配が逆伝播されます。順方向生成と勾配逆伝播中の数値誤差を減らすために、研究者らは確率的フロー ODE と拡張 ODE を指数積分を使用して単純な非剛体 ODE にさらに再パラメータ化しました。

研究者らは、AdjointDPM が 3 つのタスクにおいて非常に価値があると指摘しました。視覚効果を認識されたテキスト埋め込みに変換すること、特定の種類の様式化に対する拡散確率モデルを微調整すること、および初期ノイズを最適化することです。セキュリティ監査用の敵対的サンプルを生成して、最適化作業のコストを削減します。

視覚認識タスクでは、テキストから画像への拡散モデルを特徴抽出器として使用する方法もますます注目を集めています。この方向に向けて、ByteDance の研究者は論文の中でシンプルで効果的なソリューションを提案しました。

論文のタイトル; メタ プロンプトを使用した視覚認識のための拡散モデルの利用

論文のタイトル; メタ プロンプトを使用した視覚認識のための拡散モデルの利用

- #論文リンク: https://arxiv.org/pdf/2312.14733.pdf

- この論文の中核となるイノベーションは、学習可能な埋め込み (メタキュー) がトレーニングされた拡散モデルに導入され、追加のマルチモーダル モデルに依存して画像キャプションを生成したり、データセットのクラス ラベルを使用したりすることなく、知覚特徴を抽出します。

「中国版ソラ」誕生まで、あとどれだけある?

これらの新しい論文では、ByteDance などの国内テクノロジー企業によるビデオ生成テクノロジーの一連の積極的な研究について学びました。

しかし、Sora と比較すると、ByteDance であれ、AI ビデオ生成分野の多くのスター企業であれ、目に見えるギャップがあります。 Sora の利点は、スケーリング則への信念と画期的な技術革新に基づいており、パッチによるビデオ データの統合、Difffusion Transformer などの技術アーキテクチャと DALL・E 3 の意味理解機能に依存しており、まさに「はるか先」を実現しています。

2022 年の文生図の爆発から 2024 年のソラの出現に至るまで、人工知能分野における技術の反復の速度は誰もが想像を超えています。 2024年には、この分野でさらに「注目の製品」が出てくると思います。

Byte は明らかに、テクノロジーの研究開発への投資も強化しています。最近、Google VideoPoet プロジェクト リーダーの Jiang Lu 氏と、オープンソース マルチモーダル大規模モデル LLaVA チームのメンバーで元 Microsoft Research 主任研究員の Chunyuan Li 氏が ByteDance インテリジェント創造チームに加わったことが明らかになりました。チームは採用活動も精力的に行っており、公式ウェブサイトには大規模モデルアルゴリズムに関連する求人が多数掲載されている。

Byte だけでなく、BAT などの古い巨人も多くの目を引くビデオ生成研究結果を発表しており、多くの大手モデルのスタートアップはさらに積極的です。 Vincent ビデオ テクノロジーではどのような新たな進歩が起こるのでしょうか?見てみましょう。

以上が誤解されている「中国版Sora」の背後にあるバイトダンスにはどのような技術があるのでしょうか?の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7499

7499

15

15

1377

1377

52

52

77

77

11

11

19

19

52

52

mysqlデータテーブルフィールド操作ガイドの追加、変更、削除方法ガイド

Apr 11, 2025 pm 05:42 PM

mysqlデータテーブルフィールド操作ガイドの追加、変更、削除方法ガイド

Apr 11, 2025 pm 05:42 PM

MySQLのフィールド操作ガイド:フィールドを追加、変更、削除します。フィールドを追加:table table_nameを変更するcolumn_name data_type [not null] [default default_value] [プライマリキー] [auto_increment]フィールドの変更:column_name data_typeを変更するcolumn_name data_type [not null] [default default_value] [プライマリキー]

MySQLデータベースのネストされたクエリインスタンスの詳細な説明

Apr 11, 2025 pm 05:48 PM

MySQLデータベースのネストされたクエリインスタンスの詳細な説明

Apr 11, 2025 pm 05:48 PM

ネストされたクエリは、1つのクエリに別のクエリを含める方法です。これらは主に、複雑な条件を満たし、複数のテーブルを関連付け、要約値または統計情報を計算するデータを取得するために使用されます。例には、平均賃金を超える従業員を見つけること、特定のカテゴリの注文を見つけること、各製品の総注文量の計算が含まれます。ネストされたクエリを書くときは、サブ征服を書き、結果を外側のクエリ(エイリアスまたは条項として参照)に書き込み、クエリパフォーマンスを最適化する必要があります(インデックスを使用)。

Debian Apacheログ形式の構成方法

Apr 12, 2025 pm 11:30 PM

Debian Apacheログ形式の構成方法

Apr 12, 2025 pm 11:30 PM

この記事では、Debian SystemsでApacheのログ形式をカスタマイズする方法について説明します。次の手順では、構成プロセスをガイドします。ステップ1:Apache構成ファイルにアクセスするDebianシステムのメインApache構成ファイルは、/etc/apache2/apache2.confまたは/etc/apache2/httpd.confにあります。次のコマンドを使用してルートアクセス許可を使用して構成ファイルを開きます。sudonano/etc/apache2/apache2.confまたはsudonano/etc/apache2/httpd.confステップ2:検索または検索または

オラクルは何をしますか

Apr 11, 2025 pm 06:06 PM

オラクルは何をしますか

Apr 11, 2025 pm 06:06 PM

Oracleは、世界最大のデータベース管理システム(DBMS)ソフトウェア会社です。その主な製品には、次の機能が含まれます。リレーショナルデータベース管理システム(Oracle Database)開発ツール(Oracle Apex、Oracle Visual Builder)ミドルウェア(Oracle Weblogic Server、Oracle SOA Suite)Cloud Service(Oracle Cloud Infrastructure)Cloud ServiceおよびBusiness Intelligence(Oracle Analytics Cloud、Oracle Essbase)Blockchain(Oracle Blockchain Pla

Tomcatログがメモリの漏れのトラブルシューティングに役立つ方法

Apr 12, 2025 pm 11:42 PM

Tomcatログがメモリの漏れのトラブルシューティングに役立つ方法

Apr 12, 2025 pm 11:42 PM

Tomcatログは、メモリリークの問題を診断するための鍵です。 Tomcatログを分析することにより、メモリの使用状況とガベージコレクション(GC)の動作に関する洞察を得ることができ、メモリリークを効果的に見つけて解決できます。 Tomcatログを使用してメモリリークをトラブルシューティングする方法は次のとおりです。1。GCログ分析最初に、詳細なGCロギングを有効にします。 Tomcatの起動パラメーターに次のJVMオプションを追加します:-xx:printgcdetails-xx:printgcdateStamps-xloggc:gc.logこれらのパラメーターは、GCタイプ、リサイクルオブジェクトサイズ、時間などの情報を含む詳細なGCログ(GC.log)を生成します。分析GC.LOG

MongoDBインデックスを並べ替える方法

Apr 12, 2025 am 08:45 AM

MongoDBインデックスを並べ替える方法

Apr 12, 2025 am 08:45 AM

ソートインデックスは、特定のフィールドによるコレクション内のドキュメントのソートを許可するMongoDBインデックスの一種です。ソートインデックスを作成すると、追加のソート操作なしでクエリ結果をすばやく並べ替えることができます。利点には、クイックソート、オーバーライドクエリ、およびオンデマンドソートが含まれます。構文はdb.collection.createIndex({field:< sort and gt;})、where< sort and> IS 1(昇順)または-1(降順注文)です。また、複数のフィールドをソートするマルチフィールドソートインデックスを作成することもできます。

Debian Readdirによるファイルソートを実装する方法

Apr 13, 2025 am 09:06 AM

Debian Readdirによるファイルソートを実装する方法

Apr 13, 2025 am 09:06 AM

Debian Systemsでは、Readdir関数はディレクトリコンテンツを読み取るために使用されますが、それが戻る順序は事前に定義されていません。ディレクトリ内のファイルを並べ替えるには、最初にすべてのファイルを読み取り、QSORT関数を使用してソートする必要があります。次のコードは、debianシステムにreaddirとqsortを使用してディレクトリファイルを並べ替える方法を示しています。

UbuntuにMariadbをインストールするための特定の手順を記録します

Apr 11, 2025 pm 05:15 PM

UbuntuにMariadbをインストールするための特定の手順を記録します

Apr 11, 2025 pm 05:15 PM

UbuntuにMariadbをインストールする手順:Mariadbリポジトリのインストールを追加Mariadb Service Protection Mariadbのインストールを開始するMariadb Mariadb Create Database and user(optional)Verifyインストールに接続