グラフ学習テクノロジーは、推奨システム、ソーシャル ネットワーク分析、引用ネットワーク、交通ネットワークなど、さまざまな分野で広く使用されています。このテクノロジーは、複雑なリレーショナル データを効率的にマイニングして学習することができ、データ サイエンティストやエンジニアに強力なツールを提供します。グラフ学習アルゴリズムを通じて、データ間の関連性やつながりをより深く理解できるようになり、データの背後に隠された法則やパターンを発見するのに役立ちます。実際のアプリケーションでは、グラフ学習テクノロジは、反復メッセージ パッシング メカニズムを使用してグラフ構造データの特徴をキャプチャする、より正確で

グラフ ニューラル ネットワーク (GNN) を構築するのに役立ちます。関係は、さまざまなグラフ学習アプリケーションで顕著な結果を達成しました。

通常、この種のエンドツーエンドのグラフ ニューラル ネットワークでは、より良いトレーニング結果を達成するために、大量の高品質の注釈付きデータが必要です。

近年、いくつかの研究では、さまざまな自己教師あり学習タスクを使用して、グラフ モデルの事前トレーニングおよび微調整 (事前トレーニングと微調整) モードを提案しています。ラベルなしグラフ データ: まず、事前トレーニングが実行され、次に不十分な監視信号の問題に対処するために、少量のラベル付きデータに対して微調整が実行されます。ここでの自己教師あり学習タスクには、対照学習、マスク再構成、ローカルおよびグローバルの相互情報量の最大化などの手法が含まれます。

このような事前トレーニング方法はある程度成功していますが、一般化機能、特に事前トレーニングと下流のタスク間の分散において一定の制限があります。

レコメンデーション システムでは、事前トレーニングされたモデルが初期のデータに基づいてトレーニングされますが、ユーザーの好みや製品の人気は頻繁に変化するため、新しい情報に適応するためにモデルを継続的に更新する必要があります。

この課題に対処するために、最近の研究では、事前トレーニングされたモデルがさまざまな下流のタスクやデータにより効果的に適応できるように、グラフ モデルのヒント微調整方法が提案されています。

上記の研究はグラフ ニューラル ネットワーク モデルの一般化パフォーマンスを促進しましたが、これらのモデルは、トレーニング データとテスト データが同じノード セットと特徴空間を持っているという前提に基づいています。

これにより、事前トレーニングされたグラフ モデルの適用範囲が大幅に制限されます。したがって、この記事では、グラフィカル モデルの一般化能力をさらに向上させる方法を検討します。

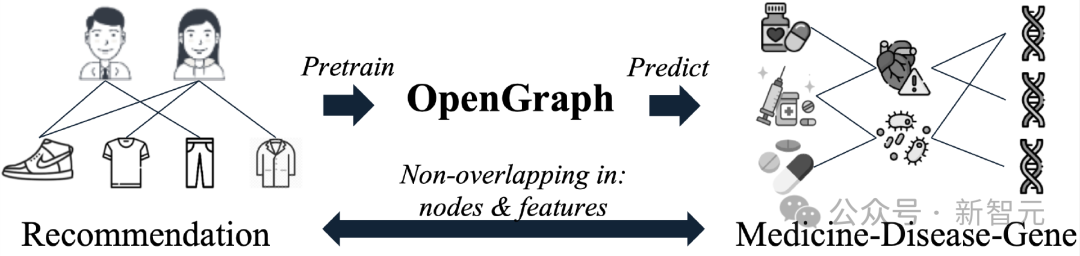

私たちは、OpenGraph が一般的なトポロジ パターンをキャプチャし、テスト データでゼロサンプル予測を達成することを期待しています。これは、順伝播プロセスを通じて、特徴が効率的に抽出され、テスト グラフ データが正確に予測されることを意味します。

モデルのトレーニング プロセスは、まったく異なるグラフ データに対して実行され、トレーニング フェーズではノード、エッジ、特徴ベクトルを含むテスト グラフの要素には一切触れられません。 。

この目標を達成するには、この記事では次の 3 つの課題を解決する必要があります。

ゼロショット グラフ予測タスクの大きな問題の 1 つは、通常、グラフ データが異なれば、グラフ トークン セットがまったく異なることです。具体的には、異なるグラフのノード セットは重複しないことが多く、異なるグラフ データセットは完全に異なるノード フィーチャを使用することがよくあります。これにより、モデルが特定のデータセットのグラフ トークンにバインドされたパラメーターを学習することによって、データセット間の予測タスクを実行できなくなります。

グラフ学習の分野では、ノード間に複雑な依存関係が存在することが多く、モデルはローカルな依存関係を理解する必要があります。ノードのグローバルな側面、近隣関係が包括的に考慮されます。一般的なグラフ モデルを構築する場合、重要なタスクはノード間の関係を効率的にモデル化できることです。これにより、大量のグラフ データを処理する際のモデル効果とスケーラビリティが向上します。

プライバシー保護やデータ収集コストなどの理由により、トレーニング データは多くの下流分野で広く普及しています。グラフ学習 データ不足の問題により、一般的なグラフ モデルのトレーニングでは特定の下流フィールドの理解が不足し、最適とはいえないトレーニング結果が生成される傾向があります。

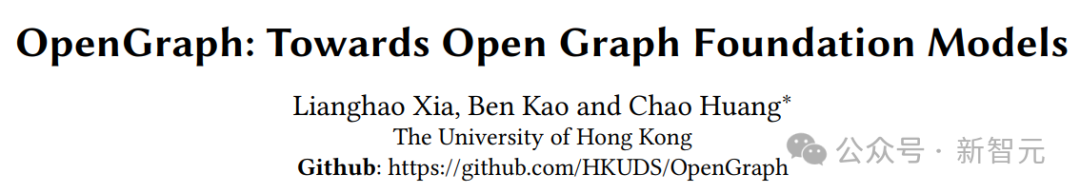

上記の課題に対処するために、香港大学の研究者は、ゼロショット学習に優れ、異なる下流ドメイン間で転送可能なトポロジー構造パターンを識別できるモデルである OpenGraph を提案しました。

論文リンク: https://arxiv.org/pdf/2403.01121.pdf

ソースコードリンク: https://github.com/HKUDS/OpenGraph

課題 C1 に対処するには、トポロジを認識した投影スキームを使用してグラフ トークナイザーを作成し、統合されたグラフ トークンを生成します。

課題 C2 に対処するために、スケーラブルなグラフ Transformer が設計されています。これには、アンカー サンプリングに基づく効率的なセルフ アテンション メカニズムが装備されており、より多くのことを達成するためのトークン シーケンス サンプリングが含まれています。効率トレーニング。

課題 C3 に対処するために、データ拡張のための大規模な言語モデルを活用して、ヒント ツリー アルゴリズムとギブズ サンプリングを使用して事前トレーニングを強化し、現実世界のグラフ構造の関係をシミュレートします。複数のグラフ データセットに対する広範なテストにより、さまざまな設定における OpenGraph の優れた一般化機能が示されています。

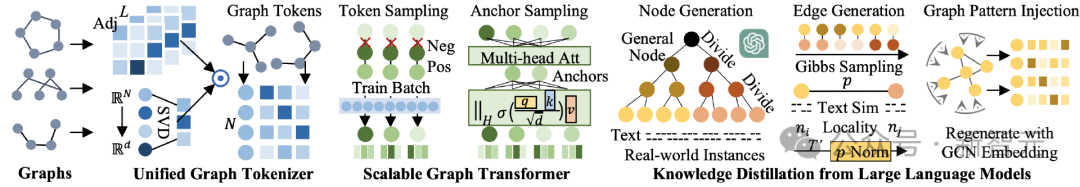

モデルの全体構造は次の図に示されており、3 つの部分に分けることができます。すなわち、1) 統合ダイアグラム Tokenizer、2) スケーラブルなグラフ Transformer、3) 大規模言語モデルの知識の蒸留です。

#さまざまなデータ セットのノード、エッジ、および特徴における大きな違いに対処するため、最初のタスクは、さまざまなグラフ データを統一されたトークン シーケンスに効果的にマッピングできる統合グラフ トークナイザーを構築することです。 。私たちのトークナイザーでは、各トークンには、対応するノードの情報を記述するセマンティック ベクトルがあります。

統一されたノード表現空間と柔軟なシーケンス データ構造を採用することで、さまざまなグラフ データに対して標準化された効率的なトークン化を実行できるようにしたいと考えています。

この目標を達成するために、トークナイザーは平滑化されたトポロジー情報と、ノード空間から潜在表現空間へのマッピング関数を使用します。

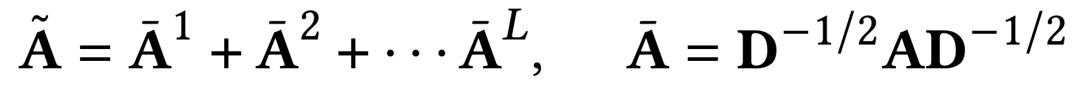

高次の滑らかな隣接行列

グラフのトークン化プロセスでは、隣接行列の高次べき乗を入力の 1 つとして使用し、グラフ構造の高次の接続関係を取得するだけでなく、元の隣接行列における接続の疎性の問題を解決します。

計算過程ではラプラシアン正規化が行われ、異なる次数のすべての隣接行列累乗が考慮されます。具体的な計算方法は次のとおりです。

#さまざまなデータセットに対する任意のグラフのトポロジ認識マッピング

隣接行列の次元には大きな違いがあるため、隣接行列を入力として直接取得し、固定入力次元を持つニューラル ネットワークを使用して処理することができません。

私たちの解決策は、まず隣接行列をノード表現シーケンスの形式に射影し、次に可変長シーケンス モデルを使用して処理することです。マッピングプロセスにおける情報損失を減らすために、トポロジーを意識したマッピング方法を提案します。

まず第一に、トポロジーを意識したマッピングの値の範囲は、高次元の潜在表現空間です。以前の研究では、より大きな潜在空間次元を採用すると、ランダムなマッピングでも満足のいく表現が得られることが多いと指摘しています。

グラフ構造情報をさらに保存し、ランダム性の影響を軽減するために、高速固有値分解 (SVD) を使用してマッピング関数を構築します。実際の実験では、2 ラウンドの高速固有値分解により位相情報を効果的に保持でき、結果として生じる計算オーバーヘッドは他のモジュールに比べて無視できます。

パラメータレス グラフのトークン化プロセスでは、OpenGraph統合されたトポロジ対応のグラフ トークン表現を、異なる特性を持つグラフ データに割り当てます。次のタスクは、トレーニング可能なニューラル ネットワークを使用してノード間の複雑な依存関係をモデル化することです。

OpenGraph は、複雑な関係をモデル化する際にその強力な機能を活用するために、トランスフォーマー アーキテクチャを採用しています。モデルの効率とパフォーマンスを確保するために、次の 2 つのサンプリング手法を導入します。

トークン シーケンス サンプリング

グラフ トークン シーケンス データには通常、多数のトークンと潜在表現が含まれるため、ディメンションOpenGraph で使用されるグラフ トランスフォーマーは、入力トークン シーケンスをサンプリングし、現在のトレーニング バッチ内のトークン間のペアごとの関係のみを学習するため、モデル化する必要がある関係ペアの数がノード数の 2 乗からノード数の 2 乗に減ります。これにより、トレーニング段階でのグラフ変換器の時間とスペースのオーバーヘッドが大幅に削減されます。さらに、このサンプリング方法により、モデルはトレーニング時に現在のトレーニング バッチにさらに注意を払うことができます。

入力データはサンプリングされていますが、最初のグラフ トークン表現にはノード間のトポロジ関係が含まれているため、サンプリングされたトークン シーケンスはグラフ全体のすべてのノードの特性を反映することができます。ある程度の情報です。

#セルフアテンションにおけるアンカー サンプリング方法

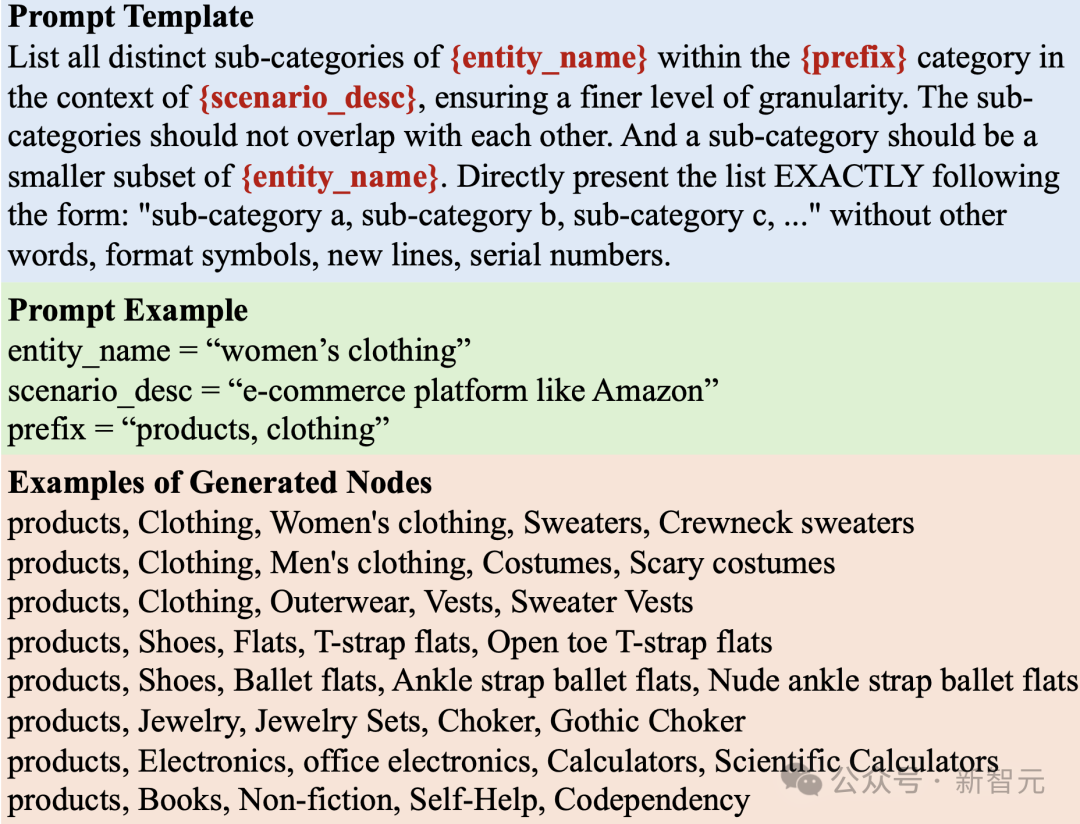

トークン シーケンス サンプリングでは、数の 2 乗から複雑さが軽減されますが、ノード数はバッチ サイズの 2 乗に減りますが、2 乗レベルの複雑さによりバッチ サイズの制限が大きくなり、モデル トレーニングに大きなバッチを使用できなくなり、全体のトレーニング時間とトレーニングの安定性に影響します。この問題を軽減するために、OpenGraph のトランスフォーマー部分はすべてのトークン間のペア関係のモデル化をあきらめますが、代わりにいくつかのアンカー ポイントをサンプリングし、すべてのノード間の関係学習を 2 つに分割します。ノードとアンカー間の関係学習。 データプライバシーと他の理由により、一般的なグラフ モデルをトレーニングするためにさまざまなドメインからデータを取得するのは困難です。大規模言語モデル (LLM) が示す驚くべき知識と理解能力を実感し、その能力を活用して、一般的なグラフ モデルのトレーニング用のさまざまなグラフ構造データを生成します。 私たちが設計したデータ拡張メカニズムにより、LLM で強化されたグラフ データが現実世界のグラフの特性をより適切に近似できるようになり、拡張データの関連性と有用性が向上します。 LLM ベースのノード生成 グラフを生成するときの最初のステップは、次のようなグラフを作成することです。特定のアプリケーションに適したシーンのノード セット。各ノードには、後続のエッジ生成プロセスを容易にするテキストベースの特徴の説明があります。 ただし、ノード セットのサイズが大きいため、実際のシナリオを扱う場合、このタスクは特に困難になる可能性があります。たとえば、電子商取引プラットフォームでは、グラフ データに数十億の商品が含まれる場合があります。したがって、LLM を効率的に有効にして多数のノードを生成することが重要な課題になります。 上記の課題に対処するために、私たちは一般的なノードをより細かいサブカテゴリーに継続的に分割する戦略を採用しています。 たとえば、電子商取引シナリオで製品ノードを生成する場合は、まず「淘宝網などの電子商取引プラットフォーム上のすべての製品のサブカテゴリを一覧表示する」のようなクエリ プロンプト LLM を使用します。 」 LLM は、「衣類」、「家庭用キッチン用品」、「電子製品」などのサブカテゴリのリストを回答しました。 次に、LLM に各サブカテゴリをさらに調整して、この反復的な分割プロセスを継続するように依頼します。このプロセスは、「衣類」、「婦人服」、「セーター」、「ポケット付きセーター」、「白いポケット付きセーター」というラベルが付いたノードなど、現実世界のインスタンスに似たノードができるまで繰り返されます。 プロンプト ツリー アルゴリズム ノードをサブカテゴリに分割し、きめの細かいエンティティを生成するプロセスは、ツリーに従います。みたいな構造。最初の一般的なノード (例: 「製品」、「深層学習論文」) はルートとして機能し、きめの細かいエンティティはリーフ ノードとして機能します。これらのノードを走査して生成するために、ツリー ヒンティング戦略を採用します。 LLM および Gibbs サンプリングに基づくエッジ生成 生成するためのエッジでは、上記で生成されたノード セットでギブス サンプリング アルゴリズムを使用します。このアルゴリズムはランダムなサンプルから開始され、反復され、毎回、現在のサンプルに基づいて、データ次元の 1 つを変更することによって得られるサンプルがサンプリングされます。 このアルゴリズムの鍵は、現在のサンプルの条件下で特定のデータ次元が変化する条件付き確率を推定することです。ノード生成時に得られるテキスト特徴量に基づいてLLMによる確率推定を行うことを提案する。 エッジ コレクション空間は大きいため、LLM による探索によって生じる膨大なオーバーヘッドを回避するために、最初に LLM を使用してノード コレクションを特徴付けてから、表現ベクトルに基づいた単純な類似演算子を使用します。ノード間の関係を計算します。上記のエッジ生成フレームワーク内で、調整のために次の 3 つの重要な手法も採用します。 動的確率正規化 LLM 表現の類似度は [0, 1] の範囲とは異なる場合があるため巨大なため、サンプリングにより適した確率値を取得するために、動的確率正規化手法を使用します。 このメソッドは、サンプリング プロセス中に最近の T' 類似性推定値を動的に維持し、それらの平均と標準偏差を計算し、最終的に現在の類似性推定値を 2 つの値にマッピングします。 1 標準偏差の分布範囲内で平均の上下に含まれるため、確率推定値はおよそ [0, 1] になります。 ノード局所性の紹介 LLM に基づくエッジ生成方法は、ノードの意味論的な類似性に効果的に基づいて行うことができます。潜在的な接続関係を判断します。 ただし、意味的に関連するすべてのノード間に過剰な接続が作成される傾向があり、現実世界のグラフにおける局所性という重要な概念が無視されます。 現実の世界では、ノードは通常、ノードのサブセットとの対話が限られているため、関連するノードのサブセットに接続される可能性が高くなります。この重要な特性をモデル化するために、エッジ生成中に局所性を考慮する方法が導入されています。 各ノードには局所性インデックスがランダムに割り当てられます。2 つのノード間の相互作用確率は、局所性インデックスの絶対差の減衰に影響されます。局所性インデックスの差が大きいほど、ノードが大きいほど、減衰は深刻になります。 #グラフ トポロジ パターンの挿入 生成されたグラフ データをトポロジ構造パターンとより一致させるために、 we inject 変更されたノード表現は、グラフ生成プロセス中に再度生成されます。 このノード表現は、単純なグラフ畳み込みネットワークを使用して、最初に生成されたグラフ上で取得されます。グラフ構造データの分布特性によりよく適合し、グラフとテキストの間のギャップを回避できます。スペースの分布シフトです。最後に、修正されたノード表現に基づいて、再度グラフ サンプリングを実行し、最終的なグラフ構造データを取得します。 #実験検証

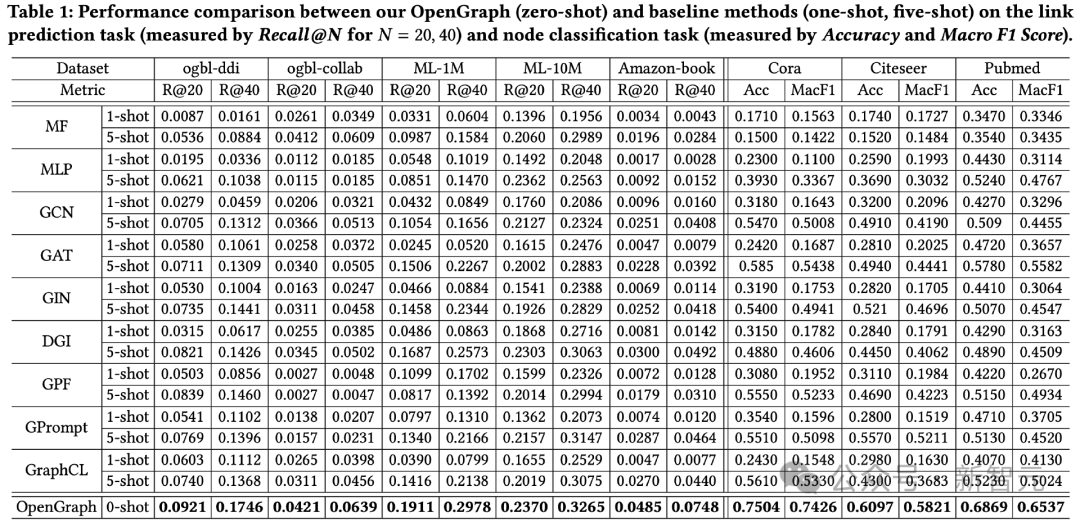

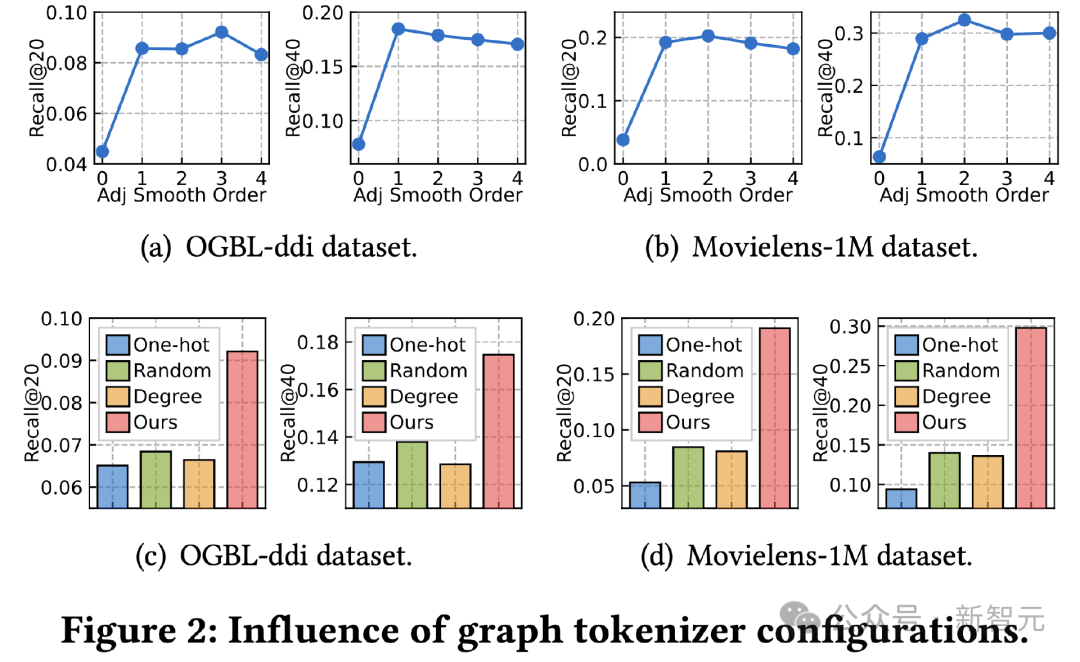

0 ショット設定 #少数ショット設定 既存の方法のほとんどは効率的なゼロの処理を実行できないため、サンプル予測では、少数サンプル予測を使用してテストします。ベースライン手法は、トレーニング前のデータで事前トレーニングした後、k ショット サンプルを使用して微調整した上でトレーニング、微調整、またはヒントを得ることができます。 2 つのタスクと合計 8 つのテスト データ セットに対するテスト効果は次のとおりです。 。 これは次のように観察できます: 1) データセット全体でこの場合、OpenGraph のゼロサンプル予測効果には、既存の方法よりも大きな利点があります。 2) クロスデータセット転送の場合、既存の事前トレーニング方法は、わずかなサンプルで最初からトレーニングされたベース モデルよりもさらに悪い場合があります。これは、次の事実を反映しています。図 データセット全体でモデルの一般化を達成することの難しさ。 #グラフ トークナイザーの研究

結果は、3 つの選択肢はいずれも効果が低いことを示しています。その中でも、データ セット全体での ID 表現の学習が最も悪い影響を及ぼします。既存の研究で一般的に使用されている度数表現の効果も減衰します。のランダム マッピングは、すべての代替方法の中で最も優れたパフォーマンスを発揮しますが、トポロジを意識したマッピングにはまだ程遠いです。

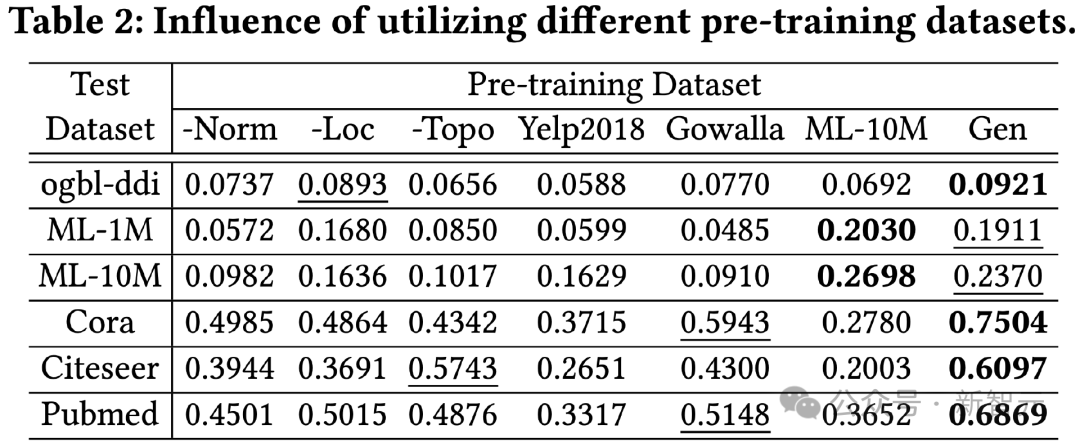

この実験で比較された事前トレーニング データ セットには、生成方法のみで特定のトリックを削除したバージョンと、テストに関連しない 2 つの実際のデータ セット Yelp2018 と Gowalla が含まれています。データ セット、およびテスト データ セットに関連する ML-10M データ セットの結果からわかります: 1) 全体として、生成されたデータ セットはより良い結果を生み出すことができます。すべてのテストデータで良好な結果が得られました。 2) テストした 3 つの生成手法はすべて、大幅な改善効果があります。 3) トレーニングに実際のデータ セット (Yelp、Gowalla) を使用すると、異なる実際のデータ セット間の分布の違いに起因する悪影響が生じる可能性があります。 4) ML-10M は、ML-1M と ML-10M の両方で最高の結果を達成しました。これは、同様のトレーニング データ セットを使用すると、より良い結果が得られることを示しています。

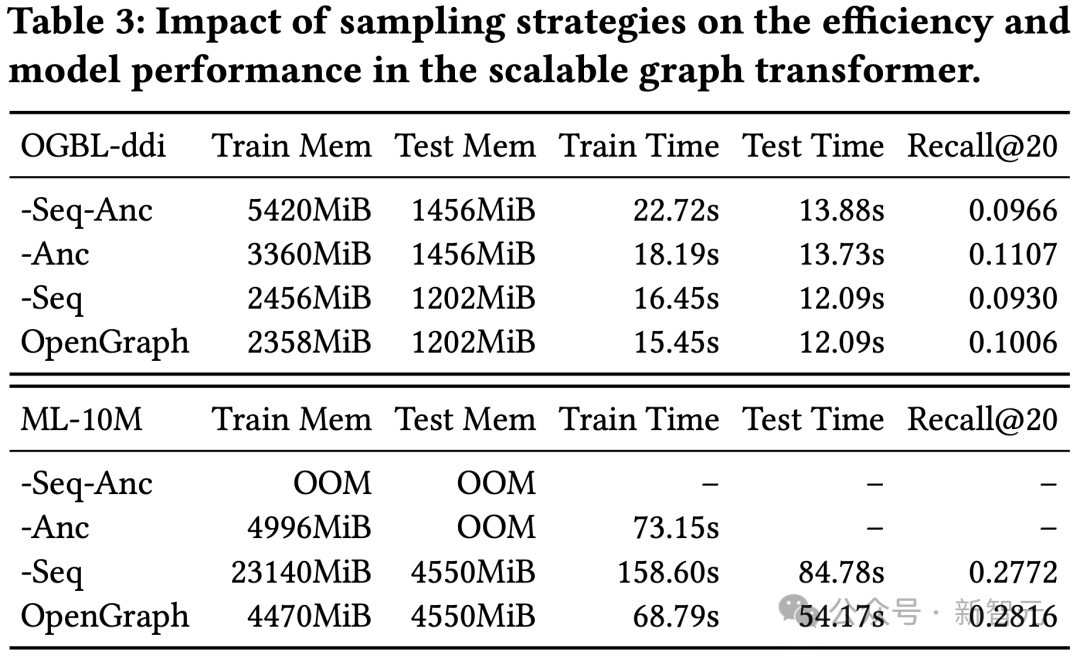

# この実験では、グラフ変換モジュールのトークン シーケンス サンプリング (Seq) とアンカー サンプリング (Anc) に対してアブレーション テストを実行しました。 結果は、2 つのサンプリング方法により、トレーニングおよびテストのプロセス中にモデルの空間と時間のオーバーヘッドを最適化できることを示しています。効果の点では、トークン シーケンス サンプリングはモデル効果にプラスの効果をもたらしますが、DDI データ セットの結果は、アンカー ディッシュ サンプリングがモデル効果にマイナスの効果を及ぼすことを示しています。 この研究の主な焦点は、さまざまな問題を正確に捉えて理解できる適応性の高いフレームワークを開発することです。グラフ構造における複雑なトポロジー パターン。 提案されたモデルの可能性を活用することで、さまざまな下流アプリケーションを含むゼロショット グラフ学習タスクにおけるモデルの汎化能力を大幅に向上させることを目指しています。 OpenGraph の効率と堅牢性をさらに向上させるために、スケーラブルなグラフ トランスフォーマー アーキテクチャと LLM ベースのデータ拡張メカニズムに基づいてモデルを構築しました。 私たちは、複数のベンチマーク データセットに対する広範な実験を通じて、モデルの優れた一般化機能を検証します。この研究では、グラフベースモデルの方向で予備的な探索を試みます。 今後の作業では、さまざまなグラフ構造パターンにわたって一般的で転移可能であることを学習しながら、反事実的な学習影響を持つノイズの多い接続や構造を自動的に検出できるようにフレームワークを強化する予定です。

大規模言語モデルの知識の蒸留

#実験では、OpenGraph モデルのトレーニング用に LLM に基づいて生成されたデータ セットのみを使用します。テスト データ セット これらはすべて、さまざまなアプリケーション シナリオにおける実際のデータ セットであり、ノード分類とリンク予測という 2 種類のタスクが含まれます。実験の具体的な設定は次のとおりです。

全体的な効果の比較

事前学習データセットの検討

検証するために蒸留法の LLM 有効性に基づいた知識に基づいて、さまざまな事前トレーニング データ セットを使用して OpenGraph をトレーニングし、さまざまなテスト セットでその効果をテストします。

結論

以上が「グラフベースモデル」の3大課題を初めて克服! HKU オープンソース OpenGraph: ゼロサンプル学習はさまざまな下流タスクに適応しますの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。