超強い!深層学習アルゴリズムのトップ 10!

2006 年にディープ ラーニングの概念が提案されてから、ほぼ 20 年が経過しました。ディープ ラーニングは、人工知能分野における革命として、多くの影響力のあるアルゴリズムを生み出してきました。では、ディープラーニングのトップ 10 アルゴリズムは何だと思いますか?

私の考える深層学習の上位アルゴリズムは次のとおりであり、それらはすべてイノベーション、アプリケーションの価値、影響力の点で重要な位置を占めています。

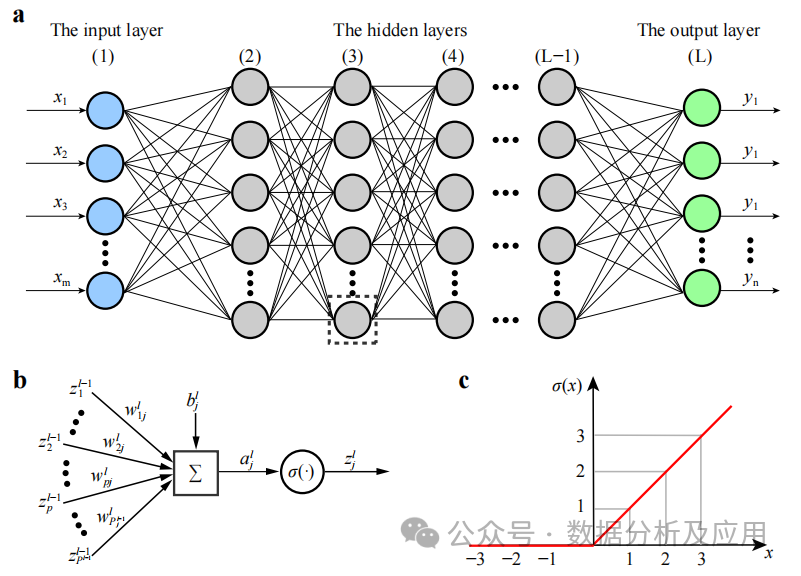

1. ディープ ニューラル ネットワーク (DNN)

背景: ディープ ニューラル ネットワーク (DNN) は、多層パーセプトロンとも呼ばれます。最も一般的なディープ ラーニング アルゴリズム は、最初に発明されたとき、コンピューティング能力のボトルネックにより批判されましたが、近年のコンピューティング能力とデータの爆発的な増加により、画期的な進歩が見られました。

#DNN は、複数の隠れ層を含むニューラル ネットワーク モデルです。このモデルでは、各層が入力を次の層に渡し、非線形活性化関数を利用して学習の非線形特性を導入します。これらの非線形変換を重ね合わせることで、DNN は入力データの複雑な特徴表現を学習できます。

モデルのトレーニングには、バックプロパゲーション アルゴリズムと勾配降下最適化アルゴリズムを使用して重みを継続的に調整することが含まれます。トレーニング中に、重みに対する損失関数の勾配が計算され、その後、勾配降下法またはその他の最適化アルゴリズムを使用して重みが更新され、損失関数が最小化されます。

利点: 入力データの複雑な特徴を学習し、非線形関係を捉えることができます。強力な特徴学習および表現機能を備えています。

ネットワークの深さが増すと、勾配消失問題が増加し、トレーニングが不安定になります。さらに、モデルは極小値に陥る傾向があり、複雑な初期化戦略と正則化手法が必要になります。

利用シナリオ: 画像分類、音声認識、自然言語処理、レコメンデーションシステムなど。

Python サンプル コード:

import numpy as npfrom keras.models import Sequentialfrom keras.layers import Dense# 10 個の入力特徴量があると仮定し、 3 つの出力カテゴリ input_dim = 10num_classes = 3# DNN モデルの作成 model = Sequential()model.add(Dense(64, activatinotallow='relu', input_shape=(input_dim,)))model.add(Dense(32, activatinotallow= ' relu'))model.add(Dense(num_classes, activatinotallow='softmax'))# モデルをコンパイルし、オプティマイザーと損失関数を選択します。model.compile(optimizer='adam', loss='categorical_crossentropy', metrics=['精度'])# トレーニング データとラベルのサンプルが 100 個あると仮定します。 X_train = np.random.rand(100, input_dim)y_train = np.random.randint(0, 2, size=(100, num_classes))# トレーニング モデルmodel.fit(X_train, y_train, epochs=10)

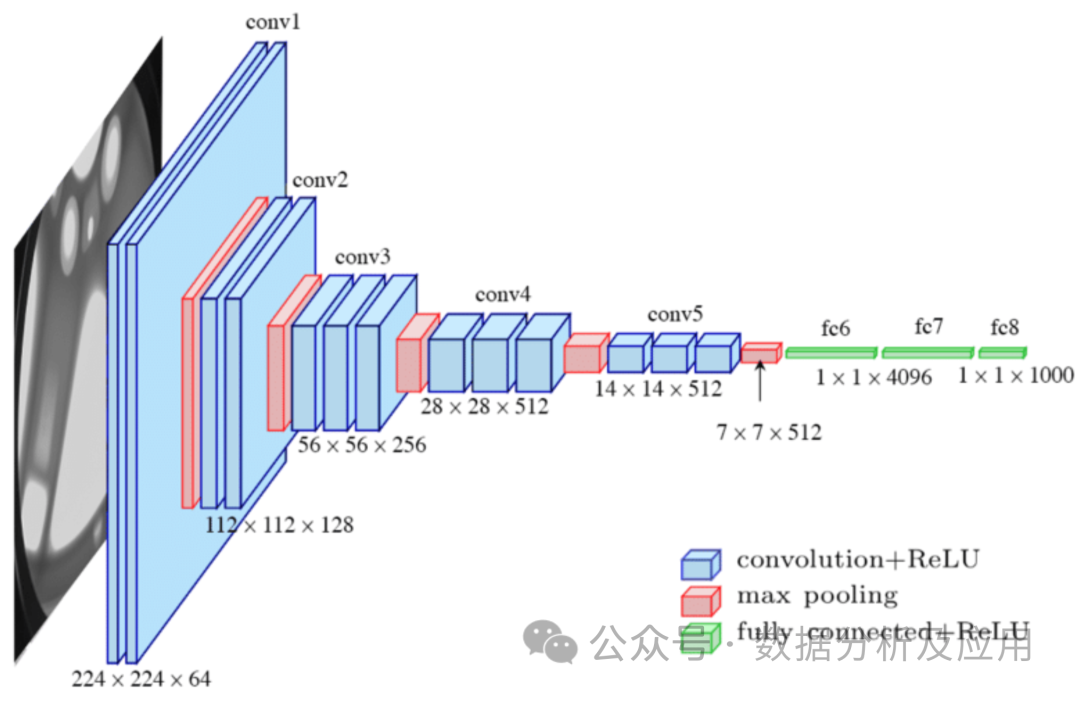

2. 畳み込みニューラル ネットワーク (CNN)

モデル原理: 畳み込みニューラル ネットワーク (CNN) は、画像データを処理するために特別に設計されたニューラル ネットワークです。 Lechun 氏は CNN の先駆者です。 CNN は、畳み込み層を使用して局所的な特徴をキャプチャし、プーリング層を通じてデータの次元を削減します。畳み込み層は、入力データに対してローカル畳み込み演算を実行し、パラメーター共有メカニズムを使用してモデルのパラメーターの数を減らします。プーリング層は畳み込み層の出力をダウンサンプリングして、データの次元数と計算の複雑さを軽減します。この構造は、画像データの処理に特に適しています。

モデルのトレーニングには、バックプロパゲーション アルゴリズムと勾配降下最適化アルゴリズムを使用して重みを継続的に調整することが含まれます。トレーニング中に、重みに対する損失関数の勾配が計算され、その後、勾配降下法またはその他の最適化アルゴリズムを使用して重みが更新され、損失関数が最小化されます。

利点: 画像データを効果的に処理し、局所的な特徴をキャプチャできます。パラメーターの数が少ないほど、過剰適合のリスクが軽減されます。

欠点: シーケンス データや長距離の依存関係には適さない可能性があります。入力データの複雑な前処理が必要になる場合があります。

使用シナリオ: 画像分類、ターゲット検出、セマンティック セグメンテーションなど。

Python サンプル コード

from keras.models import Sequentialfrom keras.layers import Conv2D, MaxPooling2D, Flatten, Dense#入力画像 64x64 ピクセルで、3 つのカラー チャネルがあります input_shape = (64, 64, 3)# CNN モデルを作成します model = Sequential()model.add(Conv2D(32, (3, 3), activatinotallow='relu', input_shape =input_shape ))model.add(MaxPooling2D((2, 2)))model.add(Conv2D(64, (3, 3), activatinotallow='relu'))model.add(Flatten())model.add( Dense( 128, activatinotallow='relu'))model.add(Dense(num_classes, activatinotallow='softmax'))# モデルをコンパイルし、オプティマイザーと損失関数を選択します。model.compile(optimizer='adam', loss=' categorical_crossentropy', metrics=['accuracy'])# トレーニング データとラベルのサンプルが 100 個あると仮定します。 X_train = np.random.rand(100, *input_shape)y_train = np.random.randint(0, 2, size=( 100, num_classes ))# トレーニング モデル model.fit(X_train, y_train, epochs=10)

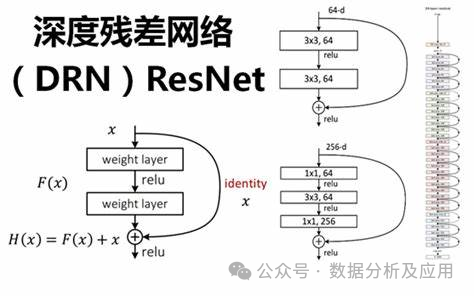

3. 残差ネットワーク (ResNet)

ディープラーニングの急速な発展に伴い、ディープ ニューラル ネットワークは多くの分野で目覚ましい成功を収めています。ただし、ディープ ニューラル ネットワークのトレーニングでは、勾配の消失やモデルの劣化などの問題が発生し、ネットワークの深さとパフォーマンスが制限されます。これらの問題を解決するために、残差ネットワーク (ResNet) が提案されました。

モデル原理:

ResNet は、「残留ブロック」を導入することでディープ ニューラル ネットワークの問題を解決します。勾配消失とモデルの劣化の問題。残差ブロックは「スキップ接続」と 1 つ以上の非線形層で構成されており、勾配を後の層から前の層に直接逆伝播できるため、ディープ ニューラル ネットワークのトレーニングを向上させることができます。このようにして、ResNet は非常に深いネットワーク構造を構築し、複数のタスクで優れたパフォーマンスを達成できます。

モデル トレーニング:

ResNet のトレーニングでは、通常、バックプロパゲーション アルゴリズムと最適化アルゴリズム (確率的勾配降下法など) が使用されます。トレーニング プロセス中に、重みに対する損失関数の勾配を計算し、最適化アルゴリズムを使用して重みを更新することにより、損失関数が最小化されます。さらに、トレーニングプロセスを高速化し、モデルの一般化能力を向上させるために、正則化技術、アンサンブル学習などの方法も使用できます。

利点:

- # 勾配の消失とモデルの劣化の問題を解決します。残差ブロックとスキップ接続を導入することで、ResNet は次のことが可能になります。ディープ ニューラル ネットワークを適切にトレーニングし、勾配の消失やモデルの劣化の問題を回避できます。

- 非常に深いネットワーク構造の構築: 勾配の消失とモデルの劣化の問題が解決されたため、ResNet は非常に深いネットワーク構造を構築できるため、モデルのパフォーマンスが向上します。

- 複数のタスクで優れたパフォーマンスを達成: ResNet は、その強力な特徴学習および表現機能により、画像分類、ターゲット テストなどの複数のタスクで優れたパフォーマンスを達成しました。

欠点:

- 大量の計算: ResNet は通常、非常に深いネットワーク構造を構築するため、計算が比較的大きく、大きいほど、より多くのコンピューティング リソースとトレーニング時間が必要になります。

- パラメーターのチューニングは難しい: ResNet には多数のパラメーターがあるため、チューニングとハイパーパラメーターの選択に多大な時間とエネルギーが必要です。

- 初期化の重みに敏感: ResNet は初期化の重みの選択に非常に敏感です。初期化の重みが不適切な場合、不安定なトレーニングや過剰適合の問題が発生する可能性があります。

使用シナリオ:

ResNet には、画像分類、ターゲット検出、顔認識など。さらに、ResNet は自然言語処理、音声認識などの分野でも使用できます。

Python サンプル コード (簡易バージョン):

この簡易バージョンの例では、Keras ライブラリを使用して次のことを行う方法を示します。単純な ResNet モデルを構築します。

from keras.models import Sequentialfrom keras.layers import Conv2D、Add、Activation、BatchNormalization、Shortcutdefresidual_block(input, filters):x = Conv2D(filters=filters, kernel_size=(3) , 3)、padding='same')(input)x = BatchNormalization()(x)x = Activation('relu')(x)x = Conv2D(filters=フィルター、kernel_size=(3, 3)、padding= 'same')(x)x = BatchNormalization()(x)x = Activation('relu')(x)return x4. LSTM (Long Short-Term Memory Network)

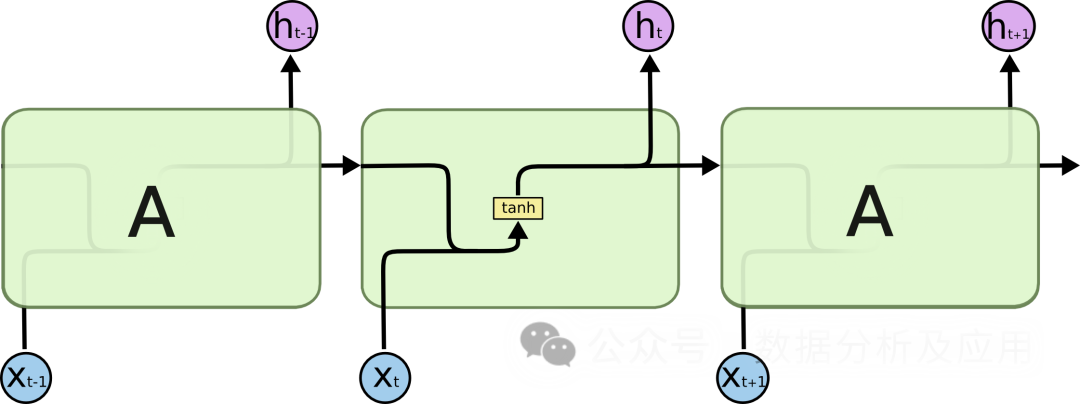

シーケンス データを処理する場合、従来のリカレント ニューラル ネットワーク (RNN) は勾配の消失やモデルの劣化などの問題に直面します。 . により、ネットワークの深さとパフォーマンスが制限されます。これらの問題を解決するために、LSTM が提案されました。

モデル原理:

LSTM は、「ゲート」メカニズムを導入することによって情報の流れを制御します。これにより、勾配の消失とモデルの劣化の問題が解決されます。 LSTM には、入力ゲート、忘却ゲート、出力ゲートという 3 つのゲート メカニズムがあります。入力ゲートは新しい情報の入力を決定し、忘却ゲートは古い情報の忘却を決定し、出力ゲートは最終的な出力情報を決定します。これらのゲート メカニズムを通じて、LSTM は長期的な依存関係の問題に対してより優れたパフォーマンスを発揮できます。

モデル トレーニング:

LSTM のトレーニングでは、通常、逆伝播アルゴリズムと最適化アルゴリズム (確率的勾配降下法など) が使用されます。トレーニング プロセス中に、重みに対する損失関数の勾配を計算し、最適化アルゴリズムを使用して重みを更新することにより、損失関数が最小化されます。さらに、トレーニングプロセスを高速化し、モデルの一般化能力を向上させるために、正則化技術、アンサンブル学習などの方法も使用できます。

利点:

- # 勾配の消失とモデルの劣化の問題を解決: ゲート メカニズムを導入することで、LSTM はより適切に処理できるようになります。長期的な依存関係の問題により、勾配の消失やモデルの劣化の問題が回避されます。

- 非常に深いネットワーク構造の構築: 勾配の消失とモデルの劣化の問題を解決するため、LSTM は非常に深いネットワーク構造を構築でき、モデルのパフォーマンスが向上します。

- 複数のタスクで優れたパフォーマンスを達成: LSTM は、その強力な特徴学習および表現機能により、テキスト生成、音声認識、機械翻訳などの複数のタスクで優れたパフォーマンスを達成しました。 。

欠点:

- パラメータの調整が難しい: LSTM には多数のパラメータがあり、多くのパラメータが必要です。時間とエネルギー チューニングとハイパーパラメータの選択を実行します。

- 初期化の重みに敏感: LSTM は初期化の重みの選択に非常に敏感です。初期化の重みが不適切な場合、不安定なトレーニングや過学習の問題が発生する可能性があります。

- 大量の計算: LSTM は通常、非常に深いネットワーク構造を構築するため、大量の計算が必要となり、トレーニングに多くのコンピューティング リソースと時間を必要とします。

使用シナリオ:

LSTM には、テキスト生成などの自然言語処理の分野における幅広いアプリケーション シナリオがあります。 、機械翻訳、音声認識など。また、LSTMは時系列分析やレコメンドシステムなどの分野でも活用できます。

Python サンプル コード (簡易バージョン):

from keras.models import Sequentialfrom keras.layers import LSTM, Densedef lstm_model(input_shape, num_classes ):model = Sequential()model.add(LSTM(units=128, input_shape=input_shape))# LSTM 層を追加します。model.add(Dense(units=num_classes, activatinotallow='softmax'))# 完全に接続された層を追加します。戻りモデル

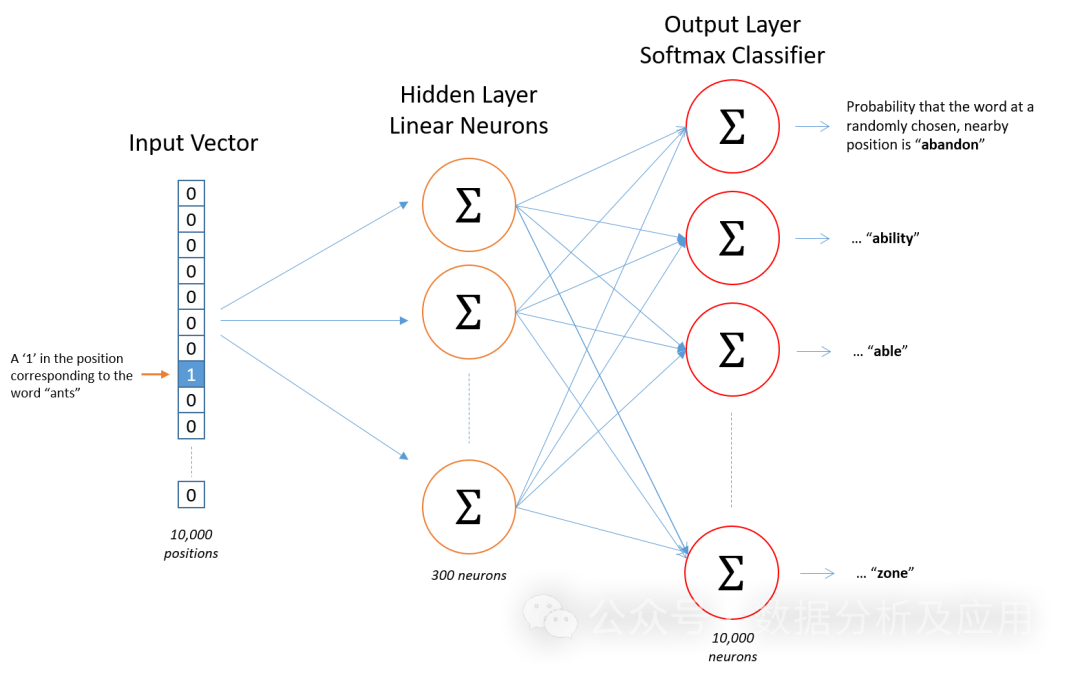

5. Word2Vec

Word2Vec モデルは、表現学習の 先駆的な研究です。 Google の科学者によって開発された、自然言語処理のための (浅い) ニューラル ネットワーク モデル。 Word2Vec モデルの目標は、各単語を固定サイズのベクトルにベクトル化し、類似した単語を類似したベクトル空間にマッピングできるようにすることです。

モデル原理

Word2Vec モデルはニューラル ネットワークに基づいており、入力単語を使用してその文脈単語を予測します。トレーニング プロセス中に、モデルは、特定のコンテキストに出現する単語がターゲット単語のベクトル表現にできる限り近づくように、各単語のベクトル表現を学習しようとします。このトレーニング方法は「スキップグラム」または「連続バッグ オブ ワード」(CBOW)と呼ばれます。

モデル トレーニング

Word2Vec モデルのトレーニングには大量のテキスト データが必要です。まず、テキスト データが一連の単語または N グラムに前処理されます。次に、ニューラル ネットワークを使用して、これらの単語または N グラムのコンテキストをトレーニングします。トレーニング プロセス中、モデルは予測誤差を最小限に抑えるために単語のベクトル表現を継続的に調整します。

利点

- 意味的類似性: Word2Vec は、ベクトル内の類似した単語間の意味的関係を学習できます。空間上の距離は次のとおりです。似ている。

- 効率的なトレーニング: Word2Vec のトレーニング プロセスは比較的効率的で、大規模なテキスト データに対してトレーニングできます。

- 解釈可能性 : Word2Vec の単語ベクトルはある程度の解釈可能性を備えており、クラスタリング、分類、意味的類似性の計算などのタスクに使用できます。

欠点

- データの疎さ: Word2Vec は、トレーニングデータ。

- コンテキスト ウィンドウ: Word2Vec は固定サイズのコンテキストのみを考慮し、それ以上の依存関係を無視する場合があります。

- 計算の複雑さ: Word2Vec のトレーニングと推論のプロセスには、大量のコンピューティング リソースが必要です。

- パラメータ調整: Word2Vec のパフォーマンスは、ハイパーパラメータの設定 (ベクトルの次元、ウィンドウ サイズ、学習率など) に大きく依存します。

使用シナリオ

Word2Vec は、テキスト分類、感情分析、情報抽出など、さまざまな自然言語処理タスクで広く使用されています。たとえば、Word2Vec を使用すると、ニュース報道の感情的な傾向 (肯定的または否定的) を特定したり、大量のテキストから重要なエンティティや概念を抽出したりできます。

Python サンプル コード

from gensim.models import Word2Vecfrom nltk.tokenize import word_tokenizefrom nltk.corpus import abcimport nltk# abc corpus nltk.download をダウンロードしてロードします('abc')corpus = abc.sents()# コーパスをセグメント化し、小文字の文に変換 = [[word. lower() for word in word_tokenize(text)] for text in corpus]# Word2Vec モデルをトレーニングする model = Word2Vec(文章、vector_size=100、window=5、min_count=5、workers=4)# 単語「the」のベクトル表現を検索します。 Vector = model.wv['the']# 他の単語との類似度を計算します。 model.wv .similarity('the', 'of')# 類似度の値を出力 print(similarity)6、トランスフォーマー

背景:

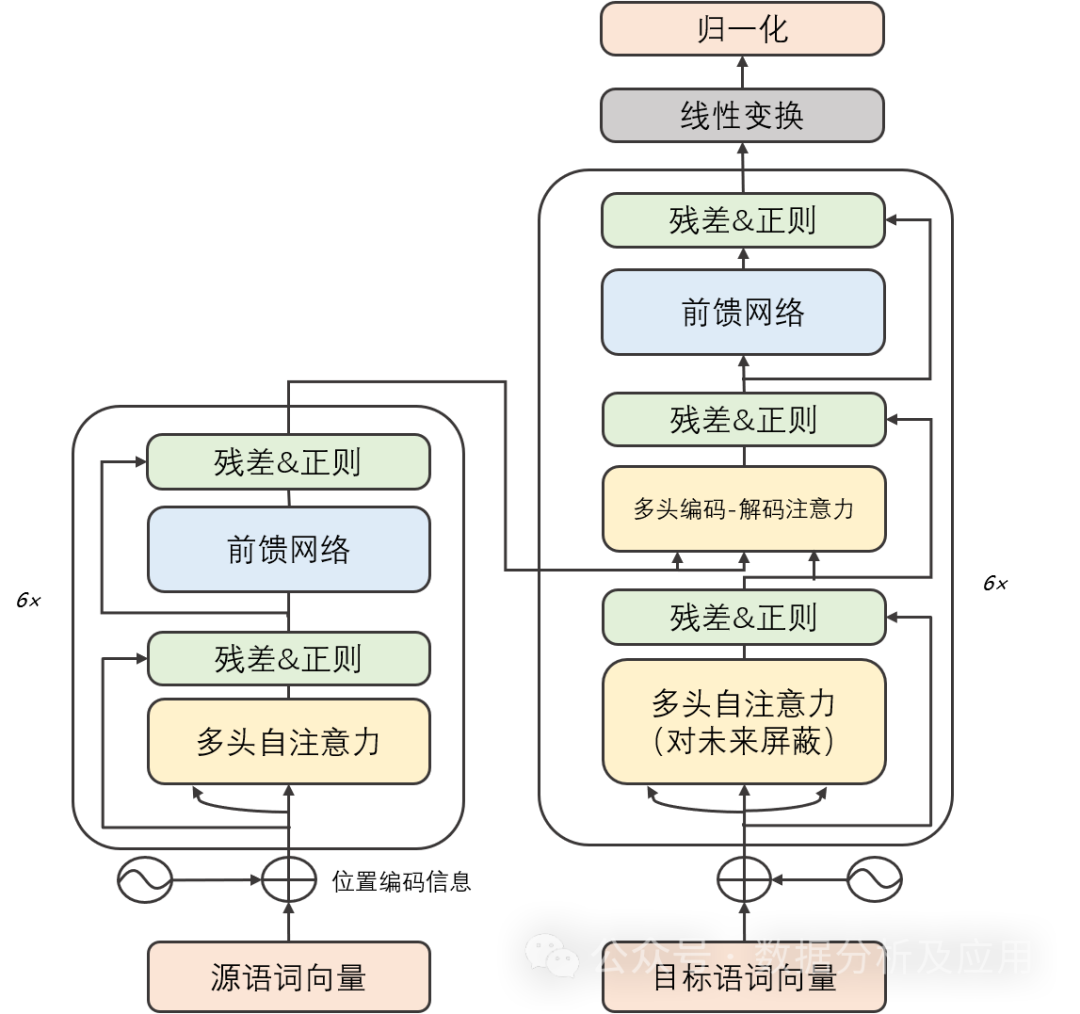

深層学習の初期段階では、畳み込みニューラル ネットワーク (CNN) が注目に値します。画像認識と自然言語処理の分野で成功を収めています。ただし、タスクの複雑さが増すにつれて、シーケンスツーシーケンス (Seq2Seq) モデルとリカレント ニューラル ネットワーク (RNN) がシーケンス データを処理する一般的な方法になりました。 RNN とそのバリアントは一部のタスクでは良好に実行されますが、長いシーケンスを処理するときに勾配消失やモデルの劣化の問題が発生する傾向があります。これらの問題を解決するために、Transformer モデルが提案されました。 GPTやBertなどの後の大型モデルはすべてTransformerをベースにしており、優れたパフォーマンスを実現しました。

モデルの原理:

Transformer モデルは主に、エンコーダーとデコーダーの 2 つの部分で構成されます。各パーツは複数の同一の「レイヤー」で構成されています。各層には、セルフアテンション サブ層と線形フィードフォワード ニューラル ネットワーク サブ層の 2 つのサブ層が含まれています。セルフ アテンション サブレイヤーは、ドット積アテンション メカニズムを使用して入力シーケンス内の各位置の表現を計算します。一方、線形フィードフォワード ニューラル ネットワーク サブレイヤーは、セルフ アテンション レイヤーの出力を入力として受け取り、出力表現。さらに、エンコーダとデコーダの両方に、入力シーケンス内の位置情報を取得するための位置エンコード層が含まれています。

モデル トレーニング:

Transformer モデルのトレーニングでは、通常、バックプロパゲーション アルゴリズムと最適化アルゴリズム (確率的勾配降下法など) が使用されます。トレーニング プロセス中に、重みに対する損失関数の勾配を計算し、最適化アルゴリズムを使用して重みを更新することにより、損失関数が最小化されます。さらに、トレーニングプロセスを高速化し、モデルの一般化能力を向上させるために、正則化技術、アンサンブル学習などの方法も使用できます。

利点:

- # 勾配の消失とモデルの劣化の問題を解決: Transformer モデルはセルフ アテンション メカニズムを採用しているためシーケンス内の長期的な依存関係を適切に捕捉し、勾配の消失やモデルの劣化の問題を回避します。

- 効率的な並列コンピューティング機能: Transformer モデルの計算は並列化できるため、トレーニングと推論を GPU 上で迅速に実行できます。

- 複数のタスクで優れたパフォーマンスを達成: Transformer モデルは、強力な特徴学習および表現機能により、機械翻訳、テキスト分類、音声認識などの複数のタスクで優れたパフォーマンスを達成しました。 、など。

欠点:

- 大量の計算: Transformer モデルの計算は並列化できるため、トレーニングと推論のための大量のコンピューティング リソース。

- 初期化の重みに敏感: Transformer モデルは初期化の重みの選択に非常に敏感です。初期化の重みが不適切な場合、不安定なトレーニングや過学習の問題が発生する可能性があります。

- 長期的な依存関係を学習できない: Transformer モデルは勾配の消失とモデルの劣化の問題を解決しますが、非常に長いシーケンスを扱う場合には依然として課題があります。

使用シナリオ:

Transformer モデルには、機械などの自然言語処理の分野における幅広いアプリケーション シナリオがあります。翻訳、テキスト分類、テキスト生成などさらに、Transformer モデルは画像認識、音声認識などの分野でも使用できます。

Python サンプル コード (簡易バージョン):

import torchimport torch.nn を nnimport torch.nn.function as Fclass TransformerModel(nn.Module):def __init__(self, vocab_size, embedding_dim, num_heads, num_layers, dropout_rate=0.5):super(TransformerModel, self) ).__init__()self.embedding = nn.Embedding(vocab_size, embedding_dim)self.transformer = nn.Transformer(d_model=embedding_dim, nhead=num_heads, num_encoder_layers=num_layers, num_decoder_layers=num_layers,dropout=dropout_rate)self.fc = nn .Linear(embedding_dim, vocab_size)def forward(self, src, tgt):embedded = self.embedding(src)output = self.transformer(embedded)output = self.fc(output)return 出力 pip インストール トランスフォーマー

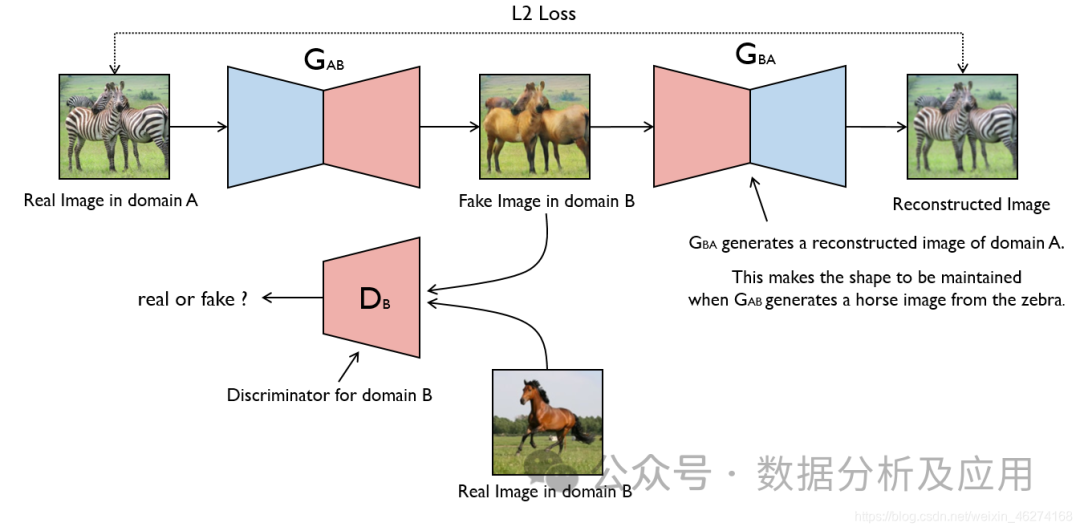

7. 敵対的生成ネットワーク (GAN)

GAN のアイデアは、ゲーム理論におけるゼロサム ゲームに由来しており、1 人のプレーヤーが生成を試みます。他のプレイヤーが本物のデータと偽のデータを区別しようとしている間、最も現実的な偽のデータ。 GAN はモンティ ホール問題 (生成モデルと判別モデルの組み合わせの問題) から発展しましたが、モンティ ホール問題とは異なり、GAN は特定の確率分布の近似や特定のサンプルの生成を重視せず、生成モデルと判別モデルを直接使用します。

モデル原理:

GAN は、ジェネレーター (Generator) とディスクリミネーター (Discriminator) の 2 つの部分で構成されます。 )。ジェネレーターのタスクは偽のデータを生成することですが、ディスクリミネーターのタスクは、入力データが本物のデータセットからのものなのか、それともジェネレーターによって生成された偽のデータなのかを判断することです。トレーニング プロセス中、ジェネレーターとディスクリミネーターが競合し、平衡状態に達するまでパラメーターが常に調整されます。この時点で、ジェネレーターによって生成された偽のデータは、弁別器が本物のデータと偽のデータを区別できないほど現実的です。

モデルのトレーニング:

GAN のトレーニング プロセスは最適化問題です。各トレーニング ステップでは、まず現在のパラメーターに基づくジェネレーターを使用して偽のデータを生成し、次にディスクリミネーターを使用してデータが本物か生成されたかを判断します。そして、この判定結果に基づいて、識別器のパラメータが更新される。同時に、弁別器の過学習を防ぐために、生成された偽のデータが弁別器を欺くことができるように生成器をトレーニングする必要があります。このプロセスは平衡状態に達するまで繰り返されます。

利点:

- 強力な生成能力: GAN はデータの固有の構造と分布を学習できるため、非常に現実的なフェイク データを生成できます。 。

- 明示的な監視は不要: GAN のトレーニング プロセス中に明示的なラベル情報は必要ありません。実際のデータのみが必要です。

- 高い柔軟性: GAN は、オートエンコーダーと組み合わせて AutoGAN を形成したり、畳み込みニューラル ネットワークと組み合わせて DCGAN を形成したりするなど、他のモデルと組み合わせて使用できます。

欠点:

- トレーニングが不安定: GAN のトレーニング プロセスは不安定で、モード崩壊を起こしやすいです。)つまり、ジェネレーターが特定の種類のサンプルしか生成しないため、ディスクリミネーターが正しく判断できなくなるという問題があります。

- デバッグが難しい: ジェネレーターとディスクリミネーターの間の複雑な相互作用のため、GAN のデバッグは困難です。

- 評価が難しい: GAN の強力な生成能力により、GAN が生成する偽データの信頼性と多様性を評価するのは困難です。

使用シナリオ:

- 画像生成: GAN は画像生成タスクに最も一般的に使用され、さまざまなスタイルを生成できます。テキストの説明に基づいて画像を生成したり、ある画像を別のスタイルに変換したりするなど、画像の処理。

- データの強化: GAN を使用して、実際のデータに似た偽のデータを生成し、データセットを拡張したり、モデルの汎化能力を向上させることができます。

- 画像修復: GAN は、画像の欠陥を修復したり、画像からノイズを除去したりするために使用できます。

- ビデオ生成: GAN ベースのビデオ生成は、現在の研究で注目されているものの 1 つであり、さまざまなスタイルのビデオを生成できます。

簡単な Python サンプル コード:

以下は、PyTorch を使用して実装された簡単な GAN サンプル コードです。

import torchimport torch.nn as nnimport torch.optim as optimimport torch.nn.Functional as F# ジェネレーターとディスクリミネーターのネットワーク構造クラス Generator(nn.Module):def __init__(self, input_dim, Output_dim) を定義します。 super(Generator, self).__init__()self.model = nn.Sequential(nn.Linear(input_dim, 128),nn.ReLU(),nn.Linear(128, Output_dim),nn.Sigmoid())def forward (self, x):return self.model(x)class Discriminator(nn.Module):def __init__(self, input_dim):super(Discriminator, self).__init__()self.model = nn.Sequential(nn.Linear (input_dim, 128),nn.ReLU(),nn.Linear(128, 1),nn.Sigmoid())def forward(self, x):return self.model(x)# ジェネレーターとディスクリミネーターをインスタンス化する Generator オブジェクト input_dim = 100# 入力次元は実際のニーズに応じて調整できます。 Output_dim = 784# MNIST データセットの場合、出力次元は 28*28=784gen = Generator(input_dim, Output_dim)disc = Discriminator(output_dim)# 損失関数を定義しますおよびオプティマイザー基準 = nn.BCELoss()# バイナリクロスエントロピー損失関数は、GAN の弁別器部分とジェネレーターのロジスティック損失部分に適しています。ただし、一般的により一般的なオプションは、バイナリ クロスエントロピー損失関数 (バイナリ クロス

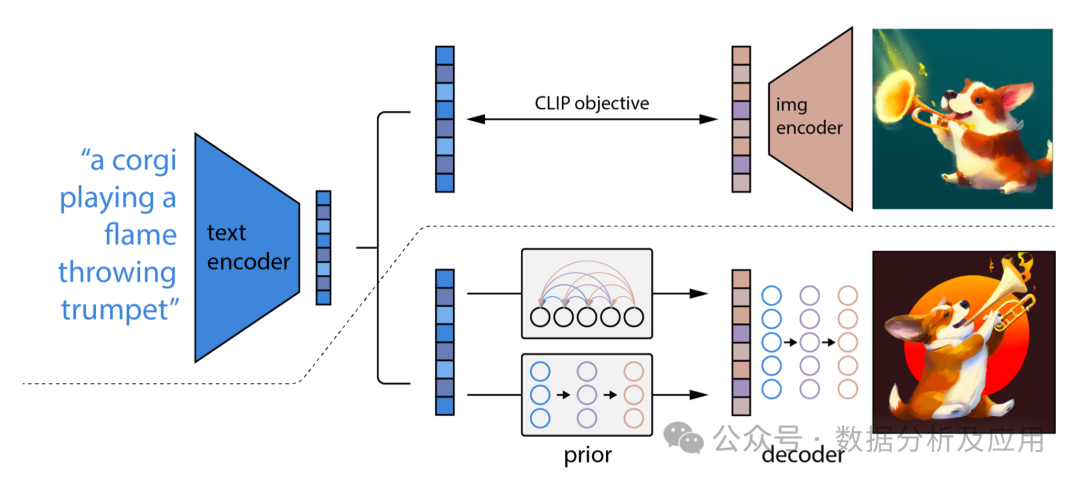

8. 拡散拡散モデル

拡散モデルは深層学習に基づいた生成モデルで、主に画像や音声などの連続データを生成するために使用されます。拡散モデルの中心的な考え方は、ノイズを徐々に追加することで複雑なデータ分布を単純なガウス分布に変換し、次にノイズを徐々に除去することで単純な分布からデータを生成することです。

モデル原理

拡散モデルには、順拡散プロセスと逆拡散プロセスという 2 つの主要なプロセスが含まれています。

順拡散プロセス:

- 実際のデータ分布からデータ ポイント (x_0) をサンプリングします。

- (T) タイム ステップ内で、ノイズを (x_0) に徐々に追加し、実際のデータ分布から徐々に遠ざかる一連のノイズ データ ポイント (x_1、x_2、...、x_T) を生成します。

- このプロセスは、データ分布を徐々にガウス分布に変換するものとみなすことができます。

逆拡散プロセス (ノイズ除去プロセスとも呼ばれます):

- ノイズ データ分布 (x_T) から開始し、徐々にノイズを除去し、次のような一連のデータを生成します。は、データ分布の実際のデータ ポイント (x_{T-1}、x_{T-2}、...、x_0) に徐々に近づきます。

- このプロセスでは、ニューラル ネットワークを学習して各ステップでノイズを予測し、この予測を使用して徐々にノイズを除去します。

モデル トレーニング

拡散モデルのトレーニングには通常、次の手順が含まれます:

- 順拡散: トレーニング データ セット内の各サンプル (x_0) について、所定のノイズ スケジューリング プランに従って、対応するノイズ シーケンス (x_1、x_2、...、x_T) が生成されます。

- ノイズ予測: タイム ステップ (t) ごとに、(x_t) のノイズを予測するようにニューラル ネットワークをトレーニングします。このニューラル ネットワークは通常、条件付き変分オートエンコーダー (CVAE) であり、(x_t) とタイム ステップ (t) を入力として受け取り、予測されたノイズを出力します。

- 最適化: 実際のノイズと予測ノイズの差を最小限に抑えて、ニューラル ネットワーク パラメーターを最適化します。一般的に使用される損失関数は、平均二乗誤差 (MSE) です。

利点

- 強力な生成機能: 拡散モデルは、高品質で多様なデータ サンプルを生成できます。

- プログレッシブ生成: モデルは生成プロセス中に中間結果を提供できるため、モデル生成プロセスを理解するのに役立ちます。

- 安定したトレーニング: 他の生成モデル (GAN など) と比較して、拡散モデルは一般にトレーニングが容易で、モード崩壊の問題が発生しにくくなります。

欠点

- 計算量が多い: 複数のタイムステップにわたる順拡散と逆拡散が必要なため、拡散モデルのトレーニングと生成プロセスには通常時間がかかります。 。

- 多数のパラメーター: タイム ステップごとに、ノイズ予測に別個のニューラル ネットワークが必要となるため、多数のモデル パラメーターが必要になります。

使用シナリオ

拡散モデルは、画像生成、音声生成、ビデオ生成など、連続データを生成する必要があるシナリオに適しています。また、モデルはプログレッシブ生成の特性を持っているため、データ補間やスタイル転送などの作業にも使用できます。

Python サンプル コード

以下は、PyTorch ライブラリを使用した拡散モデル トレーニングの簡略化されたサンプル コードです。

import torchimport torch.nn as nnimport torch.optim as optim# 単純な拡散モデル クラスがあるとします。 DiffusionModel(nn.Module):def __init__(self, input_dim, hidden_dim, num_timesteps):super(DiffusionModel , self).__init__()self.num_timesteps = num_timestepsself.noises = nn.ModuleList([nn.Linear(input_dim, hidden_dim),nn.ReLU(),nn.Linear(hidden_dim, input_dim)] for _ in range(num_timesteps ) )def forward(self, x, t):noise_prediction = self.noises[t](x)return noise_prediction# モデル パラメーターを設定します input_dim = 784# 入力が 28x28 グレースケール イメージであると仮定します hidden_dim = 128num_timesteps = 1000# model model = DiffusionModel(input_dim, hidden_dim, num_timesteps)# 損失関数とオプティマイザー基準を定義します = nn.MSELoss()optimizer = optim.Adam(model.parameters(), lr=1e-3)

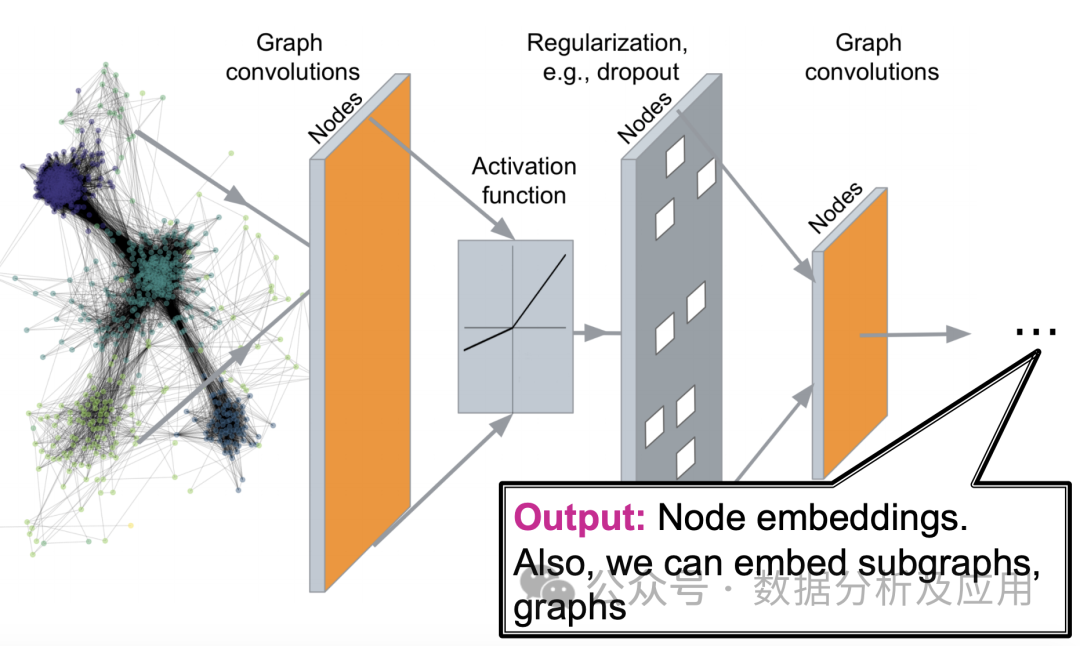

9. グラフ ニューラル ネットワーク (GNN)

グラフ ニューラル ネットワーク (略して GNN) は、グラフ構造のデータを処理するために特別に使用される深層学習モデルです。現実世界では、ソーシャル ネットワーク、分子構造、交通ネットワークなど、多くの複雑なシステムをグラフで表すことができます。従来の機械学習モデルは、これらのグラフ構造データを処理する際に多くの課題に直面しますが、グラフ ニューラル ネットワークはこれらの問題を解決するための新しいアイデアを提供します。

モデル原理:

グラフ ニューラル ネットワークの核となるアイデアは、ニューラル ネットワークを通じてグラフ内のノードの特徴表現を学習することです。ノード間の関係を考慮します。具体的には、GNN は近隣情報を繰り返し転送することでノードの表現を更新し、同じコミュニティまたは近いコミュニティ内のノードが同様の表現を持つようにします。各層で、ノードは隣接ノードに関する情報に基づいてその表現を更新し、それによってグラフ内の複雑なパターンをキャプチャします。

モデル トレーニング:

トレーニング グラフ ニューラル ネットワークでは、通常、確率的勾配降下法 (SGD) などの勾配ベースの最適化アルゴリズムが使用されます。トレーニング プロセス中に、損失関数の勾配がバックプロパゲーション アルゴリズムを通じて計算され、ニューラル ネットワークの重みが更新されます。一般的に使用される損失関数には、ノード分類のためのクロスエントロピー損失、リンク予測のためのバイナリクロスエントロピー損失などが含まれます。

利点:

- 強力な表現能力: グラフ ニューラル ネットワークは、グラフ構造の複雑なパターンを効果的にキャプチャできるため、ノード分類やリンク予測などのタスクでより良い結果が得られます。

- グラフ構造データの自然な処理: グラフ ニューラル ネットワークは、グラフを行列形式に変換せずにグラフ構造データを直接処理するため、大規模なスパース行列によって引き起こされるコンピューティングとストレージのオーバーヘッドを回避します。

- 強力なスケーラビリティ: グラフ ニューラル ネットワークは、より多くのレイヤーを積み重ねることでより複雑なパターンをキャプチャでき、スケーラビリティが高くなります。

欠点:

- 計算の複雑さが高い: グラフ内のノードとエッジの数が増加するにつれて、グラフ ニューラル ネットワークの計算の複雑さも急激に増加します。トレーニング時間が長くなる可能性があります。

- パラメータ調整の難しさ: グラフ ニューラル ネットワークには、近傍サイズ、層数、学習率などの多くのハイパーパラメータがあります。これらのパラメータを調整するには、タスクについての深い理解が必要な場合があります。

- 無向グラフと有向グラフに対する適応性の違い: グラフ ニューラル ネットワークは元々無向グラフ用に設計されており、有向グラフに対する適応性が低い場合があります。

利用シナリオ:

- ソーシャル ネットワーク分析: ソーシャル ネットワークでは、ユーザー間の関係をグラフで表現できます。グラフ ニューラル ネットワークは、ユーザー間の類似性、コミュニティの発見、影響力の広がりなどの問題を分析できます。

- 分子構造予測: 化学の分野では、分子の構造を図で表すことができます。グラフニューラルネットワークを学習させることで、分子の性質や化学反応などを予測することができます。

- レコメンデーション システム: レコメンデーション システムは、ユーザーの行動データを使用してグラフを構築し、グラフ ニューラル ネットワークを使用してユーザーの行動パターンをキャプチャして、正確なレコメンデーションを行うことができます。

- ナレッジ グラフ: ナレッジ グラフは特殊なグラフ構造データとみなすことができ、ナレッジ グラフ内のエンティティと関係は、グラフ ニューラル ネットワークを通じて深く分析できます。

簡単な Python サンプル コード:

import torchfrom torch_geometric.datasets import Planetoidfrom torch_geometric.nn import GCNConvfrom torch_geometric.data import DataLoaderimport time# Cora データセットをロードする dataset = Planetoid(root='/tmp/Cora', name='Cora')# 定義 GNNモデルクラス GNN(torch.nn.Module):def __init__(self, in_channels, hidden_channels, out_channels):super(GNN, self).__init__()self.conv1 = GCNConv(in_channels, hidden_channels)self.conv2 = GCNConv( hidden_channels 、out_channels)def forward(self, data):x、edge_index = data.x、data.edge_indexx = self.conv1(x,edge_index)x = F.relu(x)x = F.dropout(x, training= self .training)x = self.conv2(x,edge_index)return F.log_softmax(x, dim=1)# ハイパーパラメータとモデルトレーニングプロセスを定義する num_epochs = 1000lr = 0.01hidden_channels = 16out_channels = dataset.num_classesdata = dataset[0] # を使用します例としてのデータセット内の最初のデータ data model = GNN(dataset.num_features, hidden_channels, out_channels)optimizer = torch.optim.Adam(model.parameters(), lr=lr)data = DataLoader([data],batch_size=1) )# データ セットを DataLoader オブジェクトに変換して、バッチ トレーニングと評価をサポートします。model.train()# モデルをトレーニング モードに設定します。範囲 (num_epochs) のエポック:for data in data:# 各エポックでトラバースします。データ セット全体一度最適化されます optimizer.zero_grad()# 勾配をクリアします out = model(data)# 順方向伝播、出力と損失関数値を計算します loss = F.nll_loss(out[data.train_mask], data.y[data.train_mask ] )# 損失関数値を計算します。ここでは例として負の対数尤度損失関数を使用します。 loss.backward()# 逆伝播、勾配を計算します。optimizer.step()# 重みパラメータを更新します

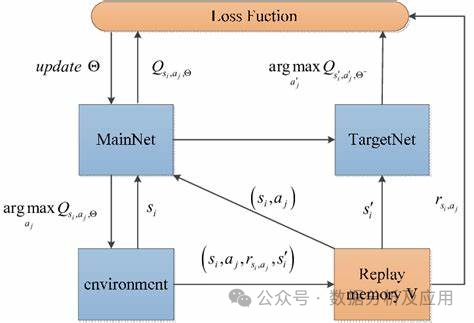

10. Deep Q ネットワーク (DQN)

従来の強化学習アルゴリズムでは、エージェントは Q テーブルを使用して状態アクション値関数の推定値を保存します。ただし、このアプローチは、高次元の状態空間とアクション空間を扱う場合に制限に遭遇します。この問題を解決するために、DQN は、より複雑な問題を処理できるように、状態アクション値関数の近似を学習する深層学習テクノロジを導入した深層強化学習アルゴリズムです。

モデル原理:

DQN は、ニューラル ネットワーク (ディープ Q ネットワークと呼ばれます) を使用して、状態アクション値関数を近似します。このニューラル ネットワークは現在の状態を入力として受け取り、各アクションの Q 値を出力します。トレーニング プロセス中、エージェントは常に環境と対話してニューラル ネットワークの重みを更新し、徐々に最適な Q 値関数に近づきます。

モデル トレーニング:

DQN のトレーニング プロセスには、オフライン段階とオンライン段階の 2 つの段階が含まれます。オフラインフェーズでは、エージェントはエクスペリエンスのバッチ (状態、アクション、報酬、次の状態) をエクスペリエンス再生バッファーからランダムにサンプリングし、これらのエクスペリエンスを使用してディープ Q ネットワークを更新します。オンライン段階では、エージェントは現在の状態とディープ Q ネットワークを使用して最適なアクションを選択して実行し、新しいエクスペリエンスをエクスペリエンス再生バッファーに保存します。

利点:

- 高次元の状態空間とアクション空間の処理: DQN は高次元の状態空間とアクション空間の複雑な問題を処理できるため、多くの分野で広く使用されています。 . .

- データ依存性の削減: エクスペリエンス リプレイ バッファーを使用することで、限られたサンプルで DQN を効果的にトレーニングできます。

- 柔軟性: DQN を他の強化学習アルゴリズムや手法と組み合わせて、パフォーマンスをさらに向上させ、その適用範囲を拡大することができます。

欠点:

- 不安定なトレーニング: 場合によっては、DQN のトレーニングが不安定になり、学習プロセスが失敗したり、パフォーマンスが低下したりすることがあります。

- 探索戦略: DQN は環境を探索し、十分な経験を収集するための効果的な探索戦略を必要とします。学習速度と最終的なパフォーマンスに影響を与える可能性があるため、適切な探索戦略を選択することが重要です。

- ターゲット ネットワークの要件: トレーニングを安定させるために、DQN は通常、ターゲット ネットワークを使用して Q 値関数を更新する必要があります。これによりアルゴリズムが複雑になり、追加のパラメーター調整が必要になります。

使用シナリオ:

DQN は、囲碁、カード ゲームなど、さまざまなゲーム AI タスクで広く使用されています。その他、ロボット制御、自然言語処理、自動運転などの分野でも活用されています。

pythonimport numpy as npimport tensorflow as tffrom tensorflow.keras.models import Sequentialfrom tensorflow.keras.layers import Dense、Dropoutclass DQN:def __init__(self, state_size, action_size):self.state_size = state_sizeself.action_size = action_sizeself .memory = np.zeros((MEM_CAPACITY, state_size * 2 2))self.gamma = 0.95self.epsilon = 1.0self.epsilon_min = 0.01self.epsilon_decay = 0.995self.learning_rate = 0.005self.model = self.create_model() def create_model(self):model = Sequential()model.add(Dense(24, input_dim=self.state_size,activation='relu'))model.add(Dense(24,activation='relu'))model.add (Dense(self.action_size, activity='linear'))model.compile(loss='mse', optimizer=tf.keras.optimizers.Adam(lr=self.learning_rate))return modeldef remember(self, state, action 、報酬、next_state、done):self.memory[self.memory_counter % MEM_CAPACITY, :] = [状態、アクション、報酬、next_state、done]self.memory_counter = 1def act(self, state):if np.random.rand () ## ###############################

以上が超強い!深層学習アルゴリズムのトップ 10!の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

Video Face Swap

完全無料の AI 顔交換ツールを使用して、あらゆるビデオの顔を簡単に交換できます。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

1668

1668

14

14

1426

1426

52

52

1329

1329

25

25

1273

1273

29

29

1256

1256

24

24

Bytedance Cutting が SVIP スーパー メンバーシップを開始: 継続的な年間サブスクリプションは 499 元で、さまざまな AI 機能を提供

Jun 28, 2024 am 03:51 AM

Bytedance Cutting が SVIP スーパー メンバーシップを開始: 継続的な年間サブスクリプションは 499 元で、さまざまな AI 機能を提供

Jun 28, 2024 am 03:51 AM

このサイトは6月27日、JianyingはByteDanceの子会社であるFaceMeng Technologyによって開発されたビデオ編集ソフトウェアであり、Douyinプラットフォームに依存しており、基本的にプラットフォームのユーザー向けに短いビデオコンテンツを作成すると報告しました。 Windows、MacOS、その他のオペレーティング システム。 Jianyingは会員システムのアップグレードを正式に発表し、インテリジェント翻訳、インテリジェントハイライト、インテリジェントパッケージング、デジタルヒューマン合成などのさまざまなAIブラックテクノロジーを含む新しいSVIPを開始しました。価格的には、クリッピングSVIPの月額料金は79元、年会費は599元(当サイト注:月額49.9元に相当)、継続月額サブスクリプションは月額59元、継続年間サブスクリプションは、年間499元(月額41.6元に相当)です。さらに、カット担当者は、ユーザーエクスペリエンスを向上させるために、オリジナルのVIPに登録している人は、

Rag と Sem-Rag を使用したコンテキスト拡張 AI コーディング アシスタント

Jun 10, 2024 am 11:08 AM

Rag と Sem-Rag を使用したコンテキスト拡張 AI コーディング アシスタント

Jun 10, 2024 am 11:08 AM

検索強化生成およびセマンティック メモリを AI コーディング アシスタントに組み込むことで、開発者の生産性、効率、精度を向上させます。 JanakiramMSV 著者の EnhancingAICodingAssistantswithContextUsingRAGandSEM-RAG から翻訳。基本的な AI プログラミング アシスタントは当然役に立ちますが、ソフトウェア言語とソフトウェア作成の最も一般的なパターンに関する一般的な理解に依存しているため、最も適切で正しいコードの提案を提供できないことがよくあります。これらのコーディング アシスタントによって生成されたコードは、彼らが解決する責任を負っている問題の解決には適していますが、多くの場合、個々のチームのコーディング標準、規約、スタイルには準拠していません。これにより、コードがアプリケーションに受け入れられるように修正または調整する必要がある提案が得られることがよくあります。

微調整によって本当に LLM が新しいことを学習できるようになるのでしょうか: 新しい知識を導入すると、モデルがより多くの幻覚を生成する可能性があります

Jun 11, 2024 pm 03:57 PM

微調整によって本当に LLM が新しいことを学習できるようになるのでしょうか: 新しい知識を導入すると、モデルがより多くの幻覚を生成する可能性があります

Jun 11, 2024 pm 03:57 PM

大規模言語モデル (LLM) は巨大なテキスト データベースでトレーニングされ、そこで大量の現実世界の知識を取得します。この知識はパラメータに組み込まれており、必要なときに使用できます。これらのモデルの知識は、トレーニングの終了時に「具体化」されます。事前トレーニングの終了時に、モデルは実際に学習を停止します。モデルを調整または微調整して、この知識を活用し、ユーザーの質問により自然に応答する方法を学びます。ただし、モデルの知識だけでは不十分な場合があり、モデルは RAG を通じて外部コンテンツにアクセスできますが、微調整を通じてモデルを新しいドメインに適応させることが有益であると考えられます。この微調整は、ヒューマン アノテーターまたは他の LLM 作成物からの入力を使用して実行され、モデルは追加の実世界の知識に遭遇し、それを統合します。

AlphaFold 3 が発売され、タンパク質とすべての生体分子の相互作用と構造をこれまでよりもはるかに高い精度で包括的に予測します。

Jul 16, 2024 am 12:08 AM

AlphaFold 3 が発売され、タンパク質とすべての生体分子の相互作用と構造をこれまでよりもはるかに高い精度で包括的に予測します。

Jul 16, 2024 am 12:08 AM

エディター | Radish Skin 2021 年の強力な AlphaFold2 のリリース以来、科学者はタンパク質構造予測モデルを使用して、細胞内のさまざまなタンパク質構造をマッピングし、薬剤を発見し、既知のあらゆるタンパク質相互作用の「宇宙地図」を描いてきました。ちょうど今、Google DeepMind が AlphaFold3 モデルをリリースしました。このモデルは、タンパク質、核酸、小分子、イオン、修飾残基を含む複合体の結合構造予測を実行できます。 AlphaFold3 の精度は、これまでの多くの専用ツール (タンパク質-リガンド相互作用、タンパク質-核酸相互作用、抗体-抗原予測) と比較して大幅に向上しました。これは、単一の統合された深層学習フレームワーク内で、次のことを達成できることを示しています。

新しい科学的で複雑な質問応答ベンチマークと大規模モデルの評価システムを提供するために、UNSW、アルゴンヌ、シカゴ大学、およびその他の機関が共同で SciQAG フレームワークを立ち上げました。

Jul 25, 2024 am 06:42 AM

新しい科学的で複雑な質問応答ベンチマークと大規模モデルの評価システムを提供するために、UNSW、アルゴンヌ、シカゴ大学、およびその他の機関が共同で SciQAG フレームワークを立ち上げました。

Jul 25, 2024 am 06:42 AM

編集者 |ScienceAI 質問応答 (QA) データセットは、自然言語処理 (NLP) 研究を促進する上で重要な役割を果たします。高品質の QA データ セットは、モデルの微調整に使用できるだけでなく、大規模言語モデル (LLM) の機能、特に科学的知識を理解し推論する能力を効果的に評価することもできます。現在、医学、化学、生物学、その他の分野をカバーする多くの科学 QA データ セットがありますが、これらのデータ セットにはまだいくつかの欠点があります。まず、データ形式は比較的単純で、そのほとんどが多肢選択式の質問であり、評価は簡単ですが、モデルの回答選択範囲が制限され、科学的な質問に回答するモデルの能力を完全にテストすることはできません。対照的に、自由回答型の Q&A

SKハイニックスは8月6日に12層HBM3E、321層NANDなどのAI関連新製品を展示する。

Aug 01, 2024 pm 09:40 PM

SKハイニックスは8月6日に12層HBM3E、321層NANDなどのAI関連新製品を展示する。

Aug 01, 2024 pm 09:40 PM

8月1日の本サイトのニュースによると、SKハイニックスは本日(8月1日)ブログ投稿を発表し、8月6日から8日まで米国カリフォルニア州サンタクララで開催されるグローバル半導体メモリサミットFMS2024に参加すると発表し、多くの新世代の製品。フューチャー メモリおよびストレージ サミット (FutureMemoryandStorage) の紹介。以前は主に NAND サプライヤー向けのフラッシュ メモリ サミット (FlashMemorySummit) でしたが、人工知能技術への注目の高まりを背景に、今年はフューチャー メモリおよびストレージ サミット (FutureMemoryandStorage) に名前が変更されました。 DRAM およびストレージ ベンダー、さらに多くのプレーヤーを招待します。昨年発売された新製品SKハイニックス

SOTA パフォーマンス、厦門マルチモーダルタンパク質-リガンド親和性予測 AI 手法、初めて分子表面情報を結合

Jul 17, 2024 pm 06:37 PM

SOTA パフォーマンス、厦門マルチモーダルタンパク質-リガンド親和性予測 AI 手法、初めて分子表面情報を結合

Jul 17, 2024 pm 06:37 PM

編集者 | KX 医薬品の研究開発の分野では、タンパク質とリガンドの結合親和性を正確かつ効果的に予測することが、医薬品のスクリーニングと最適化にとって重要です。しかし、現在の研究では、タンパク質とリガンドの相互作用における分子表面情報の重要な役割が考慮されていません。これに基づいて、アモイ大学の研究者らは、初めてタンパク質の表面、3D 構造、配列に関する情報を組み合わせ、クロスアテンション メカニズムを使用して異なるモダリティの特徴を比較する、新しいマルチモーダル特徴抽出 (MFE) フレームワークを提案しました。アライメント。実験結果は、この方法がタンパク質-リガンド結合親和性の予測において最先端の性能を達成することを実証しています。さらに、アブレーション研究は、この枠組み内でのタンパク質表面情報と多峰性特徴の位置合わせの有効性と必要性を実証しています。 「S」で始まる関連研究

AIなどの市場を開拓するグローバルファウンドリーズがタゴール・テクノロジーの窒化ガリウム技術と関連チームを買収

Jul 15, 2024 pm 12:21 PM

AIなどの市場を開拓するグローバルファウンドリーズがタゴール・テクノロジーの窒化ガリウム技術と関連チームを買収

Jul 15, 2024 pm 12:21 PM

7月5日のこのウェブサイトのニュースによると、グローバルファウンドリーズは今年7月1日にプレスリリースを発行し、自動車とインターネットでの市場シェア拡大を目指してタゴール・テクノロジーのパワー窒化ガリウム(GaN)技術と知的財産ポートフォリオを買収したことを発表した。モノと人工知能データセンターのアプリケーション分野で、より高い効率とより優れたパフォーマンスを探求します。生成 AI などのテクノロジーがデジタル世界で発展を続ける中、窒化ガリウム (GaN) は、特にデータセンターにおいて、持続可能で効率的な電力管理のための重要なソリューションとなっています。このウェブサイトは、この買収中にタゴール・テクノロジーのエンジニアリングチームがGLOBALFOUNDRIESに加わり、窒化ガリウム技術をさらに開発するという公式発表を引用した。 G