Tao Dacheng のチームは、香港大学および UMD と共同で、374 件の関連著作を要約し、LLM 知識蒸留に関する最新のレビューを発表しました。

Large Language Model (LLM) は過去 2 年間で急速に発展し、GPT-4、Gemini、Claude などのいくつかの驚異的なモデルや製品が登場しましたが、そのほとんどはクローズド ソースです。現在研究コミュニティが利用できるほとんどのオープンソース LLM とクローズドソース LLM の間には大きな隔たりがあるため、オープンソース LLM やその他の小規模モデルの機能を改善して、クローズドソースの大規模モデルとの隔たりを減らすことが研究のホットスポットとなっています。この分野で。

LLM、特にクローズドソース LLM の強力な機能により、科学研究者や産業従事者は、独自のモデルをトレーニングする際に、これらの大規模モデルの出力と知識を利用できます。このプロセスは本質的に知識蒸留 (KD) プロセスであり、教師モデル (GPT-4 など) からより小さなモデル (Llama など) に知識を蒸留し、小さなモデルの機能を大幅に向上させます。大規模な言語モデルの知識蒸留テクノロジーは遍在しており、研究者が独自のモデルをトレーニングおよび改善するのに役立つ費用対効果が高く効果的な方法であることがわかります。

それでは、現在の作業では、知識の蒸留とデータ取得のためにクローズドソース LLM をどのように利用しているのでしょうか?この知識を効率的に小さなモデルにトレーニングするにはどうすればよいでしょうか?小さなモデルは教師モデルからどのような強力なスキルを獲得できるでしょうか? LLM の知識の蒸留は、ドメインの特性を持つ業界でどのような役割を果たしますか?これらの問題は、徹底的に考え、研究する価値があります。

2020 年、Tao Dacheng のチームは、ディープラーニングにおける知識蒸留の応用を包括的に調査した「知識蒸留: 調査」を発表しました。このテクノロジーは主にモデルの圧縮と高速化に使用されます。大規模な言語モデルの台頭により、知識蒸留の応用分野は継続的に拡大しており、小規模モデルのパフォーマンスを向上させるだけでなく、モデルの自己改善も実現できます。

2024 年初頭、Tao Dacheng のチームは香港大学およびメリーランド大学と協力して、最新のレビュー「大規模言語モデルの知識蒸留に関する調査」を発表しました。このレビューでは、374 の関連研究が要約され、どのように大規模な言語モデルから学習するため、知識の獲得、小規模なモデルのトレーニング、モデルの圧縮と自己トレーニングにおける知識の蒸留の役割を学びます。同時に、このレビューでは大規模な言語モデルのスキルの抽出と垂直フィールドの抽出も取り上げており、研究者が独自のモデルをトレーニングおよび改善する方法を完全に理解するのに役立ちます。

論文タイトル: 大規模言語モデルの知識蒸留に関する調査

論文リンク: https: //arxiv.org/abs/2402.13116

プロジェクト リンク: https://github.com/Tebmer/Awesome-Knowledge-Distillation-of-LLMs

概要アーキテクチャ

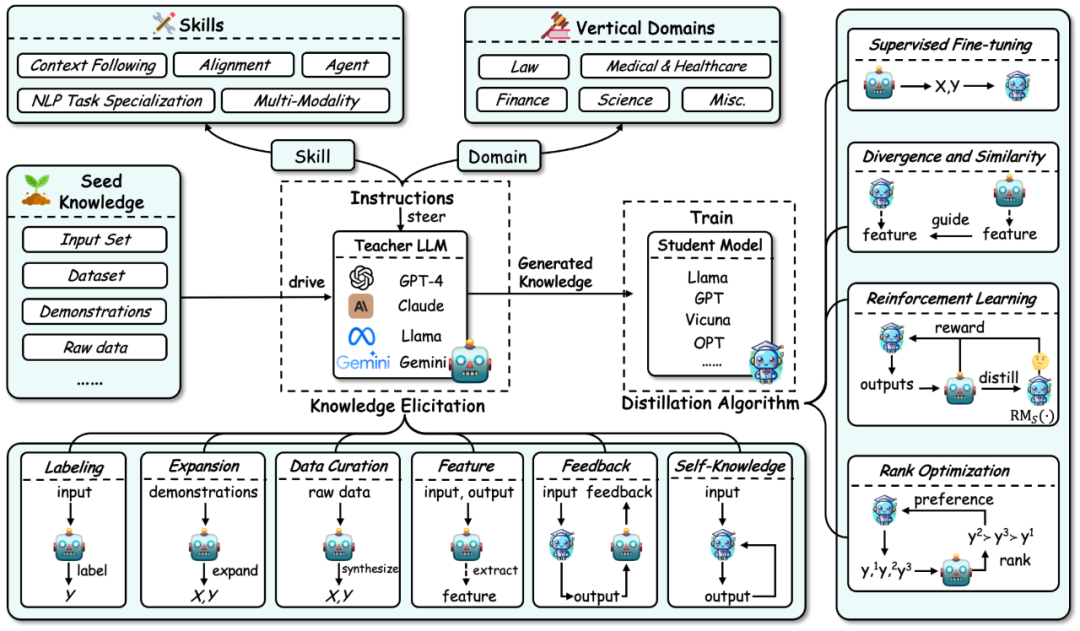

##大規模言語モデルの知識抽出の全体的なフレームワークは次のように要約されます:

知識の引き出し: 教師モデルから知識を取得する方法。このプロセスには主に次のものが含まれます。 a) 最初に、教師モデルから抽出されるスキルまたはコンピテンシーの垂直領域を特定するための指示を作成します。

b) 次に、シード知識 (特定のデータセットなど) を入力として使用して教師モデルを駆動し、対応する応答を生成し、それによって対応する知識をガイドします。

c) 同時に、知識の獲得には、アノテーション、拡張、合成、特徴抽出、フィードバック、独自の知識などの特定のテクノロジーが含まれます。

2.

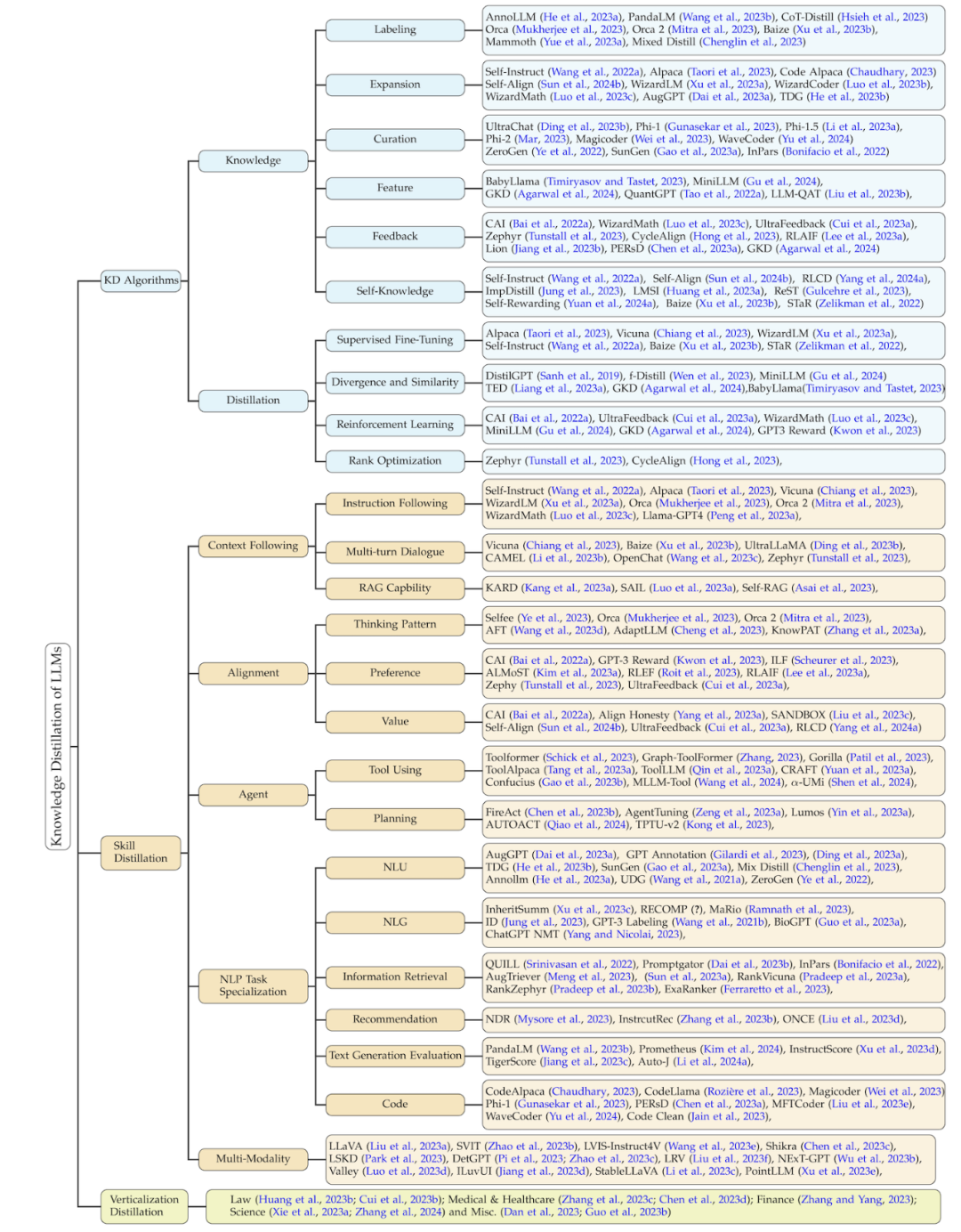

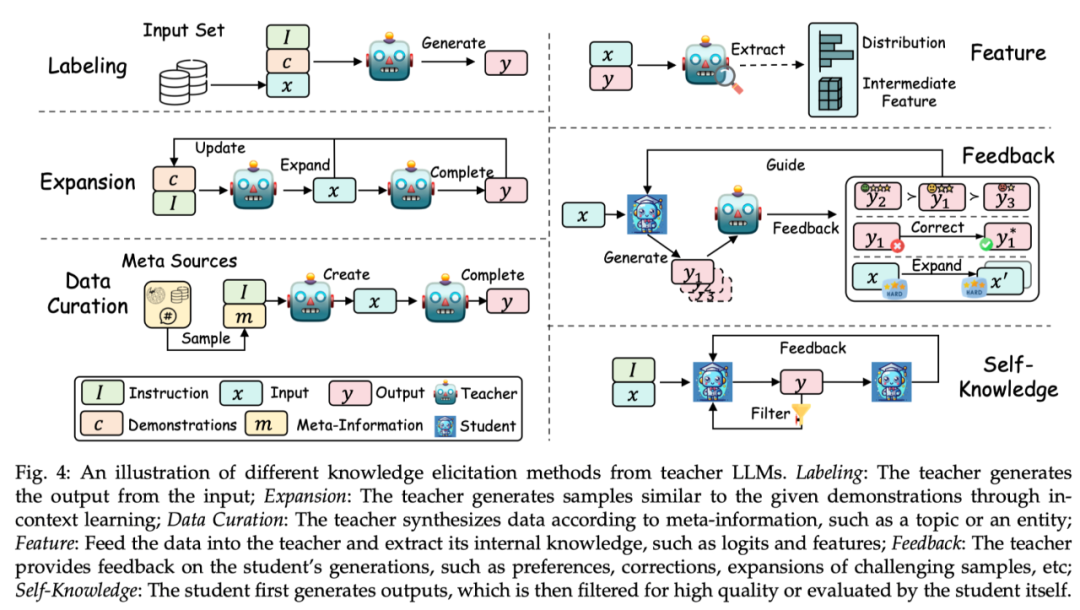

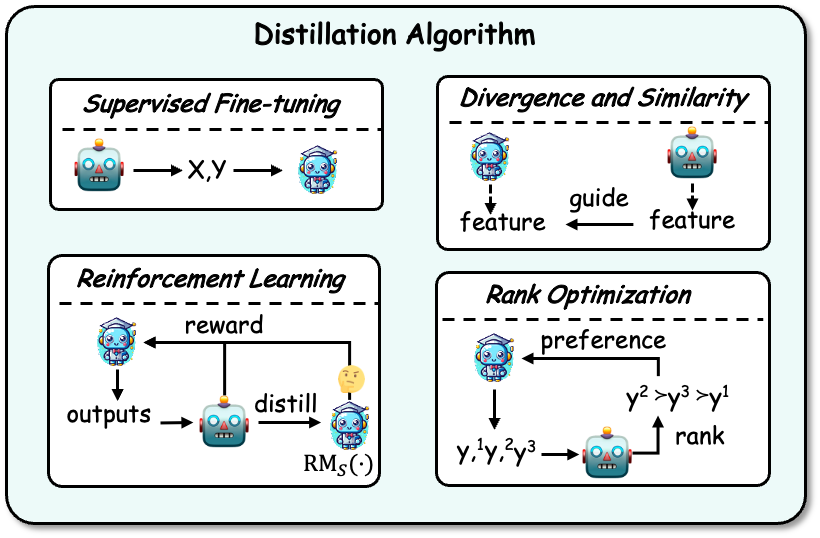

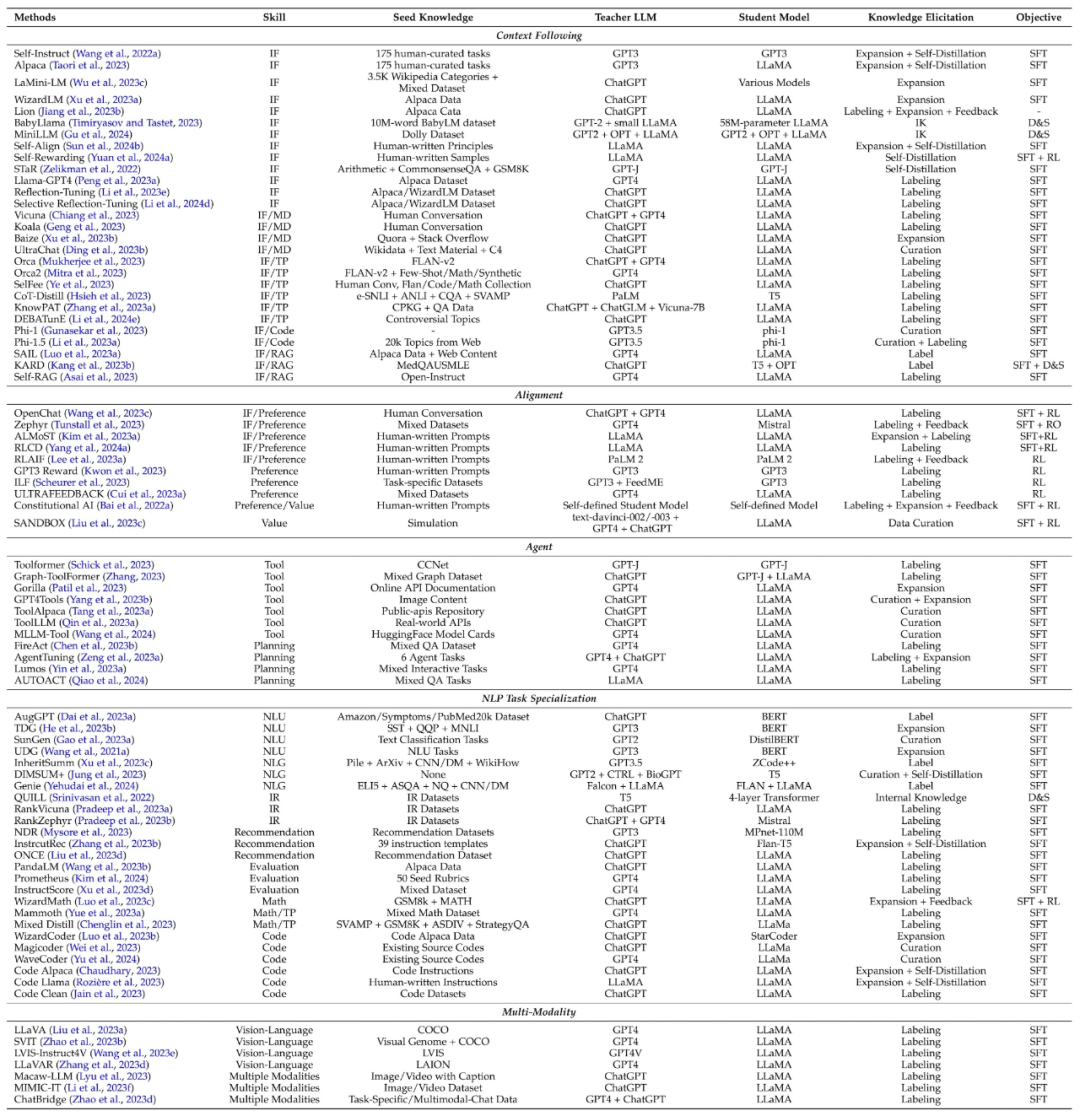

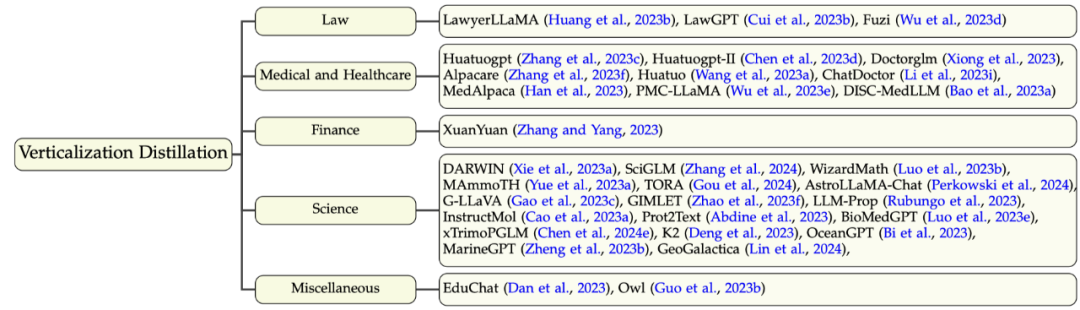

蒸留アルゴリズム: つまり、取得した知識を学生モデルに注入する方法です。この部分の具体的なアルゴリズムには、教師あり微調整、発散と類似性、強化学習 (AI フィードバックからの強化学習、RLAIF)、およびランキングの最適化が含まれます。 このレビューの分類方法は、このプロセスに基づいて、知識の蒸留アルゴリズム、スキルの蒸留、および垂直フィールドの蒸留という 3 つの側面から関連する作業を要約しています。後の 2 つは、知識抽出アルゴリズムに基づいて抽出されます。この分類の詳細と、それに対応する関連研究の概要を次の図に示します。 知識蒸留アルゴリズム 知識の引き出し 方法については、教師モデルの知識を獲得するために、このレビューではそのテクノロジーをラベル付け、拡張、データ合成、特徴抽出、フィードバック、および自己生成知識に分割しています。 ラベリング : 知識のラベリングとは、教師 LLM が指示または例に基づいて指示を与えることを指します。入力は、対応する出力を生成するためのシード知識として使用されます。たとえば、シード知識は特定のデータセットの入力であり、教師モデルは思考チェーンの出力にラベルを付けます。 拡張: このテクノロジーの重要な機能は、LLM のコンテキスト学習機能を使用して、提供されたシードの例に基づいて例と同様のデータを生成することです。利点は、例を通じてより多様で広範なデータセットを生成できることです。ただし、生成されるデータが増加し続けると、データの均一性の問題が発生する可能性があります。 データ合成 (データキュレーション): データ合成の特徴は、データを最初から合成することです。多様かつ膨大なシード知識として大量のメタ情報(トピック、知識文書、元データなど)を活用し、教師LLMから大規模かつ高品質なデータセットを取得します。 特徴の取得 (Feature): 特徴の知識を取得する一般的な方法は、入力シーケンスと出力シーケンスを教師 LLM に出力し、その内部表現を抽出することです。この方法は主にオープンソース LLM に適しており、モデルの圧縮によく使用されます。 フィードバック: フィードバック知識は通常、生徒の出力に関する教師モデルにフィードバックを提供します。たとえば、生徒がより良い出力を生成できるように導くための設定、評価、または修正情報の提供などです。 自己知識: 知識は生徒自身からも得られます。これは自己生成知識と呼ばれます。この場合、同じモデルが教師と生徒の両方として機能し、テクニックを抽出し、以前に生成された自身の出力を改善することによって反復的に自身を改善します。このアプローチは、オープンソース LLM に適しています。 まとめ: 現在でも拡張方式が広く使われており、高品質なデータを大量に生成できるデータ合成方式が徐々に主流になってきています。フィードバック方法は、学生モデルの調整能力を向上させるのに役立つ知識を提供できます。オープンソースの大規模モデルを教師モデルとして使用することにより、特徴の取得と自己生成の知識手法が普及してきました。特徴取得メソッドはオープンソース モデルの圧縮に役立ち、自己生成知識メソッドは大規模な言語モデルを継続的に改善できます。重要なのは、上記の方法は効果的に組み合わせることができ、研究者はさまざまな組み合わせを探索して、より効果的な知識を引き出すことができるということです。 アルゴリズムの抽出 知識を取得したら、それを学生モデルに抽出する必要があります。蒸留アルゴリズムには、教師あり微調整、発散と類似性、強化学習、ランキングの最適化が含まれます。例を以下に示します。 教師あり微調整: 教師あり微調整 (SFT) は、教師モデルによって生成されたシーケンスの尤度を最大化することで学生モデルを微調整し、学生モデルが教師モデルを模倣できるようにします。これは現在、LLM の知識の蒸留で最も一般的に使用されている手法です。 発散と類似性: このアルゴリズムは、教師モデルの内部パラメーターの知識を生徒モデルのトレーニングの監視信号として使用し、オープンソースの教師モデルに適しています。発散と類似性に基づく方法は、それぞれ確率分布と隠れ状態を調整します。 強化学習 : このアルゴリズムは、教師のフィードバック知識を使用して生徒モデルをトレーニングする、つまり RLAIF テクノロジーに適しています。主な側面は 2 つあります: (1) 教師が生成したフィードバック データを使用して生徒の報酬モデルをトレーニングする、(2) トレーニングされた報酬モデルを通じて期待される報酬を最大化することで生徒のモデルを最適化する。教師が直接報酬モデルとして機能することもできます。 ランクの最適化: ランキングの最適化では、生徒モデルに好みの知識を注入することもできます。その利点は、DPO、RRHF などのいくつかの古典的なアルゴリズムなど、安定性と高い計算効率です。 スキルの抽出 誰もが知っているように、大規模な言語モデルには多くの優れた機能があります。知識蒸留技術を通じて、教師が対応するスキルを含む知識を生成し、生徒モデルをトレーニングしてこれらの能力を習得できるように制御するための指示が提供されます。これらの機能には主に、コンテキスト (指示など) の追跡、位置合わせ、エージェント、自然言語処理 (NLP) タスク、マルチモダリティなどの機能が含まれます。 次の表は、スキル蒸留の古典的な作業を要約し、各作業に関連するスキル、シード知識、教師モデル、生徒モデル、知識獲得方法、蒸留アルゴリズムもまとめています。 垂直ドメイン蒸留 一般的な分野の大規模言語モデルに加えて、現在、大規模言語をトレーニングする多くの作業が行われています。垂直分野のモデル 。これは、研究コミュニティや業界が大規模な言語モデルを適用および展開するのに役立ちます。大規模な言語モデル (GPT-4 など) は、垂直分野におけるドメイン知識が限られていますが、それでもある程度のドメイン知識と機能を提供したり、既存のドメイン データ セットを強化したりできます。ここで扱う分野は主に、(1) 法律、(2) 医療、健康、(3) 金融、(4) 科学、その他の分野です。この部分の分類と関連作業を以下に示します。 今後の方向性 このレビューでは、現在の大規模な言語モデルについて調査します。知識の蒸留と潜在的な将来の研究の方向性には主に次のものが含まれます: データ選択: より良い蒸留結果を達成するためにデータを自動的に選択するにはどうすればよいですか? 複数教師の蒸留: さまざまな教師モデルから 1 つの生徒モデルへの知識の蒸留を調べます。 教師モデルのより豊富な知識 : 教師モデルでは、フィードバックや機能の知識を含むより豊富な知識を探索したり、複数の知識取得方法を探索したりできます。組み合わせ。 蒸留中の壊滅的な忘却の克服: 知識の蒸留または伝達中に元のモデルを効果的に保存する機能は依然として困難な問題です。 信頼できる知識の抽出: 現在、KD はさまざまなスキルの抽出に主に焦点を当てており、大規模なモデルの信頼性にはあまり注意を払っていません。 弱から強への蒸留(弱から強への蒸留)。 OpenAI は、「弱いものから強いものへの一般化」という概念を提案しています。これには、弱いモデルがより強いモデルの学習プロセスを効果的に導くことができるように、革新的な技術戦略を模索する必要があります。 自己調整 (自己蒸留)。フィードバック、批評、説明を生成することで、学生モデルが生成されたコンテンツを自律的に改善し、調整するように指示を設計できます。 結論 このレビューでは、大規模な言語モデルの知識を使用して、次のような学生モデルを改善する方法について包括的かつ包括的にレビューします。オープンソースの大規模言語モデル。最近人気の自己蒸留技術も含めて体系的にまとめられています。このレビューでは、知識の蒸留を知識の取得と蒸留アルゴリズムの 2 つのステップに分け、スキルの蒸留と垂直フィールドの蒸留についてもまとめます。最後に、このレビューでは、大規模言語モデルの知識蒸留の限界を押し広げ、よりアクセスしやすく、効率的、効果的で、信頼できる大規模言語モデルを取得することを期待して、大規模言語モデルの蒸留の将来の方向性を探ります。

以上がTao Dacheng のチームは、香港大学および UMD と共同で、374 件の関連著作を要約し、LLM 知識蒸留に関する最新のレビューを発表しました。の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7486

7486

15

15

1377

1377

52

52

77

77

11

11

19

19

38

38

DeepMind ロボットが卓球をすると、フォアハンドとバックハンドが空中に滑り出し、人間の初心者を完全に打ち負かしました

Aug 09, 2024 pm 04:01 PM

DeepMind ロボットが卓球をすると、フォアハンドとバックハンドが空中に滑り出し、人間の初心者を完全に打ち負かしました

Aug 09, 2024 pm 04:01 PM

でももしかしたら公園の老人には勝てないかもしれない?パリオリンピックの真っ最中で、卓球が注目を集めています。同時に、ロボットは卓球のプレーにも新たな進歩をもたらしました。先ほど、DeepMind は、卓球競技において人間のアマチュア選手のレベルに到達できる初の学習ロボット エージェントを提案しました。論文のアドレス: https://arxiv.org/pdf/2408.03906 DeepMind ロボットは卓球でどれくらい優れていますか?おそらく人間のアマチュアプレーヤーと同等です: フォアハンドとバックハンドの両方: 相手はさまざまなプレースタイルを使用しますが、ロボットもそれに耐えることができます: さまざまなスピンでサーブを受ける: ただし、ゲームの激しさはそれほど激しくないようです公園の老人。ロボット、卓球用

初のメカニカルクロー!元羅宝は2024年の世界ロボット会議に登場し、家庭に入ることができる初のチェスロボットを発表した

Aug 21, 2024 pm 07:33 PM

初のメカニカルクロー!元羅宝は2024年の世界ロボット会議に登場し、家庭に入ることができる初のチェスロボットを発表した

Aug 21, 2024 pm 07:33 PM

8月21日、2024年世界ロボット会議が北京で盛大に開催された。 SenseTimeのホームロボットブランド「Yuanluobot SenseRobot」は、全製品ファミリーを発表し、最近、世界初の家庭用チェスロボットとなるYuanluobot AIチェスプレイロボット - Chess Professional Edition(以下、「Yuanluobot SenseRobot」という)をリリースした。家。 Yuanluobo の 3 番目のチェス対局ロボット製品である新しい Guxiang ロボットは、AI およびエンジニアリング機械において多くの特別な技術アップグレードと革新を経て、初めて 3 次元のチェスの駒を拾う機能を実現しました。家庭用ロボットの機械的な爪を通して、チェスの対局、全員でのチェスの対局、記譜のレビューなどの人間と機械の機能を実行します。

クロードも怠け者になってしまった!ネチズン: 自分に休日を与える方法を学びましょう

Sep 02, 2024 pm 01:56 PM

クロードも怠け者になってしまった!ネチズン: 自分に休日を与える方法を学びましょう

Sep 02, 2024 pm 01:56 PM

もうすぐ学校が始まり、新学期を迎える生徒だけでなく、大型AIモデルも気を付けなければなりません。少し前、レディットはクロードが怠け者になったと不満を漏らすネチズンでいっぱいだった。 「レベルが大幅に低下し、頻繁に停止し、出力も非常に短くなりました。リリースの最初の週は、4 ページの文書全体を一度に翻訳できましたが、今では 0.5 ページの出力さえできません」 !」 https://www.reddit.com/r/ClaudeAI/comments/1by8rw8/something_just_feels_wrong_with_claude_in_the/ というタイトルの投稿で、「クロードには完全に失望しました」という内容でいっぱいだった。

世界ロボット会議で「未来の高齢者介護の希望」を担う家庭用ロボットを囲みました

Aug 22, 2024 pm 10:35 PM

世界ロボット会議で「未来の高齢者介護の希望」を担う家庭用ロボットを囲みました

Aug 22, 2024 pm 10:35 PM

北京で開催中の世界ロボット会議では、人型ロボットの展示が絶対的な注目となっているスターダストインテリジェントのブースでは、AIロボットアシスタントS1がダルシマー、武道、書道の3大パフォーマンスを披露した。文武両道を備えた 1 つの展示エリアには、多くの専門的な聴衆とメディアが集まりました。弾性ストリングのエレガントな演奏により、S1 は、スピード、強さ、正確さを備えた繊細な操作と絶対的なコントロールを発揮します。 CCTVニュースは、「書道」の背後にある模倣学習とインテリジェント制御に関する特別レポートを実施し、同社の創設者ライ・ジエ氏は、滑らかな動きの背後にあるハードウェア側が最高の力制御と最も人間らしい身体指標(速度、負荷)を追求していると説明した。など)、AI側では人の実際の動きのデータが収集され、強い状況に遭遇したときにロボットがより強くなり、急速に進化することを学習することができます。そしてアジャイル

ACL 2024 賞の発表: HuaTech による Oracle 解読に関する最優秀論文の 1 つ、GloVe Time Test Award

Aug 15, 2024 pm 04:37 PM

ACL 2024 賞の発表: HuaTech による Oracle 解読に関する最優秀論文の 1 つ、GloVe Time Test Award

Aug 15, 2024 pm 04:37 PM

貢献者はこの ACL カンファレンスから多くのことを学びました。 6日間のACL2024がタイのバンコクで開催されています。 ACL は、計算言語学と自然言語処理の分野におけるトップの国際会議で、国際計算言語学協会が主催し、毎年開催されます。 ACL は NLP 分野における学術的影響力において常に第一位にランクされており、CCF-A 推奨会議でもあります。今年の ACL カンファレンスは 62 回目であり、NLP 分野における 400 以上の最先端の作品が寄せられました。昨日の午後、カンファレンスは最優秀論文およびその他の賞を発表しました。今回の優秀論文賞は7件(未発表2件)、最優秀テーマ論文賞1件、優秀論文賞35件です。このカンファレンスでは、3 つの Resource Paper Award (ResourceAward) と Social Impact Award (

宏蒙スマートトラベルS9とフルシナリオ新製品発売カンファレンス、多数の大ヒット新製品が一緒にリリースされました

Aug 08, 2024 am 07:02 AM

宏蒙スマートトラベルS9とフルシナリオ新製品発売カンファレンス、多数の大ヒット新製品が一緒にリリースされました

Aug 08, 2024 am 07:02 AM

今日の午後、Hongmeng Zhixingは新しいブランドと新車を正式に歓迎しました。 8月6日、ファーウェイはHongmeng Smart Xingxing S9およびファーウェイのフルシナリオ新製品発表カンファレンスを開催し、パノラマスマートフラッグシップセダンXiangjie S9、新しいM7ProおよびHuawei novaFlip、MatePad Pro 12.2インチ、新しいMatePad Air、Huawei Bisheng Withを発表しました。レーザー プリンタ X1 シリーズ、FreeBuds6i、WATCHFIT3、スマート スクリーン S5Pro など、スマート トラベル、スマート オフィスからスマート ウェアに至るまで、多くの新しいオールシナリオ スマート製品を開発し、ファーウェイは消費者にスマートな体験を提供するフル シナリオのスマート エコシステムを構築し続けています。すべてのインターネット。宏孟志興氏:スマートカー業界のアップグレードを促進するための徹底的な権限付与 ファーウェイは中国の自動車業界パートナーと提携して、

Li Feifei 氏のチームは、ロボットに空間知能を与え、GPT-4o を統合する ReKep を提案しました

Sep 03, 2024 pm 05:18 PM

Li Feifei 氏のチームは、ロボットに空間知能を与え、GPT-4o を統合する ReKep を提案しました

Sep 03, 2024 pm 05:18 PM

ビジョンとロボット学習の緊密な統合。最近話題の1X人型ロボットNEOと合わせて、2つのロボットハンドがスムーズに連携して服をたたむ、お茶を入れる、靴を詰めるといった動作をしていると、いよいよロボットの時代が到来するのではないかと感じられるかもしれません。実際、これらの滑らかな動きは、高度なロボット技術 + 精緻なフレーム設計 + マルチモーダル大型モデルの成果です。有用なロボットは多くの場合、環境との複雑かつ絶妙な相互作用を必要とし、環境は空間領域および時間領域の制約として表現できることがわかっています。たとえば、ロボットにお茶を注いでもらいたい場合、ロボットはまずティーポットのハンドルを掴んで、お茶をこぼさないように垂直に保ち、次にポットの口がカップの口と揃うまでスムーズに動かす必要があります。 、そしてティーポットを一定の角度に傾けます。これ

7つの「ソラレベル」ビデオ生成アーティファクトをテストしました。誰が「鉄の玉座」に昇る能力を持っていますか?

Aug 05, 2024 pm 07:19 PM

7つの「ソラレベル」ビデオ生成アーティファクトをテストしました。誰が「鉄の玉座」に昇る能力を持っていますか?

Aug 05, 2024 pm 07:19 PM

Machine Power Report 編集者: Yang Wen AI ビデオ サークルの王になれるのは誰ですか?アメリカのテレビシリーズ「ゲーム・オブ・スローンズ」に「鉄の玉座」というものがあります。伝説によれば、それは最高の権威を象徴する敵が捨てた数千の剣を溶かした巨大なドラゴン「黒死病」によって作られたとされています。この鉄の椅子に座るために、主要な家族は争いと争いを始めました。 Sora の登場以来、AI ビデオ界では活発な「ゲーム オブ スローンズ」が立ち上がっています。このゲームの主なプレーヤーには、国内の Kuaishou Keling、ByteDream だけでなく、海の向こうの RunwayGen-3 や Luma も含まれます。およびZhimo。今日は、誰が AI ビデオサークルの「鉄の玉座」に座る資格があるかを評価して確認します。 -1- ヴィンセントビデオ