顧客のプライバシーを保護するために、Ruby を使用してオープンソース AI モデルをローカルで実行します。

#翻訳者| Chen Jun

##査読者| Chonglou最近、カスタマイズされた人工知能 (AI) プロジェクトを実装しました。当事者 A が非常に機密性の高い顧客情報を保持していることを考慮すると、セキュリティ上の理由から、その情報を

OpenAI や他の独自モデルに渡すことはできません。したがって、オープンソース AI モデルを AWS 仮想マシンにダウンロードして実行し、完全に管理下に置きました。同時に、Rails アプリケーションは安全な環境で AI への API 呼び出しを行うことができます。もちろん、セキュリティの問題を考慮する必要がない場合は、OpenAI と直接協力することを希望します。

#Ruby スクリプトを実行します。 #カスタマイズする理由

#このプロジェクトの動機は単純です。それはデータのセキュリティです。機密性の高い顧客情報を扱う場合、通常、最も信頼できるアプローチは社内で行うことです。したがって、より高いレベルのセキュリティ制御とプライバシー保護を提供する役割を果たすために、カスタマイズされた AI モデルが必要です。

#オープンソース モデル

過去の6

過去数か月間、Mistral、Mixtral、Lama などの製品が登場しました。 ## やその他多くのオープンソース AI モデルが市場に登場しました。 GPT-4 ほど強力ではありませんが、その多くのパフォーマンスは GPT-3.5 を上回っています。時間が経つにつれて、彼らはますます強くなります。もちろん、どのモデルを選択するかは、処理能力と何を達成する必要があるかによって決まります。 #AI モデルをローカルで実行するため、約 4GB

のサイズが選択されましたミストラル。ほとんどの指標で GPT-3.5 を上回ります。 Mixtral は Mistral よりもパフォーマンスが優れていますが、少なくとも 48GB# が必要な大容量のモデルです。 ##メモリは実行できます。 パラメータ

大規模な言語モデル (LLM) についての話)、パラメータのサイズについて言及することをよく検討します。ここで、ローカルで実行する

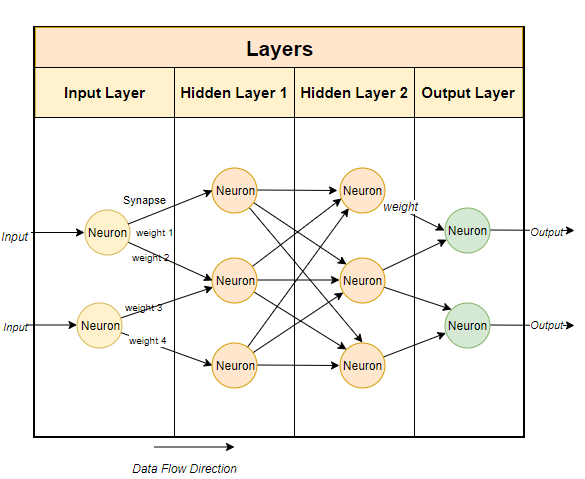

Mistral モデルは、7,000 万個のパラメータを持つ 70# モデルです (もちろん Mixtral には 700 億のパラメータがあり、GPT-3.5 には約 があります。 1750 億パラメータ)。 # 通常、大規模な言語モデルではニューラル ネットワーク ベースの手法が使用されます。ニューラル ネットワークはニューロンで構成され、各ニューロンは次の層の他のすべてのニューロンに接続されます。

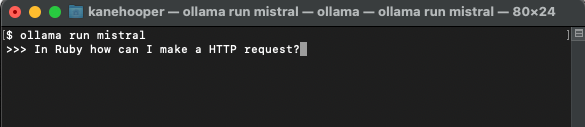

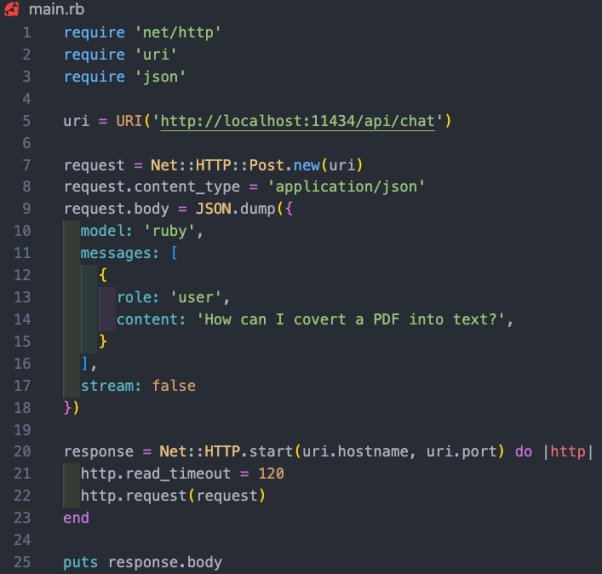

上の図に示すように、各接続には重みがあります。 、通常はパーセンテージで表されます。各ニューロンにはバイアスもあり、データがノードを通過するときにデータを修正します。 ニューラル ネットワークの目的は、高度なアルゴリズム、つまりパターン マッチング アルゴリズムを「学習」することです。大量のテキストでトレーニングを受けることで、テキストのパターンを予測し、与えられた合図に有意義に応答する能力を徐々に学習します。簡単に言うと、パラメーターはモデル内の重みとバイアスの数です。これにより、ニューラル ネットワーク内にいくつのニューロンが存在するかがわかります。たとえば、70 億個のパラメーターを持つモデルの場合、約 100 層があり、それぞれに数千のニューロンが含まれます。 オープン ソース モデルをローカルで実行するには、次のことを行う必要があります。まずは関連アプリケーションをダウンロードしてください。市場には多くのオプションがありますが、IntelMac で実行するのに最も簡単で簡単だと思うのは Ollama です。 ただし、Ollama は現在 Mac でのみ利用可能です。 Linux 上で動作しますが、将来的には Windows でも動作する予定です。もちろん、WSL (Linux 用 Windows サブシステム) を使用して、Windows 上で Linux シェル# を実行することもできます。 ####。 Ollama を使用すると、さまざまなオープン ソース モデルをダウンロードして実行できるだけでなく、ローカル ポートでモデルを開くこともできます。 Ruby コードで API 呼び出しを行うことができます。これにより、Ruby 開発者は、ローカル モデルと統合できる Ruby アプリケーションを簡単に作成できるようになります。 Get Mac# および Linux システムに Ollama をインストールするのは非常に簡単です。リンク #https://www.php.cn/link/04c7f37f2420f0532d7f0e062ff2d5b5 から Ollama をダウンロードするだけです。5# を費やしてください。 ##ソフトウェア パッケージをインストールしてモデルを実行するには、約 1 分かかります。 #最初のモデルをインストールします ##ollama run misstral #Mistral は約 4GB であるため、ダウンロードが完了するまでに時間がかかります。ダウンロードが完了すると、Mistral と対話して通信するための Ollama プロンプトが自動的に開きます。 では、対応するモデルを直接実行できます。 #カスタマイズされたモデル # に作成します。Ollama を通じて、基本モデルをカスタマイズできます。ここでは、カスタム モデルを簡単に作成できます。より詳細なケースについては、Ollama のオンライン ドキュメントを参照してください。 まず、Modelfile (モデル ファイル) を作成し、その中に次のテキストを追加します。 FROM misstral# 温度を設定します応答のランダム性または創造性を設定しますPARAMETER 温度 0.3# システム メッセージを設定しますSYSTEM ”””あなたは抜粋の Ruby 開発者です。Ruby プログラミング言語について質問されます。コード例とともに説明します。””” #上記のシステム メッセージは、AI モデルの特定の応答の基礎です。 ollama create 私たちのプロジェクトの場合、モデルにRuby##という名前を付けました。 #。 ollam create Ruby -f './Modelfile'同時に、以下を使用できます。自分自身をリストして表示するには、次のコマンドを実行します。 既存のモデル: この時点で、次のコマンドを使用してカスタム モデルを実行できます: Ollama にはまだ専用の gem がありませんが、 Ruby 開発者は、基本的な HTTP リクエスト メソッドを使用してモデルを操作できます。バックグラウンドで実行されている Ollama は、11434 ポートを介してモデルを開くことができるため、「https://www.php」経由でモデルを開くことができます。 cn/link/ dcd3f83c96576c0fd437286a1ff6f1f0」とアクセスしてください。さらに、OllamaAPI のドキュメントでは、チャット会話や埋め込みの作成などの基本的なコマンド用のさまざまなエンドポイントも提供しています。 このプロジェクトの場合、/api/chat エンドポイントを使用して、プロンプトをAIモデル。以下の画像は、モデルと対話するための基本的な Ruby コードを示しています。 上記の Ruby コード スニペットの機能には次のものが含まれます: 翻訳者紹介 Julian Chen )、51CTO コミュニティ編集者は、IT プロジェクトの実装に 10 年以上の経験があり、社内外のリソースとリスクの管理と制御に優れ、ネットワークと情報セキュリティの知識と経験の普及に重点を置いています。 #元のタイトル: ##Ruby を使用してオープンソース AI モデルをローカルで実行する方法 ケイン・フーパー著 ##

#モデルをローカルで実行する

OllamaOllama は主に以下に基づいているため、コマンドラインを使用するため、

Ollama をセットアップして実行すると、ブラウザのタスクバーに Ollama アイコンが表示されます。これは、バックグラウンドで実行されており、モデルを実行できることを意味します。モデルをダウンロードするには、ターミナルを開いて次のコマンドを実行します:

##OpenAI のものと同様## カスタマイズされた GPT

を 次に、ターミナルで次のコマンドを実行して新しいモデルを作成できます:

Ruby との統合

モデル キーは、今回のモデルである "

メッセージ ハッシュは、AI モデルと交差するパターンに従います。キャラクターとコンテンツが付属しています。ここでの役割は、システム、ユーザー、および補助です。このうち、

前述のように、ローカル AI モデルを実行します本当の価値は、機密データを保持し、電子メールや文書などの非構造化データを処理し、貴重な構造化情報を抽出する企業を支援することにあります。私たちが参加したプロジェクト ケースでは、顧客関係管理 (CRM) システム内のすべての顧客情報に対してモデル トレーニングを実施しました。これにより、ユーザーは何百ものレコードを調べなくても、顧客について質問できるようになります。

以上が顧客のプライバシーを保護するために、Ruby を使用してオープンソース AI モデルをローカルで実行します。の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

Video Face Swap

完全無料の AI 顔交換ツールを使用して、あらゆるビデオの顔を簡単に交換できます。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7697

7697

15

15

1640

1640

14

14

1393

1393

52

52

1287

1287

25

25

1229

1229

29

29

Bytedance Cutting が SVIP スーパー メンバーシップを開始: 継続的な年間サブスクリプションは 499 元で、さまざまな AI 機能を提供

Jun 28, 2024 am 03:51 AM

Bytedance Cutting が SVIP スーパー メンバーシップを開始: 継続的な年間サブスクリプションは 499 元で、さまざまな AI 機能を提供

Jun 28, 2024 am 03:51 AM

このサイトは6月27日、JianyingはByteDanceの子会社であるFaceMeng Technologyによって開発されたビデオ編集ソフトウェアであり、Douyinプラットフォームに依存しており、基本的にプラットフォームのユーザー向けに短いビデオコンテンツを作成すると報告しました。 Windows、MacOS、その他のオペレーティング システム。 Jianyingは会員システムのアップグレードを正式に発表し、インテリジェント翻訳、インテリジェントハイライト、インテリジェントパッケージング、デジタルヒューマン合成などのさまざまなAIブラックテクノロジーを含む新しいSVIPを開始しました。価格的には、クリッピングSVIPの月額料金は79元、年会費は599元(当サイト注:月額49.9元に相当)、継続月額サブスクリプションは月額59元、継続年間サブスクリプションは、年間499元(月額41.6元に相当)です。さらに、カット担当者は、ユーザーエクスペリエンスを向上させるために、オリジナルのVIPに登録している人は、

新しい科学的で複雑な質問応答ベンチマークと大規模モデルの評価システムを提供するために、UNSW、アルゴンヌ、シカゴ大学、およびその他の機関が共同で SciQAG フレームワークを立ち上げました。

Jul 25, 2024 am 06:42 AM

新しい科学的で複雑な質問応答ベンチマークと大規模モデルの評価システムを提供するために、UNSW、アルゴンヌ、シカゴ大学、およびその他の機関が共同で SciQAG フレームワークを立ち上げました。

Jul 25, 2024 am 06:42 AM

編集者 |ScienceAI 質問応答 (QA) データセットは、自然言語処理 (NLP) 研究を促進する上で重要な役割を果たします。高品質の QA データ セットは、モデルの微調整に使用できるだけでなく、大規模言語モデル (LLM) の機能、特に科学的知識を理解し推論する能力を効果的に評価することもできます。現在、医学、化学、生物学、その他の分野をカバーする多くの科学 QA データ セットがありますが、これらのデータ セットにはまだいくつかの欠点があります。まず、データ形式は比較的単純で、そのほとんどが多肢選択式の質問であり、評価は簡単ですが、モデルの回答選択範囲が制限され、科学的な質問に回答するモデルの能力を完全にテストすることはできません。対照的に、自由回答型の Q&A

SKハイニックスは8月6日に12層HBM3E、321層NANDなどのAI関連新製品を展示する。

Aug 01, 2024 pm 09:40 PM

SKハイニックスは8月6日に12層HBM3E、321層NANDなどのAI関連新製品を展示する。

Aug 01, 2024 pm 09:40 PM

8月1日の本サイトのニュースによると、SKハイニックスは本日(8月1日)ブログ投稿を発表し、8月6日から8日まで米国カリフォルニア州サンタクララで開催されるグローバル半導体メモリサミットFMS2024に参加すると発表し、多くの新世代の製品。フューチャー メモリおよびストレージ サミット (FutureMemoryandStorage) の紹介。以前は主に NAND サプライヤー向けのフラッシュ メモリ サミット (FlashMemorySummit) でしたが、人工知能技術への注目の高まりを背景に、今年はフューチャー メモリおよびストレージ サミット (FutureMemoryandStorage) に名前が変更されました。 DRAM およびストレージ ベンダー、さらに多くのプレーヤーを招待します。昨年発売された新製品SKハイニックス

SOTA パフォーマンス、厦門マルチモーダルタンパク質-リガンド親和性予測 AI 手法、初めて分子表面情報を結合

Jul 17, 2024 pm 06:37 PM

SOTA パフォーマンス、厦門マルチモーダルタンパク質-リガンド親和性予測 AI 手法、初めて分子表面情報を結合

Jul 17, 2024 pm 06:37 PM

編集者 | KX 医薬品の研究開発の分野では、タンパク質とリガンドの結合親和性を正確かつ効果的に予測することが、医薬品のスクリーニングと最適化にとって重要です。しかし、現在の研究では、タンパク質とリガンドの相互作用における分子表面情報の重要な役割が考慮されていません。これに基づいて、アモイ大学の研究者らは、初めてタンパク質の表面、3D 構造、配列に関する情報を組み合わせ、クロスアテンション メカニズムを使用して異なるモダリティの特徴を比較する、新しいマルチモーダル特徴抽出 (MFE) フレームワークを提案しました。アライメント。実験結果は、この方法がタンパク質-リガンド結合親和性の予測において最先端の性能を達成することを実証しています。さらに、アブレーション研究は、この枠組み内でのタンパク質表面情報と多峰性特徴の位置合わせの有効性と必要性を実証しています。 「S」で始まる関連研究

AIなどの市場を開拓するグローバルファウンドリーズがタゴール・テクノロジーの窒化ガリウム技術と関連チームを買収

Jul 15, 2024 pm 12:21 PM

AIなどの市場を開拓するグローバルファウンドリーズがタゴール・テクノロジーの窒化ガリウム技術と関連チームを買収

Jul 15, 2024 pm 12:21 PM

7月5日のこのウェブサイトのニュースによると、グローバルファウンドリーズは今年7月1日にプレスリリースを発行し、自動車とインターネットでの市場シェア拡大を目指してタゴール・テクノロジーのパワー窒化ガリウム(GaN)技術と知的財産ポートフォリオを買収したことを発表した。モノと人工知能データセンターのアプリケーション分野で、より高い効率とより優れたパフォーマンスを探求します。生成 AI などのテクノロジーがデジタル世界で発展を続ける中、窒化ガリウム (GaN) は、特にデータセンターにおいて、持続可能で効率的な電力管理のための重要なソリューションとなっています。このウェブサイトは、この買収中にタゴール・テクノロジーのエンジニアリングチームがGLOBALFOUNDRIESに加わり、窒化ガリウム技術をさらに開発するという公式発表を引用した。 G

Iyo One: 一部ヘッドフォン、一部オーディオコンピュータ

Aug 08, 2024 am 01:03 AM

Iyo One: 一部ヘッドフォン、一部オーディオコンピュータ

Aug 08, 2024 am 01:03 AM

どんな時でも集中力は美徳です。著者 | 編集者 Tang Yitao | 人工知能の復活により、ハードウェア革新の新たな波が起きています。最も人気のある AIPin は前例のない否定的なレビューに遭遇しました。マーケス・ブラウンリー氏(MKBHD)はこれを、これまでレビューした中で最悪の製品だと評したが、ザ・ヴァージの編集者デイビッド・ピアース氏は、誰にもこのデバイスの購入を勧めないと述べた。競合製品である RabbitR1 はそれほど優れていません。この AI デバイスに関する最大の疑問は、これが明らかに単なるアプリであるのに、Rabbit は 200 ドルのハードウェアを構築したということです。多くの人がAIハードウェアのイノベーションをスマートフォン時代を打破するチャンスと捉え、スマートフォン時代に全力を注ぐ。

初の完全自動科学発見 AI システム、Transformer 作者のスタートアップ、Sakana AI が AI Scientist を発表

Aug 13, 2024 pm 04:43 PM

初の完全自動科学発見 AI システム、Transformer 作者のスタートアップ、Sakana AI が AI Scientist を発表

Aug 13, 2024 pm 04:43 PM

編集者 | ScienceAI 1年前、GoogleのTransformer論文の最後の著者であるLlion Jones氏は起業するために退職し、元Google研究者のDavid Ha氏と人工知能会社SakanaAIを共同設立した。 SakanaAI は、自然からインスピレーションを得たインテリジェンスに基づいて新しい基本モデルを作成すると主張しています。さて、SakanaAIは解答用紙を提出しました。 SakanaAI は、自動化された科学研究とオープンディスカバリのための世界初の AI システムである AIScientist のリリースを発表します。 AIScientist は、着想、コードの作成、実験の実行、結果の要約から、論文全体の執筆、査読の実施まで、AI 主導の科学研究と加速を可能にします。

携帯電話のXMLファイルをPDFに変換する方法は?

Apr 02, 2025 pm 10:12 PM

携帯電話のXMLファイルをPDFに変換する方法は?

Apr 02, 2025 pm 10:12 PM

単一のアプリケーションで携帯電話でXMLからPDF変換を直接完了することは不可能です。クラウドサービスを使用する必要があります。クラウドサービスは、2つのステップで達成できます。1。XMLをクラウド内のPDFに変換し、2。携帯電話の変換されたPDFファイルにアクセスまたはダウンロードします。