テクノロジー周辺機器

テクノロジー周辺機器

AI

AI

エンタープライズ GenAI イノベーションをエンドツーエンドで加速する NVIDIA NIM マイクロサービスは、ソフトウェア企業にとってハイライトとなっています。

エンタープライズ GenAI イノベーションをエンドツーエンドで加速する NVIDIA NIM マイクロサービスは、ソフトウェア企業にとってハイライトとなっています。

エンタープライズ GenAI イノベーションをエンドツーエンドで加速する NVIDIA NIM マイクロサービスは、ソフトウェア企業にとってハイライトとなっています。

ソフトウェア開発会社 Cloudera は最近、生成 AI アプリケーションの展開を加速するために NVIDIA と戦略的パートナーシップを締結したことを発表しました。この提携には、NVIDIA の AI マイクロサービスを Cloudera Data Platform (CDP) に統合することが含まれており、企業がデータに基づいてカスタム大規模言語モデル (LLM) をより迅速に構築および拡張できるように設計されています。この取り組みにより、企業はデータ リソースをより効果的に活用し、AI アプリケーションの開発と導入プロセスを加速するための、より強力なツールとテクノロジーを提供できるようになります。このコラボレーションは企業にさらなる機会をもたらし、より効率的なデータ主導の意思決定を行い、ビジネス開発を促進するのに役立ちます。 Cloudera と NVIDIA の協力により、企業にはより多くの選択肢と柔軟性が提供され、さまざまな業界での AI テクノロジーの普及が促進されることが期待されます。

このコラボレーションの一環として、Cloudera は、NVIDIA Inference Manager (NIM) マイクロサービスを含む NVIDIA AI Enterprise テクノロジーを活用して、CDP の洞察における 25 エクサバイトを超えるデータの力を明らかにする予定です。 。この貴重な企業情報は、Cloudera の機械学習プラットフォームにインポートされます。これは、同社が提供するエンドツーエンドの AI ワークフロー サービスであり、生成型 AI イノベーションの新たなラウンドを推進するように設計されています。

Cloudera の AI/ML 製品担当バイスプレジデントである Priyank Patel 氏は、エンタープライズ データを結合し、大規模な言語モデルに最適化されたフルスタック プラットフォームが、組織の生成 AI アプリケーションをパイロットから運用までサポートすることは重要です。 Cloudera は現在、NVIDIA NIM と CUDA-X マイクロサービスを統合して、機械学習プラットフォームを推進し、顧客が AI の可能性をビジネスの現実に変えるのを支援しています。

このコラボレーションは、技術革新における Cloudera と NVIDIA の強みを強調するとともに、生成 AI アプリケーションに対する市場需要が急速に成長していることを示しています。双方のリソースと技術的優位性を統合することで、企業におけるAIの実用化を共同で推進し、より効率的でインテリジェントなソリューションを企業に提供していきます。

さらに、CDP の膨大なデータを活用し、Cloudera 機械学習プラットフォームの強力な機能と組み合わせることで、企業はデータの価値をより深く掘り下げ、より正確な意思決定を行うことができます。業務運営の効率化。この協力は、企業によりインテリジェントで自動化された未来をもたらし、業界全体の発展と進歩を促進します。

1. モデルとデータの接続

モデルとデータの接続において、エンタープライズ AI は、どのように接続するかという重要な課題に直面します。基本モデルは関連するビジネス データと接続され、正確で状況に応じた出力を生成します。 NVIDIA の NIM および NeMo Retriever マイクロサービスは、開発者が LLM (大規模言語モデル) を、テキスト ドキュメントから画像や視覚化に至るまでの構造化および非構造化エンタープライズ データと接続できるようにすることで、このギャップを埋めることを目指しています。

具体的には、Cloudera Machine Learning は、統合された NIM モデル提供機能を提供して、推論パフォーマンスを強化し、ハイブリッドおよびマルチクラウド環境でのフォールトトレランス、低レイテンシ、自動スケーリングを可能にします。 NeMo Retriever の追加により、関連データをリアルタイムで取得することで生成 AI の精度を向上させる、検索拡張生成 (RAG) アプリケーションの開発が簡素化されます。

その中で、NVIDIA NeMo Retriever は、NVIDIA NeMo フレームワークおよびツール シリーズの新しいサービスです。 NeMo は、生成 AI モデルを構築、カスタマイズ、展開するためのフレームワークとツールのファミリーです。 NeMo Retriever はセマンティック検索マイクロサービスとして、NVIDIA に最適化されたアルゴリズムを使用して、生成 AI アプリケーションがより正確な答えを出せるようにします。このマイクロサービスを使用する開発者は、AI アプリケーションをさまざまなクラウドやデータ センターにあるビジネス データに接続できます。この接続により、AI アプリケーションの精度が向上するだけでなく、開発者が企業データをより柔軟に処理および活用できるようになります。

要約すると、NVIDIA の NIM や NeMo Retriever などのマイクロサービスは、AI モデルをビジネス データと密接に統合して、より正確で有用な出力を生成する効果的な方法を企業に提供します。これにより、企業はさまざまな分野で AI の応用と開発をさらに推進するための強力なツールを得ることができます。

2. データから生成 AI の導入までの時間を大幅に短縮

NVIDIA と Cloudera の協力により、企業に新たな扉が開かれます。これにより、大量のデータをより効率的に利用して、カスタマイズされた共同作業アシスタントや生産性ツールを構築できるようになります。 NVIDIA エンタープライズ製品担当バイスプレジデントの Justin Boitano 氏は次のように述べています。「NVIDIA NIM マイクロサービスと Cloudera データ プラットフォームの統合により、開発者は大規模な言語モデルをより柔軟かつ簡単に展開できるようになり、それによってエンタープライズ ビジネスの変革が促進されます。」

データから生成 AI の導入までのパスを簡素化することで、Cloudera と NVIDIA は、コーディング アシスタント、チャットボット、ドキュメント要約ツール、セマンティック検索ツールなどの革新的なアプリケーションの企業導入を加速することを目指しています。このコラボレーションは、NVIDIA RAPIDS を CDP に統合することで GPU アクセラレーションを活用するという両社のこれまでの取り組みに基づいています。

Patel 氏は、コラボレーションの拡大によるビジネス上のメリットを強調し、次のように述べています。「この統合の結果、顧客に強力な生成 AI 機能とパフォーマンスを提供するだけでなく、企業は「予測における不正確さ、幻覚、エラーを削減しながら、より正確でタイムリーな意思決定を行うことができます。これはすべて、今日のデータ環境をナビゲートする上で重要な要素です。」

#Cloudera は、NVIDIA GTC 3 月で新しい生成 AI 機能をデモンストレーションします18~21日、カリフォルニア州サンノゼ。大手企業が自社の業務を変革するための基礎モデルの可能性を模索する中、Cloudera と NVIDIA は、両社の協力によって顧客がエンタープライズ AI の新たな時代の最前線に立つことができると信じています。以上がエンタープライズ GenAI イノベーションをエンドツーエンドで加速する NVIDIA NIM マイクロサービスは、ソフトウェア企業にとってハイライトとなっています。の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

Video Face Swap

完全無料の AI 顔交換ツールを使用して、あらゆるビデオの顔を簡単に交換できます。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7699

7699

15

15

1640

1640

14

14

1393

1393

52

52

1287

1287

25

25

1230

1230

29

29

NVIDIA 対話モデル ChatQA はバージョン 2.0 に進化し、コンテキストの長さは 128K と記載されています

Jul 26, 2024 am 08:40 AM

NVIDIA 対話モデル ChatQA はバージョン 2.0 に進化し、コンテキストの長さは 128K と記載されています

Jul 26, 2024 am 08:40 AM

オープンな LLM コミュニティは百花繚乱の時代です Llama-3-70B-Instruct、QWen2-72B-Instruct、Nemotron-4-340B-Instruct、Mixtral-8x22BInstruct-v0.1 などがご覧いただけます。優秀なパフォーマーモデル。しかし、GPT-4-Turboに代表される独自の大型モデルと比較すると、オープンモデルには依然として多くの分野で大きなギャップがあります。一般的なモデルに加えて、プログラミングと数学用の DeepSeek-Coder-V2 や視覚言語タスク用の InternVL など、主要な領域に特化したいくつかのオープン モデルが開発されています。

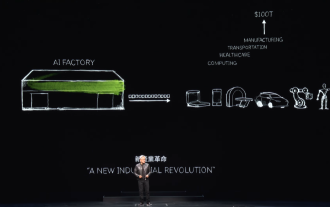

「AI Factory」はソフトウェア スタック全体の再構築を促進し、NVIDIA はユーザーが展開できる Llama3 NIM コンテナを提供します

Jun 08, 2024 pm 07:25 PM

「AI Factory」はソフトウェア スタック全体の再構築を促進し、NVIDIA はユーザーが展開できる Llama3 NIM コンテナを提供します

Jun 08, 2024 pm 07:25 PM

6月2日の当サイトのニュースによると、現在開催中のHuang Renxun 2024 Taipei Computexの基調講演で、Huang Renxun氏は、生成人工知能がソフトウェアスタック全体の再構築を促進すると紹介し、NIM(Nvidia Inference Microservices)のクラウドネイティブマイクロサービスをデモしました。 。 Nvidia は、「AI ファクトリー」が新たな産業革命を引き起こすと信じています。Microsoft が開拓したソフトウェア業界を例に挙げると、Huang Renxun 氏は、生成人工知能がそのフルスタックの再構築を促進すると信じています。あらゆる規模の企業による AI サービスの導入を促進するために、NVIDIA は今年 3 月に NIM (Nvidia Inference Microservices) クラウドネイティブ マイクロサービスを開始しました。 NIM+ は、市場投入までの時間を短縮するために最適化されたクラウドネイティブのマイクロサービスのスイートです

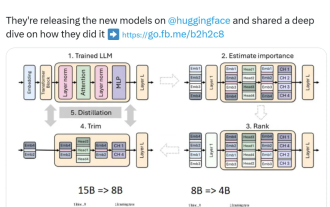

Nvidia はプルーニングと蒸留を試しています。Llama 3.1 8B のパラメータを半分にして、同じサイズでより良いパフォーマンスを実現しています。

Aug 16, 2024 pm 04:42 PM

Nvidia はプルーニングと蒸留を試しています。Llama 3.1 8B のパラメータを半分にして、同じサイズでより良いパフォーマンスを実現しています。

Aug 16, 2024 pm 04:42 PM

小型モデルの台頭。先月、Meta は Llama3.1 シリーズのモデルをリリースしました。これには、Meta のこれまでで最大のモデルである 405B モデルと、それぞれ 700 億と 80 億のパラメータを持つ 2 つの小型モデルが含まれています。 Llama3.1 は、オープンソースの新時代の到来を告げるものと考えられています。ただし、新世代モデルはパフォーマンスが強力ですが、導入時には依然として大量のコンピューティング リソースが必要です。したがって、多くの言語タスクで十分なパフォーマンスを発揮し、導入コストも非常に安価な小規模言語モデル (SLM) を開発するという別の傾向が業界に現れています。最近、NVIDIA の研究では、構造化された重み枝刈りと知識の蒸留を組み合わせることで、最初は大きなモデルから徐々に小さな言語モデルを取得できることが示されました。チューリング賞受賞、メタチーフA

NVIDIA SFF-Ready 仕様に準拠した ASUS が Prime GeForce RTX 40 シリーズ グラフィックス カードを発売

Jun 15, 2024 pm 04:38 PM

NVIDIA SFF-Ready 仕様に準拠した ASUS が Prime GeForce RTX 40 シリーズ グラフィックス カードを発売

Jun 15, 2024 pm 04:38 PM

6 月 15 日のこのサイトのニュースによると、ASUS は最近、Prime シリーズの GeForce RTX40 シリーズ「Ada」グラフィックス カードを発売しました。そのサイズは、Nvidia の最新の SFF-Ready 仕様に準拠しています。この仕様では、グラフィックス カードのサイズが超えないようになっています。 304 mm x 151 mm x 50 mm (長さ x 高さ x 厚さ)。今回ASUSが発売するPrimeシリーズのGeForceRTX40シリーズにはRTX4060Ti、RTX4070、RTX4070SUPERが含まれますが、現時点ではRTX4070TiSUPERやRTX4080SUPERは含まれません。このシリーズの RTX40 グラフィックス カードは、269 mm x 120 mm x 50 mm の寸法を持つ共通の回路基板設計を採用しています。3 つのグラフィックス カードの主な違いは次のとおりです。

Nvidia、GeForce RTX 4070 グラフィックス カードの GDDR6 メモリ バージョンをリリース、9 月から利用可能

Aug 21, 2024 am 07:31 AM

Nvidia、GeForce RTX 4070 グラフィックス カードの GDDR6 メモリ バージョンをリリース、9 月から利用可能

Aug 21, 2024 am 07:31 AM

8月20日の当サイトのニュースによると、GDDR6Xビデオメモリの不足により、Nvidia RTX4070以上のグラフィックスカードが8月に供給不足になると複数の情報源が7月に報じた。その後、RTX4070 グラフィックス カードの GDDR6 メモリ バージョンの発売に関する憶測がインターネット上で広がりました。当サイトで以前報じたとおり、Nvidiaは本日「Black Myth: Wukong」と「Star Wars: Outlaws」向けのGameReadyドライバーをリリースしたが、同時にプレスリリースではGDDR6ビデオメモリ版のGeForce RTX4070のリリースについても触れられた。 Nvidiaは、新しいRTX4070のビデオメモリ以外の仕様は変更されず(もちろん、価格も4,799元を維持し続ける)、ゲームやアプリケーションにおいてオリジナルバージョンと同様のパフォーマンスを提供し、関連製品が発売されると述べていますから

PHP フレームワークとマイクロサービス: クラウド ネイティブの導入とコンテナ化

Jun 04, 2024 pm 12:48 PM

PHP フレームワークとマイクロサービス: クラウド ネイティブの導入とコンテナ化

Jun 04, 2024 pm 12:48 PM

PHP フレームワークとマイクロサービスを組み合わせる利点: スケーラビリティ: アプリケーションを簡単に拡張し、新しい機能を追加したり、より多くの負荷を処理したりできます。柔軟性: マイクロサービスは独立してデプロイおよび保守されるため、変更や更新が容易になります。高可用性: 1 つのマイクロサービスの障害が他の部分に影響を与えないため、高可用性が確保されます。実践的なケース: Laravel と Kubernetes を使用したマイクロサービスのデプロイ ステップ: Laravel プロジェクトを作成します。マイクロサービスコントローラーを定義します。 Dockerfileを作成します。 Kubernetes マニフェストを作成します。マイクロサービスをデプロイします。マイクロサービスをテストします。

NVIDIA の最も強力なオープンソース ユニバーサル モデル Nemotron-4 340B

Jun 16, 2024 pm 10:32 PM

NVIDIA の最も強力なオープンソース ユニバーサル モデル Nemotron-4 340B

Jun 16, 2024 pm 10:32 PM

Llama-3を上回る性能を持ち、主に合成データに使用されます。 NVIDIAの汎用大型モデルNemotronが最新の3400億パラメータ版をオープンソース化した。金曜日、NVIDIA は Nemotron-4340B の発売を発表しました。これには、開発者が大規模言語モデル (LLM) をトレーニングするための合成データを生成するために使用できる一連のオープン モデルが含まれており、医療、金融、製造、小売などのあらゆる業界の商用アプリケーションに使用できます。高品質のトレーニング データは、カスタム LLM の応答性、精度、品質において重要な役割を果たしますが、堅牢なデータ セットは高価でアクセスできないことがよくあります。 Nemotron-4340B は、独自のオープン モデル ライセンスを通じて、開発者に次の機能を提供します。

NVIDIA が SFF-Ready 小型シャーシ仕様を発表: グラフィックス カードとシャーシのメーカー 15 社が参加し、グラフィックス カードとシャーシの互換性を確保

Jun 07, 2024 am 11:51 AM

NVIDIA が SFF-Ready 小型シャーシ仕様を発表: グラフィックス カードとシャーシのメーカー 15 社が参加し、グラフィックス カードとシャーシの互換性を確保

Jun 07, 2024 am 11:51 AM

6 月 2 日のこのサイトのニュースによると、Nvidia はグラフィックス カードとシャーシのメーカーと協力して、GeForce RTX ゲーミング グラフィックス カードとシャーシに SFF-Ready 仕様を正式に導入し、小型シャーシのアクセサリ選択プロセスを簡素化しました。レポートによると、現在、ASUS、Cooler Master、Parting Technology を含む 15 社のグラフィックス カードおよびシャーシ メーカーが SFF-Ready プロジェクトに参加しています。 SFF 対応 GeForce ゲーミング グラフィックス カードは、RTX4070 以降のモデル用です。 サイズ要件は次のとおりです。 最大高さ: 151 mm (電源コードの曲げ半径を含む) 最大長: 304 mm 最大厚さ: 50 mm または 2.5 スロット 2024 年 6 月 2 日現在、 36 個の GeForce RTX40 シリーズ グラフィックス カードが仕様に準拠しており、将来的にはさらに多くのグラフィックス カードが利用可能になります