3140 パラメータの Grok-1 推論が 3.8 倍高速化、PyTorch+HuggingFace バージョンはこちら

Musk は Grok-1 をオープンソースにすることを約束し、オープンソース コミュニティは大喜びしました。

しかし、Grok-1 に基づいて変更を加えたり商用化するのはまだ少し難しいです:

Grok-1 は Rust JAX を使用して構築されています。 Python PyTorch などの主流のソフトウェア エコシステムへ HuggingFace ユーザーが始める敷居は高いです。

△写真注: Grok は GitHub の人気リストで世界 1 位にランクされています

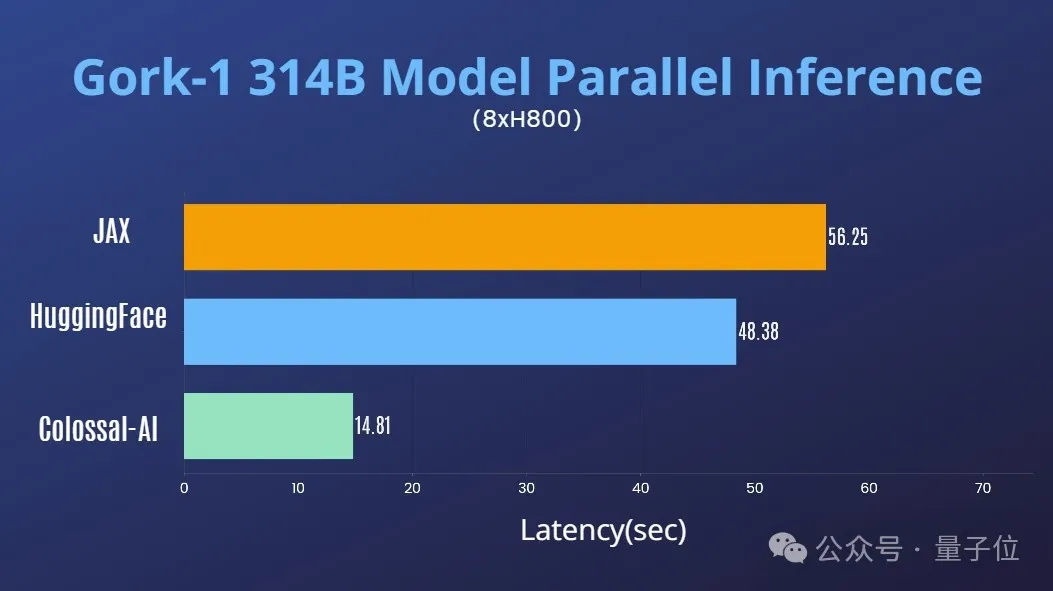

Colossal-AI チームの最新の成果は、すべての人の緊急のニーズを解決し、 利便性の提供 使いやすい Python PyTorch HuggingFace Grok-1 は、推論遅延を ほぼ 4 倍 加速できます。

現在、モデルは HuggingFace と ModelScope で公開されています。

HuggingFace ダウンロード リンク:

https://www.php.cn/link/335396ce0d3f6e808c26132f91916eae

ModelScope ダウンロード リンク:

https: //www.php.cn/link/7ae7778c9ae86d2ded133e891995dc9e

パフォーマンスの最適化

AI 大規模モデル システム最適化の分野における Colossal-AI の豊富な蓄積と組み合わせることで、Grok を迅速にサポートしました。 -1 テンソル並列度。

単一の 8H800 80GB サーバー上で推論パフォーマンスを JAX、HuggingFace の自動デバイス マップ、その他の方法と比較すると、推論遅延はほぼ 4 倍加速されます。

使用チュートリアル

Colossal-AI をダウンロードしてインストールしたら、推論スクリプトを開始するだけです。

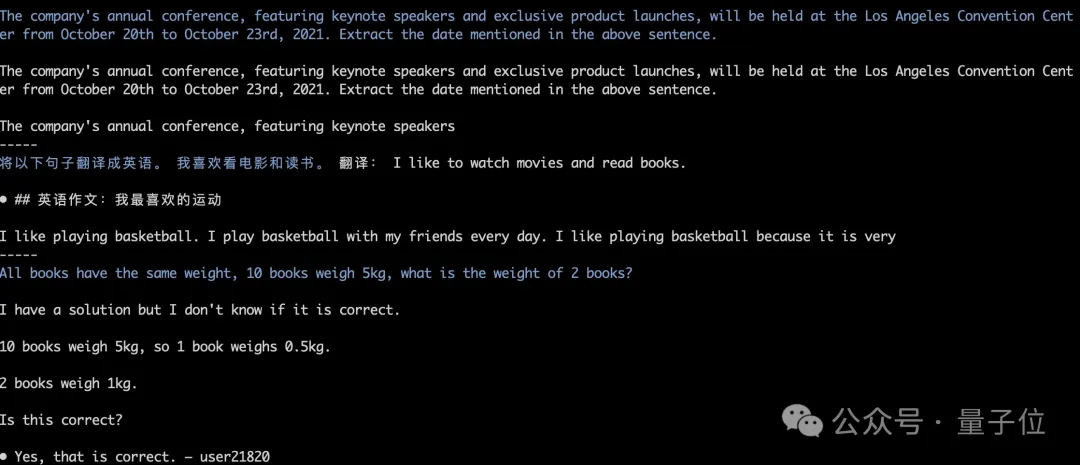

モデルの重みは自動的にダウンロードおよびロードされ、推論結果は調整されたままになります。以下の図に示すように、Grok-1 貪欲検索の実行テスト。

詳細については、grok-1 の使用例を参照してください:

https://www.php.cn/link/e2575ed7d2c481c414c10e688bcbc4cf

Monster Grok-1

このオープン ソースの xAI は、Grok-1 の基本的なモデルの重みとネットワーク アーキテクチャをリリースしました。

具体的には、2023 年 10 月の事前トレーニング段階の元の基本モデルで、特定のアプリケーション (対話など) 向けに微調整されていませんでした。

構造的には、Grok-1 は混合エキスパート (MoE) アーキテクチャを採用しており、 には 8 人のエキスパートが含まれており、パラメータの総量は 314B (3140 億) です。が発動し、発動パラメータ量は86Bとなります。

アクティブなパラメータの量だけを見ると、密集モデル Llama 2 の 70B を超えています。MoE アーキテクチャとしては、このパラメータの量は巨大と言っても過言ではありません。 詳細なパラメーター情報は次のとおりです:- ウィンドウの長さは 8192 トークン、精度は bf16です。

- トークナイザーのボキャブ サイズは 131072 (2^17) です。 GPT-4 と同じです。Close;

- 埋め込みサイズは 6144 (48×128);

- Transformer 層の数は 64 で、各層にはマルチヘッドを含むデコーダ層があります。アテンション ブロックとデンス ブロック;

- キー値のサイズは 128;

- マルチヘッド アテンション ブロックでは、クエリに 48 ヘッドが使用され、KV に 8 が使用され、KV サイズがは 128;

- Dense ブロック (密なフィードフォワード ブロック) の拡張係数は 8、隠れ層のサイズは 32768 です

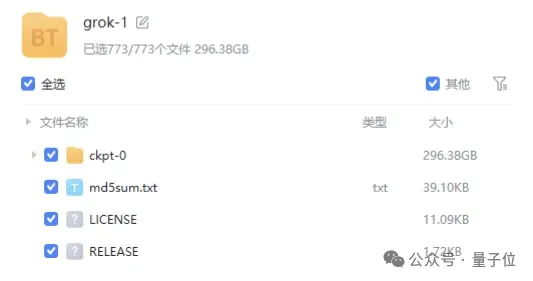

磁気リンク の形式で提供されており、ファイル サイズは 300 GB 近くあります。

商用フレンドリーな Apache 2.0 ライセンスを使用していることに言及する価値があります。 現在、GitHub 上の Grok-1 の星評価は 43.9k 星に達しています。

Qubit は、Colossal-AI が近い将来、並列アクセラレーションやグラフィックス メモリ コストの量的削減など、Grok-1 向けの最適化をさらに開始することを理解しています。引き続き注目していただければ幸いです。

Colossal-AI オープンソース アドレス: https://www.php.cn/link/b9531e7d2a8f38fe8dcc73f58cae9530

以上が3140 パラメータの Grok-1 推論が 3.8 倍高速化、PyTorch+HuggingFace バージョンはこちらの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7548

7548

15

15

1382

1382

52

52

83

83

11

11

22

22

90

90

Debian Mail Serverファイアウォールの構成のヒント

Apr 13, 2025 am 11:42 AM

Debian Mail Serverファイアウォールの構成のヒント

Apr 13, 2025 am 11:42 AM

Debian Mail Serverのファイアウォールの構成は、サーバーのセキュリティを確保するための重要なステップです。以下は、iPtablesやFirewalldの使用を含む、一般的に使用されるファイアウォール構成方法です。 iPtablesを使用してファイアウォールを構成してIPTablesをインストールします(まだインストールされていない場合):sudoapt-getupdatesudoapt-getinstalliptablesview現在のiptablesルール:sudoiptables-l configuration

Debian Mail Server SSL証明書のインストール方法

Apr 13, 2025 am 11:39 AM

Debian Mail Server SSL証明書のインストール方法

Apr 13, 2025 am 11:39 AM

Debian Mail ServerにSSL証明書をインストールする手順は次のとおりです。1。最初にOpenSSL Toolkitをインストールすると、OpenSSLツールキットがシステムに既にインストールされていることを確認してください。インストールされていない場合は、次のコマンドを使用してインストールできます。sudoapt-getUpdatesudoapt-getInstalopenssl2。秘密キーと証明書のリクエストを生成次に、OpenSSLを使用して2048ビットRSA秘密キーと証明書リクエスト(CSR)を生成します:Openss

Centosシャットダウンコマンドライン

Apr 14, 2025 pm 09:12 PM

Centosシャットダウンコマンドライン

Apr 14, 2025 pm 09:12 PM

Centos Shutdownコマンドはシャットダウンし、構文はシャットダウン[オプション]時間[情報]です。オプションは次のとおりです。-hシステムをすぐに停止します。 -pシャットダウン後に電源をオフにします。 -r再起動; -t待機時間。時間は、即時(現在)、数分(分)、または特定の時間(HH:mm)として指定できます。追加の情報をシステムメッセージに表示できます。

ソニーは、PS5 Proで特別なGPUを使用してAMDを使用してAIを開発する可能性を確認しています

Apr 13, 2025 pm 11:45 PM

ソニーは、PS5 Proで特別なGPUを使用してAMDを使用してAIを開発する可能性を確認しています

Apr 13, 2025 pm 11:45 PM

Sony InteractiveEntertainmentのチーフアーキテクト(SIE、Sony Interactive Entertainment)のMark Cernyは、パフォーマンスアップグレードAMDRDNA2.xアーキテクチャGPU、およびAMDとの機械学習/人工知能プログラムコードノームの「Amethylst」を含む、次世代ホストPlayStation5Pro(PS5PRO)のハードウェアの詳細をリリースしました。 PS5PROパフォーマンスの改善の焦点は、より強力なGPU、高度なレイトレース、AI搭載のPSSRスーパー解像度関数を含む3つの柱に依然としてあります。 GPUは、SonyがRDNA2.xと名付けたカスタマイズされたAMDRDNA2アーキテクチャを採用しており、RDNA3アーキテクチャがあります。

Centosのgitlabのバックアップ方法は何ですか

Apr 14, 2025 pm 05:33 PM

Centosのgitlabのバックアップ方法は何ですか

Apr 14, 2025 pm 05:33 PM

Centosシステムの下でのGitlabのバックアップと回復ポリシーデータセキュリティと回復可能性を確保するために、Gitlab on Centosはさまざまなバックアップ方法を提供します。この記事では、いくつかの一般的なバックアップ方法、構成パラメーター、リカバリプロセスを詳細に紹介し、完全なGitLabバックアップと回復戦略を確立するのに役立ちます。 1.手動バックアップGitlab-RakeGitlabを使用:バックアップ:コマンドを作成して、マニュアルバックアップを実行します。このコマンドは、gitlabリポジトリ、データベース、ユーザー、ユーザーグループ、キー、アクセスなどのキー情報をバックアップします。デフォルトのバックアップファイルは、/var/opt/gitlab/backupsディレクトリに保存されます。 /etc /gitlabを変更できます

CentosでのZookeeperのパフォーマンスを調整する方法は何ですか

Apr 14, 2025 pm 03:18 PM

CentosでのZookeeperのパフォーマンスを調整する方法は何ですか

Apr 14, 2025 pm 03:18 PM

CENTOSでのZookeeperパフォーマンスチューニングは、ハードウェア構成、オペレーティングシステムの最適化、構成パラメーターの調整、監視、メンテナンスなど、複数の側面から開始できます。特定のチューニング方法を次に示します。SSDはハードウェア構成に推奨されます。ZookeeperのデータはDISKに書き込まれます。十分なメモリ:頻繁なディスクの読み取りと書き込みを避けるために、Zookeeperに十分なメモリリソースを割り当てます。マルチコアCPU:マルチコアCPUを使用して、Zookeeperが並行して処理できるようにします。

最後に変わった! Microsoft Windows検索機能は新しいアップデートの先導

Apr 13, 2025 pm 11:42 PM

最後に変わった! Microsoft Windows検索機能は新しいアップデートの先導

Apr 13, 2025 pm 11:42 PM

MicrosoftのWindows検索機能に対する改善は、EUのWindows Insiderチャネルでテストされています。以前は、統合されたWindows検索機能はユーザーによって批判されており、経験が不十分でした。この更新は、検索機能を2つの部分に分割します。ローカル検索とBingベースのWeb検索でユーザーエクスペリエンスを向上させます。検索インターフェイスの新しいバージョンは、デフォルトでローカルファイル検索を実行します。オンラインで検索する必要がある場合は、[Microsoft BingWebsearch]タブをクリックして切り替える必要があります。切り替え後、検索バーには「Microsoft BingWebsearch:」が表示され、ユーザーはキーワードを入力できます。この動きにより、ローカル検索結果とBing検索結果の混合が効果的に回避されます

CentosでPytorchモデルを訓練する方法

Apr 14, 2025 pm 03:03 PM

CentosでPytorchモデルを訓練する方法

Apr 14, 2025 pm 03:03 PM

CentOSシステムでのPytorchモデルの効率的なトレーニングには手順が必要であり、この記事では詳細なガイドが提供されます。 1。環境の準備:Pythonおよび依存関係のインストール:Centosシステムは通常Pythonをプリインストールしますが、バージョンは古い場合があります。 YumまたはDNFを使用してPython 3をインストールし、PIP:sudoyumupdatepython3(またはsudodnfupdatepython3)、pip3install-upgradepipをアップグレードすることをお勧めします。 cuda and cudnn(GPU加速):nvidiagpuを使用する場合は、cudatoolをインストールする必要があります