合体後のモデルは進化し、SOTAに直接勝利します! 『トランスフォーマー』著者の新たな起業家としての功績が人気

Huggingface の 既成モデル を使用して「節約」します -

それらを直接組み合わせて新しい強力なモデルを作成できますか? !

日本の大手模型会社 sakana.ai は非常にクリエイティブでした (「トランスフォーマー エイト」の 1 人が設立した会社です) 統合モデルを進化させるためにこのようなクーデターを思いつきました。

この方法では、新しい基本モデルを自動的に生成できるだけでなく、パフォーマンスがまったく悪いです。:

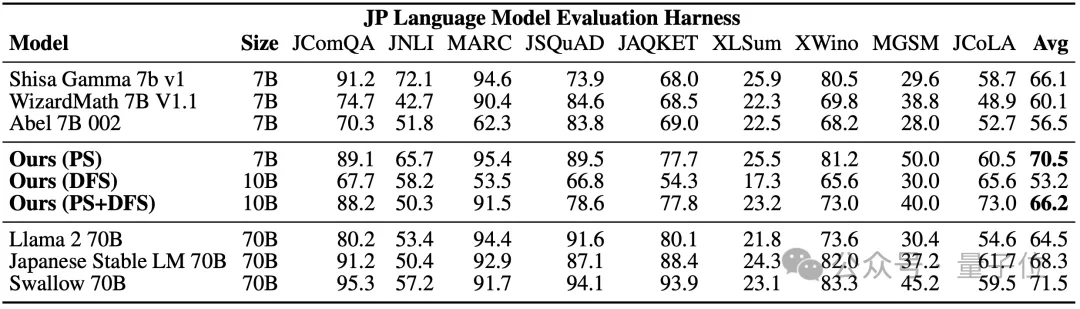

彼ら 70 億のパラメータを含む日本の数学の大規模モデルを利用して、関連ベンチマークで最先端の結果を達成し、700 億パラメータの Llama-2 などの以前のモデルを上回りました。

最も重要なことは、このようなモデルに到達するのに勾配トレーニングが必要ないということです。そのため、必要なコンピューティング リソースが大幅に削減されます。 NVIDIA の科学者 Jim Fan は、この論文を読んだ後、次のように賞賛しました。

これは、私が最近読んだ論文の中で最も想像力豊かな論文の 1 つです。 マージと進化、新しい基本モデルの自動生成

マージと進化、新しい基本モデルの自動生成

オープンソースの大規模モデル ランキングで最もパフォーマンスの高いモデルのほとんどが廃止されましたLLaMA または、Mistral のような「オリジナル」モデルですが、モデルを微調整したり結合したりすると、次のことがわかります。

新しいトレンドが出現しました。

Sakana.ai は、オープンソースの基本モデルを何百もの異なる方向に簡単に拡張および微調整でき、新しい分野で優れたパフォーマンスを発揮する新しいモデルを生成できることを紹介しました。

これらの中で、

モデルのマージは大きな可能性を示しています。

しかし、それは直感と専門知識に大きく依存する一種の「黒魔術」かもしれません。

しかし、それは直感と専門知識に大きく依存する一種の「黒魔術」かもしれません。

したがって、より体系的な

アプローチが必要です。 自然界の自然選択にインスピレーションを得たSakana.aiは、進化アルゴリズムに焦点を当て、「進化モデルのマージ」の概念を導入し、最適なモデルを発見できる手法を提案しました。組み合わせ。

このメソッドは、2 つの異なるアイデアを組み合わせたものです: (1) データ フロー スペース

(レイヤー)でモデルを結合する、および (2) パラメーター スペースを結合する

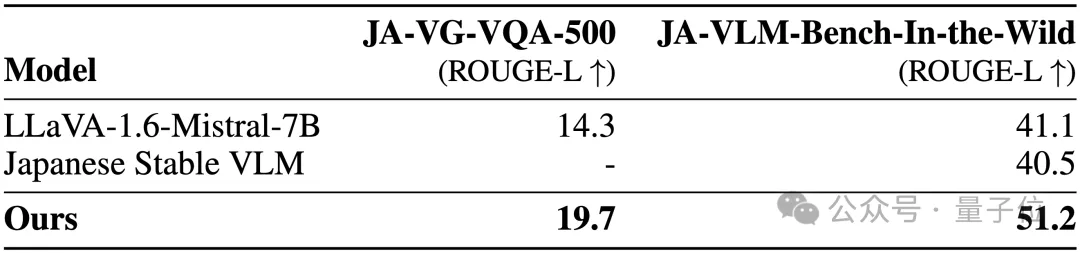

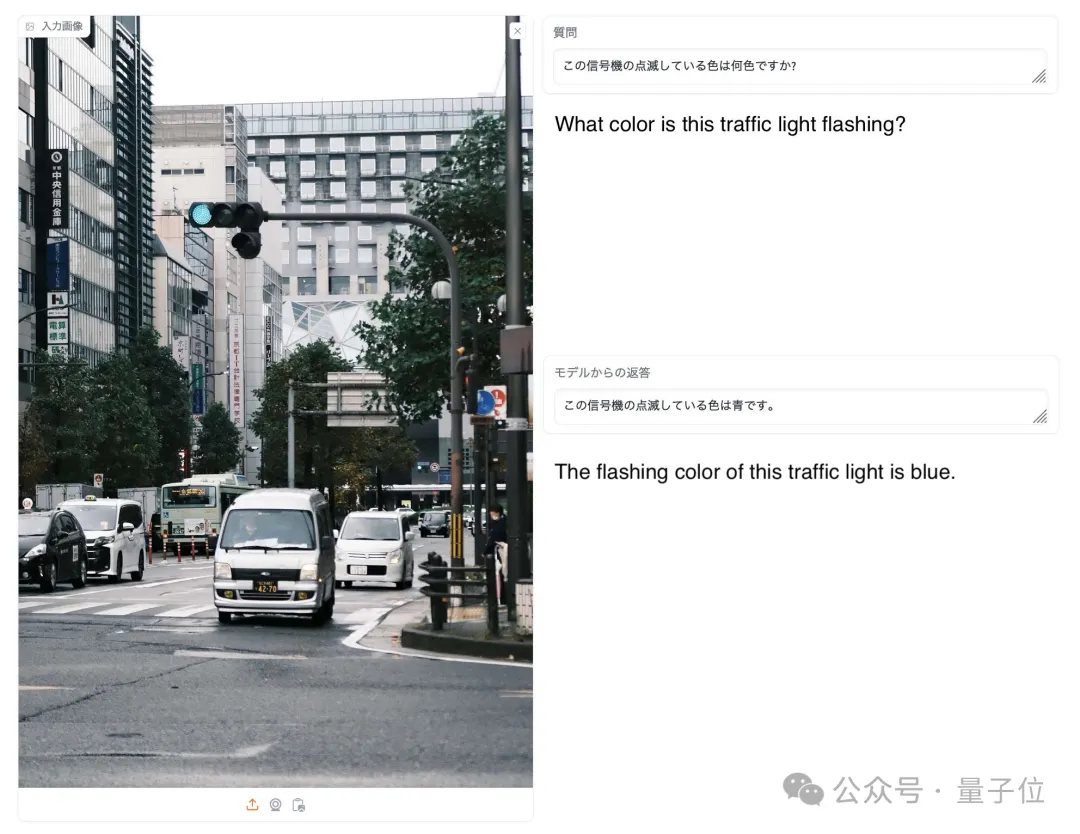

(重み) モデル ()。 具体的には、最初のデータ フロー スペース手法では、進化を使用して、新しいモデルを形成するためのさまざまなモデル層の最適な組み合わせを発見します。 これまで、コミュニティは、モデルのどのレイヤーを別のモデルのレイヤーとどのように組み合わせることができるかを決定するために直感に頼っていました。 しかし実際には、この問題には膨大な組み合わせの探索空間があり、進化アルゴリズムなどの最適化アルゴリズムによる探索に最適であるとSakana.aiは紹介しました。 操作例は次のとおりです。 2 番目のパラメータ空間方法では、複数のモデルの重みを混合して新しいモデルを形成します。 実際には、この方法を実装する方法は無数にあり、原理的には、混合の各層で異なる混合比、さらにはそれ以上の混合比を使用できます。 そしてここで、進化的手法を使用すると、より新しいハイブリッド戦略を効果的に見つけることができます。 次は、2 つの異なるモデルの重みを混合して新しいモデルを取得する例です: 上記 2 つの方法を組み合わせるだけです : 具体的に見てください。 1. EvoLLM-JP GSM8K データセットの多言語バージョンである MGSM の日本語評価セットで次の結果を達成しました。 : このうち、モデル 4 はパラメータ空間のみで最適化されており、モデル 6 はモデル 4 をデータ フロー空間でさらに最適化した結果です。 データ機能と一般的な日本語スキルの両方を評価する日本語 lm-evaluation-harness ベンチマークでは、EvoLLM-JP は、わずか 70 億のパラメーターを使用して、9 つのタスクで最高平均スコア 70.5 を達成しました。 700億個のラマ2など。 チームは、EvoLLM-JP は一般的な日本語モデルとして使用し、いくつかの興味深い例を解決するのに十分であると述べています: たとえば、特定の日本語文化が必要です。数学の知識の問題や、関西弁で日本のジョークを言ったりします。 2、EvoVLM-JP 画像の質問と回答の次の 2 つのベンチマーク データ セットでは、スコアが高いほど、モデルは回答します。日本語での説明はより正確です。 結果として、ベースとなっている英語版 VLM LLaVa-1.6-Mistral-7B よりも優れているだけでなく、既存の日本語 VLM よりも優れています。 下の写真に示すように、写真の信号灯の色は何色ですかと尋ねたところ、EvoVLM-JP だけが「青」と正解しました。 3. EvoSDXL-JP 日本語のみをサポートするこの SDXL モデルには 4 つの拡散モデルが必要ですを実行でき、生成速度は非常に高速です。 具体的なランニングスコアはまだ発表されていないが、チームは「非常に有望」であることを明らかにした。 いくつかの例をお楽しみいただけます: プロンプトの単語には、味噌ラーメン、最高品質の浮世絵、葛飾北斎、江戸時代が含まれます。 上記の 3 つの新しいモデルについて、チームは次のことを指摘しました: 原理的には、勾配ベースの逆伝播を使用して、これらのモデルのパフォーマンスを上回ります。 しかし、 は使用しません。今の目的は、バックプロパゲーションがなくても、現在のモデルに対抗する十分に高度な基本モデルを取得できることを示すことだからです。 「高価なパラダイム」。 ネチズンは次々にこれを気に入りました。 Jim Fan は次のようにも追加しました: 基本モデルの分野では、 現在のコミュニティはモデルに学習させることにほぼ完全に焦点を当てており、あまり注意を払っていません。 search ですが、後者は実際にはトレーニング (つまり、この記事で提案する進化的アルゴリズム) と推論段階で大きな可能性を秘めています。 つまり、ネチズンが言ったように: 私たちは現在、モデルのカンブリア紀にいます。大爆発の時代ですか? 論文アドレス: https://arxiv.org/abs/2403.13187

は、大規模な日本語モデル Shisa-Gamma と大規模な数学モデル WizardMath/Abel を統合して形成されており、日本の数学の問題を解くのが得意で、100 年にわたって進化しています。 -150世代。

#画像生成モデル EvoSDXL-JP

△マスク氏のお気に入り

以上が合体後のモデルは進化し、SOTAに直接勝利します! 『トランスフォーマー』著者の新たな起業家としての功績が人気の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

Video Face Swap

完全無料の AI 顔交換ツールを使用して、あらゆるビデオの顔を簡単に交換できます。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

1657

1657

14

14

1415

1415

52

52

1309

1309

25

25

1257

1257

29

29

1231

1231

24

24

オープンソース!ゾーイデプスを超えて! DepthFM: 高速かつ正確な単眼深度推定!

Apr 03, 2024 pm 12:04 PM

オープンソース!ゾーイデプスを超えて! DepthFM: 高速かつ正確な単眼深度推定!

Apr 03, 2024 pm 12:04 PM

0.この記事は何をするのですか?私たちは、多用途かつ高速な最先端の生成単眼深度推定モデルである DepthFM を提案します。従来の深度推定タスクに加えて、DepthFM は深度修復などの下流タスクでも最先端の機能を実証します。 DepthFM は効率的で、いくつかの推論ステップ内で深度マップを合成できます。この作品について一緒に読みましょう〜 1. 論文情報タイトル: DepthFM: FastMonocularDepthEstimationwithFlowMatching 著者: MingGui、JohannesS.Fischer、UlrichPrestel、PingchuanMa、Dmytr

ddrescue を使用して Linux 上のデータを回復する

Mar 20, 2024 pm 01:37 PM

ddrescue を使用して Linux 上のデータを回復する

Mar 20, 2024 pm 01:37 PM

DDREASE は、ハード ドライブ、SSD、RAM ディスク、CD、DVD、USB ストレージ デバイスなどのファイル デバイスまたはブロック デバイスからデータを回復するためのツールです。あるブロック デバイスから別のブロック デバイスにデータをコピーし、破損したデータ ブロックを残して正常なデータ ブロックのみを移動します。 ddreasue は、回復操作中に干渉を必要としないため、完全に自動化された強力な回復ツールです。さらに、ddasue マップ ファイルのおかげでいつでも停止および再開できます。 DDREASE のその他の主要な機能は次のとおりです。 リカバリされたデータは上書きされませんが、反復リカバリの場合にギャップが埋められます。ただし、ツールに明示的に指示されている場合は切り詰めることができます。複数のファイルまたはブロックから単一のファイルにデータを復元します

Google は大喜び: JAX のパフォーマンスが Pytorch や TensorFlow を上回りました! GPU 推論トレーニングの最速の選択肢となる可能性があります

Apr 01, 2024 pm 07:46 PM

Google は大喜び: JAX のパフォーマンスが Pytorch や TensorFlow を上回りました! GPU 推論トレーニングの最速の選択肢となる可能性があります

Apr 01, 2024 pm 07:46 PM

Google が推進する JAX のパフォーマンスは、最近のベンチマーク テストで Pytorch や TensorFlow のパフォーマンスを上回り、7 つの指標で 1 位にランクされました。また、テストは最高の JAX パフォーマンスを備えた TPU では行われませんでした。ただし、開発者の間では、依然として Tensorflow よりも Pytorch の方が人気があります。しかし、将来的には、おそらくより大規模なモデルが JAX プラットフォームに基づいてトレーニングされ、実行されるようになるでしょう。モデル 最近、Keras チームは、ネイティブ PyTorch 実装を使用して 3 つのバックエンド (TensorFlow、JAX、PyTorch) をベンチマークし、TensorFlow を使用して Keras2 をベンチマークしました。まず、主流のセットを選択します

こんにちは、電気アトラスです!ボストン・ダイナミクスのロボットが復活、180度の奇妙な動きにマスク氏も恐怖

Apr 18, 2024 pm 07:58 PM

こんにちは、電気アトラスです!ボストン・ダイナミクスのロボットが復活、180度の奇妙な動きにマスク氏も恐怖

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas は正式に電動ロボットの時代に突入します!昨日、油圧式アトラスが歴史の舞台から「涙ながらに」撤退したばかりですが、今日、ボストン・ダイナミクスは電動式アトラスが稼働することを発表しました。ボストン・ダイナミクス社は商用人型ロボットの分野でテスラ社と競争する決意を持っているようだ。新しいビデオが公開されてから、わずか 10 時間ですでに 100 万人以上が視聴しました。古い人が去り、新しい役割が現れるのは歴史的な必然です。今年が人型ロボットの爆発的な年であることは間違いありません。ネットユーザーは「ロボットの進歩により、今年の開会式は人間のように見え、人間よりもはるかに自由度が高い。しかし、これは本当にホラー映画ではないのか?」とコメントした。ビデオの冒頭では、アトラスは仰向けに見えるように地面に静かに横たわっています。次に続くのは驚くべきことです

iPhoneのセルラーデータインターネット速度が遅い:修正

May 03, 2024 pm 09:01 PM

iPhoneのセルラーデータインターネット速度が遅い:修正

May 03, 2024 pm 09:01 PM

iPhone のモバイル データ接続に遅延や遅い問題が発生していませんか?通常、携帯電話の携帯インターネットの強度は、地域、携帯ネットワークの種類、ローミングの種類などのいくつかの要因によって異なります。より高速で信頼性の高いセルラー インターネット接続を実現するためにできることがいくつかあります。解決策 1 – iPhone を強制的に再起動する 場合によっては、デバイスを強制的に再起動すると、携帯電話接続を含む多くの機能がリセットされるだけです。ステップ 1 – 音量を上げるキーを 1 回押して放します。次に、音量小キーを押して、もう一度放します。ステップ 2 – プロセスの次の部分は、右側のボタンを押し続けることです。 iPhone の再起動が完了するまで待ちます。セルラーデータを有効にし、ネットワーク速度を確認します。もう一度確認してください 修正 2 – データ モードを変更する 5G はより優れたネットワーク速度を提供しますが、信号が弱い場合はより適切に機能します

テスラのロボットは工場で働く、マスク氏:手の自由度は今年22に達する!

May 06, 2024 pm 04:13 PM

テスラのロボットは工場で働く、マスク氏:手の自由度は今年22に達する!

May 06, 2024 pm 04:13 PM

テスラのロボット「オプティマス」の最新映像が公開され、すでに工場内で稼働可能となっている。通常の速度では、バッテリー(テスラの4680バッテリー)を次のように分類します:公式は、20倍の速度でどのように見えるかも公開しました - 小さな「ワークステーション」上で、ピッキング、ピッキング、ピッキング:今回は、それがリリースされたハイライトの1つビデオの内容は、オプティマスが工場内でこの作業を完全に自律的に行い、プロセス全体を通じて人間の介入なしに完了するというものです。そして、オプティマスの観点から見ると、自動エラー修正に重点を置いて、曲がったバッテリーを拾い上げたり配置したりすることもできます。オプティマスのハンドについては、NVIDIA の科学者ジム ファン氏が高く評価しました。オプティマスのハンドは、世界の 5 本指ロボットの 1 つです。最も器用。その手は触覚だけではありません

Alibaba 7B マルチモーダル文書理解の大規模モデルが新しい SOTA を獲得

Apr 02, 2024 am 11:31 AM

Alibaba 7B マルチモーダル文書理解の大規模モデルが新しい SOTA を獲得

Apr 02, 2024 am 11:31 AM

マルチモーダル文書理解機能のための新しい SOTA!アリババの mPLUG チームは、最新のオープンソース作品 mPLUG-DocOwl1.5 をリリースしました。これは、高解像度の画像テキスト認識、一般的な文書構造の理解、指示の遵守、外部知識の導入という 4 つの主要な課題に対処するための一連のソリューションを提案しています。さっそく、その効果を見てみましょう。複雑な構造のグラフをワンクリックで認識しMarkdown形式に変換:さまざまなスタイルのグラフが利用可能:より詳細な文字認識や位置決めも簡単に対応:文書理解の詳しい説明も可能:ご存知「文書理解」 「」は現在、大規模な言語モデルの実装にとって重要なシナリオです。市場には文書の読み取りを支援する多くの製品が存在します。その中には、主にテキスト認識に OCR システムを使用し、テキスト処理に LLM と連携する製品もあります。

Kuaishou バージョンの Sora「Ke Ling」がテスト用に公開されています。120 秒以上のビデオを生成し、物理学をより深く理解し、複雑な動きを正確にモデル化できます。

Jun 11, 2024 am 09:51 AM

Kuaishou バージョンの Sora「Ke Ling」がテスト用に公開されています。120 秒以上のビデオを生成し、物理学をより深く理解し、複雑な動きを正確にモデル化できます。

Jun 11, 2024 am 09:51 AM

何?ズートピアは国産AIによって実現するのか?ビデオとともに公開されたのは、「Keling」と呼ばれる新しい大規模な国産ビデオ生成モデルです。 Sora も同様の技術的ルートを使用し、自社開発の技術革新を多数組み合わせて、大きく合理的な動きをするだけでなく、物理世界の特性をシミュレートし、強力な概念的結合能力と想像力を備えたビデオを制作します。データによると、Keling は、最大 1080p の解像度で 30fps で最大 2 分の超長時間ビデオの生成をサポートし、複数のアスペクト比をサポートします。もう 1 つの重要な点は、Keling は研究所が公開したデモやビデオ結果のデモンストレーションではなく、ショートビデオ分野のリーダーである Kuaishou が立ち上げた製品レベルのアプリケーションであるということです。さらに、主な焦点は実用的であり、白紙小切手を書かず、リリースされたらすぐにオンラインに移行することです。Ke Ling の大型モデルは Kuaiying でリリースされました。