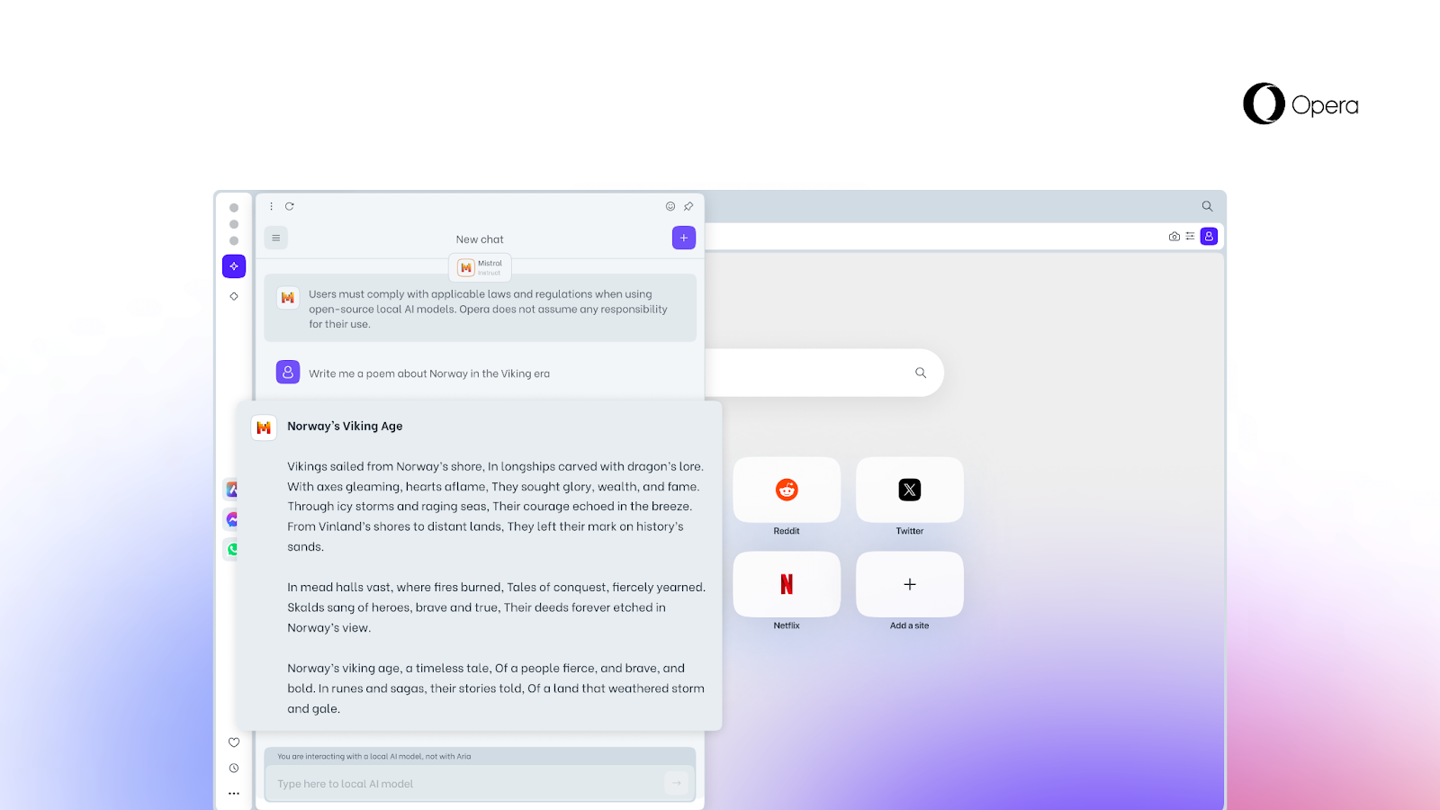

Opera は本日、試験的に 150 のローカルラージ言語モデル (LLM) をサポートする Opera One の最新バージョンをリリースしました。これは、Opera がローカル AI モデルを内蔵した最初の主流ブラウザになったことを意味します。

このタイプのローカル AI モデルは、クラウド AI と比較して、より強力なプライバシーと処理速度を提供できますが、より多くのパラメーターを備えたクラウド AI の処理効果が損なわれる可能性があります。

Opera は、Meta の Llama や Vicuna、Google の Gemma、Mistral AI の Mixtral やその他の有名なモデルなど、さまざまな人気のある LLM を統合しています。

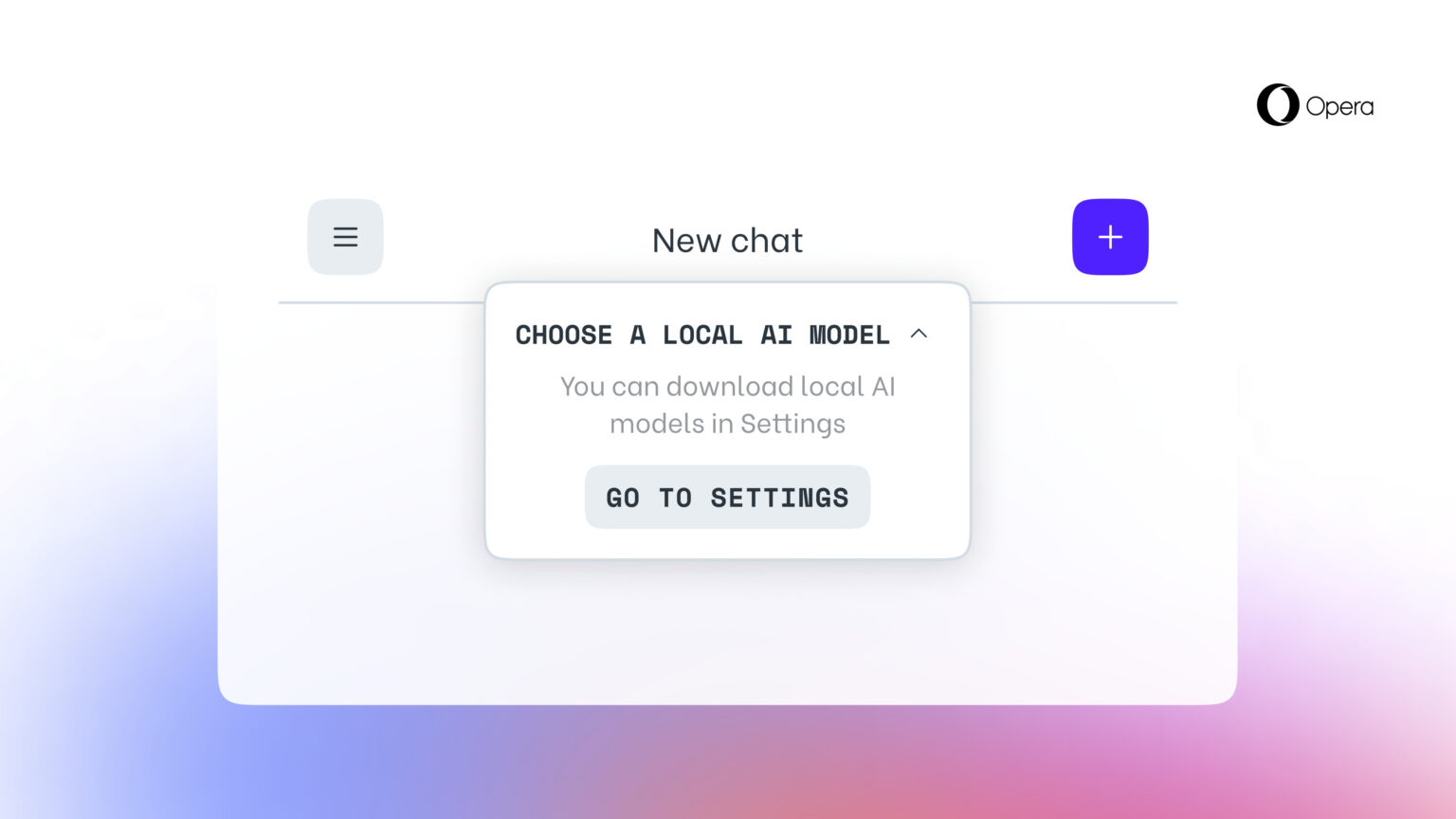

このサイトでは、興味のあるユーザーが Opera 開発者 Web サイトから Opera One 開発者バージョンをダウンロードできることを思い出させます。このバージョンでは、さまざまなローカル LLM をダウンロードするオプションがサポートされており、モデルごとに 2 ~ 10 GB のストレージが必要です。

以上がOpera はネイティブ LLM を統合する最初のブラウザとなるの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。