テクノロジー周辺機器

テクノロジー周辺機器

AI

AI

Mistral オープンソース 8X22B 大型モデル、OpenAI が GPT-4 Turbo ビジョンをアップデート、それらはすべて Google をいじめている

Mistral オープンソース 8X22B 大型モデル、OpenAI が GPT-4 Turbo ビジョンをアップデート、それらはすべて Google をいじめている

Mistral オープンソース 8X22B 大型モデル、OpenAI が GPT-4 Turbo ビジョンをアップデート、それらはすべて Google をいじめている

Google を包囲し、抑圧する傾向が実際にあります。

#今年 1 月に、Mistral AI は Mixtral 8x7B の技術詳細を発表し、Mixtral 8x7B – 指示チャット モデルを開始しました。このモデルのパフォーマンスは、人間による評価ベンチマークにおいて、GPT-3.5 Turbo、Claude-2.1、Gemini Pro、および Llama 2 70B チャット モデルを大幅に上回っています。

わずか 3 か月後、Mistral AI は Mistral 8X22B モデルをオープンソース化し、強力なパフォーマンスを備えた別の大型モデルをオープンソース コミュニティにもたらしました。

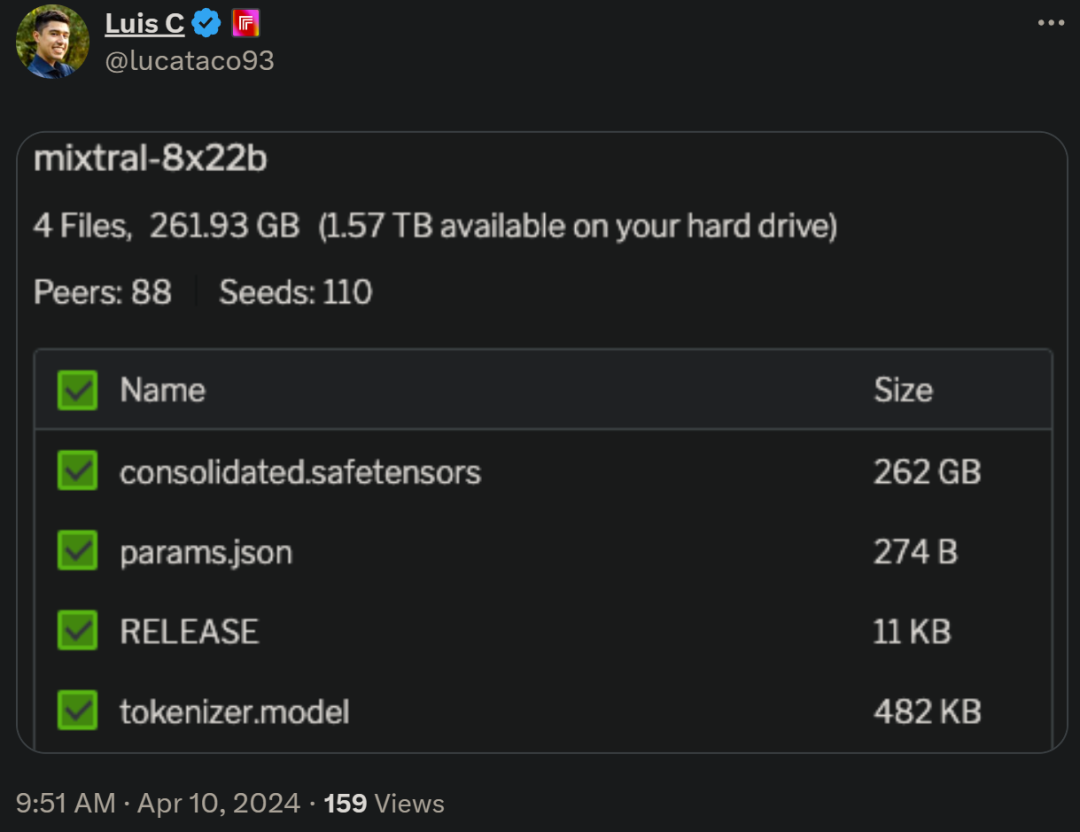

Mistral 8X22B モデルの詳細を調べた人がいますが、モデルのファイル サイズは約 262 GB です。

Mistral 8X22B モデルの詳細を調べた人がいますが、モデルのファイル サイズは約 262 GB です。  その結果、Mistral 8X22B は、xAI によって以前に発売された Grok-1 (パラメータ ボリューム 314) に次いで、現時点で 2 番目に大きいオープン ソース モデルになりました。十億)。

その結果、Mistral 8X22B は、xAI によって以前に発売された Grok-1 (パラメータ ボリューム 314) に次いで、現時点で 2 番目に大きいオープン ソース モデルになりました。十億)。  MoE サークルにもう 1 人「偉い人」がいると叫ぶ人もいます。 MoE は専門家モデルの混合であり、以前は Grok-1 も MoE モデルでした。

MoE サークルにもう 1 人「偉い人」がいると叫ぶ人もいます。 MoE は専門家モデルの混合であり、以前は Grok-1 も MoE モデルでした。

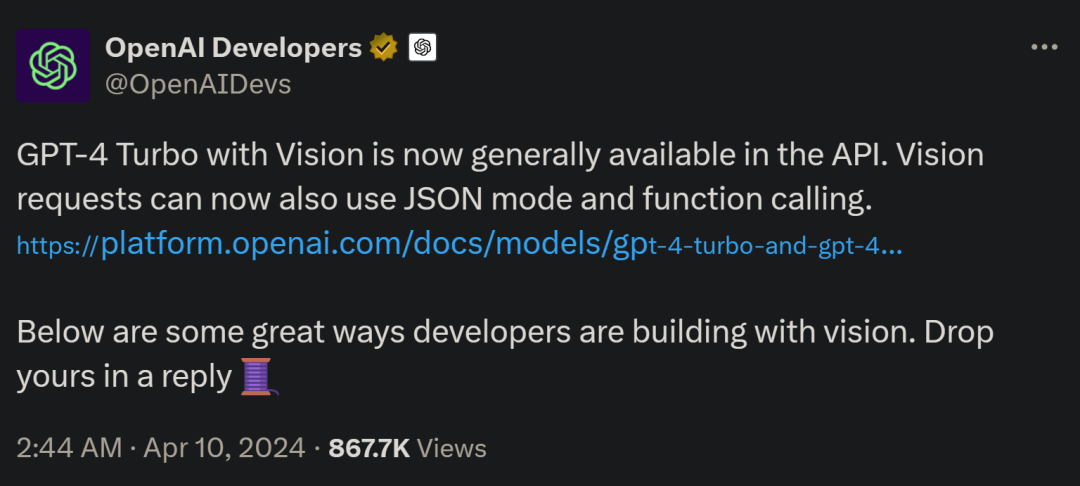

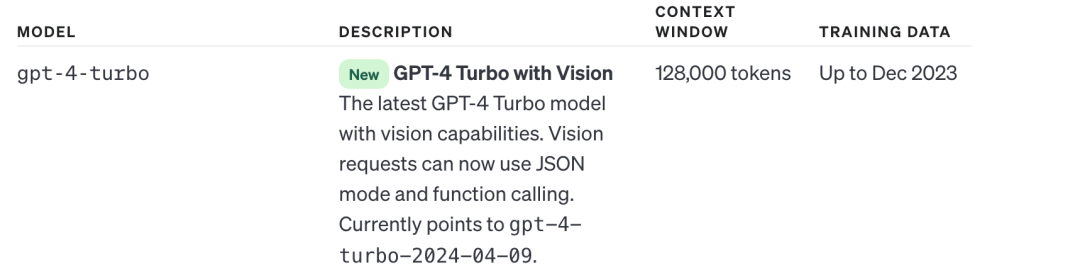

一方、OpenAI GPT -4 Turbo with Vision が API 経由で利用できるようになり、Vision 機能が JSON スキーマと関数呼び出しを使用して利用できるようになったと発表しました。

参考リンク:

参考リンク: 以上がMistral オープンソース 8X22B 大型モデル、OpenAI が GPT-4 Turbo ビジョンをアップデート、それらはすべて Google をいじめているの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7475

7475

15

15

1377

1377

52

52

77

77

11

11

19

19

31

31

DeepSeekを検索する方法

Feb 19, 2025 pm 05:39 PM

DeepSeekを検索する方法

Feb 19, 2025 pm 05:39 PM

DeepSeekは、特定のデータベースまたはシステムでのみ検索する独自の検索エンジンであり、より速く、より正確です。それを使用する場合、ユーザーはドキュメントを読み、さまざまな検索戦略を試し、ユーザーエクスペリエンスに関するヘルプを求めてフィードバックを求めて、利点を最大限に活用することをお勧めします。

セサミオープンドア交換Webページ登録リンクゲートトレーディングアプリ登録Webサイト最新

Feb 28, 2025 am 11:06 AM

セサミオープンドア交換Webページ登録リンクゲートトレーディングアプリ登録Webサイト最新

Feb 28, 2025 am 11:06 AM

この記事では、SESAME Open Exchange(gate.io)Webバージョンの登録プロセスとGate Tradingアプリを詳細に紹介します。 Web登録であろうとアプリの登録であろうと、公式Webサイトまたはアプリストアにアクセスして、本物のアプリをダウンロードし、ユーザー名、パスワード、電子メール、携帯電話番号、その他の情報を入力し、電子メールまたは携帯電話の確認を完了する必要があります。

Bybit Exchangeリンクを直接ダウンロードしてインストールできないのはなぜですか?

Feb 21, 2025 pm 10:57 PM

Bybit Exchangeリンクを直接ダウンロードしてインストールできないのはなぜですか?

Feb 21, 2025 pm 10:57 PM

Bybit Exchangeリンクを直接ダウンロードしてインストールできないのはなぜですか? BYBITは、ユーザーにトレーディングサービスを提供する暗号通貨交換です。 Exchangeのモバイルアプリは、次の理由でAppStoreまたはGooglePlayを介して直接ダウンロードすることはできません。1。AppStoreポリシーは、AppleとGoogleがApp Storeで許可されているアプリケーションの種類について厳しい要件を持つことを制限しています。暗号通貨交換アプリケーションは、金融サービスを含み、特定の規制とセキュリティ基準を必要とするため、これらの要件を満たしていないことがよくあります。 2。法律と規制のコンプライアンス多くの国では、暗号通貨取引に関連する活動が規制または制限されています。これらの規制を遵守するために、BYBITアプリケーションは公式Webサイトまたはその他の認定チャネルを通じてのみ使用できます

セサミオープンドアトレーディングプラットフォームダウンロードモバイルバージョンgateioトレーディングプラットフォームのダウンロードアドレス

Feb 28, 2025 am 10:51 AM

セサミオープンドアトレーディングプラットフォームダウンロードモバイルバージョンgateioトレーディングプラットフォームのダウンロードアドレス

Feb 28, 2025 am 10:51 AM

アプリをダウンロードしてアカウントの安全を確保するために、正式なチャネルを選択することが重要です。

Crypto Digital Asset Trading App(2025グローバルランキング)に推奨されるトップ10

Mar 18, 2025 pm 12:15 PM

Crypto Digital Asset Trading App(2025グローバルランキング)に推奨されるトップ10

Mar 18, 2025 pm 12:15 PM

この記事では、Binance、Okx、Gate.io、Bitflyer、Kucoin、Bybit、Coinbase Pro、Kraken、Bydfi、Xbit分散化された交換など、注意を払う価値のある上位10の暗号通貨取引プラットフォームを推奨しています。これらのプラットフォームには、トランザクションの数量、トランザクションの種類、セキュリティ、コンプライアンス、特別な機能の点で独自の利点があります。適切なプラットフォームを選択するには、あなた自身の取引体験、リスク許容度、投資の好みに基づいて包括的な検討が必要です。 この記事があなたがあなた自身に最適なスーツを見つけるのに役立つことを願っています

Binance Binance公式Webサイト最新バージョンログインポータル

Feb 21, 2025 pm 05:42 PM

Binance Binance公式Webサイト最新バージョンログインポータル

Feb 21, 2025 pm 05:42 PM

Binance Webサイトログインポータルの最新バージョンにアクセスするには、これらの簡単な手順に従ってください。公式ウェブサイトに移動し、右上隅の[ログイン]ボタンをクリックします。既存のログインメソッドを選択してください。「登録」してください。登録済みの携帯電話番号または電子メールとパスワードを入力し、認証を完了します(モバイル検証コードやGoogle Authenticatorなど)。検証が成功した後、Binance公式WebサイトLogin Portalの最新バージョンにアクセスできます。

2025年のBitgetの最新のダウンロードアドレス:公式アプリを取得する手順

Feb 25, 2025 pm 02:54 PM

2025年のBitgetの最新のダウンロードアドレス:公式アプリを取得する手順

Feb 25, 2025 pm 02:54 PM

このガイドは、AndroidおよびiOSシステムに適した公式Bitget Exchangeアプリの詳細なダウンロードとインストール手順を提供します。このガイドは、公式ウェブサイト、App Store、Google Playなど、複数の権威ある情報源からの情報を統合し、ダウンロードおよびアカウント管理中の考慮事項を強調しています。ユーザーは、App Store、公式WebサイトAPKダウンロード、公式Webサイトジャンプ、完全な登録、ID検証、セキュリティ設定など、公式チャネルからアプリをダウンロードできます。さらに、ガイドはよくある質問や考慮事項をカバーします。