新しくリリースされた Llama 3 を体験する 6 つの簡単な方法!

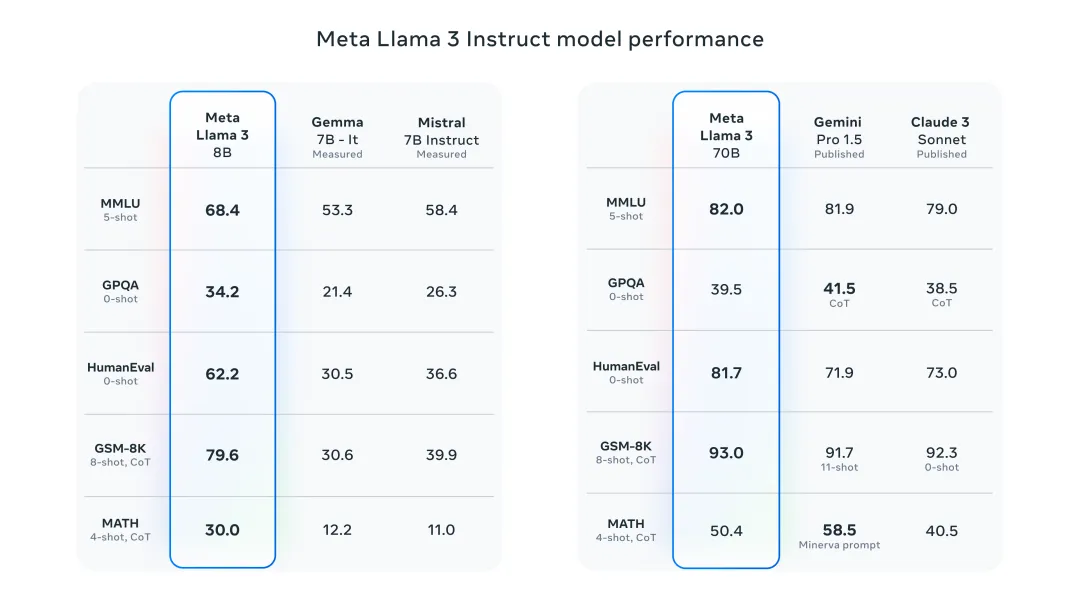

昨夜、Meta は Llama 3 8B および 70B モデルをリリースしました。Llama 3 コマンド調整モデルは、対話/チャットのユースケース向けに微調整され、最適化されており、一般的なモデルよりも優れています。多くの既存のオープンソース チャット モデル。たとえば、ジェマ 7B やミストラル 7B などです。

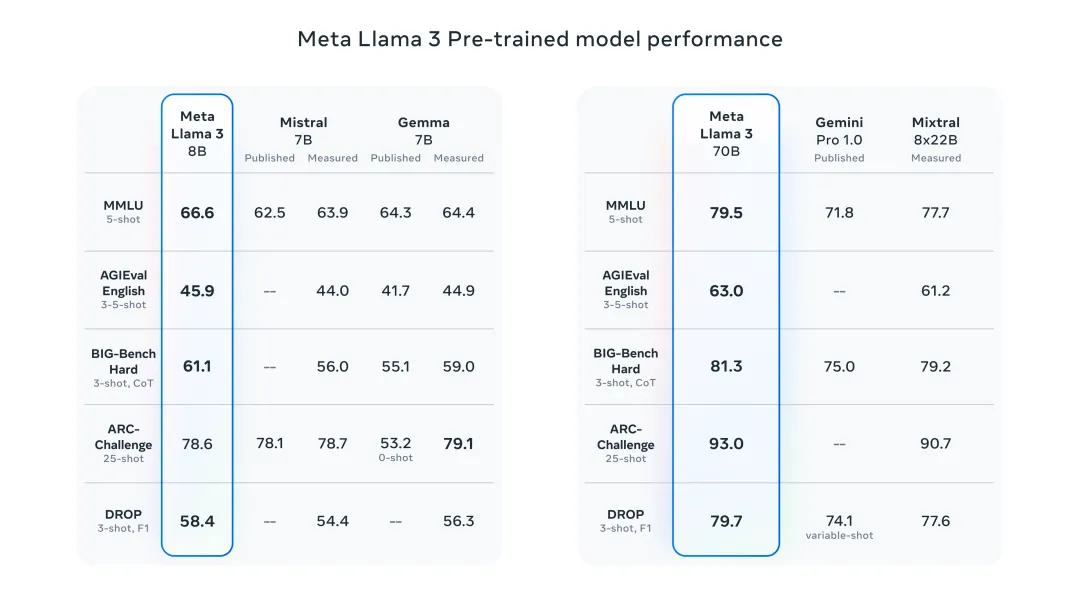

Llama 3 モデルは、データとスケールを新たな高みに改善します。これは、Meta によって最近リリースされた 2 つのカスタム 24K GPU クラスター上の 15T トークンを超えるデータでトレーニングされました。このトレーニング データセットは Llama 2 より 7 倍大きく、4 倍多くのコードが含まれています。これにより、Llama モデルの機能が現在の最高レベルになり、Llama 2 の 2 倍である 8K を超えるテキスト長がサポートされます。

以下では、リリースされたばかりの Llama 3 をすぐに体験できる 6 つの方法を紹介します。

Llama 3 をオンラインで体験

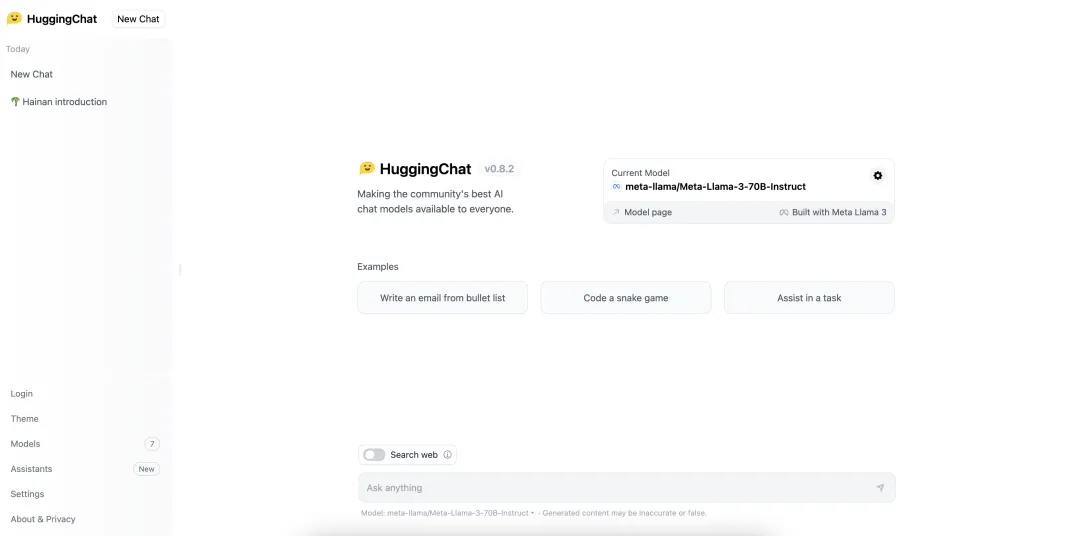

ハグチャット

llama2.ai

##https://www.llama2.ai/

現地体験ラマ 3

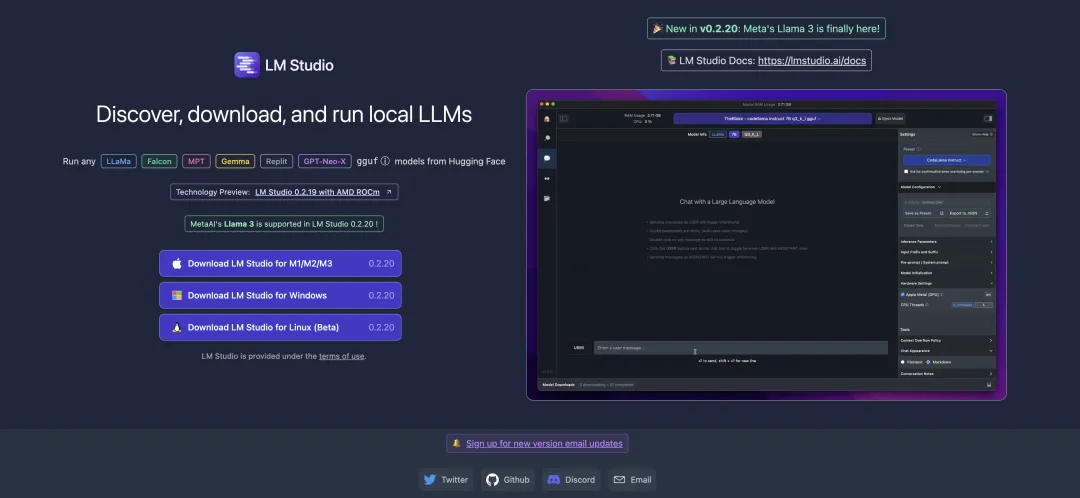

LM Studio

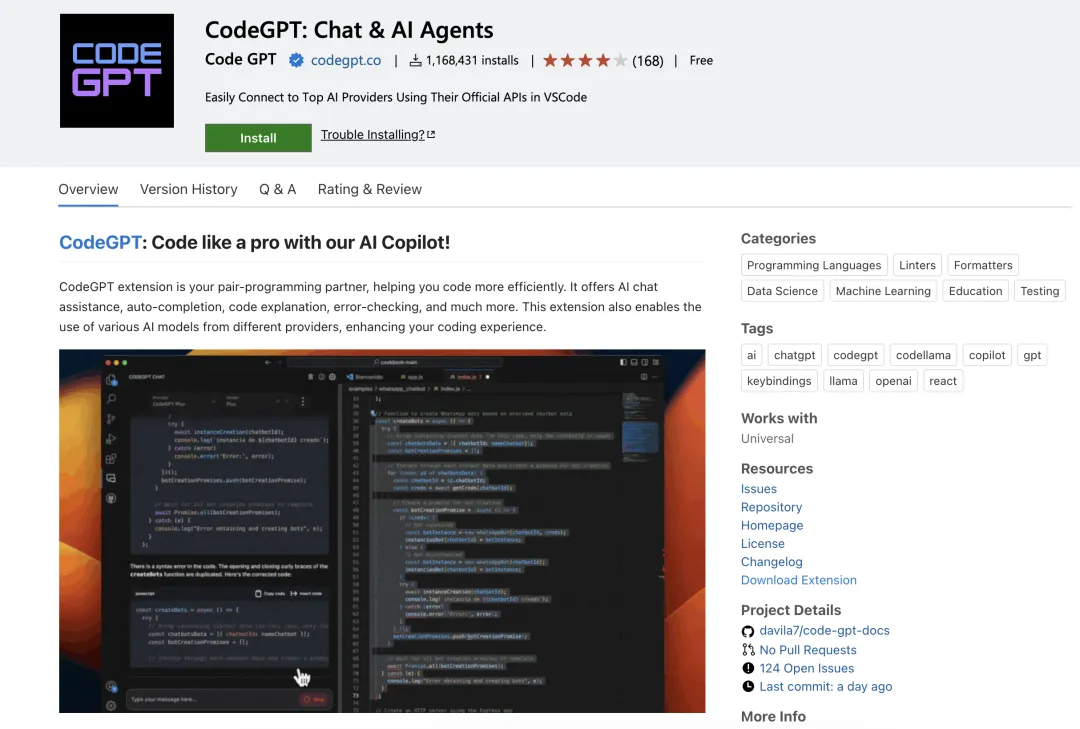

CodeGPT

##https://marketplace.visualstudio.com/items?itemName=DanielSanMedium.dscodegpt&ssr=false

##https://marketplace.visualstudio.com/items?itemName=DanielSanMedium.dscodegpt&ssr=false

CodeGPT を使用する前に、必ず Ollama を使用して対応するモデルをプルしてください。たとえば、llama3:8b モデルをプルするには、ollama pull llama3:8b とします。 ollam をローカルにインストールしていない場合は、この記事「ローカルの大規模言語モデルをわずか数分でデプロイする!」を参照してください。

Ollama

Llama 3 8B モデルの実行:

ollama run llama3

ollama run llama3:70b

##https://pinokio.computer/item?uri=https:/ / github.com/cocktailpeanutlabs/open-webui。

以上が新しくリリースされた Llama 3 を体験する 6 つの簡単な方法!の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7555

7555

15

15

1382

1382

52

52

83

83

11

11

28

28

96

96

GITでリポジトリを削除する方法

Apr 17, 2025 pm 04:03 PM

GITでリポジトリを削除する方法

Apr 17, 2025 pm 04:03 PM

gitリポジトリを削除するには、次の手順に従ってください。削除するリポジトリを確認します。リポジトリのローカル削除:RM -RFコマンドを使用して、フォルダーを削除します。倉庫をリモートで削除する:倉庫の設定に移動し、「倉庫の削除」オプションを見つけて、操作を確認します。

gitコミットの使用方法

Apr 17, 2025 pm 03:57 PM

gitコミットの使用方法

Apr 17, 2025 pm 03:57 PM

GITコミットは、プロジェクトの現在の状態のスナップショットを保存するために、ファイルの変更をGITリポジトリに記録するコマンドです。使用方法は次のとおりです。一時的なストレージエリアに変更を追加する簡潔で有益な提出メッセージを書き込み、送信メッセージを保存して終了して送信を完了します。

Gitサーバーのパブリックネットワークに接続する方法

Apr 17, 2025 pm 02:27 PM

Gitサーバーのパブリックネットワークに接続する方法

Apr 17, 2025 pm 02:27 PM

GITサーバーをパブリックネットワークに接続するには、5つのステップが含まれます。1。パブリックIPアドレスのセットアップ。 2。ファイアウォールポート(22、9418、80/443)を開きます。 3。SSHアクセスを構成します(キーペアを生成し、ユーザーを作成します)。 4。http/httpsアクセスを構成します(サーバーをインストールし、許可を構成); 5.接続をテストします(SSHクライアントまたはGITコマンドを使用)。

GitでSSHを検出する方法

Apr 17, 2025 pm 02:33 PM

GitでSSHを検出する方法

Apr 17, 2025 pm 02:33 PM

GITを介してSSHを検出するには、次の手順を実行する必要があります。SSHキーペアを生成します。 Gitサーバーに公開キーを追加します。 sshを使用するようにgitを構成します。 SSH接続をテストします。実際の条件に応じて可能な問題を解決します。

Gitプロジェクトをローカルにダウンロードする方法

Apr 17, 2025 pm 04:36 PM

Gitプロジェクトをローカルにダウンロードする方法

Apr 17, 2025 pm 04:36 PM

gitを介してローカルにプロジェクトをダウンロードするには、次の手順に従ってください。gitをインストールします。プロジェクトディレクトリに移動します。次のコマンドを使用してリモートリポジトリのクローニング:git clone https://github.com/username/repository-name.git

Gitダウンロードがアクティブでない場合はどうすればよいですか

Apr 17, 2025 pm 04:54 PM

Gitダウンロードがアクティブでない場合はどうすればよいですか

Apr 17, 2025 pm 04:54 PM

解決:gitのダウンロード速度が遅い場合、次の手順を実行できます。ネットワーク接続を確認し、接続方法を切り替えてみてください。 GIT構成の最適化:ポストバッファーサイズ(Git Config -Global HTTP.Postbuffer 524288000)を増やし、低速制限(GIT Config -Global HTTP.LowsPeedLimit 1000)を減らします。 Gitプロキシ(Git-ProxyやGit-LFS-Proxyなど)を使用します。別のGitクライアント(SourcetreeやGithubデスクトップなど)を使用してみてください。防火を確認してください

PHPプロジェクトで効率的な検索問題を解決する方法は?タイプセンスはあなたがそれを達成するのに役立ちます!

Apr 17, 2025 pm 08:15 PM

PHPプロジェクトで効率的な検索問題を解決する方法は?タイプセンスはあなたがそれを達成するのに役立ちます!

Apr 17, 2025 pm 08:15 PM

eコマースのウェブサイトを開発するとき、私は困難な問題に遭遇しました:大量の製品データで効率的な検索機能を達成する方法は?従来のデータベース検索は非効率的であり、ユーザーエクスペリエンスが低いです。いくつかの調査の後、私は検索エンジンタイプセンスを発見し、公式のPHPクライアントタイプセンス/タイプセンス-PHPを通じてこの問題を解決し、検索パフォーマンスを大幅に改善しました。

gitの提出後に戻る方法

Apr 17, 2025 pm 01:06 PM

gitの提出後に戻る方法

Apr 17, 2025 pm 01:06 PM

Git Commitをフォールバックするには、Git Reset - Hard Head〜nコマンドを使用できます。ここで、nはコミット数の数を表します。詳細な手順には、次のものがあります。 - ハードオプションを使用して、フォールバックを強制します。指定されたコミットに戻るためにコマンドを実行します。