CVPR 2024 | AI は、ダンス時のスカートの飛行を高度に復元することもでき、ダイナミックな人体レンダリングの新しいパラダイムを提案します。

AIxivコラムは、当サイトが学術的・技術的な内容を掲載するコラムです。過去数年間で、このサイトの AIxiv コラムには 2,000 件を超えるレポートが寄せられ、世界中の主要な大学や企業のトップ研究室がカバーされ、学術交流と普及を効果的に促進しています。共有したい優れた作品がある場合は、お気軽に寄稿するか、報告のために当社までご連絡ください。提出電子メール: liyazhou@jiqizhixin.com; zhaoyunfeng@jiqizhixin.com。

論文タイトル: SurMo: ダイナミックヒューマンレンダリングのためのサーフェスベースの4Dモーションモデリング 論文アドレス: https://arxiv.org/pdf/2404.01225.pdf プロジェクトホームページ: https ://taohuumd.github.io/projects/SurMo Github リンク: https://github.com/TaoHuUMD/SurMo

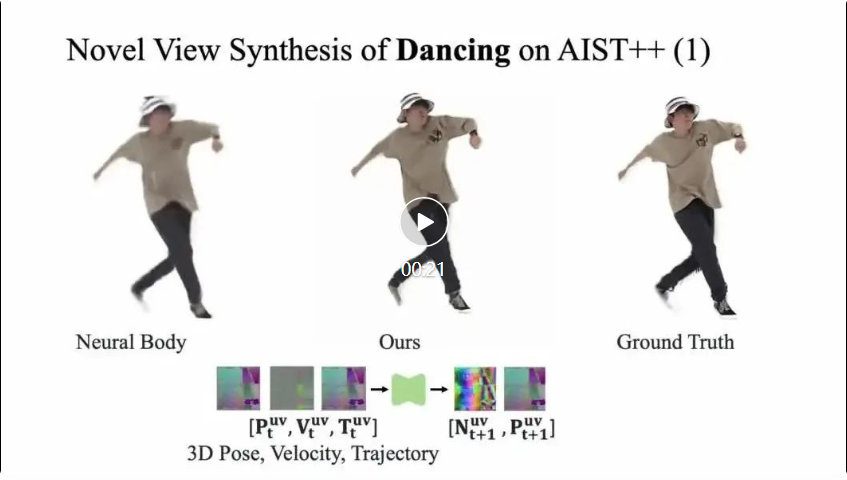

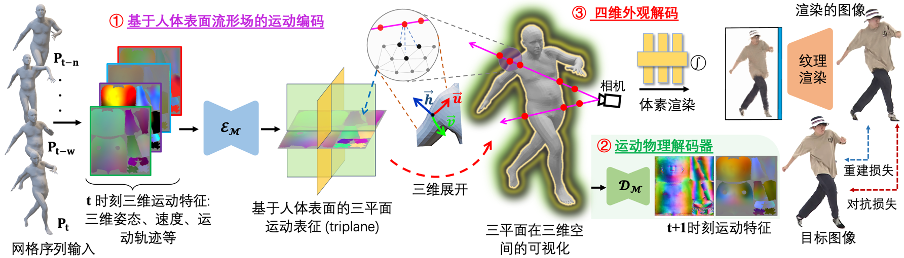

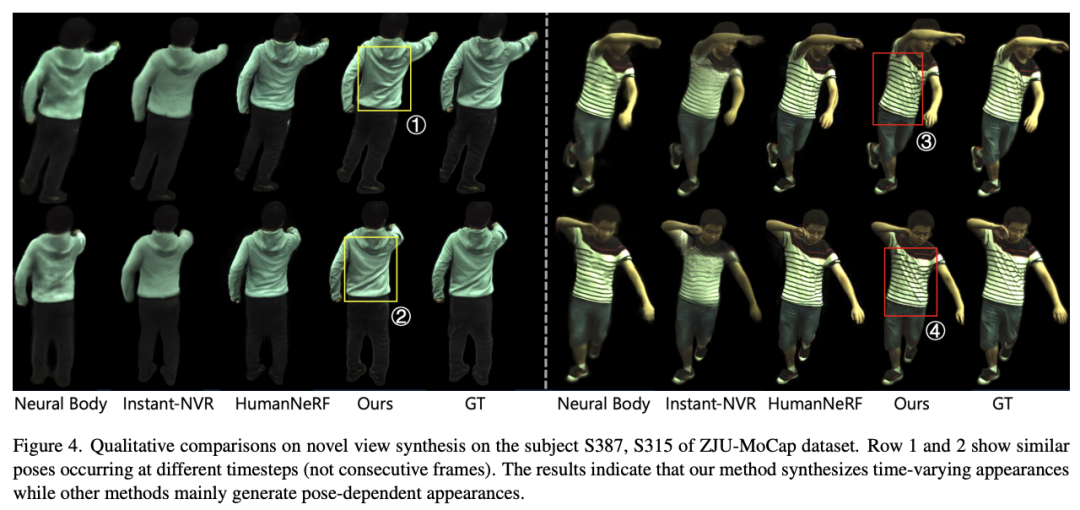

疎な 3 次元空間での動きをモデル化する既存の手法とは異なり、SurMo は、人間の表面多様体フィールド (またはコンパクト) に基づいて提案します。 2 次元テクスチャ UV 空間) 4 次元 (XYZ-T) モーション モデリングであり、人体表面上に定義された 3 つの平面 (サーフェスベースのトリプレーン) を介してモーションを表します。 運動の空間的偏向などの現在の運動特性 (3 次元の姿勢、速度、運動軌道など) に基づいて次のフレームの運動状態を予測する運動物理デコーダーを提案します - 表面法線ベクトルと時間的偏向 - 速度、これは動きの特徴の連続性をモデル化します。 4 次元外観デコーディング、3 次元自由視点ビデオをレンダリングするための動き特徴の時間デコーディング。主にハイブリッド ボクセル-テクスチャ ニューラル レンダリング (ハイブリッド ボリューム-テクスチャ レンダリング、HVTR [Hu et al. 2022]) を通じて実装されます。 .

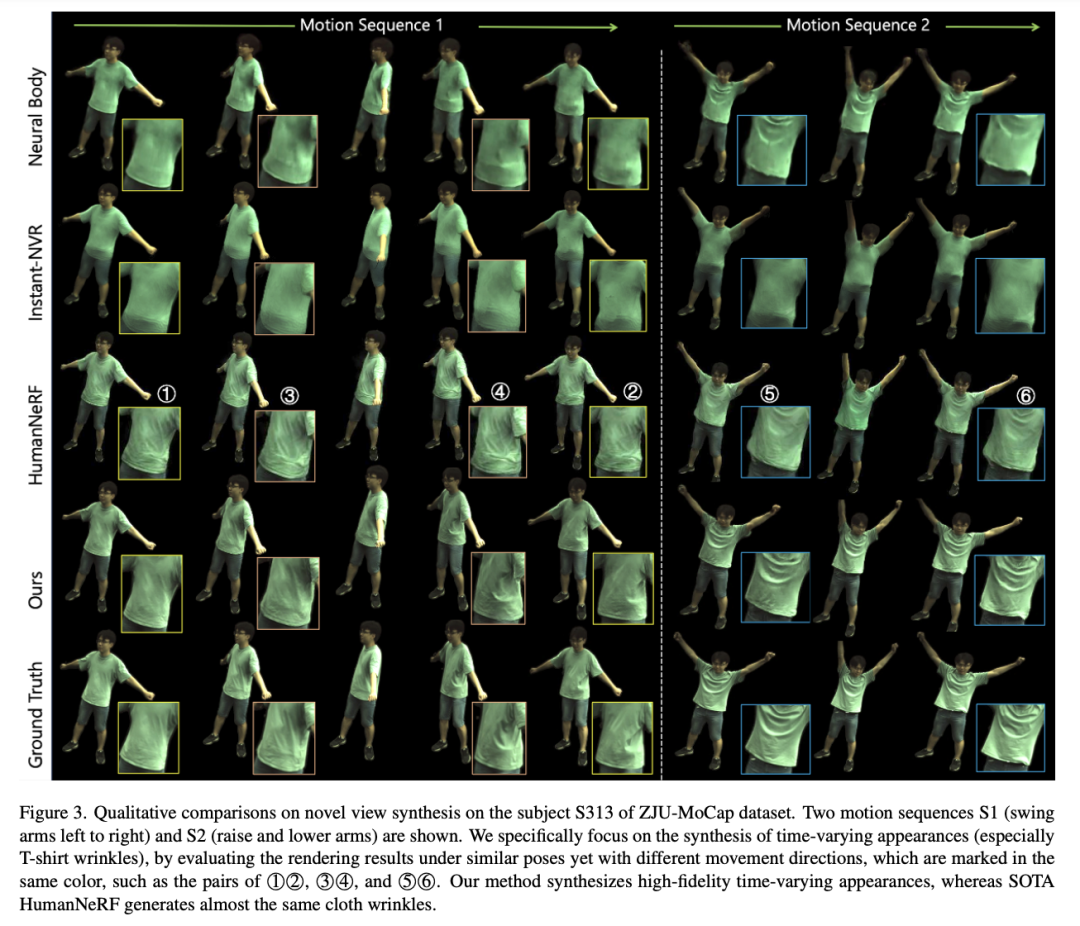

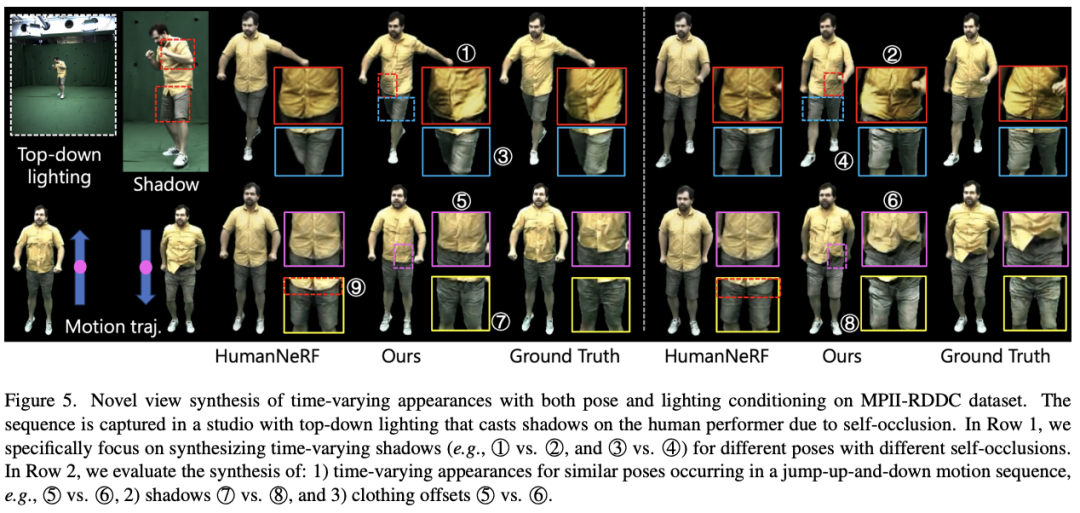

SurMo では、これらの①②、③④、⑦⑧などの影を新しい視点レンダリングで復元することができます。対照的な方法である HumanNeRF [Weng et al.] は、動きに関連した影を回復できません。さらに、SurMo は、ジャンプ動作の折り目⑤⑥ など、動作軌道に応じて変化する服飾品の動作を再構築できますが、HumanNeRF はこの動的効果を再構築できません。

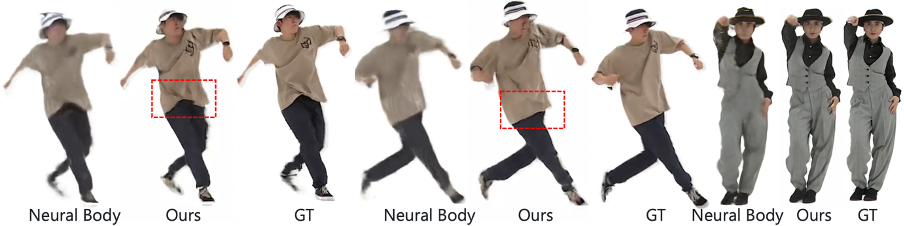

高速で動く人体のレンダリング

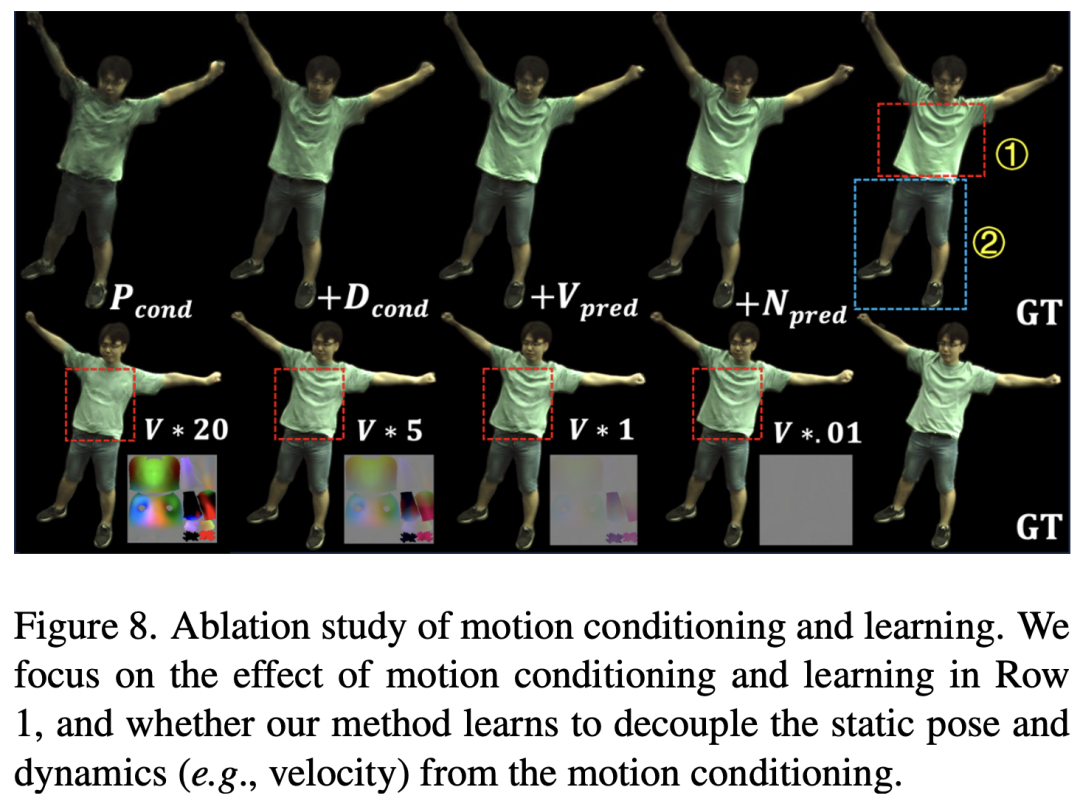

アブレーション実験

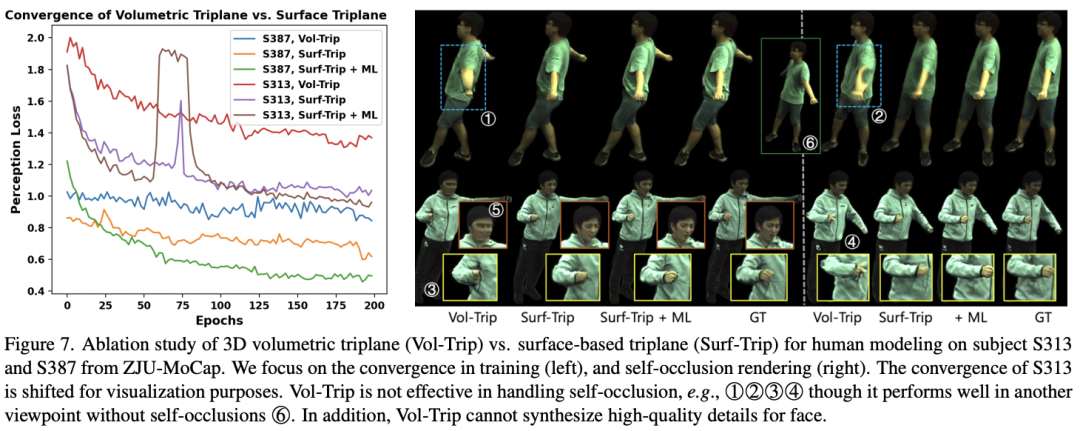

この研究では、2つの異なる運動モデリング手法を比較しました:現在ボクセル空間(体積空間)で一般的に使用されている運動モデリング、および SurMo によって提案された人間の表面多様体フィールド (表面多様体) の運動モデリング、特にボリューム トリプレーンと表面ベースのトリプレーンを比較したものを以下の図に示します。

以上がCVPR 2024 | AI は、ダンス時のスカートの飛行を高度に復元することもでき、ダイナミックな人体レンダリングの新しいパラダイムを提案します。の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7450

7450

15

15

1374

1374

52

52

77

77

11

11

14

14

9

9

Giteeページ静的なWebサイトの展開に失敗しました:単一のファイル404エラーをトラブルシューティングと解決する方法

Apr 04, 2025 pm 11:54 PM

Giteeページ静的なWebサイトの展開に失敗しました:単一のファイル404エラーをトラブルシューティングと解決する方法

Apr 04, 2025 pm 11:54 PM

GiteEpages静的Webサイトの展開が失敗しました:404エラーのトラブルシューティングと解像度Giteeを使用する

GOのどのライブラリが大企業によって開発されていますか、それとも有名なオープンソースプロジェクトによって提供されていますか?

Apr 02, 2025 pm 04:12 PM

GOのどのライブラリが大企業によって開発されていますか、それとも有名なオープンソースプロジェクトによって提供されていますか?

Apr 02, 2025 pm 04:12 PM

大企業または有名なオープンソースプロジェクトによって開発されたGOのどのライブラリが開発されていますか? GOでプログラミングするとき、開発者はしばしばいくつかの一般的なニーズに遭遇します...

海外バージョンの配送地域データを取得する方法は?利用可能な既製のリソースは何ですか?

Apr 01, 2025 am 08:15 AM

海外バージョンの配送地域データを取得する方法は?利用可能な既製のリソースは何ですか?

Apr 01, 2025 am 08:15 AM

質問の説明:海外バージョンの配送地域データを取得する方法は?既製のリソースはありますか?国境を越えた電子商取引またはグローバル化ビジネスで正確に入手してください...

Redisストリームを使用してGO言語でメッセージキューを実装する場合、user_idタイプの変換の問題を解決する方法は?

Apr 02, 2025 pm 04:54 PM

Redisストリームを使用してGO言語でメッセージキューを実装する場合、user_idタイプの変換の問題を解決する方法は?

Apr 02, 2025 pm 04:54 PM

redisstreamを使用してGo言語でメッセージキューを実装する問題は、GO言語とRedisを使用することです...

H5プロジェクトの実行方法

Apr 06, 2025 pm 12:21 PM

H5プロジェクトの実行方法

Apr 06, 2025 pm 12:21 PM

H5プロジェクトを実行するには、次の手順が必要です。Webサーバー、node.js、開発ツールなどの必要なツールのインストール。開発環境の構築、プロジェクトフォルダーの作成、プロジェクトの初期化、コードの書き込み。開発サーバーを起動し、コマンドラインを使用してコマンドを実行します。ブラウザでプロジェクトをプレビューし、開発サーバーURLを入力します。プロジェクトの公開、コードの最適化、プロジェクトの展開、Webサーバーの構成のセットアップ。

Python hourglassグラフ図面:可変未定義エラーを避ける方法は?

Apr 01, 2025 pm 06:27 PM

Python hourglassグラフ図面:可変未定義エラーを避ける方法は?

Apr 01, 2025 pm 06:27 PM

Python:Hourglassグラフィック図面と入力検証この記事では、Python NoviceがHourglass Graphic Drawingプログラムで遭遇する可変定義の問題を解決します。コード...

TypeChoルートマッチングの競合:なぜMy/test/tag/his/10086は、testtagpageの代わりにtesttagindexを一致させるのですか?

Apr 01, 2025 am 09:03 AM

TypeChoルートマッチングの競合:なぜMy/test/tag/his/10086は、testtagpageの代わりにtesttagindexを一致させるのですか?

Apr 01, 2025 am 09:03 AM

Typechoルーティングマッチングルール分析と問題調査