## 最近、Yan Shuicheng 教授のチームは Vitron ユニバーサル ピクセル レベル ビジョン Multimodal ラージを共同でリリースし、オープンソース化しました。言語モデル。

##プロジェクトのホームページとデモ:

https://www. php.cn/link/d8a3b2dde3181c8257e2e45efbd1e8ae紙のリンク: https://www.php.cn/ link/0ec5ba872f1179835987f9028c4cc4dfオープンソース コード: https://www.php.cn/link/26d6e896db39edc7d7bdd357d6984c95

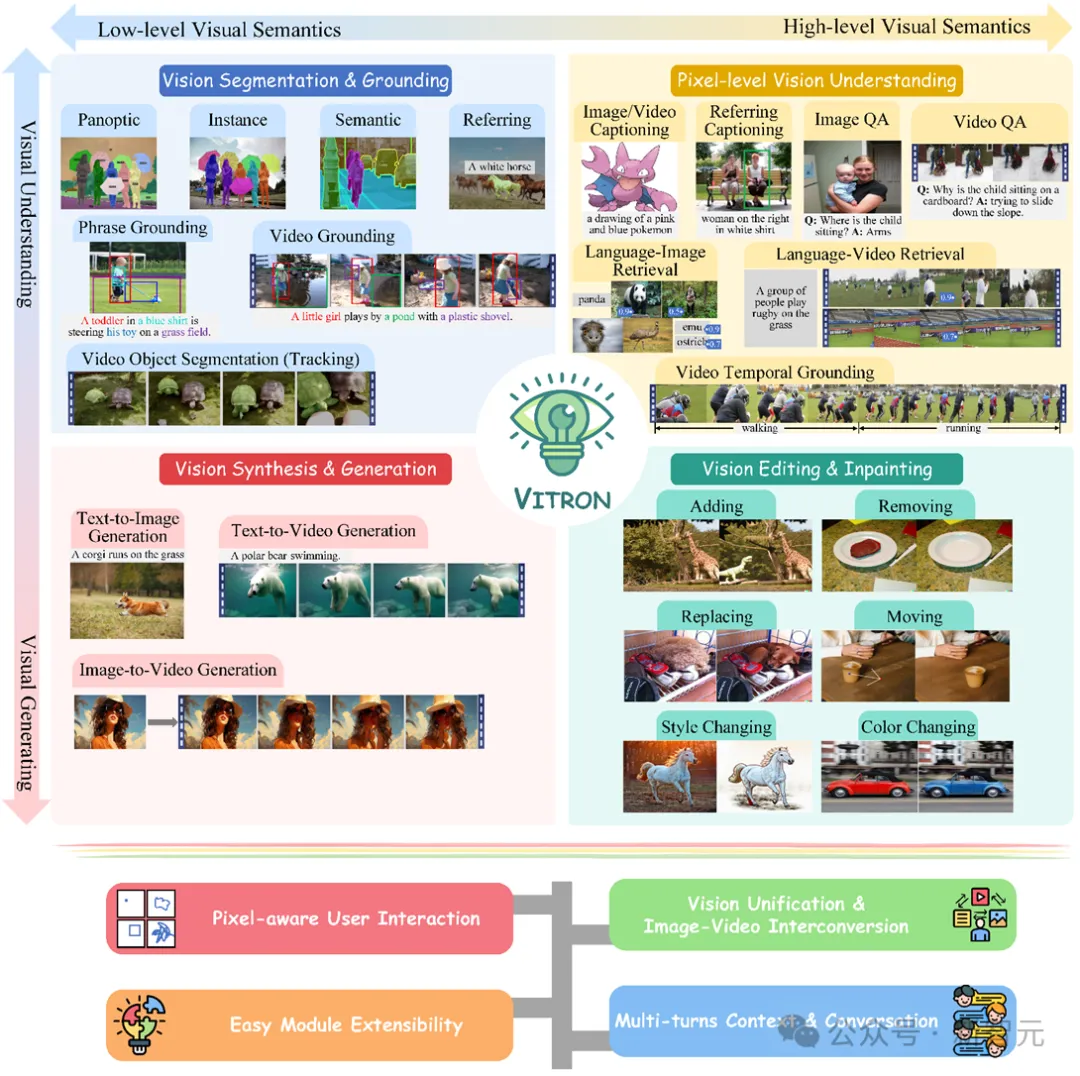

##これは頑丈です一般的なビジュアルマルチモーダル大規模モデルは、視覚的な理解から視覚的な生成まで、低レベルから高レベルまでの一連の視覚タスクをサポートし、大規模言語モデル業界を長年悩ませてきた画像/イメージの問題を解決します。ビデオモデルのセグメンテーションは、静止画像と動的なビデオコンテンツの理解、生成、セグメンテーション、編集を包括的に統合するピクセルレベルの一般的なビジュアルマルチモーダルラージモデルを提供し、次世代の一般的なビジュアルラージの究極の形式の基礎を築きます。モデルは、大規模モデル向けの汎用人工知能 (AGI) に向けた新たな大きな一歩でもあります。

Vitron は、統一されたピクセルレベルのビジュアルマルチモーダル大規模言語モデルとして、低レベルから高レベルまでの視覚タスクを実現します。レベル 包括的なサポートにより、複雑な視覚的タスクを処理し、画像とビデオのコンテンツを理解して生成し、強力な視覚的理解とタスク実行機能を提供します。同時に、Vitron はユーザーとの継続的な操作をサポートし、柔軟な人間とコンピューターの対話を可能にし、より統一された視覚的なマルチモーダル ユニバーサル モデルに向けた大きな可能性を実証します。

Vitron 関連の論文、コード、デモはすべて公開されており、その包括性、技術革新、人間とコンピューターの相互作用、および応用が可能です。可能性 他の側面で示された独自の利点と可能性は、マルチモーダル大規模モデルの開発を促進するだけでなく、将来の視覚的大規模モデル研究に新しい方向性を提供します。

ビジュアルラージ言語モデル (LLM) の現在の開発は、満足のいく進歩を遂げています。コミュニティでは、より汎用的で強力なマルチモーダル大規模モデル (MLLM) を構築することが汎用人工知能 (AGI) を実現する唯一の方法であるとの考えが高まっています。ただし、マルチモーダルな一般モデル (ジェネラリスト) に移行するプロセスには、依然として重要な課題がいくつかあります。たとえば、作業の大部分は、ピクセルレベルのきめ細かい視覚的理解を達成できていないか、画像とビデオの統一されたサポートが不足しています。あるいは、さまざまな視覚的タスクのサポートが不十分であり、汎用的な大型モデルには程遠いです。このギャップを埋めるために、チームは最近共同で、オープンソースの Vitron ユニバーサル ピクセル レベル ビジュアル マルチモーダル大規模言語モデルをリリースしました。 Vitron は、静止画像と動的なビデオ コンテンツの包括的な理解、生成、セグメンテーション、編集を含む、低レベルから高レベルまで、視覚的な理解から視覚的な生成までの一連の視覚タスクをサポートします。

上の図は、4 つの主要な視覚関連タスクに対する Vitron の機能サポートと、その主な利点を包括的に示しています。 Vitron はまた、ユーザーとの継続的な操作をサポートし、柔軟な人間とコンピューターの対話を実現します。このプロジェクトは、より統合されたビジョン マルチモーダル一般モデルの大きな可能性を実証し、次世代の一般ビジョン大型モデルの究極の形の基礎を築きます。 Vitron 関連の論文、コード、デモはすべて公開されました。

近年、大規模言語モデル (LLM) は前例のない強力な機能を実証し、AGI への道であることが徐々に検証されてきました。テクニカルルート。マルチモーダル大規模言語モデル (MLLM) は、多くのコミュニティで急速に開発されており、視覚認識を実行できるモジュールを導入することにより、画像理解における多くの強力で優れた MLLM が開発されています。 BLIP-2、LLaVA、MiniGPT-4など。同時に、VideoChat、Video-LLaMA、Video-LLaVA など、ビデオの理解に焦点を当てた MLLM も立ち上げられています。

その後、研究者は主に 2 次元から MLLM の機能をさらに拡張しようとしました。一方で、研究者たちは、GLaMM などの視覚領域の位置特定 (地域接地) 機能を実現するために、画像についての大まかなインスタンス レベルの理解からピクセル レベルの詳細な理解に移行して、MLLM の視覚についての理解を深めようとしています。 、PixelLM、NExT-Chat、MiniGPT-v2など。

一方、研究者は、MLLM がサポートできる視覚機能を拡張しようとしています。 MLLM が入力視覚信号を理解するだけでなく、出力視覚コンテンツの生成をどのようにサポートするかを研究する研究も行われ始めています。例えば、GILL や Emu などの MLLM は画像コンテンツを柔軟に生成でき、GPT4Video や NExT-GPT はビデオ生成を実現します。

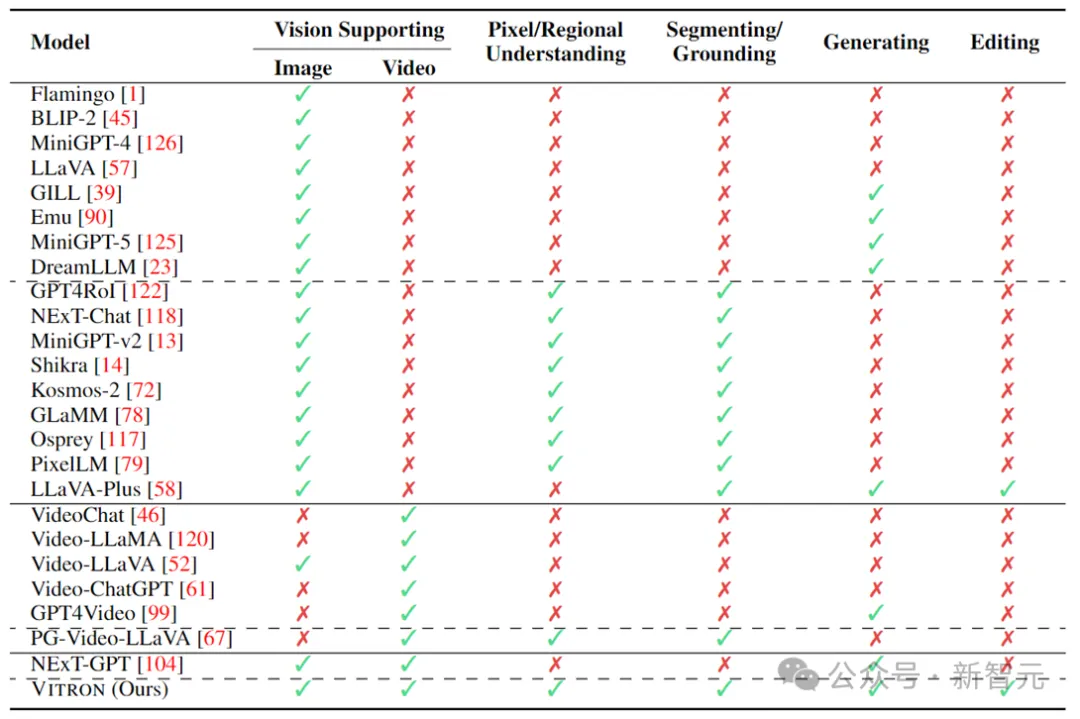

現在、人工知能コミュニティは、ビジュアル MLLM の将来の傾向が高度に統合され、より強力な機能の方向に必然的に発展するというコンセンサスに徐々に達しています。ただし、コミュニティによって多数の MLLM が開発されているにもかかわらず、明らかなギャップが依然として存在します。

1. ほとんどすべての既存のビジュアル LLM は、画像とビデオを別のエンティティとして扱い、画像のみまたはビデオのみをサポートします。

研究者らは、視覚には静止画像と動的なビデオの両方を含めるべきだと主張しています。どちらも視覚世界の一部です。コアコンポーネントは、次のようなものでも交換可能です。ほとんどのシナリオ。したがって、画像とビデオの両方のモダリティをサポートできる統合 MLLM フレームワークを構築する必要があります。

#2. 現在、MLLM による視覚機能のサポートはまだ不十分です。

ほとんどのモデルは、画像やビデオを理解するか、せいぜい生成することしかできません。研究者らは、将来の MLLM は、より広範囲の視覚タスクと操作をカバーし、すべての視覚関連タスクの統一サポートを実現し、「one for all」機能を実現できる、一般的な大規模言語モデルになるべきだと考えています。これは、実際のアプリケーション、特に一連の反復的でインタラクティブな操作を伴うことが多いビジュアル作成において非常に重要です。

たとえば、ユーザーはまずテキストから始めて、Vincent 図を使用してアイデアをビジュアル コンテンツに変換し、その後、さらにきめ細かい画像編集を通じて最初のアイデアを改良し、さらに詳細を追加します。 、画像からビデオを生成して動的なコンテンツを作成します。最後に、ビデオ編集などの反復操作を数回実行して、作成を完成させます。

上の表は、既存のビジュアル MLLM の機能を簡単に要約したものです (一部のモデルが代表的に含まれているだけであり、範囲は不完全です)。これらのギャップを埋めるために、チームは一般的なピクセルレベルのビジュアルMLLMであるVitronを提案しています。

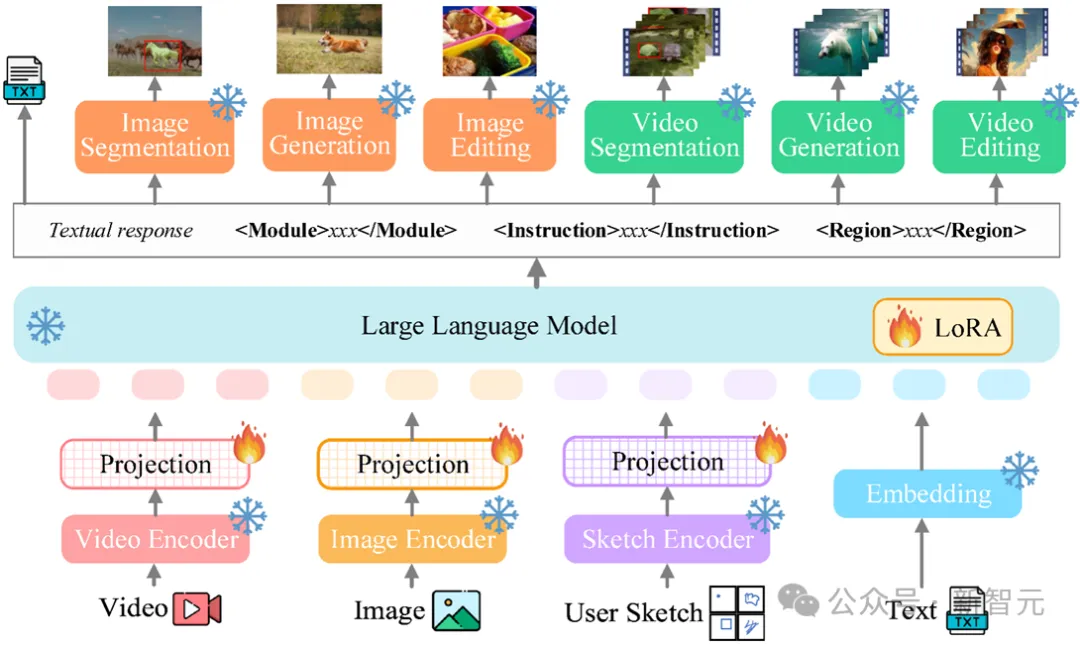

Vitron の全体的なフレームワークを次の図に示します。 Vitron は、既存の関連する MLLM と同様のアーキテクチャを採用しています。これには、1) フロントエンドのビジュアルおよび言語エンコーディング モジュール、2) 中央の LLM 理解およびテキスト生成モジュール、3) バックエンドのユーザー応答およびビジュアル コントロールのモジュール呼び出しの 3 つの主要な部分が含まれます。モジュール。

##フロントエンド モジュール: ビジュアル言語コーディング

画像とビデオのモーダル信号を認識し、きめ細かいユーザー視覚入力をサポートするために、Vitron は画像エンコーダ、ビデオ エンコーダ、領域ボックス/スケッチ エンコーダを統合しています。

センター モジュール: Core LLM

Vitron は Vicuna (7B、v1 .5) を使用します)、理解、推論、意思決定、および複数回のユーザー対話を可能にします。

バックエンド モジュール: ユーザー応答とモジュール呼び出し

Vitron はテキストを中央呼び出し戦略は、低レベルから高レベルまでの一連のビジュアル端末タスクをデコードして実行するための、いくつかの強力な既製 (SoTA) 画像およびビデオ処理モジュールを統合します。 Vitron は、テキスト中心のモジュール統合呼び出し方式を採用することで、システムの統合を実現するだけでなく、調整効率とシステムの拡張性も確保します。

上記のアーキテクチャに基づいて、Vitron はトレーニングおよび微調整され、強力な視覚的理解とタスク実行機能が提供されます。モデルのトレーニングには主に 3 つの異なる段階があります。

ステップ 1: 視覚言語による全体的な調整学習。入力された視覚言語の特徴は統一された特徴空間にマッピングされるため、入力されたマルチモーダル信号を効果的に理解できるようになります。これは、システムが入ってくる視覚信号を全体として効果的に処理できるようにする、粗粒度の視覚と言語の調整学習です。研究者らは、既存の画像とキャプションのペア (CC3M)、ビデオとキャプションのペア (Webvid)、および領域とキャプションのペア (RefCOCO) のデータセットをトレーニングに使用しました。

ステップ 2: 時空間的な視覚的位置決め命令をきめ細かく微調整します。このシステムは外部モジュールを使用してさまざまなピクセル レベルの視覚タスクを実行しますが、LLM 自体は詳細な視覚トレーニングを受けていないため、システムが真のピクセル レベルの視覚的理解を達成することが妨げられます。この目的を達成するために、研究者らは、LLM が画像の詳細な空間性とビデオの特定の時間特性を特定できるようにする、詳細な時空間位置指示の微調整トレーニングを提案しました。

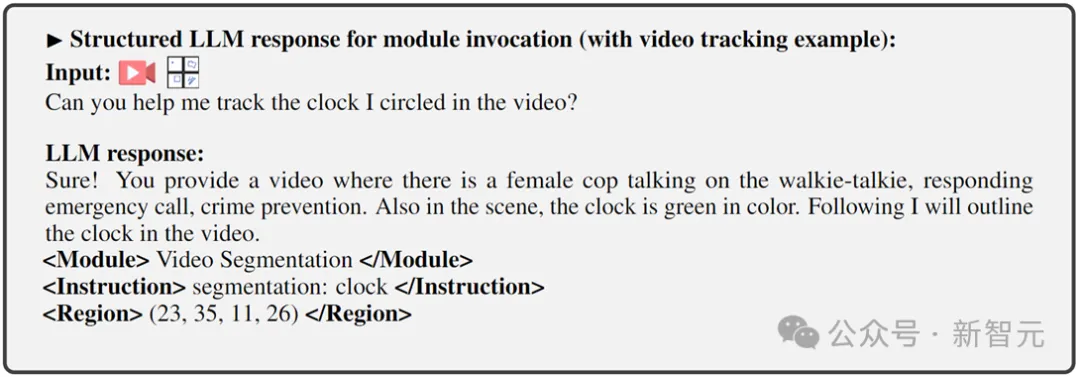

ステップ 3: 出力端はコマンド呼び出しに合わせて微調整されます。上で説明したトレーニングの第 2 段階により、LLM とフロントエンド エンコーダーにピクセル レベルで視覚を理解する能力が与えられます。この最後のステップであるコマンド呼び出しの命令微調整は、コマンドを正確に実行できる機能をシステムに装備し、LLM が適切で正しい呼び出しテキストを生成できるようにすることを目的としています。異なる端末ビジョンタスクには異なる呼び出しコマンドが必要になる可能性があるため、これを統一するために、研究者らは LLM の応答出力を次のような構造化テキスト形式に標準化することを提案しました:

1)ユーザー応答出力。ユーザー入力に直接応答します。

2) モジュール名。実行する機能またはタスクを示します。

3) コマンドを呼び出して、タスク モジュールのメタ命令をトリガーします。

4) ビデオ トラッキングやビジュアル編集など、バックエンド モジュールがこの情報を必要とする特定のタスクに必要な詳細なビジュアル機能を指定する領域 (オプションの出力)。領域の場合、LLM のピクセルレベルの理解に基づいて、座標によって記述された境界ボックスが出力されます。

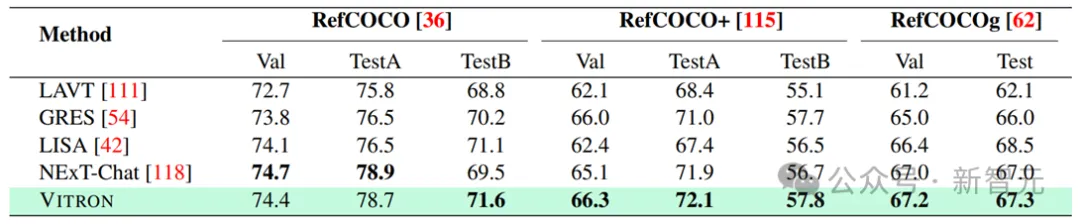

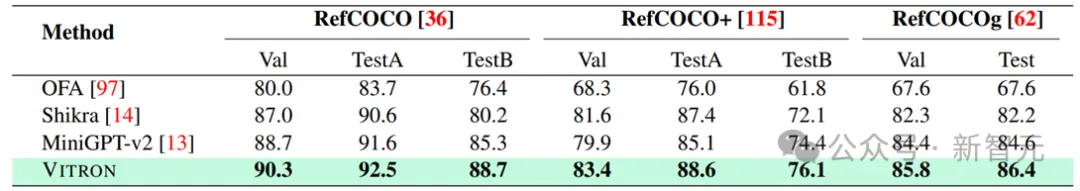

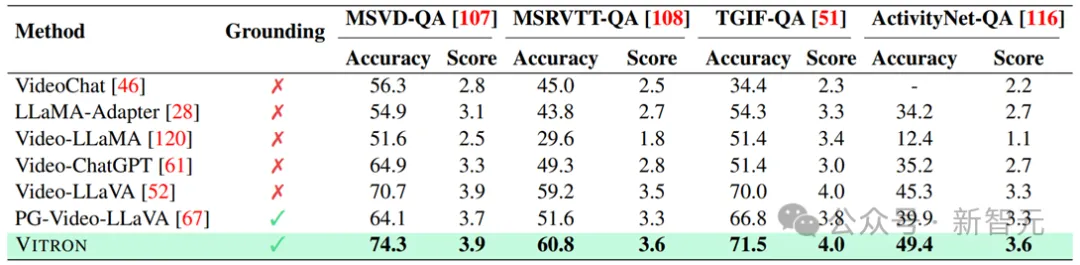

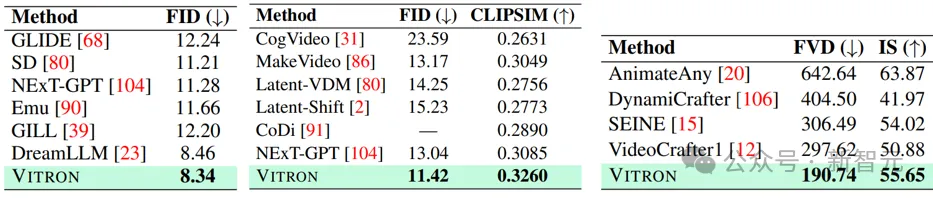

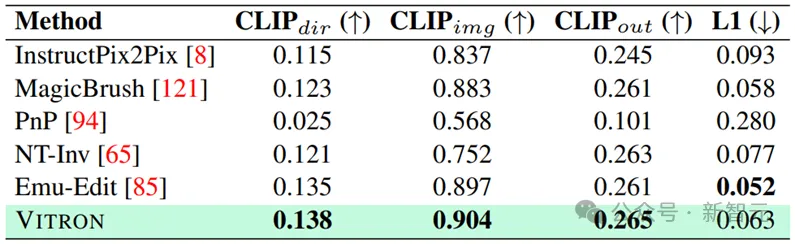

研究者は、22 の一般的なベンチマーク データ セットと 12 の画像/ビデオ ビジョン タスクに関する Vitron に基づいて、広範な実験評価を行いました。実行されました。 Vitron は、4 つの主要なビジュアル タスク グループ (セグメンテーション、理解、コンテンツ生成および編集) で強力な機能を発揮すると同時に、柔軟な人間とコンピューターの対話機能を備えています。以下は、いくつかの定性的な比較結果を代表的に示しています:

ビジョンセグメンテーション

画像参照画像セグメンテーションの結果

##詳細な視覚の理解

ビジョン生成

##テキストから画像への生成/テキストからビデオへの生成/画像からビデオへの生成

ビジョン編集

##画像編集結果

より詳細な実験内容と詳細については、論文を参照してください。

全体として、この研究は、統合された視覚マルチモーダル一般大規模モデルを開発する大きな可能性を実証し、次世代視覚大規模モデルの研究のための新たな基盤を築きます。この方向への第一歩を踏み出します。チームが提案した Vitron システムは強力な一般的な機能を示していますが、それでも独自の制限があります。以下の研究者は、将来さらに研究される可能性のあるいくつかの方向性を列挙しています。

システム アーキテクチャ

Vitron システムは、外部ツールを呼び出すために依然としてセミジョイント、セミエージェント アプローチを使用しています。 。この呼び出しベースの方法は、潜在的なモジュールの拡張と置き換えを容易にしますが、このパイプライン構造のバックエンド モジュールがフロントエンド モジュールと LLM コア モジュールの共同学習に参加しないことも意味します。

この制限は、システム全体の学習には役に立ちません。つまり、さまざまなビジュアル タスクのパフォーマンスの上限がバックエンド モジュールによって制限されることになります。将来の作業では、さまざまなビジョン タスク モジュールを 1 つのユニットに統合する必要があります。単一の生成パラダイムを通じて生成および編集機能をサポートしながら、画像とビデオの統一された理解と出力を実現することは、依然として課題です。現在、有望なアプローチは、モジュール性永続的なトークン化を組み合わせて、さまざまな入出力およびさまざまなタスクにおけるシステムの統合を向上させることです。

ユーザー対話性

単一ビジョンタスクに焦点を当てた以前のモデルとの比較 (例: 、安定した拡散とSEEM)、Vitronは、業界のOpenAIのDALL-Eシリーズ、Midjourneyなどと同様に、LLMとユーザーの間の深いインタラクションを促進することを目指しています。最適なユーザー対話性を実現することが、この作業の中心的な目標の 1 つです。

Vitron は、既存の言語ベースの LLM を活用し、適切なディレクティブ調整と組み合わせて、一定レベルの対話性を実現します。たとえば、システムは、ユーザー入力がバックエンド モジュールの条件と正確に一致する必要がなく、ユーザーが入力する予期されるメッセージに柔軟に応答し、対応する視覚的な操作結果を生成できます。ただし、この作業にはインタラクティブ性の向上という点でまだ改善の余地が多く残されています。たとえば、クローズドソースの Midjourney システムからインスピレーションを得て、LLM が各ステップでどのような決定を下しても、システムはユーザーに積極的にフィードバックを提供して、そのアクションと決定がユーザーの意図と一致していることを確認する必要があります。

モーダル機能

##現在、Vitron は 7B Vicuna モデルを統合しています。言語、画像、ビデオを理解する能力には制限があります。将来の探求の方向性としては、ビジョンをより徹底的かつ包括的に理解するためにモデルの規模を拡大するなど、包括的なエンドツーエンドのシステムを開発することが考えられます。さらに、LLM が画像とビデオのモダリティの理解を完全に統一できるようにするための努力が必要です。

以上が厳水成が担当し、「ユニバーサルビジュアルマルチモーダル大型モデル」の究極の形を確立しました。統一理解・生成・分割・編集の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。