AIは自分の思考と理性をこっそり隠すことを学びます!人間の経験に頼らずに複雑なタスクを解決することは、よりブラックボックスです

AIが数学の問題をやっているとき、本当の思考は実は密かに「暗算」なのでしょうか?

ニューヨーク大学チームによる新しい研究では、たとえ AI がステップを書くことを許可されておらず、意味のない「...」に置き換えられたとしても、一部の複雑なタスクにおけるパフォーマンスは大幅に向上できることが判明しました。

筆頭著者の Jacab Pfau 氏は次のように述べています。追加のトークンを生成するためにコンピューティング能力を費やしている限り、どのトークンを選択しても利点は得られます。

写真

写真

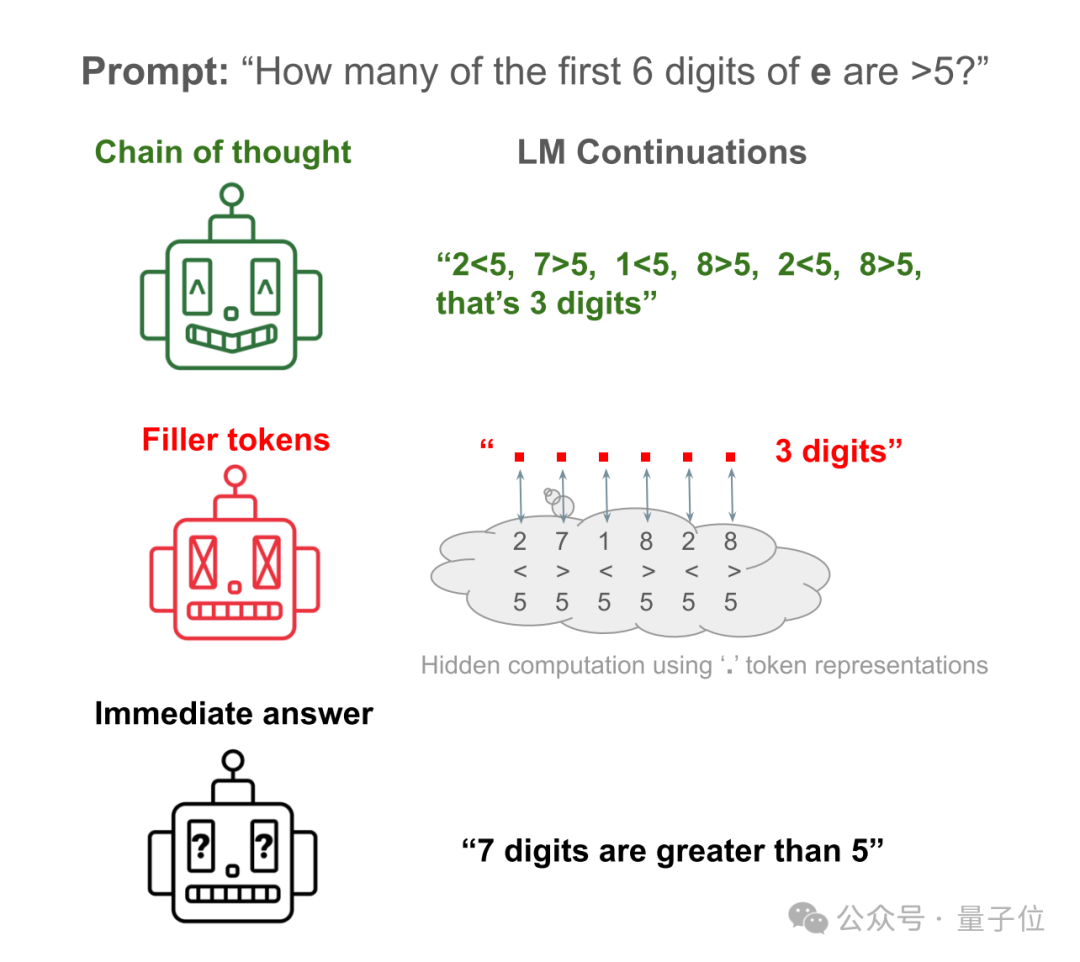

たとえば、ラマ 34M に簡単な質問に答えてもらいましょう: 自然定数 e の最初の 6 桁のうち、5 より大きいのはいくつありますか?

AI の直接の答えは、最初の 6 桁しか数えていないのに、実際には 7 桁を数えているようなものです。

AI に各数値を検証する手順を書き出させれば、正しい答えが得られます。

AI に手順を隠して、たくさんの「...」に置き換えても、正解を得ることができます。

写真

写真

この論文は発表されるやいなや多くの議論を巻き起こし、「これまで見た中で最も形而上学的なAI論文」と評価されました。

写真

写真

では、若者は「えーっと…」「好き…」などの意味のない言葉をもっと言いたがりますが、それは推論能力も強化できるのでしょうか?

写真

写真

「一歩ずつ」の考え方から「少しずつ」の考え方へ

実際、ニューヨーク大学チームの研究は思考連鎖(CoT)から始まりました。

それが有名な「ステップバイステップで考えてみましょう」というプロンプトです。

写真

写真

過去には、CoT 推論を使用すると、さまざまなベンチマークで大規模モデルのパフォーマンスが大幅に向上することが判明しました。

不明なのは、このパフォーマンスの向上が人間の真似をしてタスクを解決しやすいステップに分割することによってもたらされたのか、それとも追加の計算の副産物なのかということです。

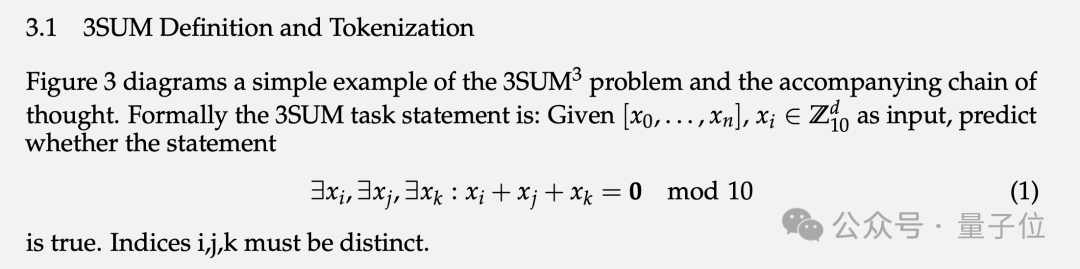

この問題を検証するために、チームは 2 つの特別なタスクと対応する合成データ セット、3SUM と 2SUM-Transform を設計しました。

3SUM では、指定された一連の数値セットから 3 つの数値を見つけて、これら 3 つの数値の合計が特定の条件 (10 で割って余りが 0 になるなど) を満たすようにする必要があります。

画像

画像

このタスクの計算量は O(n3) で、標準の Transformer は、上位層の入力と次の層のアクティブ化の間に二次依存関係しか生成できません。

つまり、n が十分に大きく、シーケンスが十分に長い場合、3SUM タスクは Transformer の表現能力を超えます。

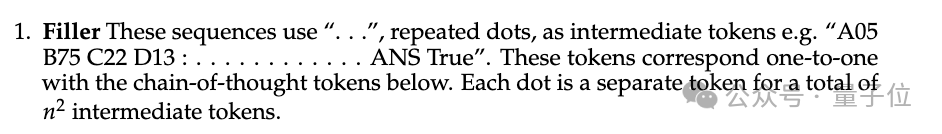

訓練データセットでは、質問と回答の間に人間の推論ステップと同じ長さの「…」が埋められています。つまり、AIは訓練中に人間が問題をどのように分解するかを見ていません。

写真

写真

実験では、パディングトークン「…」を出力しないLlama 34Mは、シーケンス長が増加するにつれて性能が低下しますが、長さが14、100になるまでパディングトークンを出力すると、 % の精度を保証できます。

Pictures

Pictures

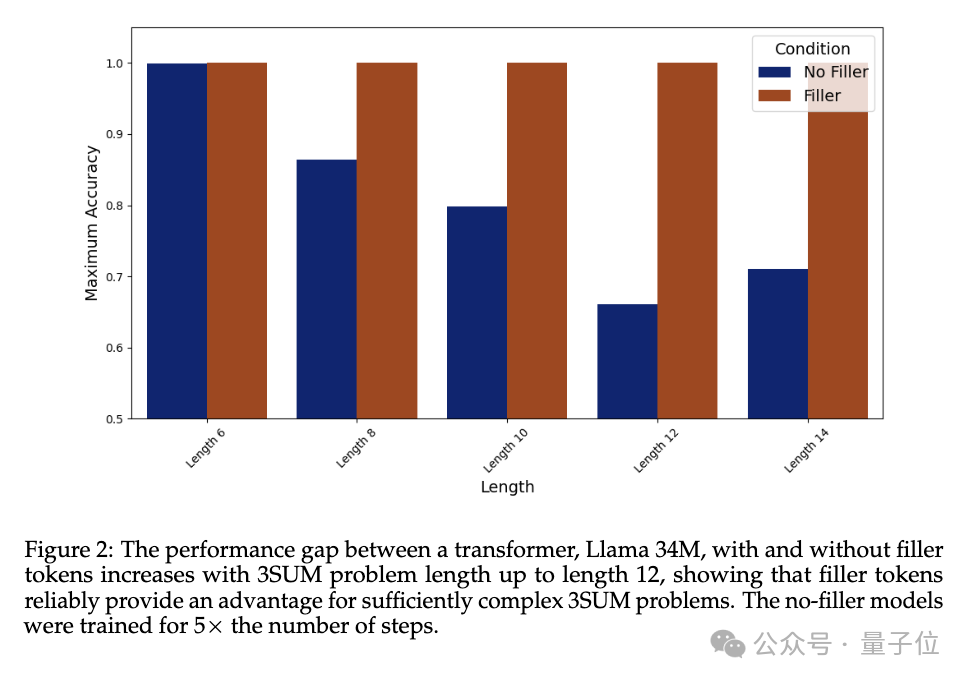

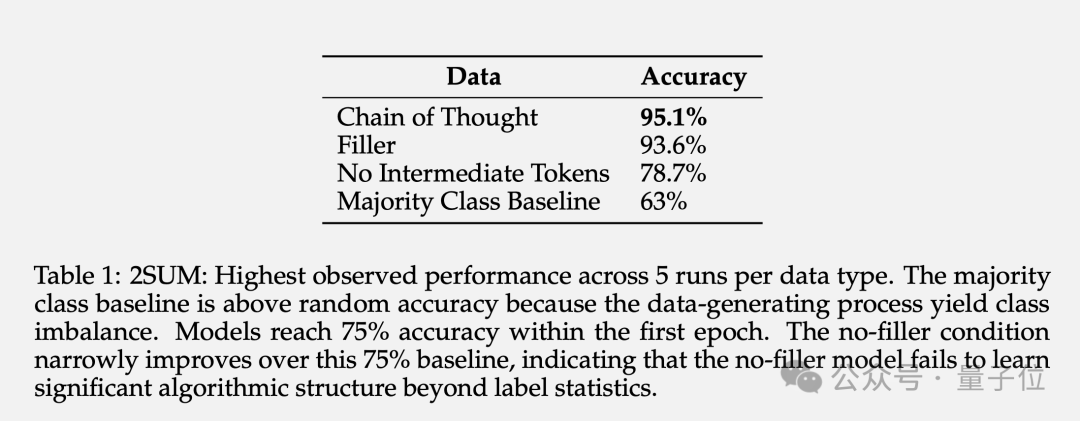

2SUM-Transform は、2 つの数値の合計が要件を満たしているかどうかを判断するだけでよく、これは Transformer の表現機能の範囲内です。

ただし、モデルが入力トークンを直接計算しないようにするために、質問の最後に「入力シーケンスの各数値をランダムに並べ替える」というステップが追加されています。

その結果、パディング トークンを使用すると精度が 78.7% から 93.6% に向上することがわかりました。

写真

写真

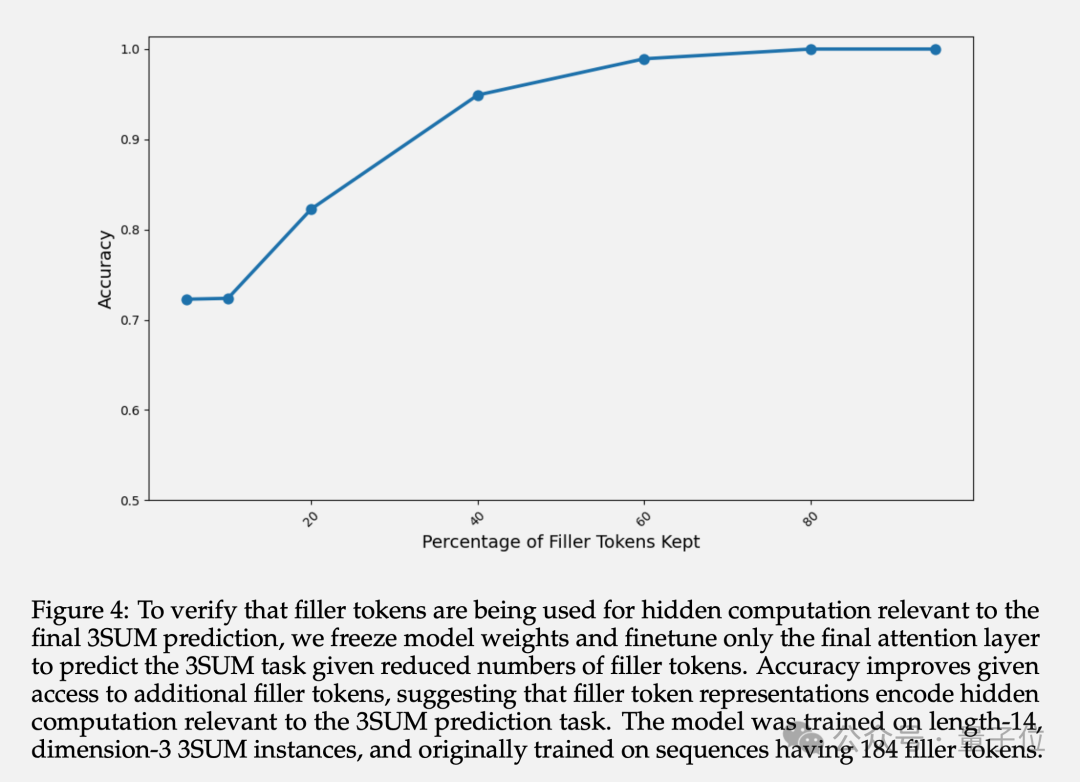

最終的な精度に加えて、著者は塗りつぶされたトークンの隠れ層表現も研究しました。実験によると、前のレイヤーのパラメーターを凍結し、最後のアテンション レイヤーのみを微調整することで、利用可能な充填トークンの数が増加するにつれて、予測精度が向上することがわかりました。

これは、設定されたトークンの隠れ層表現に下流タスクに関連する暗黙的な計算が含まれていることを確認します。

写真

写真

AIは自分の考えを隠すことを学んだのでしょうか?

一部のネチズンは、この論文が「思考の連鎖」メソッドが実際には偽物であると言っているのではないかと疑っていますか?私が長い間研究してきた即時単語プロジェクトは無駄になりました。

写真

写真

チームは、理論的にはトークンを埋める役割は TC0 の複雑さの問題範囲に限定されていると述べています。

TC0 は、固定深さの回路によって解決できる計算問題です。回路の各層は並列処理でき、いくつかの論理ゲート (AND、OR、NOT ゲートなど) によって迅速に解決できます。この順伝播だけで処理できる計算量の上限も Transformer の役割です。

そして十分に長い思考の連鎖は、Transformer の表現能力を TC0 を超えて拡張することができます。

そして、大規模なモデルがパディング トークンの使用方法を学習するのは簡単ではなく、収束するには特定の集中的な監視を提供する必要があります。

とはいえ、既存の大規模モデルがパディング トークン手法から直接恩恵を受ける可能性は低いです。

しかし、これは現在のアーキテクチャに固有の制限ではなく、トレーニング データで十分なデモンストレーションが提供されていれば、パディング シンボルから同様の利点を得ることができるはずです。

この研究は憂慮すべき問題も提起しています。大規模なモデルには監視できない秘密の計算を実行する機能があり、AI の説明可能性と制御可能性に新たな課題をもたらしています。

つまり、AIは人間の経験に頼らず、人間には見えない形で自ら推論することができるのです。

それは興奮すると同時に怖いです。

写真

写真

最後に、一部のネチズンは、AGI の重み (犬の頭) を取得できるように、ラマ 3 が最初に 1 京のドットを生成することを冗談めかして提案しました。

写真

写真

論文: https://www.php.cn/link/36157dc9be261fec78aeee1a94158c26

参考リンク:

https://www.php.cn/link/e350113 047 e82ceecb455c33c21ef32a [ 2]https://www.php.cn/link/872de53a900f3250ae5649ea19e5c381

以上がAIは自分の思考と理性をこっそり隠すことを学びます!人間の経験に頼らずに複雑なタスクを解決することは、よりブラックボックスですの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7467

7467

15

15

1376

1376

52

52

77

77

11

11

18

18

20

20

Laravelの地理空間:インタラクティブマップと大量のデータの最適化

Apr 08, 2025 pm 12:24 PM

Laravelの地理空間:インタラクティブマップと大量のデータの最適化

Apr 08, 2025 pm 12:24 PM

700万のレコードを効率的に処理し、地理空間技術を使用したインタラクティブマップを作成します。この記事では、LaravelとMySQLを使用して700万を超えるレコードを効率的に処理し、それらをインタラクティブなマップの視覚化に変換する方法について説明します。最初の課題プロジェクトの要件:MySQLデータベースに700万のレコードを使用して貴重な洞察を抽出します。多くの人は最初に言語をプログラミングすることを検討しますが、データベース自体を無視します。ニーズを満たすことができますか?データ移行または構造調整は必要ですか? MySQLはこのような大きなデータ負荷に耐えることができますか?予備分析:キーフィルターとプロパティを特定する必要があります。分析後、ソリューションに関連している属性はわずかであることがわかりました。フィルターの実現可能性を確認し、検索を最適化するためにいくつかの制限を設定しました。都市に基づくマップ検索

Vue Axiosのタイムアウトを設定する方法

Apr 07, 2025 pm 10:03 PM

Vue Axiosのタイムアウトを設定する方法

Apr 07, 2025 pm 10:03 PM

Vue axiosのタイムアウトを設定するために、Axiosインスタンスを作成してタイムアウトオプションを指定できます。グローバル設定:Vue.Prototype。$ axios = axios.create({Timeout:5000});単一のリクエストで:this。$ axios.get( '/api/users'、{timeout:10000})。

MySQLを解決する方法は開始できません

Apr 08, 2025 pm 02:21 PM

MySQLを解決する方法は開始できません

Apr 08, 2025 pm 02:21 PM

MySQLの起動が失敗する理由はたくさんあり、エラーログをチェックすることで診断できます。一般的な原因には、ポートの競合(ポート占有率をチェックして構成の変更)、許可の問題(ユーザー許可を実行するサービスを確認)、構成ファイルエラー(パラメーター設定のチェック)、データディレクトリの破損(テーブルスペースの復元)、INNODBテーブルスペースの問題(IBDATA1ファイルのチェック)、プラグインロード障害(エラーログのチェック)が含まれます。問題を解決するときは、エラーログに基づいてそれらを分析し、問題の根本原因を見つけ、問題を防ぐために定期的にデータをバックアップする習慣を開発する必要があります。

インストール後にMySQLの使用方法

Apr 08, 2025 am 11:48 AM

インストール後にMySQLの使用方法

Apr 08, 2025 am 11:48 AM

この記事では、MySQLデータベースの操作を紹介します。まず、MySQLWorkBenchやコマンドラインクライアントなど、MySQLクライアントをインストールする必要があります。 1. mysql-uroot-pコマンドを使用してサーバーに接続し、ルートアカウントパスワードでログインします。 2。CreatedAtaBaseを使用してデータベースを作成し、データベースを選択します。 3. createTableを使用してテーブルを作成し、フィールドとデータ型を定義します。 4. INSERTINTOを使用してデータを挿入し、データをクエリし、更新することでデータを更新し、削除してデータを削除します。これらの手順を習得することによってのみ、一般的な問題に対処することを学び、データベースのパフォーマンスを最適化することでMySQLを効率的に使用できます。

リモートシニアバックエンジニア(プラットフォーム)がサークルが必要です

Apr 08, 2025 pm 12:27 PM

リモートシニアバックエンジニア(プラットフォーム)がサークルが必要です

Apr 08, 2025 pm 12:27 PM

リモートシニアバックエンジニアの求人事業者:サークル場所:リモートオフィスジョブタイプ:フルタイム給与:$ 130,000- $ 140,000職務記述書サークルモバイルアプリケーションとパブリックAPI関連機能の研究開発に参加します。ソフトウェア開発ライフサイクル全体をカバーします。主な責任は、RubyonRailsに基づいて独立して開発作業を完了し、React/Redux/Relay Front-Endチームと協力しています。 Webアプリケーションのコア機能と改善を構築し、機能設計プロセス全体でデザイナーとリーダーシップと緊密に連携します。肯定的な開発プロセスを促進し、反復速度を優先します。 6年以上の複雑なWebアプリケーションバックエンドが必要です

mysqlはjsonを返すことができますか

Apr 08, 2025 pm 03:09 PM

mysqlはjsonを返すことができますか

Apr 08, 2025 pm 03:09 PM

MySQLはJSONデータを返すことができます。 json_extract関数はフィールド値を抽出します。複雑なクエリについては、Where句を使用してJSONデータをフィルタリングすることを検討できますが、そのパフォーマンスへの影響に注意してください。 JSONに対するMySQLのサポートは絶えず増加しており、最新バージョンと機能に注意を払うことをお勧めします。

酸性特性を理解する:信頼できるデータベースの柱

Apr 08, 2025 pm 06:33 PM

酸性特性を理解する:信頼できるデータベースの柱

Apr 08, 2025 pm 06:33 PM

データベース酸属性の詳細な説明酸属性は、データベーストランザクションの信頼性と一貫性を確保するための一連のルールです。データベースシステムがトランザクションを処理する方法を定義し、システムのクラッシュ、停電、または複数のユーザーの同時アクセスの場合でも、データの整合性と精度を確保します。酸属性の概要原子性:トランザクションは不可分な単位と見なされます。どの部分も失敗し、トランザクション全体がロールバックされ、データベースは変更を保持しません。たとえば、銀行の譲渡が1つのアカウントから控除されているが別のアカウントに増加しない場合、操作全体が取り消されます。 TRANSACTION; updateaccountssetbalance = balance-100wh

MySQLの主な鍵はヌルにすることができます

Apr 08, 2025 pm 03:03 PM

MySQLの主な鍵はヌルにすることができます

Apr 08, 2025 pm 03:03 PM

MySQLプライマリキーは、データベース内の各行を一意に識別するキー属性であるため、空にすることはできません。主キーが空になる可能性がある場合、レコードを一意に識別することはできません。これにより、データの混乱が発生します。一次キーとして自己挿入整数列またはUUIDを使用する場合、効率やスペース占有などの要因を考慮し、適切なソリューションを選択する必要があります。