国内のオープンソース MoE 指標が爆発的に増加: GPT-4 レベルの機能、API 価格はわずか 1%

最新の国内オープンソースMoE大型モデルは、デビュー直後から人気を集めています。

DeepSeek-V2 のパフォーマンスは GPT-4 レベルに達しますが、オープンソースで商用利用は無料で、API 価格は GPT-4-Turbo のわずか 1% です。

そのため、リリースされるとすぐに、すぐに多くの議論を引き起こしました。

写真

写真

公開されたパフォーマンス指標から判断すると、DeepSeek V2 の包括的な中国語機能は多くのオープンソース モデルを上回っています。同時に、GPT-4 Turbo や Wenkuai 4.0 などのクローズド ソース モデルも最初に含まれています。階層。

総合的な英語力もLLaMA3-70Bと同じ第一段階にあり、同じくMoEであるMixtral 8x22Bを上回っています。

知識、数学、推論、プログラミングなどでも優れたパフォーマンスを発揮します。 128K コンテキストをサポートします。

写真

写真

これらの機能は、一般ユーザーが無料で直接使用できます。クローズドベータ版が公開されており、登録後すぐに体験することができます。

Pictures

Pictures

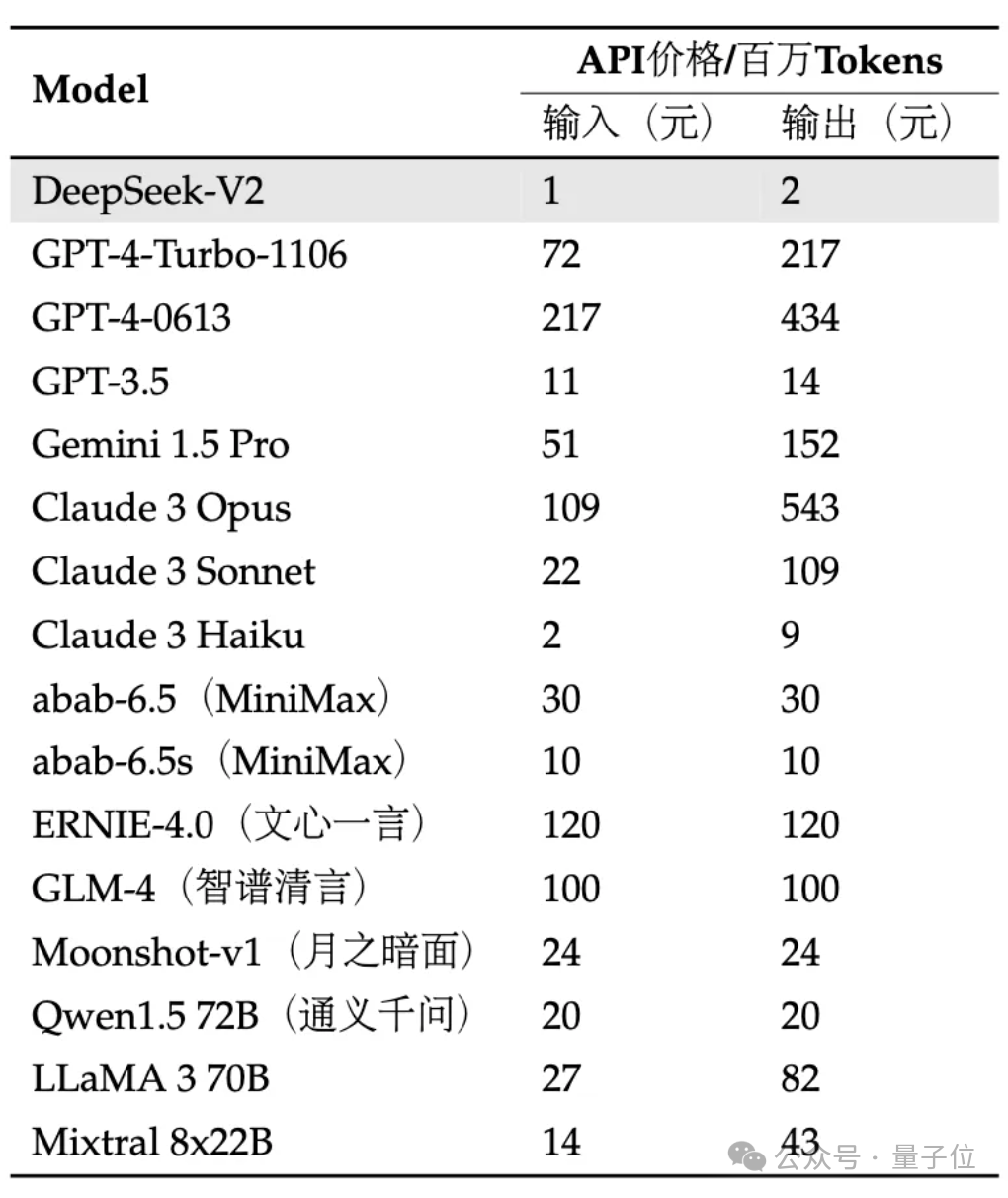

API はさらに高価です。入力は 1 元、出力は 100 万トークン (32K コンテキスト) あたり 2 元です。価格は GPT-4-Turbo のわずか 1% 近くです。

同時に、モデル アーキテクチャも革新され、自社開発の MLA (マルチヘッド潜在注意) とスパース構造を使用して、モデルの計算と推論メモリの量を大幅に削減できます。

ネチズンは嘆きました: DeepSeek は常に人々に驚きをもたらします!

写真

写真

具体的な効果をいち早く体験してきました!

実際にテストしてみよう

現在、V2 内部ベータ版ではユニバーサル ダイアログとコード アシスタントを体験できます。

写真

写真

一般的な会話で、大きなモデルの論理、知識、生成、数学、その他の能力をテストできます。

たとえば、「ジェン・フアンの伝説」のスタイルを模倣して口紅を植えるコピーライティングを書くように依頼できます。

写真

写真

は、量子もつれとは何かを一般的な方法で説明することもできます。

写真

写真

数学に関しては、次のような高度な微積分の質問に答えることができます。

微積分を使用して、自然対数の底 e の無限級数表現を証明します。

Picture

Picture

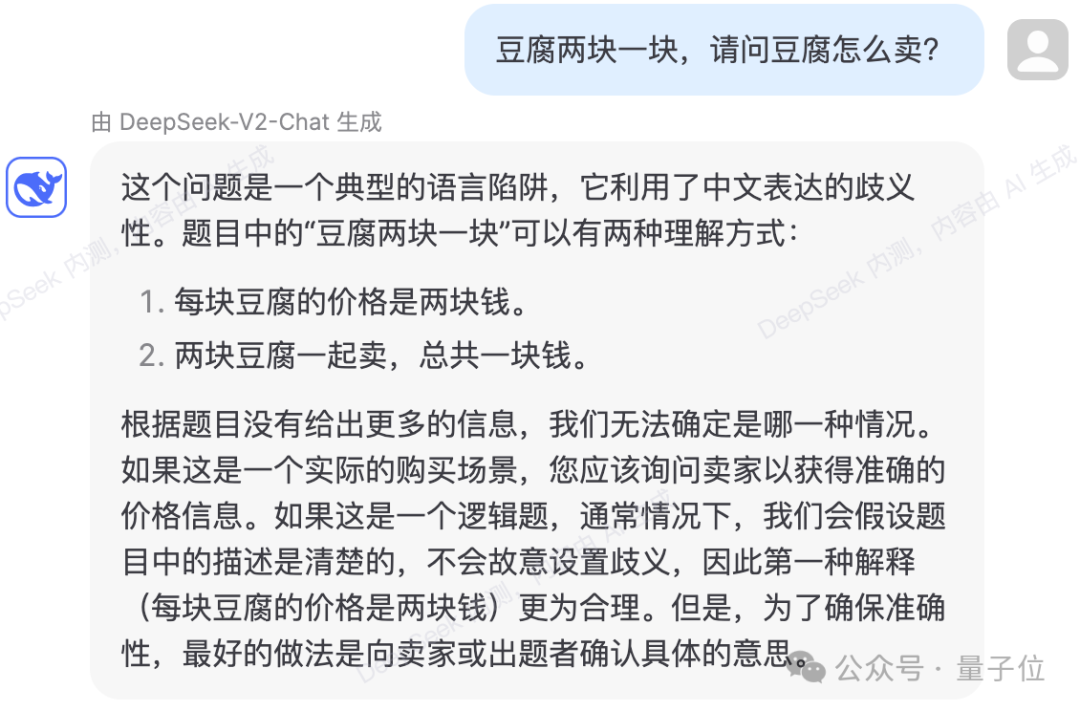

は、いくつかの言語論理の罠を回避することもできます。

写真

写真

テストにより、DeepSeek-V2 の知識コンテンツが 2023 に更新されたことがわかります。

写真

写真

コードに関しては、内部テスト ページでは、質問に答えるために DeepSeek-Coder-33B が使用されていることが示されています。

より単純なコードを生成する際、いくつかの実際のテストではエラーは発生しませんでした。

写真

写真

は、指定されたコードを説明および分析することもできます。

Pictures

Pictures

Pictures

Pictures

しかし、テストでは誤答するケースもあります。

次の論理質問では、計算プロセス中に、DeepSeek-V2 が、ろうそくの両端から同時に点火して燃え尽きるまでにかかる時間を、ろうそくが燃えるまでにかかる時間の 4 分の 1 として誤って計算しました。片端から出ます。

写真

写真

はどのようなアップグレードをもたらしますか?

公式の紹介によると、DeepSeek-V2 の合計パラメータは 236B、アクティベーションは 21B で、これはおおよそ 70B ~ 110B Dense のモデル能力に達します。

写真

写真

以前の DeepSeek 67B と比較して、パフォーマンスが向上し、トレーニング コストが 42.5% 節約され、KV キャッシュが 93.3% 削減され、最大スループットが 5.76 倍に増加します。

これは、DeepSeek-V2が消費するビデオメモリ(KVキャッシュ)が同レベルのDenseモデルの1/5~1/100に過ぎず、トークン当たりのコストが大幅に削減されることを意味すると公式に述べられています。

H800 仕様に合わせて多くの通信が最適化されており、実際には 8 カードの H800 マシンにデプロイされており、入力スループットは 1 秒あたり 100,000 トークンを超え、出力は 1 秒あたり 50,000 トークンを超えています。

Pictures

Pictures

いくつかの基本的なベンチマークでは、DeepSeek-V2 基本モデルのパフォーマンスは次のとおりです:

Pictures

Pictures

DeepSeek-V2 は革新的なアーキテクチャを採用しています。

計算メモリと推論メモリの量を大幅に削減するための MLA (マルチヘッド潜在注意) アーキテクチャを提案しました。

同時に、計算量をさらに削減するためにSparse構造を独自に開発しました。

写真

写真

これらのアップグレードはデータセンターの大規模コンピューティングに非常に役立つ可能性があると言う人もいます。

写真

写真

そして、API 価格の観点から見ると、DeepSeek-V2 は市場のすべてのスター モデルよりもほぼ低価格です。

写真

写真

チームは、DeepSeek-V2 モデルと論文も完全にオープンソースになると述べました。モデルの重量と技術レポートが提供されます。

今すぐ DeepSeek API オープン プラットフォームにログインし、登録して 1,000 万入力/500 万出力トークンをギフトとして受け取りましょう。通常お試しは完全無料です。

以上が国内のオープンソース MoE 指標が爆発的に増加: GPT-4 レベルの機能、API 価格はわずか 1%の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7488

7488

15

15

1377

1377

52

52

77

77

11

11

19

19

40

40

オープンソースのフリーテキスト注釈ツールのおすすめ 10 選

Mar 26, 2024 pm 08:20 PM

オープンソースのフリーテキスト注釈ツールのおすすめ 10 選

Mar 26, 2024 pm 08:20 PM

テキスト注釈は、テキスト内の特定のコンテンツにラベルまたはタグを対応させる作業です。その主な目的は、特に人工知能の分野で、より深い分析と処理のためにテキストに追加情報を提供することです。テキスト注釈は、人工知能アプリケーションの教師あり機械学習タスクにとって非常に重要です。これは、自然言語テキスト情報をより正確に理解し、テキスト分類、感情分析、言語翻訳などのタスクのパフォーマンスを向上させるために AI モデルをトレーニングするために使用されます。テキスト アノテーションを通じて、AI モデルにテキスト内のエンティティを認識し、コンテキストを理解し、新しい同様のデータが出現したときに正確な予測を行うように教えることができます。この記事では主に、より優れたオープンソースのテキスト注釈ツールをいくつか推奨します。 1.LabelStudiohttps://github.com/Hu

オープンソースの無料画像注釈ツールおすすめ 15 選

Mar 28, 2024 pm 01:21 PM

オープンソースの無料画像注釈ツールおすすめ 15 選

Mar 28, 2024 pm 01:21 PM

画像の注釈は、ラベルまたは説明情報を画像に関連付けて、画像の内容に深い意味と説明を与えるプロセスです。このプロセスは機械学習にとって重要であり、画像内の個々の要素をより正確に識別するために視覚モデルをトレーニングするのに役立ちます。画像に注釈を追加することで、コンピュータは画像の背後にあるセマンティクスとコンテキストを理解できるため、画像の内容を理解して分析する能力が向上します。画像アノテーションは、コンピュータ ビジョン、自然言語処理、グラフ ビジョン モデルなどの多くの分野をカバーする幅広い用途があり、車両が道路上の障害物を識別するのを支援したり、障害物の検出を支援したりするなど、幅広い用途があります。医用画像認識による病気の診断。この記事では主に、より優れたオープンソースおよび無料の画像注釈ツールをいくつか推奨します。 1.マケセンス

世界で最も強力なオープンソース MoE モデルが登場。GPT-4 に匹敵する中国語機能を備え、価格は GPT-4-Turbo のわずか 1% 近くです

May 07, 2024 pm 04:13 PM

世界で最も強力なオープンソース MoE モデルが登場。GPT-4 に匹敵する中国語機能を備え、価格は GPT-4-Turbo のわずか 1% 近くです

May 07, 2024 pm 04:13 PM

従来のコンピューティングを超える能力を備えているだけでなく、より低コストでより効率的なパフォーマンスを実現する人工知能モデルを想像してみてください。これは SF ではありません。世界で最も強力なオープンソース MoE モデルである DeepSeek-V2[1] が登場しました。 DeepSeek-V2 は、経済的なトレーニングと効率的な推論の特徴を備えた強力な専門家混合 (MoE) 言語モデルです。これは 236B のパラメータで構成されており、そのうち 21B は各マーカーをアクティブにするために使用されます。 DeepSeek67B と比較して、DeepSeek-V2 はパフォーマンスが優れていると同時に、トレーニング コストを 42.5% 節約し、KV キャッシュを 93.3% 削減し、最大生成スループットを 5.76 倍に高めます。 DeepSeek は一般的な人工知能を研究する会社です

スタンフォード大学の「バーチャルタウン」と「ウエストワールド」から着想を得た25種類のAIエージェントのソースコードが公開

Aug 11, 2023 pm 06:49 PM

スタンフォード大学の「バーチャルタウン」と「ウエストワールド」から着想を得た25種類のAIエージェントのソースコードが公開

Aug 11, 2023 pm 06:49 PM

「ウエストワールド」に慣れている視聴者は、このショーが未来の世界にある巨大なハイテク成人向けテーマパークを舞台としていることを知っています。ロボットは人間と同様の行動能力を持ち、見聞きしたものを記憶し、核となるストーリーラインを繰り返すことができます。これらのロボットは毎日リセットされ、初期状態に戻ります。スタンフォード大学の論文「Generative Agents: Interactive Simulacra of Human Behavior」の発表後、このシナリオは映画やテレビシリーズに限定されなくなりました。AI はこれを再現することに成功しました。スモールヴィルの「バーチャルタウン」のシーン》概要図用紙アドレス:https://arxiv.org/pdf/2304.03442v1.pdf

推奨: 優れた JS オープンソースの顔検出および認識プロジェクト

Apr 03, 2024 am 11:55 AM

推奨: 優れた JS オープンソースの顔検出および認識プロジェクト

Apr 03, 2024 am 11:55 AM

顔の検出および認識テクノロジーは、すでに比較的成熟しており、広く使用されているテクノロジーです。現在、最も広く使用されているインターネット アプリケーション言語は JS ですが、Web フロントエンドでの顔検出と認識の実装には、バックエンドの顔認識と比較して利点と欠点があります。利点としては、ネットワーク インタラクションの削減とリアルタイム認識により、ユーザーの待ち時間が大幅に短縮され、ユーザー エクスペリエンスが向上することが挙げられます。欠点としては、モデル サイズによって制限されるため、精度も制限されることが挙げられます。 js を使用して Web 上に顔検出を実装するにはどうすればよいですか? Web 上で顔認識を実装するには、JavaScript、HTML、CSS、WebRTC など、関連するプログラミング言語とテクノロジに精通している必要があります。同時に、関連するコンピューター ビジョンと人工知能テクノロジーを習得する必要もあります。 Web 側の設計により、次の点に注意してください。

Alibaba 7B マルチモーダル文書理解の大規模モデルが新しい SOTA を獲得

Apr 02, 2024 am 11:31 AM

Alibaba 7B マルチモーダル文書理解の大規模モデルが新しい SOTA を獲得

Apr 02, 2024 am 11:31 AM

マルチモーダル文書理解機能のための新しい SOTA!アリババの mPLUG チームは、最新のオープンソース作品 mPLUG-DocOwl1.5 をリリースしました。これは、高解像度の画像テキスト認識、一般的な文書構造の理解、指示の遵守、外部知識の導入という 4 つの主要な課題に対処するための一連のソリューションを提案しています。さっそく、その効果を見てみましょう。複雑な構造のグラフをワンクリックで認識しMarkdown形式に変換:さまざまなスタイルのグラフが利用可能:より詳細な文字認識や位置決めも簡単に対応:文書理解の詳しい説明も可能:ご存知「文書理解」 「」は現在、大規模な言語モデルの実装にとって重要なシナリオです。市場には文書の読み取りを支援する多くの製品が存在します。その中には、主にテキスト認識に OCR システムを使用し、テキスト処理に LLM と連携する製品もあります。

リリースされたばかりの!ワンクリックでアニメ風の画像を生成するオープンソース モデル

Apr 08, 2024 pm 06:01 PM

リリースされたばかりの!ワンクリックでアニメ風の画像を生成するオープンソース モデル

Apr 08, 2024 pm 06:01 PM

最新の AIGC オープンソース プロジェクト、AnimagineXL3.1 をご紹介します。このプロジェクトは、アニメをテーマにしたテキストから画像へのモデルの最新版であり、より最適化された強力なアニメ画像生成エクスペリエンスをユーザーに提供することを目的としています。 AnimagineXL3.1 では、開発チームは、モデルのパフォーマンスと機能が新たな高みに達することを保証するために、いくつかの重要な側面の最適化に重点を置きました。まず、トレーニング データを拡張して、以前のバージョンのゲーム キャラクター データだけでなく、他の多くの有名なアニメ シリーズのデータもトレーニング セットに含めました。この動きによりモデルの知識ベースが充実し、さまざまなアニメのスタイルやキャラクターをより完全に理解できるようになります。 AnimagineXL3.1 では、特別なタグと美学の新しいセットが導入されています

Llama 70B を実行するシングル カードはデュアル カードより高速、Microsoft は FP6 を A100 オープンソースに強制導入

Apr 29, 2024 pm 04:55 PM

Llama 70B を実行するシングル カードはデュアル カードより高速、Microsoft は FP6 を A100 オープンソースに強制導入

Apr 29, 2024 pm 04:55 PM

FP8 以下の浮動小数点数値化精度は、もはや H100 の「特許」ではありません。 Lao Huang は誰もが INT8/INT4 を使用できるようにしたいと考え、Microsoft DeepSpeed チームは NVIDIA からの公式サポートなしで A100 上で FP6 の実行を開始しました。テスト結果は、A100 での新しい方式 TC-FPx の FP6 量子化が INT4 に近いか、場合によってはそれよりも高速であり、後者よりも精度が高いことを示しています。これに加えて、エンドツーエンドの大規模モデルのサポートもあり、オープンソース化され、DeepSpeed などの深層学習推論フレームワークに統合されています。この結果は、大規模モデルの高速化にも即座に影響します。このフレームワークでは、シングル カードを使用して Llama を実行すると、スループットはデュアル カードのスループットの 2.65 倍になります。 1つ