合計 10000 件の関連コンテンツが見つかりました

C++ を使用した機械学習モデルのトレーニング: データの前処理からモデルの検証まで

記事の紹介:C++ での ML モデルのトレーニングには、次の手順が含まれます。 データの前処理: データの読み込み、変換、エンジニアリングを行います。モデルのトレーニング: アルゴリズムを選択し、モデルをトレーニングします。モデルの検証: データセットを分割し、パフォーマンスを評価し、モデルを調整します。これらの手順に従うことで、C++ で機械学習モデルを正常に構築、トレーニング、検証できます。

2024-06-01

コメント 0

632

バッチ サイズの意味とトレーニングへの影響 (機械学習モデルに関連)

記事の紹介:BatchSize は、トレーニング プロセス中に毎回機械学習モデルによって使用されるデータの量を指します。モデルのトレーニングとパラメーターの更新のために、大量のデータを小さなデータ バッチに分割します。このバッチ処理方法は、トレーニングの効率とメモリ使用率の向上に役立ちます。通常、トレーニング データはトレーニング用のバッチに分割され、各バッチには複数のサンプルが含まれます。バッチサイズ (batchsize) は、各バッチに含まれるサンプルの数を指します。モデルをトレーニングするとき、バッチ サイズはトレーニング プロセスに重要な影響を与えます。 1. トレーニング速度 バッチ サイズ (batchsize) は、モデルのトレーニング速度に影響します。バッチ サイズが大きいほど、各エポックでより多くのデータを同時に処理できるため、トレーニング データをより速く処理できます。

2024-01-23

コメント 0

2211

ChatGPT Python モデル トレーニング ガイド: チャットボットをカスタマイズする手順

記事の紹介:ChatGPTPython モデル トレーニング ガイド: チャット ロボットをカスタマイズするための手順の概要: 近年、NLP (自然言語処理) 技術の発展に伴い、チャット ロボットがますます注目を集めています。 OpenAI の ChatGPT は、マルチドメイン チャットボットの構築に使用できる強力な事前トレーニング済み言語モデルです。この記事では、データの準備、モデルのトレーニング、ダイアログ サンプルの生成など、Python を使用して ChatGPT モデルをトレーニングする手順を紹介します。ステップ 1: データの準備、収集、クリーニング

2023-10-24

コメント 0

1305

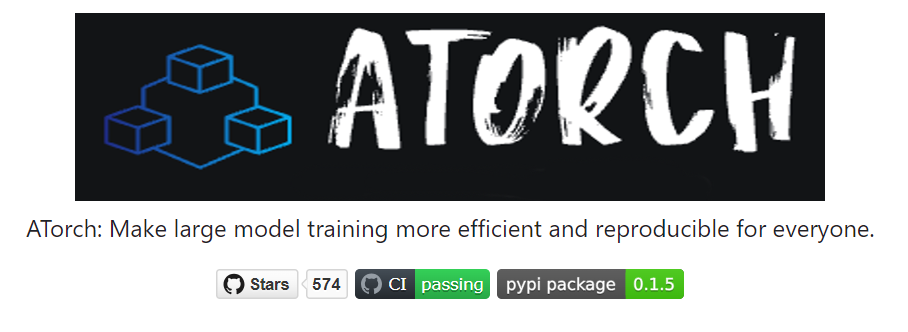

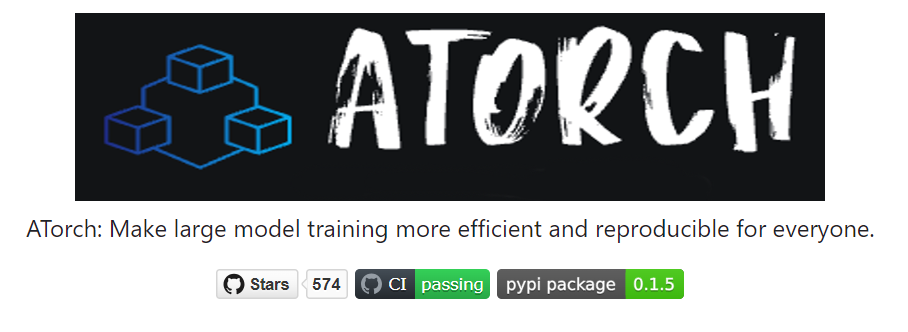

Ant のオープンソース分散トレーニング拡張ライブラリ AToch は、大規模モデル トレーニングのコンピューティング能力の 60% の有効利用率を達成

記事の紹介:Ant Group は最近、オープン ソース ツールである ATorch と呼ばれる大規模モデル分散トレーニング アクセラレーション拡張ライブラリのリリースを発表しました。 ATorch の目標は、リソースの動的最適化と分散トレーニングの安定性の向上を通じて、ディープ ラーニングのインテリジェンスを向上させることです。大規模なモデルのトレーニングにおいて、AToch は 1,000 億モデルのキロカロリー レベルのトレーニングの計算能力利用率を 60% に高めることができることがわかりました。これは、スポーツ カーに強力なエンジンを追加するのと同等です。これは、深層学習の研究者や開発者にとって、大規模なモデルをより効率的にトレーニングおよび最適化するのに役立つ重要なツールになります。図: ATorch は、大規模なモデルのトレーニングをより効率的かつ再現可能にすることに取り組んでいます。生成的な大規模モデルの爆発的な増加に伴い、モデル トレーニング用のデータ セットとパラメーターの規模は飛躍的に増加しました。

2024-01-14

コメント 0

1405

PHP マイクロサービスで分散アルゴリズムとモデル トレーニングを実装する方法

記事の紹介:PHP マイクロサービスで分散アルゴリズムとモデル トレーニングを実装する方法 はじめに: クラウド コンピューティングとビッグ データ テクノロジの急速な発展に伴い、データ処理とモデル トレーニングの需要が増加しています。分散アルゴリズムとモデルのトレーニングは、効率、速度、拡張性を達成するための鍵となります。この記事では、PHP マイクロサービスで分散アルゴリズムとモデル トレーニングを実装する方法を紹介し、いくつかの具体的なコード例を示します。 1. 分散アルゴリズムとモデル トレーニングとは何ですか? 分散アルゴリズムとモデル トレーニングは、複数のマシンまたはサーバー リソースを使用してデータ処理とモデル トレーニングを同時に実行するテクノロジーです。

2023-09-25

コメント 0

1427

PHP トレーニング モデルとは何ですか?

記事の紹介:PHP トレーニング モデルは次のとおりです: 1. 洗練された指導。一般的なモデルは、経験豊富な講師の支援のもと、午前は教室で指導し、午後は自主練習です。2. これらの PHP トレーニングには企業との実際のプロジェクトがあり、研修生は参加できます。では、雇用リソース、プロジェクト リソース、得られた教訓をお楽しみください。

2020-02-21

コメント 0

2394

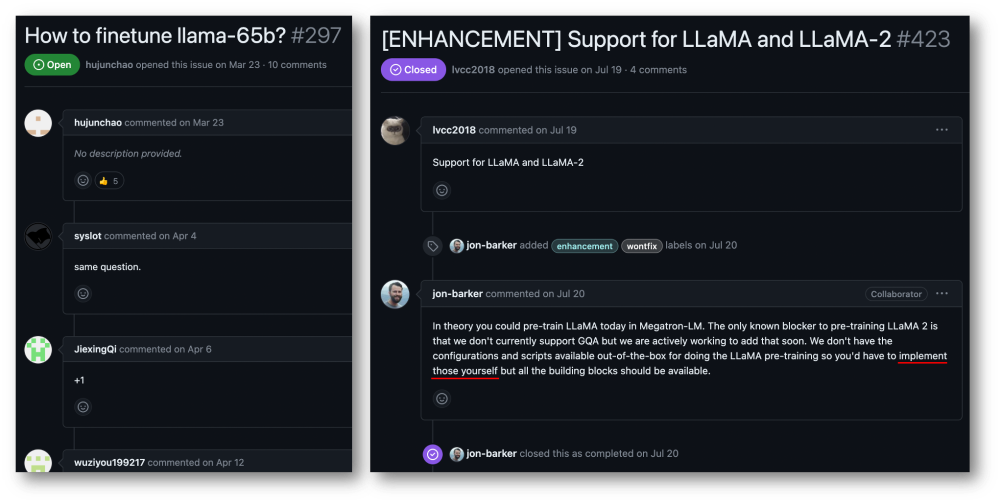

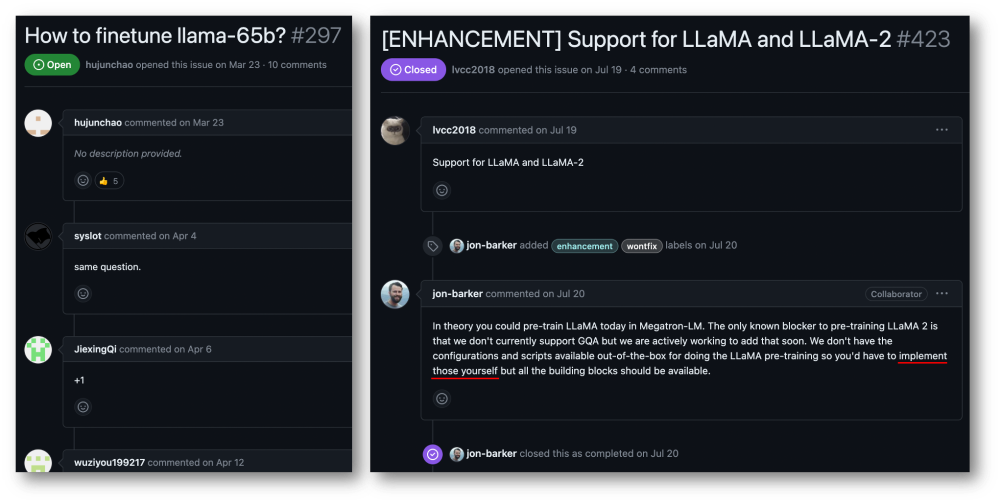

32 枚のカードで 176% トレーニングを高速化、オープンソースの大規模モデル トレーニング フレームワーク Megatron-LLaMA が登場

記事の紹介:Taotian Group と Aicheng Technology は、9 月 12 日にオープンソースの大規模モデル トレーニング フレームワーク Megatron-LLaMA を正式にリリースしました。このフレームワークの目標は、テクノロジー開発者が大規模な言語モデルのトレーニング パフォーマンスを向上させ、トレーニング コストを削減し、LLaMA コミュニティとの互換性を維持しやすくすることです。テスト結果は、32 枚のカードのトレーニングでは、Megatron-LLaMA が HuggingFace で直接取得したコード バージョンと比較して 176% の高速化を達成できることを示していますが、大規模なトレーニングでは、Megatron-LLaMA はほぼ直線的に拡張し、ネットワークに対して不安定になります。高いレベルの寛容性。現在、Megatron-LLaMA は、オープン ソース アドレス: https: のオープン ソース コミュニティで開始されています。

2023-09-14

コメント 0

613

Java フレームワークはどのように人工知能モデルのトレーニングを加速しますか?

記事の紹介:Java フレームワークは、TensorFlowServing を使用して事前トレーニングされたモデルをデプロイして高速推論を実現し、H2OAIDriverlessAI を使用してトレーニング プロセスを自動化し、SparkMLlib を使用してトレーニング時間を短縮することで、人工知能モデルのトレーニングを高速化できます。 Apache Spark アーキテクチャ上での処理を設定します。

2024-06-04

コメント 0

882

ChatGPT Python モデル トレーニング ガイド: チャットボットへの新しいスキルの注入

記事の紹介:ChatGPTPython モデル トレーニング ガイド: チャットボットに新しいスキルを導入するには、特定のコード サンプルが必要です はじめに: 近年、人工知能技術の急速な発展により、チャットボットはさまざまな分野で広く使用されています。ただし、既存のチャットボット モデルは、多くの場合、基本的な会話機能のみを提供しており、質問応答や推奨システムなど、よりインテリジェントなスキルを備えることはできません。チャットボットがより多くのスキルを備えられるようにするには、ChatGPT モデルを使用し、Python を通じてモデルをトレーニングします。

2023-10-24

コメント 0

991

JavaScript 関数を使用して機械学習モデルのトレーニングを実装する

記事の紹介:JavaScript 関数を使用して機械学習モデルのトレーニングを実装する 機械学習の急速な発展に伴い、多くの開発者は、JavaScript を使用してフロントエンドで機械学習モデルのトレーニングを実装する方法に注目し始めています。この記事では、JavaScript 関数を使用して機械学習モデルのトレーニングを実装する方法を紹介し、具体的なコード例を示します。始める前に、いくつかの重要な概念を理解する必要があります。データセット: 機械学習モデルのトレーニングには、入力として一連のラベル付きデータセットが必要です。データセットは次のもので構成されます

2023-11-03

コメント 0

1183

大規模言語モデルのトレーニングにおける転移学習アプリケーションと共通テクノロジー

記事の紹介:大規模言語モデルとは、1 億を超えるパラメーターを持つ自然言語処理モデルを指します。サイズと複雑さが非常に大きいため、このようなモデルのトレーニングには大量のコンピューティング リソースとデータが必要です。したがって、転移学習は大規模な言語モデルをトレーニングするための重要な方法となっており、既存のモデルとデータを利用することでトレーニング プロセスを高速化し、パフォーマンスを向上させることができます。転移学習では、他のタスクでトレーニングされたモデルのパラメーターと知識をターゲット タスクに転送できるため、データ要件とトレーニング時間が削減されます。このアプローチは研究と業界の両方で広く使用されており、より強力な言語モデルを構築するための基礎を築きます。転移学習は、他のタスクを解決するときに、すでにトレーニングされたモデルを使用してそのパラメーターまたは一部のコンポーネントを調整する方法です。自然言語処理の分野では、転移学習により次のことが可能になります。

2024-01-22

コメント 0

922

1,890 ドルで、12 億のパラメータ拡散モデルをゼロからトレーニングできます。

記事の紹介:わずか 1,890 ドルと 3,700 万枚の画像があれば、まともな拡散モデルをトレーニングできます。現在、視覚生成モデルは現実的な視覚コンテンツの作成に優れていますが、これらのモデルを最初からトレーニングするコストと労力は依然として高いままです。たとえば、StableDiffusion2.1 には 200,000 A100GPU 時間かかりました。研究者が最も先進的な方法を使用したとしても、8×H100 GPU でのトレーニングには 1 か月以上かかります。さらに、大規模なモデルをトレーニングすると、データセットにも課題が生じます。これらのデータは基本的に数億単位であるため、モデルのトレーニングにも課題が生じます。高いトレーニングコストとデータセット要件により、大規模な普及モデルの開発には乗り越えられない障害が生じます。 SonyAI などから

2024-07-29

コメント 0

525

YOLOv7 モデルをトレーニングし、AI 火災検知を開発する

記事の紹介:1. データ セットの準備: データ セットは、煙と火でマークされた合計 6,000 個の火災画像を含むオープン ソース画像を使用します。 Fire and Smoke プロジェクトはトレーニングに YOLO を使用しています。データを YOLO 形式に変換し、トレーニング セットと検証セットに分割しました。データセット ディレクトリを参照してください。 2. トレーニングについては、YOLOv7 公式 Web サイトのトレーニング プロセスのドキュメントを参照してください。 data/coco.yaml ファイルを変更し、トレーニング データのパスとカテゴリを構成します。事前トレーニング済みモデル yolov7.pt をダウンロードすると、トレーニングを開始できます 3. 火災監視トレーニングが完了したら、yolov7 ディレクトリの下の run ディレクトリで生成されたモデル ファイル best.pt を見つけます。私はトレーニングします

2023-05-11

コメント 0

974

Mininglamp Technology が大規模モデルの事前トレーニングを促進するために無料のオープンソース TensorBoard.cpp をリリース

記事の紹介:最近、Mininglamp Technology Group は、機械学習視覚化ツールである TensorBoard の C++ インターフェイスを実装しました。これにより、C++ に基づく大規模モデル プロジェクトのツール セットがさらに強化され、大規模モデルの事前トレーニング プロセスのモニタリングがより便利かつ効率的になります。マーケティング分野における大規模モデルの事前トレーニングのプロセスを加速します。このツールは Github 上のオープンソースです。 TensorBoard は、Google によって開発された機械学習視覚化ツールであり、機械学習プロセスのさまざまな指標を監視するためによく使用されます。 Mininglamp Technology のシニア テクニカル ディレクターである Zhao Liang 氏は次のように述べています。「大規模モデルのトレーニングのプロセスでは、データのモニタリングが重要な側面であり、TensorBoard は、大規模モデルのトレーニング中に損失の変更や検証セットを記録するなど、モデル内のさまざまなパラメーターと結果を視覚化します。モデルのトレーニング プロセス。

2023-08-14

コメント 0

794

知識の圧縮: モデルの蒸留とモデルの枝刈り

記事の紹介:モデルの蒸留と枝刈りは、パラメーターと計算の複雑さを効果的に軽減し、操作効率とパフォーマンスを向上させるニューラル ネットワーク モデル圧縮テクノロジーです。モデルの蒸留では、より大きなモデルでより小さなモデルをトレーニングし、知識を伝達することでパフォーマンスを向上させます。プルーニングは、冗長な接続とパラメーターを削除することでモデルのサイズを削減します。これら 2 つの手法は、モデルの圧縮と最適化に非常に役立ちます。モデルの蒸留 モデルの蒸留は、より小さなモデルをトレーニングすることによって、大規模なモデルの予測能力を再現する手法です。大きいモデルを「教師モデル」、小さいモデルを「生徒モデル」と呼びます。通常、教師モデルにはより多くのパラメータと複雑性があるため、トレーニング データとテスト データによりよく適合できます。モデルの蒸留では、教師モデルの予測された動作を模倣するように学生モデルがトレーニングされ、より小さなモデルでより良いパフォーマンスを実現します。

2024-01-23

コメント 0

744

ML モデルをトレーニングするための適応的な方法

記事の紹介:適応手法とは、機械学習モデルで動的調整テクノロジーを使用して、モデルの自己適応と改善を実現することを指します。これらの方法により、リアルタイムのデータと環境の変化に基づいてモデルを調整できるため、パフォーマンスが向上し、新しい状況に適応できます。一般的な適応手法には、パラメータ適応、学習率調整、特徴選択、モデル統合などがあります。これらの方法は、モデルがさまざまなタスクや環境に適応するのに役立ち、それによってモデルの精度と堅牢性が向上します。増分学習は、新しいトレーニング サンプルを継続的に導入してモデル パラメーターを更新する方法です。モデル全体を再トレーニングする場合と比較して、増分学習ではコンピューティング リソースと時間の無駄を回避できます。新しいサンプルを継続的に追加することで、モデルは新しいデータに徐々に適応し、元のパラメーターの有効性を維持しながらパフォーマンスを向上させることができます。この方法

2024-01-23

コメント 0

1120

深層学習モデルの学習時間の問題

記事の紹介:深層学習モデルのトレーニング時間問題の紹介: 深層学習の発展に伴い、深層学習モデルはさまざまな分野で目覚ましい成果を上げています。ただし、深層学習モデルのトレーニング時間は一般的な問題です。大規模なデータセットと複雑なネットワーク構造の場合、深層学習モデルのトレーニング時間は大幅に増加します。この記事では、深層学習モデルのトレーニング時間の問題について説明し、具体的なコード例を示します。並列コンピューティングによりトレーニング時間が短縮される 深層学習モデルのトレーニング プロセスには、通常、大量のコンピューティング リソースと時間が必要です。トレーニングをスピードアップするために

2023-10-09

コメント 0

1712

T5 に基づく 2 段階マルチタスク Text-to-SQL 事前トレーニング モデル MIGA

記事の紹介:事前トレーニング済み言語モデル (PLM) には豊富な知識が含まれていることが、ますます多くの研究で証明されており、さまざまなタスクに対して、適切なトレーニング方法を使用して PLM を活用することで、モデルの機能をより向上させることができます。 Text-to-SQL タスクでは、現在の主流のジェネレーターは構文ツリーに基づいており、SQL 構文用に設計する必要があります。最近、NetEase Interactive Entertainment AI Lab は広東外国語大学およびコロンビア大学と提携し、事前トレーニング済み言語モデル T5 の事前トレーニング方法に基づいた 2 段階のマルチタスク事前トレーニング モデル MIGA を提案しました。 MIGA は、事前トレーニング段階で 3 つの補助タスクを導入し、それらを統合生成タスク パラダイムに編成します。これにより、すべての Text-to-SQL データ セットを統合できます。

2023-04-13

コメント 0

1297

AI描画モデルのトレーニングから推論までWebページで行える

記事の紹介:コードの書き方がわからなくても、AI ペイント モデルをトレーニングできます。このフレームワークを利用することで、学習から推論までをワンストップで行うことができ、複数のモデルを一度に管理することができます。 Alibaba チームは、ユニバーサル画像生成ワークベンチである SCEPTERStudio を立ち上げ、オープンソース化しました。これを使用すると、コーディングせずに Web インターフェイスでモデルのトレーニングと微調整を直接完了し、関連データを管理できます。チームはまた、オンラインで SCEPTER の推論機能を体験できる、3 つの組み込みモデルを備えたデモを開始しました。それでは、SCEPTERで具体的に何ができるのか見ていきましょう!描画モデルをワンストップで管理 SCEPTER を使用すると、プログラムを作成する必要がなくなります。 Webページ上でモデルを選択しパラメータを調整するだけでトレーニングや微調整が完了します。

2024-02-19

コメント 0

1093