合計 10000 件の関連コンテンツが見つかりました

大規模言語モデルと単語埋め込みモデルの違い

記事の紹介:大規模言語モデルと単語埋め込みモデルは、自然言語処理における 2 つの重要な概念です。どちらもテキストの分析と生成に適用できますが、原理と適用シナリオは異なります。大規模な言語モデルは主に統計的モデルと確率的モデルに基づいており、連続的なテキストと意味の理解を生成するのに適しています。単語埋め込みモデルは、単語をベクトル空間にマッピングすることで単語間の意味関係を捉えることができ、単語の意味推論やテキスト分類に適しています。 1. 単語埋め込みモデル 単語埋め込みモデルは、単語を低次元のベクトル空間にマッピングすることでテキスト情報を処理する技術です。言語内の単語をベクトル形式に変換して、コンピューターがテキストをよりよく理解して処理できるようにします。一般的に使用される単語埋め込みモデルには、Word2Vec や GloVe などがあります。これらのモデルは自然言語処理タスクで広く使用されています

2024-01-23

コメント 0

1441

2023 年のベスト大規模言語モデル 6 つ

記事の紹介:今は AI の季節で、テクノロジー企業はパン屋のパンのような大規模な言語モデルを大量に生産しています。新しいモデルが急速にリリースされ、それを追い続けるのは非常に困難になってきています。しかし、新しいリリースの嵐の中で、残っているモデルはほんのわずかです

2024-06-14

コメント 0

905

大規模な言語モデルにおけるデコード戦略の適用

記事の紹介:大規模言語モデルは自然言語処理分野の重要なテクノロジーであり、さまざまなタスクで優れたパフォーマンスを発揮します。デコード戦略は、モデルによるテキスト生成の重要な側面の 1 つです。この記事では、大規模な言語モデルにおけるデコード戦略について詳しく説明し、その利点と欠点について説明します。 1. デコード戦略の概要 大規模言語モデルでは、デコード戦略はテキスト シーケンスを生成する方法です。一般的なデコード戦略には、グリーディ サーチ、ビーム サーチ、ランダム サーチなどがあります。貪欲検索は、毎回最も確率の高い単語を次の単語として選択する単純かつ単純な方法ですが、他の可能性は無視される場合があります。ビーム検索では、貪欲検索に幅制限が追加され、最も確率の高い候補単語のみが保持されるため、多様性が高まります。ランダム検索では次の単語がランダムに選択され、より多様な単語が生成されます。

2024-01-22

コメント 0

1191

大規模言語モデル (LLM) のデータ注釈方法の改善

記事の紹介:大規模言語モデル (LLM) の微調整には、ドメイン固有のデータを使用して事前トレーニングされたモデルを再トレーニングし、特定のタスクまたはドメインに適応させることが含まれます。データの注釈は微調整プロセスで重要な役割を果たし、モデルが理解する必要がある特定の情報をデータにラベル付けすることが含まれます。 1. データ アノテーションの原理 データ アノテーションは、タグやタグなどのメタデータをデータに追加することで、機械学習モデルがデータをよりよく理解して処理できるようにすることです。大規模な言語モデルを微調整する場合、データ アノテーションの原則は、モデルが特定のドメインの言語とコンテキストをよりよく理解できるようにガイド情報を提供することです。一般的なデータの注釈付け方法には、エンティティ認識、センチメント分析、関係抽出などがあります。 2. データアノテーションの手法 2.1 エンティティ認識 エンティティ認識は情報抽出の一種です

2024-01-22

コメント 0

1110

大規模な言語モデルの評価指標

記事の紹介:この記事では、大規模言語モデル (LLM) を評価するために最も広く使用されている信頼性の高い指標について検討します。この記事では、BLEU、ROUGE、METEOR、NIST などのさまざまなカテゴリのメトリクスと、それらが L のパフォーマンスを測定する方法について説明します。

2024-08-13

コメント 0

1045

大規模言語モデルのトレーニングにおける転移学習アプリケーションと共通テクノロジー

記事の紹介:大規模言語モデルとは、1 億を超えるパラメーターを持つ自然言語処理モデルを指します。サイズと複雑さが非常に大きいため、このようなモデルのトレーニングには大量のコンピューティング リソースとデータが必要です。したがって、転移学習は大規模な言語モデルをトレーニングするための重要な方法となっており、既存のモデルとデータを利用することでトレーニング プロセスを高速化し、パフォーマンスを向上させることができます。転移学習では、他のタスクでトレーニングされたモデルのパラメーターと知識をターゲット タスクに転送できるため、データ要件とトレーニング時間が削減されます。このアプローチは研究と業界の両方で広く使用されており、より強力な言語モデルを構築するための基礎を築きます。転移学習は、他のタスクを解決するときに、すでにトレーニングされたモデルを使用してそのパラメーターまたは一部のコンポーネントを調整する方法です。自然言語処理の分野では、転移学習により次のことが可能になります。

2024-01-22

コメント 0

878

NeurIPS2024 エッジ デバイス大規模言語モデル チャレンジ

記事の紹介:人工知能、特に自然言語処理 (NLP) の分野における急速な発展に伴い、大規模言語モデル (LLM) は変革の大きな可能性を示しています。これらのモデルは、私たちの仕事やコミュニケーションの方法を変え、さまざまなコンピューティング デバイスにわたる幅広いアプリケーションを示しています。しかし、LLM の巨大なモデルは、スマートフォン、IoT デバイス、車載システムなどのエッジデバイスでのアプリケーションに大きな課題をもたらします。私たちの競争は、リソースに制約のあるエッジ デバイス上での LLM のパフォーマンス、効率、およびマルチタスク機能の限界を押し上げることを目的としています。競争の背景: LLM には大きな応用可能性がありますが、その膨大なパラメーターにより、エッジ デバイスのリソースに厳しい要求が課されます。たとえば、10B パラメータの LLM モデルには次のものが必要です。

2024-08-07

コメント 0

517

人工知能における言語学: Python の言語モデル 自然言語処理

記事の紹介:自然言語処理 (NLP) は、コンピューターが自然言語を使用して効果的に通信できるようにすることに焦点を当てたコンピューター サイエンスの分野です。言語モデルは NLP で重要な役割を果たし、言語の確率分布を学習して、テキスト生成、機械翻訳、センチメント分析などのテキストに対するさまざまな処理タスクを実行できます。言語モデルのタイプ 言語モデルには主に 2 つのタイプがあります: n グラム言語モデル: 前の n 単語を考慮して次の単語の確率を予測します。n は順序と呼ばれます。ニューラル言語モデル: ニューラル ネットワークを使用して、言語の複雑な関係を学習します。 Python の言語モデル Python には、次のような言語モデルを実装できるライブラリが多数あります。 nltk.lm: N グラム言語モデルの実装を提供します。げ

2024-03-21

コメント 0

1196

LLM 大規模言語モデルと検索拡張の生成

記事の紹介:LLM の大規模言語モデルは通常、Transformer アーキテクチャを使用してトレーニングされ、大量のテキスト データを通じて自然言語を理解して生成する能力を向上させます。これらのモデルは、チャットボット、テキスト要約、機械翻訳などの分野で広く使用されています。有名な LLM 大規模言語モデルには、OpenAI の GPT シリーズや Google の BERT などがあります。自然言語処理の分野において、検索強化生成とは、検索と生成を組み合わせた技術です。大規模なテキストコーパスから関連情報を取得し、生成モデルを使用してこの情報を再結合および配置することで、要件を満たすテキストを生成します。この技術は、テキストの要約、機械翻訳、対話の生成、その他のタスクを含む幅広い用途に使用できます。検索と生成を活用した検索強化

2024-01-23

コメント 0

1208

逆の考え方: MetaMath の新しい数学的推論言語モデルが大規模モデルをトレーニングする

記事の紹介:複雑な数学的推論は、大規模な言語モデルの推論能力を評価するための重要な指標です。現在、一般的に使用されている数的推論データセットはサンプルサイズが限られており、問題の多様性が不十分であるため、大規模な言語モデルでは「逆転の呪い」現象が発生しています。つまり、「A は B である」ということについて訓練された人です。「言語モデルは、「B は A である」に一般化することはできません [1]。数学的推論タスクにおけるこの現象の具体的な形式は次のとおりです。数学的問題が与えられた場合、言語モデルは順推論を使用して問題を解決するのは得意ですが、逆推論で問題を解決する能力に欠けています。次の 2 つの例に示すように、数学の問題では逆推論が非常に一般的です。 1. 古典的な質問 - 同じ檻の中のニワトリとウサギの前向き推論: 檻の中には 23 羽の鶏と 12 羽のウサギがいます。檻の中には頭は何本、足は何本ありますか?逆推論: 同じ檻の中に数羽のニワトリとウサギがいます。上から数えると 3 羽です。

2023-10-11

コメント 0

948

大規模な言語モデルがアクティベーション関数として SwiGLU を使用するのはなぜですか?

記事の紹介:大規模な言語モデルのアーキテクチャに注目している場合は、最新のモデルや研究論文で「SwiGLU」という用語を見たことがあるかもしれません。 SwiGLUは大規模言語モデルで最もよく使われるアクティベーション関数と言えますので、この記事で詳しく紹介します。実はSwiGLUとは、2020年にGoogleが提案したSWISHとGLUの特徴を組み合わせたアクティベーション関数です。 SwiGLU の正式な中国語名は「双方向ゲート線形ユニット」で、SWISH と GLU の 2 つの活性化関数を最適化して組み合わせ、モデルの非線形表現能力を向上させます。 SWISH は大規模な言語モデルで広く使用されている非常に一般的なアクティベーション関数ですが、GLU は自然言語処理タスクで優れたパフォーマンスを示しています。

2024-04-08

コメント 0

1116

言語モデルの自己回帰特性

記事の紹介:自己回帰言語モデルは、統計的確率に基づく自然言語処理モデルです。前の単語シーケンスを利用して次の単語の確率分布を予測することにより、連続したテキスト シーケンスを生成します。このモデルは自然言語処理に非常に役立ち、言語生成、機械翻訳、音声認識などの分野で広く使用されています。履歴データを分析することで、自己回帰言語モデルは言語の法則と構造を理解して、一貫性と意味論的な正確性を備えたテキストを生成できます。これはテキストの生成に使用できるだけでなく、次の単語の予測にも使用でき、後続のテキスト処理タスクに役立つ情報を提供します。したがって、自己回帰言語モデルは、自然言語処理における重要かつ実用的な手法です。 1. 自己回帰モデルの概念. 自己回帰モデルは、以前の観察を使用して、

2024-01-22

コメント 0

683

ドキュメント内の単語が多ければ多いほど、モデルはより興奮します。 KOSMOS-2.5: 「テキスト密度の高い画像」を読み取るためのマルチモーダル大規模言語モデル

記事の紹介:現在の明らかな傾向は、印象的な言語出力を生成できる数百億、数千億のパラメーターを備えた、より大規模で複雑なモデルを構築する方向にありますが、既存の大規模言語モデルは主にテキスト情報に焦点を当てており、視覚情報を理解することができません。マルチモーダル大規模言語モデル (MLLM) の分野の進歩は、この制限に対処することを目的としています。MLLM は、視覚情報とテキスト情報を単一の Transformer ベースのモデルに融合し、モデルが両方のモダリティに基づいてコンテンツを学習および生成できるようにします。 MLLM は、自然な画像理解やテキスト画像理解など、さまざまな実用的なアプリケーションでの可能性を示しています。これらのモデルは、マルチモーダルな問題を処理するための共通インターフェイスとして言語モデリングを活用し、モデル化を可能にします。

2023-09-29

コメント 0

661

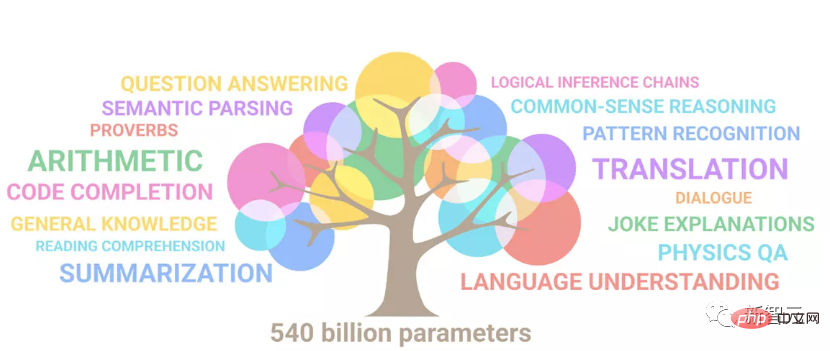

史上最大の ViT を便利にトレーニングしましたか? Google、ビジュアル言語モデルPaLIをアップグレード:100以上の言語をサポート

記事の紹介:近年の自然言語処理の進歩は主に大規模言語モデルによるものであり、新しいモデルがリリースされるたびにパラメータと学習データの量が新たな最高値に押し上げられ、同時に既存のベンチマーク ランキングが壊滅することになります。たとえば、今年 4 月に Google は、5,400 億パラメータの言語モデル PaLM (Pathways Language Model) をリリースしました。これは、一連の言語および推論テストで人間を超えることに成功し、特に数ショットの小規模サンプル学習シナリオで優れたパフォーマンスを発揮しました。 PaLM は、次世代言語モデルの開発方向であると考えられています。同様に、視覚言語モデルは実際に驚くべき働きをしており、モデルの規模を大きくすることでパフォーマンスを向上させることができます。もちろん、それが単なるマルチタスク視覚言語モデルであれば、

2023-04-12

コメント 0

1323

共通パラメータの型と機能: 大規模言語モデルのパラメータの詳細な説明

記事の紹介:大規模言語モデルとは、多数のパラメーターを含む自然言語処理モデルを指し、通常は数十億のパラメーターが含まれます。これらのパラメーターは、モデルのパフォーマンスを決定する際に重要な役割を果たします。主なパラメータとその機能を以下に紹介します。 1. 埋め込み層パラメータ 埋め込み層は、テキスト シーケンスをベクトル シーケンスに変換する重要な部分とみなされます。各単語をベクトル表現にマッピングして、モデルが単語間の意味関係を理解できるようにします。埋め込み層のパラメータの数は通常、語彙サイズ、つまり語彙内の単語の数に関係します。これらのパラメーターの役割は、後続のレベルでのより高いレベルの意味理解のために単語間の関係を学習することです。埋め込みレイヤーは、感情分析、テキスト分類、機械翻訳などの自然言語処理タスクで重要な役割を果たします。単語と単語の間に効果的に学習することで

2024-01-23

コメント 0

1536

大規模言語モデルが普及モデルを上回る!ビデオ画像生成デュアル SOTA、Google CMU の最新研究、北京大学卒業生

記事の紹介:言語モデルは拡散モデルを打ち破り、ビデオと画像の生成で 2 倍の SOTA を達成します。これは Google CMU による最新の研究結果です。レポートによると、象徴的な ImageNet ベンチマークで言語モデルが拡散モデルを破ったのはこれが初めてです。その背後にある重要なコンポーネントは、ピクセル空間入力を LLM 学習に適したトークンにマッピングするビジュアル トークナイザー (videotokenizer) です。 Google CMU 研究チームは、他の 2 つのタスクにおいて、これまで最高のビジュアル ワード セグメンタを上回った MAGVIT-v2 を提案しました。大規模な言語モデルが拡散モデルに勝つ 大規模な言語モデルがさまざまな生成分野で優れたパフォーマンスを発揮することについてはコンセンサスがあります。テキスト、オーディオ、コード生成など。しかし歴史的に、視覚生成、言語という観点から見ると、

2023-10-16

コメント 0

796

OpenHarmony で大規模な言語モデルをローカルにデプロイする

記事の紹介:この記事は、第 2 回 OpenHarmony テクノロジー カンファレンスで実証された「OpenHarmony での大規模言語モデルのローカル デプロイメント」の結果をオープンソース化します。オープンソースのアドレス: https://gitee.com/openharmony-sig/tpc_c_cplusplus/blob/master/thirdparty。 /InferLLM/docs/hap_integrate.md。実装のアイデアと手順は、軽量 LLM モデル推論フレームワーク InferLLM を OpenHarmony 標準システムに移植し、OpenHarmony 上で実行できるバイナリ製品をコンパイルすることです。 InferLLM はシンプルで効率的な L

2024-06-07

コメント 0

926

大規模な言語モデルの可能性を解き放つパフォーマンス最適化戦略

記事の紹介:この記事では、特殊なハードウェアの利用、モデルとデータの並列処理の実装、混合精度トレーニングの活用など、大規模言語モデル (LLM) の計算効率を高める革新的な方法について説明します。それはまた、

2024-08-13

コメント 0

490

MIT は、大規模な言語モデル ≠ ランダムなオウムが実際にセマンティクスを学習できることを示しています。

記事の紹介:大規模な事前トレーニング済み言語モデル (LLM) は、さまざまな下流タスクにわたってパフォーマンスが劇的に向上していることが実証されていますが、使用および生成するテキストのセマンティクスを本当に理解しているのでしょうか? AI コミュニティは、この問題に関して長年にわたって深く意見が分かれてきました。推測の 1 つは、純粋に言語の形式 (トレーニング コーパス内のトークンの条件付き分布など) に基づいてトレーニングされた言語モデルは、セマンティクスをまったく獲得しないということです。代わりに、モデルとトレーニング データのサイズに起因する強力な創発機能により、トレーニング データから収集した表面的な統計的相関関係に基づいてテキストを生成するだけです。これらの人々は LLM を「ランダム オウム」と呼んでいます。しかし、この見解に同意しない人もいます。最近の調査によると、NLP コミュニティの回答者の約 51% が、「一部の人々は、

2023-05-23

コメント 0

1015