合計 10000 件の関連コンテンツが見つかりました

Python を使用して画像上でモデルをトレーニングする方法

記事の紹介:Python を使用して画像上でモデルをトレーニングする方法の概要: コンピューター ビジョンの分野では、深層学習モデルを使用して画像の分類、ターゲット検出、その他のタスクを行うことが一般的な方法になりました。広く使用されているプログラミング言語として、Python は豊富なライブラリとツールを提供しており、画像上でモデルをトレーニングするのが比較的簡単です。この記事では、Python とその関連ライブラリを使用して画像上でモデルをトレーニングする方法と、対応するコード例を紹介します。環境の準備: 開始する前に、以下のものがインストールされていることを確認する必要があります。

2023-08-26

コメント 0

1663

深層学習モデルの学習時間の問題

記事の紹介:深層学習モデルのトレーニング時間問題の紹介: 深層学習の発展に伴い、深層学習モデルはさまざまな分野で目覚ましい成果を上げています。ただし、深層学習モデルのトレーニング時間は一般的な問題です。大規模なデータセットと複雑なネットワーク構造の場合、深層学習モデルのトレーニング時間は大幅に増加します。この記事では、深層学習モデルのトレーニング時間の問題について説明し、具体的なコード例を示します。並列コンピューティングによりトレーニング時間が短縮される 深層学習モデルのトレーニング プロセスには、通常、大量のコンピューティング リソースと時間が必要です。トレーニングをスピードアップするために

2023-10-09

コメント 0

1740

ChatGPT Python モデル トレーニング ガイド: チャットボットをカスタマイズする手順

記事の紹介:ChatGPTPython モデル トレーニング ガイド: チャット ロボットをカスタマイズするための手順の概要: 近年、NLP (自然言語処理) 技術の発展に伴い、チャット ロボットがますます注目を集めています。 OpenAI の ChatGPT は、マルチドメイン チャットボットの構築に使用できる強力な事前トレーニング済み言語モデルです。この記事では、データの準備、モデルのトレーニング、ダイアログ サンプルの生成など、Python を使用して ChatGPT モデルをトレーニングする手順を紹介します。ステップ 1: データの準備、収集、クリーニング

2023-10-24

コメント 0

1329

C++ を使用した機械学習モデルのトレーニング: データの前処理からモデルの検証まで

記事の紹介:C++ での ML モデルのトレーニングには、次の手順が含まれます。 データの前処理: データの読み込み、変換、エンジニアリングを行います。モデルのトレーニング: アルゴリズムを選択し、モデルをトレーニングします。モデルの検証: データセットを分割し、パフォーマンスを評価し、モデルを調整します。これらの手順に従うことで、C++ で機械学習モデルを正常に構築、トレーニング、検証できます。

2024-06-01

コメント 0

656

Java フレームワークはどのように人工知能モデルのトレーニングを加速しますか?

記事の紹介:Java フレームワークは、TensorFlowServing を使用して事前トレーニングされたモデルをデプロイして高速推論を実現し、H2OAIDriverlessAI を使用してトレーニング プロセスを自動化し、SparkMLlib を使用してトレーニング時間を短縮することで、人工知能モデルのトレーニングを高速化できます。 Apache Spark アーキテクチャ上での処理を設定します。

2024-06-04

コメント 0

904

データ不足がモデルトレーニングに及ぼす影響

記事の紹介:データ不足がモデル トレーニングに与える影響には、特定のコード サンプルが必要です。機械学習と人工知能の分野では、データはモデルをトレーニングするための中核要素の 1 つです。しかし、実際に私たちがよく直面する問題はデータ不足です。データ不足とは、トレーニング データの量が不足していること、またはアノテーション付きデータが不足していることを指し、この場合、モデルのトレーニングに一定の影響を及ぼします。データ不足の問題は、主に次の側面に反映されます。 過学習: トレーニング データの量が不十分な場合、モデルは過学習する傾向があります。過学習とは、モデルがトレーニング データに過剰に適応することを指します。

2023-10-08

コメント 0

1407

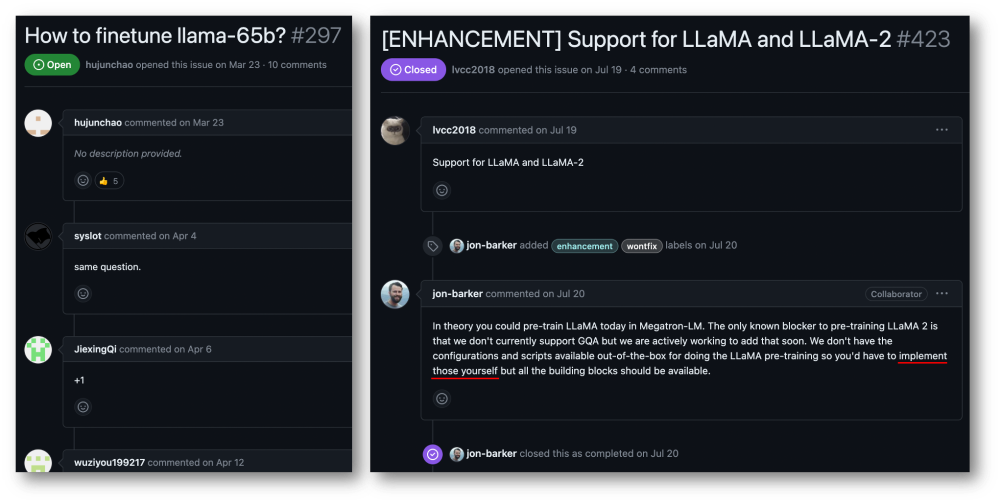

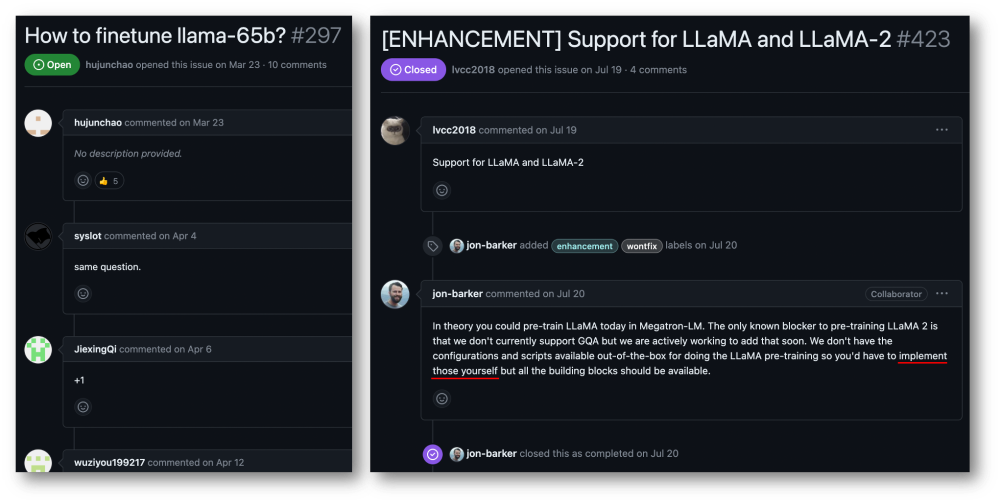

32 枚のカードで 176% トレーニングを高速化、オープンソースの大規模モデル トレーニング フレームワーク Megatron-LLaMA が登場

記事の紹介:Taotian Group と Aicheng Technology は、9 月 12 日にオープンソースの大規模モデル トレーニング フレームワーク Megatron-LLaMA を正式にリリースしました。このフレームワークの目標は、テクノロジー開発者が大規模な言語モデルのトレーニング パフォーマンスを向上させ、トレーニング コストを削減し、LLaMA コミュニティとの互換性を維持しやすくすることです。テスト結果は、32 枚のカードのトレーニングでは、Megatron-LLaMA が HuggingFace で直接取得したコード バージョンと比較して 176% の高速化を達成できることを示していますが、大規模なトレーニングでは、Megatron-LLaMA はほぼ直線的に拡張し、ネットワークに対して不安定になります。高いレベルの寛容性。現在、Megatron-LLaMA は、オープン ソース アドレス: https: のオープン ソース コミュニティで開始されています。

2023-09-14

コメント 0

633

Llama3 のトレーニングが 3 時間ごとにクラッシュしますか?ビッグビーンバッグモデルと HKU チームがサクサクの Wanka トレーニングを改善

記事の紹介:大規模なモデルの反復速度がますます高速になるにつれて、トレーニング クラスターの規模もますます大きくなり、高頻度のソフトウェアとハードウェアの障害がトレーニング効率のさらなる向上を妨げる問題点となっています。チェックポイント システムがその原因となっています。トレーニングプロセス中の状態の保存と回復は、トレーニングの失敗を克服し、トレーニングの進行を確実にし、トレーニングの効率を向上させるための鍵となっています。最近、ByteDance Beanbao モデル チームと香港大学が共同で ByteCheckpoint を提案しました。これは、PyTorch にネイティブな大規模なモデルのチェックポイント システムであり、複数のトレーニング フレームワークと互換性があり、チェックポイントの効率的な読み取りと書き込みと自動再セグメント化をサポートしています。既存の方法と比較して、大幅なパフォーマンスの向上と使いやすさの利点があります。この記事では大規模モデルのトレーニングについて紹介します

2024-08-08

コメント 0

617

PHP マイクロサービスで分散アルゴリズムとモデル トレーニングを実装する方法

記事の紹介:PHP マイクロサービスで分散アルゴリズムとモデル トレーニングを実装する方法 はじめに: クラウド コンピューティングとビッグ データ テクノロジの急速な発展に伴い、データ処理とモデル トレーニングの需要が増加しています。分散アルゴリズムとモデルのトレーニングは、効率、速度、拡張性を達成するための鍵となります。この記事では、PHP マイクロサービスで分散アルゴリズムとモデル トレーニングを実装する方法を紹介し、いくつかの具体的なコード例を示します。 1. 分散アルゴリズムとモデル トレーニングとは何ですか? 分散アルゴリズムとモデル トレーニングは、複数のマシンまたはサーバー リソースを使用してデータ処理とモデル トレーニングを同時に実行するテクノロジーです。

2023-09-25

コメント 0

1454

Ant のオープンソース分散トレーニング拡張ライブラリ AToch は、大規模モデル トレーニングのコンピューティング能力の 60% の有効利用率を達成

記事の紹介:Ant Group は最近、オープン ソース ツールである ATorch と呼ばれる大規模モデル分散トレーニング アクセラレーション拡張ライブラリのリリースを発表しました。 ATorch の目標は、リソースの動的最適化と分散トレーニングの安定性の向上を通じて、ディープ ラーニングのインテリジェンスを向上させることです。大規模なモデルのトレーニングにおいて、AToch は 1,000 億モデルのキロカロリー レベルのトレーニングの計算能力利用率を 60% に高めることができることがわかりました。これは、スポーツ カーに強力なエンジンを追加するのと同等です。これは、深層学習の研究者や開発者にとって、大規模なモデルをより効率的にトレーニングおよび最適化するのに役立つ重要なツールになります。図: ATorch は、大規模なモデルのトレーニングをより効率的かつ再現可能にすることに取り組んでいます。生成的な大規模モデルの爆発的な増加に伴い、モデル トレーニング用のデータ セットとパラメーターの規模は飛躍的に増加しました。

2024-01-14

コメント 0

1426

JavaScript 関数を使用して機械学習モデルのトレーニングを実装する

記事の紹介:JavaScript 関数を使用して機械学習モデルのトレーニングを実装する 機械学習の急速な発展に伴い、多くの開発者は、JavaScript を使用してフロントエンドで機械学習モデルのトレーニングを実装する方法に注目し始めています。この記事では、JavaScript 関数を使用して機械学習モデルのトレーニングを実装する方法を紹介し、具体的なコード例を示します。始める前に、いくつかの重要な概念を理解する必要があります。データセット: 機械学習モデルのトレーニングには、入力として一連のラベル付きデータセットが必要です。データセットは次のもので構成されます

2023-11-03

コメント 0

1192

大規模言語モデルのトレーニングにおける転移学習アプリケーションと共通テクノロジー

記事の紹介:大規模言語モデルとは、1 億を超えるパラメーターを持つ自然言語処理モデルを指します。サイズと複雑さが非常に大きいため、このようなモデルのトレーニングには大量のコンピューティング リソースとデータが必要です。したがって、転移学習は大規模な言語モデルをトレーニングするための重要な方法となっており、既存のモデルとデータを利用することでトレーニング プロセスを高速化し、パフォーマンスを向上させることができます。転移学習では、他のタスクでトレーニングされたモデルのパラメーターと知識をターゲット タスクに転送できるため、データ要件とトレーニング時間が削減されます。このアプローチは研究と業界の両方で広く使用されており、より強力な言語モデルを構築するための基礎を築きます。転移学習は、他のタスクを解決するときに、すでにトレーニングされたモデルを使用してそのパラメーターまたは一部のコンポーネントを調整する方法です。自然言語処理の分野では、転移学習により次のことが可能になります。

2024-01-22

コメント 0

934

バッチ サイズの意味とトレーニングへの影響 (機械学習モデルに関連)

記事の紹介:BatchSize は、トレーニング プロセス中に毎回機械学習モデルによって使用されるデータの量を指します。モデルのトレーニングとパラメーターの更新のために、大量のデータを小さなデータ バッチに分割します。このバッチ処理方法は、トレーニングの効率とメモリ使用率の向上に役立ちます。通常、トレーニング データはトレーニング用のバッチに分割され、各バッチには複数のサンプルが含まれます。バッチサイズ (batchsize) は、各バッチに含まれるサンプルの数を指します。モデルをトレーニングするとき、バッチ サイズはトレーニング プロセスに重要な影響を与えます。 1. トレーニング速度 バッチ サイズ (batchsize) は、モデルのトレーニング速度に影響します。バッチ サイズが大きいほど、各エポックでより多くのデータを同時に処理できるため、トレーニング データをより速く処理できます。

2024-01-23

コメント 0

2241

モデルトレーニングにおけるデータ前処理の重要性

記事の紹介:モデルトレーニングにおけるデータ前処理の重要性と具体的なコード例 はじめに: 機械学習およびディープラーニングモデルのトレーニングプロセスにおいて、データ前処理は非常に重要かつ不可欠なリンクです。データ前処理の目的は、一連の処理ステップを通じて生データをモデルのトレーニングに適した形式に変換し、モデルのパフォーマンスと精度を向上させることです。この記事の目的は、モデル トレーニングにおけるデータ前処理の重要性について説明し、一般的に使用されるデータ前処理のコード例をいくつか示すことです。 1. データ前処理の重要性 データクリーニング データクリーニングとは、

2023-10-08

コメント 0

1286

1,890 ドルで、12 億のパラメータ拡散モデルをゼロからトレーニングできます。

記事の紹介:わずか 1,890 ドルと 3,700 万枚の画像があれば、まともな拡散モデルをトレーニングできます。現在、視覚生成モデルは現実的な視覚コンテンツの作成に優れていますが、これらのモデルを最初からトレーニングするコストと労力は依然として高いままです。たとえば、StableDiffusion2.1 には 200,000 A100GPU 時間かかりました。研究者が最も先進的な方法を使用したとしても、8×H100 GPU でのトレーニングには 1 か月以上かかります。さらに、大規模なモデルをトレーニングすると、データセットにも課題が生じます。これらのデータは基本的に数億単位であるため、モデルのトレーニングにも課題が生じます。高いトレーニングコストとデータセット要件により、大規模な普及モデルの開発には乗り越えられない障害が生じます。 SonyAI などから

2024-07-29

コメント 0

537

Apple は自己回帰言語モデルを使用して画像モデルを事前トレーニングします

記事の紹介:1. 背景 GPT などの大規模モデルの出現後、nexttoken を予測する事前学習タスクである言語モデルの Transformer + 自己回帰モデリング手法が大きな成功を収めました。では、この自己回帰モデリング手法はビジュアル モデルでより良い結果を達成できるでしょうか?今回紹介する記事は、Apple が最近公開した Transformer+autoregressive pre-training をベースにしたビジュアルモデルのトレーニングに関する記事ですので、その成果を紹介させていただきます。絵用紙タイトル:ScalablePre-trainingofLargeAutoregressiveImageModels ダウンロードアドレス:https://ar

2024-01-29

コメント 0

1019