Tachyon的配置和使用入门

Tachyon是一个基于内存的分布式文件系统(项目首页:tachyon-project.org),它是AmpLab的BDAS(berkeley data analytics stack)的一个重要组成。解决了丢失cache导致的重新计算,不同app(job),甚至是不同计算框架间重复的内存使用等问题。目前Spark 1.1默

Tachyon是一个基于内存的分布式文件系统(项目首页:tachyon-project.org),它是AmpLab的BDAS(berkeley data analytics stack)的一个重要组成。解决了丢失cache导致的重新计算,不同app(job),甚至是不同计算框架间重复的内存使用等问题。目前Spark 1.1默认支持0.5的版本。

特性

Java-like File API: Tachyon的原生API和Java文件系统非常相似,提供InputStream, OutputStream等接口, 以及高效的内存映射I/O,用这些API能够获得最好的性能。

Compatibility: Tachyon 实现了Hadoop FileSystem 接口, 因此Hadoop MapReduce和Spark可以不经过任何修改就能在使用Tachyon。

Native support for raw tables: Tachyon对列存储结构的数据提供了原生的支持,用户可以将某些访问量高的列选择性地放到内存中。

Pluggable underlayer file system: Tachyon 提供memory data到底层文件系统的方法。目前支持HDFS和单点的本地文件系统。

Web UI: 用户可以通过浏览器浏览文件系统,在debug模式下,管理员可以查看文件的位置等详细信息。

Command line interaction: 用户可以使用 ./bin/tachyon tfs和 Tachyon交互,例如将文件在Tachyon和本地文件系统中拷贝。

原理简述

参考Dr.浩源 6月30日的slide。Tachyon的架构是常见的Master/Worker结构,使用Zookeeper可以构建Master的HA。由Master节点负责管理维护文件系统MetaData(使用Journal image+edit log,详见参考1),而文件数据维护在Worker节点的内存中。Worker和Master的通讯依赖于thrift。另外,底层支持用户指定文件的持久化(保存到underlyHDFS中)。

Tachyon充分利用内存,在内存中只存一份数据(没有replica复制内存数据),并将lineage的设计应用到存储层,通过异步的向Tachyon的底层文件系统做Checkpoint。当我们向Tachyon里面写入文件的时候,Tachyon会在后台异步的把这个文件给checkpoint到它的底层存储。另外,Tachyon的重算如下图,如果File Set B丢失,则需要由File Set A通过Spark Job重新得到File Set B。

Tachyon中定义了下面几种cache的类型

package tachyon.client

import java.io.IOException;

/**

* Different write types for a TachyonFile.

*/

public enum WriteType {

/**

* Write the file and must cache it.

*/

MUST_CACHE(1),

/**

* Write the file and try to cache it.

*/

TRY_CACHE(2),

/**

* Write the file synchronously to the under fs, and also try to cache it,

*/

CACHE_THROUGH(3),

/**

* Write the file synchronously to the under fs, no cache.

*/

THROUGH(4),

/**

* Write the file asynchronously to the under fs (either must cache or must through).

*/

ASYNC_THROUGH(5);

......Tachyon集群配置

下载并解压Tachyon 0.5

wget http://tachyon-project.org/downloads/tachyon-0.5.0-bin.tar.gz

tar xvfz tachyon-0.5.0-bin.tar.gz

cd tachyon-0.5.0/conf

Tachyon官方文档Configuration Settings,除了设置正确的JAVA_HOME,我们要设置的参数如下:

#Basic tachyon.home = /var/lib/spark/tachyon-0.5.0 tachyon.underfs.address = hdfs://hdp01:8020 tachyon.data.folder = /user/spark/tach_data tachyon.workers.folder = /user/spark/tach_worker # tachyon.underfs.hdfs.impl = "org.apache.hadoop.hdfs.DistributedFileSystem" #default # tachyon.max.columns = 1000 #default # tachyon.table.metadata.byte = 5242880 #default #HA tachyon.usezookeeper = true tachyon.zookeeper.address = hdp02:2181, hdp03:2181, hdp04:2181 tachyon.zookeeper.election.path = "/tach_elect" tachyon.zookeeper.leader.path = "/tach_leader" #Master # tachyon.master.journal.folder = "$TACHYON_UNDERFS_ADDRESS/user/spark/tach_journal/" #default $tachyon.home + "/journal/" tachyon.master.hostname = hdp04 # tachyon.master.port = 19998 #default # tachyon.master.web.port = 19999 #default # tachyon.master.whitelist = "/" #default #Worker # tachyon.worker.port = 29998 #default # tachyon.worker.data.port = 29999 #default tachyon.worker.memory.size = 10G #default 128M tachyon.worker.data.folder = /mnt/ramdisk #default /mnt/ramdisk #User # tachyon.user.failed.space.request.limits = 3 #default # tachyon.user.quota.unit.bytes = 8MB #default # tachyon.user.file.buffer.bytes = 1MB #default # tachyon.user.default.block.size.byte = 1GB #default # tachyon.user.remote.read.buffer.size.byte = 1MB #default

如果启用了基于ZooKeeper的master HA,除了设置underfs为分布式文件系统和zk之外,还需要设置所有master的tachyon.master.hostname为自身的地址(必须对所有worker节点可见)。根据模版,配置tachyon-env.sh.template文件,tachyon-env.sh的如下:

#!/usr/bin/env bash

# This file contains environment variables required to run Tachyon. Copy it as tachyon-env.sh and

# edit that to configure Tachyon for your site. At a minimum,

# the following variables should be set:

#

# - JAVA_HOME, to point to your JAVA installation

# - TACHYON_MASTER_ADDRESS, to bind the master to a different IP address or hostname

# - TACHYON_UNDERFS_ADDRESS, to set the under filesystem address.

# - TACHYON_WORKER_MEMORY_SIZE, to set how much memory to use (e.g. 1000mb, 2gb) per worker

# - TACHYON_RAM_FOLDER, to set where worker stores in memory data

# - TACHYON_UNDERFS_HDFS_IMPL, to set which HDFS implementation to use (e.g. com.mapr.fs.MapRFileSystem,

# org.apache.hadoop.hdfs.DistributedFileSystem)

# The following gives an example:

export TACHYON_HOME=/var/lib/spark/tachyon-0.5.0

export HADOOP_HOME=/usr/lib/hadoop

if [[ `uname -a` == Darwin* ]]; then

# Assuming Mac OS X

export JAVA_HOME=${JAVA_HOME:-$(/usr/libexec/java_home)}

export TACHYON_RAM_FOLDER=/var/lib/spark/tachyon-0.5.0

export TACHYON_JAVA_OPTS="-Djava.security.krb5.realm= -Djava.security.krb5.kdc="

else

# Assuming Linux

if [ -z "$JAVA_HOME" ]; then

export JAVA_HOME=/usr/java/latest

fi

export TACHYON_RAM_FOLDER=$TACHYON_HOME/ramdisk

fi

export JAVA="$JAVA_HOME/bin/java"

export TACHYON_MASTER_ADDRESS=hdp04

export TACHYON_UNDERFS_ADDRESS=hdfs://hdp01:8020

export TACHYON_WORKER_MEMORY_SIZE=10GB

export TACHYON_UNDERFS_HDFS_IMPL=org.apache.hadoop.hdfs.DistributedFileSystem

CONF_DIR="$( cd "$( dirname "${BASH_SOURCE[0]}" )" && pwd )"

export TACHYON_JAVA_OPTS+="

-Dlog4j.configuration=file:$CONF_DIR/log4j.properties

-Dtachyon.debug=false

-Dtachyon.underfs.address=$TACHYON_UNDERFS_ADDRESS

-Dtachyon.underfs.hdfs.impl=$TACHYON_UNDERFS_HDFS_IMPL

-Dtachyon.data.folder=$TACHYON_UNDERFS_ADDRESS/user/spark/tach_data

-Dtachyon.workers.folder=$TACHYON_UNDERFS_ADDRESS/user/spark/tach_worker

-Dtachyon.worker.memory.size=$TACHYON_WORKER_MEMORY_SIZE

-Dtachyon.worker.data.folder=$TACHYON_RAM_FOLDER/tachyonworker/

-Dtachyon.master.worker.timeout.ms=60000

-Dtachyon.master.hostname=$TACHYON_MASTER_ADDRESS

-Dtachyon.master.journal.folder=$TACHYON_UNDERFS_ADDRESS/user/spark/tach_journal/

-Dorg.apache.jasper.compiler.disablejsr199=true

-Dtachyon.usezookeeper=true

-Dtachyon.zookeeper.address=hdp02:2181,hdp03:2181,hdp04:2181

-Dtachyon.zookeeper.election.path="/tach_elect"

-Dtachyon.zookeeper.leader.path="/tach_leader"

-Djava.net.preferIPv4Stack=true

"

# Master specific parameters. Default to TACHYON_JAVA_OPTS.

export TACHYON_MASTER_JAVA_OPTS="$TACHYON_JAVA_OPTS"

# Worker specific parameters that will be shared to all workers. Default to TACHYON_JAVA_OPTS.

export TACHYON_WORKER_JAVA_OPTS="$TACHYON_JAVA_OPTS"

---------------------------------------------------------------------------------------------------------------

vim slaves

hdp01

hdp02

hdp03

hdp04第一次运行需要format

$ tachyon format ...... # Connection to hdp01... Formatting Tachyon Worker @ hdp01 Removing local data under folder: /var/lib/spark/tachyon-0.5.0/ramdisk/tachyonworker/ Connection to hdp01 closed. Connection to hdp02... Formatting Tachyon Worker @ hdp02 Removing local data under folder: /var/lib/spark/tachyon-0.5.0/ramdisk/tachyonworker/ Connection to hdp02 closed. Connection to hdp03... Formatting Tachyon Worker @ hdp03 Removing local data under folder: /var/lib/spark/tachyon-0.5.0/ramdisk/tachyonworker/ Connection to hdp03 closed. Connection to hdp04... Formatting Tachyon Worker @ hdp04 Removing local data under folder: /var/lib/spark/tachyon-0.5.0/ramdisk/tachyonworker/ Connection to hdp04 closed. ......

启动tachyon,为了让ramFS能mount,需要使用root来启动。

tachyon-start.sh all Mount Starting master @ hdp04 ... Connection to hdp04... Formatting RamFS: /var/lib/spark/tachyon-0.5.0/ramdisk (10gb) Starting worker @ hdp04 ...

打开web UI http://hdp04:19999/home, 可以看到可用内存为我们配置的TACHYON_WORKER_MEMORY_SIZE大小。

在Spark中使用Tachyon

首先在$SPARK_HOME/conf中新建core-site.xml文件

fs.tachyon.impl

tachyon.hadoop.TFS

然后$SPARK_HOME/conf/spark-env.sh中设置

export SPARK_CLASSPATH=/var/lib/spark/tachyon-0.5.0/client/target/tachyon-client-0.5.0-jar-with-dependencies.jar:$SPARK_CLASSPATH

下面在Spark程序中需要指定:

spark.tachyonStore.url

spark.tachyonStore.BaseDir

例如:

vim $SPARK_HOME/conf/spark-defaults.conf

spark.tachyonStore.url tachyon://hdp4:19998

spark.tachyonStore.baseURL /data/tach_tmp

#打开Spark-Shell,通过tachyon来加载underfs(HDFS)中的数据/user/spark/1.txt

scala> val mydata = sc.textfile("tachyon-fs://hdp04:19998/user/spark/1.txt")

scala> data.count

...

res0: Long = 52

# 以in-memory保存到tachyon,可供其他应用使用

scala> mydata.saveAsTextFile("tachyon-fs://hdp04:19998/my/1.txt")

这个文件就以in-memory file保存到tft中,可以在web UI中查看,并通过命令进行删除

tachyon tft rm /my/1.txt

#使用tachyon持久化RDD,由于之前已经设置了spark.tachyonStore.url和spark.tachyonStore.baseDir,可以直接使用spark sc的persist(StorageLevel.OFF_HEAP)来持久化,当该Spark SC结束时,RDD会被自动清理。

scala> mydata.persist(StorageLevel.OFF_HEAP)underfs和ramfs之间的数据同步

当TACHYON启动时,Tachyon不会知道已经存在的数据文件。需要使用下面的同步数据命令

$ ./bin/tachyon loadufs [TACHYON_PATH] [UNDERLYING_FILESYSTEM_PATH] [Optional EXCLUDE_PATHS]

例如:

$ tachyon loadufs tachyon://hdp04:19998 hdfs://hdp01:8020/user/spark/tach_data

第三个可选参数指的是UNDERLYING_FILESYSTEM_PATH下的这个PATH列表会除外,不加载到tfs中。

例如”tachyon;spark”表示hdfs://hdp01:8020/user/spark/tach_data下的tachyon和spark目录不会被加载。

tachyon的命令行参数

参照官方文档:http://tachyon-project.org/Command-Line-Interface.html

tachyon的命令行操作和hdfs类似,除了文件系统操作ls, lsr, mkdir, rm, mv, copyFromLocal, copyToLocal还一些工具命令cat, count(Display the number of folders and files matching the specified prefix in “path”.), tail(Print the last 1KB of the specified file to the console.), touch, fileinfo(Print the information of the blocks of a specified file.)之外,还有特有的pin和unpin命令:

command: pin

usage:pin “path”

Description:Pins the given file, such that Tachyon will never evict it from memory. If called on a folder, it recursively pins all contained files and any new files created within this folder.

command: unpin

usage: unpin “path”

Description:Unpins the given file to allow Tachyon to start evicting it again. If called on a folder, it recursively unpins all contained files and any new files created within this folder.

^o^

参考

Tachyon Docs

Tachyon架构分析和现存问题讨论

?CrazyJVM老师的Spark课程

原文地址:Tachyon的配置和使用入门, 感谢原作者分享。

핫 AI 도구

Undresser.AI Undress

사실적인 누드 사진을 만들기 위한 AI 기반 앱

AI Clothes Remover

사진에서 옷을 제거하는 온라인 AI 도구입니다.

Undress AI Tool

무료로 이미지를 벗다

Clothoff.io

AI 옷 제거제

AI Hentai Generator

AI Hentai를 무료로 생성하십시오.

인기 기사

뜨거운 도구

메모장++7.3.1

사용하기 쉬운 무료 코드 편집기

SublimeText3 중국어 버전

중국어 버전, 사용하기 매우 쉽습니다.

스튜디오 13.0.1 보내기

강력한 PHP 통합 개발 환경

드림위버 CS6

시각적 웹 개발 도구

SublimeText3 Mac 버전

신 수준의 코드 편집 소프트웨어(SublimeText3)

뜨거운 주제

7451

7451

15

15

1374

1374

52

52

77

77

11

11

40

40

19

19

14

14

9

9

시간을 투자할 가치가 있는 확산 모델 튜토리얼(Purdue University 제공)

Apr 07, 2024 am 09:01 AM

시간을 투자할 가치가 있는 확산 모델 튜토리얼(Purdue University 제공)

Apr 07, 2024 am 09:01 AM

확산은 더 잘 모방할 수 있을 뿐만 아니라 "창조"할 수도 있습니다. 확산 모델(DiffusionModel)은 이미지 생성 모델입니다. AI 분야에서 잘 알려진 GAN, VAE 알고리즘과 비교할 때 확산 모델은 먼저 이미지에 노이즈를 추가한 다음 점차적으로 노이즈를 제거하는 프로세스를 취합니다. 원본 이미지의 노이즈를 제거하고 복원하는 방법이 알고리즘의 핵심 부분입니다. 최종 알고리즘은 임의의 잡음이 있는 이미지에서 이미지를 생성할 수 있습니다. 최근 몇 년 동안 생성 AI의 경이적인 성장으로 인해 텍스트-이미지 생성, 비디오 생성 등에서 많은 흥미로운 애플리케이션이 가능해졌습니다. 이러한 생성 도구의 기본 원리는 이전 방법의 한계를 극복하는 특수 샘플링 메커니즘인 확산의 개념입니다.

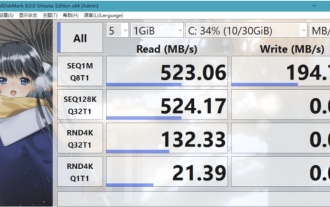

크리스탈디스크마크란 어떤 소프트웨어인가요? -크리스탈디스크마크는 어떻게 사용하나요?

Mar 18, 2024 pm 02:58 PM

크리스탈디스크마크란 어떤 소프트웨어인가요? -크리스탈디스크마크는 어떻게 사용하나요?

Mar 18, 2024 pm 02:58 PM

CrystalDiskMark는 순차 및 무작위 읽기/쓰기 속도를 빠르게 측정하는 하드 드라이브용 소형 HDD 벤치마크 도구입니다. 다음으로 편집자님에게 CrystalDiskMark 소개와 crystaldiskmark 사용법을 소개하겠습니다~ 1. CrystalDiskMark 소개 CrystalDiskMark는 기계식 하드 드라이브와 솔리드 스테이트 드라이브(SSD)의 읽기 및 쓰기 속도와 성능을 평가하는 데 널리 사용되는 디스크 성능 테스트 도구입니다. ). 무작위 I/O 성능. 무료 Windows 응용 프로그램이며 사용자 친화적인 인터페이스와 다양한 테스트 모드를 제공하여 하드 드라이브 성능의 다양한 측면을 평가하고 하드웨어 검토에 널리 사용됩니다.

클릭 한 번으로 PPT를 생성해보세요! 키미: 'PPT 이주노동자'가 먼저 대중화되게 해주세요

Aug 01, 2024 pm 03:28 PM

클릭 한 번으로 PPT를 생성해보세요! 키미: 'PPT 이주노동자'가 먼저 대중화되게 해주세요

Aug 01, 2024 pm 03:28 PM

키미: 단 한 문장이면 단 10초만에 PPT가 완성됩니다. PPT가 너무 짜증나네요! 회의를 하려면 PPT가 있어야 하고, 주간 보고서를 작성하려면 PPT가 있어야 하며, 누군가를 부정행위를 했다고 비난하려면 PPT를 보내야 합니다. 대학은 PPT 전공을 공부하는 것과 비슷합니다. 수업 시간에 PPT를 보고 수업 후에 PPT를 하는 거죠. 아마도 데니스 오스틴이 37년 전 PPT를 발명했을 때, 언젠가 PPT가 이렇게 널리 보급될 것이라고는 예상하지 못했을 것입니다. 우리가 PPT를 만들면서 힘들었던 경험을 이야기하면 눈물이 납니다. "20페이지가 넘는 PPT를 만드는 데 3개월이 걸렸고, 수십 번 수정했어요. PPT를 보면 토할 것 같았어요. 한창 때는 하루에 다섯 장씩 했는데, 숨소리까지 냈어요." PPT였어요." 즉석 회의가 있으면 해야죠.

foobar2000을 어떻게 다운로드하나요? - foobar2000 사용법

Mar 18, 2024 am 10:58 AM

foobar2000을 어떻게 다운로드하나요? - foobar2000 사용법

Mar 18, 2024 am 10:58 AM

foobar2000은 언제든지 음악 리소스를 들을 수 있는 소프트웨어입니다. 모든 종류의 음악을 무손실 음질로 제공합니다. 음악 플레이어의 향상된 버전을 사용하면 더욱 포괄적이고 편안한 음악 경험을 얻을 수 있습니다. 컴퓨터에서 고급 오디오를 재생합니다. 이 장치는 보다 편리하고 효율적인 음악 재생 경험을 제공합니다. 인터페이스 디자인은 단순하고 명확하며 사용하기 쉽습니다. 또한 다양한 스킨과 테마를 지원하고, 자신의 선호도에 따라 설정을 개인화하며, 다양한 오디오 형식의 재생을 지원하는 전용 음악 플레이어를 생성합니다. 또한 볼륨을 조정하는 오디오 게인 기능도 지원합니다. 과도한 볼륨으로 인한 청력 손상을 방지하려면 자신의 청력 상태에 따라 조정하십시오. 다음엔 내가 도와줄게

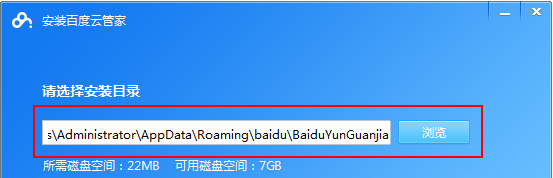

Baidu Netdisk 앱 사용 방법

Mar 27, 2024 pm 06:46 PM

Baidu Netdisk 앱 사용 방법

Mar 27, 2024 pm 06:46 PM

오늘날 클라우드 스토리지는 우리의 일상 생활과 업무에 없어서는 안 될 부분이 되었습니다. 중국 최고의 클라우드 스토리지 서비스 중 하나인 Baidu Netdisk는 강력한 스토리지 기능, 효율적인 전송 속도 및 편리한 운영 경험으로 많은 사용자의 호감을 얻었습니다. 중요한 파일을 백업하고, 정보를 공유하고, 온라인으로 비디오를 시청하고, 음악을 듣고 싶은 경우 Baidu Cloud Disk는 귀하의 요구를 충족할 수 있습니다. 그러나 많은 사용자가 Baidu Netdisk 앱의 구체적인 사용 방법을 이해하지 못할 수 있으므로 이 튜토리얼에서는 Baidu Netdisk 앱 사용 방법을 자세히 소개합니다. Baidu 클라우드 네트워크 디스크 사용 방법: 1. 설치 먼저 Baidu Cloud 소프트웨어를 다운로드하고 설치할 때 사용자 정의 설치 옵션을 선택하십시오.

NetEase 메일박스 마스터를 사용하는 방법

Mar 27, 2024 pm 05:32 PM

NetEase 메일박스 마스터를 사용하는 방법

Mar 27, 2024 pm 05:32 PM

NetEase Mailbox는 중국 네티즌들이 널리 사용하는 이메일 주소로, 안정적이고 효율적인 서비스로 항상 사용자들의 신뢰를 얻어 왔습니다. NetEase Mailbox Master는 휴대폰 사용자를 위해 특별히 제작된 이메일 소프트웨어로 이메일 보내기 및 받기 프로세스를 크게 단순화하고 이메일 처리를 더욱 편리하게 만듭니다. 따라서 NetEase Mailbox Master를 사용하는 방법과 그 기능이 무엇인지 아래에서 이 사이트의 편집자가 자세한 소개를 제공하여 도움을 드릴 것입니다! 먼저, 모바일 앱스토어에서 NetEase Mailbox Master 앱을 검색하여 다운로드하실 수 있습니다. App Store 또는 Baidu Mobile Assistant에서 "NetEase Mailbox Master"를 검색한 후 안내에 따라 설치하세요. 다운로드 및 설치가 완료되면 NetEase 이메일 계정을 열고 로그인합니다. 로그인 인터페이스는 아래와 같습니다.

Linux Bashrc 이해: 기능, 구성 및 사용법

Mar 20, 2024 pm 03:30 PM

Linux Bashrc 이해: 기능, 구성 및 사용법

Mar 20, 2024 pm 03:30 PM

Linux Bashrc 이해: 기능, 구성 및 사용법 Linux 시스템에서 Bashrc(BourneAgainShellruncommands)는 시스템 시작 시 자동으로 실행되는 다양한 명령과 설정이 포함된 매우 중요한 구성 파일입니다. Bashrc 파일은 일반적으로 사용자의 홈 디렉토리에 있으며 숨겨진 파일입니다. 해당 기능은 사용자를 위해 Bashshell 환경을 사용자 정의하는 것입니다. 1. Bashrc 기능 설정 환경

CVPR 2024 시상식 전체가 발표되었습니다! 약 10,000명이 오프라인으로 컨퍼런스에 참석했으며 Google의 중국인 연구원이 최우수 논문상을 수상했습니다.

Jun 20, 2024 pm 05:43 PM

CVPR 2024 시상식 전체가 발표되었습니다! 약 10,000명이 오프라인으로 컨퍼런스에 참석했으며 Google의 중국인 연구원이 최우수 논문상을 수상했습니다.

Jun 20, 2024 pm 05:43 PM

베이징 시간으로 6월 20일 이른 아침, 시애틀에서 열린 최고의 국제 컴퓨터 비전 컨퍼런스인 CVPR2024가 최우수 논문 및 기타 수상작을 공식 발표했습니다. 올해는 우수논문 2편, 최우수 학생논문 2편 등 총 10편의 논문이 수상하였습니다. 컴퓨터 비전(CV) 분야 최고 학회는 매년 수많은 연구기관과 대학이 모여드는 CVPR이다. 통계에 따르면 올해 총 1만1532편의 논문이 제출돼 2719편이 채택돼 합격률 23.6%를 기록했다. Georgia Institute of Technology의 CVPR2024 데이터 통계 분석에 따르면 연구 주제 관점에서 가장 많은 논문이 이미지 및 비디오 합성 및 생성입니다(Imageandvideosyn