KubeCon EU 2024에서 CNCF는 첫 번째 클라우드 네이티브 AI 백서를 출시했습니다. 이 기사는 본 백서의 내용에 대한 심층 분석을 제공합니다.

2024년 3월 KubeCon EU에서 클라우드 네이티브 컴퓨팅 재단(CNCF)은 클라우드 네이티브 인공 지능(CNAI)에 대한 첫 번째 세부 백서를 발표했습니다1. 이 보고서에서는 클라우드 네이티브 기술과 인공 지능 통합의 현재 상태, 과제 및 향후 개발 방향을 광범위하게 살펴봅니다. 이 글에서는 이 백서의 핵심 내용을 자세히 살펴보겠습니다.

이 글은 미디엄 MPP 기획서에 처음 게재되었습니다. 미디엄 유저라면 미디엄에서 저를 팔로우해주세요. 정말 감사합니다.

클라우드 네이티브 AI는 클라우드 네이티브 기술 원리를 사용하여 인공 지능 애플리케이션과 워크로드를 구축하고 배포하는 것을 의미합니다. 여기에는 마이크로서비스, 컨테이너화, 선언적 API, CI/CD(지속적 통합/지속적 배포) 등 기타 클라우드 기반 기술을 활용하여 AI 애플리케이션의 확장성, 재사용성, 운영성을 향상시키는 것이 포함됩니다.

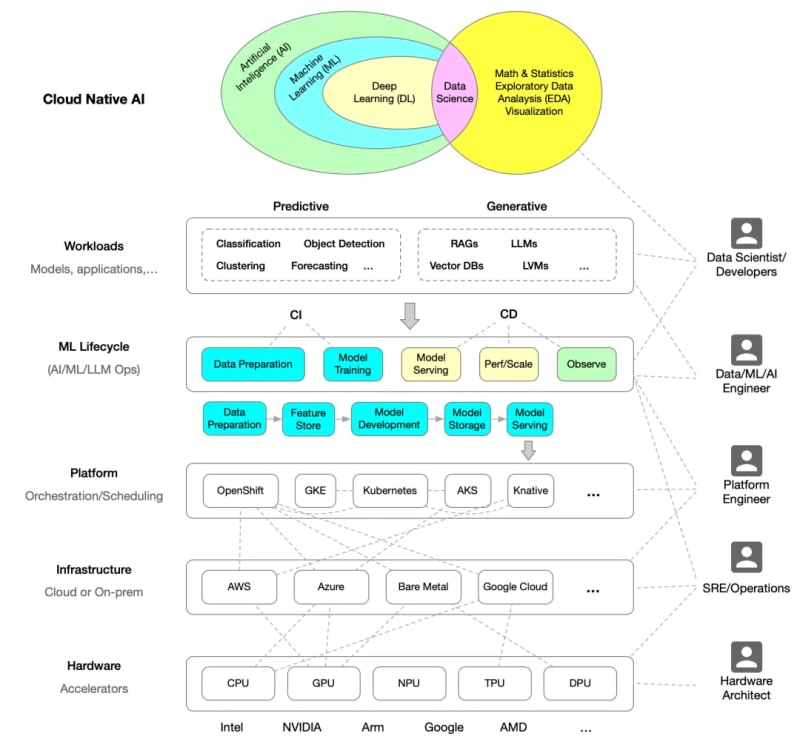

다음 다이어그램은 백서를 기반으로 다시 그린 클라우드 네이티브 AI의 아키텍처를 보여줍니다.

클라우드 네이티브 기술은 AI 애플리케이션의 개발과 운영을 더욱 효율적으로 만들어주는 유연하고 확장 가능한 플랫폼을 제공합니다. 컨테이너화 및 마이크로서비스 아키텍처를 통해 개발자는 AI 모델을 빠르게 반복하고 배포하는 동시에 시스템의 고가용성과 확장성을 보장할 수 있습니다. Kuuch는 리소스 예약, 자동 확장 및 서비스 검색입니다.

이 백서는 클라우드 네이티브 AI와 클라우드 네이티브 기술, 즉 클라우드 네이티브 인프라에서 AI를 실행하는 것 사이의 관계를 설명하는 두 가지 예를 제공합니다.

AI 애플리케이션을 위한 탄탄한 기반을 제공함에도 불구하고 AI 워크로드를 클라우드 네이티브 플랫폼과 통합하는 데는 여전히 과제가 있습니다. 이러한 과제에는 데이터 준비 복잡성, 모델 교육 리소스 요구 사항, 다중 테넌트 환경에서 모델 보안 및 격리 유지 관리가 포함됩니다. 또한 클라우드 네이티브 환경의 리소스 관리 및 예약은 대규모 AI 애플리케이션에 매우 중요하며 효율적인 모델 교육 및 추론을 지원하려면 추가 최적화가 필요합니다.

백서는 AI 워크로드를 더 잘 지원하기 위한 리소스 예약 알고리즘 개선, AI 애플리케이션의 성능과 보안을 강화하기 위한 새로운 서비스 메시 기술 개발, 클라우드 네이티브의 혁신과 표준화 촉진 등 클라우드 네이티브 AI를 위한 여러 개발 경로를 제안합니다. 오픈소스 프로젝트와 커뮤니티 협업을 통한 AI 기술.

클라우드 네이티브 AI에는 컨테이너와 마이크로서비스부터 서비스 메시와 서버리스 컴퓨팅에 이르기까지 다양한 기술이 포함됩니다. Kubernetes는 AI 애플리케이션을 배포하고 관리하는 데 중심적인 역할을 하며, Istio 및 Envoy와 같은 서비스 메시 기술은 강력한 트래픽 관리 및 보안 기능을 제공합니다. 또한 Prometheus 및 Grafana와 같은 모니터링 도구는 AI 애플리케이션의 성능과 안정성을 유지하는 데 매우 중요합니다.

아래는 백서에 제공된 Cloud-Native AI 환경도입니다.

마지막으로 다음과 같은 핵심 사항을 요약합니다.

자세한 내용은 클라우드 네이티브 AI 백서4를 다운로드하세요.

백서: ↩︎

Hugging Face는 Microsoft와 협력하여 Azure에서 Hugging Face 모델 카탈로그를 출시합니다 ↩︎

OpenAI Kubernetes를 7,500개 노드로 확장: ↩︎

클라우드 네이티브 AI 백서: ↩︎

위 내용은 CNCF의 클라우드 네이티브 AI 백서 심층 분석의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!