AIxiv 칼럼은 본 사이트에서 학술 및 기술 콘텐츠를 게재하는 칼럼입니다. 지난 몇 년 동안 이 사이트의 AIxiv 칼럼에는 전 세계 주요 대학 및 기업의 최고 연구실을 대상으로 한 2,000개 이상의 보고서가 접수되어 학술 교류 및 보급을 효과적으로 촉진하고 있습니다. 공유하고 싶은 훌륭한 작품이 있다면 자유롭게 기여하거나 보고를 위해 연락주시기 바랍니다. 제출 이메일: liyazhou@jiqizhixin.com; zhaoyunfeng@jiqizhixin.com

이 논문의 첫 번째 저자는 난카이 대학교 통계 및 데이터 과학부 석사 2년차 학생이자 그의 고문입니다. 난카이 대학교 통계 및 데이터 과학부의 Xu Jun 부교수입니다. Xu Jun 교수 팀의 연구 초점은 컴퓨터 비전, 생성 AI 및 효율적인 기계 학습이며, 4,700개 이상의 Google Scholar 인용과 함께 최고의 컨퍼런스 및 저널에 많은 논문을 발표했습니다.

대규모 Transformer 모델이 점차 다양한 분야에서 통일된 아키텍처가 되면서 미세 조정은 사전 훈련된 대형 모델을 다운스트림 작업에 적용하는 중요한 수단이 되었습니다. 그러나 모델의 크기가 나날이 증가함에 따라 미세 조정에 필요한 비디오 메모리도 점차 증가하고 있습니다. 미세 조정 비디오 메모리를 어떻게 효율적으로 줄일 것인가가 중요한 문제가 되었습니다. 이전에는 Transformer 모델을 미세 조정할 때 그래픽 메모리 오버헤드를 절약하기 위해 일반적인 접근 방식은 그라디언트 체크포인트(활성화 재계산이라고도 함)를 사용하여 훈련 속도를 희생하면서 역전파(BP) 프로세스에 필요한 시간을 줄이는 것이었습니다. . 비디오 메모리 사용을 활성화합니다.

최근 ICML 2024에서 난카이대학교 통계 및 데이터 과학부 Xu Jun 선생님 팀이 발표한 "Reducing Fine-Tuning Memory Overhead by Approximate and Memory-Sharing Backpropagation" 논문에서는 역전파를 변경하여( BP) 프로세스에서는 계산량을 늘리지 않고도 최대 활성화 메모리 사용량이 크게 줄어듭니다.

논문: 근사 및 메모리 공유 역전파를 통한 미세 조정 메모리 오버헤드 감소

논문 링크: https://arxiv.org/abs/2406.16282

프로젝트 링크: https:/ / /github.com/yyyyychen/LowMemoryBP

이 기사에서는 Approximate Backpropagation(Approx-BP)과 Memory-Sharing Backpropagation(MS-BP)이라는 두 가지 역전파 개선 전략을 제안합니다. Approx-BP와 MS-BP는 각각 역전파에서 메모리 효율성을 향상시키는 두 가지 솔루션을 나타내며, 이를 통칭하여 LowMemoryBP라고 합니다. 이론적이든 실제적이든 관계없이 이 기사는 보다 효율적인 역전파 훈련을 위한 획기적인 지침을 제공합니다.

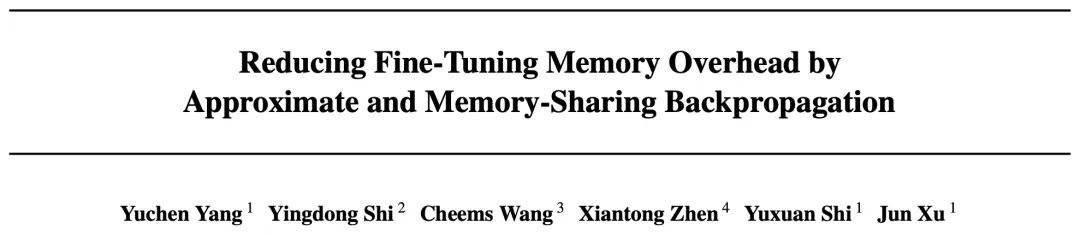

이론적 메모리 분석에서 LowMemoryBP는 활성화 함수 및 정규화 레이어에서 활성화 메모리 사용량을 크게 줄일 수 있습니다. ViT 및 LLaMA를 예로 들면 ViT를 미세 조정하면 활성화 메모리를 39.47%까지 줄일 수 있고 LLaMA를 미세 조정하면 활성화를 줄일 수 있습니다. 29.19%.

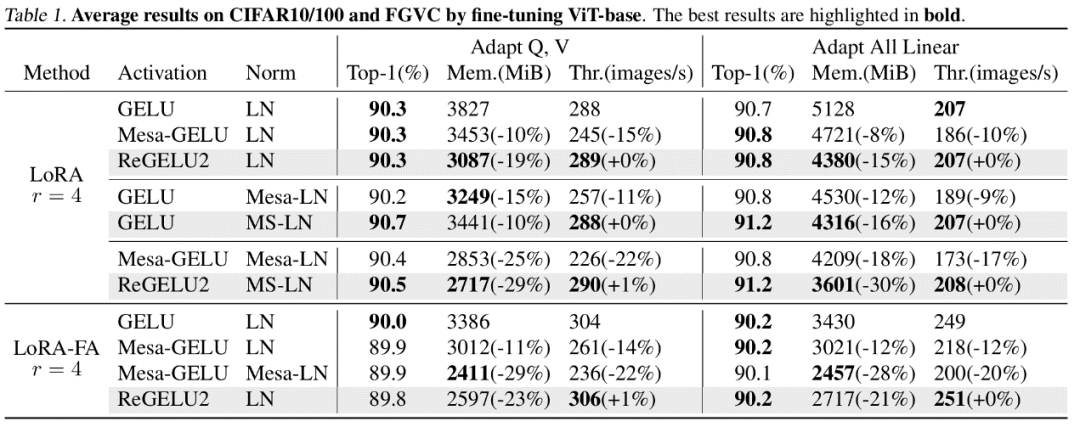

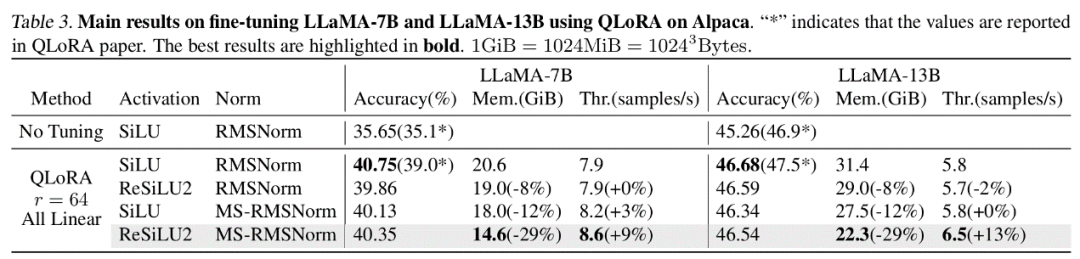

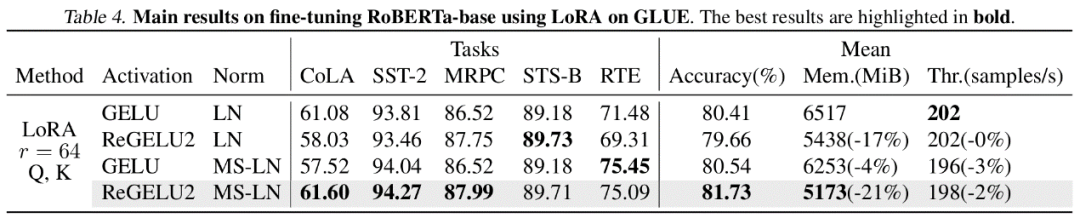

실제 실험에서 LowMemoryBP는 ViT, LLaMA, RoBERTa, BERT 및 Swin을 포함한 Transformer 모델 미세 조정의 최대 메모리 사용량을 20%~30% 효과적으로 줄일 수 있으며 훈련 처리량과 손실은 증가하지 않습니다. 테스트 정확도.

Approx-BP

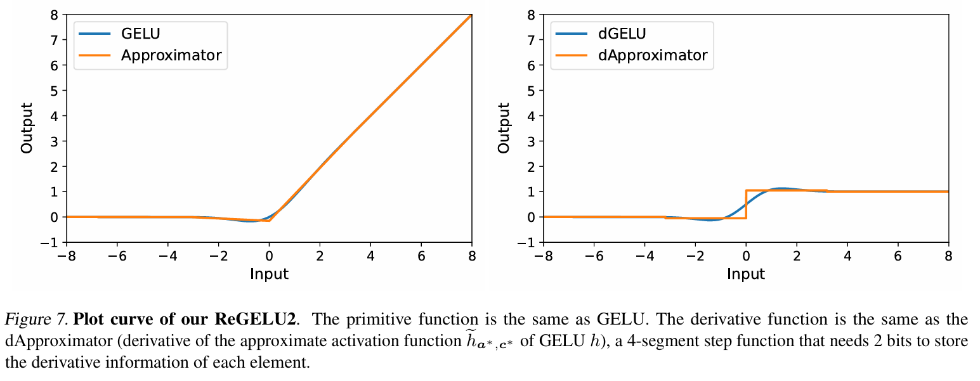

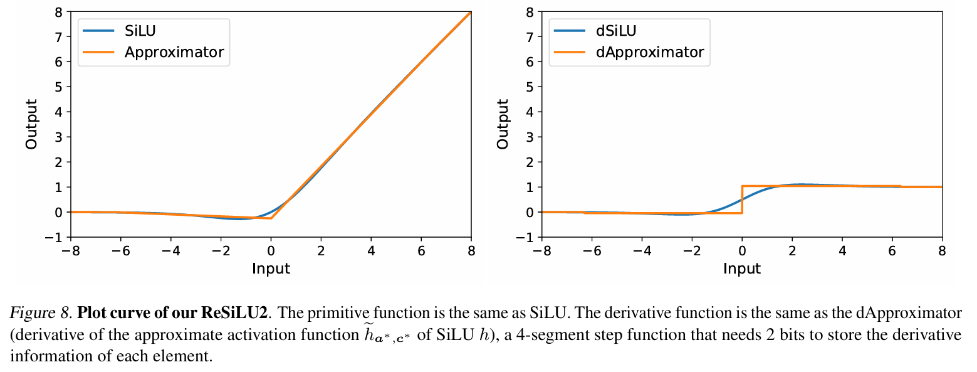

기존 역전파 훈련에서 활성화 함수의 기울기 역전파는 Transformer 모델에서 일반적으로 사용되는 GELU 및 SiLU 함수의 경우 입력이 다음과 같아야 함을 의미합니다. be 기능 텐서는 활성 비디오 메모리에 완전히 저장됩니다. 이 기사의 저자는 일련의 역전파 근사 이론, 즉 Approx-BP 이론을 제안했습니다. 이 이론에 따라 저자는 조각 선형 함수를 사용하여 활성화 함수를 근사화하고 GELU/SiLU 그라데이션의 역전파를 조각 선형 함수(계단 함수)의 도함수로 대체합니다. 이 접근 방식은 ReGELU2 및 ReSiLU2라는 두 가지 비대칭 메모리 효율적인 활성화 함수로 이어집니다. 이러한 유형의 활성화 함수는 역방향 패스백을 위해 4단계 단계 함수를 사용하므로 활성화 저장소는 2비트 데이터 유형만 사용하면 됩니다.

MS-BP

BP 네트워크의 각 계층은 일반적으로 역전파 계산을 위해 입력 텐서를 활성화 메모리에 저장합니다. 저자는 특정 레이어의 역전파를 출력 종속 형식으로 다시 작성할 수 있다면 이 레이어와 후속 레이어가 동일한 활성화 텐서를 공유할 수 있으므로 활성화 저장의 중복이 줄어들 수 있다고 지적합니다.

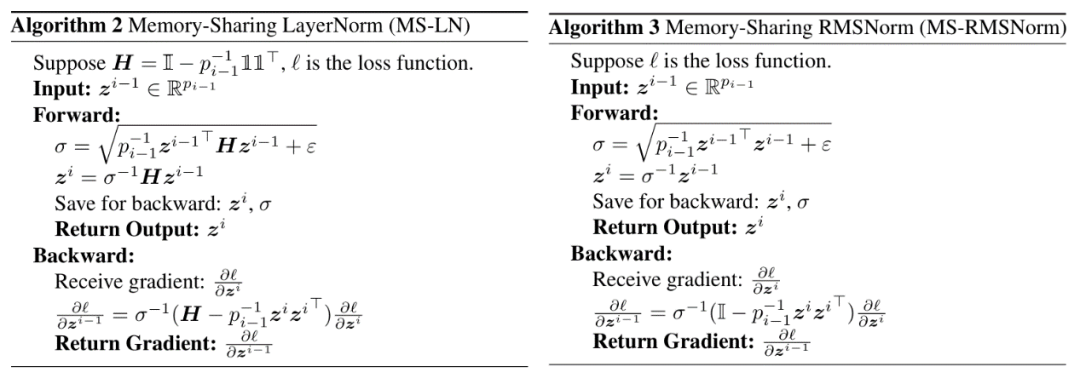

기사에서는 Transformer 모델에서 흔히 사용되는 LayerNorm과 RMSNorm이 후자 레이어의 선형 레이어에 아핀 매개변수를 병합한 후 MS-BP 전략의 요구 사항을 잘 충족할 수 있다고 지적합니다. 재설계된 MS-LayerNorm 및 MS-RMSNorm은 더 이상 독립적인 활성 그래픽 메모리를 생성하지 않습니다.

실험 결과

저자는 컴퓨터 비전과 자연어 처리 분야의 여러 대표 모델을 대상으로 미세 조정 실험을 진행했습니다. 그 중 ViT, LLaMA, RoBERTa의 미세 조정 실험에서 기사에서 제안한 방법은 훈련 효과와 훈련 속도의 손실 없이 최대 메모리 사용량을 각각 27%, 29%, 21% 줄였습니다. 비교 Mesa(8비트 활성화 압축 훈련 방법)는 훈련 속도를 약 20% 감소시키는 반면, 기사에서 제안한 LowMemoryBP 방법은 훈련 속도를 완전히 유지합니다.

결론과 의의

기사에서 제안한 두 가지 혈압 개선 전략인 Approx-BP와 MS-BP는 모두 훈련 효과와 훈련을 유지하면서 비디오 메모리 활성화를 달성합니다. 속도가 크게 절약됩니다. 이는 BP 원칙을 기반으로 한 최적화가 매우 유망한 메모리 절약 솔루션임을 의미합니다. 또한 기사에서 제안된 Approx-BP 이론은 기존 신경망의 최적화 프레임워크를 깨고 짝이 없는 파생 상품을 사용하기 위한 이론적 타당성을 제공합니다. 파생된 ReGELU2 및 ReSiLU2는 이 접근 방식의 중요한 실제 가치를 보여줍니다.

알고리즘의 세부 사항을 이해하려면 논문이나 코드를 읽어보세요. 관련 모듈은 LowMemoryBP 프로젝트의 github 저장소에 오픈 소스로 공개되어 있습니다.

위 내용은 ICML 2024 | 그라데이션 체크포인트가 너무 느립니까? LowMemoryBP는 속도를 늦추거나 비디오 메모리를 절약하지 않고도 역전파 비디오 메모리 효율성을 크게 향상시킵니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!