데이터 엔지니어링을 통한 건강 추적 - 식사 최적화 장

소개

안녕하세요 여러분! 이번이 첫 글이 될 테니 가혹하게 대해주시고, 제가 개선할 수 있다고 생각하는 점을 비판해 주시면 다음번에는 반드시 반영하도록 하겠습니다.

지난 몇 달 동안 저는 건강에 대해 깊이 생각하며 주로 운동하고 먹는 것을 지켜봤고, 이제는 확실히 이해한 것 같으니 어떻게 하면 건강을 더욱 최적화할 수 있는지 보고 싶었습니다. 혹시나 제가 놓친 부분이 있을 수도 있으니.

목표

이 장에서는 건강 여행 전반에 걸쳐 식사에 대해 연구하고 다음 주의 식사 계획으로 마무리하고 싶습니다. (1) 최소 단백질 요구 사항을 충족하고, (2) 칼로리 한도를 초과하지 않고, (3) 최소 섬유 요구 사항을 충족하고 (4) 비용을 최소화합니다.

데이터세트

크로노미터를 사용하여 추적한 음식인 데이터 세트를 소개하는 것부터 시작합니다. 크로노미터는 저의 여정에서 저와 함께 일해 왔으며 이제는 이전에 나열한 목표에 따라 제가 직접 분석하기 위해 입력한 데이터를 내보내게 됩니다.

다행히도 Cronometer를 사용하면 웹사이트에서 쉽게 데이터를 .csv 파일로 내보낼 수 있습니다.

이 장에서는 '음식 및 레시피 항목' 데이터세트만 내보냅니다.

'음식 및 레시피 항목'에서 얻은 데이터를 검토하는 것부터 시작합니다. 데이터 세트는 매우 포괄적이므로 향후 장에서 유용할 것이라고 확신합니다! 이 장에서는 식품명, 함량, 단백질, 칼로리, 섬유질로 제한하고 싶습니다.

# Importing and checking out the dataset

df = pd.read_csv("servings.csv")

df.head()

데이터 전처리

'음식 이름', '양', '에너지(kcal)', '섬유질(g)', '단백질(g)'과 같은 몇 가지 열이 이미 설정되어 있습니다. 완벽한! 이제 우리에게 부족한 유일한 것은 데이터 세트에서 추적되지 않았기 때문에 특정 금액이 주어진 각 음식의 비용을 얻는 것입니다. 다행스럽게도 내가 아는 가격을 입력할 수 있도록 데이터를 먼저 입력한 사람이 나였다. 하지만 모든 식품의 가격을 입력하지는 않겠습니다. 대신 우리는 오랜 친구인 ChatGPT에게 견적을 요청하고 .csv 파일을 조정하여 우리가 알고 있는 가격을 입력합니다. 원본 데이터세트에서 '음식 이름' 및 '금액' 열을 가져와서 파생된 'cost.csv'에 새 데이터세트를 저장합니다.

# Group by 'Food Name' and collect unique 'Amount' for each group

grouped_df = df.groupby('Food Name')['Amount'].unique().reset_index()

# Expand the DataFrame so each unique 'Food Name' and 'Amount' is on a separate row

expanded_df = grouped_df.explode('Amount')

# Export the DataFrame to a CSV file

expanded_df.to_csv('grouped_food_names_amounts.csv')

# Read the added costs and save as a new DataFrame

df_cost = pd.read_csv("cost.csv").dropna()

df_cost.head()

일부 음식은 단순히 너무 이상하게 구체적이고 저칼로리, 영양가 및/또는 저렴하다는 데이터 범위에 포함되지 않기 때문에(또는 단순히 조리법을 다시 만드는 데 신경 쓸 수 없기 때문에 삭제되었습니다) ). 그런 다음 가정된 '최종' 데이터 세트를 얻기 위해 원래 데이터 세트와 비용이 있는 데이터 프레임 두 개를 병합해야 합니다. 원본 데이터 세트에는 각 음식에 대한 항목이 포함되어 있으므로 이는 원본 데이터 세트에 동일한 음식, 특히 반복적으로 먹는 음식(예: 계란, 닭 가슴살, 쌀)에 대한 여러 항목이 있음을 의미합니다. 또한 여기서 문제의 원인이 될 가능성이 가장 높은 항목은 '에너지', '섬유질', '단백질' 및 '가격' 열이므로 값이 없는 열을 '0'으로 채우려고 합니다.

merged_df = pd.merge(df, df_cost, on=['Food Name', 'Amount'], how='inner') specified_columns = ['Food Name', 'Amount', 'Energy (kcal)', 'Fiber (g)', 'Protein (g)', 'Price'] final_df = merged_df[specified_columns].drop_duplicates() final_df.fillna(0, inplace=True) final_df.head()

최적화

완벽해요! 데이터 세트가 완료되었으며 이제 두 번째 부분인 최적화부터 시작합니다. 연구의 목적을 상기하면서, 우리는 최소량의 단백질과 섬유질, 최대량의 칼로리를 고려하여 최소 비용을 식별하고자 합니다. 여기서 옵션은 모든 단일 조합을 무차별 대입하는 것입니다. 그러나 업계에서는 "선형 프로그래밍" 또는 "선형 최적화"라는 적절한 용어를 사용하지만 그에 대해 인용하지는 않습니다. 이번에는 이를 정확하게 수행하는 것을 목표로 하는 Python 라이브러리인 puLP를 사용하겠습니다. 나는 템플릿을 따르는 것 외에는 그것을 사용하는 것에 대해 많이 알지 못하므로 그것이 어떻게 작동하는지에 대한 비전문적인 설명을 읽는 대신 해당 문서를 찾아보십시오. 하지만 주제에 대한 저의 간단한 설명을 듣고 싶은 분들을 위해 기본적으로 y = ax1 + bx2 + cx3 + ... + zxn으로 풀겠습니다.

우리가 따를 템플릿은 혼합 문제 사례 연구의 템플릿입니다. 여기서는 비슷한 목표를 따르지만 이 경우에는 하루 종일 식사를 혼합하려고 합니다. 시작하려면 DataFrame을 사전으로 변환해야 합니다. 특히 '음식 이름'을 일련의 x 역할을 하는 독립 변수 목록으로 변환한 다음 에너지, 섬유질, 단백질 및 가격을 사전으로 변환해야 합니다. '음식 이름': 각각의 값입니다. 양을 정량적으로 사용하지 않으므로 앞으로는 금액이 생략되고 대신 '음식 이름'과 연결됩니다.

# Concatenate Amount into Food Name

final_df['Food Name'] = final_df['Food Name'] + ' ' + final_df['Amount'].astype(str)

food_names = final_df['Food Name'].tolist()

# Create dictionaries for 'Energy', 'Fiber', 'Protein', and 'Price'

energy_dict = final_df.set_index('Food Name')['Energy (kcal)'].to_dict()

fiber_dict = final_df.set_index('Food Name')['Fiber (g)'].to_dict()

fiber_dict['Gardenia, High Fiber Wheat Raisin Loaf 1.00 Slice'] = 3

fiber_dict['Gardenia, High Fiber Wheat Raisin Loaf 2.00 Slice'] = 6

protein_dict = final_df.set_index('Food Name')['Protein (g)'].to_dict()

price_dict = final_df.set_index('Food Name')['Price'].to_dict()

# Display the results

print("Food Names Array:", food_names)

print("Energy Dictionary:", energy_dict)

print("Fiber Dictionary:", fiber_dict)

print("Protein Dictionary:", protein_dict)

print("Price Dictionary:", price_dict)

For those without keen eyesight, continue scrolling. For those who did notice the eerie 2 lines of code, let me explain. I saw this while I was grocery shopping but the nutrition facts on Gardenia's High Fiber Wheat Raisin loaf do not actually have 1 slice be 9 grams of Fiber, it has 2 slices for 6 grams. This is a big deal and has caused me immeasurable pain knowing that the values may be incorrect due to either a misinput of data or a change of ingredients which caused the data to be outdated. Either way, I needed this justice corrected and I will not stand for any less Fiber than I deserve. Moving on.

We go straight into plugging in our values using the template from the Case Study data. We set variables to stand for the minimum values we want out of Protein and Fiber, as well as the maximum Calories we are willing to eat. Then, we let the magical template code do its work and get the results.

# Set variables

min_protein = 120

min_fiber = 40

max_energy = 1500

# Just read the case study at https://coin-or.github.io/pulp/CaseStudies/a_blending_problem.html. They explain it way better than I ever could.

prob = LpProblem("Meal Optimization", LpMinimize)

food_vars = LpVariable.dicts("Food", food_names, 0)

prob += (

lpSum([price_dict[i] * food_vars[i] for i in food_names]),

"Total Cost of Food daily",

)

prob += (

lpSum([energy_dict[i] * food_vars[i] for i in food_names]) <= max_energy,

"EnergyRequirement",

)

prob += (

lpSum([fiber_dict[i] * food_vars[i] for i in food_names]) >= min_fiber,

"FiberRequirement",

)

prob += (

lpSum([protein_dict[i] * food_vars[i] for i in food_names]) >= min_protein,

"ProteinRequirement",

)

prob.writeLP("MealOptimization.lp")

prob.solve()

print("Status:", LpStatus[prob.status])

for v in prob.variables():

if v.varValue > 0:

print(v.name, "=", v.varValue)

print("Total Cost of Food per day = ", value(prob.objective))

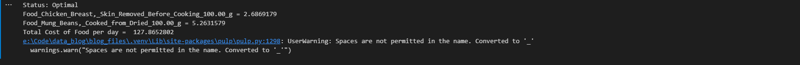

Results

In order to get 120 grams of protein and 40 grams of fiber, I would need to spend 128 Philippine Pesos on 269 grams of chicken breast fillet, and 526 grams of mung beans. This... does not sound bad at all considering how much I love both ingredients. I will definitely try it out, maybe for a week or a month just to see how much money I would save despite having just enough nutrition.

That was it for this chapter of Tracking Health with Data Engineering, if you want to see the data I worked on in this chapter, visit the repository or visit the notebook for this page. Do leave a comment if you have any and try to stay healthy.

위 내용은 데이터 엔지니어링을 통한 건강 추적 - 식사 최적화 장의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!

핫 AI 도구

Undresser.AI Undress

사실적인 누드 사진을 만들기 위한 AI 기반 앱

AI Clothes Remover

사진에서 옷을 제거하는 온라인 AI 도구입니다.

Undress AI Tool

무료로 이미지를 벗다

Clothoff.io

AI 옷 제거제

Video Face Swap

완전히 무료인 AI 얼굴 교환 도구를 사용하여 모든 비디오의 얼굴을 쉽게 바꾸세요!

인기 기사

뜨거운 도구

메모장++7.3.1

사용하기 쉬운 무료 코드 편집기

SublimeText3 중국어 버전

중국어 버전, 사용하기 매우 쉽습니다.

스튜디오 13.0.1 보내기

강력한 PHP 통합 개발 환경

드림위버 CS6

시각적 웹 개발 도구

SublimeText3 Mac 버전

신 수준의 코드 편집 소프트웨어(SublimeText3)

Python vs. C : 학습 곡선 및 사용 편의성

Apr 19, 2025 am 12:20 AM

Python vs. C : 학습 곡선 및 사용 편의성

Apr 19, 2025 am 12:20 AM

Python은 배우고 사용하기 쉽고 C는 더 강력하지만 복잡합니다. 1. Python Syntax는 간결하며 초보자에게 적합합니다. 동적 타이핑 및 자동 메모리 관리를 사용하면 사용하기 쉽지만 런타임 오류가 발생할 수 있습니다. 2.C는 고성능 응용 프로그램에 적합한 저수준 제어 및 고급 기능을 제공하지만 학습 임계 값이 높고 수동 메모리 및 유형 안전 관리가 필요합니다.

파이썬과 시간 : 공부 시간을 최대한 활용

Apr 14, 2025 am 12:02 AM

파이썬과 시간 : 공부 시간을 최대한 활용

Apr 14, 2025 am 12:02 AM

제한된 시간에 Python 학습 효율을 극대화하려면 Python의 DateTime, Time 및 Schedule 모듈을 사용할 수 있습니다. 1. DateTime 모듈은 학습 시간을 기록하고 계획하는 데 사용됩니다. 2. 시간 모듈은 학습과 휴식 시간을 설정하는 데 도움이됩니다. 3. 일정 모듈은 주간 학습 작업을 자동으로 배열합니다.

Python vs. C : 성능과 효율성 탐색

Apr 18, 2025 am 12:20 AM

Python vs. C : 성능과 효율성 탐색

Apr 18, 2025 am 12:20 AM

Python은 개발 효율에서 C보다 낫지 만 C는 실행 성능이 높습니다. 1. Python의 간결한 구문 및 풍부한 라이브러리는 개발 효율성을 향상시킵니다. 2.C의 컴파일 유형 특성 및 하드웨어 제어는 실행 성능을 향상시킵니다. 선택할 때는 프로젝트 요구에 따라 개발 속도 및 실행 효율성을 평가해야합니다.

Python 학습 : 2 시간의 일일 연구가 충분합니까?

Apr 18, 2025 am 12:22 AM

Python 학습 : 2 시간의 일일 연구가 충분합니까?

Apr 18, 2025 am 12:22 AM

하루에 2 시간 동안 파이썬을 배우는 것으로 충분합니까? 목표와 학습 방법에 따라 다릅니다. 1) 명확한 학습 계획을 개발, 2) 적절한 학습 자원 및 방법을 선택하고 3) 실습 연습 및 검토 및 통합 연습 및 검토 및 통합,이 기간 동안 Python의 기본 지식과 고급 기능을 점차적으로 마스터 할 수 있습니다.

Python vs. C : 주요 차이점 이해

Apr 21, 2025 am 12:18 AM

Python vs. C : 주요 차이점 이해

Apr 21, 2025 am 12:18 AM

Python과 C는 각각 고유 한 장점이 있으며 선택은 프로젝트 요구 사항을 기반으로해야합니다. 1) Python은 간결한 구문 및 동적 타이핑으로 인해 빠른 개발 및 데이터 처리에 적합합니다. 2) C는 정적 타이핑 및 수동 메모리 관리로 인해 고성능 및 시스템 프로그래밍에 적합합니다.

Python Standard Library의 일부는 무엇입니까? 목록 또는 배열은 무엇입니까?

Apr 27, 2025 am 12:03 AM

Python Standard Library의 일부는 무엇입니까? 목록 또는 배열은 무엇입니까?

Apr 27, 2025 am 12:03 AM

Pythonlistsarepartoftsandardlardlibrary, whileraysarenot.listsarebuilt-in, 다재다능하고, 수집 할 수있는 반면, arraysarreprovidedByTearRaymoduledlesscommonlyusedDuetolimitedFunctionality.

파이썬 : 자동화, 스크립팅 및 작업 관리

Apr 16, 2025 am 12:14 AM

파이썬 : 자동화, 스크립팅 및 작업 관리

Apr 16, 2025 am 12:14 AM

파이썬은 자동화, 스크립팅 및 작업 관리가 탁월합니다. 1) 자동화 : 파일 백업은 OS 및 Shutil과 같은 표준 라이브러리를 통해 실현됩니다. 2) 스크립트 쓰기 : PSUTIL 라이브러리를 사용하여 시스템 리소스를 모니터링합니다. 3) 작업 관리 : 일정 라이브러리를 사용하여 작업을 예약하십시오. Python의 사용 편의성과 풍부한 라이브러리 지원으로 인해 이러한 영역에서 선호하는 도구가됩니다.

과학 컴퓨팅을위한 파이썬 : 상세한 모양

Apr 19, 2025 am 12:15 AM

과학 컴퓨팅을위한 파이썬 : 상세한 모양

Apr 19, 2025 am 12:15 AM

과학 컴퓨팅에서 Python의 응용 프로그램에는 데이터 분석, 머신 러닝, 수치 시뮬레이션 및 시각화가 포함됩니다. 1.numpy는 효율적인 다차원 배열 및 수학적 함수를 제공합니다. 2. Scipy는 Numpy 기능을 확장하고 최적화 및 선형 대수 도구를 제공합니다. 3. 팬더는 데이터 처리 및 분석에 사용됩니다. 4. matplotlib는 다양한 그래프와 시각적 결과를 생성하는 데 사용됩니다.