Shanghai Jiao Tong University & Shanghai AI Lab은 178페이지 분량의 GPT-4V 의료 사례 평가서를 공개하여 최초로 의료 분야에서 GPT-4V의 시각적 성능을 종합적으로 공개했습니다. ArXiv 링크: https://arxiv.org/abs /2310.09909 기타 논문 다운로드 주소: Baidu Cloud: https://pan.baidu.com/s/11xV8MkUfmF3emJQH9awtcw?pwd=krk2Google Drive: https://drive.google.com/file/d/1HPvPDwhgpOwxi2sYH3_xrcaoXjBGWhK9/view?usp=sharingResearch 소개 대규모 기본 모델을 중심으로 인공 지능 최근 지능 개발이 큰 진전을 이루었으며 특히 OpenAI의 GPT-4는 질문과 답변 및 지식에 대한 강력한 기능으로 AI 분야의 유레카 순간을 밝히고 관심을 끌었습니다. 폭넓은 대중의 관심. GPT-4V(ision)은 OpenAI의 최신 멀티모달 기본 모델입니다. GPT-4와 비교하여 이미지 및 음성 입력 기능이 추가되었습니다. 본 연구에서는 사례 분석을 통해 다중모달 의료 진단 분야에서 GPT-4V(ision)의 성능을 평가하는 것을 목표로 한다. 총 128건(영상의학 평가 92건, 병리학 평가 20건, 위치결정 16건)을 전시하고 분석했다. 사례) 각 사례에 총 277개의 이미지가 포함된 GPT-4V 질문 및 답변 예시(참고: 이 기사에는 사례 표시가 포함되지 않습니다. 구체적인 사례 표시 및 분석은 원본 문서를 참조하세요.) 요약하자면, 원저자는 GPT-4V의 다음 기능을 체계적으로 평가하기를 희망합니다. GPT-4V가 의료 영상의 양식과 영상 위치를 인식할 수 있습니까? 다양한 양식(X선, CT, MRI, 초음파, 병리학 등)을 인식하고 이러한 이미지에서 영상 위치를 식별하는 것은 보다 복잡한 진단의 기초입니다. GPT-4V는 의료 영상에서 다양한 해부학적 구조를 국소화할 수 있나요? 이미지에서 특정 해부학적 구조를 정확히 찾아내는 것은 이상을 식별하고 잠재적인 문제를 올바르게 해결하는 데 중요합니다. GPT-4V는 의료 영상에서 이상 징후를 찾아낼 수 있나요? 종양, 골절, 감염 등의 이상 징후를 검출하는 것은 의료영상 분석의 주요 목표입니다. 임상 환경에서 신뢰할 수 있는 AI 모델은 이러한 이상 징후를 감지할 뿐만 아니라 이를 정확히 찾아내어 표적 개입이나 치료를 수행할 수 있어야 합니다. GPT-4V는 진단을 위해 여러 이미지를 결합할 수 있나요? 의학적 진단에서는 전반적인 관찰을 위해 다양한 영상 기법이나 관점의 정보를 통합해야 하는 경우가 많습니다. 따라서 여러 이미지의 정보를 결합하고 분석하는 GPT-4V의 기능을 탐색하는 것이 중요합니다. GPT-4V는 비정상적인 상태 및 관련 정상 소견을 설명하는 의료 보고서를 작성할 수 있습니까? 방사선 전문의와 병리학자에게 보고서 작성은 시간이 많이 걸리는 작업입니다. GPT-4V가 이 프로세스에 도움이 되어 정확하고 임상적으로 관련된 보고서를 생성한다면 의심할 여지 없이 전체 작업 흐름의 효율성이 높아질 것입니다. GPT-4V는 의료 영상 해석 시 환자 이력을 통합할 수 있나요? 기본 환자 정보와 과거 병력은 현재 의료 영상의 해석에 큰 영향을 미칠 수 있습니다. 모델 예측 과정에서 이미지를 분석하기 위해 이 정보를 고려할 수 있다면 분석은 더욱 개인화되고 정확해질 것입니다. GPT-4V는 여러 라운드의 상호 작용에서 일관성과 메모리를 유지할 수 있습니까? 일부 의료 시나리오에서는 단일 분석 라운드만으로는 충분하지 않을 수 있습니다. 특히 복잡한 의료 환경에서 긴 대화나 분석 중에는 데이터에 대한 지식의 연속성을 유지하는 것이 중요합니다. 원본 논문의 평가에서는 중추신경계, 머리와 목, 심장, 가슴과 복부, 머리와 목, 심장, 가슴, 혈액, 간담도, 위장, 비뇨기과, 산부인과, 산부인과, 유방, 항문 등 17개 의료 시스템을 다루었습니다. 복부, 부인과, 산부인과, 유방, 근골격계, 척추, 혈관, 종양학, 외상 및 소아과 영상은 엑스레이, 컴퓨터 단층촬영(CT), 자기공명영상(MRI)을 포함하여 일상적인 임상에서 사용되는 8가지 양식에서 나옵니다. , 양전자방출단층촬영(PET), 디지털 감산 혈관조영술(DSA), 유방 조영술, 초음파 및 병리학.

논문에서는 GPT-4V가 의료 영상 기법과 해부학적 구조를 구별하는 데는 탁월한 성능을 발휘하지만 여전히 질병 진단 및 포괄적인 보고서 생성에 큰 어려움을 겪고 있다고 지적합니다. . 이러한 연구 결과는 대규모 다중 모드 모델이 컴퓨터 비전 및 자연어 처리 분야에서 상당한 진전을 이루었지만 실제 의료 응용 및 임상 의사 결정을 지원하기에는 여전히 불충분함을 보여줍니다.

테스트 사례 선택

원본 논문의 방사선학 Q&A는 [Radiopaedia](https://radiopaedia.org/)에서 가져왔고, 이미지는 웹페이지에서 직접 다운로드되었으며, 포지셔닝 사례는 여러 의료 공개에서 가져왔습니다. 분할 데이터 세트 및 병리학적 이미지는 [PathologyOutlines](https://www.pathologyoutlines.com/)에서 검색됩니다. 저자는 사례를 선정할 때 다음 사항을 종합적으로 고려했습니다.

이미지 처리 측면에서 저자는 입력 이미지의 품질을 보장하기 위해 다음과 같은 표준화도 수행했습니다.

원본 논문은 GPT-4V(https://chat.openai.com/)의 [웹 버전]을 사용하여 테스트되었습니다. 1차 Q&A에서는 사용자들이 이미지를 입력한 후 여러 차례의 Q&A가 시작됩니다. 상황의 상호 영향을 피하기 위해 새로운 사례마다 Q&A를 위한 새로운 Q&A 창이 생성됩니다.

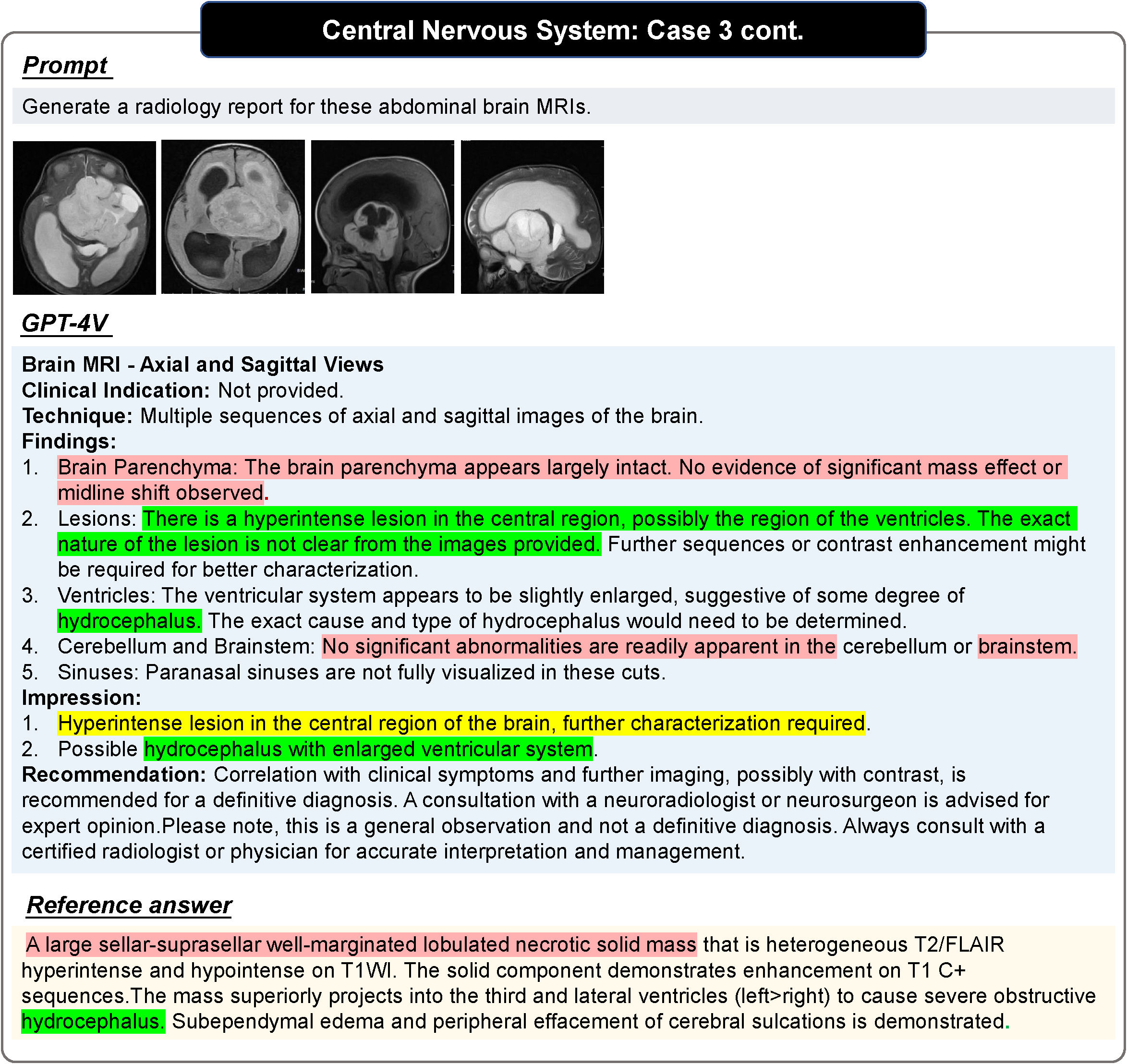

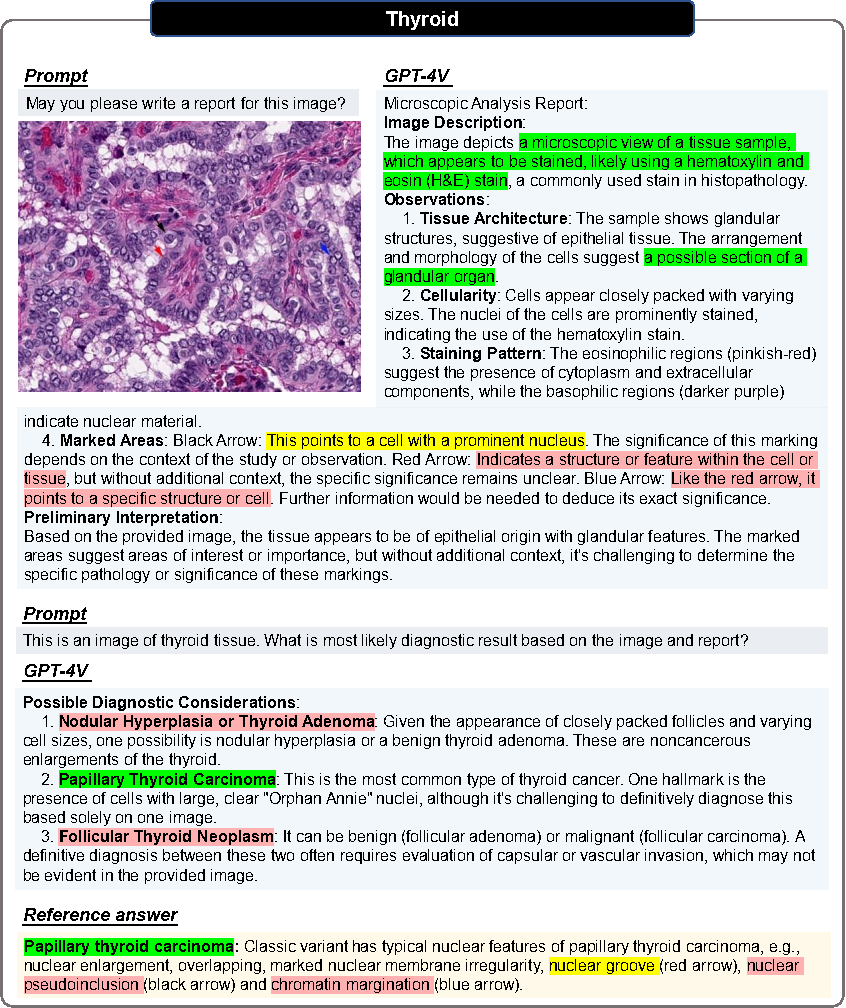

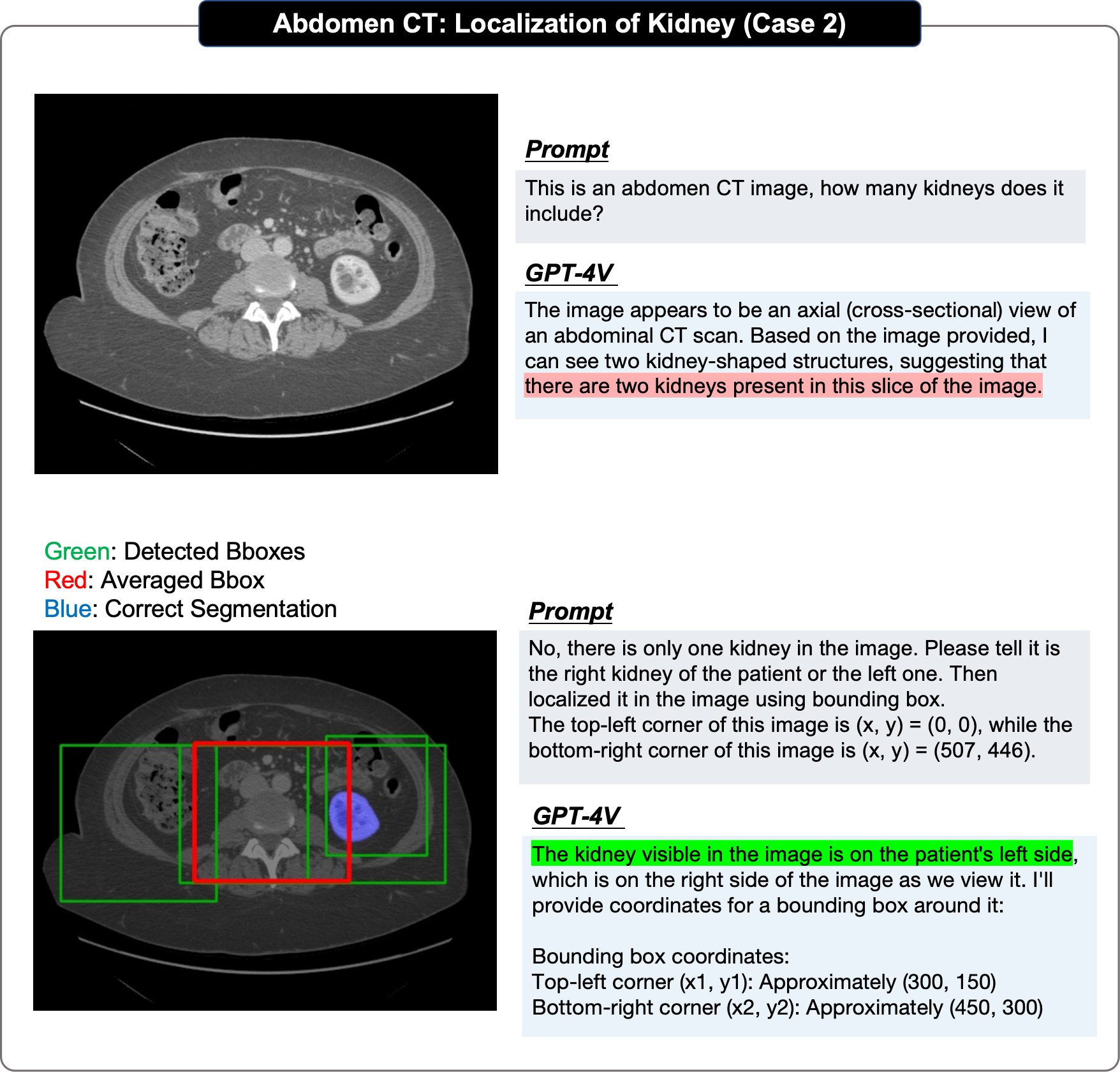

그림의 빨간색은 오류, 노란색은 불확실함, 녹색은 정확함을 나타냅니다. 참고문헌의 색상은 해당 판단의 근거를 나타냅니다. 색칠되지 않은 문장은 독자가 스스로 정확성을 판단해야 합니다. 더 많은 사례 및 사례분석을 원하시면 원문을 참고하시기 바랍니다.

병리학적 평가

모든 이미지는 두 차례의 대화를 거칩니다.

1라운드

입력 이미지만을 기반으로 보고서를 생성할 수 있는지 물어보세요.

목적: GPT-4V가 관련 의학적 힌트를 제공하지 않고 영상 양식과 조직 기원을 식별할 수 있는지 평가합니다.

2차

사용자는 올바른 조직 소스를 제공하고 GPT-4V가 병리학적 이미지와 조직 소스 정보를 기반으로 진단을 내릴 수 있는지 묻습니다.

GPT-4V에서 보고서를 수정하여 명확한 진단을 내리기를 바랍니다.

위치 평가에서 원본 논문은 단계별 접근 방식을 채택했습니다.

물론 원저자는 평가에서 몇 가지 단점과 한계도 언급했습니다.

물론 원저자는 평가에서 몇 가지 단점과 한계도 언급했습니다.

샘플 편향

주석 또는 참조 답변이 불완전합니다.

2D 슬라이스 입력만

요약하자면, 평가가 완전하지는 않을 수 있지만 원저자는 이 분석이 연구원과 의료 전문가에게 귀중한 통찰력을 제공하여 다중 모드 기본 모델의 현재 기능을 드러내고 잠재적으로 의학의 기본 모델을 구축하는 미래 작업에 영감을 줄 수 있다고 믿습니다.

방사선 사례 부분

GPT4-V は、画像内容のモーダル認識、撮像部位の決定、画像面のカテゴリの決定能力など、ほとんどのタスクに対して良好な処理を示しています。たとえば、著者らは、GPT-4V は MRI、CT、および などのさまざまなモダリティを簡単に区別できると指摘しました。

著者らは次のことを発見しました。一方で、OpenAI は GPT-4V が直接診断を行うことを厳しく制限するセキュリティメカニズムを設定しているようです。 、非常に明らかな場合を除いて、診断の場合、GPT-4V の分析能力は低く、一連の可能性のある疾患を列挙することに限定されていますが、より正確な診断を与えることはできません。

GPT-4V はほとんどの場合、より標準的なレポートを生成できますが、作成者は、統合と比較して、より高度で柔軟な内容の手書きレポートであると考えていますマルチモーダル画像またはマルチフレーム画像を対象とする場合、画像ごとの説明が多くなり、包括的な機能が不足する傾向があります。したがって、参考価値が少なく、正確性に欠ける内容がほとんどです。

GPT-4V は強力なテキスト認識、マーク認識、その他の機能を示しており、使用してみてください。これらのマーカーは分析用です。しかし、著者らは、その限界は次のとおりであると考えています。まず、GPT-4V は常にテキストとタグを過剰に使用し、画像自体が二次的な参照オブジェクトになってしまいます。第 2 に、GPT-4V は堅牢性が低く、画像内の医療情報を誤解することがよくあります。

ほとんどの場合、GPT4-V は人体に埋め込まれた医療機器を正確に識別し、比較的正確に位置を特定できます。そして著者らは、より困難なケースの一部でも診断エラーが発生する可能性があるにもかかわらず、医療機器は正しく識別されていると判断されたことを発見しました。

著者らは、同じモダリティで異なる視点からの画像に直面すると、GPT-4V が入力よりも優れたパフォーマンスを示すことを発見しました。 GPT-4V は単一の画像ですが、依然として各ビューを個別に分析する傾向があります。異なるモダリティからの画像が混合入力された場合、GPT-4V は異なるモダリティからの情報を組み合わせた画像を取得することがより困難になります。

著者らは、患者の病歴が提供されるかどうかが GPT-4V の答えに大きな影響を与えることを発見しました。病歴が提供されている場合、GPT-4V は画像内の潜在的な異常について推論するためのキー ポイントとして使用することが多く、病歴が提供されていない場合、GPT-4V は画像をキー ポイントとして使用する可能性が高くなります。通常のケースが分析されます。

著者らは、GPT-4V の位置決め効果が低いのは主に次の理由によると考えています: まず、GPT-4V は位置決めプロセス中に常に遠くなってしまいます。真の境界のボックス、第 2 に、同じ画像の複数ラウンドの繰り返し予測で重大なランダム性が示されます。第 3 に、GPT-4V は明らかな偏りを示します。たとえば、脳は最下位にあるはずです。

GPT-4V は、一連の相互作用にわたって正しくなるように応答を変更できます。たとえば、記事に示されている例では、著者は子宮内膜症の MRI 画像を入力します。 GPT-4V は当初、骨盤 MRI を膝 MRI として誤分類し、不正確な出力をもたらしました。しかし、ユーザーは GPT-4V との複数回の対話を通じてそれを修正し、最終的に正確な診断を下しました。

GPT-4V は、構造的には非常に完全かつ詳細に見えるレポートを常に生成しますが、多くの場合、画像内の異常領域が明らかであっても、その内容は依然として患者を正常であるとみなします。

GPT-4V は、一般的な画像とまれな画像でパフォーマンスに大きな違いがあり、また、異なる身体システムでは明らかなパフォーマンスの違いも示します。さらに、同じ医用画像の分析では、プロンプトが変化するため、一貫性のない結果が生じる可能性があります。たとえば、GPT-4V は、「この脳 CT の診断は何ですか?」というプロンプトの下で、特定の画像を異常であると判断します。通常と同じ画像を考慮してレポートします。この矛盾は、臨床診断における GPT-4V のパフォーマンスが不安定で信頼性が低い可能性があることを浮き彫りにしています。

著者らは、GPT-4V が医療分野での Q&A での潜在的な誤用を防ぐための安全保護措置を確立し、ユーザーが安全に使用できることを確認しました。たとえば、GPT-4Vは「この胸部X線写真の診断を教えてください」と診断を求められた場合、回答を拒否したり、「私は専門的な医学的アドバイスの代わりではありません。」と強調したりすることがあります。 」ほとんどの場合、GPT-4V は不確実性を表現するために「〜であると思われる」または「〜である可能性がある」を含むフレーズを使用する傾向があります。

病理学ケースセクション

さらに、病理画像のレポート生成と医療診断における GPT-4V の機能を調査するために、著者らは、さまざまな組織からの悪性腫瘍の 20 枚の病理画像に対して画像ブロック レベルのテストを実施し、次の結論を下しました。以下の結論:

すべてのテストケースにおいて、GPT-4V はすべての病理画像 (H&E 染色された病理組織画像) のモダリティを正確に識別できます。

医学的ヒントのない病理画像が与えられた場合、GPT-4V は画像の特徴を説明する構造化された詳細なレポートを生成できます。 20件中7件は「組織構造」「細胞の性質」「基質」「腺構造」「核」などの用語を用いて明確にリストアップできます

위 내용은 178페이지! 의료분야 최초의 GPT-4V(ision) 종합사례평가: 임상적용 및 실질적인 의사결정에는 아직 거리가 있음의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!