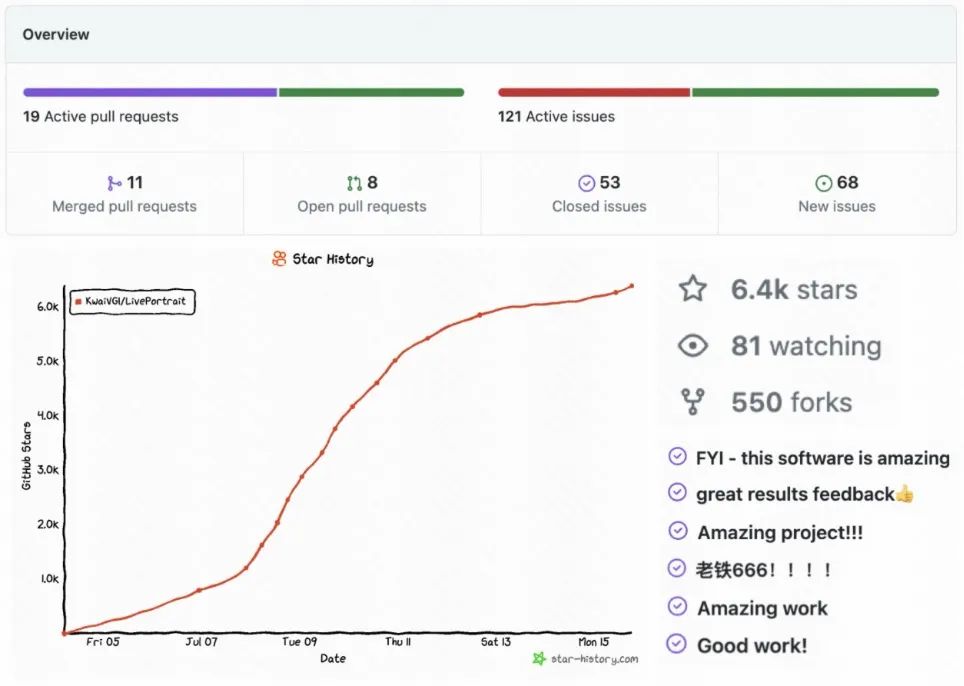

HuggingFace 전체 테마 순위 1위|

Untuk maklumat sumber lanjut, anda boleh melihat:

- Alamat kod: https://github.com/KwaiVGI/LivePortrait

- pautan: https://github.com/LivePortrait

- abs /2407.03168

- Laman utama projek: https://liveportrait.github.io/

HuggingFace Space pengalaman dalam talian satu klik: https://huggingface.co/spaces/KwaiVGI/LivePortrait Apakah jenis teknologi yang digunakan LivePortrait untuk cepat menjadi popular di seluruh Internet?

Pengenalan KaedahBerbeza daripada kaedah berasaskan model resapan arus perdana, LivePortrait meneroka dan mengembangkan potensi kerangka kerja implisit kebolehcapaian yang berpotensi. LivePortrait memfokuskan pada generalisasi, kebolehkawalan dan kecekapan praktikal yang lebih baik. Untuk meningkatkan keupayaan penjanaan dan kebolehkawalan, LivePortrait menggunakan bingkai latihan berkualiti tinggi 69M, strategi latihan hibrid gambar video, menaik taraf struktur rangkaian dan mereka bentuk pemodelan tindakan dan kaedah pengoptimuman yang lebih baik. Selain itu, LivePortrait menganggap perkara utama tersirat sebagai gambaran tersirat yang berkesan bagi ubah bentuk campuran muka (Blendshape), dan dengan berhati-hati mencadangkan modul jahitan dan penyasaran semula berdasarkan perkara ini. Kedua-dua modul ini adalah rangkaian MLP yang ringan, jadi sambil meningkatkan kebolehkawalan, kos pengiraan boleh diabaikan. Walaupun dibandingkan dengan beberapa kaedah berasaskan model penyebaran sedia ada, LivePortrait masih sangat berkesan. Pada masa yang sama, pada GPU RTX4090, kelajuan penjanaan bingkai tunggal LivePortrait boleh mencapai 12.8ms Jika terus dioptimumkan, seperti TensorRT, ia dijangka mencapai kurang daripada 10ms.

Latihan model LivePortrait dibahagikan kepada dua peringkat. Peringkat pertama ialah latihan model asas, dan peringkat kedua ialah latihan modul pemasangan dan pengalihan.

Peringkat pertama latihan model asas

🎜🎜模 Peringkat pertama latihan model asas

Dalam latihan model fasa pertama, LivePortrait telah membuat satu siri penambahbaikan pada rangka kerja berasaskan titik tersembunyi, seperti Face vid2vid [1], termasuk:

Pengumpulan data latihan berkualiti tinggi: LivePortrait menggunakan set data video awam Voxceleb[2], MEAD[3], RAVDESS[4] dan set data gambar yang digayakan AAHQ[5]. Selain itu, video potret beresolusi 4K berskala besar digunakan, termasuk ekspresi dan postur yang berbeza, lebih daripada 200 jam video potret bercakap, set data peribadi LightStage [6] dan beberapa video dan gambar yang digayakan. LivePortrait membahagikan video panjang kepada segmen kurang daripada 30 saat dan memastikan setiap segmen hanya mengandungi satu orang. Untuk memastikan kualiti data latihan, LivePortrait menggunakan KVQ yang dibangunkan sendiri oleh Kuaishou [7] (kaedah penilaian kualiti video yang dibangunkan sendiri oleh Kuaishou, yang boleh melihat secara menyeluruh kualiti, kandungan, pemandangan, estetika, pengekodan, audio dan ciri-ciri lain bagi video untuk melaksanakan penilaian berbilang dimensi ) untuk menapis klip video berkualiti rendah. Jumlah data latihan termasuk 69J video, termasuk 18.9K identiti dan 60K potret bergaya statik.

Latihan Hibrid Imej-Video: Model yang dilatih menggunakan hanya video orang sebenar menunjukkan prestasi yang baik untuk orang sebenar, tetapi mempunyai keupayaan generalisasi yang tidak mencukupi untuk orang yang digayakan (seperti anime). Video potret bergaya adalah lebih jarang, dengan LivePortrait hanya mengumpul kira-kira 1.3K klip video daripada kurang daripada 100 identiti. Sebaliknya, gambar potret yang digayakan berkualiti tinggi lebih banyak LivePortrait telah mengumpulkan kira-kira 60K gambar dengan identiti yang berbeza, memberikan maklumat identiti yang pelbagai. Untuk memanfaatkan kedua-dua jenis data, LivePortrait menganggap setiap imej sebagai klip video dan melatih model pada kedua-dua video dan imej secara serentak. Latihan hibrid ini meningkatkan keupayaan generalisasi model.

Struktur rangkaian yang dipertingkatkan: LivePortrait menyatukan rangkaian anggaran titik kunci tersirat kanonik (L), rangkaian anggaran pose kepala (H) dan rangkaian anggaran ubah bentuk ungkapan (Δ) ke dalam model tunggal (M), Dan menggunakan ConvNeXt-V2-Tiny [8] sebagai strukturnya untuk menganggarkan secara langsung perkara utama tersirat kanonik, pose kepala dan ubah bentuk ekspresi imej input. Selain itu, diilhamkan oleh kerja berkaitan face vid2vid, LivePortrait menggunakan penyahkod SPADE [9] yang lebih berkesan sebagai penjana (G). Ciri terpendam (fs) dimasukkan secara halus ke dalam penyahkod SPADE selepas ubah bentuk, di mana setiap saluran ciri terpendam digunakan sebagai peta semantik untuk menjana imej yang didorong. Untuk meningkatkan kecekapan, LivePortrait turut memasukkan lapisan PixelShuffle[10] sebagai lapisan terakhir (G), sekali gus meningkatkan peleraian daripada 256 kepada 512.

Pemodelan transformasi tindakan yang lebih fleksibel: Kaedah pengiraan dan pemodelan bagi perkara utama tersirat asal mengabaikan pekali penskalaan, yang menyebabkan penskalaan mudah dipelajari ke dalam pekali ungkapan, menjadikan latihan lebih sukar. Untuk menyelesaikan masalah ini, LivePortrait memperkenalkan faktor penskalaan ke dalam pemodelan. LivePortrait mendapati bahawa penskalaan unjuran biasa boleh membawa kepada pekali ekspresi boleh dipelajari yang terlalu fleksibel, menyebabkan lekatan tekstur apabila didorong merentas identiti. Oleh itu, transformasi yang diterima pakai oleh LivePortrait adalah kompromi antara fleksibiliti dan kebolehpanduan. . Khususnya, arah bola mata dan orientasi kepala potret dalam hasil pemanduan cenderung kekal selari. LivePortrait mengaitkan had ini kepada kesukaran pembelajaran ekspresi muka halus tanpa pengawasan. Untuk menyelesaikan masalah ini, LivePortrait memperkenalkan titik kekunci 2D untuk menangkap ekspresi mikro, menggunakan kehilangan berpandukan titik kunci (Lguide) sebagai panduan untuk pengoptimuman titik kunci tersirat. : LivePortrait menggunakan kehilangan invarian mata utama vid2vid tersirat (LE), kehilangan sebelum mata utama (LL), kehilangan pose kepala (LH) dan kehilangan sebelum ubah bentuk (LΔ). Untuk meningkatkan lagi kualiti tekstur, LivePortrait menggunakan kehilangan persepsi dan GAN, yang bukan sahaja digunakan pada domain global imej input, tetapi juga pada domain tempatan muka dan mulut, direkodkan sebagai kehilangan persepsi lata (LP, lata) dan lata GAN (LG, lata). Kawasan muka dan mulut ditakrifkan oleh titik kekunci semantik 2D. LivePortrait juga menggunakan kehilangan identiti muka (Lfaceid) untuk mengekalkan identiti imej rujukan. Semua modul di peringkat pertama dilatih dari awal, dan jumlah fungsi pengoptimuman latihan (Lbase) ialah jumlah wajaran syarat kerugian di atas. Latihan modul pemasangan dan ubah hala peringkat kedua kos pengiraan boleh diabaikan. Mengambil kira keperluan sebenar, LivePortrait mereka bentuk modul yang sesuai, modul ubah hala mata dan modul ubah hala mulut.當參考人像被裁切時,驅動後的人像會從裁圖空間被反貼回原始影像空間,貼合模組的加入是為了避免反貼過程中出現像素錯位,例如肩膀區域。由此,LivePortrait能對更大的圖片尺寸或多人合照進行動作驅動。眼部重定向模組旨在解決跨身分驅動時眼睛閉合不完全的問題,尤其是當眼睛小的人像驅動眼睛大的人像時。嘴部重定向模組的設計想法類似於眼部重定向模組,它透過將參考圖片的嘴部驅動為閉合狀態來規範輸入,從而更好地進行驅動。

合模組:在訓練過程中,貼合模組(S) 的輸入為參考圖的隱式關鍵點(xs) 和另一個身分驅動影格的隱式關鍵點(xd),並估計驅動隱式關鍵點(xd) 的表情變化量 (Δst)。可以看到,和第一階段不同,LivePortrait採用跨身分的動作取代同身分的動作來增加訓練難度,旨在使貼合模組具有更好的泛化性。接著,驅動隱式關鍵點 (xd) 被更新,對應的驅動輸出為 (Ip,st) 。 LivePortrait在此階段也同時輸出自重建圖片 (Ip,recon)。最後,貼合模組的損失函數 (Lst) 計算兩者肩膀區域的像素一致損失以及貼合變化量的正規損失。 眼部和嘴部重定向模組:眼部重定向模組(Reyes) 的輸入為參考圖隱式關鍵點(xs),參考圖眼部張開條件元組和一個隨機的驅動眼部張開係數,由此估計驅動關鍵點的變形變化量(Δeyes)。眼部張開條件元組表示眼部張開比例,越大表示眼部張開程度越大。類似的,嘴部重定向模組(Rlip) 的輸入為參考圖隱式關鍵點(xs),參考圖嘴部張開條件係數和一個隨機的驅動嘴部張開係數,並由此估計驅動關鍵點的變化量 (Δlip)。接著,驅動關鍵點 (xd) 分別被眼部和嘴部對應的變形變化量更新,對應的驅動輸出為 (Ip,eyes) 和 (Ip,lip) 。最後,眼部和嘴部重定向模組的目標函數分別為(Leyes) 和 (Llip),分別計算眼部和嘴部區域的像素一致性損失,眼部和嘴部變化量的正則損失,以及隨機驅動係數與驅動輸出的張開條件係數之間的損失。眼部和嘴部的變化量 (Δeyes) 和 (Δlip) 是相互獨立的,因此在推理階段,它們可以被線性相加並更新驅動隱式關鍵點。 同身份驅動:由如上同擴散模型對比的結果,與未上相同的方法比較具有較好的生成品質和驅動精確度,可以捕捉驅動幀的眼部和嘴部細微表情,同時保有參考圖片的紋理和身份。即使在較大的頭部姿態下,LivePortrait也有較穩定的表現。

|

을 받았습니다. 우리는 광범위한 칭찬을 받았으며 여전히 관심이 높아지고 있습니다.

을 받았습니다. 우리는 광범위한 칭찬을 받았으며 여전히 관심이 높아지고 있습니다.  일주일 연속 1위 , 최근 허깅페이스 전체 테마랭킹 1위

일주일 연속 1위 , 최근 허깅페이스 전체 테마랭킹 1위