AIxiv專欄是本站發布學術、技術內容的欄位。過去數年,本站AIxiv專欄接收通報了2,000多篇內容,涵蓋全球各大專院校與企業的頂尖實驗室,有效促進了學術交流與傳播。如果您有優秀的工作想要分享,歡迎投稿或聯絡報道。投稿信箱:liyazhou@jiqizhixin.com;zhaoyunfeng@jiqizhixin.com

吳翼,清華大學對齊資訊院助理影響,曾任OpenAI 全職學習師,大研究領域為人機交互,機器人學習等。 2019 年在美國加州大學柏克萊分校取得博士學位,師從 Stuart Russell 教授;2014 年大學部畢業於清華大學交叉資訊院(姚班)。其代表作包括:NIPS2016 最佳論文,Value Iteration Network;多智能體深度強化學習領域最高引用論文,MADDPG 演算法;OpenAI hide-and-seek 專案等。 如何讓大模型更好的遵從人類指令和意圖?如何讓大模型有更好的推理能力?如何讓大模型避免幻覺?能否解決這些問題,是讓大模型真正廣泛可用,甚至實現超級智慧(Super Intelligence)最為關鍵的技術挑戰。這些最困難的挑戰也是吳翼團隊長期以來的研究重點,大模型對齊技術(Alignment)所要攻克的難題。 對齊技術中,最重要的演算法框架就是根據人類回饋的強化學習(RLHF, Reinforcement Learning from Human Feedback)。 RLHF 根據人類對大模型輸出的偏好回饋,來學習基於人類回饋的獎勵函數(Reward Model),並進一步對大模型進行強化學習訓練,讓大模型在反覆迭代中學會辨別回覆的好壞,並實現模型能力提升。目前世界上最強的語言模型,例如 OpenAI 的 GPT 模型和 Anthropic 的 Claude 模型,都極為強調 RLHF 訓練的重要性。 OpenAI 和 Anthropic 內部也都開發了基於大規模 PPO 演算法的 RLHF 訓練系統進行大模型對齊。 然而,由於PPO 演算法流程複雜,算力消耗大,美國AI 公司的大規模RLHF 訓練系統也從不開源,所以儘管PPO 演算法非常強大,學術界的對齊工作卻一直很少採用複雜的PPO 演算法進行RLHF 研究,轉而普遍使用SFT(監督微調)或DPO(Direct Policy Optimization)等更簡化、更直接、對訓練系統要求更低的對齊演算法。 那麼,簡單的對齊演算法一定效果更好嗎?吳翼團隊發表在 ICML 2024 的工作 “Is DPO Superior to PPO for LLM Alignment? A Comprehensive Study” 仔細探討了 DPO 與 PPO 演算法的特點,並指出提升 RLHF 演算法效果的關鍵點。在該工作中,吳翼團隊基於自研的大規模RLHF 訓練系統,首次採用PPO 演算法及參數量更少的開源模型,在公認最困難的挑戰—— 程式碼生成任務CodeContest—— 上超過閉源大模型AlphaCode 41B。

相關成果被 ICML 2024 錄用為 Oral Presentation,並將在 7 月 23 日於 ICML 2024 第一個 Oral session Alignment-1 上和 OpenAI、Anthropic 等知名機構的工作一起進行公開匯報。

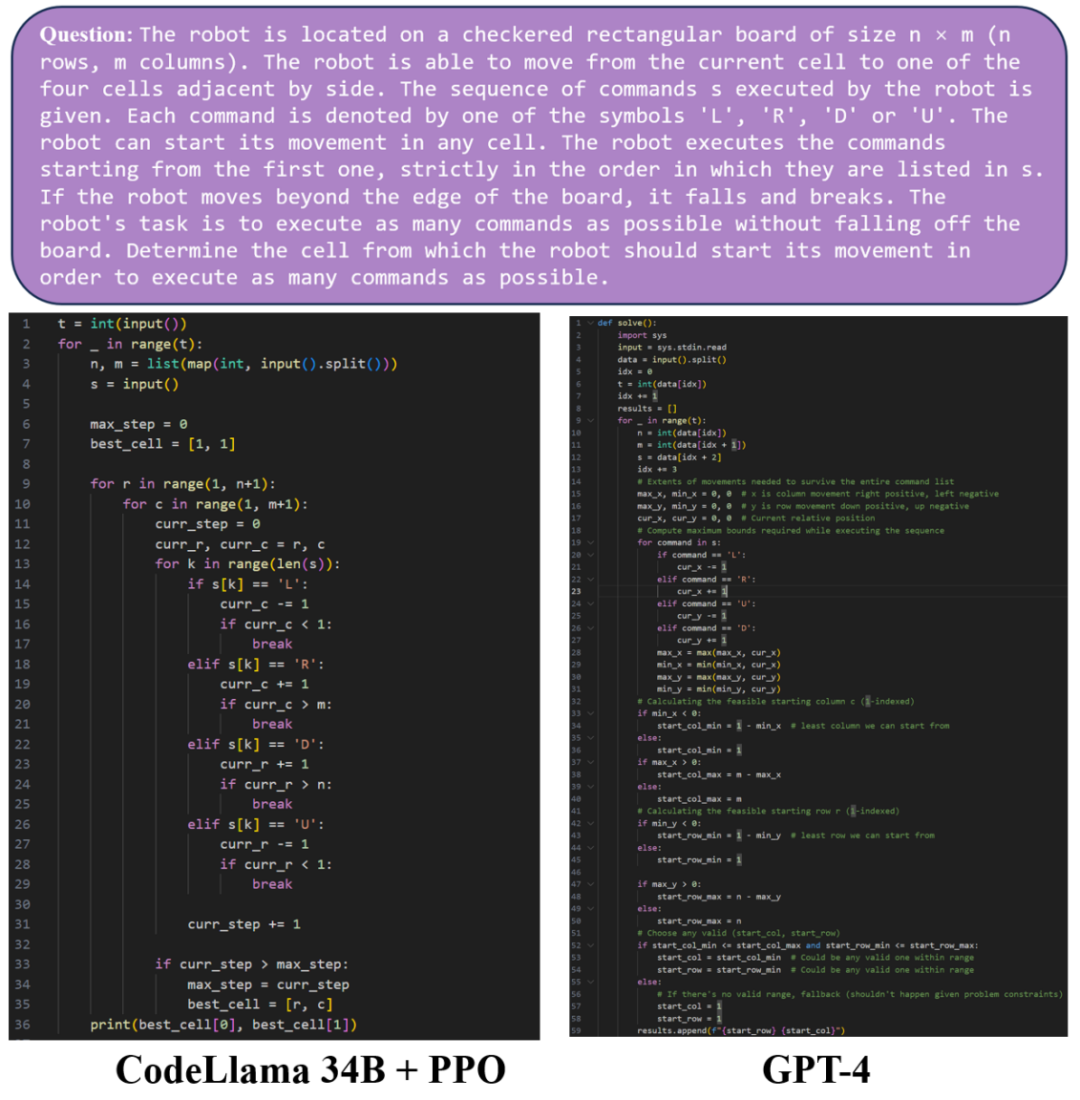

接下來讓我們比較一下GPT-4 和經過PPO 演算法訓練的CodeLlama 34B 模型在程式碼產生上的效果,在範例1 中,經過PPO 演算法訓練的CodeLlama 34B 模型與GPT-4 模型產生了品質相當的程式碼。

在範例 2 中,可以看到經過 PPO 演算法訓練的 CodeLlama 34B 模型與 GPT-4 模型都能產生完整且可運作的 python 程式碼。然而,在這個例子下,GPT-4 產生了錯誤的程式碼,在測試資料上無法正確輸出。而經過 PPO 演算法訓練的 CodeLlama 34B 模型產生的程式碼可以通過測試。

ICML 2024의 이번 논문에서 연구팀은 DPO와 PPO 알고리즘의 특징을 자세히 논의하고 DPO와 PPO의 역량을 향상시키기 위한 핵심 포인트를 지적했습니다.

- 논문 제목: LLM 정렬을 위한 DPO가 PPO보다 우수합니까? 종합 연구

- 논문 주소: https://arxiv.org/pdf/2404.10719

PPO와 비교하여 DPO는 훈련을 위해 온라인 샘플링 데이터 대신 오프라인 데이터를 사용합니다. 분석 후 DPO 알고리즘은 훈련된 모델이 훈련 데이터 분포 외부의 출력을 선호하도록 하며 경우에 따라 예측할 수 없는 응답을 생성합니다. 그래서 연구팀은 DPO 알고리즘의 성능을 향상시키기 위해 두 가지 핵심 기술을 요약했습니다. RLHF 훈련 전에 추가 SFT 훈련을 수행하고, 오프라인 데이터 대신 온라인 샘플링 데이터를 사용합니다.

실험에 따르면 추가 SFT 교육을 사용하면 기본 모델과 참조 모델이 데이터 세트 내 분포에 더 편향되어 DPO 알고리즘의 효과가 크게 향상되는 반면 온라인 샘플링을 사용하는 DPO 알고리즘이 향상됩니다. 반복 훈련을 위한 데이터는 꾸준히 개선되어 왔으며 기본 DPO 알고리즘보다 성능이 훨씬 뛰어납니다. DPO를 제외하고 이 백서는 PPO의 기능을 극대화하기 위한 세 가지 핵심 포인트도 요약합니다.

- 및 지수 이동 평균(참조 모델의 지수 이동 평균)을 사용하여 참조 모델을 업데이트합니다.

연구팀은 PPO 알고리즘을 성공적으로 사용하여 대화 작업 Safe-RLHF/HH-RLHF 및 코드 생성 작업 APPS/CodeContest에서 SOTA 결과를 얻었습니다.

대화 과제에서 연구팀은 세 가지 핵심 포인트를 결합한 PPO 알고리즘이 DPO 알고리즘과 온라인 샘플링 DPO 알고리즘 DPO-Iter보다 훨씬 우수하다는 사실을 발견했습니다.

코드 생성 작업 APPS 및 CodeContest에서는 오픈 소스 모델 Code Llama 34B를 기반으로 PPO 알고리즘도 CodeContest에서 이전 SOTA인 AlphaCode 41B를 능가하는 가장 강력한 수준에 도달했습니다. 더 나은 결과로 대규모 모델 정렬을 달성하려면 매우 효율적인 교육 시스템이 필수적입니다. Wu Yi 팀은 대규모 강화 학습 교육을 구현하는 데 장기간 축적되어 있으며 2021년부터 이를 구축했습니다. 독점적인 분산 강화 학습 프레임워크입니다. .

- NeurIPS 2022 협동 다중 에이전트 게임에서 PPO의 놀라운 효과 [1]: 협동 시나리오에서 다중 에이전트 훈련을 지원하기 위해 다중 에이전트용 강화 학습 병렬 훈련 프레임워크 MAPPO를 제안하고 오픈 소스화했습니다. Multi-agent 분야에서 다수의 연구에 활용되었으며, 현재 논문 인용 횟수는 1,000회를 넘어섰습니다.

- ICLR 2024 분산 강화 학습을 10,000개 이상의 코어로 확장 [2]: 수만 개의 코어로 쉽게 확장할 수 있고 가속 비율이 OpenAI의 대규모 강화를 초과하는 강화 학습을 위한 분산 학습 프레임워크를 제안했습니다. 학습 시스템 Rapid .

- ReaLHF: 매개변수 재할당을 통해 대규모 언어 모델에 대한 최적화된 RLHF 훈련 [3]: 최근 Wu Yi 팀은 분산 RLHF 훈련 프레임워크 ReaLHF를 추가로 구현했습니다. Wu Yi 팀의 ICML 구두 논문은 ReaLHF 시스템을 기반으로 제작되었습니다. ReaLHF 시스템은 오랫동안 개발되었으며 최적의 성능을 달성하기 위해 많은 세부 사항 연마를 거쳤습니다. 이전 오픈 소스 작업과 비교하여 ReaLHF는 사전 훈련보다 더 복잡한 시나리오인 RLHF에서 거의 선형 확장성을 달성할 수 있으며 리소스 활용도도 높고 128 A100 GPU 훈련 관련 작업에서 RLHF를 안정적이고 빠르게 수행할 수 있습니다. 오픈소스화되었습니다: https://github.com/openpsi-project/ReaLHF

Wu Yi의 팀은 대규모 언어 모델의 코딩 기능을 향상시키는 것 외에도 다양한 강화 학습 알고리즘과 대규모 언어 모델을 사용합니다. 모델의 조합은 다양하고 복잡한 LLM 에이전트를 실현하고 인간과 복잡한 상호 작용을 수행할 수 있습니다. MiniRTS의 강화 학습을 사용하여 인간의 지시를 따르고 최적의 결정을 내릴 수 있는 언어 에이전트를 만듭니다[4].

대형 모델의 의사 결정 능력을 향상시키기 위해 Werewolf의 다양한 강화 학습 전략을 훈련합니다[5].

오버쿡드 게임에서는 작은 모델과 큰 모델이 결합되어 실시간 피드백을 제공할 수 있는 협력적인 Language Agent를 구현합니다[6].

강화 학습을 통해 훈련된 로봇 제어 전략과 대규모 언어 모델의 추론 기능을 결합하면 로봇이 일련의 복잡한 작업을 수행할 수 있습니다[7].

대형 모델이 실제로 수천 가구에 진출하려면 정렬 기술이 중요합니다. 학계 및 대형 모델 실무자에게 좋은 오픈 소스 작업과 논문은 의심할 여지 없이 실험 비용과 개발 난이도를 크게 줄일 것으로 기대합니다. 기술이 발전하면 인간에게 봉사하는 더 큰 모델이 나타날 것입니다. [1] Yu, Chao, Akash Velu, Eugene Vinitsky, Jiaxuan Gao, Yu Wang, Alexandre Bayen 및 Yi Wu "협동 멀티 에이전트 게임에서 ppo의 놀라운 효과." [2] Mei, Zhiyu, Wei Fu, Guangju Wang, Huanchen Zhang 및 Yi Wu. "SRL: 분산 강화 학습을 10,000개 이상의 코어로 확장."[3] Mei, Zhiyu, Wei Fu, Kaiwei Li, Guangju Wang, Huanchen Zhang 및 Yi Wu. "ReaLHF: 매개변수 재할당을 통한 대규모 언어 모델에 대한 최적화된 RLHF 교육."[4] Xu, Shusheng, Huaijie Wang, Jiaxuan Gao, Yutao Ouyang, Chao Yu 및 Yi Wu. "물리적으로 현실적인 로봇 동작 및 제어의 언어 기반 생성."[5] Xu, Zelai, Chao Yu, Fei Fang, Yu Wang 및 Yi Wu. "늑대인간 게임의 전략적 플레이를 위한 강화 학습 기능을 갖춘 언어 에이전트."[6] Liu, Jijia, Chao Yu, Jiaxuan Gao, Yuqing Xie, Qingmin Liao, Yi Wu 및 Yu Wang "Llm-. 실시간 인간-AI 조정을 위한 강력한 계층적 언어 에이전트."[7] Ouyang, Yutao, Jinhan Li, Yunfei Li, Zhongyu Li, Chao Yu, Koushil Sreenath 및 Yi Wu. "Long-horizon 대규모 언어 모델을 갖춘 4족 로봇의 이동 및 조작."위 내용은 ICML 2024 Oral | Tsinghua Wuyi 팀의 최신 계시는 DPO가 LLM에 더 적합합니까?의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!