기술 주변기기

기술 주변기기

IT산업

IT산업

Moore Thread 'Kua'e 지능형 컴퓨팅 클러스터 KUAE' 버전 1.2 출시: 64K 긴 텍스트 지원, 대형 모델의 LLaMA2 전체 시리즈 추가 등

Moore Thread 'Kua'e 지능형 컴퓨팅 클러스터 KUAE' 버전 1.2 출시: 64K 긴 텍스트 지원, 대형 모델의 LLaMA2 전체 시리즈 추가 등

Moore Thread 'Kua'e 지능형 컴퓨팅 클러스터 KUAE' 버전 1.2 출시: 64K 긴 텍스트 지원, 대형 모델의 LLaMA2 전체 시리즈 추가 등

8월 19일 본 사이트의 소식에 따르면 무어의 스레드 “KUAE 지능형 컴퓨팅 클러스터” 1.2 버전이 공식 출시되었습니다. 이 버전은 소프트웨어 및 하드웨어 수준의 포괄성을 최적화하고 64K 긴 텍스트를 지원하며 전체 범위의 LLaMA2 대형 모델, Baichuan, Yayi, Qwen2, Mixtral(MoE 8x7B) 및 기타 모델을 추가합니다.

-

MFU 프로모션# 🎜🎜#

- 킬로카드 클러스터를 사용하여 1,000억 개의 모델을 훈련하면 MFU가 10% 증가했습니다.

- 밀도 모델 클러스터 학습 MFU가 최대 55%에 도달합니다.

-

Flash Attention2 최적화

- 통합 MUSA SDK 플랫폼 최적화 Flash Attention2 기술은 대규모 모델 훈련 효율성과 리소스 활용도를 향상시킵니다.

-

64K 긴 텍스트 지원

- 긴 텍스트를 위한 향상된 대형 모델 긴 텍스트 이해 및 생성 작업을 처리하는 능력을 최적화하기 위한 교육 지원.

-

혼합 전문가 모델 지원 MoE

- All2All muDNN에 최적화됨 연산자는 다양한 형태에서 매트릭스 작업을 최적화하고 MoE 대규모 모델 교육을 지원합니다.

-

중단점에서 계속 교육

- 검사점 읽기 및 쓰기 성능 향상 , 훈련 효율성을 향상시킵니다. ### ## ## ## ## ## ## ############ ## #####딥 스피드는 무어 스레드 GPU에 적응했습니다. 클러스터 Ulysses를 사용하면 향상된 긴 텍스트 학습 지원이 가능합니다.

- 국내외 많은 대형 모델에 적합합니다.

-

안정성 개선

- 성숙한 소프트웨어 및 하드웨어로 지속적인 안정성 달성 15일 동안 결함 훈련을 실시합니다.

- 모니터링, 자동 진단, 장애 복구 기능을 강화하는 KUAE Aegis 신뢰성 기능을 도입합니다.

-

시각화/관찰 가능성

- PerfSight 성능 모니터링 시스템 소개, 훈련 중 리소스 소비 및 성능 데이터를 실시간으로 표시합니다.

-

내장 모델 라이브러리에 새로운 대형 모델이 추가되었습니다

#🎜🎜 #LLaMA2 Full 시리즈, Baichuan, Yayi, Qwen2, Mixtral(MoE 8x7B) 및 기타 모델이 추가되었습니다.

위 내용은 Moore Thread 'Kua'e 지능형 컴퓨팅 클러스터 KUAE' 버전 1.2 출시: 64K 긴 텍스트 지원, 대형 모델의 LLaMA2 전체 시리즈 추가 등의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!

핫 AI 도구

Undresser.AI Undress

사실적인 누드 사진을 만들기 위한 AI 기반 앱

AI Clothes Remover

사진에서 옷을 제거하는 온라인 AI 도구입니다.

Undress AI Tool

무료로 이미지를 벗다

Clothoff.io

AI 옷 제거제

Video Face Swap

완전히 무료인 AI 얼굴 교환 도구를 사용하여 모든 비디오의 얼굴을 쉽게 바꾸세요!

인기 기사

뜨거운 도구

메모장++7.3.1

사용하기 쉬운 무료 코드 편집기

SublimeText3 중국어 버전

중국어 버전, 사용하기 매우 쉽습니다.

스튜디오 13.0.1 보내기

강력한 PHP 통합 개발 환경

드림위버 CS6

시각적 웹 개발 도구

SublimeText3 Mac 버전

신 수준의 코드 편집 소프트웨어(SublimeText3)

Moore Threads는 차세대 디지털 트윈 지도를 만들기 위해 Baidu Maps와 전략적 협력을 체결했습니다.

Jul 25, 2024 am 12:31 AM

Moore Threads는 차세대 디지털 트윈 지도를 만들기 위해 Baidu Maps와 전략적 협력을 체결했습니다.

Jul 25, 2024 am 12:31 AM

이 웹사이트는 7월 24일에 Moore Thread와 Baidu Maps가 전략적 협력 계약을 체결했다고 보도했습니다. 양 당사자는 각자의 기술 및 제품 장점을 활용하여 디지털 트윈 지도의 기술 혁신을 공동으로 추진할 것입니다. 협력 계약에 따르면 양 당사자는 바이두 지도의 지도 엔진 장점, 디지털 트윈 기술 장점, 지도 빅데이터 애플리케이션 장점, 3D 그래픽 렌더링 및 AI 컴퓨팅 기술을 활용해 디지털 트윈 지도 프로젝트 구축에 중점을 둘 예정이다. 무어 스레드의 모든 기능을 갖춘 GPU의 장점을 적극적으로 수행하기 위한 심층적이고 광범위한 지속적인 협력은 디지털 트윈 맵 솔루션의 적용 및 대규모 구현을 공동으로 촉진할 것입니다. Moore Thread의 공식 소개에 따르면 지도 데이터는 국가의 핵심 자산이며 디지털 트윈 지도는 특히 GPU의 렌더링 성능과 성능에 큰 영향을 미치는 고부하 렌더링 시나리오에서 그 중요성을 강조합니다.

국산 그래픽카드의 진정한 빛! Moore Thread의 국내 GPU, AI 및 Metaverse 개발에 대한 심층적 해석

Jun 05, 2023 am 11:10 AM

국산 그래픽카드의 진정한 빛! Moore Thread의 국내 GPU, AI 및 Metaverse 개발에 대한 심층적 해석

Jun 05, 2023 am 11:10 AM

1. 무어의 스레드에 대한 간략한 역사: 광속 기업가 정신(Lightspeed Entrepreneurship) 공격 오늘날 우리는 이미 상대적으로 성숙한 독립 CPU 프로세서, NAND 플래시 메모리, DRAM 메모리 및 OS 운영 체제를 컴퓨팅 플랫폼의 매우 중요한 부분으로 보유하고 있습니다. 그래픽 카드에는 항상 심각한 단점이 있었습니다. 주로 하드웨어 설계가 극도로 어려울 뿐만 아니라 생태학적 재배가 더욱 어렵고 하루아침에 달성할 수 없기 때문입니다. 실제로 국내 GPU 업체는 꽤 많지만, 그 중 상당수는 특정 산업 분야에 국한되거나 고성능 컴퓨팅을 지향하고 있다. 진정으로 포괄적인 레이아웃을 만들어 소비자 시장에 진출하려는 이들이라면 무어쓰레드(MooreThread)를 언급하지 않을 수 없다. 5월 31일, 무어라인은 2023년 여름 기자회견을 위해 Kuai Technology에 초대장을 보냈습니다.

AI의 주요 전장에서 Wanka는 표준 구성입니다. 국내 GPU Wanka WanP 클러스터가 여기에 있습니다!

Jul 10, 2024 pm 03:07 PM

AI의 주요 전장에서 Wanka는 표준 구성입니다. 국내 GPU Wanka WanP 클러스터가 여기에 있습니다!

Jul 10, 2024 pm 03:07 PM

ScalingLaw는 계속해서 결과를 보여주고 있으며, 컴퓨팅 성능은 대형 모델의 확장을 거의 따라잡을 수 없습니다. "규모가 클수록 컴퓨팅 성능이 높아지고 효과가 좋아진다"는 것이 업계 표준이 되었습니다. 주류 대형 모델이 수백억 개에서 1조 8천억 개의 매개변수로 도약하는 데 불과 1년이 걸렸다. META, 구글, 마이크로소프트 등 거대 기업들도 2022년부터 카드 1만5000개 이상을 갖춘 초대형 클러스터를 구축해왔다. "Wanka는 AI 주요 전장의 표준이 되었습니다." 그러나 중국에서는 국산 GPU Wanka 클러스터가 소수에 불과합니다. 업계에서 격차가 있는 초다용성을 갖춘 초대형 완카 클러스터가 있다. 국내 GPU Wanka WanP 클러스터가 데뷔하면서 자연스럽게 업계의 폭넓은 관심을 끌었습니다. 7월 3일, Moore Thread는 상하이에서 AI 주력 제품을 발표했습니다.

게임 'Zero'를 지원하는 Moore Thread, 그래픽 카드 드라이버 v260.70.2 버전 업데이트 출시

Jul 22, 2024 pm 08:44 PM

게임 'Zero'를 지원하는 Moore Thread, 그래픽 카드 드라이버 v260.70.2 버전 업데이트 출시

Jul 22, 2024 pm 08:44 PM

7월 22일 이 웹사이트의 뉴스에 따르면 Moore Thread는 오늘 버전 번호 v260.70.2의 그래픽 카드 드라이버를 출시했습니다. 이번 업데이트는 "제로제로(Zero Zero)" 게임을 지원하며, 게임 실행 로비와 게임 내 장면의 확률적 렌더링 누락 및 기타 문제를 수정합니다. 동시에 새로운 드라이버는 '레고 레전드', '서바이벌 아일랜드: 청춘의 샘 전설', '바벨의 찬가' 등 다수의 인기 게임 성능 향상에 초점을 맞췄다. 또한 새 드라이버는 일부 DirectX11 게임의 성능을 특별히 최적화했습니다. 예를 들어 "Expedition: Mud Run Game"의 평균 프레임 속도가 150% 이상 증가했으며 "Project Zero 2"의 평균 프레임 속도도 향상되었습니다. : 아포칼립스 파티'가 약 150% 증가했습니다. 그래픽 카드 사용자는 Moore Thread 공식 웹사이트를 방문하여 최신 버전 v2를 다운로드할 수 있습니다.

Moore Thread의 'Intelligent Entertainment Mofang' 데스크톱 컴퓨터 호스트 구성이 새로워졌습니다. i5-14400F + MTT S80 국내 그래픽 카드가 7,099위안에 판매되었습니다.

Jul 28, 2024 pm 05:14 PM

Moore Thread의 'Intelligent Entertainment Mofang' 데스크톱 컴퓨터 호스트 구성이 새로워졌습니다. i5-14400F + MTT S80 국내 그래픽 카드가 7,099위안에 판매되었습니다.

Jul 28, 2024 pm 05:14 PM

28일 이 사이트 소식에 따르면 무어 스레드는 "게임 분야에 집중한다"며 지난해 6월 30일 데스크톱 컴퓨터 호스트 '지유 모팡'을 출시했다. 오늘 'i5-14400F'가 공식 출시됐다. 머신 +32GBRAM+1TB+MTTS80 그래픽 카드” 구성의 경우 제품 페이지에 가격이 7,099위안으로 표시됩니다. 게이밍 컴퓨터는 10코어 16스레드 Core i5-14400F 프로세서, B760I 랜딩쉽 마더보드, 32GBDDR43200Mhz의 실행 메모리, 내장형 PCIe4.01TBSSD를 사용하는 것으로 알려졌습니다. 구체적인 사양은 JD를 참조하세요. .com 매개 변수는 다음과 같습니다. GPU의 경우 "Intelligent Entertainment Mofang" "게임용 컴퓨터는 Moore Thread의 자체 MTTS80 그래픽 카드를 사용합니다.

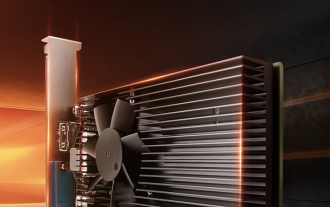

Moore Thread MTT S30 국내 그래픽 카드 판매 중: 4GB 비디오 메모리, 40W 전력 소비, 가격은 399위안

Feb 22, 2024 am 08:00 AM

Moore Thread MTT S30 국내 그래픽 카드 판매 중: 4GB 비디오 메모리, 40W 전력 소비, 가격은 399위안

Feb 22, 2024 am 08:00 AM

2월 21일 이 웹사이트의 소식에 따르면 Moore Thread MTTS30 국내 그래픽 카드는 현재 JD.com에서 구매 가능하며 초기 가격은 399위안, 보증금 50위안이 필요합니다. 이 웹사이트에서는 Moore Thread MTTS30 그래픽 카드가 MUSA 통합 시스템 아키텍처를 기반으로 하며 x86, Arm 및 LoongArch와 같은 다중 CPU 아키텍처와 호환되며 OpenGL, OpenGLES 및 Vulkan과 같은 다양한 그래픽 API를 지원한다는 점에 주목했습니다. 4K 영상 출력 및 AV1 코덱은 컴팩트한 섀시에 맞으며 추가 전원 공급 장치가 필요하지 않습니다. 매개변수 측면에서 이 그래픽 카드는 1024MUSA 코어, 코어 주파수 1.3Ghz, 4GB 그래픽 카드, 전력 소비 40W, 카드 길이 144mm, 카드 너비 67mm, HDMI2 1개를 갖추고 있습니다.

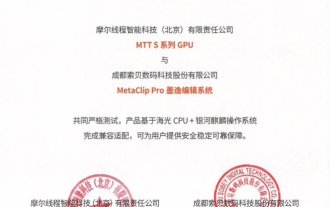

Moore Threads와 Sobey는 CPU, GPU, 소프트웨어 및 시스템의 전체 체인에 대해 현지화된 글로벌 울트라 클리어 솔루션을 구현합니다.

Sep 03, 2024 am 12:00 AM

Moore Threads와 Sobey는 CPU, GPU, 소프트웨어 및 시스템의 전체 체인에 대해 현지화된 글로벌 울트라 클리어 솔루션을 구현합니다.

Sep 03, 2024 am 12:00 AM

9월 2일 이 사이트의 소식에 따르면, 무어 스레드(Moore Thread)는 소비(Sobey)와 협력해 제31회 베이징 국제 라디오, 영화, 텔레비전 전시회에서 '국내화된 글로벌 울트라클리어 솔루션'을 시연했다. 모든 기능을 갖춘 Moore 스레드 GPU를 기반으로 하는 Sobey의 MetaClipPro 비선형 편집 시스템 및 그래픽 패키징 시스템은 국내 환경에서 안정적으로 실행될 수 있습니다. ▲사진 출처 Moore Thread 공개 계정, 아래와 동일 이 사이트는 양 당사자가 공동 개발을 통해 소프트웨어, CPU, 운영 체제에서 GPU에 이르기까지 전체 체인의 현지화를 성공적으로 실현했음을 알게 되었습니다. Sobey는 또한 Haiguang 3330 시리즈 및 Haiguang 7000 시리즈 CPU, Galaxy Kirin 운영 체제 및 Moore 스레드 전체 기능 GPU를 갖춘 여러 국내 솔루션을 출시했습니다.

Moore Thread는 그래픽 카드 드라이버 v270.80 출시: OpenGL 4.1 및 AV1 인코딩을 지원하여 DX11에서 '검은 신화: 오공' 벤치마크 충돌을 해결합니다.

Aug 20, 2024 pm 07:52 PM

Moore Thread는 그래픽 카드 드라이버 v270.80 출시: OpenGL 4.1 및 AV1 인코딩을 지원하여 DX11에서 '검은 신화: 오공' 벤치마크 충돌을 해결합니다.

Aug 20, 2024 pm 07:52 PM

8월 20일 이 사이트의 뉴스에 따르면 Moore Thread는 오늘 그래픽 카드 드라이버 버전 번호 v270.80을 출시했습니다. 새 버전의 드라이버는 Windows 10 및 Windows 11 운영 체제 환경에서 OpenGL4.1을 완벽하게 지원할 수 있으며 AV1 형식 인코딩 및 VC1 형식 디코딩을 지원합니다. 동시에 새 드라이버는 DirectX11 모드에서 "Black Myth: Wukong" 벤치마크를 실행할 때 발생하는 충돌 문제를 해결합니다. Moore Threading 팀은 현재 게임을 최적화하고 있습니다. 새로운 드라이버는 더 많은 DirectX11 게임의 성능을 최적화했습니다. 예를 들어, "Chain Together"의 평균 프레임 속도는 150% 이상 증가했고, "Payday 3"의 평균 프레임 속도는 100% 이상 증가했습니다. , DOTA2의 평균 프레임 속도가 150% 이상 향상되었습니다.