이미지의 마법 잠금 해제 : 최첨단 Smolvlm-M 모델 사용에 대한 빠르고 쉬운 안내서

이 기사에서는 최첨단 소형 비전-텍스트 모델인 SmolVLM-500M-Instruct를 소개합니다. 상대적으로 작은 크기(5억 개의 매개변수)에도 불구하고 인상적인 성능을 보여줍니다.

Python 코드는 다음과 같습니다.

import torch

from transformers import AutoProcessor, AutoModelForVision2Seq

from PIL import Image

import warnings

warnings.filterwarnings("ignore", message="Some kwargs in processor config are unused")

def describe_image(image_path):

processor = AutoProcessor.from_pretrained("HuggingFaceTB/SmolVLM-500M-Instruct")

model = AutoModelForVision2Seq.from_pretrained("HuggingFaceTB/SmolVLM-500M-Instruct")

image = Image.open(image_path)

prompt = "Describe the image content in detail. Provide a concise textual response."

inputs = processor(text=[prompt], images=[image], return_tensors="pt")

with torch.no_grad():

outputs = model.generate(

pixel_values=inputs["pixel_values"],

input_ids=inputs["input_ids"],

attention_mask=inputs["attention_mask"],

max_new_tokens=150,

do_sample=True,

temperature=0.7

)

description = processor.batch_decode(outputs, skip_special_tokens=True)[0]

return description.strip()

if __name__ == "__main__":

image_path = "images/bender.jpg"

try:

description = describe_image(image_path)

print("Image Description:", description)

except Exception as e:

print(f"Error: {e}")이 스크립트는 Hugging Face Transformers 라이브러리를 활용하여 이미지에서 텍스트 설명을 생성합니다. 사전 훈련된 모델과 프로세서를 로드하고, 이미지를 처리하고, 설명 텍스트를 출력합니다. 오류 처리가 포함되어 있습니다.

코드는 여기에서 확인할 수 있습니다: https://www.php.cn/link/042886829869470b75f63dddfd7e9d9d

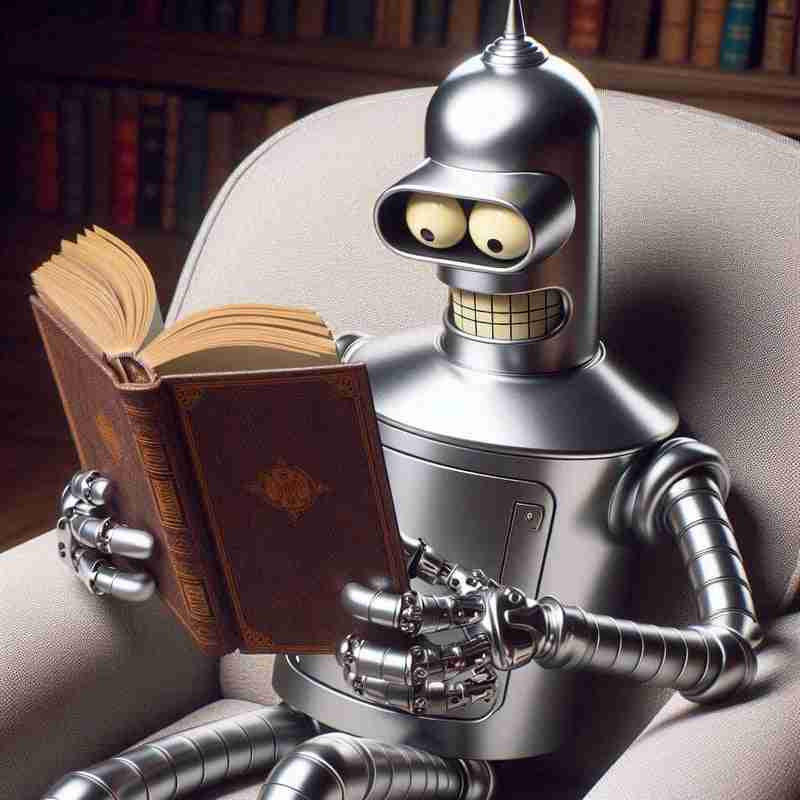

다음 비스톡 이미지 사용(프로젝트의 이미지 디렉토리에 있음):

모델이 설명을 생성합니다(세밀한 제어를 위해 프롬프트와 매개변수를 조정할 수 있음). 로봇이 소파에 앉아 책을 읽는 데 열중하고 있습니다. 책장과 문이 배경에 보입니다. 쿠션이 있는 흰색 의자도 등장합니다.

대형 언어 모델에 비해 모델의 속도와 효율성이 주목할 만합니다.

위 내용은 이미지의 마법 잠금 해제 : 최첨단 Smolvlm-M 모델 사용에 대한 빠르고 쉬운 안내서의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!

핫 AI 도구

Undresser.AI Undress

사실적인 누드 사진을 만들기 위한 AI 기반 앱

AI Clothes Remover

사진에서 옷을 제거하는 온라인 AI 도구입니다.

Undress AI Tool

무료로 이미지를 벗다

Clothoff.io

AI 옷 제거제

Video Face Swap

완전히 무료인 AI 얼굴 교환 도구를 사용하여 모든 비디오의 얼굴을 쉽게 바꾸세요!

인기 기사

뜨거운 도구

메모장++7.3.1

사용하기 쉬운 무료 코드 편집기

SublimeText3 중국어 버전

중국어 버전, 사용하기 매우 쉽습니다.

스튜디오 13.0.1 보내기

강력한 PHP 통합 개발 환경

드림위버 CS6

시각적 웹 개발 도구

SublimeText3 Mac 버전

신 수준의 코드 편집 소프트웨어(SublimeText3)

뜨거운 주제

7889

7889

15

15

1650

1650

14

14

1411

1411

52

52

1302

1302

25

25

1248

1248

29

29

중간 독서를 위해 Fiddler를 사용할 때 브라우저에서 감지되는 것을 피하는 방법은 무엇입니까?

Apr 02, 2025 am 07:15 AM

중간 독서를 위해 Fiddler를 사용할 때 브라우저에서 감지되는 것을 피하는 방법은 무엇입니까?

Apr 02, 2025 am 07:15 AM

Fiddlerevery Where를 사용할 때 Man-in-the-Middle Reading에 Fiddlereverywhere를 사용할 때 감지되는 방법 ...

Linux 터미널에서 Python (Version 명령)을 사용할 때 권한 문제를 해결하는 방법은 무엇입니까?

Apr 02, 2025 am 06:36 AM

Linux 터미널에서 Python (Version 명령)을 사용할 때 권한 문제를 해결하는 방법은 무엇입니까?

Apr 02, 2025 am 06:36 AM

Linux 터미널에서 Python 사용 ...

10 시간 이내에 프로젝트 및 문제 중심 방법에서 컴퓨터 초보자 프로그래밍 기본 사항을 가르치는 방법?

Apr 02, 2025 am 07:18 AM

10 시간 이내에 프로젝트 및 문제 중심 방법에서 컴퓨터 초보자 프로그래밍 기본 사항을 가르치는 방법?

Apr 02, 2025 am 07:18 AM

10 시간 이내에 컴퓨터 초보자 프로그래밍 기본 사항을 가르치는 방법은 무엇입니까? 컴퓨터 초보자에게 프로그래밍 지식을 가르치는 데 10 시간 밖에 걸리지 않는다면 무엇을 가르치기로 선택 하시겠습니까?

Python Asyncio Telnet 연결이 즉시 분리됩니다. 서버 측 차단 문제를 해결하는 방법은 무엇입니까?

Apr 02, 2025 am 06:30 AM

Python Asyncio Telnet 연결이 즉시 분리됩니다. 서버 측 차단 문제를 해결하는 방법은 무엇입니까?

Apr 02, 2025 am 06:30 AM

Pythonasyncio에 대해 ...

Inversiting.com의 크롤링 메커니즘을 우회하는 방법은 무엇입니까?

Apr 02, 2025 am 07:03 AM

Inversiting.com의 크롤링 메커니즘을 우회하는 방법은 무엇입니까?

Apr 02, 2025 am 07:03 AM

Investing.com의 크롤링 전략 이해 많은 사람들이 종종 Investing.com (https://cn.investing.com/news/latest-news)에서 뉴스 데이터를 크롤링하려고합니다.

Python 3.6 피클 파일로드 오류 modulenotfounderRor : 피클 파일 '__builtin__'를로드하면 어떻게해야합니까?

Apr 02, 2025 am 06:27 AM

Python 3.6 피클 파일로드 오류 modulenotfounderRor : 피클 파일 '__builtin__'를로드하면 어떻게해야합니까?

Apr 02, 2025 am 06:27 AM

Python 3.6에 피클 파일 로딩 3.6 환경 오류 : ModulenotFounderRor : nomodulename ...

SCAPY 크롤러를 사용할 때 파이프 라인 파일을 작성할 수없는 이유는 무엇입니까?

Apr 02, 2025 am 06:45 AM

SCAPY 크롤러를 사용할 때 파이프 라인 파일을 작성할 수없는 이유는 무엇입니까?

Apr 02, 2025 am 06:45 AM

SCAPY 크롤러를 사용할 때 파이프 라인 파일을 작성할 수없는 이유에 대한 논의 지속적인 데이터 저장을 위해 SCAPY 크롤러를 사용할 때 파이프 라인 파일이 발생할 수 있습니다 ...