<:> Deepseek : llms 에 대한 강화 학습에 대한 깊은 다이빙

Deepseek의 최근 성공으로 저렴한 비용으로 인상적인 성능을 달성하면서 LLM (Lange Language Model) 교육 방법의 중요성을 강조합니다. 이 기사는 강화 학습 (RL) 측면, TRPO, PPO 및 새로운 GRPO 알고리즘을 탐색하는 데 중점을 둡니다. 머신 러닝, 딥 러닝 및 LLM에 대한 기본적인 친숙 함을 가정하여 복잡한 수학을 최소화 할 수 있습니다.

LLM 훈련의 세 가지 기둥

llm 훈련은 일반적으로 세 가지 주요 단계를 포함합니다 :

사전 훈련 : 모델은 대규모 데이터 세트를 사용하여 선행 토큰의 순서로 다음 토큰을 예측하는 법을 배웁니다.

감독 된 미세 조정 (SFT) : 타겟팅 된 데이터는 모델을 개선하여 특정 지침과 정렬합니다.

강화 학습 (RLHF) : 이 단계,이 기사의 초점은 직접적인 피드백을 통해 인간 선호도를 더 잘 일치시키기 위해 응답을 더 개선합니다.

.

강화 학습 기초

강화 학습은 환경 와 상호 작용하는 것을 포함합니다. 에이전트는 특정 에 존재하며, 조치 를 취하여 새로운 상태로 전환합니다. 각 조치는 환경에서 보상 를 통해 에이전트의 미래 행동을 안내합니다. 미로를 탐색하는 로봇을 생각해보십시오. 그 위치는 상태이며, 움직임은 행동이며, 출구에 도달하는 것은 긍정적 인 보상을 제공합니다. .

llms의 rl : 상세한 모양

LLM 교육에서 구성 요소는 다음과 같습니다

에이전트 : - llm 자체

환경 : 사용자 프롬프트, 피드백 시스템 및 상황 정보와 같은 외부 요인.

조치 : LLM이 쿼리에 응답하여 생성하는 토큰.

상태 :

현재 쿼리와 생성 된 토큰 (부분 응답).

보상 : - 는 일반적으로 인간이 주식화 된 데이터에 대해 훈련 된 별도의 보상 모델 에 의해 결정되며, 점수를 지정하기위한 응답 순위. 고품질 응답은 더 높은 보상을받습니다. DeepSeekMath와 같은 특정 경우에 더 간단하고 규칙 기반 보상이 가능합니다.

- 정책 는 어떤 행동을 취할 것인지 결정합니다. LLM의 경우 다음 토큰을 샘플링하는 데 사용되는 가능한 토큰보다 확률 분포입니다. RL 교육은 정책의 매개 변수 (모델 가중치)를 조정하여 더 높은 보상 토큰을 선호합니다. 정책은 종종 다음과 같이 표시됩니다

RL의 핵심은 최적의 정책을 찾는 것입니다. 감독 학습과 달리, 우리는 보상을 사용하여 정책 조정을 안내합니다. - .

trpo (신뢰 지역 정책 최적화)

trpo는 감독 학습에서 손실 함수와 유사하지만 보상에서 파생 된 이점 기능을 사용합니다.

-

TRPO는 이전 반복에서 큰 정책 편차를 방지하기 위해 대리 목표를 최대화하여 안정성을 보장합니다.

PPO (근위 정책 최적화)

Chatgpt 및 Gemini와 같은 LLMS에 선호되는 PPO는 클리핑 된 대리 목표를 사용하여 정책 업데이트를 제한하고 계산 효율성을 향상시켜 TRPO를 단순화합니다. PPO 목적 함수는 다음과 같습니다

GRPO (그룹 상대 정책 최적화)

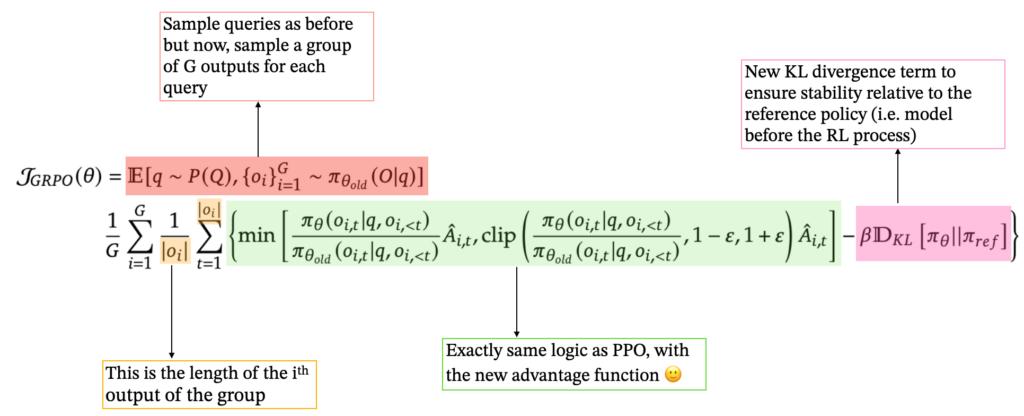

GRPO는 별도의 값 모델을 제거하여 교육을 간소화합니다. 각 쿼리마다 응답 그룹을 생성하고 보상에 따라 z- 점수로서 이점을 계산합니다.

이것은 프로세스를 단순화하며 LLMS의 여러 응답을 생성 할 수있는 능력에 적합합니다. GRPO는 또한 현재 정책을 참조 정책과 비교하여 KL 발산 용어를 통합합니다. 최종 GRPO 제형은 다음과 같습니다

결론

강화 학습, 특히 PPO 및 최신 GRPO는 현대적인 LLM 교육에 중요합니다. 각 방법은 RL 기초를 기반으로하며 안정성, 효율성 및 인간 정렬의 균형을 맞추기위한 다양한 접근 방식을 제공합니다. DeepSeek의 성공은 다른 혁신과 함께 이러한 발전을 활용합니다. 강화 학습은 LLM 기능을 발전시키는 데 점점 지배적 인 역할을 할 준비가되어 있습니다.

참고 문헌 :  (참고 문헌은 동일하게 유지되며, 더 나은 가독성을 위해 재구성되었습니다)

(참고 문헌은 동일하게 유지되며, 더 나은 가독성을 위해 재구성되었습니다)

[1] "대형 언어 모델의 기초", 2025. https://www.php.cn/link/fbf8ca43dcc014c2c94549d6b8ca0375

[2] "강화 학습." 에나리스. https://www.php.cn/link/20e169b48c8f869887e2bbe1c5c3ea65

[3] Y. Gokhale. "LLMS 및 생성 AI 파트 5 : rlhf," medium , 2023. https://www.php.cn/link/b24b1810f41d38b55728a9f56b043d35

[4] L. Weng. "강화 학습의 개요"2018

[5] "DeepSeek-R1 : 강화 학습을 통한 LLM의 인센티브 화 능력", 2025.

"6]"Deepseekmath : 오픈 언어 모델에서 수학적 추론의 한계를 높이기 ", 2025.

[7] "신뢰 지역 정책 최적화", 2017. https://www.php.cn/link/77a44d5cfb595b3545d61aa742268c9b

위 내용은 대형 언어 모델 교육 : TRPO에서 GRPO까지의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!

(참고 문헌은 동일하게 유지되며, 더 나은 가독성을 위해 재구성되었습니다)

(참고 문헌은 동일하게 유지되며, 더 나은 가독성을 위해 재구성되었습니다)