Deepseek의 획기적인 오픈 소스 릴리스 : Flashmla, Cuda 커널 가속 LLM. Hopper GPU 용으로 특별히 설계된이 최적화 된 다단히 해석 된주의 (MLA) 디코딩 커널은 AI 모델 호스팅의 속도와 효율성을 크게 향상시킵니다. 주요 개선 사항에는 BF16 지원 및 PAGED KV 캐시 (64 블록 크기)가 포함되어있어 인상적인 성능 벤치 마크가 발생합니다.

? #opensourceweek의 1 일차 : FlashMla

BF16 지원 ✅ PAGED KV 캐시 (블록 크기 64) 3000 GB/S 메모리 바운드 및 580 TFLOPS…- DeepSeek (@deepseek_ai) 2025 년 2 월 24 일 주요 기능 :

BF16 정밀도 :

이러한 최적화는 CUDA 12.6을 사용하여 H800 SXM5 GPU의 계산 결합 시나리오에서 최대 3000GB/s 메모리 대역폭 및 580 TFLOPS를 달성합니다. 이것은 AI 추론 성능을 크게 향상시킵니다. DeepSeek 모델에서 이전에 사용 된 FlashMla는 이제 DeepSeek AI의 R1 V3를 가속화합니다. 목차 :

수치 안정성을 유지하면서 효율적인 계산을 가능하게합니다 PAGED KV 캐시 (64 블록 크기) :

는 메모리 효율을 향상시키고 대기 시간, 특히 대형 모델의 경우 중요한 지연을 줄입니다.

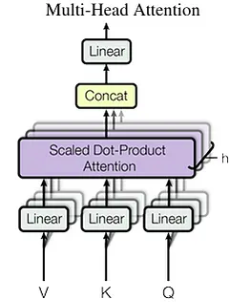

flashmla 란 무엇입니까? 다중 헤드 잠재주의 이해 (MLA) 표준 다중 헤드주의 제한 MLA의 메모리 최적화 전략

성능 벤치 마크 : 표준 다중 헤드주의 제한 :

MHA의 KV 캐시는 시퀀스 길이로 선형으로 스케일링하여 긴 시퀀스에 대한 메모리 병목 현상을 만듭니다. 캐시 크기는 다음과 같이 계산됩니다.

MLA의 메모리 최적화 :

MLA는 키와 값을 더 작은 잠재 벡터 ()로 압축하여 kv 캐시 크기를 로 줄입니다 (여기서

결론

메모리 대역폭 :

다중 헤드 잠재주의 이해 (mla)

seq_len * n_h * d_h

메모리 문제 해결 : n_h

d_h

FlashMla는 DeepSeek의 R1 및 V3 모델을 통해 효율적인 대규모 AI 애플리케이션을 가능하게합니다.

Nvidia Hopper Architecture

위 내용은 DeepSeek은 FlashMla를 출시합니다의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!